【2023 最新】微博爬虫及配套数据分析可视化教程

【2023 最新】微博爬虫及配套数据分析可视化教程

微博超级爬虫已经走到第四个年头,开源在 Github 上的代码已经收获了超过 1000 个 star,感谢大家的一路支持。总结了各类型的需求及问题,结合 2022 开年的推送 万字长文,2022 最全微博超级爬虫指南,和以下对应的博客,特开此篇。

https://buyixiao.github.io/blog/weibo-super-spider.html#%E8%AF%9D%E9%A2%98%E5%85%B3%E9%94%AE%E8%AF%8D%E7%B3%BB%E5%88%971、热搜话题、关键词等微博抓取

如果你想爬微博热搜话题等,你可以在上述博客地址查看说明书并索引到对应的爬虫文件获取方式。

如果抓取过程中遇到问题,可以在当前页面全局搜索问题关键词,你的问题很可能其他人已经遇到过了,在页面内容区域或者评论区域查看对应的解决方案就行了。如果没有找到,你可在评论区留言,贴上报错信息,我会定期 check 并回复,相信我应该不会跑路,已经维护四年迭代差不多十次了。

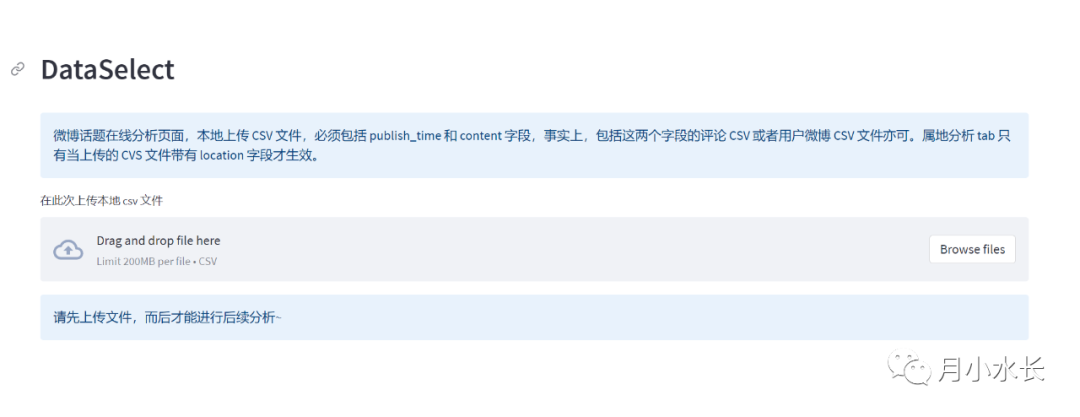

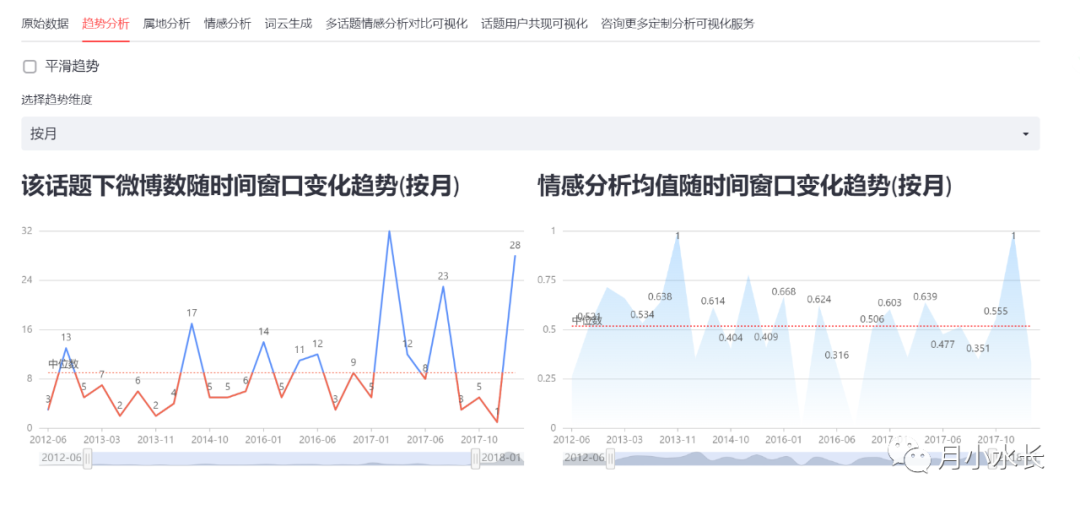

抓完微博热搜数据,如果你还想分析数据并可视化,比如趋势分析、情感分析、ip 属地分布、词云生成、共现可视化等等,你可以前往以下页面直接上传刚才抓完保存的 csv 文件,在网页自动完成分析并可视化。

https://weibo-crawl-visual.buyixiao.xyz/topic-weibo-visual

上传 CSV

趋势分析

自定义词云生成

对于任意最近的微博热搜或者以往的微博热搜抓取和分析可视化,你都可以遵循上面一样的流程。以下是更多探索部分。

2、用户微博抓取或备份、相册下载等

如果你想抓取一个用户主页的微博或者下载他的图片等等,可以在上述博客地址单功能系列爬虫下用户抓取爬虫之用户微博爬虫,如下图。

除了抓取用户微博、下载相册、还有抓取用户文章和公开信息等功能~

3、指定(单个或者批量)微博的评论、转发、点赞数据抓取

如果你想抓取微博热搜话题或者微博用户的评论、转发或者点赞,道理同话题微博,在博客地址上找到说明书并获取对应的文件即可,对于微博热搜话题的分析和可视化同样适用于评论或者转发,字段等我都做好了上下游适配,你只需要在分析页面上传 CSV 文件即可。

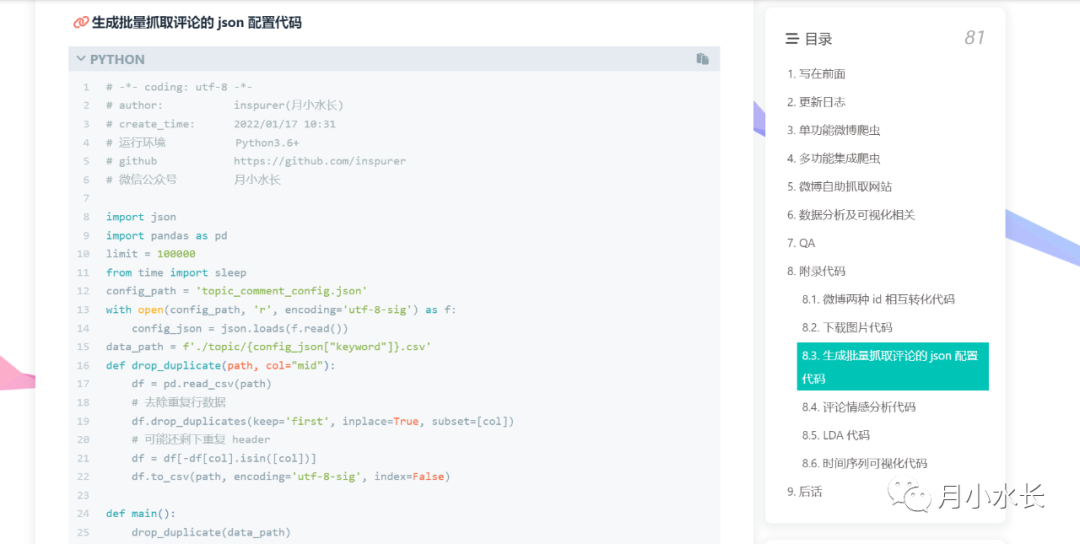

如果你想批量抓取评论,我也写好了对应的脚本工具,包括其他各种上下游边缘工具代码,一并放在了博客的附录代码部分~

4、在浏览器中抓取数据

为了面向部分产品和运营同学,可能不想在本地配置 python 环境,也可以选择在线运行本系列爬虫,比如上面的微博评论,可以选择在以下地址在线抓取。

https://weibo-crawl-visual.buyixiao.xyz/weibo-comment-with-reply-spider你只需要在线点点点就行了,抓取结束可以点击下载 CSV 文件。

这个效果和本地运行几乎一样,但迭代速度会快于本地,因为本地运行我需要再发布,更新后你也需要再重新获取,而网页版本是即时更新的。如果你觉得效果不好,可以尝试另外一条技术路线实现的网页版,这个单条微博最多能抓到几十万条评论。

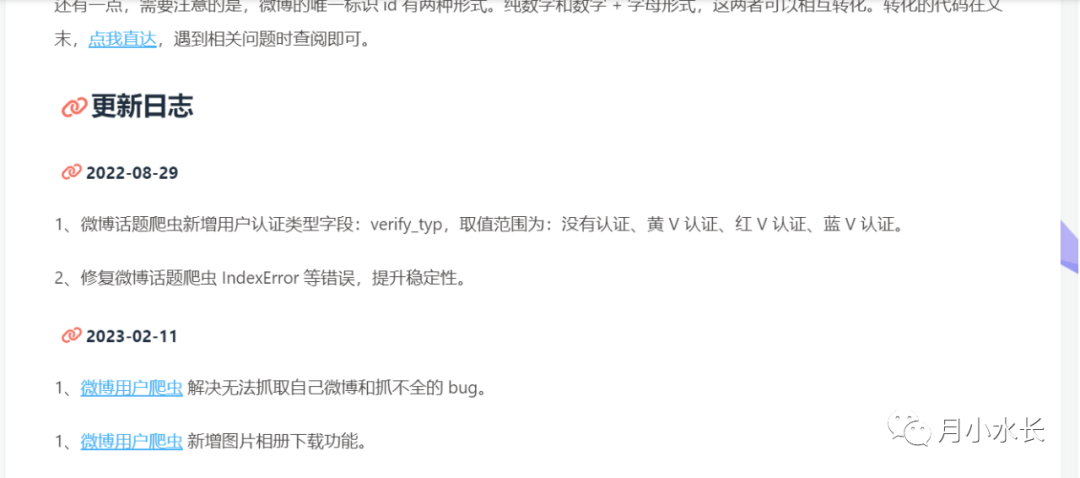

https://weibo-crawl-visual.buyixiao.xyz/weibo-comment-spider这个爬虫配套的教程和网站还有很多未能详尽阐述的,但是道理都类似,一般有新增或者修复我都会更新在对应的博客地址,并附有对应的更新日志。

同时积累了一些常见的 QA,大家可以保存关注,可以 RSS 订阅博客,更新后可立即就能收到推送。

https://buyixiao.github.io/blog/weibo-super-spider.html