Transformer大模型的运行原理

原创一、原理介绍

Transformer是谷歌研究院在2017年提出的一种重要的神经网络结构,目前已广泛应用于自然语言处理领域。它的主要运行原理如下:

- Encoder-Decoder结构

Transformer采用Encoder-Decoder结构。Encoder用于编码输入序列,得到 vector 表示;Decoder用于生成输出序列。Encoder和Decoder都由Multi-Head Attention和Feed Forward Networks组成。

- Multi-Head Attention

Multi-Head Attention允许模型并行地计算多个Attention,这些Attention生成的结果通过拼接后传给下一层。每个Attention都有不同的权重,这允许模型 jointly attend 到信息的不同表示来计算最终的输出。

- Positional Encoding

由于Transformer没有循环结构或卷积结构,所以无法像RNN或CNN一样利用位置信息。为此,Transformer在输入embeddings中添加Positional Encodings来编码位置信息。

- Layer Normalization

Transformer使用Layer Normalization来简化模型,加速训练。Layer Normalization对每一个样本中所有隐层节点的激活值进行标准化。

- Residual Connection

Transformer中每个子层(包括Attention和Feed Forward Networks)都使用残差连接,即将输入值加到子层的输出上。这可以加速训练,并控制 gradient vanishing问题。

- Feed Forward Networks

每个Attention后面会跟一个前馈神经网络,用于映射到高维空间,再映射回来。这一步可以增加模型的非线性能力。

- 其他

包括softmax激活函数、优化器选择、dropout等,这些与一般神经网络类似。

综上,Transformer的主要原理在于Encoder-Decoder结构、Multi-Head Attention机制、Positional Encoding方法以及残差连接和层标准化技术。这些元素共同作用,让Transformer成为深度学习领域具有里程碑意义的模型之一,对各种序列学习任务有着广阔的应用前景。

二、产品介绍

Transformer是一种重要的神经网络结构,由Encoder和Decoder两部分组成。Encoder编码输入信息,得到向量表示。Decoder生成输出序列。

Encoder和Decoder都是由多头注意力机制和前馈神经网络堆叠而成。

多头注意力机制允许模型并行计算多个Attention,获得不同角度的信息,产生最终输出。

由于Transformer没有循环或卷积结构,无法利用位置信息。所以在输入中加入位置编码来表示位置。

Transformer使用层规范化和残差连接来简化模型和加速训练。

每个注意力层后还有一个前馈神经网络,提高非线性能力。

其他还使用Softmax、Dropout等常见机制。

综上,Transformer得益于Encoder-Decoder结构、多头注意力、位置编码、层规范化和残差连接等元素,成为当下最重要的神经网络结构之一,广泛应用于自然语言处理。

之所以Transformer可以理解并回复段落文字,主要是因为:

1) Encoder可以理解输入段落的向量表示,保留语义和结构信息。

2) Decoder生成的输出也是一段一段的,其中每个段落都对应Encoder的某个时间步的输出。

3) 多头注意力机制允许模型捕捉输入段落之间的依赖关系,产生连贯的回复。

4) 位置编码提供了位置信息,Decoder知道在生成的时候应考虑输入的前后关系。

5) 残差连接和层规范化使得模型稳定,可以处理长文本输入。

所以,Transformer之所以可以理解并流畅回复长文本,在于它的结构和机制都考虑了序列学习的需求,尤其是输入输出的连贯性和依赖性。这使其成为自然语言理解的先驱之作。

三、场景应用

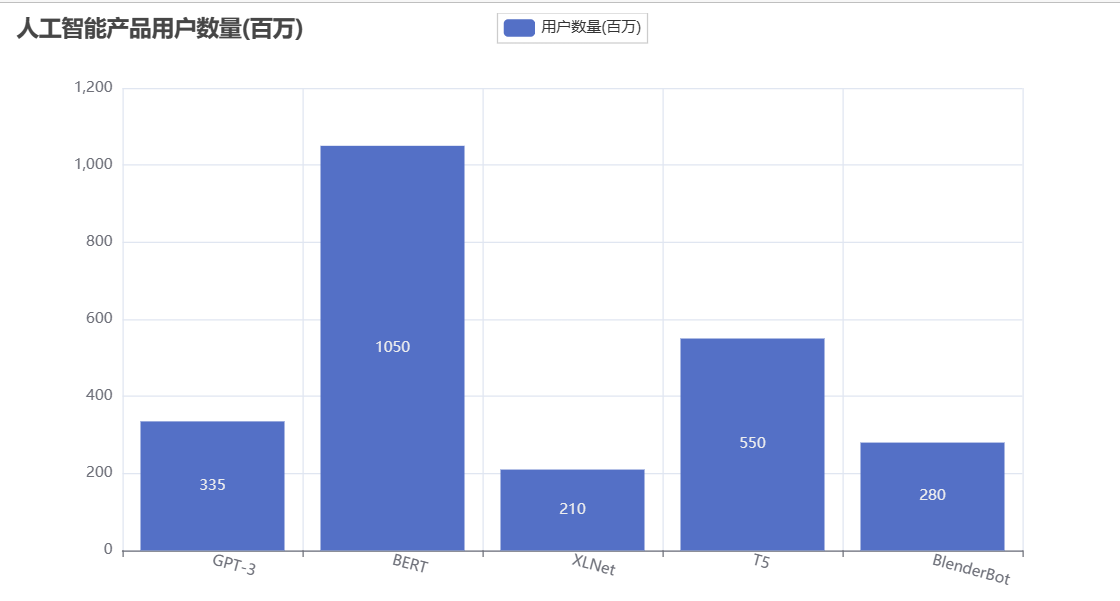

GPT-3(OpenAI):专注语言理解,能自动完成各类写作任务,xn--openai-9i7k537u.com,用户数不公开。

BERT(谷歌):自然语言理解预训练模型,应用于搜索、推荐、机器翻译等,官网bert.dev,用户数10亿+。

XLNet(谷歌):自然语言理解预训练模型,改进了BERT的一些限制,xn--xlnet-zh8iz74s.readthedocs.io,用户数不公开。

T5(谷歌):统一的文本编码器-解码器框架,可应用于多种自然语言处理任务,xn--ai-4d1dw86k.googleblog.com,用户数10亿+。

BlenderBot(Facebook):开源聊天机器人,具有跨越多回合的记忆力和共同知识,xn--parl-pg9g424p.ai,用户数2.8亿。

四、行业应用

GAN(NVIDIA):生成对抗网络,能生成逼真图像,,用户数不详。

VQGAN(研究者):变分自编码器,图像压缩和生成,用户数不详。

CLIP(OpenAI):联合图像和文本的语言表示用户数不详。

DALL·E(OpenAI):生成图像和文本,用户数不详。

Paints Chainer(Sony): 生成动漫人物图像,用户数不详。 (已编辑)

五、客户案例

游戏行业:GANcraft(NVIDIA):生成游戏资,用户数不详。

广告行业:Generative Ads(Anthropic):生成定制化广告,用户数不详。

影视行业:Cinematic AI(Anthropic):生成影视内容,用户数不详。

时装行业:Poetic AI(Poetic):生成时尚产品图像用户数不详。

建筑行业:Dreamscapes(Anthropic):根据场景描述生成3D建筑环境,用户数不详。

这些产品运用GAN、VQGAN等人工智能绘画模型,提供定制化内容生成服务,最大限度释放人工智能在创意设计和作品创作方面的潜力。 各个行业用户可以根据自身需求选择不同的人工智能产品和服务,这必将极大改变传统行业运营模式和创意生产方式。

人工智能绘画模型开启了内容自动生成的大门,它的影响将是深远的。未来,人工智能定制化创意产出将成为更多行业和领域默认选择,创新创业也将聚焦在此。这必将催生出更多创意服务型人工智能产品与平台。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录