NVEdit | 基于现有 T2I 模型的帧间一致长视频编辑方法,北大张健团队提出显存高效的神经视频编辑场

NVEdit | 基于现有 T2I 模型的帧间一致长视频编辑方法,北大张健团队提出显存高效的神经视频编辑场

大家好,今天要介绍的是最近出现的一篇关于文本驱动的视频编辑工作NVEdit(Neural Video Fields Editing)。

详细信息如下:

- 项目地址:https://nvedit.github.io/

- 代码地址:https://github.com/Ysz2022/NVEdit

- 作者:Shuzhou Yang, Chong Mou, Jiwen Yu, Yuhan Wang, Xiandong Meng, Jian Zhang

本文针对现有的基于扩散模型的算法编辑结果存在明显抖动,且受限于显存限制,难以编辑长视频的缺陷,提出了一种显存高效的长视频编辑算法NVEdit,基于现有的T2I模型实现帧间一致的长视频编辑。

具体来说,本文以隐式神经表示显存高效地编码视频信号,并用T2I模型优化神经网络参数,注入编辑效果,实现帧间一致的长视频编辑。

实验证明NVEdit足以编辑几百上千帧的长视频,且编辑效果高度符合文本指令并保留了原始视频的语义布局。

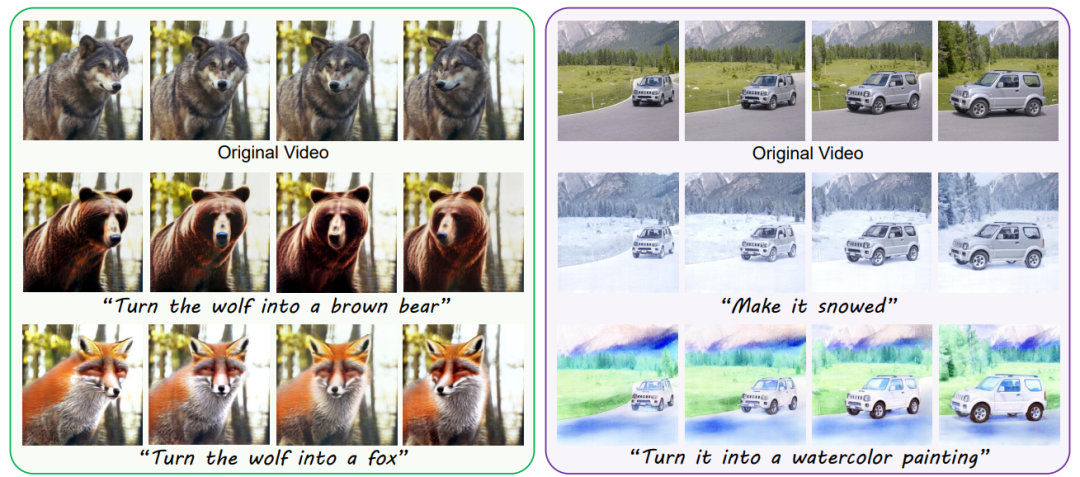

如上图所示,用户可向NVEdit提供文本指令实现帧间一致的高质量视频编辑。比如左侧第一行展示的是狼的视频,用户输入“把狼变成熊的文本”后,NVEdit成功输出一段新的视频(左侧第二行)。

本文方法支持各种编辑操作,包括变形、场景变化和风格迁移等,同时保留原始场景的运动和语义布局。由于其高效的编码率,具有几百上千帧的长视频也可被很好地编辑。

方法概述

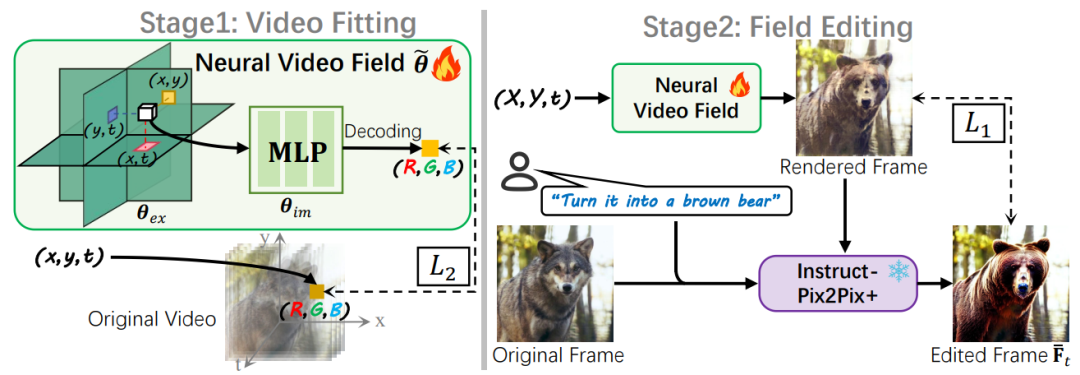

如下图所示,本文方法由两阶段训练组成:视频拟合阶段和场编辑阶段。

在视频拟合阶段,作者先用一个神经网络(Neural Video Field)将视频信号编码为模型参数,学习原视频的运动和语义布局等先验。

在场编辑阶段,作者逐帧地让神经网络渲染出图片,调用现有的T2I模型对渲染帧进行文本驱动编辑,以编辑帧为伪GT优化网络参数,注入编辑效果。

视频拟合阶段

受益于已有的基于神经场的视频编辑算法[1,2],本文选用了一种混合的显隐式编码结构,其将视频建模为一个x-y-t的三维空间,并以三平面和稀疏网格结构显式地编码视频信号。

编码后的特征可由一个定制的轻量级MLP(multilayer perceptron)解码回RGB的像素信号。

在场编辑阶段中,作者令MLP解码的像素与原始视频对应坐标处的像素值一致,实现以神经网络参数记录视频信号的功能。此过程中,模型充分学习了原始视频的运动及语义布局等先验。

场编辑阶段

考虑到T2I算法的蓬勃发展,本文选用现有的T2I模型(Instruct-Pix2Pix[3])为视频编辑提供编辑效果。如图所示,作者逐帧渲染图像,并以原视频对应帧和用户指令为条件,调用T2I模型生成编辑帧。编辑帧可作为伪GT进一步优化上一阶段训练好的神经视频场,从而注入编辑效果。

实验结果

主观结果

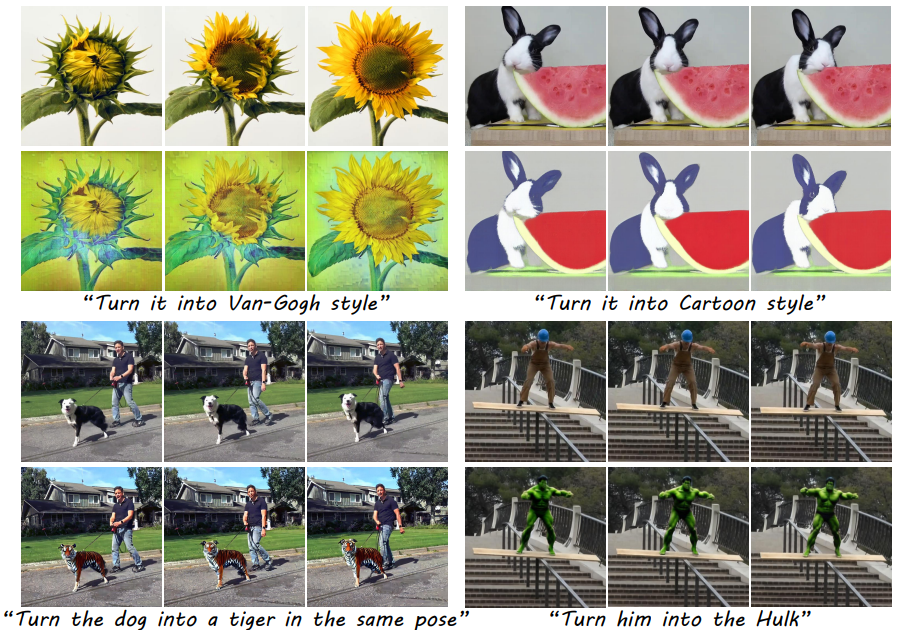

如下图所示,本文展示了四组来自 NVEdit 的视觉结果,它支持多种类型的编辑,包括风格迁移和形状变化。每组结果对应的编辑文本都在下方给出。

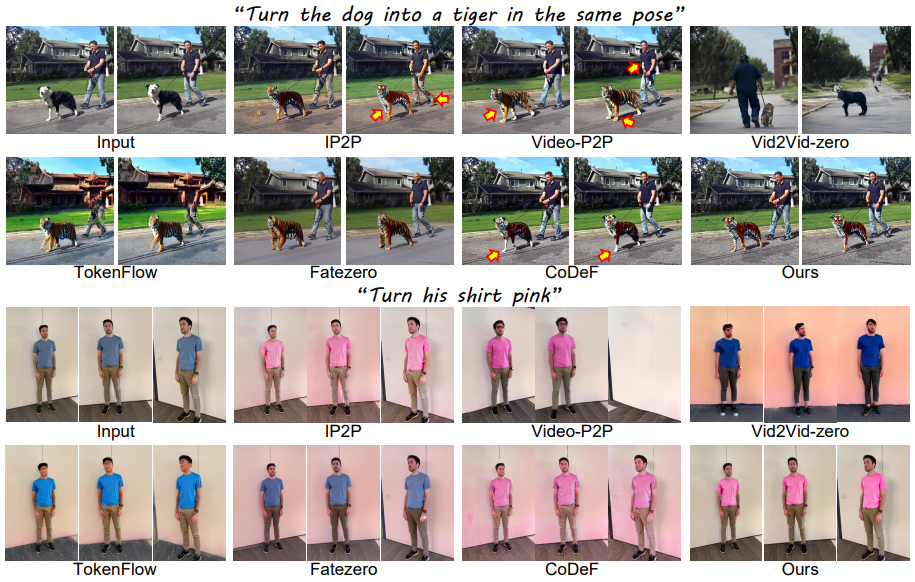

此外,本文也与其他SOTA的文本驱动视频编辑算法做了对比实验。注意由于本文主要选用Instruct-Pix2Pix(IP2P)提供编辑效果,IP2P作为基准模型也被纳入对比范围。

为了尽可能让这个T2I模型生成帧间一致的结果,作者固定了它的随机种子。下图给出了NVEdit和其他 SOTA 方法之间的主观比较。

可以看到IP2P无法输出帧间一致的结果,例如箭头指向的区域的差异。其他方法要么扭曲形状,要么编辑了错误的区域,要么无法在不同的视点上运行稳定。

NVEdit不仅生成时序一致的内容,而且还能精确控制要编辑的区域。

定量结果

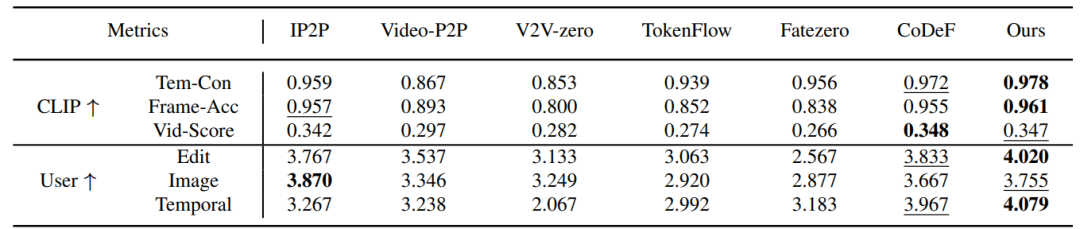

本文还设计了一些定量指标以客观对比不同方法的视频编辑效果。具体来说,作者设计了两组六个指标,分别为由CLIP计算的3个指标:

- Tem-Con:测量帧间一致性。只采用CLIP中的图像编码器,计算所有连续帧对之间的余弦相似度。

- Frame-Acc:逐帧编辑精度,表示编辑视频中与目标文本具有更高的CLIP相似度的帧占总帧数的百分比。

- Vid-Score:编辑帧和目标文本之间的余弦相似度的平均值,表示语义差异。

以及根据21名志愿者打分的3个指标,包括“Edit”、“Image”和“Temporal”。这些指标分别衡量编辑帧和目标文本之间的一致性、编辑帧的图像质量和编辑视频的时间一致性。

结果如下表所示。

显存对比

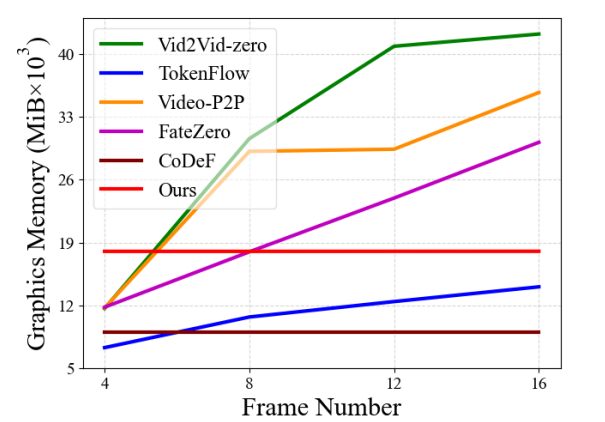

如下图所示,作者在NVIDIA A40显卡上测试了不同的视频编辑算法处理不同帧数时的显存占用情况。

横坐标为视频的帧数,纵坐标为显存开销。可以看到基于扩散模型的方法处理更多帧时都需要更大的显存,而NVEdit和CoDeF的显存开销基本稳定,这是因为他们都是基于隐式神经表示的方法,能实现长视频编辑。

而CoDeF的显存占用比NVEdit还要低一些,这是因为其采用了全隐式的编码方式,而NVEdit基于显-隐式的编码框架(三平面编码与MLP解码)。

以往的工作[4]证明了显-隐式的混合框架比隐式的方案具有更好的表示效果。CoDeF选择将视频内容映射到规范图像,从而可以仅编码运动信息,减少图形内存需求。但是对于变化较大的视频,其内容映射和运动编码往往不准确。

相比之下,本文的方法通过有效的混合结构将内容和运动一起编码解决了这个问题。

其他讨论

更换/改进T2I模型

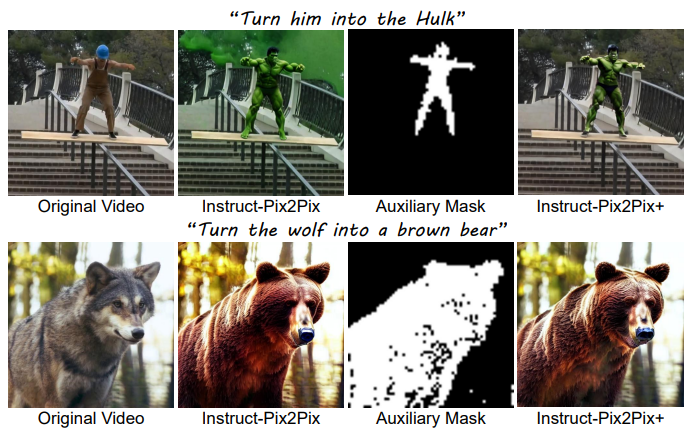

本文还讨论了NVEdit其他有趣的性质,比如可通过更换或改进场编辑阶段调用的T2I模型,实现不同功能或更高质量的图像处理任务。

具体来说,由于NVEdit对视频的编辑效果高度依赖于T2I模型对图像的编辑性能,对T2I模型的改进可有效提升视频编辑效果。

此外,通过将T2I模型更换为其他下游的图像处理算法,NVEdit也能实现不同的视频下游任务。

作者在文中详细阐述了他们对IP2P的改进,提出了Instruct-Pix2Pix+以提升其在局部区域的图像编辑时的编辑性能,IP2P与IP2P+的效果对比如下图所示。

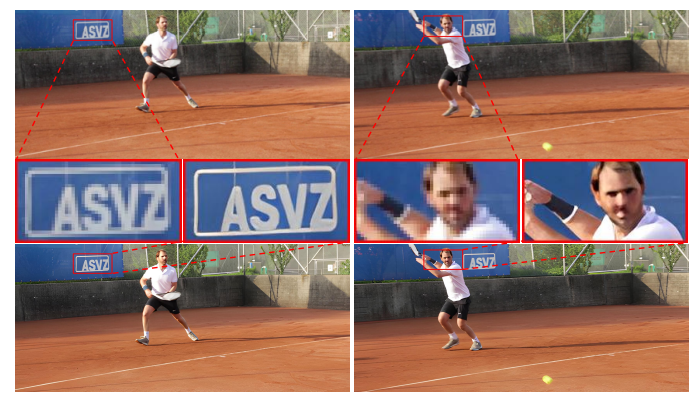

此外,作者还尝试了将T2I模型替换为其他的图像处理算法(如R-ESRGAN [5])使NVEdit实现其他的视频下游任务,训练操作与用T2I模型的流程一样。下图是其对视频进行4倍超分的结果,上行帧来自低分辨率视频,下行帧来自NVEdit最终的输出视频。

神经视频场的其他性质

以往的工作[1,2]已经证明了神经视频场天然具有视频插帧等性质。由于NVEdit基于视频场进行编码及编辑,因此也继承了神经表示的这些性质。

本文主要展示了视频插帧的效果,如下图所示,黄圈中的水滴在第一帧()和第二帧()会有一个从无到有的变化,而NVEdit很好地预测了中间帧()的运动。

此外,该视频是根据“Make it sunset”的文本编辑的,可以看到编辑效果也被很好地传播到了插帧的新图中,即便训练集中并不含有此帧。

参考文献: [1]Hao Chen, Bo He, Hanyu Wang, Yixuan Ren, Ser Nam Lim, and Abhinav Shrivastava. Nerv: Neural representations for videos. In Advances in Neural Information Processing Systems, 2021. [2]Subin Kim, Sihyun Yu, Jaeho Lee, and Jinwoo Shin. Scalable neural video representations with learnable positional features. In Advances in Neural Information Processing Systems, 2022. [3]Tim Brooks, Aleksander Holynski, and Alexei A. Efros. Instructpix2pix: Learning to follow image editing instructions. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2023. [4]Eric R. Chan, Connor Z. Lin, Matthew A. Chan, Koki Nagano, Boxiao Pan, Shalini De Mello, Orazio Gallo, Leonidas J. Guibas, Jonathan Tremblay, Sameh Khamis, Tero Karras, and Gordon Wetzstein. Efficient geometryaware 3d generative adversarial networks. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2022. [5]Xintao Wang, Liangbin Xie, Chao Dong, and Ying Shan. Real-esrgan: Training real-world blind super-resolution with pure synthetic data. In Proceedings of the IEEE/CVF International Conference on Computer Vision Workshops, 2021.

实验室简介: 视觉信息智能学习实验室(VILLA)由张健助理教授在2019年创立并负责,致力于AI内容生成与安全、底层视觉、三维场景理解等研究方向,已在CVPR、ICCV、ECCV、NeurIPS、ICLR、TPAMI、TIP、IJCV、AAAI等高水平国际期刊会议上发表成果50余篇。VILLA在图像合成与编辑领域发布多款爆火技术和产品,包括T2I-Adapter、DragonDiffusion、FreeDoM。其中T2I-Adapter已被AIGC领域的独角兽公司Stability AI与其旗舰模型StableDiffusion-XL结合,推出涂鸦生成产品Stable Doodle。近期,VILLA在AIGC内容生成和安全方面推出了多项工作,包括零样本图生视频新方法AnimateZero,联合篡改定位与版权保护的多功能图像水印EditGuard,扩散隐写新范式CRoSS,基于物理的动态人机交互模拟框架PhysHOI,渐进式3D内容生成框架Progressive3D等。 更多信息可关注: 实验室主页:https://villa.jianzhang.tech/ 张健老师主页:https://jianzhang.tech/

END