揭秘NanoGPT模型切片技术:如何高效共享推理算力,加速AI应用落地

原创揭秘NanoGPT模型切片技术:如何高效共享推理算力,加速AI应用落地

原创

目录

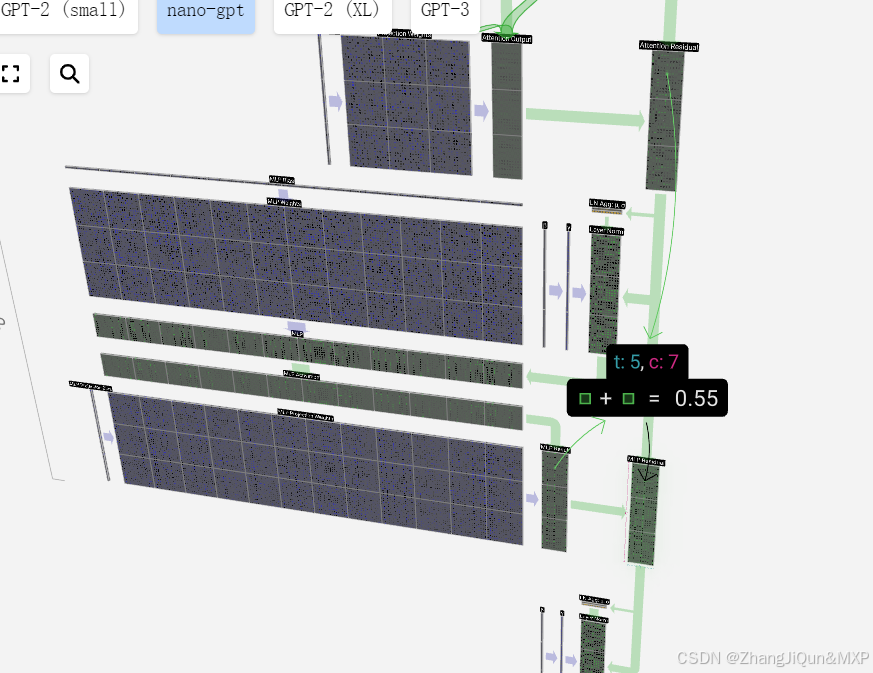

nanogpt怎么进行模型切片,以实现推理过程算力共享,切多头

由于transformer的矩阵参数结构,每一个多头都能独立运行输出结果,因此模型切片是可以从头到尾执行完成的

nanogpt怎么进行模型切片,以实现推理过程算力共享,切多头

nanogpt在进行模型切片以实现推理过程算力共享,并特别关注多头注意力机制时,可以采用多种策略来优化资源的分配和利用。以下是一些可能的方法:

1. 多头并行与数据并行结合

在nanogpt的推理过程中,可以结合多头并行和数据并行来提高算力共享的效率。具体地,每个GPU或计算设备可以处理输入数据的一部分,并在这些设备上并行地执行多头注意力机制。由于多头注意力允许每个头独立地处理输入并生成输出,因此可以在单个设备上并行化多个头的计算,而在多个设备之间并行化数据处理。

2. 模型切片策略

对于nanogpt模型的切片,可以考虑以下几种策略:

- 层间切片:将模型的不同层分配到不同的计算设备上。这种策略需要确保层间的数据传输高效且不会成为瓶颈。例如,可以将模型的前几层放在一个GPU上,而后几层放在另一个GPU上,并在两个GPU之间传输层间的输出。

- 参数切片:对于具有大量参数的层(如全连接层或某些特定层中的多头注意力组件),可以考虑将参数切分到多个设备上。然而,由于Transformer模型中的多头注意力通常不会单独占据大量参数(相对于整个模型而言),因此这种策略可能更适用于其他类型的层。

- 动态切片:根据实时负载和资源可用性动态调整模型切片。这种策略需要复杂的调度和资源管理机制,但在某些情况下可能能够提高整体效率和响应速度。

3. 多头并行实现

在多头注意力机制中,每个头都可以独立地处理输入并生成输出。为了实现多头并行,可以将每个头的计算任务分配给不同的计算单元(如GPU中的不同线程或核心)。这样,多个头可以同时处理输入数据,从而提高整体的计算效率。

4. 注意事项

- 通信开销:在多个计算设备之间传输数据时会产生通信开销。为了最小化这种开销,需要优化数据传输策略,如使用高效的通信协议和减少不必要的数据传输。

- 负载均衡:确保不同计算设备之间的负载相对均衡,以避免某些设备过载而其他设备空闲的情况。

- 同步问题:在并行计算中,需要确保不同计算单元之间的同步,以确保最终结果的正确性。

编辑

5. 示例说明

假设我们有一个nanogpt模型,该模型包含多个Transformer层,并且我们想要在两个GPU上进行模型切片以实现推理过程的算力共享。我们可以将模型的前半部分(包括多个Transformer层及其中的多头注意力机制)放在一个GPU上,而将后半部分放在另一个GPU上。在推理过程中,输入数据首先被发送到第一个GPU,该GPU处理前半部分模型并生成中间输出。然后,这些中间输出被传输到第二个GPU,由该GPU处理后半部分模型并生成最终输出。通过这种方式,两个GPU可以并行地处理输入数据的不同部分,从而实现算力共享和加速推理过程。

请注意,上述示例是基于一般原理和深度学习框架的并行处理能力进行的说明,并非nanogpt的特定实现细节。在实际应用中,需要根据nanogpt的具体实现和计算环境来设计合适的模型切片策略。

大语言模型推理过程中多头切片运行,是从头到尾全部并行执行

在nanoGPT的推理过程中,模型切片运行并不等同于从头到尾全部并行执行。下面我将详细解释这一点:

1. 模型切片运行的概念

模型切片运行(Sharding)通常指的是将大型模型或数据集分割成更小的部分(或“片”),以便在多个计算设备(如CPU、GPU或TPU)上并行处理。这种策略可以显著提高模型的推理速度,尤其是在处理大规模数据集或复杂模型时。

2. nanoGPT的特点

nanoGPT是一个旨在简化和加速中型语言模型训练过程的开源库,它基于PyTorch等轻量级但强大的库实现。nanoGPT的设计初衷是在资源有限的情况下也能实现高效的语言模型训练和推理。因此,它可能采用了多种优化策略来提高性能,包括模型切片运行。

3. 并行执行与切片运行的区别

并行执行通常指的是在同一时间点上,多个任务或计算单元同时执行,以提高整体处理速度。而在nanoGPT的推理过程中,虽然可能会采用并行处理技术(如GPU并行计算),但模型切片运行更多是指将模型或数据分割成小块,以便在多个计算单元上并行处理,而不是指整个模型从头到尾的每一个步骤都是并行执行的。

4. nanoGPT中的并行处理

在nanoGPT中,并行处理可能主要体现在以下几个方面:

- 多头注意力机制:Transformer模型中的多头注意力机制允许模型在不同的表示子空间上并行地关注输入的不同部分,这是模型内部的一种并行处理方式。

- 数据并行:将输入数据分割成多个批次,每个批次在独立的计算设备上并行处理。

- 模型并行:在极端情况下,如果模型太大以至于无法完全放入单个计算设备的内存中,可以将模型的不同部分分配到不同的计算设备上并行处理。然而,这通常不是nanoGPT这种中型模型的主要考虑因素。

5. 结论

综上所述,nanoGPT在推理过程中可能会采用模型切片运行等并行处理策略来提高性能,但这并不意味着模型从头到尾的每一个步骤都是并行执行的。实际上,模型的执行通常还涉及到顺序的层间传递和数据处理步骤。因此,在回答“nanoGpt 推理中模型切片运行,是从头到尾全部并行执行?”的问题时,答案是否定的。

由于transformer的矩阵参数结构,每一个多头都能独立运行输出结果,因此模型切片是可以从头到尾执行完成的

在Transformer模型中,多头注意力(Multi-Head Attention)的设计确实允许每个“头”独立地计算注意力分数并产生输出。然而,将这一特性直接等同于“模型切片可以从头到尾执行完成”可能有些误导,因为这里涉及到了几个不同层面的并行和切片概念。

首先,多头注意力内部的并行性确实存在,每个头独立地处理输入的一部分,并生成该部分的注意力权重和输出。但是,这种并行性是在单个注意力层内部发生的,而不是在整个模型层面。

其次,当谈到“模型切片”时,我们通常指的是将模型的不同部分(如层、参数块等)或输入数据分割成小块,以便在多个计算设备上并行处理。在Transformer模型中,虽然理论上可以将不同的层或注意力头分配到不同的计算设备上,但这并不意味着整个模型可以“从头到尾”地完全独立并行执行,因为层与层之间、头与头之间以及模型的其他部分(如编码器-解码器架构中的交互)通常需要顺序的数据流和计算。

此外,即使每个头都能独立地输出结果,这些输出也需要被合并(通常是通过拼接和线性变换)以形成该层的最终输出。这一合并过程通常是在所有头完成计算之后进行的,因此它本身不是并行的。

最后,虽然模型切片和并行处理可以显著提高模型的训练和推理速度,但它们通常受到计算设备、内存限制、通信开销等多种因素的制约。在实际应用中,需要仔细设计模型的切片和并行策略,以确保它们能够有效地提高性能,而不会引入过多的额外开销。

综上所述,虽然Transformer模型中的多头注意力允许每个头独立地运行并输出结果,但模型切片并不能简单地等同于“从头到尾执行完成”。相反,它涉及到了多个层面的并行和切片策略,需要综合考虑模型的架构、计算资源以及性能需求。

nanogpt怎么进行模型切片,以实现算力共享

nanogpt进行模型切片以实现算力共享,主要依赖于分布式计算和并行处理技术。在深度学习领域,尤其是处理大型语言模型时,模型切片和算力共享是提高训练效率和推理速度的重要手段。以下是一个关于nanogpt如何进行模型切片以实现算力共享的示例说明:

1. 模型切片的概念

模型切片(Sharding)是指将大型模型分割成较小的部分(或“片”),以便在多个计算设备上并行处理。这些计算设备可以是CPU、GPU或TPU等。通过模型切片,可以充分利用多设备的算力资源,加速模型的训练和推理过程。

2. nanogpt的模型切片策略

虽然nanogpt本身可能没有直接提供内置的模型切片工具或框架,但我们可以根据PyTorch等深度学习框架的并行处理能力,结合nanogpt的模型结构,设计适合的模型切片策略。以下是一些可能的策略:

- 层级切片:将Transformer模型的多个层分配到不同的计算设备上。例如,将前几个层放在一个GPU上,后几个层放在另一个GPU上。这样,每个GPU可以独立地处理其负责的层,并通过网络或内存传输层间的输出和输入。

- 参数切片:对于特别大的层(如嵌入层或全连接层),可以将其参数分割成多个部分,并分配到不同的计算设备上。每个设备负责计算参数的一部分,然后将结果合并以得到最终的输出。

- 数据并行:虽然这不是模型切片,但它是实现算力共享的重要手段。通过数据并行,可以将输入数据分割成多个批次,并在多个计算设备上同时处理。这样,每个设备都在处理不同的数据批次,从而提高了整体的处理速度。

3. 举例说明

假设我们有一个nanogpt模型,该模型包含多个Transformer层,并且我们想要在两个GPU上进行模型切片以实现算力共享。我们可以按照以下步骤进行:

- 模型划分:首先,确定每个GPU将负责哪些层。例如,我们可以将前一半层分配给GPU1,后一半层分配给GPU2。

- 数据准备:准备输入数据,并将其分割成多个批次。这些批次将被发送到不同的GPU上进行处理。

- 并行处理:在每个GPU上,独立地处理分配给它的层。对于GPU1,它将处理输入数据通过前一半层,并将输出发送到GPU2(如果后续层在GPU2上)。对于GPU2,它将接收来自GPU1的输出(或直接从输入数据开始,如果它是第一个处理的GPU),并处理剩余的后一半层。

- 结果合并:如果模型需要跨层的结果(如编码器-解码器架构中的交互),则需要将不同GPU上的结果合并。这通常涉及到网络通信或内存共享。

- 输出生成:最后,将所有GPU上的输出合并以生成最终的模型输出。

4. 注意事项

- 在进行模型切片时,需要仔细考虑层与层之间的依赖关系和数据流,以确保切片的合理性和正确性。

- 通信开销是模型切片中的一个重要问题。在多个计算设备之间传输数据时,可能会产生显著的延迟和带宽限制。因此,需要优化通信策略以减少开销。

- 分布式训练框架(如PyTorch的DistributedDataParallel或Horovod)可以提供更高级的模型切片和算力共享功能,可以考虑使用这些框架来简化实现过程。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。