mixtral大模型

原创mixtral大模型

原创

霍格沃兹测试开发Muller老师

发布于 2024-10-16 17:49:39

发布于 2024-10-16 17:49:39

简介

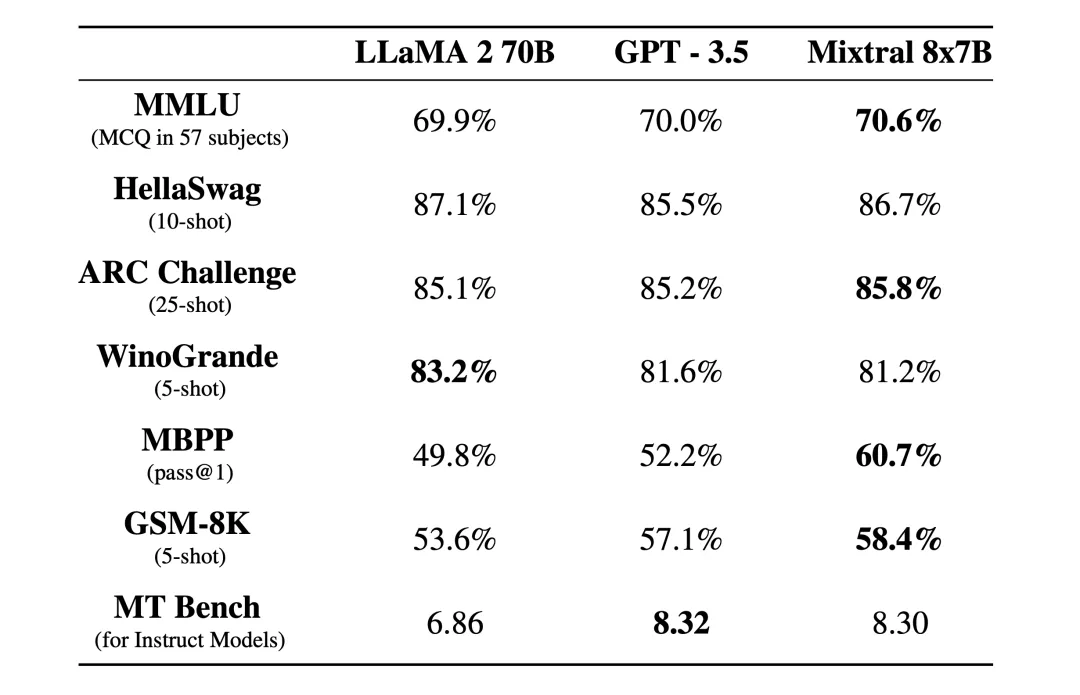

Mixtral 是一种具有开放权重的高质量稀疏专家混合模型 (SMoE)。根据 Apache 2.0 许可。 Mixtral 在大多数基准测试中都优于 Llama 2 70B,推理速度提高了 6 倍。它是最强大的开放权重模型,具有宽松的许可证,也是成本/性能权衡方面的最佳模型。特别是,它在大多数标准基准测试中匹配或优于 GPT3.5。

Mixtral 的特点

- 可以优雅地处理 32k 令牌的上下文。

- 可以处理英语、法语、意大利语、德语和西班牙语。

- 在代码生成方面表现出强大的性能。

基于 Hugging Face Transformers 使用 mixtral

## Use a pipeline as a high-level helper

from transformers import pipeline

def test_mixtral():

pipe = pipeline("text-generation", model="mistralai/Mixtral-8x7B-Instruct-v0.1")

pipe("请为google编写web自动化测试用例,使用pytest page object设计模式,断言使用hamcrest"))使用 langchain 调用 mixtral

def test_mixtral():

llm = Ollama(model="mixtral", base_url="http://localhost:11434")

r = llm.invoke('请为google编写web自动化测试用例,使用pytest page object设计模式,断言使用hamcrest')

debug(r)总结

Mixtral 是一种具有开放权重的高质量稀疏专家混合模型。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录