生成式AI新星:DeepSeek-V3 与 GPT-4o 的对比分析

原创

image.png

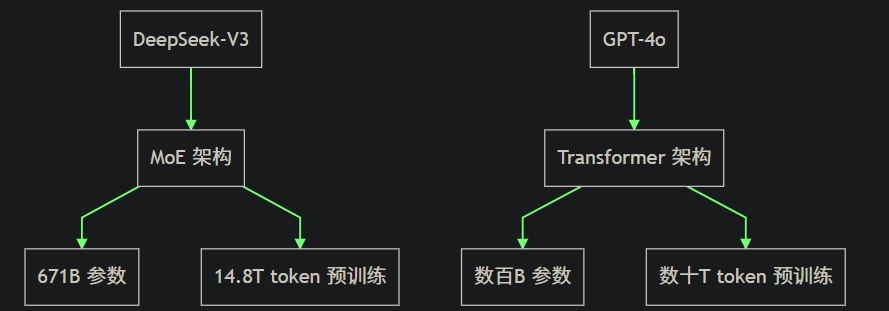

DeepSeek-V3 是 DeepSeek 公司推出的最新一代自研 MoE(Mixture of Experts)模型,拥有 671B 参数,激活 37B,并在 14.8T token 上进行了预训练。GPT-4o 是 OpenAI 推出的顶尖闭源模型,以其强大的通用性和多模态能力著称。以下将从多个维度对 DeepSeek-V3 和 GPT-4o 进行详细对比。

1. 模型架构

DeepSeek-V3

- 架构类型: MoE(Mixture of Experts)

- 参数规模: 671B 参数,激活 37B

- 预训练数据: 14.8T token

GPT-4o

- 架构类型: Transformer

- 参数规模: 具体参数未公开,但预计在数百B级别

- 预训练数据: 未公开,但预计在数十T token级别

2. 性能表现

知识类任务

- DeepSeek-V3: 在 MMLU, MMLU-Pro, GPQA, SimpleQA 等知识类任务上表现接近 Claude-3.5-Sonnet-1022。

- GPT-4o: 在知识类任务上表现优异,尤其在复杂推理和知识检索方面。

长文本处理

- DeepSeek-V3: 在 DROP, FRAMES, LongBench v2 等长文本测评中平均表现超越其他模型。

- GPT-4o: 在长文本处理方面表现稳定,能够处理复杂的上下文信息。

代码生成

- DeepSeek-V3: 在算法类代码场景(Codeforces)中领先,工程类代码场景(SWE-Bench Verified)逼近 Claude-3.5-Sonnet-1022。

- GPT-4o: 在代码生成和调试方面表现出色,尤其在复杂算法和工程代码场景中。

数学能力

- DeepSeek-V3: 在美国数学竞赛(AIME 2024, MATH)和全国高中数学联赛(CNMO 2024)上大幅超过所有开源和闭源模型。

- GPT-4o: 在数学竞赛和复杂数学问题解决方面表现优异。

中文能力

- DeepSeek-V3: 在教育类测评 C-Eval 和代词消歧等评测集上表现相近,但在事实知识 C-SimpleQA 上更为领先。

- GPT-4o: 在中文处理方面表现稳定,能够处理复杂的中文语境和知识检索。

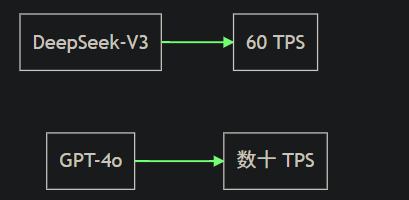

3. 生成速度

- DeepSeek-V3: 生成吐字速度从 20 TPS 大幅提高至 60 TPS,相比 V2.5 模型实现了 3 倍的提升。

- GPT-4o: 生成速度未公开,但预计在数十 TPS 级别。

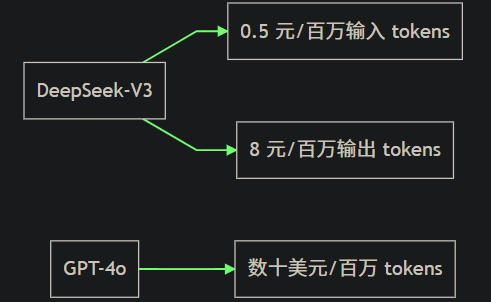

4. API 服务价格

- DeepSeek-V3: 每百万输入 tokens 0.5 元(缓存命中)/ 2 元(缓存未命中),每百万输出 tokens 8 元。

- GPT-4o: 具体价格未公开,但预计在每百万 tokens 数十美元级别。

5. 开源与闭源

- DeepSeek-V3: 开源了原生 FP8 权重,支持社区适配和拓展应用场景。

- GPT-4o: 闭源模型,未公开权重和具体实现细节。

6. 未来展望

- DeepSeek-V3: 将继续在基座模型上打造深度思考、多模态等更加丰富的功能,并持续与社区分享最新的探索成果。

- GPT-4o: 预计将继续在多模态和复杂任务处理方面进行优化和升级。

总结

DeepSeek-V3 在多个领域展现出了与 GPT-4o 不相上下的性能,尤其在生成速度和中文能力方面表现突出。同时,DeepSeek-V3 的开源策略也为社区提供了更多的灵活性和拓展空间。未来,随着 DeepSeek-V3 的持续优化和功能扩展,其与 GPT-4o 的竞争将更加激烈。

通过以上对比分析,可以看出 DeepSeek-V3 在多个维度上都具备与 GPT-4o 竞争的实力,未来有望在更多应用场景中发挥重要作用。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录