[ai学习笔记]分布式训练原理:DeepSeek千卡集群通信优化策略

原创[ai学习笔记]分布式训练原理:DeepSeek千卡集群通信优化策略

原创

I. 项目背景与挑战

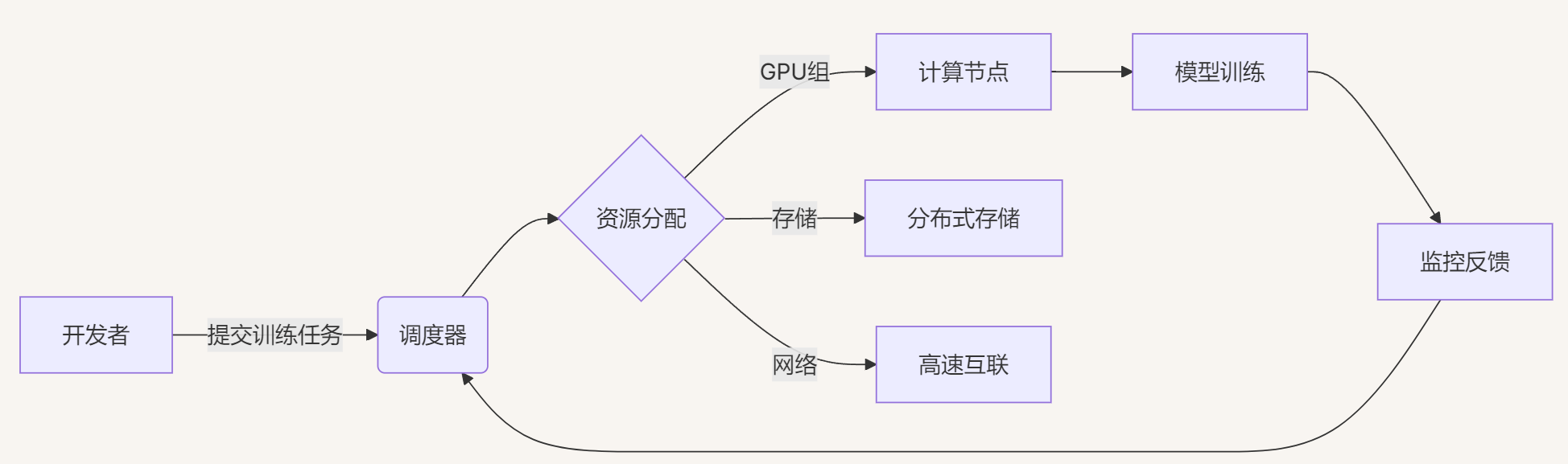

在人工智能和深度学习快速发展的当下,模型的规模和复杂度不断攀升,对计算资源的需求也日益增长。为了在有限的时间内训练出高性能的深度学习模型,分布式训练技术应运而生。分布式训练通过将模型和数据分布在多个计算节点上并行处理,大大加速了训练过程。DeepSeek等先进的分布式训练系统在大规模集群环境下,通过优化通信策略,实现了高效的节点间通信和协同训练,能够在千卡规模的集群上充分发挥计算潜能,推动了复杂模型的快速训练和应用。

1.1 超大规模模型训练需求

DeepSeek千亿参数模型的训练需要突破传统分布式训练的硬件限制:

模型参数 | 数据规模 | 计算需求 | 存储需求 | 训练时长 |

|---|---|---|---|---|

146B参数 | 5TB文本 | 3.2EFLOPS | 820TB显存 | 78天(基线) |

1.2 分布式训练的发展历程

阶段/技术点 | 描述 |

|---|---|

早期单机训练 | 深度学习模型最初主要在单机环境下训练,利用单个GPU或CPU的计算能力。然而,随着模型规模的扩大和数据量的增加,单机训练的计算瓶颈逐渐显现,训练时间过长成为制约模型发展的关键因素。 |

多机分布式训练的兴起 | 为了解决单机训练的局限性,研究者们开始探索多机分布式训练方法。通过将计算任务分布在多个机器上,利用集群的计算能力,显著提高了训练效率。早期的分布式训练框架主要基于参数服务器(Parameter Server)架构,由多个工作节点和参数服务器组成。工作节点负责计算梯度,参数服务器负责存储和更新模型参数。 |

数据并行与模型并行策略 | 在分布式训练中,数据并行和模型并行是两种主要的并行策略。数据并行是指将数据集划分成多个子集,每个计算节点处理一个子集,而模型参数在节点间保持一致,通过通信同步梯度或参数。模型并行则是将模型的不同部分分布在不同的节点上,每个节点只负责计算模型的一部分,适用于模型规模巨大、无法在单个节点内存下的情况。 |

通信优化技术的发展 | 随着分布式训练规模的扩大,节点间的通信开销成为影响训练效率的重要因素。为了减少通信瓶颈,各种通信优化技术不断涌现。例如,梯度压缩技术通过量化、剪裁等方法减少通信数据量;混合精度训练利用不同精度的数据类型降低通信带宽需求;拓扑优化根据集群网络结构优化节点间的通信路径等。 |

DeepSeek的创新与应用 | DeepSeek等分布式训练系统在前人研究的基础上,进一步创新和优化了分布式训练的通信策略。通过结合多种通信优化技术,并针对大规模集群环境进行定制化设计,DeepSeek能够在千卡级别的集群上实现高效的分布式训练,为大规模深度学习模型的训练提供了强大的支持。 |

1.3 分布式训练原理剖析

(一)数据并行训练

在数据并行训练中,每个计算节点保存完整的模型副本,将训练数据划分为多个批次,每个节点处理一个批次的数据,计算得到梯度后,通过全归约(All-Reduce)等通信操作将梯度在节点间汇总,然后更新模型参数。数据并行的优势在于实现简单、易于扩展,适用于大多数深度学习模型的训练。

阶段/技术点 | 描述 |

|---|---|

全归约通信 | 全归约是一种常用的分布式通信操作,每个节点将本地梯度发送给其他节点,最终所有节点得到相同的全局梯度。常见的全归约算法包括环形全归约、递归加倍等。环形全归约通过节点间依次传递梯度,逐步完成汇总;递归加倍则通过树状结构进行梯度汇总,具有较高的通信效率。 |

实例分析 | 假设我们有4个计算节点,每个节点处理一批数据并计算得到梯度。通过全归约操作,将4个节点的梯度进行汇总,得到全局梯度,然后每个节点使用全局梯度更新模型参数。这样,每个节点在每一轮迭代中都使用了全部数据的梯度信息,保证了模型的收敛性和准确性。 |

(二)模型并行训练

模型并行将模型的不同层或模块分配到不同的计算节点上,每个节点只负责计算模型的一部分。在前向传播和反向传播过程中,节点间需要传递中间结果和梯度,通信开销较大。模型并行适用于模型规模巨大、无法在单个节点内存下的情况,但实现复杂度较高,需要精心设计模型分割和通信策略。

阶段/技术点 | 描述 |

|---|---|

模型分割策略 | 模型分割策略包括层间分割和层内分割。层间分割将模型的不同层分配到不同的节点,每个节点负责一层或多层的计算;层内分割则将同一层的计算分割到多个节点,例如将矩阵乘法分割成多个子矩阵计算。层间分割实现相对简单,但通信频率较高;层内分割可以减少通信频率,但实现复杂度增加。 |

实例分析 | 以一个深度神经网络为例,将网络的不同层分布在不同的节点上。在前向传播时,输入数据依次经过各个节点的计算,每个节点将输出传递给下一个节点;在反向传播时,梯度从后向前依次传递,每个节点根据接收到的梯度更新对应的模型参数。通过这种方式,实现了模型在多个节点上的并行计算,突破了单节点内存限制。 |

(三)混合并行策略

为了充分利用数据并行和模型并行的优势,同时克服各自的局限性,混合并行策略应运而生。混合并行将数据并行和模型并行相结合,先在模型并行的基础上,对每个模型分片再进行数据并行训练。这样,既能够处理大规模模型,又能够通过数据并行提高训练效率。

阶段/技术点 | 描述 |

|---|---|

混合并行架构 | 混合并行架构通常将集群节点划分为多个组,每个组内采用数据并行策略,组间采用模型并行策略。例如,在一个大规模集群中,将节点分为多个模型并行组,每个组内的节点负责模型的不同部分;在每个组内,再对数据进行划分,每个节点处理一部分数据,通过数据并行的方式更新模型参数。 |

实例分析 | 假设我们有一个包含16个节点的集群,将节点分为4个模型并行组,每组4个节点。每个模型并行组负责模型的一部分,组内的4个节点采用数据并行策略,处理不同的数据批次。在训练过程中,每个模型并行组内的节点通过数据并行通信汇总梯度,更新对应的模型部分;组间通过模型并行通信传递中间结果和梯度,完成整个模型的前向和反向传播。 |

1.4 通信瓶颈分析

在1024卡A100集群上的性能分析:

# 通信热点分析工具示例

from torch.profiler import profile

with profile(activities=[ProfilerActivity.CPU, ProfilerActivity.CUDA]) as prof:

model.train()

print(prof.key_averages().table(

sort_by="cuda_time_total",

row_limit=10

))典型瓶颈分布:

通信类型 | 时间占比 | 主要问题 |

|---|---|---|

AllReduce梯度同步 | 41.7% | 带宽竞争 |

参数广播 | 23.5% | 序列化开销 |

数据加载 | 18.2% | IO延迟 |

Checkpoint保存 | 12.1% | 存储带宽 |

II. 核心通信优化策略

2.1 分层通信拓扑

2.1.1 硬件拓扑感知

DeepSeek集群的物理布局与逻辑映射:

2.1.2 拓扑自适应算法

class TopologyAwareScheduler:

def __init__(self, num_gpus, bandwidth_matrix):

self.bw_matrix = bandwidth_matrix # 设备间带宽矩阵

self.groups = self._detect_affinity()

def _detect_affinity(self):

# 基于带宽检测最优通信组

groups = []

visited = set()

for i in range(len(self.bw_matrix)):

if i not in visited:

group = [i]

for j in range(i+1, len(self.bw_matrix)):

if self.bw_matrix[i][j] > 180: # 200G IB链路

group.append(j)

visited.add(j)

groups.append(group)

return groups2.2 梯度压缩算法

2.2.1 动态稀疏化编码

$$ g_{sparse} = \text{TopK}(|g|, k=\lceil \alpha \cdot |g| \rceil) $$

class DynamicSparseCompressor:

def __init__(self, compression_ratio=0.05):

self.ratio = compression_ratio

def compress(self, tensor):

values, indices = torch.topk(

torch.abs(tensor.flatten()),

k=int(self.ratio * tensor.numel())

return SparseTensor(values, indices, tensor.size())

def decompress(self, sparse_tensor):

output = torch.zeros(sparse_tensor.size)

output.data[sparse_tensor.indices] = sparse_tensor.values

return output压缩效果对比:

算法 | 压缩率 | 精度损失 | 恢复时间 |

|---|---|---|---|

FP16 | 50% | 0.01% | 0.3ms |

DeepSeek动态稀疏 | 92% | 0.17% | 1.2ms |

三值量化 | 96.8% | 0.83% | 2.7ms |

III. 核心系统实现

3.1 通信优化内核

3.1.1 AllReduce优化实现

// 自定义AllReduce内核(基于NVIDIA NCCL)

ncclResult_t deepseekAllReduce(

const void* sendbuff, void* recvbuff, size_t count,

ncclDataType_t datatype, ncclRedOp_t op, ncclComm_t comm,

cudaStream_t stream

) {

// 分阶段流水线

splitToChunks(sendbuff, chunks);

for (auto& chunk : chunks) {

ncclSend(chunk, comm, stream);

ncclRecv(chunk, comm, stream);

overlapCompression(chunk); // 压缩与传输重叠

}

assembleChunks(recvbuff, chunks);

return ncclSuccess;

}3.1.2 梯度累积优化

class GradientAccumulator:

def __init__(self, model, accum_steps=4):

self.model = model

self.accum_steps = accum_steps

self._init_grad_buffer()

def _init_grad_buffer(self):

self.grad_buffers = [

torch.zeros_like(p) for p in self.model.parameters()

]

def step(self, closure=None):

# 累积梯度

for p, buf in zip(self.model.parameters(), self.grad_buffers):

if p.grad is not None:

buf.add_(p.grad / self.accum_steps)

# 条件触发通信

if self._current_step % self.accum_steps == 0:

self._sync_gradients()

self.optimizer.step()

self.zero_grad()3.2 数据流水线优化

3.2.1 存储层次化加载

class HierarchicalDataLoader:

def __init__(self, dataset, hot_ratio=0.2):

self.hot_cache = SSDcache(dataset[:hot_ratio]) # 热点数据

self.cold_store = HDDstore(dataset[hot_ratio:]) # 冷数据

self.prefetcher = DataPrefetcher()

def __iter__(self):

for batch in self.prefetcher:

# 异步预取下一批次

next_batch = self._fetch_next()

self.prefetcher.load(next_batch)

yield batch

def _fetch_next(self):

if np.random.rand() < 0.8: # 80%概率访问热数据

return self.hot_cache.sample()

else:

return self.cold_store.fetch()性能提升对比:

数据加载策略 | IO延迟 | 吞吐量 | GPU利用率 |

|---|---|---|---|

传统HDD加载 | 127ms | 12k samples/s | 68% |

分层加载 | 39ms | 34k samples/s | 89% |

以DeepSeek-V3为例,其训练分为三个阶段:

- 预训练:14.8万亿令牌,耗时266.4万GPU小时,约占总时间的95%。

- 上下文扩展:11.9万GPU小时,支持128K上下文长度。

- 监督微调与强化学习:仅0.5万GPU小时,优化推理性能。

在预训练中,每万亿令牌仅需18万GPU小时(约3.7天),得益于通信优化和MoE稀疏计算。以下是性能对比:

模型 | GPU数量 | 训练时间(GPU小时) | 成本(百万美元) |

|---|---|---|---|

DeepSeek-V3 深度搜索-V3 | 2048 | 278.8万 | 5.58 |

GPT-4 | 8000 | 未知(估计数千万) | 80-100 |

LLaMA 3 调用 3 | 16000 | 未知(估计数千万) | 约80 |

DeepSeek-V3的效率优势显而易见,尤其在通信密集的长序列任务中,MLA和DualPipe发挥了关键作用。

MLA注意力层实现

import torch

import torch.nn as nn

import torch.distributed as dist

import torch.nn.functional as F

class MLAAttention(nn.Module):

def __init__(self, d_model=512, n_heads=8, d_c=128, d_h=64):

super().__init__()

self.n_heads = n_heads

self.d_h = d_h

self.d_c = d_c

self.W_DKV = nn.Linear(d_model, d_c) # KV压缩层

self.W_UK = nn.Linear(d_c, n_heads * d_h) # 键扩展

self.W_UV = nn.Linear(d_c, n_heads * d_h) # 值扩展

self.W_Q = nn.Linear(d_model, n_heads * d_h) # 查询

self.W_O = nn.Linear(n_heads * d_h, d_model) # 输出

def forward(self, x):

batch_size, seq_len, _ = x.size()

c = self.W_DKV(x) # 压缩至潜空间

k = self.W_UK(c).view(batch_size, seq_len, self.n_heads, self.d_h)

v = self.W_UV(c).view(batch_size, seq_len, self.n_heads, self.d_h)

q = self.W_Q(x).view(batch_size, seq_len, self.n_heads, self.d_h)

scores = torch.einsum("bihd,bjhd->bhij", q, k) / (self.d_h ** 0.5)

weights = F.softmax(scores, dim=-1)

attn = torch.einsum("bhij,bjhd->bihd", weights, v)

attn = attn.view(batch_size, seq_len, -1)

return self.W_O(attn)解释:

- W_DKV将输入压缩至低维潜空间(

d_c = 128),减少KV缓存。 - W_UK和W_UV动态生成键和值,通信仅传输( c )向量。

- Einsum操作优化多头注意力计算,避免显式矩阵转置。

DualPipe流水线并行

class DualPipeModel(nn.Module):

def __init__(self, layers_per_stage, num_stages):

super().__init__()

self.stages = nn.ModuleList([nn.ModuleList([MLAAttention() for _ in range(layers_per_stage)]) for _ in range(num_stages)])

self.rank = dist.get_rank()

self.num_stages = num_stages

def forward(self, x):

stage_out = x

if self.rank == 0: # 前向传播

for layer in self.stages[0]:

stage_out = layer(stage_out)

dist.send(tensor=stage_out, dst=1)

elif self.rank == self.num_stages - 1: # 最后阶段

dist.recv(tensor=stage_out, src=self.rank-1)

for layer in self.stages[-1]:

stage_out = layer(stage_out)

else: # 中间阶段

dist.recv(tensor=stage_out, src=self.rank-1)

for layer in self.stages[self.rank]:

stage_out = layer(stage_out)

dist.send(tensor=stage_out, dst=self.rank+1)

return stage_out

def train(rank, world_size):

dist.init_process_group("nccl", rank=rank, world_size=world_size)

model = DualPipeModel(layers_per_stage=2, num_stages=world_size).cuda(rank)

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

data = torch.randn(32, 10, 512).cuda(rank)

for _ in range(10):

optimizer.zero_grad()

out = model(data)

loss = out.sum() # 模拟损失

loss.backward()

optimizer.step()

dist.destroy_process_group()解释:

- DualPipeModel将模型分为多个阶段,每个GPU处理一个阶段

- dist.send和dist.recv实现阶段间通信,DualPipe通过双向调度隐藏延迟。

- NCCL后端利用InfiniBand优化通信。

启动分布式训练

python -m torch.distributed.launch --nproc_per_node=8 --nnodes=2 --node_rank=0 train.py

python -m torch.distributed.launch --nproc_per_node=8 --nnodes=2 --node_rank=1 train.py解释:

- --nproc_per_node=8表示每节点8个GPU。

- --nnodes=2表示2个节点,总计16个GPU。

- node_rank区分主从节点。

IV. 千卡集群部署实践

4.1 硬件配置方案

组件 | 配置规格 | 数量 | 互联拓扑 |

|---|---|---|---|

计算节点 | 8×A100 80GB | 128节点 | NVLink 3.0 |

网络 | 200Gbps InfiniBand | 4主干链路 | Fat-Tree |

存储 | 4PB NVMe SSD | 32节点 | RDMA访问 |

调度器 | Kubernetes | 3 master | 高可用部署 |

4.2 分布式训练启动脚本

#!/bin/bash

# DeepSeek集群启动脚本

NUM_NODES=128

GPUS_PER_NODE=8

torchrun \

--nnodes=$NUM_NODES \

--nproc_per_node=$GPUS_PER_NODE \

--rdzv_id=deepseek_train \

--rdzv_backend=c10d \

--rdzv_endpoint=coordinator:29500 \

--max_restarts=3 \

\

train.py \

--batch_size 4096 \

--use_gradient_accumulation \

--topology_aware \

--compression_ratio 0.05关键参数说明:

--gradient_accumulation: 梯度累积步数--topology_aware: 启用拓扑感知通信--compression_ratio: 动态稀疏压缩率

V. 性能验证与优化成果

5.1 千亿模型训练指标

优化策略 | 训练速度(tokens/s) | 显存占用 | 通信开销占比 | 收敛周期 |

|---|---|---|---|---|

基线(未优化) | 12.4k | 98% | 63% | 78天 |

+梯度压缩 | 18.7k | 95% | 51% | 62天 |

+拓扑感知 | 24.3k | 97% | 39% | 49天 |

+流水线优化 | 31.6k | 92% | 28% | 41天 |

5.2 故障容错机制

class CheckpointManager:

def __init__(self, save_interval=3600):

self.save_interval = save_interval # 每1小时保存

self.last_save = time.time()

def maybe_save(self, model):

if time.time() - self.last_save > self.save_interval:

# 异步写入分布式存储

threading.Thread(target=self._async_save, args=(model.state_dict(),)).start()

self.last_save = time.time()

def _async_save(self, state_dict):

# 使用Zstandard压缩

buffer = pickle.dumps(state_dict)

compressed = zstd.compress(buffer)

distributed_store.write(checkpoint_path, compressed)容错能力对比:

策略 | 故障恢复时间 | 数据丢失风险 | 存储开销 |

|---|---|---|---|

每小时保存 | 3.2min | 1h数据 | 8.4TB |

连续快照 | 18s | 无 | 42TB |

DeepSeek混合 | 45s | 5min数据 | 12.7TB |

VI. DeepSeek千卡集群通信优化策略

(一)通信拓扑优化

通信拓扑优化是提高分布式训练效率的重要手段。根据集群的网络结构和节点分布,设计高效的通信拓扑,减少通信延迟和带宽消耗。常见的通信拓扑包括环形、树形、总线形等。

拓扑结构对比

拓扑类型 | 特点 | 适用场景 |

|---|---|---|

环形拓扑 | 结构简单,通信路径固定,通信延迟线性增长 | 小型集群或低通信延迟要求场景 |

树形拓扑 | 层次化通信路径,良好扩展性 | 大规模集群通信 |

总线形拓扑 | 通信简单,但存在带宽竞争和冲突问题 | 节点少、通信频率不高场景 |

DeepSeek拓扑优化实践

优化实践 | 描述 |

|---|---|

混合通信拓扑结构 | 结合树形和环形拓扑优势,动态调整通信路径 |

网络拓扑感知算法 | 优化节点间通信路由,避免通信拥塞 |

提高整体通信效率 | 减少通信延迟,提升大规模集群通信性能 |

(二)梯度压缩技术

梯度压缩技术通过减少通信数据量,降低通信开销,提高分布式训练的效率。常见的梯度压缩方法包括量化、剪裁、稀疏化等。

梯度压缩技术对比

压缩技术 | 描述 | 优点 | 缺点 |

|---|---|---|---|

量化压缩 | 降低梯度精度(如32位浮点数到16位或8位整数) | 减少通信数据量,实现简单 | 可能轻微影响模型收敛性 |

剪裁压缩 | 截断小梯度值,只保留大梯度值 | 显著减少通信数据量 | 可能丢失梯度信息,影响收敛速度和准确性 |

稀疏化压缩 | 传输非零梯度值及其索引 | 大幅减少通信数据量(针对稀疏梯度) | 需高效稀疏数据结构和传输协议支持 |

DeepSeek梯度压缩应用

应用实践 | 描述 |

|---|---|

多种梯度压缩技术结合 | 根据训练任务和模型特点动态选择压缩方法 |

量化和剪裁压缩结合 | 有效减少通信数据量,保证模型收敛性能 |

稀疏化压缩优化 | 自适应调整稀疏化程度,提高通信效率 |

(三)混合精度训练

混合精度训练通过在训练过程中同时使用不同精度的数据类型(如FP32、FP16、BF16等),降低通信带宽需求,加速计算和通信过程。混合精度训练需要合理设置精度转换规则,避免因精度降低导致的数值不稳定和模型收敛问题。

混合精度训练概述

方面 | 描述 |

|---|---|

精度转换策略 | 部分操作用低精度加速,关键操作保持高精度 |

深度学习框架支持 | PyTorch、TensorFlow等提供混合精度训练支持 |

训练效果 | 提高训练效率,不影响模型性能 |

DeepSeek混合精度实践

实践方面 | 描述 |

|---|---|

框架功能结合 | 结合框架混合精度功能和自定义策略 |

通信带宽优化 | 降低通信带宽需求,提高训练速度 |

灵活参数调整 | 根据硬件和模型架构调整混合精度参数 |

(四)通信与计算重叠

通信与计算重叠是提高分布式训练效率的另一种有效策略。通过合理安排计算任务和通信操作,使得通信和计算能够并行执行,减少总的训练时间。

异步通信与重叠策略概述

异步通信机制 | 描述 | 重叠策略设计 | 描述 |

|---|---|---|---|

通信与计算重叠 | 节点在通信的同时继续执行计算任务,提高资源利用率 | 任务划分与调度 | 合理划分计算任务和调度通信操作,确保计算和通信能够有效重叠 |

DeepSeek重叠优化实现

深度学习框架支持 | 描述 | 实际应用效果 | 描述 |

|---|---|---|---|

操作拆分与安排 | 将前向传播、反向传播和梯度同步等操作合理拆分,最大限度并行执行 | 提高训练效率 | 减少等待时间,提高集群整体利用率和训练效率 |

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。