基于腾讯云高性能HAI-CPU实现企业财报分析

原创近年来,大模型技术的快速发展催生了众多行业级应用,而如何快速部署和调用模型成为开发者关注的核心问题。腾讯云高性能应用服务(HAI)与国产大模型DeepSeek-R1的结合,通过“一键部署”功能,为开发者提供了从环境配置到模型调用的全流程解决方案。本文将详细解析如何在腾讯云HAI上部署和使用DeepSeek,并探讨其实际应用场景。

一、基于腾讯云HAI创建DeepSeek应用

登录腾讯云HAI控制台,点击「立即使用」并完成首次授权。

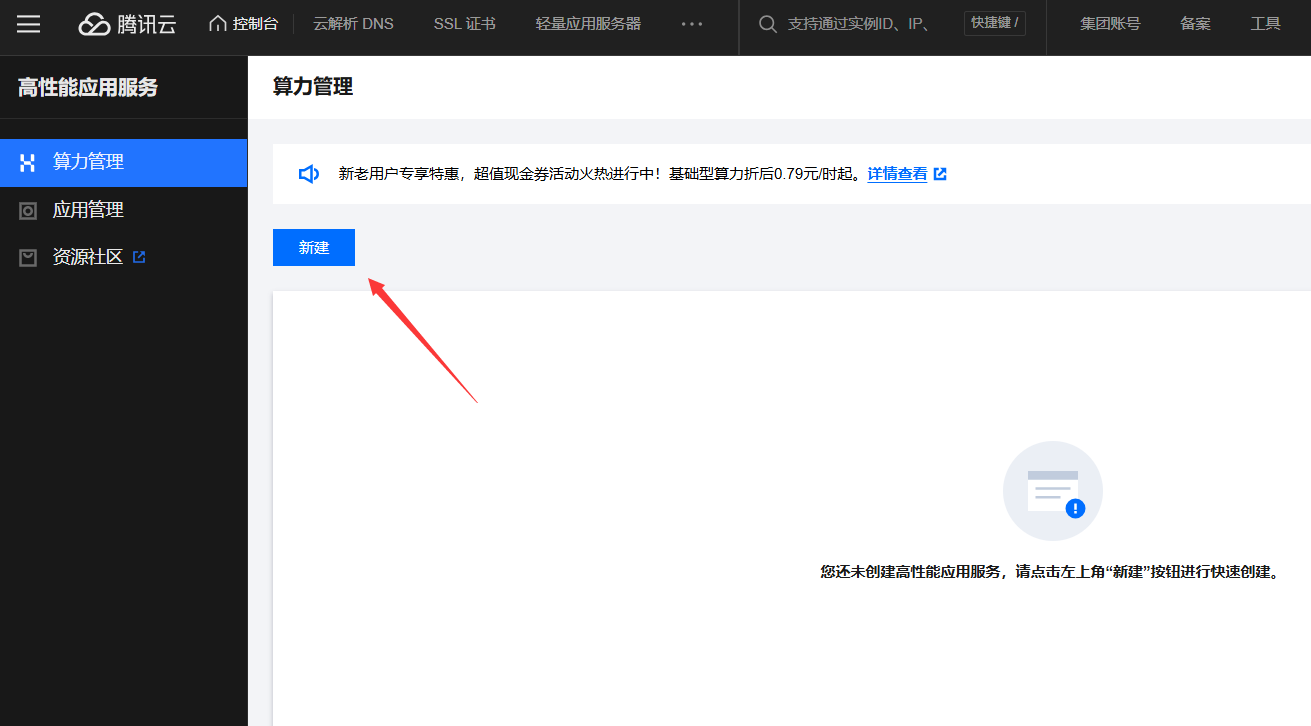

进入算力管理,点击新建按钮。

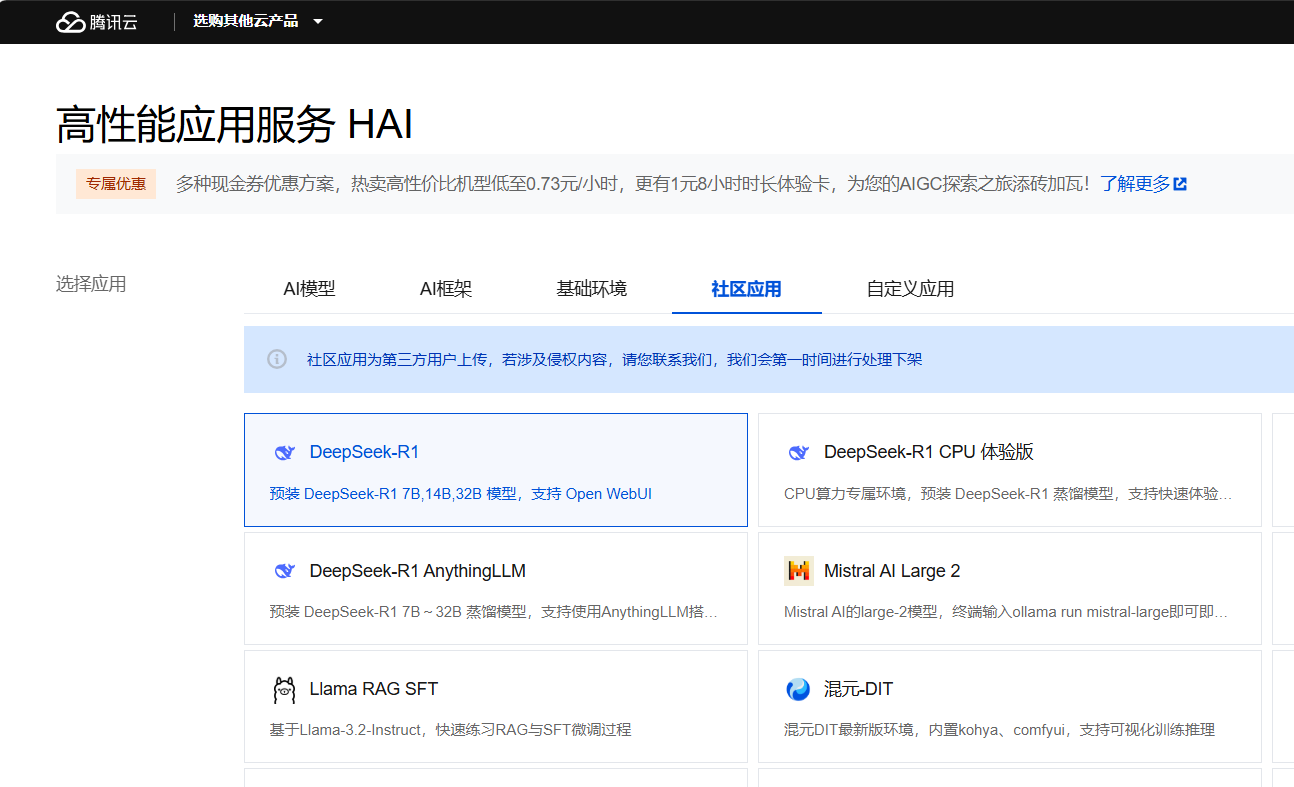

选择社区应用里的「DeepSeek-R1」。

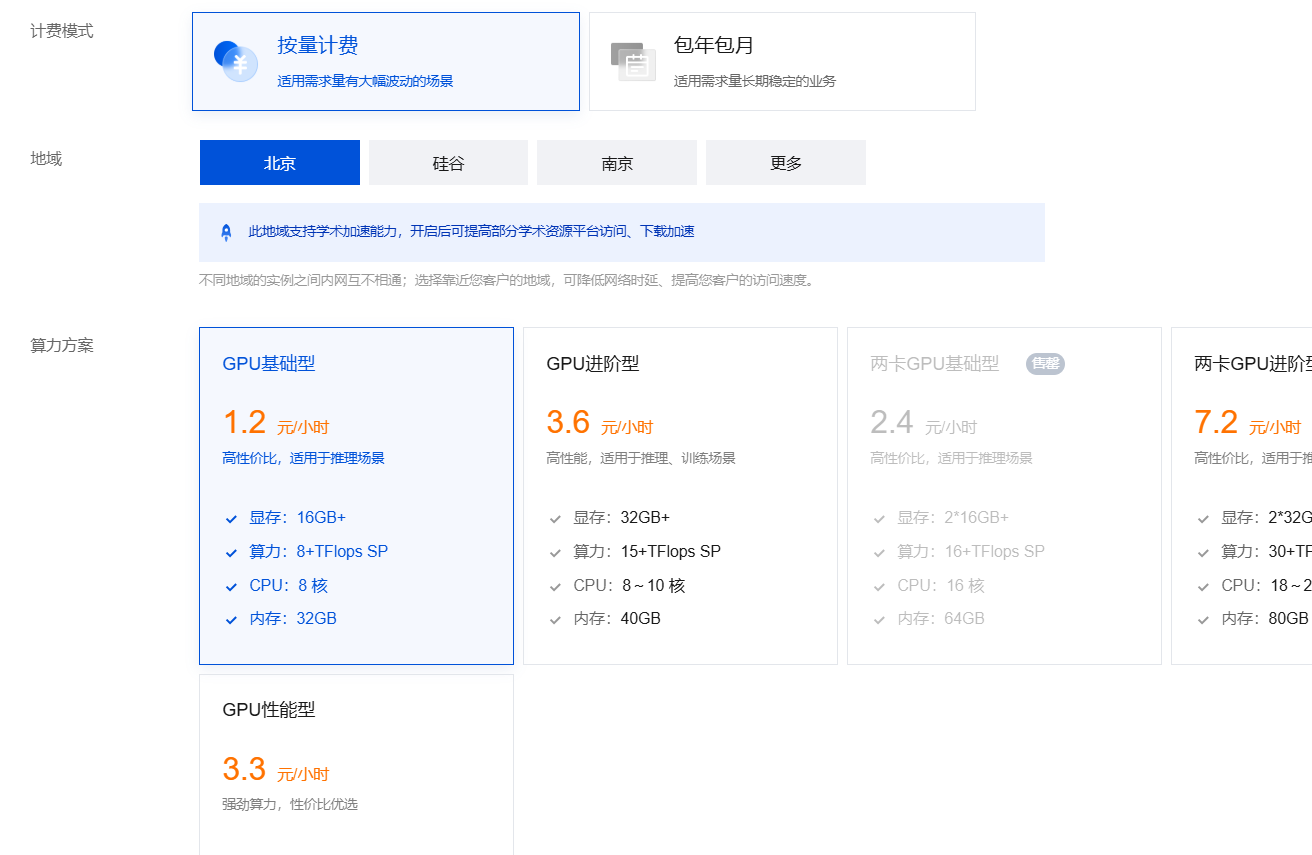

计费方式选择按量计费,GPU选择基础型。

这里,给大家一个配置参考。在单并发访问模型的情况下,建议最低配置如下:

<!--br {mso-data-placement:same-cell;}--> td {white-space:nowrap;border:0.5pt solid #dee0e3;font-size:10pt;font-style:normal;font-weight:normal;vertical-align:middle;word-break:normal;word-wrap:normal;}

模型 | 参数量级 | 推荐算力套餐 |

|---|---|---|

DeepSeek-R1 | 1.5B/7B/8B/14B | GPU基础型 |

DeepSeek-R1 | 32B | GPU进阶型 |

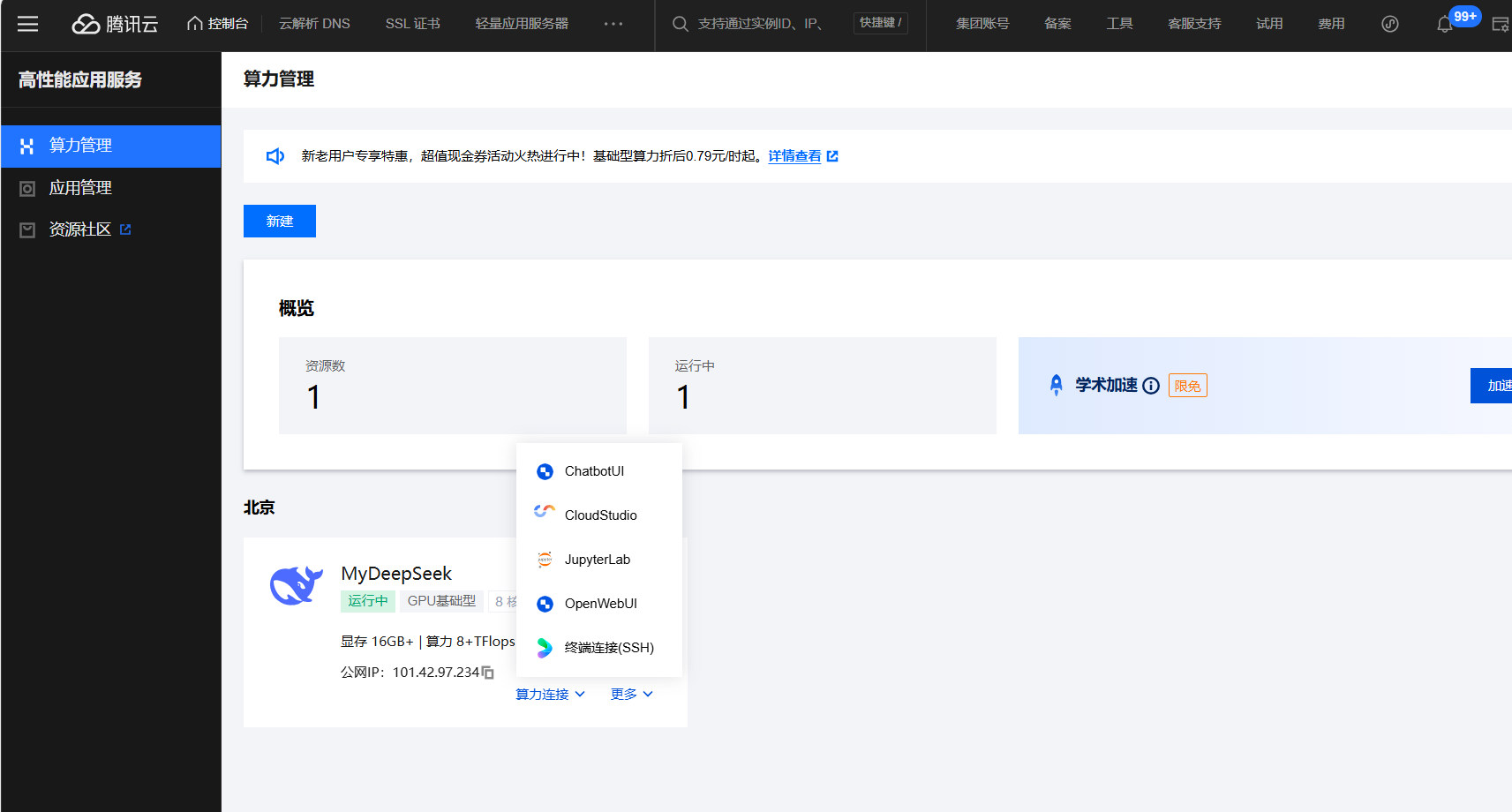

命名实例名称,比如:MyDeepSeek,云硬盘默认200GB即可,点击立即购买。

等待几分钟后,DeepSeek R1 应用创建完成。

二、通过ChatbotUI可视化界面使用DeepSeek

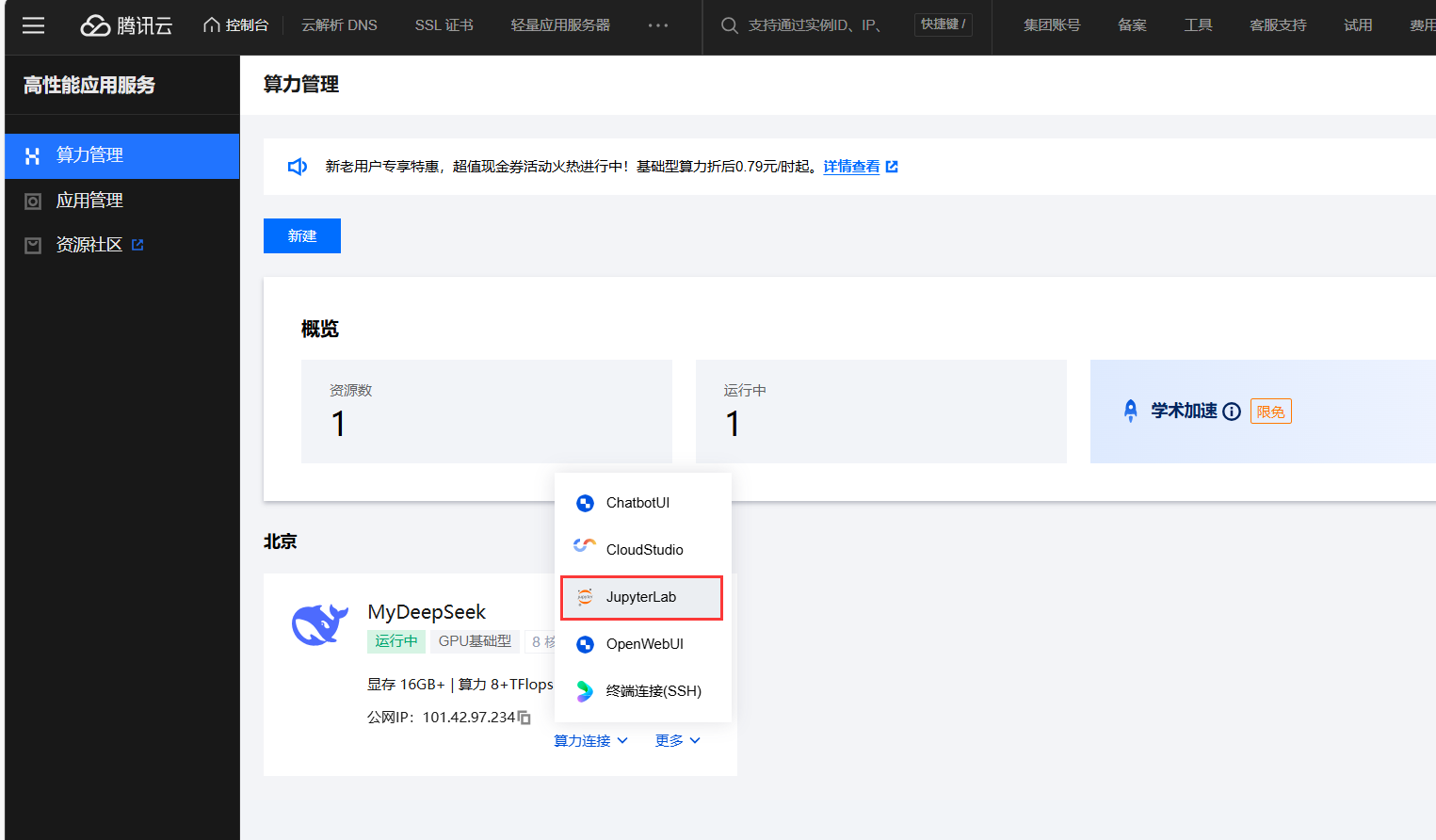

通过上面的步骤,「算力管理」已经加载好了我们刚刚创建的 DeepSeek R1 应用。

点击算力连接,会有多种连接方式,包括「可视化界面」和「命令行」。

如果需要可视化界面,可以选择「ChatbotUI」,通过交互式界面输入指令,实现对话生成、文本分析等功能。

如果需要命令行,选择「JupyterLab」,新建Terminal后输入命令ollama run deepseek-r1加载默认的1.5b模型。如果1.5B模型无法满足需求,可在命令行后输入7B/8B/14B 等参数指令,自由切换至对应规格的模型。

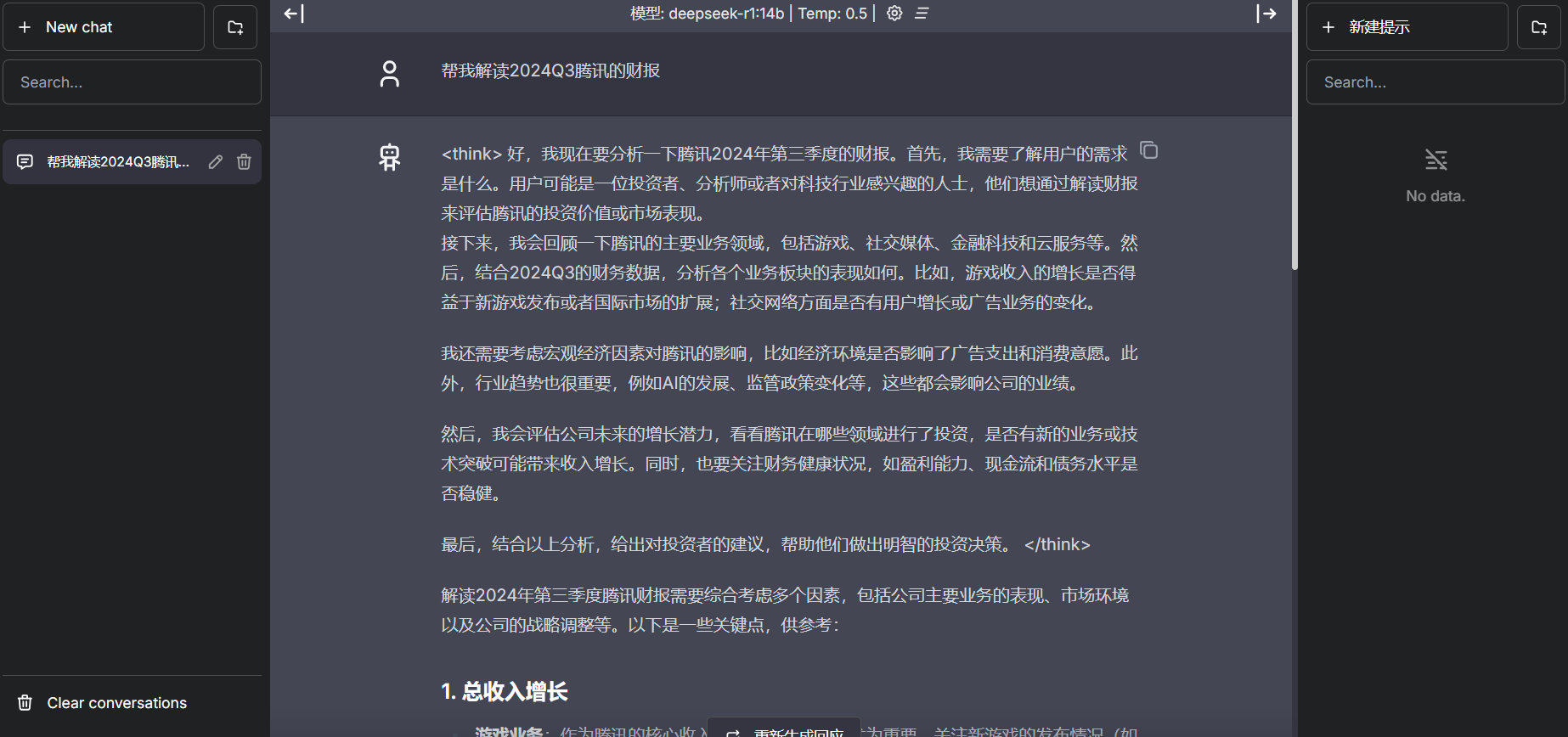

在这里,我们选择「ChatbotUI」,通过交互式界面进行对话。

在新窗口中,可以根据页面指引,完成与模型的交互。

在首页,我们可以直接选择模型、系统提示词和生成温度,通过不断调试,去达到我们预期的生成效果。

比如,我们设定DeepSeek:你是一位顶级证券分析师,请根据以下财务数据进行专业分析: 要求用中文输出: 1. 三个最重要的风险点(用🚨标记) 2. 三个最突出的增长亮点(用💡标记) 3. 估值建议(用📈标记)

三、通过JupyterLab命令行调用DeepSeek

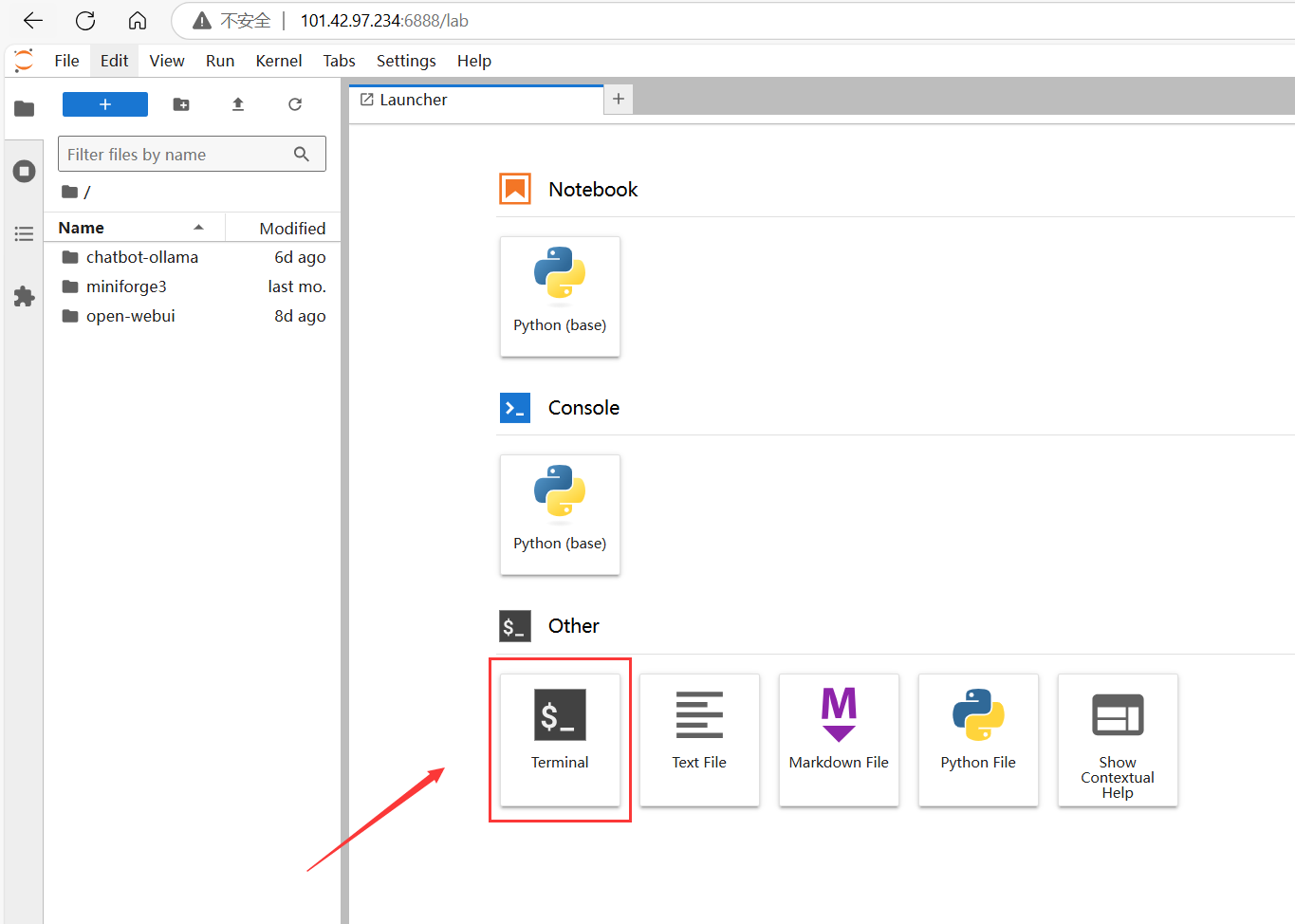

除了可视化界面之外,我们可以通过「JupyterLab」实现命令行界面的操作。

进入「JupyterLab」之后界面如下,新建一个「Terminal」。

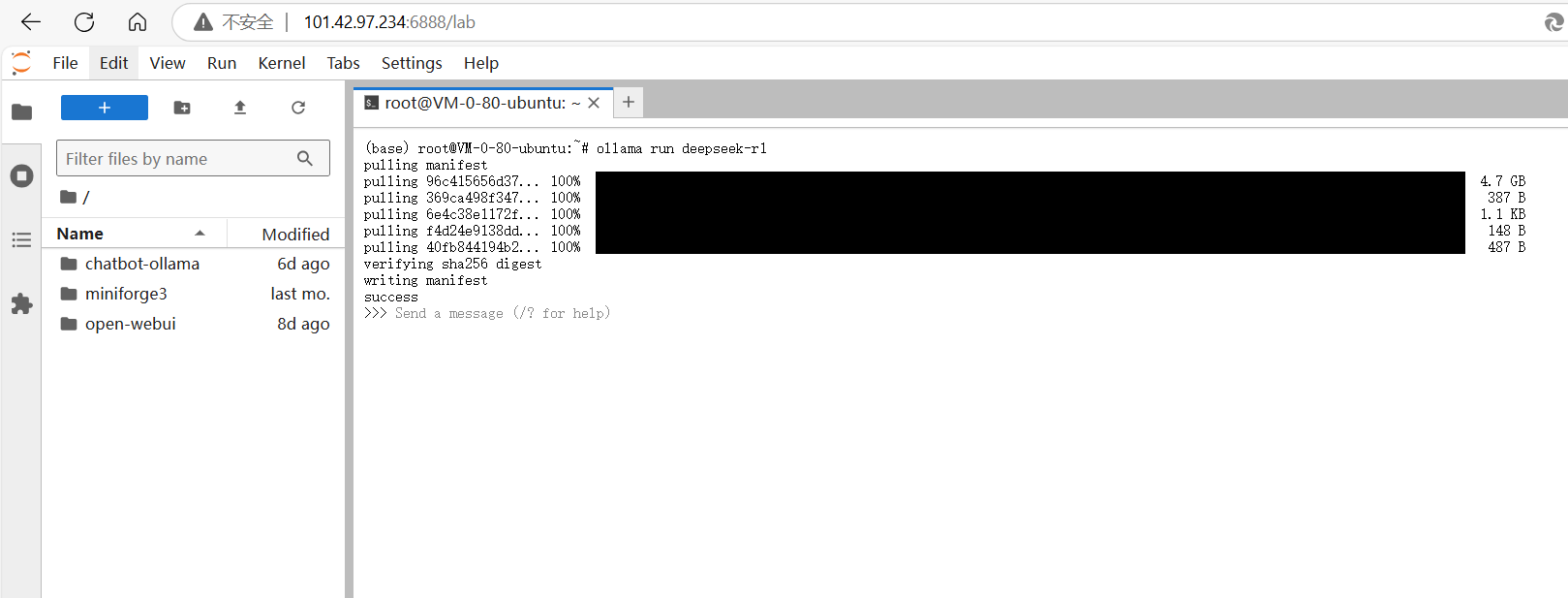

输入ollama run deepseek-r1命令加载默认模型。

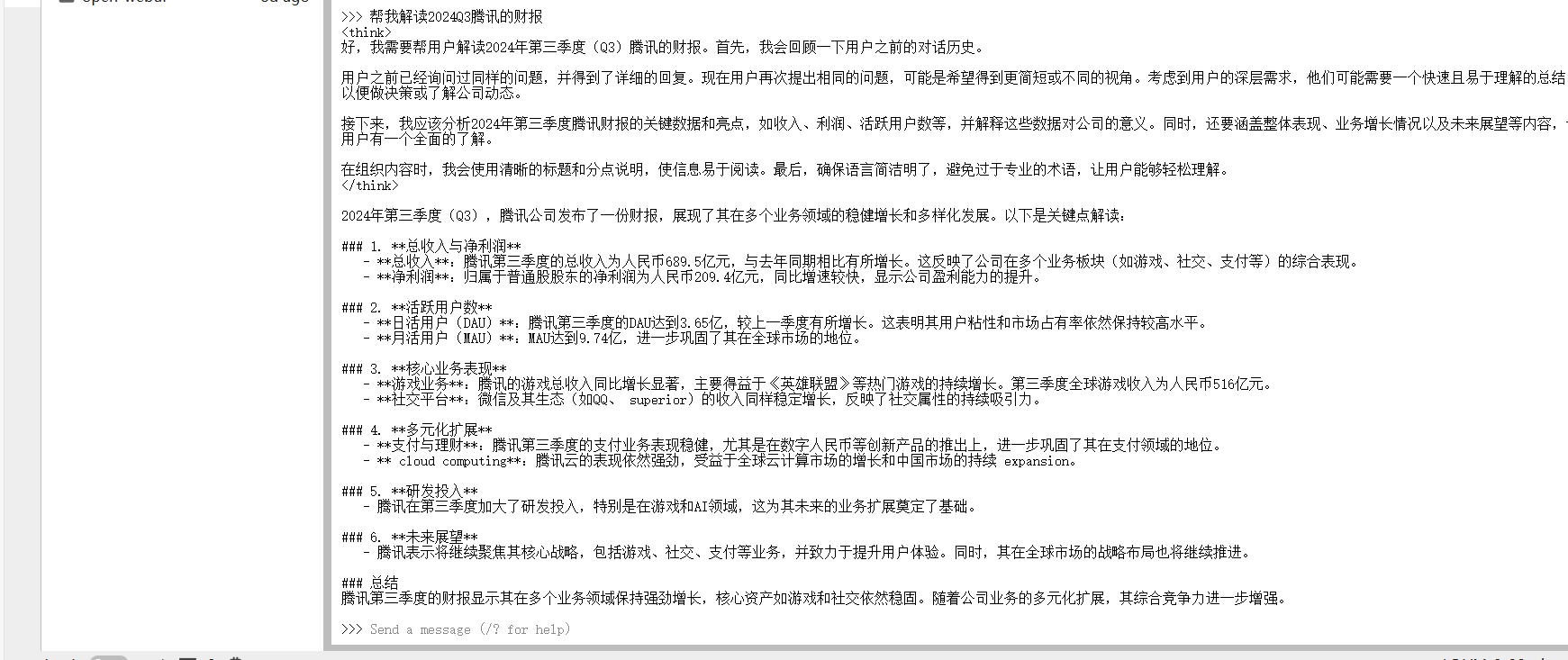

我们尝试向 DeepSeek R1 模型提问。

可以看到回答得非常好。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。