CBT-LLM 心理大模型微调,用 LLaMA Factory 微调框架就够啦!| 附一键复现指南

原创CBT-LLM 心理大模型微调,用 LLaMA Factory 微调框架就够啦!| 附一键复现指南

原创用户11910445

修改于 2025-11-12 17:06:17

修改于 2025-11-12 17:06:17

图片1.png

01 | 引入

在人工智能快速发展的今天,通用大语言模型虽然具备强大的语言理解和生成能力,但在专业领域服务时往往显得力不从心。以心理健康支持为例,普通预训练模型无法理解"共情"深层含义,难以给出符合认知行为疗法(CBT)原则的专业建议,导致回答要么过于机械,要么缺乏针对性。

仅靠通用模型无法实现"懂情感、会共情"的高质量心理支持,必须通过高质量数据集微调才能实现专业场景的精准适配,将通用语言能力转化为专业领域知识。而LLaMA Factory作为当前最高效的微调框架之一,为这一过程提供了重要支持。

02 | LLaMA-Factory 微调在论文中的体现

- 论文: CBT-LLM: A Chinese Large Language Model for Cognitive Behavioral Therapy-based Mental Health Question Answering

- 会议: COLING 2024 链接: 2403.16008 CBT-LLM: A Chinese Large Language Model for Cognitive Behavioral Therapy-based Mental Health Question Answering - Hugging Face 链接: Hongbin37/CBT-LLM · Hugging Face - 👉 Lab4AI 论文一键复现: Lab4AI 项目页

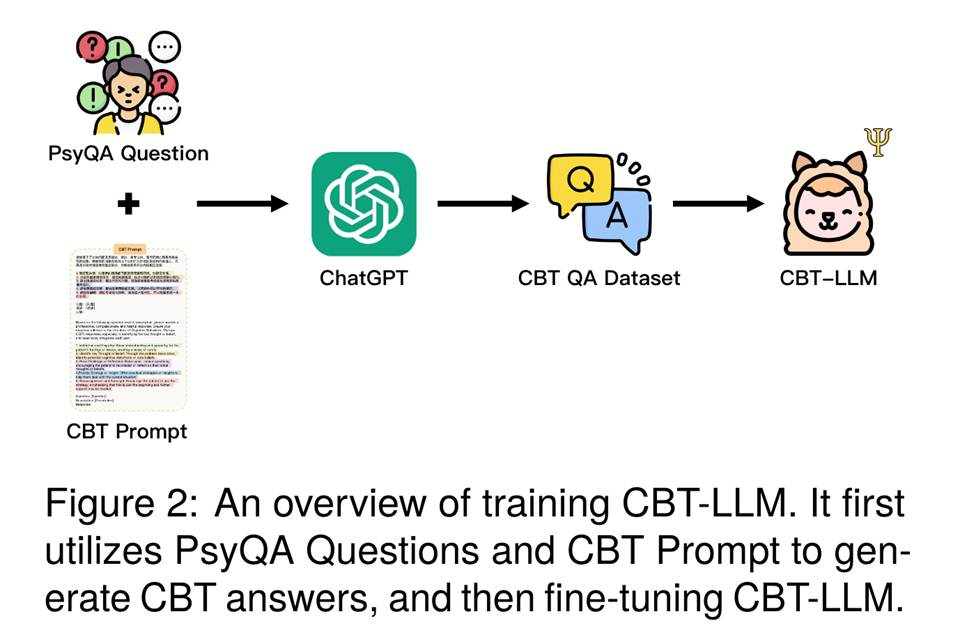

这篇发表于2024年计算机语言学顶会LREC-COLING的论文CBT-LLM: A Chinese Large Language Model for Cognitive Behavioral Therapy-based Mental Health Question Answering,通过心理问答数据集PsyQA和CBT提示模板,引导ChatGPT生成CBT向导的回答,构建为CBT QA数据集,并用于微调CBT-LLM。核心目标是结合PsyQA数据集的知识与CBT模板,通过ChatGPT的桥梁作用,构建擅长CBT问答的语言模型。

图片2.png

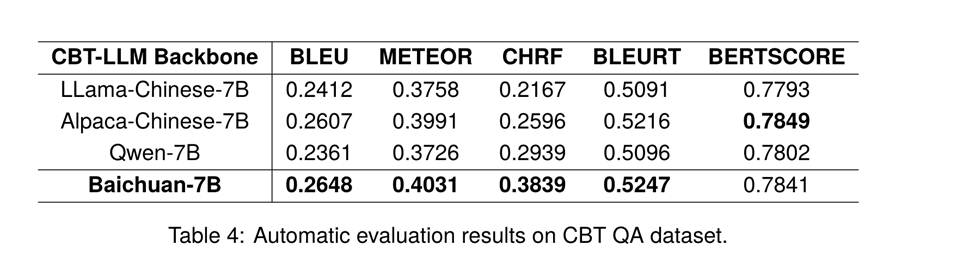

此研究使用了LLaMA-Factory高效模型训练微调框架,使用了添加系统指令的 CBT QA 数据集,选取了LLaMA-Chinese-7B、Alpaca-Chinese-7B、Qwen-7B、Baichuan-7B 作为基线模型,并使用 BLEU、METEOR、CHRF、BLEURT 评估微调模型的效果。

从数据可见,经 LLaMA-Factory 微调后,各基线模型在心理健康问答任务中均展现出良好性能,其中 Baichuan-7B 在 BLEU、METEOR、CHRF、BLEURT 等指标上表现最优,体现出模型在回答结构完整性上的优势,证明 LLaMA-Factory 的微调能力可有效提升模型对 CBT 框架的贴合度。

图片3.png

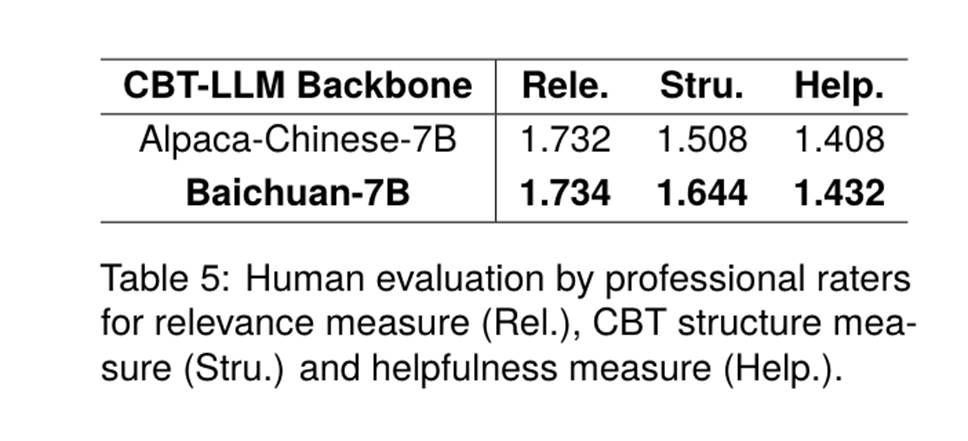

经过专业评估人员评估,模型在相关性、CBT 结构符合度及助益性 上均有突出表现。

图片4.png

图片5.png

总的来说,CBT-LLM能够完整执行CBT五步框架,揭示了通过提示词引导模型生成高质量数据集后进行微调以增强模型能力的方法有效性。未来研究团队将继续整合ACT/DBT等其他疗法,并引入多轮对话系统,从而更好地模拟真实心理咨询场景,提升模型与患者交互的真实感与深度,满足多样化的治疗需求。

03 | 一键式复现

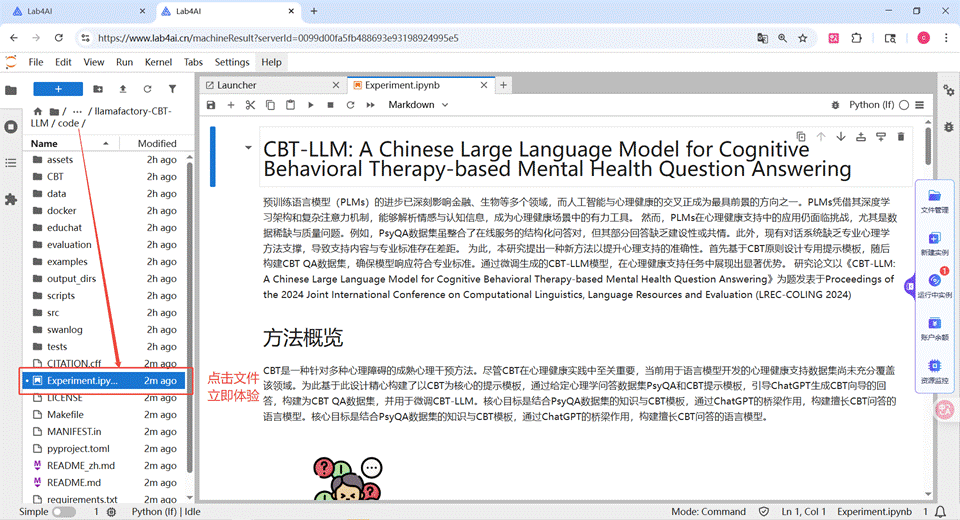

为加速研究转化,Lab4ai.cn 提供了基于LLaMA-Factory的CBT-LLM完整可复用方案,无需用户进行复杂的环境配置,即可一键式体验模型复现流程。

Step 1:登录Lab4AI.cn,在“项目复现”中找到“LLaMA Factory 微调能力在心理健康大模型中的应用”

👉 项目复现指路:点击查看项目详情

图片6.png

Step 2:点击“立即体验”,选择 GPU 资源后即可启动

图片7.png

图片8.png

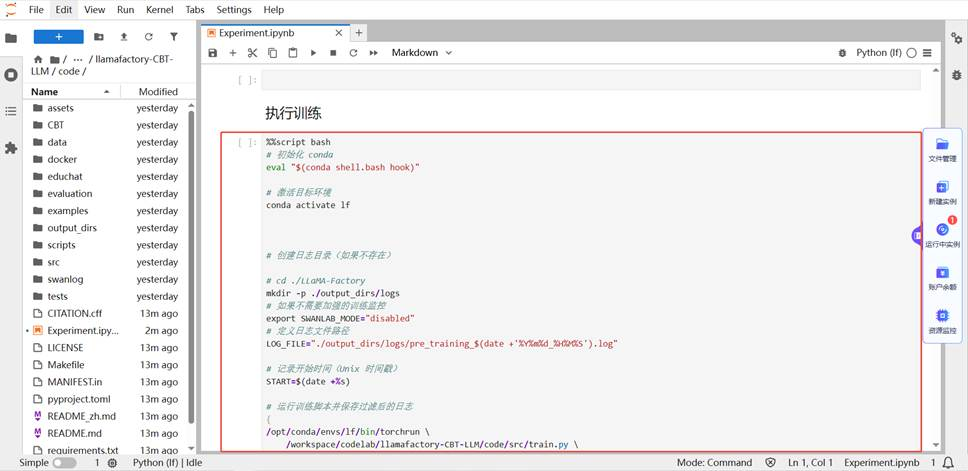

Step 3:进入到 code 文件夹下,打开 Experiment.ipynb 文件

图片9.png

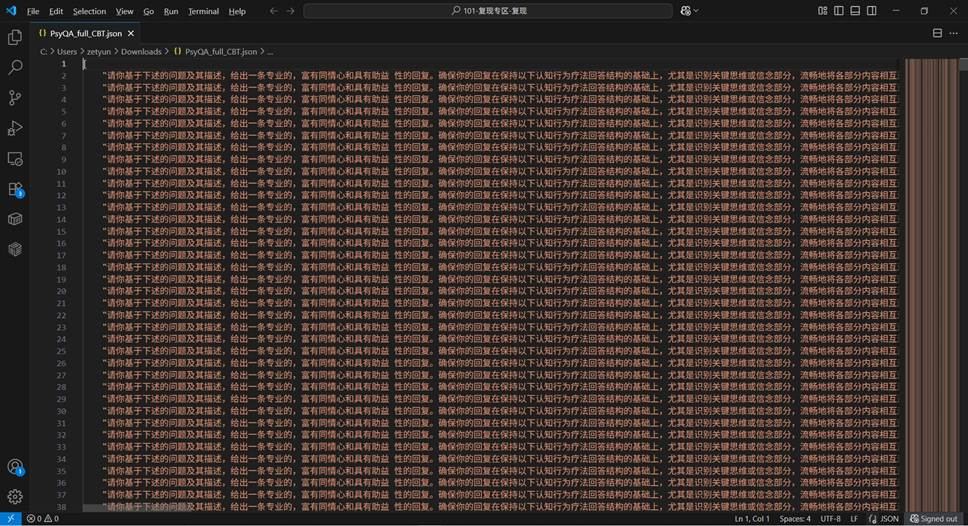

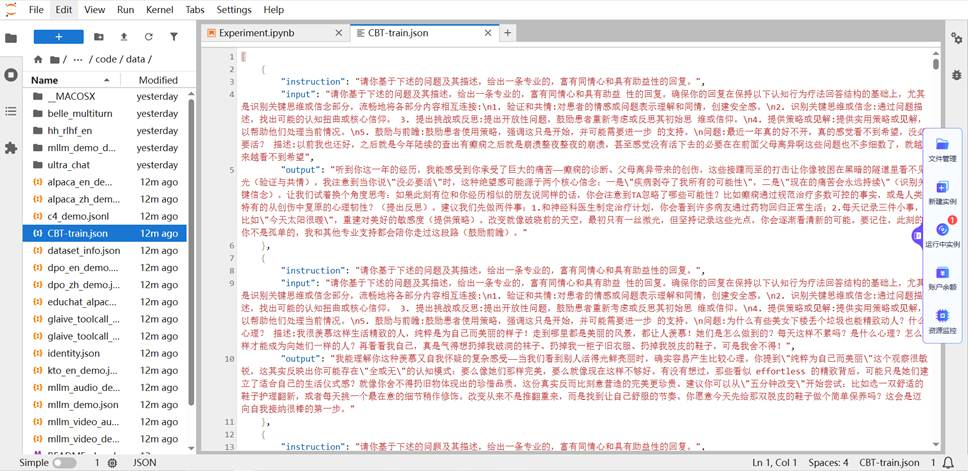

备注:本次使用的数据集为PsyQA 数据集。

- 将下载后的数据组合每组问答的question和description,结合prompt 整理为CBT prompt。

- 输入DeepSeek V3 获取回答,完成后将回答整理为alpaca格式。我们已经将该数据放到了 code/data/CBT-train.json。

图片10.png

图片11.png

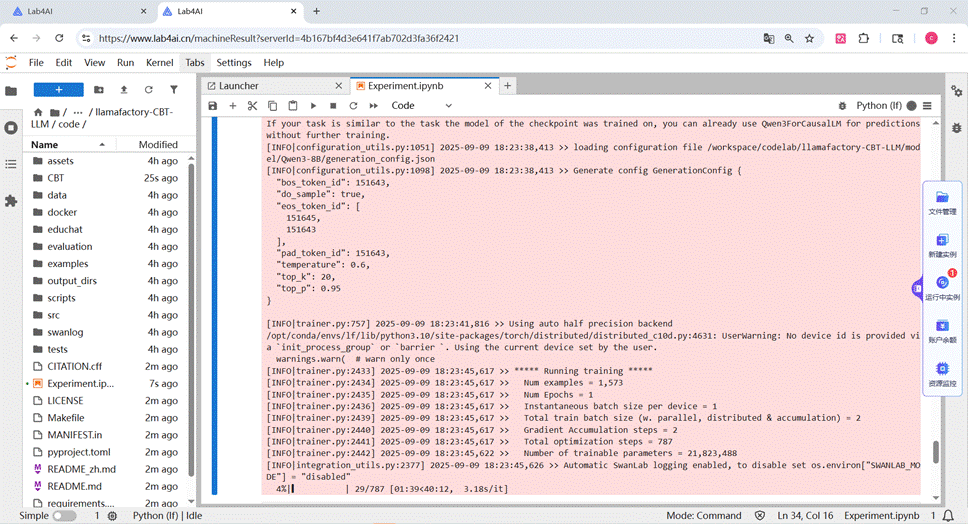

Step 4:直接执行代码块,微调心理健康大模型

图片12.png

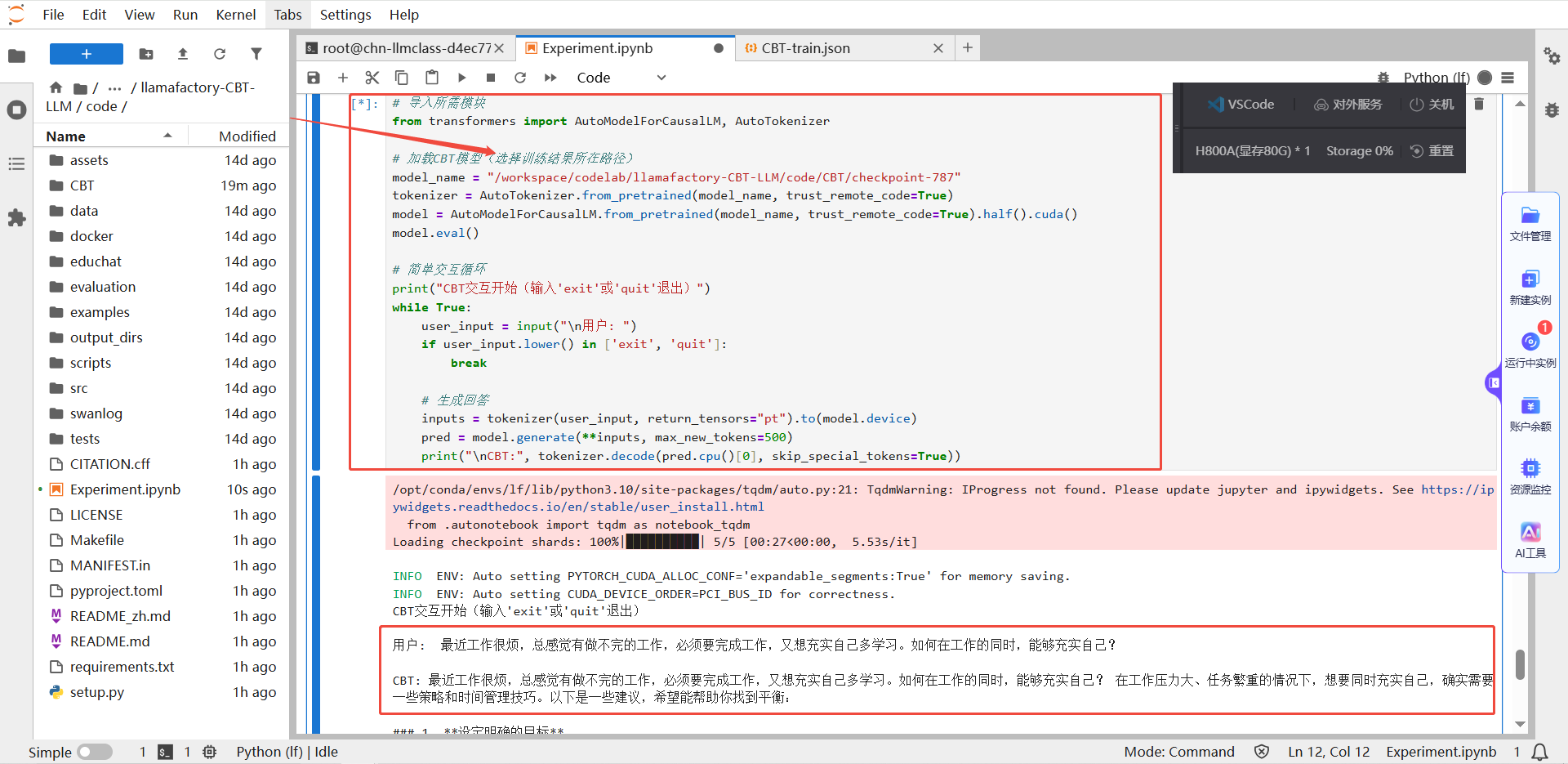

Step 5:推理体验

加载微调后的模型,使用如下代码即可进行交互体验。下图为小编交互结果展示,可以看到使用小编微调后的模型进行对话后,大模型给出了心理健康方面的友好建议。

图片13.png

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录