GoogLeNet之inception模块

原创引进背景

在 Inception 之前,VGG 等网络通过使用更小尺寸的卷积核(3x3)和增加网络深度来提升性能,但这种方式很快遇到了瓶颈:

计算量爆炸:深层网络中,特征图通道数很大,卷积操作的计算成本(FLOPs)和参数量(Params)急剧上升。

梯度不稳定:虽然 ReLU 和更好的初始化缓解了部分梯度消失/爆炸,但深层网络仍面临训练困难。

特征提取效率低:在同一层中,固定的卷积核尺寸(如 3x3 或 5x5)可能不是最优的。大核擅长捕获全局特征但计算量大、容易过拟合,小核擅长细节特征但感受野有限。

Inception 的革命性解决方案:网络中的网络

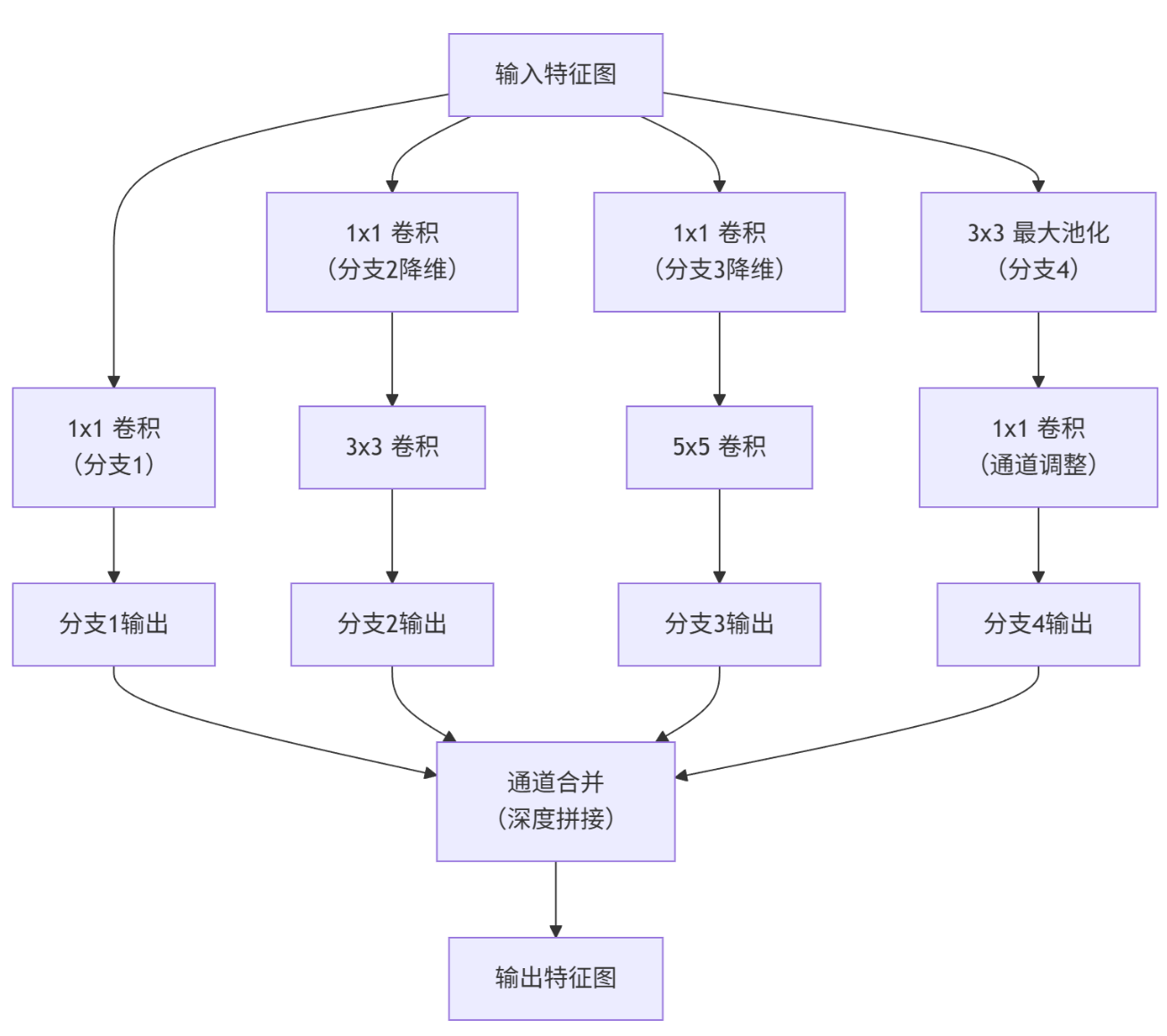

Inception 模块的核心思想是在网络的每一层中,并行地应用多种尺度的卷积核和池化操作,让网络“自己选择”最合适的特征。

整个inception结构就是由多个这样的inception模块串联起来的

这是最初的构想,在同一层并行进行:

1x1 卷积(捕获局部特征)

3x3 卷积(捕获中等范围特征)

5x5 卷积(捕获更大范围特征)

3x3 最大池化(提供另一种特征提取方式)

然后将所有输出的特征图在通道维度上拼接起来,传递给下一层。

输入特征图经过四个并行路径处理后合并输出。左上路径是直接的1x1卷积操作,对输入特征图进行线性变换和通道调整,输出H×W×C1的特征图。右上路径包含两个连续操作,先用1x1卷积将通道数从Cin降维到Creduce2,再用3x3卷积从Creduce2变换到C2,最终输出H×W×C2的特征图。

左下路径同样采用两步处理,先用1x1卷积从Cin降维到Creduce3,再用5x5卷积从Creduce3变换到C3,输出H×W×C3的特征图。右下路径首先进行3x3最大池化操作,空间尺寸保持不变但通道数仍为Cin,接着通过1x1卷积将通道数调整为C4,得到H×W×C4的特征图。

所有四个路径的输出特征图在高度H和宽度W上保持完全一致,这使得它们能够在通道维度上进行合并。最终,这四个特征图被拼接为一个综合的特征图,其尺寸为H×W×(C1+C2+C3+C4),

1x1 卷积的巧妙运用

1x1卷积核,又称为网中网(Network in Network)

主要以下功能:

实现跨通道的交互和信息整合

卷积核通道数的降维和升维,减少网络参数

计算对比分析

目标:计算从 输入 (28x28x192) 到 输出 (28x28x128) 这条路径的参数总量,对比两种实现方式。

方案A:直接使用3x3卷积(“传统”方式)

- 结构:输入 → 3x3卷积 → 输出

- 参数量 = 卷积核宽 × 卷积核高 × 输入通道数 × 输出通道数 ParamsA=3×3×192×128=221,184

- 计算量同样巨大,因为是在高维度(192通道)上直接做3x3卷积。

方案B:Inception方式(1x1卷积 + 3x3卷积)

- 结构:输入 → 1x1卷积(降维) → 3x3卷积 → 输出

- 第一步:1x1卷积

- 输入通道:192

- 输出通道:96

- 参数量 = 1×1×192×96=18,432

- 输出特征图尺寸变为:28x28x96

- 第二步:3x3卷积

- 输入通道:96

- 输出通道:128

- 参数量 = 3×3×96×128=110,592

- 总参数量: ParamsB=18,432+110,592=129,024

关键结论

- 参数量大幅减少: ParamsB−ParamsA=129,024−221,184=−92,160 参数量减少了 92,160,约为原来的 58.3%。

- 核心机制——“瓶颈”结构: 您图片中的“1x1卷积”在这里的核心作用是降维。它先将192个通道压缩到96个,再进行昂贵的3x3卷积。这就像一个“瓶颈”,先缩减数据量,处理后再扩张。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录