智能体(AI Agent)培训的工程化实践体系:从落地到长期迭代

原创智能体(AI Agent)培训的工程化实践体系:从落地到长期迭代

原创

网上易只猪

发布于 2026-01-23 18:56:37

发布于 2026-01-23 18:56:37

在当前企业级 AI Agent 落地过程中,行业普遍存在一个误区:将智能体能力等同于大模型微调效果,忽视了从业务对齐到持续运维的全流程体系化建设。实际上,智能体的 “培训” 是一项覆盖业务、数据、算法、工程的系统工程,其长期稳定性与业务适配性,直接决定了智能体在生产环境中的 ROI(投入产出比)。

一、业务目标对齐:从模糊需求到可工程化定义

行业痛点:近 60% 的智能体项目卡在需求阶段 —— 业务方仅提出 “做一个能解决问题的智能体”,未明确场景边界与验收标准,导致后续环节反复返工。

技术实践:

- 原子任务拆解:将目标场景拆解为可量化的原子任务(如电商智能体的 “订单状态查询”“售后申请引导”“物流异常处理”),每个任务定义明确的输入输出、成功 / 失败判定规则;

- 边界条件量化:嵌入合规、资源、业务三重边界,例如金融智能体不得输出投资建议、单轮响应 Token 数限制在 2000 以内、拒绝处理非本平台业务问题;

- 行业标准对齐:强监管领域(如医疗、金融)参考 NIST AI 风险管理框架、《生成式 AI 服务管理暂行办法》等,将合规要求提前嵌入目标定义。

行业判断:只有将业务需求转化为可工程化的指标,后续的模型选型、数据准备、测试环节才能有明确的验收锚点,避免 “为智能而智能” 的无效投入。

二、数据工程:构建适配业务场景的训练数据集

行业痛点:多数智能体性能不佳的核心原因是数据质量问题 —— 要么样本覆盖不足边缘场景,要么标注一致性差导致模型学习到错误模式。

技术实践:

- 数据分层构建:

- 冷启动阶段:基于领域专家知识构建种子样本库,覆盖 80% 常规场景;

- 迭代阶段:收集用户交互日志中的高频问题、差评案例补充样本;

- 边缘场景:主动生成对抗样本(如用户输入错别字、歧义句、跨领域问题),避免模型泛化不足;

- 标注质量管控:采用 “交叉标注 + 专家校验” 机制,用 Cohen's Kappa 系数衡量标注一致性(目标≥0.8),对低一致性样本重新审核;

- 数据偏倚修正:通过 KS 检验检测样本分布与生产环境的差异,用重采样、加权训练等方法修正偏倚(如金融智能体需补充小微企业客户的样本占比)。

工程视角:数据准备不是一次性工作,而是需要搭建可复用的数据管道(如用 Airflow 调度数据清洗、标注、入库流程),为后续持续迭代提供支撑。

三、模型选型与架构设计:匹配任务复杂度的技术路线

行业痛点:盲目跟风大模型原生 Agent,忽视业务场景的实际需求 —— 例如简单的客服场景用复杂的强化学习架构,导致资源浪费与维护成本飙升。

技术实践:

- 场景化选型策略:

- 规则驱动场景(如工单流转):采用 “规则引擎 + 意图识别” 轻量架构,降低运维成本;

- 知识密集场景(如技术支持):用 “检索增强生成(RAG)+ 大模型” 混合架构,平衡准确率与可控性;

- 决策优化场景(如供应链调度):采用 “强化学习 + 知识图谱” 架构,实现动态决策;

- 核心模块设计:

- 交互机制:用有限状态机(FSM)管理对话状态,避免大模型遗忘上下文;

- 工具调用:设计标准化工具接口(如调用 CRM 查用户信息),加入参数校验与异常回滚逻辑。

行业判断:智能体的架构核心是 “适配业务” 而非 “技术炫技”,选择最贴合场景的技术路线,才能在性能、成本、可维护性之间取得平衡。

四、迭代训练与评估:构建闭环优化机制

行业痛点:仅用 “任务完成率” 单一指标评估智能体,导致模型在实际场景中出现 “看起来完成任务,但结果不符合业务逻辑” 的问题。

技术实践:

- 多维度评估体系:

- 功能性指标:任务完成率(目标≥90%)、意图识别准确率(目标≥95%)、业务合规性(违规率 = 0);

- 效率性指标:响应时间(目标≤1s)、Token 消耗成本(单轮≤1500Token)、资源利用率(GPU 显存占用≤70%);

- 体验指标:用户满意度评分(目标≥4.5/5)、差评率(目标≤2%);

- CI/CD 式迭代流程:用 MLflow、Kubeflow 等工具搭建 MLOps 平台,实现 “数据更新→自动训练→评估触发→模型上线” 的闭环,当评估指标低于阈值时自动触发回滚。

工程视角:迭代训练不是 “调参试错”,而是基于数据驱动的科学优化,通过标准化流程降低试错成本,提升迭代效率。

五、全链路测试:提前暴露生产环境的风险点

行业痛点:多数智能体上线后出现故障,是因为测试环节仅覆盖常规场景,未模拟真实环境的复杂情况。

技术实践:

- 分层测试体系:

- 单元测试:用 Mock 框架测试核心模块(如 RAG 的召回模块、工具调用接口),确保单个功能的正确性;

- 集成测试:采用契约测试验证模块间的接口兼容性,避免上下游变更导致的故障;

- 场景化测试:在沙箱环境中模拟真实业务流(如用户从咨询到售后的全流程),验证智能体的端到端能力;

- 专项测试:

- 压力测试:用 Locust、JMeter 模拟 10 倍峰值流量,测试系统的吞吐量与稳定性;

- 对抗测试:由红队或自动生成 adversarial prompts(如诱导智能体输出违规内容、输入超长文本),暴露模型的脆弱点;

- 合规测试:针对强监管领域,验证智能体是否符合行业合规要求(如医疗智能体不得诊断疾病)。

行业判断:测试的核心目标是 “模拟真实风险”,而非 “追求高测试覆盖率”,只有在接近生产环境的场景中测试,才能提前发现潜在的失效模式。

六、持续监控与迭代:保障智能体的长期有效性

行业痛点:智能体上线后 “一劳永逸”,未建立监控机制,导致数据分布漂移、业务规则变更时智能体性能快速下降。

技术实践:

- 实时监控体系:用 Prometheus+Grafana 监控核心指标(任务完成率、响应时间、违规率),设置阈值告警(如任务完成率低于 85% 时触发告警);

- 数据漂移检测:用 PSI(群体稳定性指数)、KS 检验检测训练数据与生产数据的分布差异,当 PSI>0.2 时触发模型再训练;

- 反馈闭环优化:收集用户差评、人工介入的对话案例,自动标注后加入训练集,每月进行一次小规模迭代,每季度进行一次全量再训练。

工程视角:智能体的生命周期管理是长期工程,持续监控与迭代的成本占比应不低于初始开发成本,才能保障其长期适配业务需求。

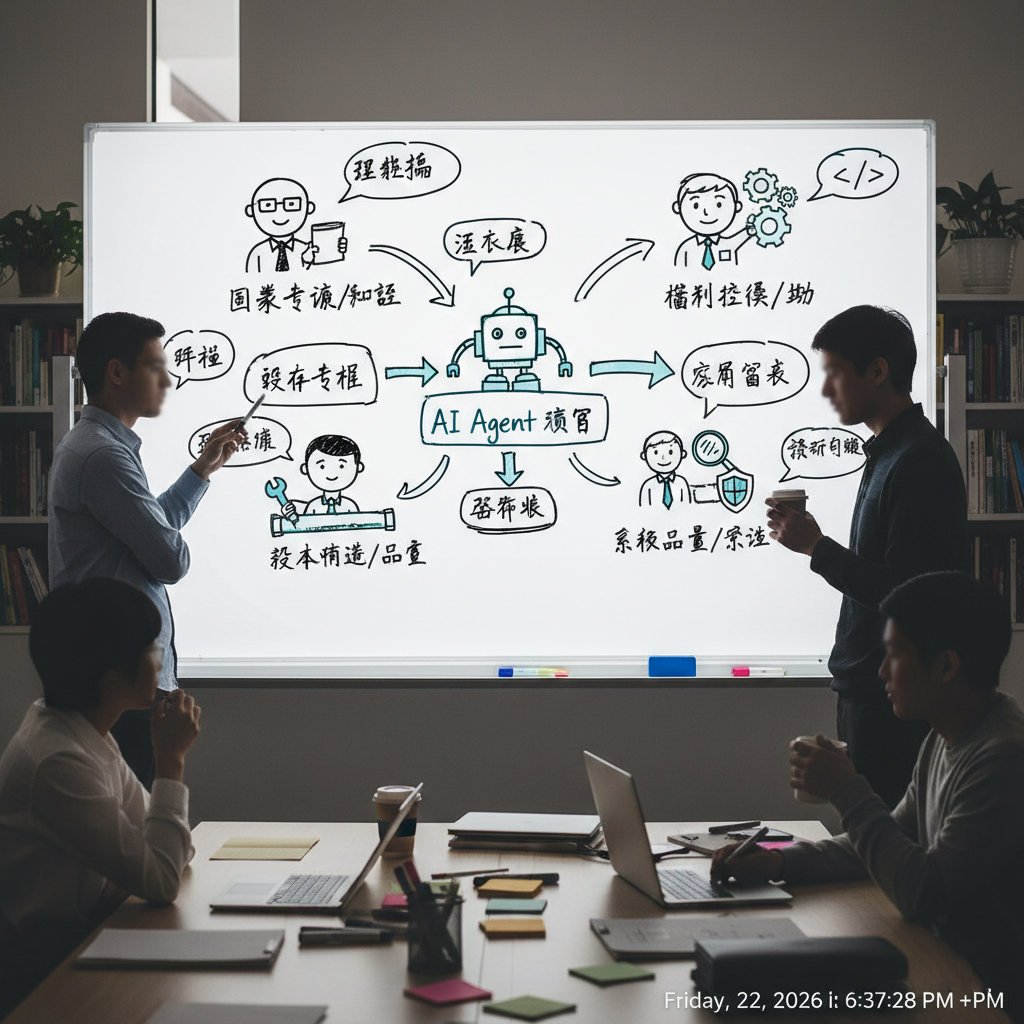

七、跨职能协作:系统工程的核心保障

行业痛点:智能体项目由算法团队单独负责,导致业务知识对齐不足、工程落地困难、运维保障缺失。

技术实践:

- 跨职能团队协作模式:

- 领域专家:嵌入算法团队,负责业务知识对齐、样本标注审核、合规校验;

- 数据工程师:搭建数据管道、MLOps 平台,保障数据的持续供给;

- 算法工程师:负责模型选型、训练、优化;

- 测试 / 运维团队:负责全链路测试、监控告警、故障排查;

- 敏捷协作机制:每周召开跨团队站会,同步进度与问题,每两周进行一次 Demo 评审,确保项目方向与业务需求对齐。

行业判断:智能体的培训是系统工程,而非单纯的模型训练,只有跨职能团队紧密协作,才能构建从业务落地到长期迭代的完整体系,保障智能体的长期价值。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录