Microchip:从SR-IOV到SIOV:云原生存储虚拟化范式

Microchip:从SR-IOV到SIOV:云原生存储虚拟化范式

数据存储前沿技术

发布于 2026-01-28 16:12:13

发布于 2026-01-28 16:12:13

阅读收获

- 理解SR-IOV与SIOV在控制面/数据面分离策略上的本质差异,掌握"快路径"与"慢路径"分离的架构设计思想

- 认识PASID技术如何突破传统PCIe寻址限制,为超大规模容器部署提供理论和技术基础

- 洞察存储虚拟化技术演进背后的硬件、标准和软件三维协同机制,建立技术生态视角

- 获取评估下一代云原生存储架构的关键指标框架,包括设备密度、隔离性和TCO等核心要素

全文概览

在云计算与容器化技术高速发展的今天,存储虚拟化正面临一个关键转折点。传统的SR-IOV技术虽然成熟可靠,但其在多租户场景下的扩展性瓶颈日益凸显——当需要支持成百上千个容器实例时,255个虚拟实例的限制成为难以逾越的天花板。

那么,我们能否在不牺牲性能的前提下,打破这一物理限制?SIOV(软件定义I/O虚拟化)的出现给出了答案:通过重新划分软硬件职责,将控制面上移至软件层,数据面保留在硬件端,成功实现了单个SSD支撑上千租户的技术突破。

本文将从架构原理、技术演进和生态挑战三个维度,深入剖析这场正在发生的存储虚拟化范式变革,为技术决策者和研究者提供有价值的参考框架。

👉 划线高亮 观点批注

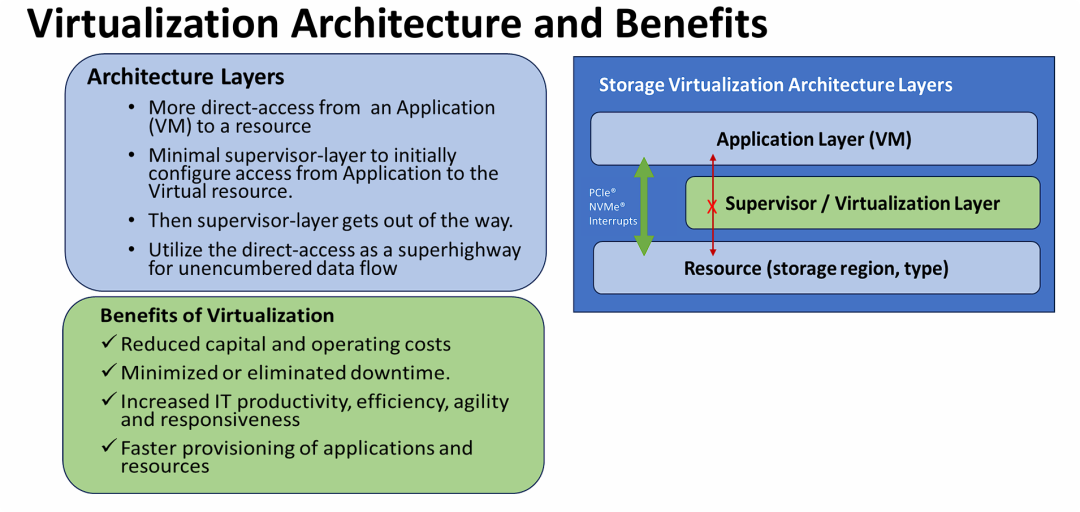

虚拟化架构(特别是存储虚拟化)的分层原理及其带来的商业与技术优势

虚拟化架构(特别是存储虚拟化)的分层原理及其带来的商业与技术优势

SR-IOV 作为一种优化的存储虚拟化架构,其关键点在于 “控制面与数据面分离” 和 “硬件直通” 技术。

- 架构核心理念: 传统的虚拟化层(Hypervisor)往往会成为I/O瓶颈。SR-IOV 架构提出,虚拟化层应仅负责初始的配置和管理(控制流),而在实际进行大量数据传输时,应允许虚拟机通过 PCIe/NVMe 协议直接访问底层存储资源(数据流)。

- 技术价值: 通过这种“直接访问(Direct-Access)”机制,消除了虚拟化层的开销(Overhead),实现了低延迟、高吞吐的数据传输(“无阻碍的数据流高速公路”)。

- 商业价值: 在保持虚拟化带来的灵活性、敏捷性和低成本优势的同时,解决了传统虚拟化可能面临的性能损耗问题,特别适用于对 I/O 要求极高的存储场景(如全闪存、NVMe 环境)。

多租户虚拟化环境中面临的痛点

多租户虚拟化环境中面临的痛点

图片的核心观点在于揭示多租户环境下“资源有限性”与“业务扩展性”之间的矛盾。主要包含以下关键信息:

- 硬件资源瓶颈: 在传统虚拟化模式下,随着租户(VM)数量增加,内存、存储和 CPU 资源面临巨大的线性增长压力,这限制了服务器的整合密度(Consolidation Ratio)。

- 管理复杂性: 真正的挑战不仅仅是增加硬件,更在于如何在共享资源的同时,严格保证隔离性(Isolation)、安全性(Security) 以及数据迁移(Migration) 的灵活性。

- 技术暗示: 结合上一张关于“直接访问”的PPT,这张图旨在通过列出传统挑战,为引入更先进的存储技术(如 NVMe SR-IOV、NVMe Namespaces)做铺垫。这些新技术正是为了解决上述的资源争用、隔离性差和性能损耗问题。

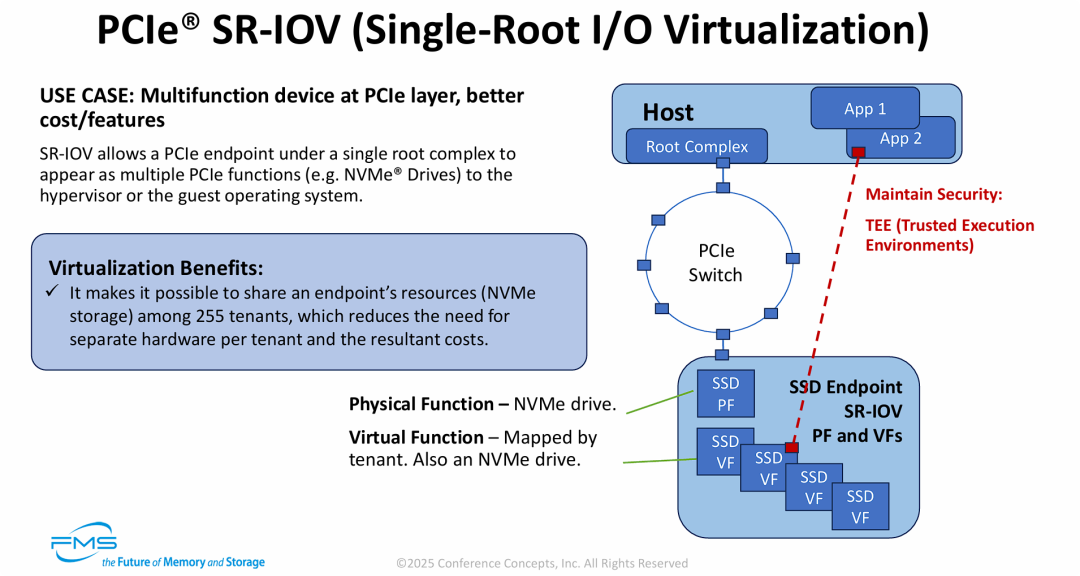

硬件级解决方案——PCIe SR-IOV 技术

硬件级解决方案——PCIe SR-IOV 技术

图片的核心在于展示 SR-IOV 技术如何通过硬件虚拟化解决多租户存储瓶颈。

- 资源倍增(1变N): 通过引入 PF(物理功能) 和 VF(虚拟功能) 的概念,让一块物理 NVMe SSD 在逻辑上分裂成多达 255 个独立的虚拟 SSD,极大提升了硬件的整合密度。

- 性能与隔离并重: 架构图中的红色虚线展示了“直通”路径。VF 允许虚拟机直接访问硬件资源,消除了软件模拟的性能开销,同时配合 TEE(可信执行环境) 技术,解决了上一张 PPT 中提到的“在共享系统中确保存储安全”的挑战。

- 经济效益: 这种架构大幅减少了物理硬件的需求量(无需为每个租户购买独立硬盘),直接降低了数据中心的 TCO(总拥有成本)。

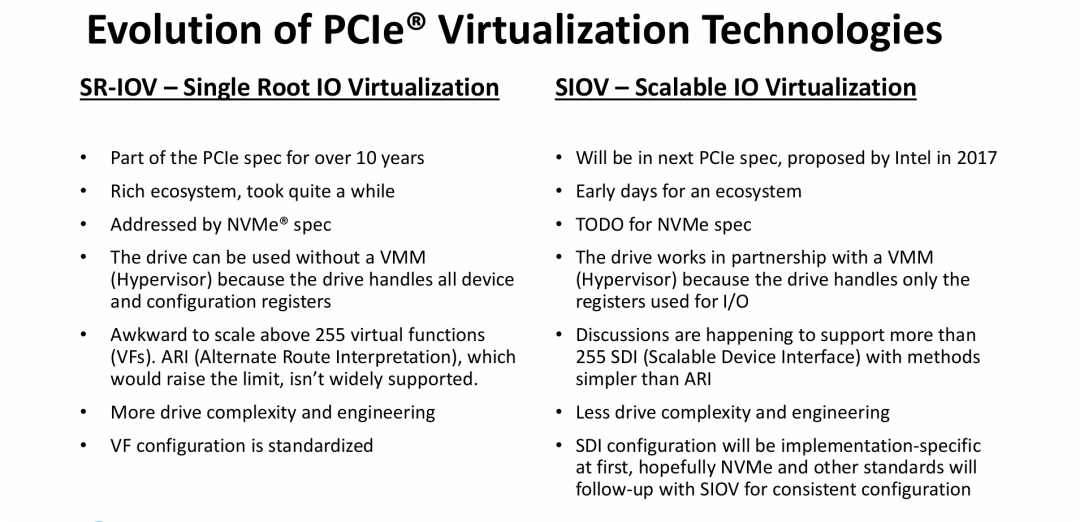

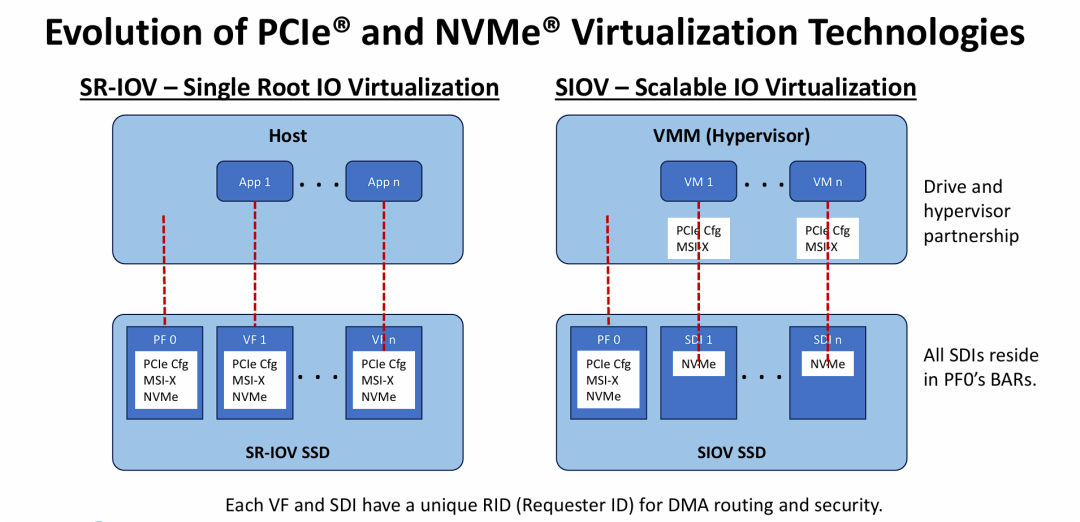

深度对比了成熟的 SR-IOV 技术和新兴的 SIOV 技术

深度对比了成熟的 SR-IOV 技术和新兴的 SIOV 技术

图片的核心观点在于 “从重硬件的全功能虚拟化(SR-IOV)向软硬协同的高扩展虚拟化(SIOV)演进”。

- 痛点与变革: 现有的 SR-IOV 虽然成熟且性能好,但在扩展性(难以超过 255 个租户) 和硬件复杂度上遇到了瓶颈,难以适应未来超大规模(Hyperscale)和容器化环境的需求。

- SIOV 的解决方案: SIOV 通过重新划分软硬件职责——“控制面归软件(VMM),数据面归硬件”,成功降低了硬件设计的复杂度,并打破了 255 个实例的限制,为未来支持成千上万个容器/轻量级虚拟机提供了技术基础。

- 技术成熟度曲线: 行业正处于从 SR-IOV 向 SIOV 过渡的早期阶段,SIOV 虽然前景广阔(低成本、高扩展),但在标准制定和生态建设上仍有很长的路要走。

PCIe 配置空间(Configuration Space) 和 寄存器映射 的微观层面

PCIe 配置空间(Configuration Space) 和 寄存器映射 的微观层面

架构对比图揭示了存储虚拟化**从“重硬件”向“轻量化、高扩展”**演进的本质技术细节:

- 控制面与数据面的彻底解耦:

- SR-IOV 是“全包”方案,硬件负责控制(Config)和数据(NVMe),导致硬件臃肿。

- SIOV 实现了控制面上移(给软件/VMM),数据面保留(在硬件/SDI)。通过剥离非数据传输必须的配置逻辑,实现了硬件的极简设计。

- 扩展性的物理基础:

- 正因为 SDI 移除了昂贵的片上寄存器(PCIe Config Space),硬件厂商可以在同样的芯片面积上,塞入成千上万个轻量级的 SDI 实例。这从物理底层解释了为何 SIOV 能突破 SR-IOV 的 255 数量限制。

- 安全性未打折:

- 虽然 SIOV 简化了硬件,但通过保留唯一的 RID (Requester ID),依然保证了硬件级的 DMA 隔离和安全性,没有因为追求扩展性而牺牲安全。

观点: 这张图是理解下一代云原生存储架构的关键。如果您正在规划超大规模容器云(如 Kubernetes on Bare Metal),SIOV 的这种架构能提供比 SR-IOV 高几个数量级的设备密度,是未来的必然选择。

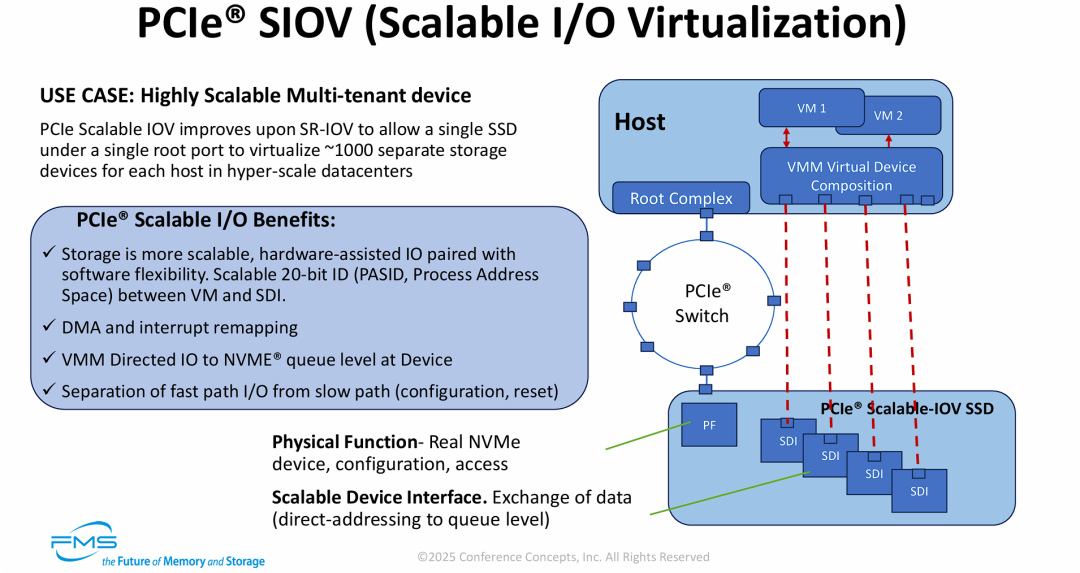

SIOV 技术规格、关键机制以及具体的架构实现

SIOV 技术规格、关键机制以及具体的架构实现

1. 左侧文字:核心优势与技术定义

- 应用场景 :

- 高扩展性多租户设备: 明确指出 SIOV 是为了改进 SR-IOV 而生。它允许单个根端口下的单个 SSD 虚拟化出 ~1000 个独立的存储设备。这直接回应了超大规模数据中心(Hyper-scale datacenters)对高密度容器部署的需求。

- SIOV 的四大核心优势 (PCIe® Scalable I/O Benefits):

- 软件灵活性与硬件性能结合: 这一点至关重要。

- PASID (Process Address Space ID): 这是一个关键的技术参数。SIOV 引入了 20-bit 的可扩展 ID。相比传统 PCIe ID 的限制,20位 ID 理论上支持百万级的寻址空间,彻底打破了 SR-IOV 的 255 限制。

- 重映射机制: 支持 DMA 和中断重映射(DMA and interrupt remapping),确保在大量虚拟设备下的地址转换安全。

- VMM 导向的 I/O (VMM Directed IO): 虚拟机管理程序(VMM)将 I/O 直接指向设备端的 NVMe 队列级别 (Queue level),实现了极细粒度的控制。

- 路径分离 (Separation of paths): 提出了核心架构理念——“快路径 (Fast Path)”(数据 I/O)与 “慢路径 (Slow Path)”(配置、重置)分离。数据走硬件直通,配置走软件模拟。

- 底部术语定义:

- Physical Function (PF): 真实的 NVMe 设备,负责整体配置和访问控制。

- Scalable Device Interface (SDI): 数据交换接口。注意这里的描述是 "direct-addressing to queue level"(直接寻址到队列级别),强调了 SDI 的本质就是一组硬件队列,非常轻量。

2. 右侧架构图:SIOV 工作原理

- Host (主机端) 的变化:

- VMM Virtual Device Composition (VMM 虚拟设备组合): 这是一个全新的模块。与 SR-IOV 不同,Host 端出现了一个软件层,负责“组合”出一个虚拟设备。这印证了“慢路径(配置)在软件中处理”的设计。

- VM 1 / VM 2: 虚拟机通过 VMM 提供的接口进行交互。

- 连接路径 (红色虚线):

- 这些虚线代表 I/O Fast Path (I/O 快速路径)。尽管配置由软件管理,但实际的数据读写依然通过 PCIe Switch 直接穿透到硬件,保证了高性能。

- Device (设备端) 的结构:

- PCIe® Scalable-IOV SSD:

- SDI (Scalable Device Interface): 图中展示了多个 SDI 块。由于 SDI 剥离了繁重的配置寄存器,它们在芯片上占用的资源极小,因此可以密集排列,支持海量实例。

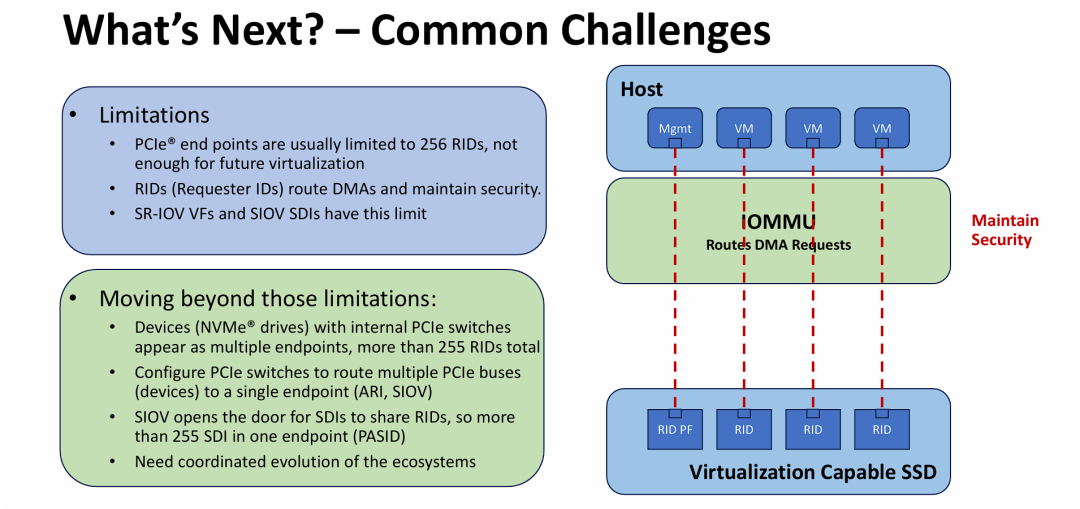

技术演进的下一步以及面临的共性挑战

技术演进的下一步以及面临的共性挑战

核心观点在于 “破解身份标识(ID)枯竭危机”,主要传递了以下关键信息:

- 瓶颈识别: 随着虚拟化密度增加,传统的 PCIe 寻址方式(依赖 Request ID)遇到了天花板。PCIe 规范中 Bus/Device/Function 的位宽限制导致通常只能支持 256 个唯一 ID,这限制了 SR-IOV 的进一步扩展。

- IOMMU 的关键角色: 强调了 IOMMU 在硬件虚拟化中的核心地位。它是利用 RID 进行 DMA 隔离和安全保护的硬件基础。

- SIOV 的杀手锏 (PASID): 再次点明 SIOV 的真正威力——复用 RID,引入 PASID。

- 传统模式:1 个 VM = 1 个 RID(总数受限)。

- SIOV 模式:多个 VM = 共享 1 个 RID + 不同的 PASID(总数几乎无限)。

- 通过这种方式,SIOV 成功绕过了物理层面的寻址限制,为实现单设备支持 1000+ 租户提供了理论和架构基础。

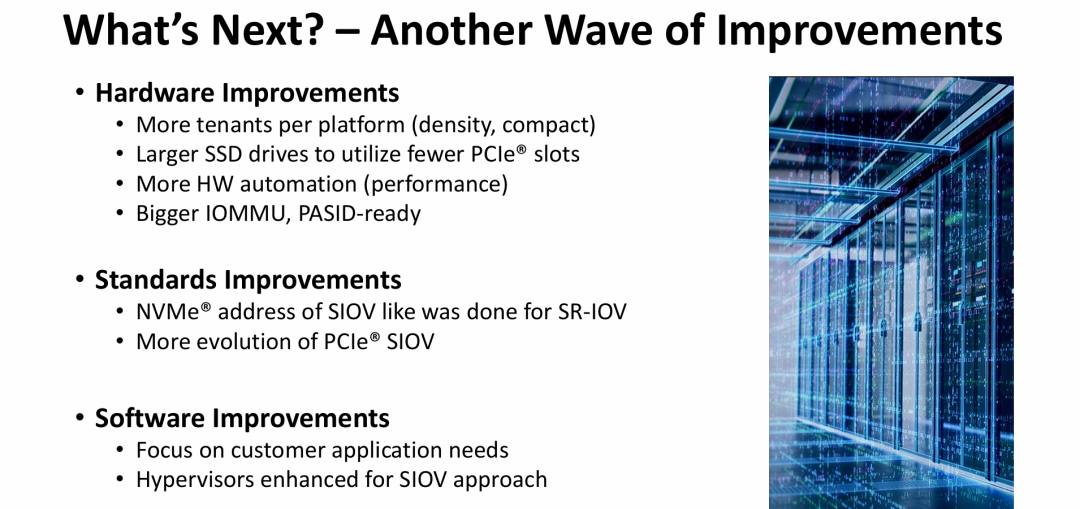

SIOV 在硬件、标准和软件三个层面必须进行的具体改进

SIOV 在硬件、标准和软件三个层面必须进行的具体改进

图片的核心观点在于 “SIOV 的落地需要硬件、标准和软件三位一体的协同进化”。

- 硬件准备度 (Hardware Readiness): 明确指出了 SIOV 部署的物理门槛——即 IOMMU 必须支持 PASID。没有这个硬件特性,前面提到的“千级租户”扩展性就是空谈。同时,硬件需要向更高密度(大容量盘)方向发展。

- 标准化进程: 强调了 NVMe 规范跟进的重要性。目前 PCIe 定义了传输层,但存储协议层(NVMe)需要给出具体的 SIOV 实现定义,以保证不同厂商设备的兼容性。

- 软件生态重构: 再次呼应了第5张图提到的“Partnership”。硬件准备好了,标准制定了,还需要 Hypervisor 厂商修改底层代码来支持这种新的虚拟化模型。

总结: 这张图标志着从“理论架构”转向“生态落地”。它告诉我们,从 SR-IOV 切换到 SIOV 不是换一块硬盘就能解决的,而是一场涉及 CPU/主板(IOMMU)、SSD 控制器、PCIe/NVMe 协议标准以及 OS/虚拟化软件的全行业技术升级。

延伸思考

这次分享的内容就到这里了,或许以下几个问题,能够启发你更多的思考,欢迎留言,说说你的想法~

- 在您的实际业务场景中,当前使用的虚拟化方案是否遇到过扩展性瓶颈?是如何应对的?

- SIOV技术的落地需要硬件、标准和软件三方面协同推进,您认为哪个环节的进展最有可能成为整体落地的关键制约因素?

- 随着NVMe over Fabrics和CXL技术的兴起,存储虚拟化的边界正在被重新定义。您如何看待这些新技术对SR-IOV/SIOV技术路线的影响?

原文标题:Transition from SR-IOV to SIOV (PCISIG) for IO Virtualization[1]

Notice:Human's prompt, Datasets by Gemini-3-Pro, Workflow by Minimax-M2.1

#FMS25 #多租户存储虚拟化

---【本文完】---

👇阅读原文,搜索🔍更多历史文章。

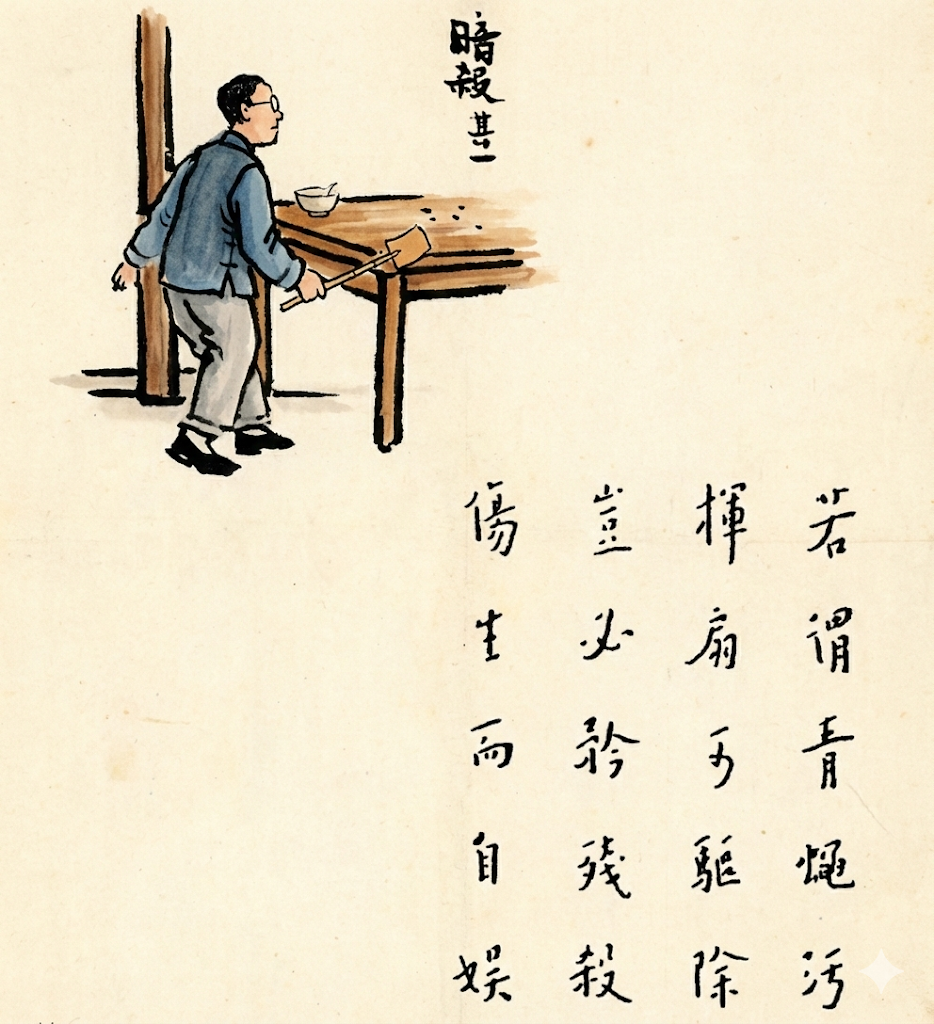

丰子恺-护生画集-暗杀·其一

- https://files.futurememorystorage.com/proceedings/2025/20250807_DCTR-301-1_Waidhofer.pdf ↩

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2026-01-18,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读