浅谈世界模型(上篇)

原创

(前段时间在看世界模型相关论文,规划一月初的文章,拖到了一月底...)

在通往通用人工智能(AGI)的道路上,“世界模型”已成为核心战场。本文就浅谈下世界模型。

由于篇幅较长,文章分为上下两篇:

上篇:世界模型的概念与抽象建模路线

- 心智模型:世界模型的哲学起点

- 世界模型:从强化学习到通用建模

- 联合嵌入流派:JEPA 系列

下篇:世界模型的生成、行动与空间智能路线

- 视频生成流派:Sora(OpenAI)、Genie(Google DeepMind)

- 强化学习流派:Dreamer(Google)

- 空间智能流派:World Labs

1. 前言:什么是世界模型

在深入技术细节前,我们必须先搞清:什么是世界模型?

什么是世界模型

在强化学习与智能体研究中,“世界模型”最早是由 Ha & Schmidhuber 在world models论文中提出:世界模型是通过学习,对环境的状态进行压缩表示,并预测这些状态之间如何随时间变化的模型。

什么不是世界模型

世界模型的核心是对环境状态的理解与预测能力,而不是要包揽从输入感知到输出动作的所有任务。

大家容易将世界模型能力理解过大,认为它应当解决 Agent 流程中的全部问题:

感知 --> 理解 --> 规划 --> 决策 --> 执行动作

但是如果按照论文定义,世界模型应该是系统中的一环(或几环):

世界模型不是Agent:世界模型是 Agent 的“大脑模拟器”,负责理解与预测;而 Agent 还包含决策、反馈和执行。

世界模型不是VLA: VLA 倾向于端到端映射,往往缺乏对物理规律的深度建模,泛化性较弱。

世界模型不是Planner:规划是基于世界模型的预测结果做出的,目前常用方案还是接入一个大模型做规划。

2. 世界模型技术流派

当前世界模型正从“建模数据”转向“建模物理世界本身”,主要分为以下四大流派:

2.1 联合嵌入流派:潜空间表征与抽象预测

代表模型:JEPA(Yann LeCun / Meta)

核心思路:理解世界不必重构像素,而是预测高层语义特征。例如给模型一段视频,它预测后续事件的抽象表示,但不是生成人类可懂的像素级画面。

优势: 极大地节省算力,且避免了生成式模型容易产生的“幻觉”,其实更接近人类观察世界的方式。

2.2 视频生成流派:物理规律的“像素模拟器”

代表模型:Sora(OpenAI)、Genie(Google DeepMind)

核心思路:通过像素级预测理解世界,如果模型能生成未来每一帧图像,就隐式理解了物理规律。

Sora:通过大规模视频训练学习重力、流体、物体遮挡等规律。视觉逼真,但可能违反物理。

Genie:可交互生成器,不仅生成视频,还能通过动作干预,例如通过键盘控制生成的视频内容。

2.3 强化学习流派:潜空间里的“白日梦”

代表模型:Dreamer(Google)

核心思路:将图像压缩到潜空间,在潜空间中进行“梦境”推演,从而训练策略。

优势:在机器人控制和游戏中证明,只靠内部想象就能学会复杂技能,不需要真实环境交互,这样可以大幅降低成本,尤其是极其难收集的机器人真实数据。

2.4 空间智能流派:3D物理的“架构师”

代表模型:World Labs(李飞飞团队)

核心思路:相比 Sora 的 2D 像素补丁,Marble 模型强调 空间一致性。它生成的不是“看起来像”的视频,而是可进入、可旋转、具有3D 几何结构的持久化世界。

优势:提供三维推理能力,支持机器人导航、建筑设计等需要精确空间感的应用

3. 心智模型:世界模型的哲学根源

1943年,肯尼斯·克雷克在《解释的性质》一书中首次提出了心智模型(Mental Model)的概念。书中的经典表述为:“The mind constructs small-scale models of reality that it uses to anticipate events。”克雷克认为,人类大脑是通过构建外部现实的“小型模型”来思考、推理和预测的。

举个例子,你正在准备过马路。在这个过程中,大脑会构建一个关于当前交通状况的“小模型”。这个模型可能有以下能力:

思考当前交通状况:观察到红绿灯的状态,以及是否有车辆正在接近。

预测未来:根据红绿灯和车速等,预测交通情况。

决策:基于预测,决定是立即过马路还是等待。

这种构建和操作“心智模型”的能力是智能和意识的基础。通过这些模型,我们能够更好地理解和预测现实世界的运作方式,从而做出更合理的决策。

心智模型的概念也是世界模型的哲学根源。

4. 世界模型(World Model)

World Models (2018.05.09)

论文地址: https://arxiv.org/pdf/1803.10122

2018年,David Ha 和 Jurgen Schmidhuber第一次在深度学习的语境下系统、明确地提出“World Models”的概念。论文的标题非常直白,影响力很大。

论文的核心思想是把高维、复杂的真实世界,压缩到一个可预测、可滚动的潜在空间中,再在这个潜在世界里做决策。后续很多世界模型都借鉴了这个思路。

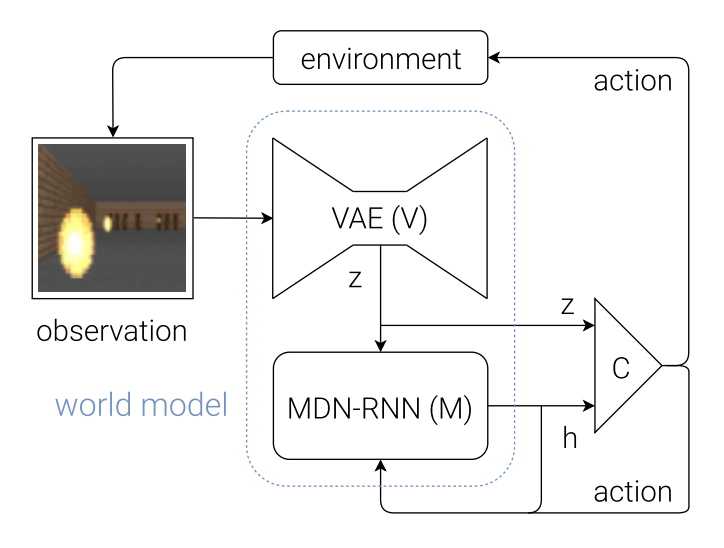

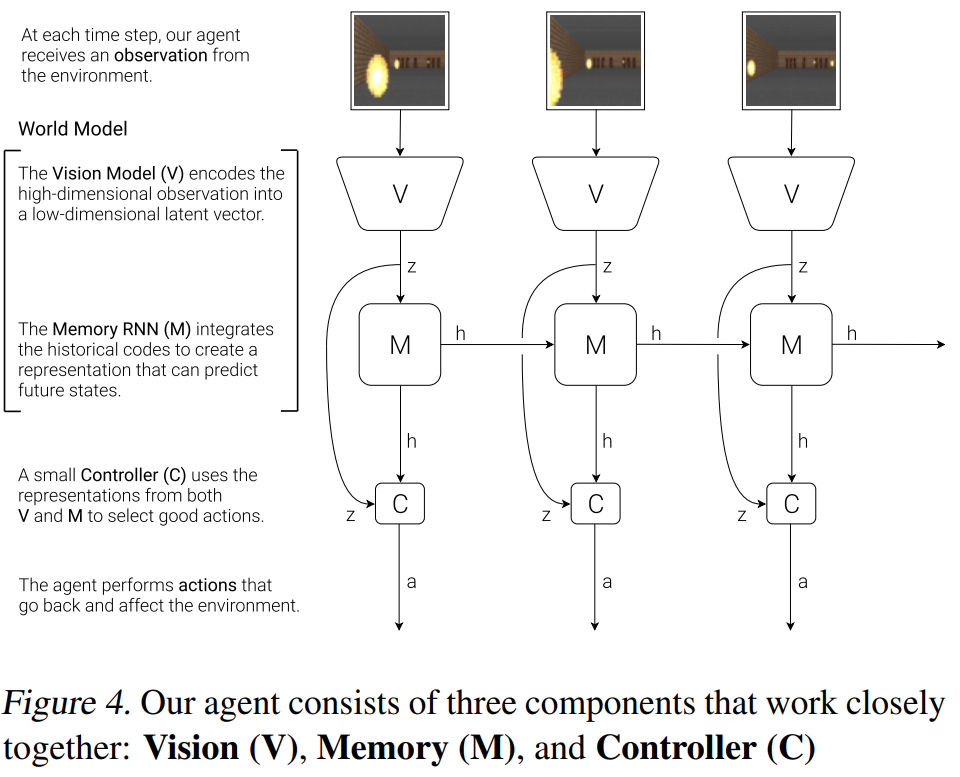

论文给出了非常有启发的三段式结构:Vision-Memory-Controller。

[V] 视觉表征模型(VAE):将高维视觉观测压缩为低维潜变量 z;

[M] 世界动力学模型(MDN-RNN):在潜在空间中学习世界的时间演化规律;

[C] 控制器(Policy):当前 latent 状态 + RNN hidden state,输出动作。

我们看下论文中伪代码,结构非常清晰

其中V和M模型的设计目前看都相对简单,但是因为他的阶段是分层的,所以每个模块的设计可以根据最新模型进行替,比如RNN换为Transformer。

总的来说,Ha 与 Schmidhuber首次提出通过深度生成模型在潜在空间中联合学习感知表征与环境动力学,从而构建一个可用于内部仿真与决策的世界模型,使智能体能够在“想象的世界”中进行规划与学习。虽然当时的模型比较原型,但是奠定了后续多年world model 研究主线思路。

5. 联合嵌入流派:JEPA 系列

5.1 JEPA:理论框架

A Path Towards Autonomous Machine Intelligence (2022.06.27)

论文地址: https://openreview.net/pdf?id=BZ5a1r-kVsf

背景和问题

如果说Ha的论文是证明世界模型是有用的,LeCun就是在追问那世界模型应该长什么样。Lecun在论文中指出动物和人类展现出的学习能力和对世界的理解远远超过了当前的AI。

生物能在有限数据下快速学习复杂技能,能有常识地进行推理与规划;能根据观察而不是纯监督大量试错来构建世界知识。

但是现有的AI技术的核心局限包括:

- 缺乏稳定且全面的世界模型;

- 学习依赖外部监督和强化学习试验次数极高;

- 现有表示和策略学习系统难以实现长期规划和抽象推理。

所以论文提出机器存必须面对挑战:

- 机器如何通过观察来学习表示世界、学习预测以及学习行动?

- 机器如何以一种用基于梯度的学习的方式来进行推理和规划?

- 机器如何能够在多个抽象层次和时间尺度上以分层的方式学习表示感知和动作计划?

论文方案

论文提出了构建自主智能体的架构和训练范式。它结合了可配置的预测世界模型、通过内在动机驱动的行为以及通过自我监督学习训练的分层联合嵌入架构等概念。

论文的主要贡献:

- 提出了一个整体认知架构如下图:

感知负责抽象现实,世界模型负责预测变化,Actor 在想象中决策,Critic 负责评估代价与收益,最终只将最优动作执行到真实世界。

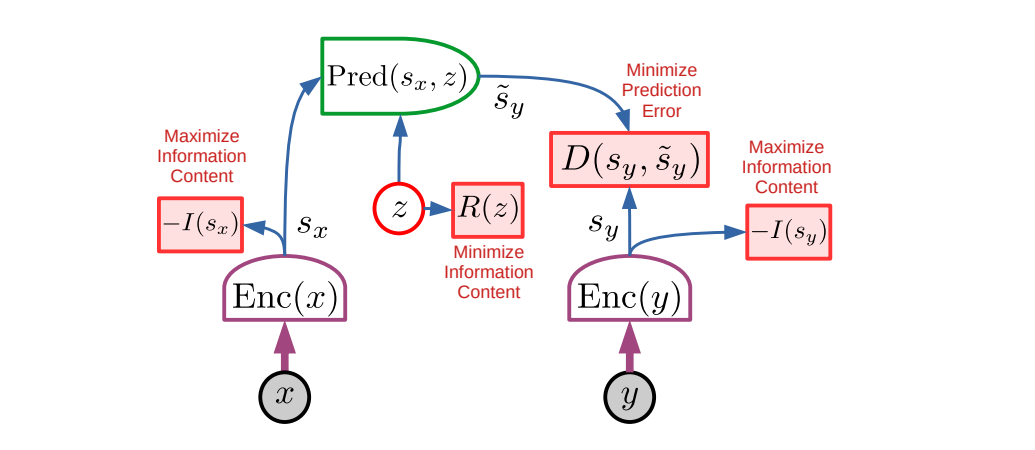

论文的核心方案:

- 提出了用于学习表示层次结构的预测世界模型的非生成架构

2. 一种非对比的自我监督学习范式,它产生同时提供信息和可预测的表示。

3. 一种使用 H-JEPA 作为预测世界模型基础的方法,用于在不确定性下进行分层规划。

其中关于JEPA的技术在下面章节重点介绍。

论文贡献

总的来说,论文提出了一个可行的机器智能认知架构蓝图:将世界模型、预测、规划、内在驱动和表示学习集成;强调模块可微分与协同训练;从整体上定义了未来自主智能体的设计方向。

另外JEPA最核心的思想是,世界模型应该是能够支持预测未来的抽象表示,捕捉世界的关键动态和高层次规律,而不是精确预测每一个像素或细节,不试图去构建没有见过的输入(比如像素)。LeCun认为这种预测能更有效捕获结构性和可预测的世界规律。

和上一节Ha的世界模型一样都是学习世界的表征,然后在潜空间学习规律;但是有个最大的区别是Ha提出的世界模型的laten是通过像素重建训练出来的,所以可以认为表征好不好的判断是能不能重构世界。JEPA是在潜空间和未来潜空间对齐,不存在要恢复世界的思想。

这篇论文是JEPA的初期阶段,主要还是一种理论与框架,它阐明了一类非生成性、自监督预训练,如何通过预测潜在表示来学习世界模型。2023 年以后,JEPA 被具体化为多个实际模型。

5.2 I-JEPA:图像领域落地

I-JEPA :Self-Supervised Learning from Images with a Joint-Embedding Predictive Architecture(2023.04.13)

论文地址:https://arxiv.org/pdf/2301.08243

背景和问题

当前图像自监督学习的主流方法大致有两类:

视图不变性方法(Contrastive / Invariance):通过对同一张图片进行数据增强,学习不变的表示,从而获取到图像表征。这类方法性能强但需要精心设计的数据增强策略。

生成式重建方法(Reconstruction / Masked Modeling):通过遮掩部分图像,然后重建像素或语义 token 来学习表征,但侧重于像素级信息,难以获得高层语义特征。

这些方法存在一个共同问题:要么依赖手工准则的数据增强,要么在像素空间重建细节,都不是直接学习图像的语义表示。

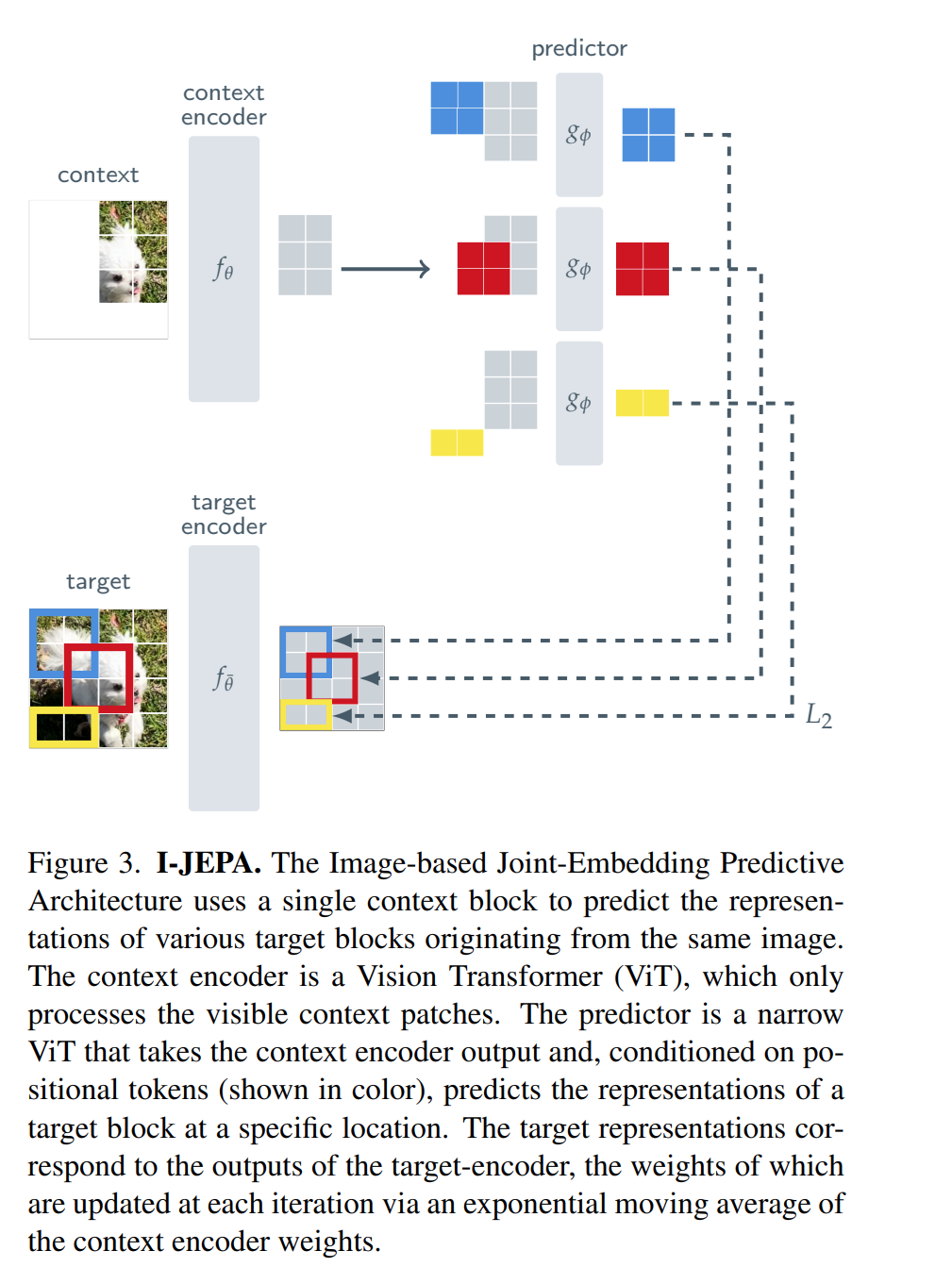

I-JEPA论文提出的思路在上篇JEPA一致,就是在抽象的表示空间中直接预测目标块的表征,而非重建像素,从而更高效且更语义化地学习图像表示

论文方案

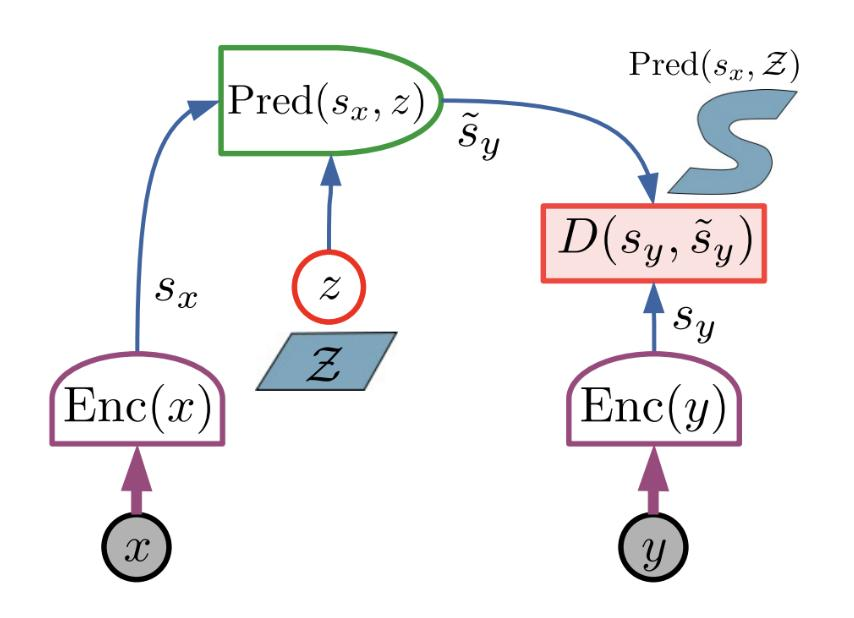

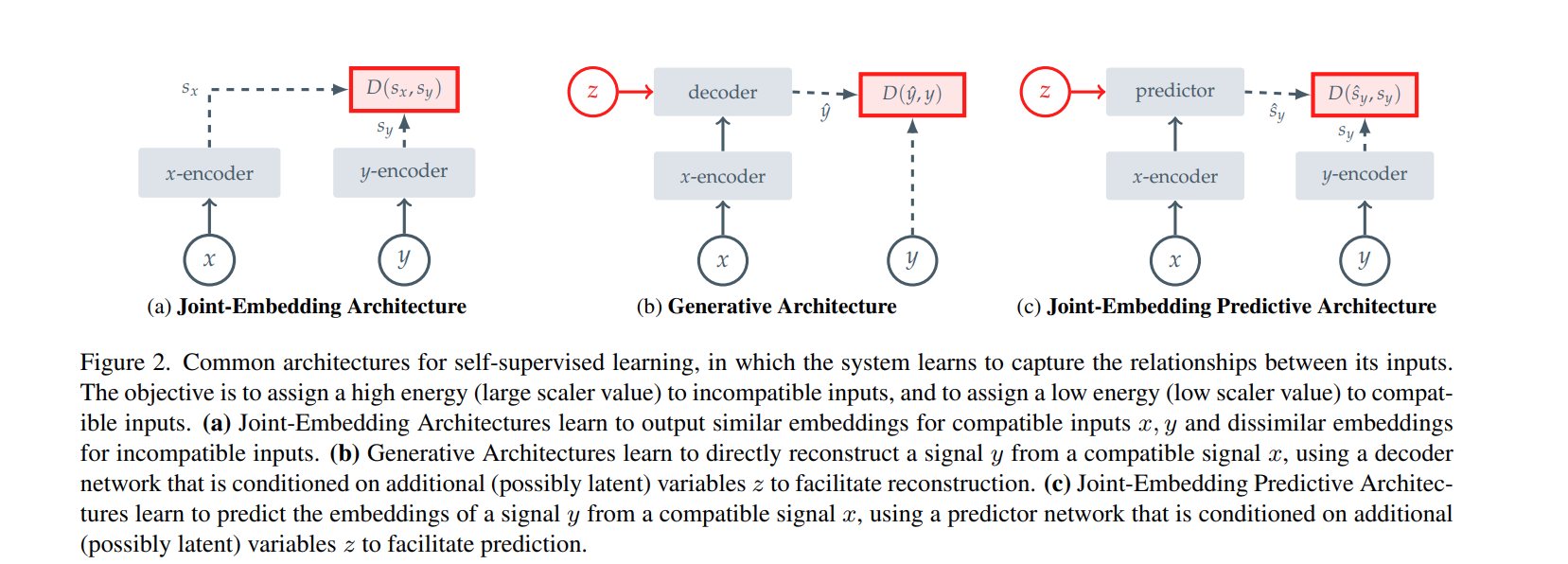

(a ) 联合嵌入架构 (Joint-Embedding Architecture, JEA) 是对比学习常用的框架,计算x和y在特征层的空间距离。框架简单只关注语义特征,但是缺点是容易出现坍塌问题,模型容易把数据映射到同一个常向量。

(b ) 生成式架构(Generative Architecture),主流生成模型架构,输入x通过编解码,再引入潜在变量z,目标是和原始数据空间(图像像素或者Token级)重建。优点是学习到特征丰富,因为要关注所有细节,缺点就是计算成本高并且效率低。而且在世界理解的场景,通常不需要关注细节。

(c ) 联合嵌入预测架构(Joint-Embedding Predictive Architecture, JEPA)论文提出的架构,结合了a和b的优点,不做像素级别的重建,也不仅仅简单对比特征层的特征,而是做特征层的预测。Predictor预测器接收x的特征和潜变量z,去预测y的特征层。

JEPA框架的优势是不需要预测无关紧要的细节了,而是预测高层语义;然后通过预测器的引入又能迫使模型去理解动态变化,而不是静态相似防止模型坍塌。

这篇论文提出的I-JEPA就是基于图像数据来使用JEPA框架。上图解释了encoder使用的ViT,然后训练方法就是遮住一部分图像,然后去进行预测。熟悉么?我看到这个训练方式的第一反应就是Bert。但是只是训练思路有相似,本质上还是很不一样的。LeCun一直有强调他不是在像素级别重构上去做生成式,所以训练目标不一样,I-JEPA对齐的是遮住的像素的特征表示,而不是要去对齐像素本身。

主要贡献

上一篇JEPA是提出了一个认知框架和学习范式,提出未来的Agent应该如何学习世界,预测未来,驱动行为。

那本篇论文就是提出了按照JEPA的思路,再图像落地具体是什么样子,给出在图像领域真实可训练可复现的实验模型。

5.3 V-JEPA:视频领域落地

V-JEPA: Revisiting Feature Prediction for Learning Visual Representations from Video(2024.02)

论文地址:https://arxiv.org/abs/2404.08471

背景和问题

JEPA的思路在上篇论文I-JEAP图像领域已有实验和验证。这篇论文提出是否可以仅通过在 latent 表示空间中预测未来/被遮蔽的特征,作为自监督目标,来学习通用且高质量的视频表示呢?V-JEPA就是在再视频领域利用JEPA框架,学习视频的高级表征。

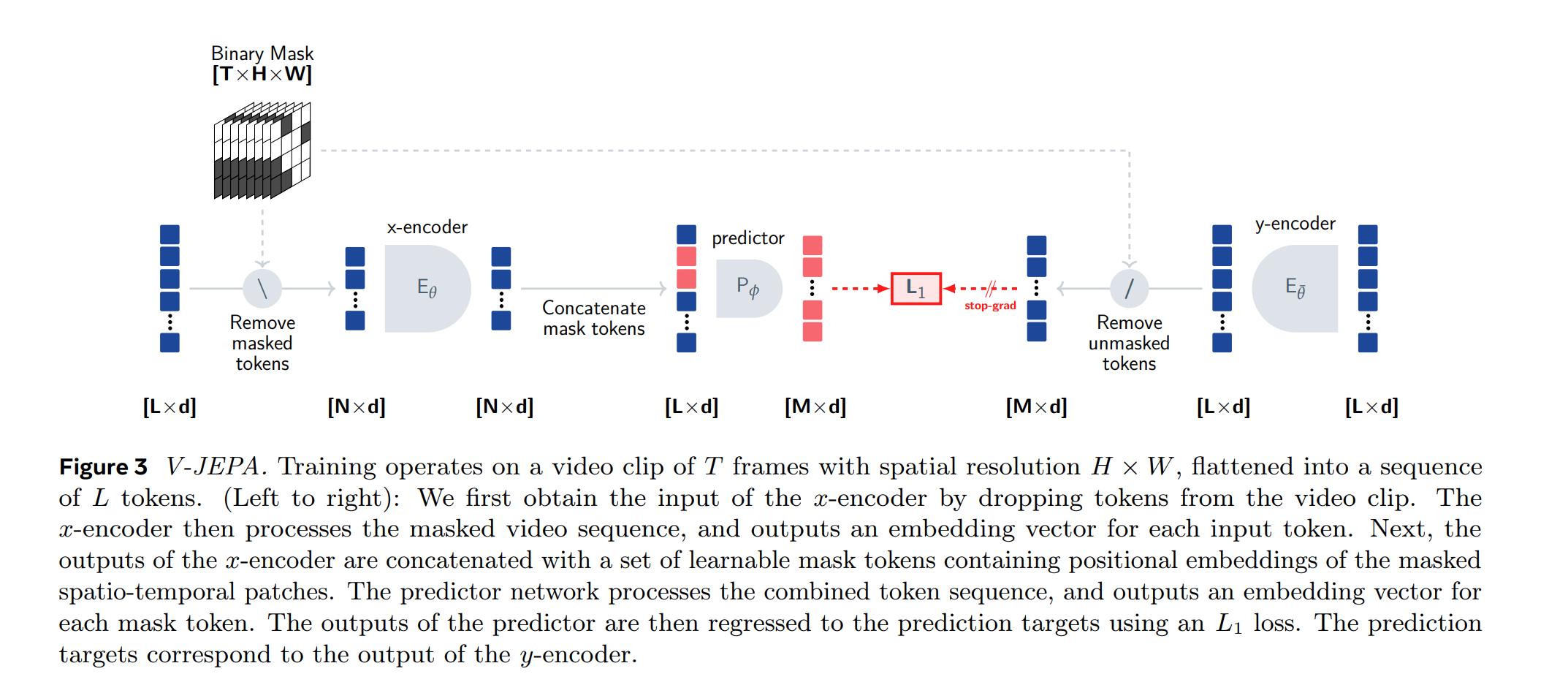

论文方案

整个思路和I-JEPA一样,但是从图像领域跨越到了视频领域。针对视频数据进行了调整,输入上通过将视频视为3D图像来实现这一点。

训练过程基于一个包含T帧的视频片段,空间分辨率为H×W,将其展平成一个L个token的序列。和I-JEPA一样的训练逻辑,先mask一些tokens经过Encoder;训练目标就是预测这些被mask的token的Encoder特征。

所以V-JEPA也是学习通过视频的一部分表示来预测视频另一部分的表示。

主要贡献

该论文与 I-JEPA类似,都是在 latent 表示空间学习预测目标;但 V-JEPA 扩展到视频时空结构上,并展示了预测视频特征能学习同时具 motion 和 appearance 表征。作者在大规模视频集(约两百万视频)上预训练了 V-JEPA 模型。主要实验结果证明:

在动作识别任务 Kinetics-400 上实现 81.9% top-1 accuracy(ViT-H/16 架构);

在 Something-Something-v2(强调 temporal motion)上 72.2% accuracy;

在 ImageNet1K 上也达到了有竞争力的表现 77.9%。

在此期间,openai的Sora也横空出世,下篇会介绍。

5.4 V-JEPA 2:视频与行动

V-JEPA 2: Self-Supervised Video Models Enable Understanding, Prediction and Planning(2025.02)

论文地址:https://arxiv.org/pdf/2506.09985

背景和问题

当前的世界模型缺少一个能够统一“理解世界、预测状态、规划行动”的自监督体系。

V-JEPA 是 JEPA 思想的初始视频表征实例,主要关注视频特征学习;V-JEPA 2 是这一思路的大规模、跨任务推广版本,不仅学习视觉表征,而且通过额外训练步骤构建世界模型,支持行动预测与规划,大幅拓展了模型的能力边界。

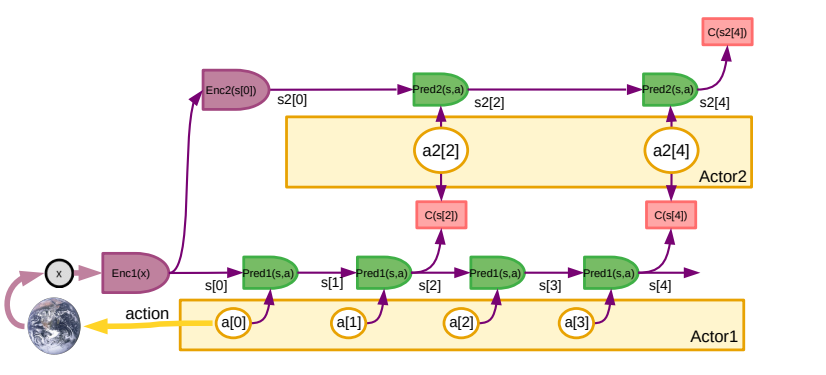

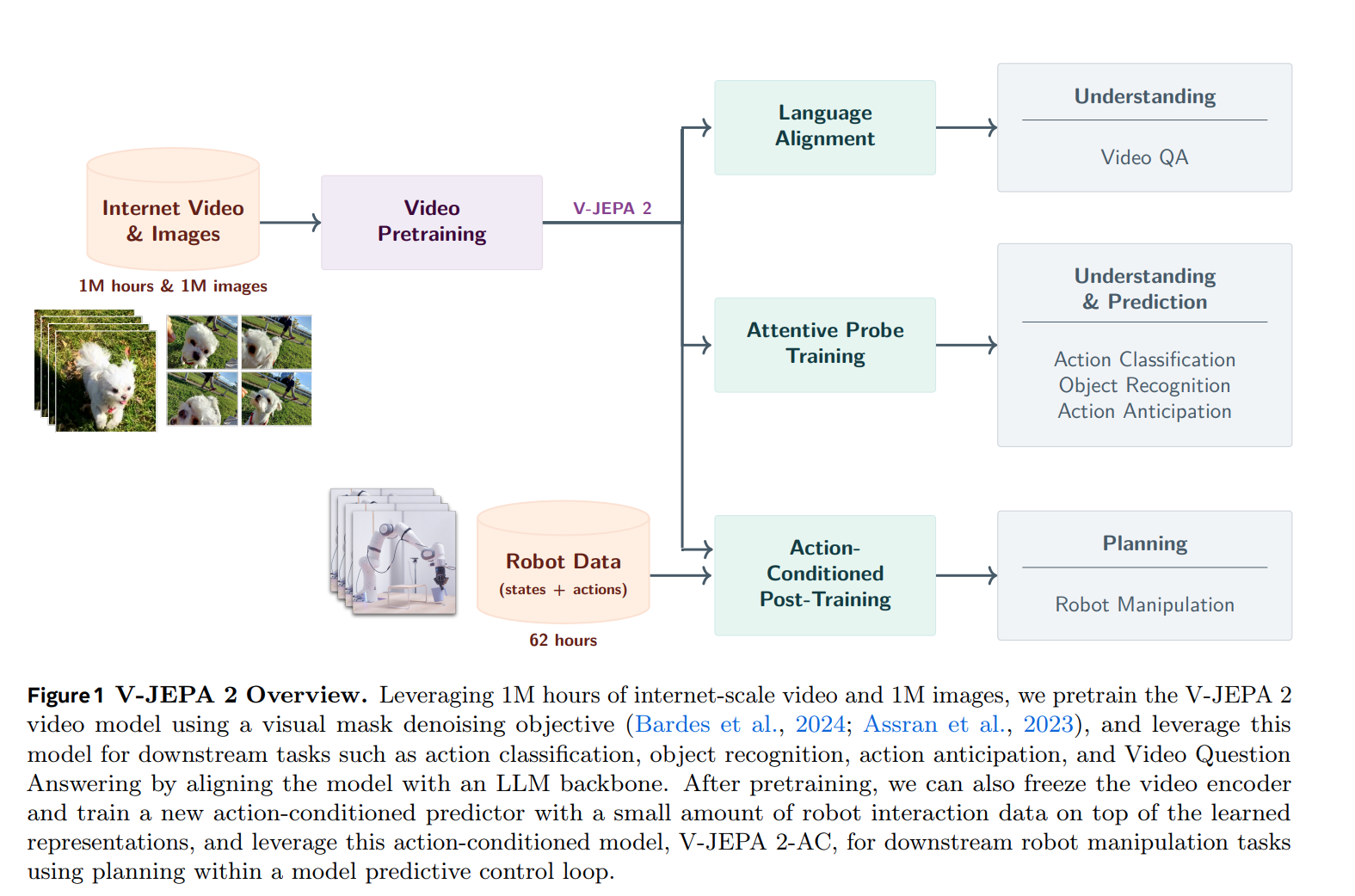

论文方法

V-JEPA 2相对比V-JEPA的在模型和数据上都做了扩展,数据从200w视频扩展到2200w,包含100万小时的互联网规模视频和100万张图像;模型参数也从3亿参数扩展到10亿参数;训练的迭代次数从9万次增加到25.2万次;另外在训练阶段渐进增长分辨率和视频长度,从16帧256x256 到 64 帧 384x384。V-JEPA 2 在多项下游任务的准确率上比V-JEPA取得了显著提升。

V-JEPA 2 模型可以对视频中缺失的部分进行预测,具备了更好的视频表征。但模型并没有直接考虑动作所带来的因果效应。所以还需要下游的交互数据,让模型能够对未来规划。

作者通过预训练的V-JEPA 2模型再完成下游任务,例如动作分类、物体识别、动作预测以及通过将模型与大型语言模型骨干对齐来进行视频问答,达到理解世界和预测世界能力。

在完成预训练之后,冻结视频编码器,使用少量机器人交互数据(62小时的机器人数据)训练一个新的动作条件预测器。利用这个动作条件模型——V-JEPA 2-AC(3亿参数的Transform结构模型),通过在模型预测控制环内进行规划,来完成下游的机器人操作任务,达到规划和执行能力。

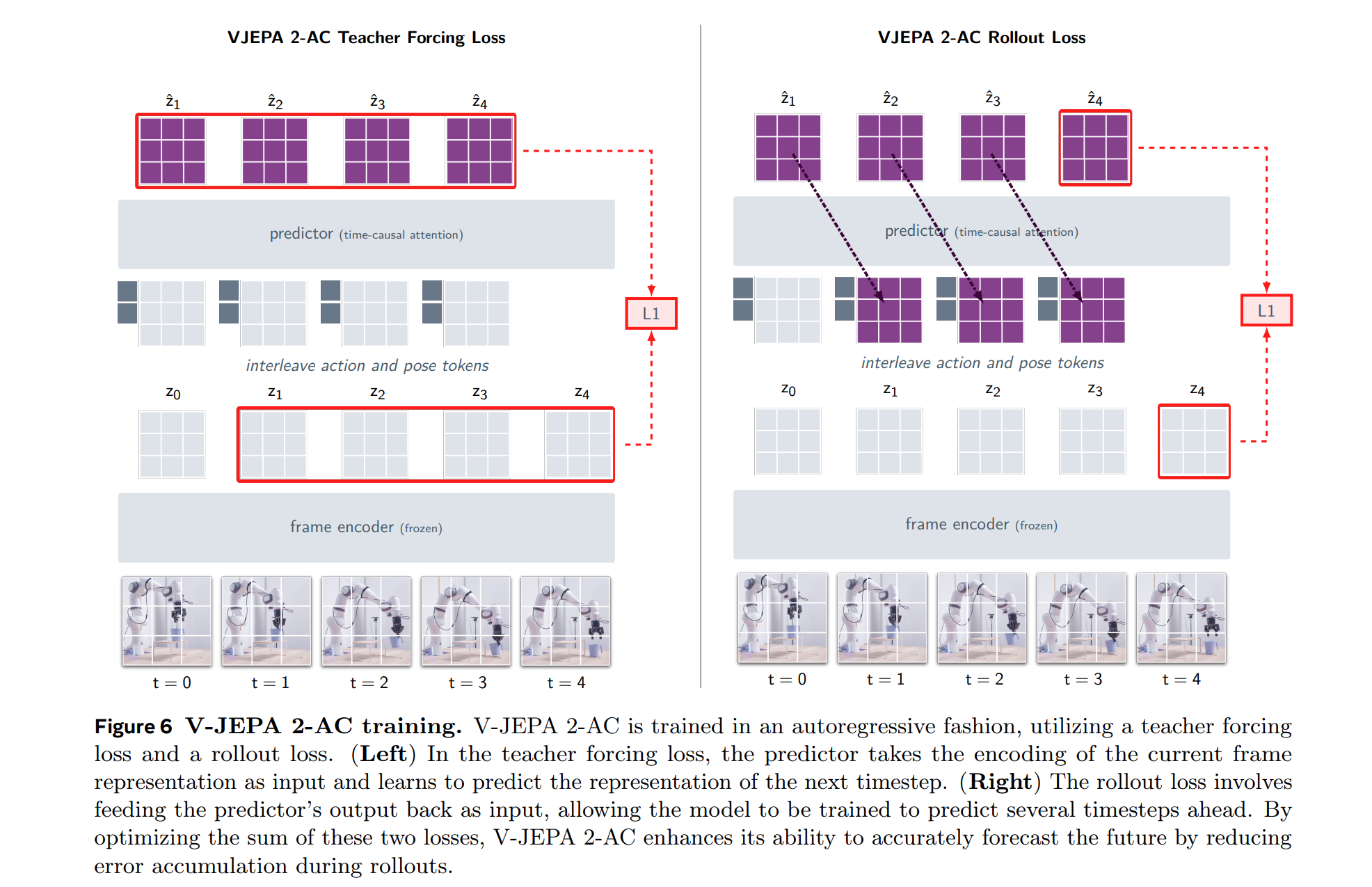

V-JEPA 2-AC 以自回归的方式进行训练,上图(左)Teacher Foring Loss,预测器将当前系列帧表征的编码作为输入,学习预测下一时刻的表征。上图(右)rolloutLoss将预测器的输出反馈为输入,使模型自回归训练去预测未来的时间步。通过优化这两个损失的和,V-JEPA 2-AC 增强了准确预测未来的能力,也减少了rollout过程中的误差累积。

主要贡献

V-JEPA 2 不仅是一个更强的视频表示学习模型,更是一种通用世界模型的具体实例。首先通在超过百万小时视频上学习 latent 表示的预测性结构,训练统一的大规模自监督视频世界模型;然后将V-JEPA 2 与大语言模型对齐后,从理解到语义推理和规划;最后在机器人上引导规划与零样本机器人控制,代表了从视觉理解/预测向实际行为规划应用的重要跨越。

5.5 LeJEPA:理论收敛

LeJEPA: Provable and Scalable Self-Supervised Learning Without the Heuristics(2025.11)

论文地址:https://arxiv.org/pdf/2511.08544

问题和背景

前几篇论文中介绍了,JEPA都是通过无需人工标注的数据来训练强大的表征学习模型。但是这些方法普遍存在一个核心痛点:“模型坍塌”。 为了避免坍塌,研究人员不得不引入大量经验性的技巧,例如:

负样本:强制将不相似的样本在特征空间中推开。

停止梯度(Stop-Gradient):阻止一部分梯度回传,制造不对称性。

Teacher-Student EMA:使用一个参数缓慢更新的老师网络来指导学生网络。

但是这些技巧缺乏坚实的理论基础,使得模型训练过程充满玄学,对超参数敏感,复杂脆弱且难以解释难以复现。

论文方案

LeJEPA 的提出就是为了解决这一根本性问题。它基于JEPA框架,但核心创新在于引入了一种名为 SIGReg (Sketched Isotropic Gaussian Regularization) 的正则化方法。

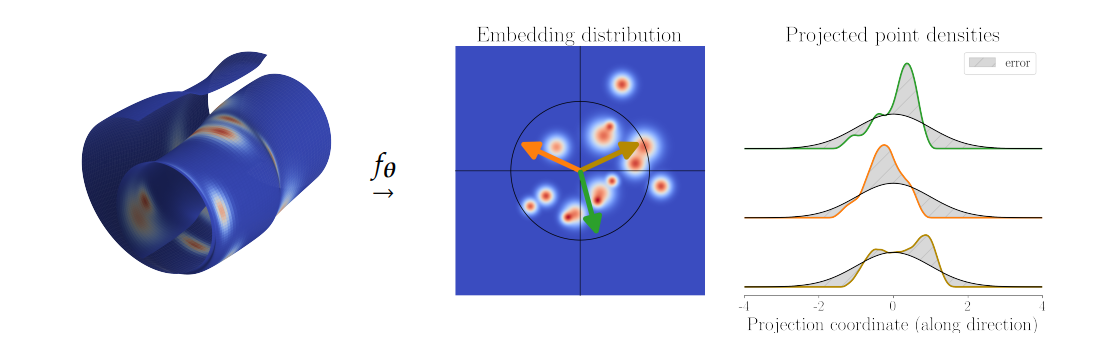

不再直接干预高维特征的形态,而是通过“观察其投影”来引导其分布,如下图。

简单来说,这张图展示了如何把原本杂乱无章的数据(左),强行捏成一个完美的球形分布(中),而且是通过一种极其巧妙的降维切片方法(右)来实现的。

关于为什么一定要强行捏为高斯球,论文有解释,我让gemini总结了下 :

LeJEPA 的核心思想是:与其在高维空间中直接拉伸或挤压这些特征点,不如从多个随机方向上对它们进行“降维投影”,然后检查这些投影是否符合我们期望的完美形状。

完美形状:上面已经解释了各向同性高斯分布(Isotropic Gaussian)是目标分布 因为高斯分布在固定方差下拥有最大熵(承载信息量最多),且其各维度之间统计独立(特征解耦),更重要的是,它具有投影不变性——无论从哪个方向投影,其一维影子依然是高斯曲线。

这是一个理想的特征分布,它天然避免了坍塌。

SIGReg随机选择若干个 1D 投影方向(彩色箭头)。将高维特征投影到这些 1D 方向上,得到一维的投影密度函数(如上图右侧的彩色曲线)。

SIGReg 的目标是:最小化这些实际投影密度与理想一维高斯曲线(黑色曲线)之间的差异(灰色阴影区域)。

Cramér-Wold 定理表示如果一个高维分布在所有(或足够多的随机)一维投影上都符合某个目标分布,那么它在高维空间中也必然符合那个目标分布。这样,我们就把一个难以处理的高维问题,转化为了无数个简单且高效的一维匹配问题。

论文提出新的算法 LeJEPA,它由两部分组成:

预测任务:

这与标准的 JEPA 一样,要求模型根据部分输入 x 预测缺失部分 y 的特征。

作用:学习语义理解能力。

核心创新:SIGReg

它的作用非常直接:强行把特征向量的分布“捏”成上述的各向同性高斯分布。

它利用了一种叫“草图(Sketching)”的数学技巧,能够在大规模数据上极快地计算特征分布与高斯分布的距离。

公式逻辑(简化版):

只要最小化这个 Loss,模型既能预测未来(理解世界),其特征又会自动撑开(防止坍塌)。

LeJEPA 标志着 JEPA 架构从经验主义走向了严谨科学。

以前:我们通过加各种复杂的补丁来防止模型坍塌,虽然能跑通,但不知道为什么。

现在:我们知道模型特征必须是“各向同性高斯分布”,我们直接把这个要求写进 Loss 函数里(SIGReg),模型自然就不会坍塌,而且训练更快、更稳、更可解释。

论文贡献

LeJEPA 的核心价值在于,它将自监督学习从依赖于“技巧配方”的经验主义,转向了基于严谨理论的系统性设计。其表现出的简洁性、稳定性和强大性能,有望使其成为构建下一代基础模型的核心预制训练方法。

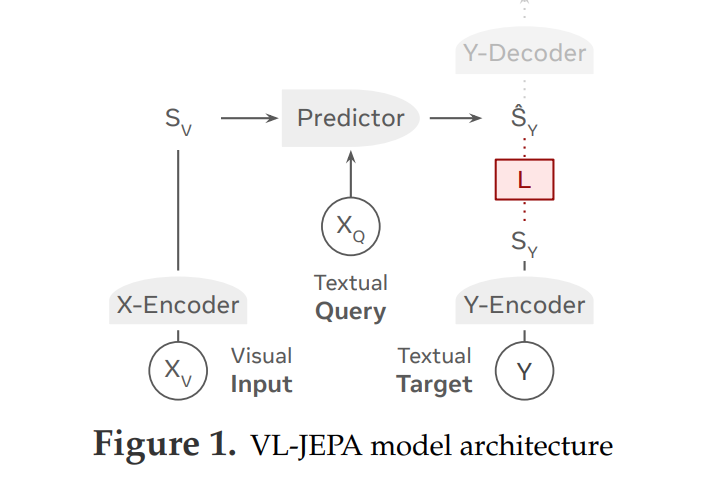

5.6 VL-JEPA:理论收敛

VL-JEPA: Joint Embedding Predictive Architecture for Vision-language (2025.12)

论文地址:https://arxiv.org/pdf/2512.10942

背景和问题

常用视觉语言模型(VLM)通常采用自回归方式逐词生成文本,这种方式存在两个主要问题:

训练效率低:模型需要学习所有表面语言细节,这分散了学习核心语义的算力;

推理延迟高:必须等完整文本生成后才能获得语义,难以支持需要实时语义流的应用比如实时动作追踪、流视频分析等场景。

论文依然基于JEPA思想,认为智能的核心在于理解和预测,而不是是否能把每个token都修饰的很完美。结合视觉和语言,提出了VL-JEPA框架:

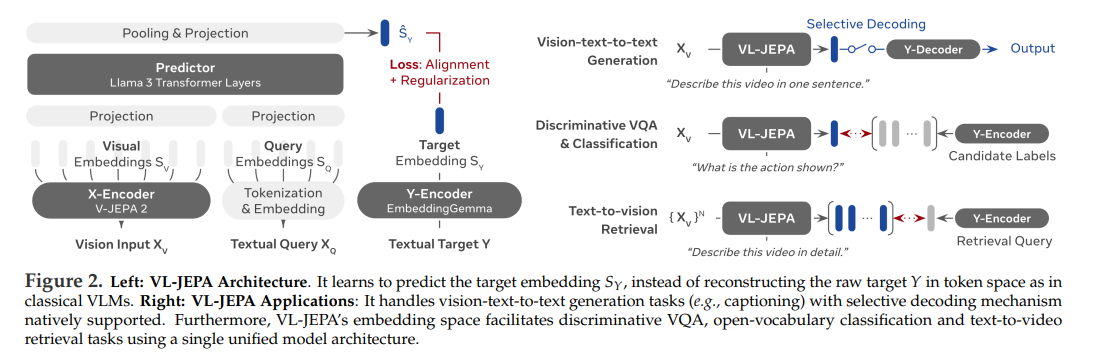

论文方案

论文思路依然是基于潜在空间,用连续语义嵌入空间(continuous embeddings)代替离散 token 空间特征生成目标。让模型可以更直接学习视觉与文本之间的语义关联,并摆脱复杂的 token 自回归假设。

如上图,VL-JEPA 由四个模块构成:

(1)X-Encoder(视觉编码器)

将图像或视频帧序列采用V-JEPA 2 编码为视觉向量,并冻结权重。

(2)Y-Encoder(文本编码器)

将目标文本采用EmbeddingGemma-300M映射为连续语义embedding。注意不是生成 token,该编码器输出用于对齐与预测的语义embedding目标。

(3)Predictor(预测器核心)

这个组件是 VL-JEPA 的核心:

在输入视觉嵌入与查询文本嵌入后,输出对目标 embedding 的预测。预测器本质上是一个有条件 Transformer,通过语义上下文预测目标 embedding。

(4)Y-Decoder(轻量文本解码器)

训练时冻结,只在推理阶段使用,将预测的语义 embedding 转换为人类可理解的文本

虽然在编码器上和VLM一样,也是基于潜空间对齐,但是VL-JEPA 的训练与传统VLM 有本质区别:

(A)嵌入空间预测损失(VL-JEPA Loss)

VLM是图文表征拉齐,最终是token级别的生成对齐。

VL-JEPA 的监督目标是在嵌入空间匹配的预测 embedding 与真实文本 embedding:

使用 InfoNCE loss 来衡量预测嵌入与真实嵌入之间的相似性(对比学习形式)。

这种目标使学习更注重语义一致性而不是token生成顺序,从而提升效率与泛化。

(B)两阶段训练流程

首先大规模非条件对齐预训练,在大量图像/视频 + 描述对上进行嵌入预测对齐,以获得强语义表征基础。

然后进行SFT有监督微调,使用问答与句子生成任务数据使模型具备更强的视觉问答与交互理解能力。

基于VL-JEPA也有推理优势:

(A)选择性解码(Selective Decoding)

因为预测的是连续 embedding,不必每一步都生成文字 token。模型可以根据语义流的变化只在必要时才调用文本解码器,论文认为世界状态变了(使用向量距离)才需要解码,世界状态没变是不需要解码的。根据连续性不用和token离散性解码的优势,显著减少解码次数(约 2.85×)。

(B)参数与计算更节省

相比于自回归 VLM,VL-JEPA 的可训练参数减少了约 50%,且推理大幅更快。

主要贡献

VL-JEPA 是一个视觉-语言建模方向的新架构,它把语义嵌入预测的概念从单模态推广到多模态领域。通过更高效的监督目标和推理机制,使用更少的参数,速度更快,表现更好,再相同视觉编码器和训练数据下,VL-JEPA比传统VLM少用50% 的可训练参数,但在零样本描述和分类任务上表现更优。

另外,不需要修改架构,即可支持生成(如描述)、判别(如视觉问答VQA)、开放词汇分类和文本-视频检索等多种任务。

模型经过监督微调后,在8个视频分类和8个视频检索数据集的平均性能上超过了CLIP、SigLIP2等专门模型。尽管只有16亿参数,其在GQA、TallyQA等四个VQA数据集上的表现与InstructBLIP、QwenVL等大型传统VLM相当。

6. 总结

本篇重点介绍了以 JEPA 系列 为代表的联合嵌入预测路线。这一流派强调:世界模型不必生成可见像素,而应在潜在空间中学习可预测、可泛化的高层结构,从而更高效地支撑理解、推理与规划。

但世界模型的探索远不止于此。

在下篇中,将进一步介绍三条具有代表性的技术路线:

生成式视频世界模型(Sora / Genie)、强化学习世界模型(Dreamer),以及强调三维一致性的空间智能世界模型(World Labs),探讨它们如何从“预测世界”走向“生成世界”和“在世界中行动”~

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录