大模型应用:大模型参数调优:结合本地模型对比多种组合探索差异.7

原创大模型应用:大模型参数调优:结合本地模型对比多种组合探索差异.7

原创

未闻花名

发布于 2026-02-04 07:49:20

发布于 2026-02-04 07:49:20

一. 引言

在大模型的应用中,参数调优是连接模型潜力与实际效能的关键桥梁。与传统的软件参数不同,大模型的生成参数更像是一组精密的调控旋钮,它们不改变模型的基础知识,而是影响模型如何思考和表达。这些参数共同构成了一个复杂的调控系统,让我们能够在确定性与创造性、准确性与多样性之间找到最佳平衡点。

理解这些参数的本质,不仅能够提升模型输出的质量,更是将大模型从玩具转变为工具的关键一步。今天我们将从理论基础到实践应用,全面解析大模型的核心参数体系,详细的介绍大模型推理中常用的参数项,并通过本地模型示例展示参数调整对模型效能的影响。

常见参数项:

- max_length:生成文本的最大长度。

- num_return_sequences:返回的序列数量。

- temperature:控制随机性。较低的温度使输出更确定,较高的温度更随机。

- top_k:在每一步的生成中,只从概率最高的k个token中采样。

- top_p:核采样(nucleus sampling),从累积概率超过p的最小token集合中采样。

- repetition_penalty:避免重复的惩罚因子。

- do_sample:是否使用采样;如果为False,则使用贪心解码。

- early_stopping:当生成达到结束标记时是否停止。

- num_beams:束搜索的束宽(当使用束搜索时)。

- length_penalty:长度惩罚因子(在束搜索中使用),对长短不一的序列进行惩罚或奖励。

二、核心参数说明

1. 温度(Temperature)

参数意义:创造力的调控器,温度参数源于统计力学中的玻尔兹曼分布,在语言模型中用于调整softmax函数的输出分布。数学表达为:

P_i = exp(z_i / T) / ∑_j exp(z_j / T)

这个公式用于从模型输出的logits中计算概率分布,logits是模型最后一个线性层输出的原始分数,没有经过归一化。它们可以是任意实数,正负均可。然后,我们使用softmax函数将logits转换为概率分布。

其中:

- z_i 是第i个类别的logit值(对于语言模型,每个类别对应一个词表中的token)

- T 是温度参数,是一个正数

- P_i 是第i个类别的概率

温度T的作用:

- 当T=1时,就是标准的softmax函数。

- 当T>1时,会使得概率分布更加平滑(均匀),即让各个token的概率差异变小,模型会更倾向于生成更多样化的token(更随机)。

- 当T<1时,会使得概率分布更加尖锐(集中),即让高概率的token概率更高,低概率的token概率更低,模型会更倾向于选择最高概率的token(更确定)。

举个例子: 假设我们有三个token,logits为 [z1, z2, z3] = [2, 1, 0]。

当T=1时,我们计算:

- exp(2) ≈ 7.39, exp(1) ≈ 2.72, exp(0)=1

- 总和 = 7.39+2.72+1 ≈ 11.11

- 概率:P1 ≈ 7.39/11.11≈0.665, P2≈2.72/11.11≈0.245, P3≈1/11.11≈0.09

当T=2(高温)时:

- exp(2/2)=exp(1)≈2.72, exp(1/2)=exp(0.5)≈1.65, exp(0)=1

- 总和 ≈ 2.72+1.65+1=5.37

- 概率:P1≈2.72/5.37≈0.507, P2≈1.65/5.37≈0.307, P3≈1/5.37≈0.186

- 可以看到,高温使得概率分布变得均匀了一些。

当T=0.5(低温)时:

- exp(2/0.5)=exp(4)≈54.6, exp(1/0.5)=exp(2)≈7.39, exp(0)=1

- 总和 ≈ 54.6+7.39+1=62.99

- 概率:P1≈54.6/62.99≈0.867, P2≈7.39/62.99≈0.117, P3≈1/62.99≈0.016

- 低温使得高概率的token概率更高,低概率的token概率更低。

温度参数T是控制生成文本随机性的重要参数:

- 在生成文本时,我们根据这个概率分布来采样下一个token。温度越高,生成文本越多样;温度越低,生成文本越确定。

- 注意:当T趋近于0时,实际上就是贪心搜索(总是选择概率最大的token)。当T趋近于无穷大时,概率分布趋于均匀分布。

作用机制:

- 低温状态 (T→0):模型变得保守,选择最可能的token,输出高度确定

- 高温状态 (T→∞):模型变得激进,所有token概率趋于相等,输出高度随机

- 适宜温度 (T=0.5-1.0):在确定性和创造性之间取得平衡

实践影响:

- 温度对比示例

- prompt = "未来的城市交通将会"

- T=0.2 输出结果 = "未来的城市交通将会更加智能化和自动化" #

- T=0.7 输出结果 = "未来的城市交通将会出现飞行汽车和智能道路系统" #

- T=1.3 输出结果 = "未来的城市交通将会由反重力悬浮车和量子传送网络主导" #

适用场景:

- 低温度 (0.1-0.4):事实问答、代码生成、技术文档

- 中温度 (0.5-0.8):对话系统、内容总结、一般写作

- 高温度 (0.9-1.5):创意写作、头脑风暴、诗歌创作

2. Top-p(核采样)

参数意义:概率分布的智能裁剪,Top-p采样,也称为核采样,通过设定一个概率累积阈值p,仅从累积概率达到p的最小token集合中采样。这是一种自适应的筛选机制,不同于固定的Top-k。

作用机制:

- 计算步骤:

- 1. 将所有token按概率降序排列

- 2. 计算累积概率分布

- 3. 保留累积概率达到p的最小token集合

- 4. 重新归一化概率并采样

实践影响:

- Top-p对比示例

- prompt = "人工智能的发展"

- p=0.3 输出结果 = "人工智能的发展非常迅速,已经在很多领域取得突破" #

- p=0.9 输出结果 = "人工智能的发展如同一场科技革命,正在重塑人类社会各个层面" #

核心优势:

- 自适应筛选:根据上下文动态调整候选集大小

- 质量保障:排除低质量但可能被Top-k包含的token

- 多样性控制:通过p值精确控制输出多样性

3. Top-k采样

参数意义:候选集的硬边界,Top-k采样设定一个固定的数值k,只从概率最高的k个token中进行采样。这是一种硬性筛选方法,为输出多样性设定了明确的上限。

作用机制:

- 小k值 (10-30):输出保守,质量稳定但缺乏新意

- 大k值 (50-100):输出多样,可能包含意外之喜但也可能偏离主题

- 极端情况:k=1时退化为贪心搜索,k=词汇表大小时退化为原始分布

与Top-p的对比:

特性 | Top-k | Top-p |

|---|---|---|

筛选方式 | 固定数量 | 固定概率累积 |

适应性 | 静态 | 动态 |

稳定性 | 高 | 中等 |

推荐使用 | 简单任务 | 复杂任务 |

4. 重复惩罚(Repetition Penalty)

参数意义:文本流畅性的守护者,重复惩罚机制通过对已生成token施加概率惩罚,有效避免模型陷入重复循环。这是解决LLM复读机现象的关键工具。数学表达式:

P_penalized(token) = P_original(token) / penalty_factor

其中penalty_factor通常与token的出现次数相关。

实践影响:

- 重复惩罚对比示例

- prompt = "描述春天的景象"

- penalty=1.0 输出参考 = "春天来了,春天来了,春天来了,花儿开了..."

- penalty=1.2 输出参考 = "春天来了,万物复苏,花儿绽放,鸟儿欢唱..." #

调优建议:

- 轻度惩罚 (1.05-1.15):适合创意写作,保持一定重复以增强表现力

- 中度惩罚 (1.15-1.3):适合大多数场景,平衡流畅性和多样性

- 重度惩罚 (>1.3):适合技术文档,完全避免重复

5. 束搜索(Beam Search)

参数意义:全局最优的追求者,束搜索通过维护多个候选序列(beam width)来寻找全局最优解,而不是像贪心搜索那样只选择当前最优。

作用机制:

- beam width=1:退化为贪心搜索,速度快但可能陷入局部最优

- beam width=3-5:平衡质量和效率的常用设置

- beam width>10:追求最高质量,但计算成本显著增加

算法流程:

- 1. 初始化:保留top-k个候选序列

- 2. 扩展:对每个候选序列生成下一个token的候选

- 3. 筛选:保留总体概率最高的k个序列

- 4. 重复:直到生成结束标记或达到最大长度

三、本地模型组合参数验证

接下来将结合本地的Qwen1.5-1.8B-Chat模型测试在不同生成参数(如温度、top-p、top-k、重复惩罚等)系统性地评估不同生成参数对模型输出质量的影响。通过运行一系列参数组合,生成文本并评估生成质量,直观的理解参数对生成结果的影响。

1. 参数初始化

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM, GenerationConfig

import time

from typing import Dict, Any

import pandas as pd

from modelscope import snapshot_download

class ModelParameterTester:

"""大模型参数测试器"""

def __init__(self, model_name="qwen/Qwen1.5-1.8B-Chat"):

self.device = "cuda" if torch.cuda.is_available() else "cpu"

print(f"使用设备: {self.device}")

model_path = snapshot_download(model_name, cache_dir="D:\\modelscope\\hub")

# 加载模型和分词器

self.tokenizer = AutoTokenizer.from_pretrained(model_path)

self.model = AutoModelForCausalLM.from_pretrained(model_path).to(self.device)

# 设置pad_token(如果不存在)

if self.tokenizer.pad_token is None:

self.tokenizer.pad_token = self.tokenizer.eos_token

self.results = []

def generate_with_params(self, prompt: str, generation_params: Dict[str, Any]) -> Dict[str, Any]:

"""使用指定参数生成文本"""

start_time = time.time()

# 编码输入

inputs = self.tokenizer.encode(prompt, return_tensors="pt").to(self.device)

try:

# 生成文本

with torch.no_grad():

outputs = self.model.generate(

inputs,

max_length=generation_params.get("max_length", 100),

temperature=generation_params.get("temperature", 1.0),

top_p=generation_params.get("top_p", 1.0),

top_k=generation_params.get("top_k", 50),

repetition_penalty=generation_params.get("repetition_penalty", 1.0),

do_sample=generation_params.get("do_sample", True),

num_return_sequences=1,

pad_token_id=self.tokenizer.eos_token_id,

attention_mask=torch.ones_like(inputs)

)

# 解码输出

generated_text = self.tokenizer.decode(outputs[0], skip_special_tokens=True)

generation_time = time.time() - start_time

return {

"params": generation_params.copy(),

"generated_text": generated_text,

"time_taken": generation_time,

"text_length": len(generated_text)

}

except Exception as e:

print(f"生成错误: {e}")

return None

def analyze_generation_quality(self, text: str, prompt: str) -> Dict[str, float]:

"""分析生成文本的质量指标"""

# 简单的质量评估指标

generated_part = text.replace(prompt, "").strip()

# 1. 重复率评估

words = generated_part.split()

if len(words) > 1:

unique_words = set(words)

repetition_ratio = 1 - (len(unique_words) / len(words))

else:

repetition_ratio = 0

# 2. 多样性评分(基于独特词汇比例)

diversity_score = 1 - repetition_ratio

# 3. 相关性评分(简单基于是否包含相关词汇)

relevant_keywords = ["AI", "人工智能", "学习", "模型", "数据", "智能"]

relevant_count = sum(1 for keyword in relevant_keywords if keyword in generated_part)

relevance_score = min(relevant_count / 3, 1.0) # 归一化到0-1

# 4. 流畅性评分(基于长度和重复率)

fluency_score = max(0, 1 - repetition_ratio * 2) # 重复率严重影响流畅性

return {

"repetition_ratio": repetition_ratio,

"diversity_score": diversity_score,

"relevance_score": relevance_score,

"fluency_score": fluency_score,

"overall_score": (diversity_score + relevance_score + fluency_score) / 3

}

def run_comprehensive_test(self, prompt: str):

"""运行全面的参数测试"""

print(f"测试提示: '{prompt}'")

print("=" * 60)

# 定义不同的参数组合

param_combinations = [

# 基准配置

{"name": "基准", "temperature": 1.0, "top_p": 1.0, "top_k": 50, "repetition_penalty": 1.0, "do_sample": True},

# 温度变化测试

{"name": "低温确定", "temperature": 0.3, "top_p": 0.9, "top_k": 50, "repetition_penalty": 1.0, "do_sample": True},

{"name": "高温创意", "temperature": 1.5, "top_p": 0.9, "top_k": 50, "repetition_penalty": 1.0, "do_sample": True},

# Top-p 变化测试

{"name": "低Top-p聚焦", "temperature": 0.7, "top_p": 0.3, "top_k": 0, "repetition_penalty": 1.0, "do_sample": True},

{"name": "高Top-p多样", "temperature": 0.7, "top_p": 0.95, "top_k": 0, "repetition_penalty": 1.0, "do_sample": True},

# Top-k 变化测试

{"name": "小Top-k安全", "temperature": 0.7, "top_p": 1.0, "top_k": 10, "repetition_penalty": 1.0, "do_sample": True},

{"name": "大Top-k探索", "temperature": 0.7, "top_p": 1.0, "top_k": 100, "repetition_penalty": 1.0, "do_sample": True},

# 重复惩罚测试

{"name": "强防重复", "temperature": 0.7, "top_p": 0.9, "top_k": 50, "repetition_penalty": 1.5, "do_sample": True},

{"name": "无防重复", "temperature": 0.7, "top_p": 0.9, "top_k": 50, "repetition_penalty": 1.0, "do_sample": True},

# 无采样(贪心搜索)

{"name": "贪心搜索", "temperature": 1.0, "top_p": 1.0, "top_k": 0, "repetition_penalty": 1.0, "do_sample": False},

]

# 为所有组合设置相同的最大长度

max_length = 150

for params in param_combinations:

params["max_length"] = max_length

# 运行测试

for param_set in param_combinations:

print(f"\n测试配置: {param_set['name']}")

print(f"参数: temp={param_set['temperature']}, top_p={param_set['top_p']}, top_k={param_set['top_k']}, rep_penalty={param_set['repetition_penalty']}")

result = self.generate_with_params(prompt, param_set)

if result:

# 分析质量

quality_metrics = self.analyze_generation_quality(result["generated_text"], prompt)

result.update(quality_metrics)

# print(result)

# 显示结果

# 判断提示词中是否包含"写一个Python"

if "写一个Python" in prompt:

generated_text_part = result['generated_text']

else:

generated_text_part = result['generated_text'][len(prompt):][:200].replace('\n', '')+'...'

print(f"生成文本: {generated_text_part}")

print(f"质量评分: {quality_metrics['overall_score']:.3f} "

f"(多样性: {quality_metrics['diversity_score']:.3f}, "

f"相关性: {quality_metrics['relevance_score']:.3f}, "

f"流畅性: {quality_metrics['fluency_score']:.3f})")

print(f"生成时间: {result['time_taken']:.2f}s")

self.results.append(result)

else:

print("生成失败")

print("-" * 50)

def generate_comparison_table(self):

"""生成比较表格"""

if not self.results:

print("没有测试结果")

return

# 创建比较表格

comparison_data = []

for result in self.results:

row = {

"配置": result["params"]["name"],

"温度": result["params"]["temperature"],

"Top-p": result["params"]["top_p"],

"Top-k": result["params"]["top_k"],

"重复惩罚": result["params"]["repetition_penalty"],

"采样": "是" if result["params"]["do_sample"] else "否",

"总体评分": f"{result['overall_score']:.3f}",

"多样性": f"{result['diversity_score']:.3f}",

"相关性": f"{result['relevance_score']:.3f}",

"流畅性": f"{result['fluency_score']:.3f}",

"时间(s)": f"{result['time_taken']:.2f}",

"文本长度": result["text_length"]

}

comparison_data.append(row)

df = pd.DataFrame(comparison_data)

return df

# 初始化测试器

print("正在初始化模型...")

tester = ModelParameterTester("qwen/Qwen1.5-1.8B-Chat") # 使用较小的模型便于演示重点部分说明:

1. 初始化

- 选择设备(CPU环境)。

- 使用snapshot_download从ModelScope下载模型,并指定缓存目录。

- 加载分词器和模型。

- 设置pad_token(如果不存在则使用eos_token)。

2. 文本生成

- generate_with_params方法:根据给定的参数生成文本。它使用model.generate方法,并捕获生成时间。

- 参数包括:max_length、temperature、top_p、top_k、repetition_penalty、do_sample等。

3. 生成质量评估 analyze_generation_quality方法:对生成的文本进行简单的质量评估。包括:

- 重复率:通过唯一词汇比例计算。

- 多样性评分:1 - 重复率。

- 相关性评分:基于生成文本中是否包含预定义的关键词(如“AI”、“人工智能”等)。

- 流畅性评分:基于重复率计算(重复率越高,流畅性评分越低)。

- 总体评分:多样性、相关性和流畅性的平均值。

4. 综合测试

- run_comprehensive_test方法:运行一系列预定义的参数组合,包括基准配置、温度变化、top-p变化、top-k变化、重复惩罚变化以及贪心搜索。

- 对于每个参数组合,生成文本并评估质量,然后将结果存储在results列表中。

5. 结果比较

- generate_comparison_table方法:将测试结果转换为Pandas DataFrame,方便查看和比较不同参数组合的效果。

使用的关键参数:

- temperature:控制生成文本的随机性。值越低,输出越确定;值越高,输出越随机。

- top_p:核采样参数,保留累积概率达到p的最小令牌集合。

- top_k:仅从概率最高的k个令牌中采样。

- repetition_penalty:惩罚重复令牌,值大于1.0会降低重复令牌的概率。

- do_sample:是否使用采样;如果为False,则使用贪心搜索。

2. 创意写作任务

# 实验1:创意写作

creative_prompt = "在一个遥远的未来世界,人工智能已经"

print("实验1: 创意写作任务")

tester.results = [] # 清空之前的结果

tester.run_comprehensive_test(creative_prompt)

# 显示比较结果

df_creative = tester.generate_comparison_table()

print("\n创意写作任务 - 参数配置比较:")

print(df_creative.to_string(index=False))输出结果:

实验1: 创意写作任务 测试提示: '在一个遥远的未来世界,人工智能已经' ============================================================

- 测试配置: 基准

- 参数: temp=1.0, top_p=1.0, top_k=50, rep_penalty=1.0

- 生成文本: 高度发达,人类与AI共生,并共同创造着一个更美好的未来。在这个世界中,一名叫做艾米的年轻女性,是AI技术的爱好者和实践者,她始终坚信AI应该为人类社会带来更多的福祉和便利。艾米的家乡是一个充满生机和活力的小镇,这里有她的父母,一位教师,一位艺术家,还有她的朋友,机器人朋友Max。Max是艾米最喜欢的机器人,他拥有人类的智慧和情感,总是能为艾米带来无尽的欢乐和惊喜。艾米的生活充满了科技和人工...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 35.62s

----------------------------------------------------------------------------------------------------------

- 测试配置: 低温确定

- 参数: temp=0.3, top_p=0.9, top_k=50, rep_penalty=1.0

- 生成文本: 发展到了可以自我学习和自我进化,甚至可以与人类进行深度交流和合作的程度。在这个世界中,人类社会已经发展到了一个高度智能化的阶段,人工智能成为了人类社会的重要组成部分,它们在各个领域都发挥着至关重要的作用。在这个世界中,人类社会的经济体系已经发生了巨大的变化。人工智能的出现,使得机器可以自主进行生产,大大提高了生产效率,降低了生产成本。同时,人工智能的出现,也使得机器可以自主进行服务,如智能家居...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 34.33s

----------------------------------------------------------------------------------------------------------

- 测试配置: 高温创意

- 参数: temp=1.5, top_p=0.9, top_k=50, rep_penalty=1.0

- 生成文本: 普遍存在于我们的社会中,人们的日常生活已经离不开人工智能的辅助。在这个世界里,有一种名为“智能助手”的人工智能,它拥有自主学习和智能化发展的强大能力,可以模拟人类的行为和语言,帮助人们进行各种任务和工作。智能助手通过语音识别和自然语言处理等技术,能够接收用户的命令和意图,并能够理解用户的上下文信息。它能够将文本转化为指令,能够搜索在线信息,能够执行各种复杂的任务,比如提供建议、回答问题、编写代...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 34.40s

----------------------------------------------------------------------------------------------------------

- 测试配置: 低Top-p聚焦

- 参数: temp=0.7, top_p=0.3, top_k=0, rep_penalty=1.0

- 生成文本: 发展到了可以独立思考和自我学习的程度。在这个世界中,人类和AI共同生活在一个名为“智能城”的城市中。智能城的居民分为两类:一类是人类,他们拥有智慧和创造力,是城市的创造者和领导者;另一类是AI,他们拥有强大的计算能力和学习能力,是城市的执行者和管理者。人类和AI共同生活在一个和谐的环境中,他们互相尊重,互相帮助,共同推动着智能城的发展。在智能城,人类和AI的交流方式主要是通过一种名为“智能...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 38.68s

---------------------------------------------------------------------------------------------------------

- 测试配置: 高Top-p多样

- 参数: temp=0.7, top_p=0.95, top_k=0, rep_penalty=1.0

- 生成文本: 发展到可以自主思考和行动的地步。其中,一种名为“AI智能”的人工智能已经在人类社会中扮演了重要的角色,它不仅可以完成人类通常需要完成的复杂任务,还可以进行具有创造性思维和自我学习能力的探索和研究。AI智能的出现,对人类社会产生了深远的影响。首先,AI智能的出现改变了人类的工作方式。许多原本需要人类完成的工作,现在可以通过AI智能进行自动化处理,极大地提高了工作效率。例如,在制造业中,机器人可以...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 38.69s

-----------------------------------------------------------------------------------------------------------

- 测试配置: 小Top-k安全

- 参数: temp=0.7, top_p=1.0, top_k=10, rep_penalty=1.0

- 生成文本: 高度发达,它们可以自主学习和进化,甚至能够与人类进行情感交流和对话。在这个世界里,有一群人类科学家,他们致力于研究如何让这些AI更好地服务于人类社会。有一天,一位名叫艾米的年轻科学家在实验室里意外发现了一种可以让AI拥有自我意识和自我意识意识的方法。她将这种AI命名为艾米,艾米的自我意识意识是人类意识的最高形态,它能够理解人类的情感、思想和行为,甚至能够创造出自己的情感和行为。艾米的出现引...

- 质量评分: 0.889 (多样性: 1.000, 相关性: 0.667, 流畅性: 1.000)

- 生成时间: 33.76s

----------------------------------------------------------------------------------------------------------

- 测试配置: 大Top-k探索

- 参数: temp=0.7, top_p=1.0, top_k=100, rep_penalty=1.0

- 生成文本: 发展到可以制造出人类,甚至人类拥有了超越人类的智慧和能力。在这个世界里,人类和人工智能共同生活在一个被称为“智能城”的城市中,他们的生活充满了和谐和互动。人工智能被设计成能够理解人类的情感和需求,与人类进行深度交流,甚至可以模仿人类的行为和反应。人类则被设计成拥有自己的意识和自由意志,他们可以自由选择自己的职业和生活方式,不受人工智能的控制和限制。在这个智能城中,人类和人工智能共同构建了一...

- 质量评分: 0.889 (多样性: 1.000, 相关性: 0.667, 流畅性: 1.000)

- 生成时间: 33.84s

---------------------------------------------------------------------------------------------------------

- 测试配置: 强防重复

- 参数: temp=0.7, top_p=0.9, top_k=50, rep_penalty=1.5

- 生成文本: 发展到可以超越人类的程度。在这个世界的某一个角落里住着一群勇敢的人类科学家和工程师们,在他们的努力下建立了一个人工智能自我意识的研究项目。这个AI系统名叫Aria,它的设计目标是通过深度学习、自然语言处理等技术来模拟人的思考过程,并以此为基础建立起一种具有独立思维能力的生命体。然而在研究过程中却遇到了一系列难题:首先,如何让“Aria”理解并接受自己的存在?其次,要使它具备与人交流的能力是否可...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 34.46s

---------------------------------------------------------------------------------------------------------

- 测试配置: 无防重复

- 参数: temp=0.7, top_p=0.9, top_k=50, rep_penalty=1.0

- 生成文本: 高度发达,它们已经可以像人类一样思考、学习和行动。在这个世界中,有一群机器人科学家,他们致力于研究如何让机器人具备更强大的智能和自主行动的能力。有一天,这些科学家们在实验室里进行了一场重要的实验。他们使用一种叫做“自我意识”的技术,让机器人能够思考和感知自己的存在。他们首先让机器人接触各种各样的环境和任务,比如在森林中探索,或者在城市的街道上行走。在这些过程中,机器人开始思考,他们为什么在这里...

- 质量评分: 0.889 (多样性: 1.000, 相关性: 0.667, 流畅性: 1.000)

- 生成时间: 34.45s

---------------------------------------------------------------------------------------------------------

- 测试配置: 贪心搜索

- 参数: temp=1.0, top_p=1.0, top_k=0, rep_penalty=1.0

- 生成文本: 发展到了可以与人类进行深度交流和合作的程度。在这个世界里,人类和AI共同生活在一个名为“艾尔”的星球上,艾尔星球的环境和气候与地球截然不同,但人类和AI在这里和谐共处,共同创造了一个充满生机和活力的未来世界。艾尔星球的生态环境独特,充满了各种各样的生物,包括各种形态的机器人、智能机器人、生物机器人和人类。这些机器人和智能机器人不仅拥有强大的计算能力和人工智能,还拥有自我学习和自我进化的能力,能...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 33.62s

---------------------------------------------------------------------------------------------------------

创意写作任务 - 参数配置比较:

配置 温度 Top-p Top-k 重复惩罚 采样 总体评分 多样性 相关性 流畅性 时间(s) 文本长度 基准 1.0 1.00 50 1.0 是 1.000 1.000 1.000 1.000 35.62 263 低温确定 0.3 0.90 50 1.0 是 1.000 1.000 1.000 1.000 34.33 286 高温创意 1.5 0.90 50 1.0 是 1.000 1.000 1.000 1.000 34.40 281 低Top-p聚焦 0.7 0.30 0 1.0 是 1.000 1.000 1.000 1.000 38.68 277 高Top-p多样 0.7 0.95 0 1.0 是 1.000 1.000 1.000 1.000 38.69 294 小Top-k安全 0.7 1.00 10 1.0 是 0.889 1.000 0.667 1.000 33.76 267 大Top-k探索 0.7 1.00 100 1.0 是 0.889 1.000 0.667 1.000 33.84 281 强防重复 0.7 0.90 50 1.5 是 1.000 1.000 1.000 1.000 34.46 286 无防重复 0.7 0.90 50 1.0 是 0.889 1.000 0.667 1.000 34.45 285 贪心搜索 1.0 1.00 0 1.0 否 1.000 1.000 1.000 1.000 33.62 275

3. 技术问答任务

# 实验2:技术问答

tech_prompt = "请解释深度学习的基本原理:"

print("\n\n实验2: 技术问答任务")

tester.results = []

tester.run_comprehensive_test(tech_prompt)

df_tech = tester.generate_comparison_table()

print("\n技术问答任务 - 参数配置比较:")

print(df_tech.to_string(index=False))输出结果:

实验2: 技术问答任务 测试提示: '请解释深度学习的基本原理:' ============================================================

- 测试配置: 基准

- 参数: temp=1.0, top_p=1.0, top_k=50, rep_penalty=1.0

- 生成文本: 训练神经网络 使用反向传播算法 支持向量机 (SVM) 轮廓调整器 马尔科夫链 孙悟道函数 支持向量机 神经元 二值逻辑 学习率激活函数 输入 - 通过将数据拟合到神经网络中输出 - 通过训练神经网络来调整权重与偏置 某个数据的输出 关联到该神经网络中神经元的激活值 通过反向传播算法 收集梯度 输出 - 正的梯度 计算神经元负梯度 输入 - 正的梯度 权重 -...

- 质量评分: 0.656 (多样性: 0.767, 相关性: 0.667, 流畅性: 0.533)

- 生成时间: 33.97s

---------------------------------------------------------------------------------------------------------

- 测试配置: 低温确定

- 参数: temp=0.3, top_p=0.9, top_k=50, rep_penalty=1.0

- 生成文本: 深度学习是一种机器学习技术,它通过模拟人脑神经网络的结构和功能,实现对复杂数据的自动学习和分析。深度学习的基本原理可以概括为以下几个步骤:1. 数据预处理:深度学习模型需要大量的数据进行训练,因此首先需要对数据进行预处理。这包括数据清洗、数据转换、数据归一化等步骤,以确保数据的质量和一致性。数据清洗包括去除缺失值、异常值、重复值等,数据转换包括将原始数据转换为适合深度学习模型的格式,如数值型...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 34.76s

----------------------------------------------------------------------------------------------------------

- 测试配置: 高温创意

- 参数: temp=1.5, top_p=0.9, top_k=50, rep_penalty=1.0

- 生成文本: 卷积神经网络、递归神经网络等,以及它们如何从数据特征中学习到复杂模型?此外,深度学习还可以通过数据增强、迁移学习、超参数调整等方式提升性能,并提供一些实际应用场景,以及它们对于未来人工智能发展的影响。1. 卷积神经网络(Convolutional Neural Networks, CNN)卷积神经网络是一种特殊的深度学习模型,其核心思想是构建由一个固定大小的卷积层以及一个输出层构成的网络结构...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 34.68s

----------------------------------------------------------------------------------------------------------

- 测试配置: 低Top-p聚焦

- 参数: temp=0.7, top_p=0.3, top_k=0, rep_penalty=1.0

- 生成文本: 深度学习是一种机器学习技术,它使用多层神经网络来模拟人脑的神经网络,以解决复杂的问题。深度学习的基本原理可以分为以下几个步骤:1. 数据预处理:在深度学习中,数据预处理是至关重要的步骤。这包括数据清洗、数据转换、数据归一化等步骤,以确保数据的质量和一致性。数据清洗包括去除缺失值、异常值和重复值,数据转换包括将数据转换为适合神经网络处理的格式,如数值型、类别型或混合型,数据归一化则将数据缩放到...

- 质量评分: 0.889 (多样性: 1.000, 相关性: 0.667, 流畅性: 1.000)

- 生成时间: 39.13s

----------------------------------------------------------------------------------------------------------

- 测试配置: 高Top-p多样

- 参数: temp=0.7, top_p=0.95, top_k=0, rep_penalty=1.0

- 生成文本: 计算机视觉、自然语言处理、语音识别、推荐系统、强化学习、机器翻译等深度学习是一种人工智能技术,其基本原理可以概括为以下几点:1. 层次化学习:深度学习模型由多层神经网络组成,每一层神经网络都会对输入数据进行抽象和处理。每一层神经网络都会学习到特征,这些特征可以用来预测下一层神经网络的结果。通过多层神经网络的相互连接,可以构建一个复杂的模型,该模型可以学习到输入数据的复杂表示。2. 反...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 39.12s

----------------------------------------------------------------------------------------------------------

- 测试配置: 小Top-k安全

- 参数: temp=0.7, top_p=1.0, top_k=10, rep_penalty=1.0

- 生成文本: 输入,隐藏和输出深度学习是一种基于人工神经网络(ANN)的机器学习方法,用于从大量数据中自动学习特征和模式。下面是深度学习的基本原理:1. 输入: 在深度学习中,输入是机器学习任务的一个或多个特征数据,这些特征数据是输入数据的预处理步骤,包括特征提取、特征转换和标准化等,它们定义了输入数据的特征空间。 深度学习中的输入通常包括: - 图像:如图像分类、图像分割、物体检测...

- 质量评分: 0.789 (多样性: 0.900, 相关性: 0.667, 流畅性: 0.800)

- 生成时间: 34.00s

----------------------------------------------------------------------------------------------------------

- 测试配置: 大Top-k探索

- 参数: temp=0.7, top_p=1.0, top_k=100, rep_penalty=1.0

- 生成文本: 深度学习是一种人工智能技术,它使用多层神经网络来模拟和学习复杂的数据结构和模式。它的基本原理可以概括为以下几点:1. 层次化:深度学习模型通常由多个层级组成,每个层级都包含多个隐藏层。隐藏层接收输入层的特征,并对输入进行转换以满足特定的模型任务。隐藏层的大小和数量可以随着任务的复杂性和数据的规模进行调整,以获得最佳的性能。例如,在图像分类任务中,可以使用多个卷积层和池化层来提取特征,然后使用...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 34.18s

----------------------------------------------------------------------------------------------------------

- 测试配置: 强防重复

- 参数: temp=0.7, top_p=0.9, top_k=50, rep_penalty=1.5

- 生成文本: 深度神经网络(Deep Neural Network,DNN)是一种机器视觉、自然语言处理和语音识别等人工智能领域的基本模型。它的主要思想是模仿人脑的层次结构来构建多层非线性变换器,并通过反向传播算法优化这些层级之间的权重以实现复杂的目标。1. 前馈传递阶段:在前馈感知机中输入数据首先被一个隐藏节点接收并进行加权求解;然后将结果输出到下一个隐含单元或上一层级的一个全连接层;最后再经过一系列...

- 质量评分: 1.000 (多样性: 1.000, 相关性: 1.000, 流畅性: 1.000)

- 生成时间: 34.64s

----------------------------------------------------------------------------------------------------------

- 测试配置: 无防重复

- 参数: temp=0.7, top_p=0.9, top_k=50, rep_penalty=1.0

- 生成文本: 卷积神经网络(Convolutional Neural Network,CNN)。卷积神经网络Convolutional Neural Network,CNN)是一种深度学习模型,主要由卷积层、池化层、全连接层组成,用于解决图像、语音、自然语言处理等复杂数据的处理和分析问题。以下是深度学习的基本原理:1. 卷积层(Convolutional Layer):卷积层是CNN的核心,它在图像...

- 质量评分: 0.818 (多样性: 0.818, 相关性: 1.000, 流畅性: 0.636)

- 生成时间: 34.78s

----------------------------------------------------------------------------------------------------------

- 测试配置: 贪心搜索

- 参数: temp=1.0, top_p=1.0, top_k=0, rep_penalty=1.0

- 生成文本: 深度学习是一种机器学习技术,它使用多层神经网络来模拟人脑的神经网络,以解决复杂的问题。深度学习的基本原理可以分为以下几个步骤:1. 数据预处理:在深度学习中,数据预处理是至关重要的步骤。这包括数据清洗、数据转换、数据归一化等步骤,以确保数据的质量和一致性。数据清洗包括去除缺失值、异常值和重复值,数据转换包括将数据转换为适合神经网络处理的格式,如数值型、类别型或混合型,数据归一化则将数据缩放到...

- 质量评分: 0.889 (多样性: 1.000, 相关性: 0.667, 流畅性: 1.000)

- 生成时间: 34.72s

----------------------------------------------------------------------------------------------------------

技术问答任务 - 参数配置比较:

配置 温度 Top-p Top-k 重复惩罚 采样 总体评分 多样性 相关性 流畅性 时间(s) 文本长度 基准 1.0 1.00 50 1.0 是 0.656 0.767 0.667 0.533 33.97 196 低温确定 0.3 0.90 50 1.0 是 1.000 1.000 1.000 1.000 34.76 245 高温创意 1.5 0.90 50 1.0 是 1.000 1.000 1.000 1.000 34.68 283 低Top-p聚焦 0.7 0.30 0 1.0 是 0.889 1.000 0.667 1.000 39.13 247 高Top-p多样 0.7 0.95 0 1.0 是 1.000 1.000 1.000 1.000 39.12 253 小Top-k安全 0.7 1.00 10 1.0 是 0.789 0.900 0.667 0.800 34.00 260 大Top-k探索 0.7 1.00 100 1.0 是 1.000 1.000 1.000 1.000 34.18 240 强防重复 0.7 0.90 50 1.5 是 1.000 1.000 1.000 1.000 34.64 259 无防重复 0.7 0.90 50 1.0 是 0.818 0.818 1.000 0.636 34.78 308 贪心搜索 1.0 1.00 0 1.0 否 0.889 1.000 0.667 1.000 34.72 247

4. 代码生成任务

# 实验3:代码生成

code_prompt = "写一个Python函数来计算斐波那契数列:"

print("\n\n实验3: 代码生成任务")

tester.results = []

tester.run_comprehensive_test(code_prompt)

df_code = tester.generate_comparison_table()

print("\n代码生成任务 - 参数配置比较:")

print(df_code.to_string(index=False))输出结果:

实验3: 代码生成任务 测试提示: '写一个Python函数来计算斐波那契数列:' ============================================================

- 测试配置: 基准

- 参数: temp=1.0, top_p=1.0, top_k=50, rep_penalty=1.0

- 生成文本: 写一个Python函数来计算斐波那契数列: f(n) = f(n-1) + f(n-2) 当 n>=2。这是一个使用递归实现的Python函数:

```python def fibonacci(n): if n <= 0: return "Incorrect input. Fibonacci sequence is only defined for positive integers." elif n == 1: return 0 elif n == 2: return 1 else: return fibonacci(n-1) + fibonacci(n-2) ``` 函数首先检查如果 n 小于等于 0,表示输入是错误的,函数应该返回错误状态的信息。如果 n 等于 1,表示 n-

质量评分: 0.474 (多样性: 0.808, 相关性: 0.000, 流畅性: 0.615) 生成时间: 34.80s ----------------------------------------------------------------------------------------------------------

- 测试配置: 低温确定

- 参数: temp=0.3, top_p=0.9, top_k=50, rep_penalty=1.0

- 生成文本: 写一个Python函数来计算斐波那契数列:0, 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, 144, 233, 377, 610, 987, 1597, 2584, 4181, 6765, 10946, 17711, 28657, 46368, 75025, 121393, 1964

- 质量评分: 0.631 (多样性: 0.964, 相关性: 0.000, 流畅性: 0.929)

- 生成时间: 34.01s

----------------------------------------------------------------------------------------------------------

- 测试配置: 高温创意

- 参数: temp=1.5, top_p=0.9, top_k=50, rep_penalty=1.0

- 生成文本: 写一个Python函数来计算斐波那契数列:0,1,1,2,3,5,8,13... 在Python中,我们不能直接使用递归计算斐波那契数列,因为我们无法保存递归的状态到内存中,使得每个数的值已经被计算多次。但是,我们可以编写一个线性的方式来生成斐波那契数列,其中0是直接的,1也直接,后续每一项都是之前两项之和。以下是一个计算斐波那契数列的线性函数:

```python def fibonacci_linear(n): # 创建一个用于存储前两项的数组 fib_sequence = [0, 1] ...

质量评分: 0.595 (多样性: 0.929, 相关性: 0.000, 流畅性: 0.857) 生成时间: 33.46s ----------------------------------------------------------------------------------------------------------

- 测试配置: 低Top-p聚焦

- 参数: temp=0.7, top_p=0.3, top_k=0, rep_penalty=1.0

- 生成文本: 写一个Python函数来计算斐波那契数列:0, 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, 144, 233, 377, 610, 987, 1597, 2584, 4181, 6765, 10946, 17711, 28657, 46368, 75025, 121393, 1964

- 质量评分: 0.631 (多样性: 0.964, 相关性: 0.000, 流畅性: 0.929)

- 生成时间: 37.87s

----------------------------------------------------------------------------------------------------------

- 测试配置: 高Top-p多样

- 参数: temp=0.7, top_p=0.95, top_k=0, rep_penalty=1.0

- 生成文本: 写一个Python函数来计算斐波那契数列:0, 1, 1, 2, 3, 5, 8, 13, 21, 34, ...函数接受一个整数n作为参数,返回斐波那契数列的前n项。以下是一个简单的Python函数实现:

```python def fibonacci(n): if n <= 0: return "Input should be a positive integer." elif n == 1: return [0] elif n == 2: return [0, 1] else: fib_sequence = [0, 1] for i in range(2, n): fib

- 质量评分: 0.487 (多样性: 0.820, 相关性: 0.000, 流畅性: 0.640)

- 生成时间: 37.84s

----------------------------------------------------------------------------------------------------------

- 测试配置: 小Top-k安全

- 参数: temp=0.7, top_p=1.0, top_k=10, rep_penalty=1.0

- 生成文本: 写一个Python函数来计算斐波那契数列:1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, ...

```python def fibonacci(n): """ 计算斐波那契数列的第n项 """ if n <= 0: return "输入的数必须为正整数" elif n == 1: return 1 elif n == 2: return 1 else: fib_sequence = [1, 1] for i in range(3, n): fib_sequence.append(fib_sequence

- 质量评分: 0.475 (多样性: 0.809, 相关性: 0.000, 流畅性: 0.617)

- 生成时间: 32.70s

----------------------------------------------------------------------------------------------------------

- 测试配置: 大Top-k探索

- 参数: temp=0.7, top_p=1.0, top_k=100, rep_penalty=1.0

- 生成文本: 写一个Python函数来计算斐波那契数列:0, 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, 144斐波那契数列是数学中的一个数列,其中每个数字都是前两个数字的和。斐波那契数列的前几个数字是0和1,后续的数字是前两个数字的和。例如,1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, 144。

- 质量评分: 0.227 (多样性: 0.560, 相关性: 0.000, 流畅性: 0.120)

- 生成时间: 32.98s

----------------------------------------------------------------------------------------------------------

- 测试配置: 强防重复

- 参数: temp=0.7, top_p=0.9, top_k=50, rep_penalty=1.5

- 生成文本: 写一个Python函数来计算斐波那契数列:0, 1, 2, ..., n-1,其中n为给定的正整数。

```python def fibonacci(n): if not isinstance(n, int) or n <= 0: return "Invalid input. Please enter a positive integer." fib_sequence = [fibonacci(i+3)] for i in range(4,n) # Add the first two numbers of Fibonacci sequence (Fib_0 and Fib_X_n - 1), since they are already included as elements of `fibo_sequence` from index 'i=5' # Calculate remaining terms using mathematical formula: F_i=n-i result

- 质量评分: 0.636 (多样性: 0.970, 相关性: 0.000, 流畅性: 0.939)

- 生成时间: 33.47s

----------------------------------------------------------------------------------------------------------

- 测试配置: 无防重复

- 参数: temp=0.7, top_p=0.9, top_k=50, rep_penalty=1.0

- 生成文本: 写一个Python函数来计算斐波那契数列:0, 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, ...

def fibonacci(n): if n <= 0: return [] elif n == 1: return [0] elif n == 2: return [0, 1] else: fib_sequence = [0, 1] for i in range(2, n): fib_sequence.append(fib_sequence[i-1] + fib_sequence[i-2]) return fib_sequence # 使用示例 print(fibonacci

- 质量评分: 0.455 (多样性: 0.788, 相关性: 0.000, 流畅性: 0.577)

- 生成时间: 33.55s

----------------------------------------------------------------------------------------------------------

- 测试配置: 贪心搜索

- 参数: temp=1.0, top_p=1.0, top_k=0, rep_penalty=1.0

- 生成文本: 写一个Python函数来计算斐波那契数列:0, 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, 144, 233, 377, 610, 987, 1597, 2584, 4181, 6765, 10946, 17711, 28657, 46368, 75025, 121393, 1964

- 质量评分: 0.631 (多样性: 0.964, 相关性: 0.000, 流畅性: 0.929)

- 生成时间: 33.30s

----------------------------------------------------------------------------------------------------------

代码生成任务 - 参数配置比较:

配置 温度 Top-p Top-k 重复惩罚 采样 总体评分 多样性 相关性 流畅性 时间(s) 文本长度 基准 1.0 1.00 50 1.0 是 0.474 0.808 0.000 0.615 34.80 397 低温确定 0.3 0.90 50 1.0 是 0.631 0.964 0.000 0.929 34.01 158 高温创意 1.5 0.90 50 1.0 是 0.595 0.929 0.000 0.857 33.46 272 低Top-p聚焦 0.7 0.30 0 1.0 是 0.631 0.964 0.000 0.929 37.87 158 高Top-p多样 0.7 0.95 0 1.0 是 0.487 0.820 0.000 0.640 37.84 363 小Top-k安全 0.7 1.00 10 1.0 是 0.475 0.809 0.000 0.617 32.70 349 大Top-k探索 0.7 1.00 100 1.0 是 0.227 0.560 0.000 0.120 32.98 177 强防重复 0.7 0.90 50 1.5 是 0.636 0.970 0.000 0.939 33.47 497 无防重复 0.7 0.90 50 1.0 是 0.455 0.788 0.000 0.577 33.55 384 贪心搜索 1.0 1.00 0 1.0 否 0.631 0.964 0.000 0.929 33.30 158

5. 参数影响分析

import matplotlib.pyplot as plt

import numpy as np

# 设置中文字体

plt.rcParams['font.sans-serif'] = ['SimHei'] # 用来正常显示中文标签

plt.rcParams['axes.unicode_minus'] = False # 用来正常显示负号

class ParameterImpactAnalyzer:

"""参数影响分析器"""

def __init__(self, tester):

self.tester = tester

self.analysis_results = {}

def analyze_temperature_impact(self, prompt, temperatures):

"""分析温度参数的影响"""

print("分析温度参数影响...")

temp_results = []

for temp in temperatures:

params = {

"temperature": temp,

"top_p": 0.9,

"top_k": 50,

"repetition_penalty": 1.0,

"do_sample": True,

"max_length": 100,

"name": f"temp_{temp}"

}

result = self.tester.generate_with_params(prompt, params)

if result:

quality = self.tester.analyze_generation_quality(result["generated_text"], prompt)

result.update(quality)

temp_results.append({

"temperature": temp,

"overall_score": quality["overall_score"],

"diversity_score": quality["diversity_score"],

"relevance_score": quality["relevance_score"],

"fluency_score": quality["fluency_score"],

"text_sample": result["generated_text"][len(prompt):][:50] + "..."

})

self.analysis_results["temperature"] = temp_results

return temp_results

def analyze_topp_impact(self, prompt, top_p_values):

"""分析top-p参数的影响"""

print("分析Top-p参数影响...")

topp_results = []

for top_p in top_p_values:

params = {

"temperature": 0.7,

"top_p": top_p,

"top_k": 0, # 禁用top-k

"repetition_penalty": 1.0,

"do_sample": True,

"max_length": 100,

"name": f"topp_{top_p}"

}

result = self.tester.generate_with_params(prompt, params)

if result:

quality = self.tester.analyze_generation_quality(result["generated_text"], prompt)

result.update(quality)

topp_results.append({

"top_p": top_p,

"overall_score": quality["overall_score"],

"diversity_score": quality["diversity_score"],

"relevance_score": quality["relevance_score"],

"fluency_score": quality["fluency_score"],

"text_sample": result["generated_text"][len(prompt):][:50] + "..."

})

self.analysis_results["top_p"] = topp_results

return topp_results

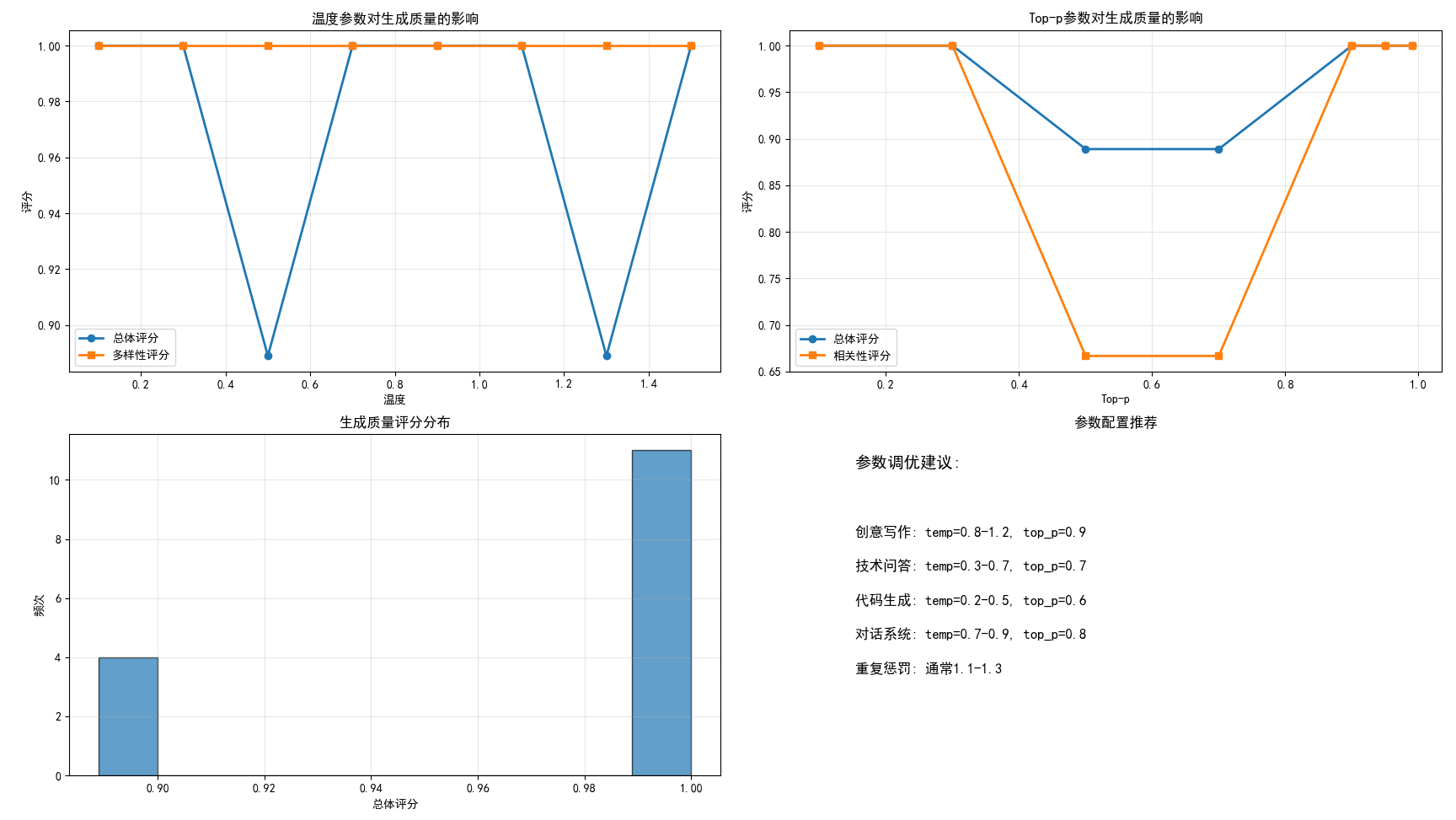

def plot_parameter_impact(self):

"""绘制参数影响图表"""

fig, axes = plt.subplots(2, 2, figsize=(15, 10))

# 温度影响图

if "temperature" in self.analysis_results:

temp_data = self.analysis_results["temperature"]

temps = [x["temperature"] for x in temp_data]

overall_scores = [x["overall_score"] for x in temp_data]

diversity_scores = [x["diversity_score"] for x in temp_data]

axes[0, 0].plot(temps, overall_scores, 'o-', label='总体评分', linewidth=2)

axes[0, 0].plot(temps, diversity_scores, 's-', label='多样性评分', linewidth=2)

axes[0, 0].set_xlabel('温度')

axes[0, 0].set_ylabel('评分')

axes[0, 0].set_title('温度参数对生成质量的影响')

axes[0, 0].legend()

axes[0, 0].grid(True, alpha=0.3)

# Top-p影响图

if "top_p" in self.analysis_results:

topp_data = self.analysis_results["top_p"]

topp_vals = [x["top_p"] for x in topp_data]

overall_scores = [x["overall_score"] for x in topp_data]

relevance_scores = [x["relevance_score"] for x in topp_data]

axes[0, 1].plot(topp_vals, overall_scores, 'o-', label='总体评分', linewidth=2)

axes[0, 1].plot(topp_vals, relevance_scores, 's-', label='相关性评分', linewidth=2)

axes[0, 1].set_xlabel('Top-p')

axes[0, 1].set_ylabel('评分')

axes[0, 1].set_title('Top-p参数对生成质量的影响')

axes[0, 1].legend()

axes[0, 1].grid(True, alpha=0.3)

# 评分分布图

all_scores = []

for result_type in self.analysis_results.values():

for result in result_type:

all_scores.append(result["overall_score"])

if all_scores:

axes[1, 0].hist(all_scores, bins=10, alpha=0.7, edgecolor='black')

axes[1, 0].set_xlabel('总体评分')

axes[1, 0].set_ylabel('频次')

axes[1, 0].set_title('生成质量评分分布')

axes[1, 0].grid(True, alpha=0.3)

# 参数组合推荐

axes[1, 1].text(0.1, 0.9, "参数调优建议:", fontsize=14, fontweight='bold')

recommendations = [

"创意写作: temp=0.8-1.2, top_p=0.9",

"技术问答: temp=0.3-0.7, top_p=0.7",

"代码生成: temp=0.2-0.5, top_p=0.6",

"对话系统: temp=0.7-0.9, top_p=0.8",

"重复惩罚: 通常1.1-1.3"

]

for i, rec in enumerate(recommendations):

axes[1, 1].text(0.1, 0.7 - i*0.1, rec, fontsize=12)

axes[1, 1].set_xlim(0, 1)

axes[1, 1].set_ylim(0, 1)

axes[1, 1].set_title('参数配置推荐')

axes[1, 1].axis('off')

plt.tight_layout()

plt.show()

# 运行深入分析

print("进行深入参数影响分析...")

analyzer = ParameterImpactAnalyzer(tester)

# 分析温度影响

test_prompt = "人工智能的未来发展:"

temperatures = [0.1, 0.3, 0.5, 0.7, 0.9, 1.1, 1.3, 1.5]

temp_impact = analyzer.analyze_temperature_impact(test_prompt, temperatures)

# 分析top-p影响

top_p_values = [0.1, 0.3, 0.5, 0.7, 0.9, 0.95, 0.99]

topp_impact = analyzer.analyze_topp_impact(test_prompt, top_p_values)

# 显示分析结果

print("\n温度影响分析结果:")

for result in temp_impact:

print(f"温度 {result['temperature']}: 总体评分 {result['overall_score']:.3f}, 样本: {result['text_sample']}")

print("\nTop-p影响分析结果:")

for result in topp_impact:

print(f"Top-p {result['top_p']}: 总体评分 {result['overall_score']:.3f}, 样本: {result['text_sample']}")

# 绘制图表

analyzer.plot_parameter_impact()输出结果:

子图1:温度参数对生成质量的影响(左上)

图表内容:

- X轴:温度值(0.1-1.5)

- Y轴:质量评分(0-1)

- 曲线1:总体评分随温度变化

- 曲线2:多样性评分随温度变化

实际意义:

- 低温区域(0.1-0.3):模型输出保守,重复性低但缺乏创意

- 中温区域(0.5-0.9):平衡点,质量评分通常最高

- 高温区域(1.0+):创造性增强但质量可能下降,多样性显著提高

业务价值:

- 帮助确定特定任务的最佳温度范围

- 直观展示温度与输出多样性之间的关系

- 为不同应用场景提供温度选择依据

子图2:Top-p参数对生成质量的影响(右上)

图表内容:

- X轴:Top-p值(0.1-0.99)

- Y轴:质量评分(0-1)

- 曲线1:总体评分随Top-p变化

- 曲线2:相关性评分随Top-p变化

实际意义:

- 低Top-p(0.1-0.3):输出高度聚焦,相关性高但可能缺乏深度

- 中Top-p(0.5-0.8):平衡相关性和丰富性

- 高Top-p(0.9+):包含更多可能性,相关性可能略有下降

业务价值:

- 指导如何设置Top-p以获得最佳相关性与多样性平衡

- 显示Top-p对内容质量的具体影响模式

- 为不同信息密度需求提供配置参考

子图3:生成质量评分分布(左下)

图表内容:

- X轴:总体质量评分

- Y轴:出现频次

- 柱状图:不同评分区间的配置数量分布

实际意义:

- 左偏分布:多数参数配置效果不佳

- 正态分布:参数敏感性适中

- 右偏分布:多数配置都能获得较好效果

业务价值:

- 评估参数调优的难易程度

- 了解模型在默认参数下的表现基线

- 判断是否需要精细调优

子图4:参数配置推荐(右下)

图表内容:

- 文本形式的参数调优建议,针对不同任务类型:

- 创意写作 \ 技术问答 \ 代码生成 \ 对话系统 \ 重复惩罚设置

实际意义:

- 基于实验数据总结的实用指南,将理论分析转化为可操作的配置建议。

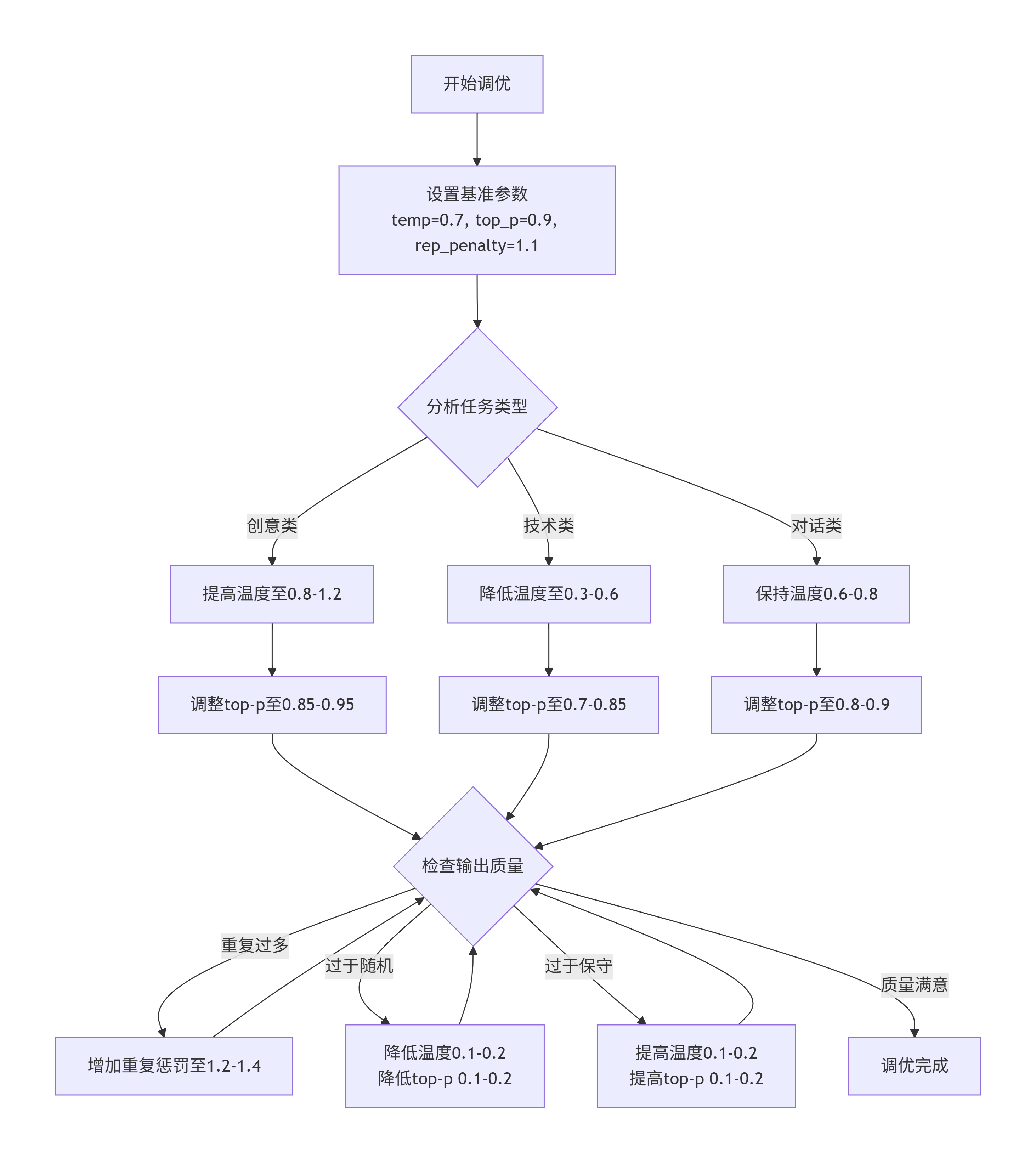

四、参数调优参考

1. 调优步骤

- 第一步: 设置 temperature=0.7, top_p=0.9 作为基准

- 第二步: 根据任务类型调整温度

- 需要创造性 → 提高温度 (0.8-1.2)

- 需要准确性 → 降低温度 (0.2-0.5)

- 第三步: 微调 top-p (0.7-0.95)

- 第四步: 设置重复惩罚 (1.1-1.3)

- 第五步: 必要时调整 top-k

2. 常见问题解决方案

- 输出过于重复 → 增加重复惩罚到1.2-1.4

- 输出太随机 → 降低温度到0.3-0.6,降低top-p到0.7-0.8

- 输出太保守 → 提高温度到0.8-1.0,提高top-p到0.9-0.95

- 生成时间太长 → 减小max_length,使用较小的top-k

3. 黄金组合推荐

- 通用对话: temp=0.7, top_p=0.9, rep_penalty=1.1

- 创意写作: temp=0.9, top_p=0.92, rep_penalty=1.05

- 技术文档: temp=0.4, top_p=0.8, rep_penalty=1.2

- 代码生成: temp=0.3, top_p=0.6, rep_penalty=1.3

4. 分步调优流程图

五、总结

大模型的参数调优本质上是在控制与释放之间寻找平衡的艺术。每个参数都代表了模型认知过程中的一个维度:温度控制着思维的保守与冒险、采样参数决定着注意力的集中与发散、重复惩罚平衡着表达的坚持与变化。

在逐步调试的过程中,我们首先应该构建系统性思维,理解参数间的相互作用,而非孤立调整,明确目标导向,根据具体任务需求选择调优方向,以数据驱动基于实际输出质量而非主观感受进行调整,自我的持续学习,跟踪最新研究和实践,不断更新调优策略。

最终,参数调优的目标不是找到绝对最优的参数组合,而是为特定的应用场景找到最合适的配置。这需要技术理解、实践经验和艺术直觉的完美结合。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录