概述

Ollama 是一款支持在本地运行多种开源大型语言模型,具有本地运行、开源模型支持、简化流程、高度定制且跨平台兼容等特性的软件平台。在 Cloud Studio 中,已内置 Ollama 环境,方便用户快速开展相关操作并探索模型功能。

环境配置

Ubuntu20.04、Python 3.10、Llama3 8B、CUDA 11.7、cuDNN 8、Ollama 和 JupyterLab。

快速开始

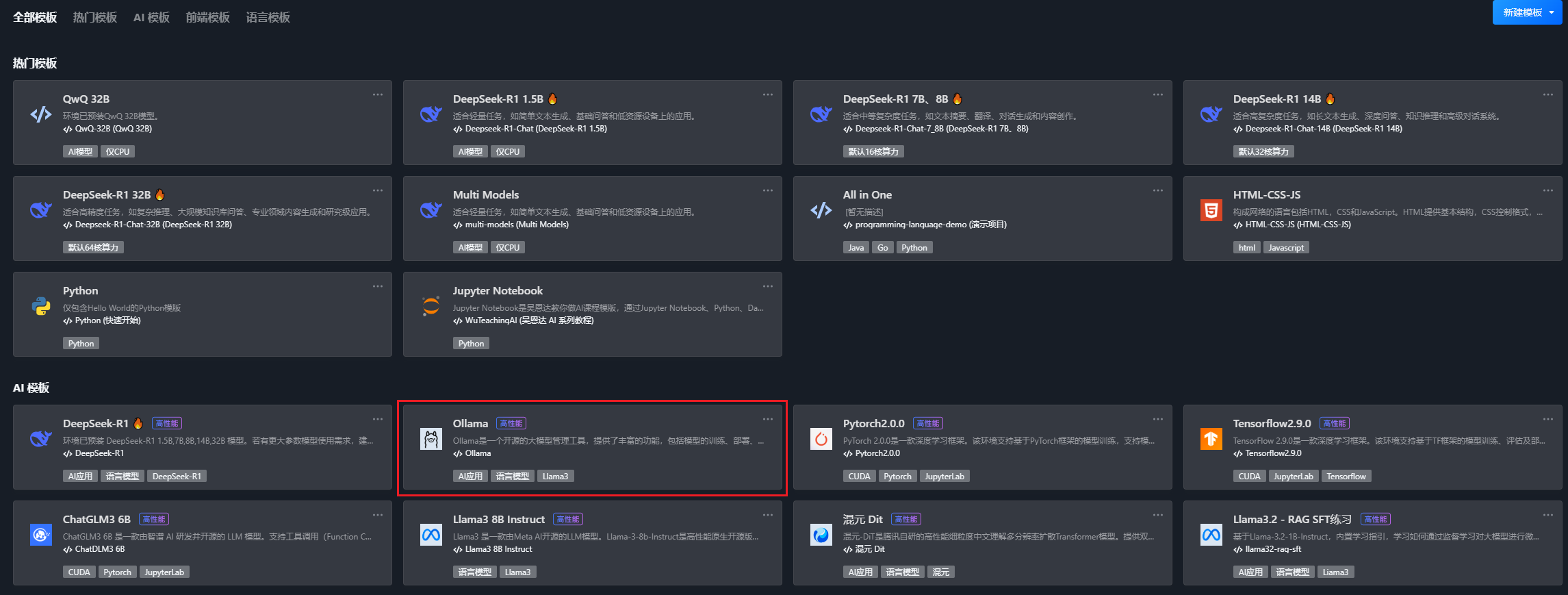

1. 访问 控制台,在空间模板 > AI 模板下单击选择 Ollama 来创建包含 Ollama 运行环境的工作空间。

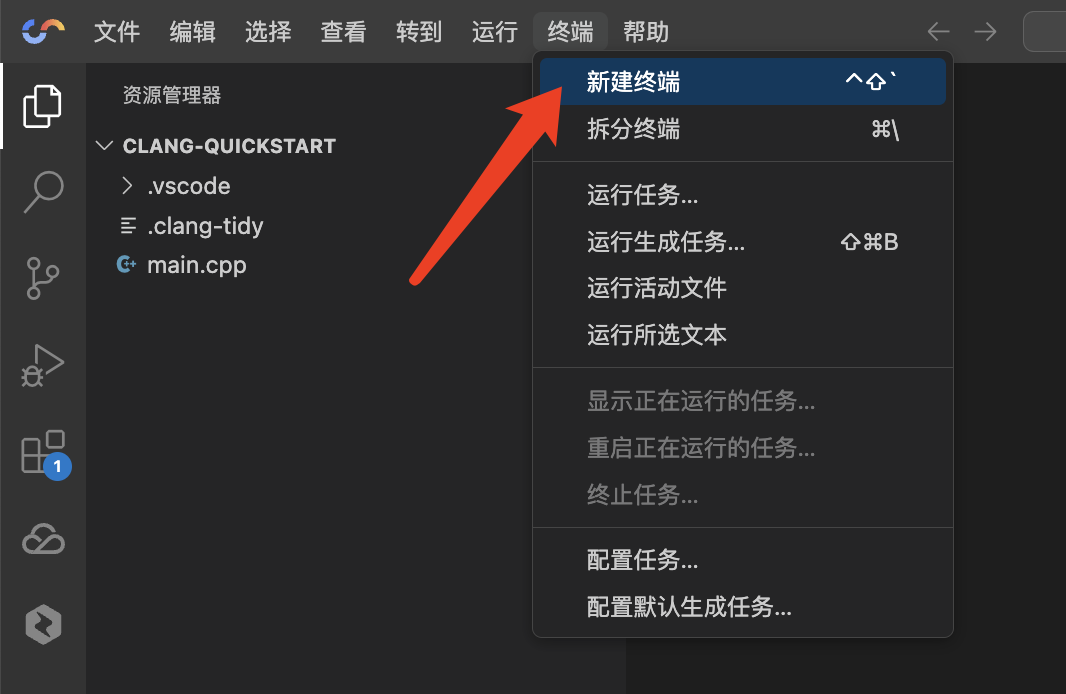

2. 单击终端 > 新建终端,在终端中输入以下命令直接运行。

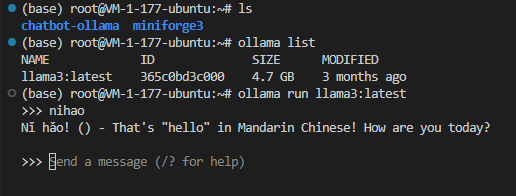

# 查看Ollama语言模型列表ollama list# 选择语言模型,启动ollamaollama run llama3:latest

3. 查看运行结果。

Ollama 的运行结果示例图如下:

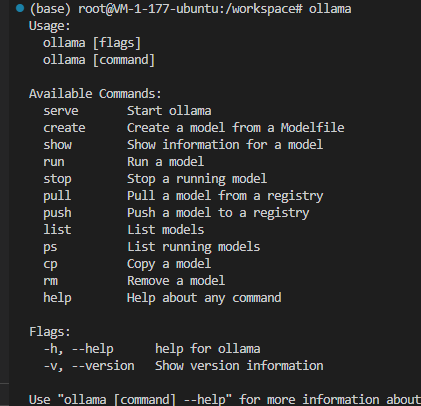

输入 Ollama 查看更多命令:

文件结构

当前目录树默认为 workspace 目录,完整文件结构如下:

root/├── workspace/ # Cloud Studio 内置示例文件,仅该文件夹变更支持持久化│ └── Readme.md├── qcloud_hai/ # HAI 其他进程,如ComfyUI、WebUI等│ └── ...├── root/ # 一般模型文件存放在该文件夹│ └── chatbot-ollama│ └── CONTRIBUTING.md│ └── LICENSE│ └── README.md│ └── docker-compose.yml│ └── __tests__│ └── ...│ └── k8s│ └── ...│ └── next-i18next.config.js│ └── node_modules│ └── ...│ └── package.json│ └── postcss.config.js│ └── public│ └── ...│ └── styles│ └── ...│ └── tsconfig.json│ └── utils│ └── ...│ └── Dockerfile│ └── Makefile│ └── SECURITY.md│ └── components│ └── ...│ └── hooks│ └── ...│ └── next-env.d.ts│ └── next.config.js│ └── package-lock.json│ └── pages│ └── ...│ └── prettier.config.js│ └── services│ └── ...│ └── tailwind.config.js│ └── types│ └── ...│ └── vitest.config.ts│ └── ...├── ...

Ollama 官方文档与资源

Ollama 官方 使用文档。

查看 Ollama 语言模型。