概述

使用 QwQ 32B 模板,我们已为您预装并启动了以下服务,工作空间创建后等待加载十几秒即可查看效果。

Ollama 服务:支持通过 API 调用多个模型。

AnythingLLM 前端服务:提供交互式聊天界面,支持知识库上传并基于知识库进行问答。

Open WebUI 前端服务:提供交互式聊天界面,支持上传文件作为上下文进行问答。

预装模型:QwQ 32B 及其他 Ollama 官网上的热门模型,包括多个通用模型及嵌入模型,并且我们会持续更新。

使用教程

您可以通过 AnythingLLM 及 Open WebUI 管理知识库并对话,通过命令行调用模型、使用 Ollama 原生命令对话等方式来使用 QwQ 32B。

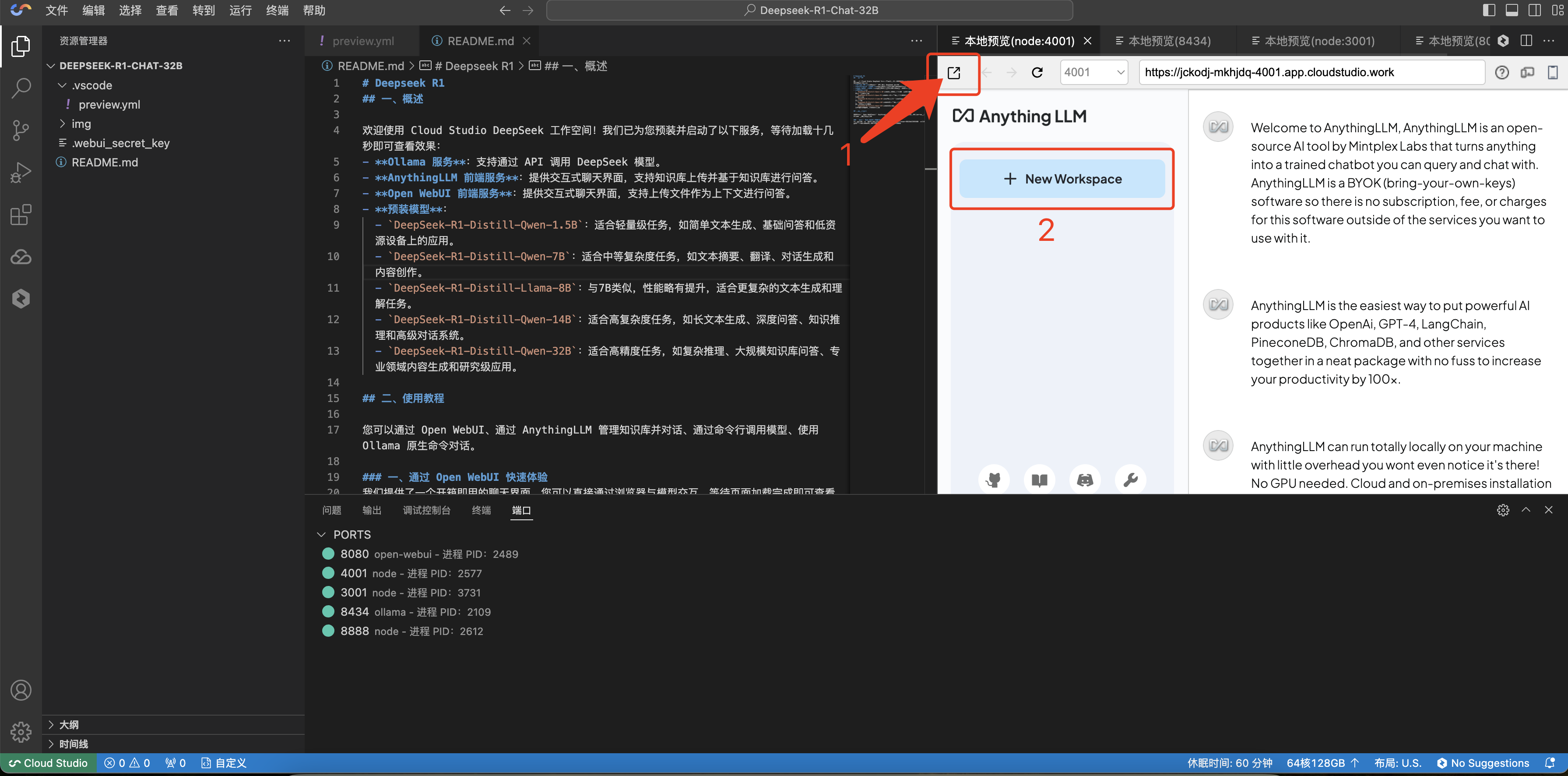

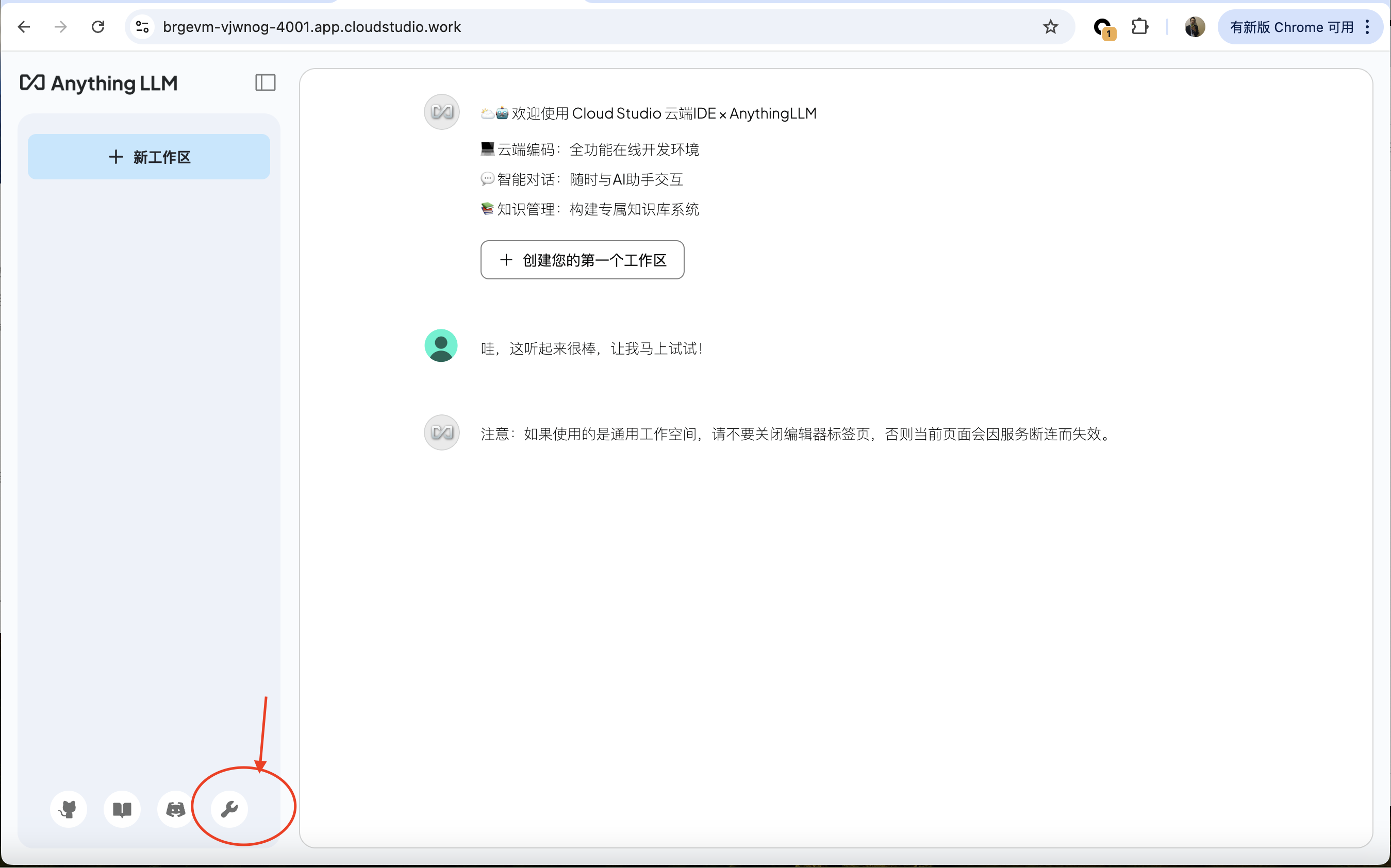

一. 通过 AnythingLLM 管理知识库并对话

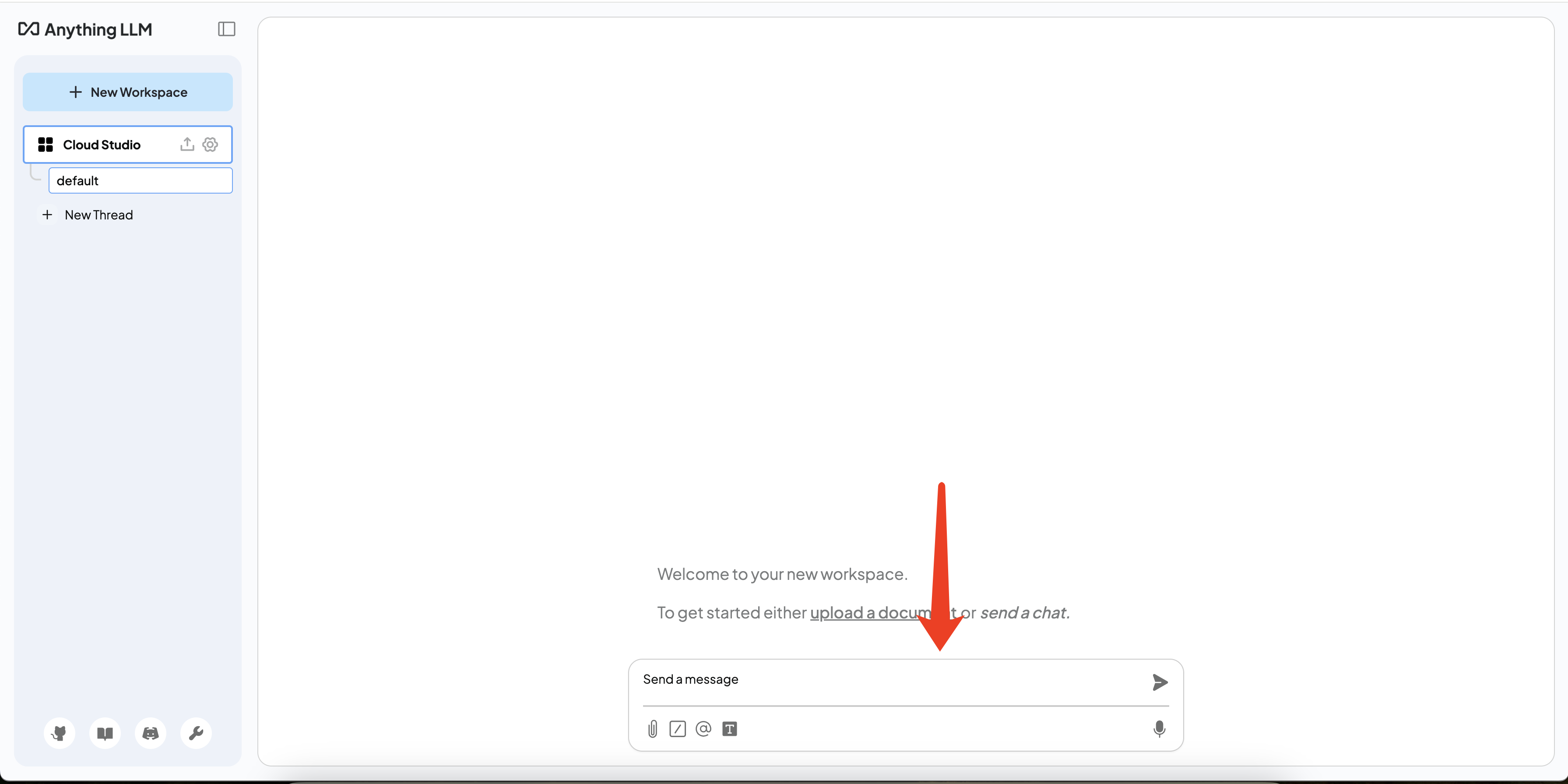

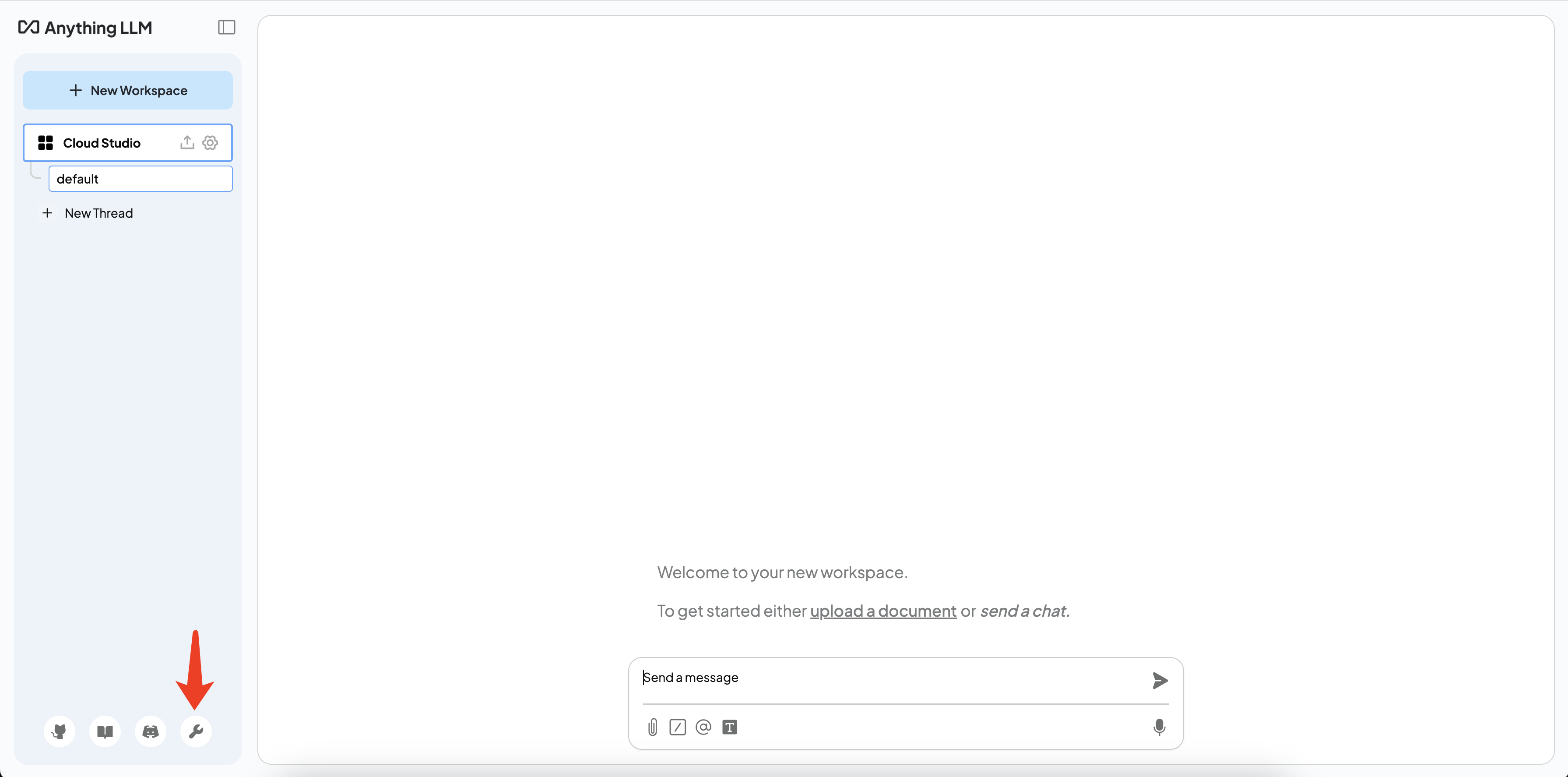

我们提供了一个开箱即用的聊天界面,您可以直接通过浏览器与模型交互。等待页面加载完成即可查看到下图中的预览界面。单击红框区域,即可在新页面打开聊天页面。或单击 New Workspace 创建工作区进行对话。

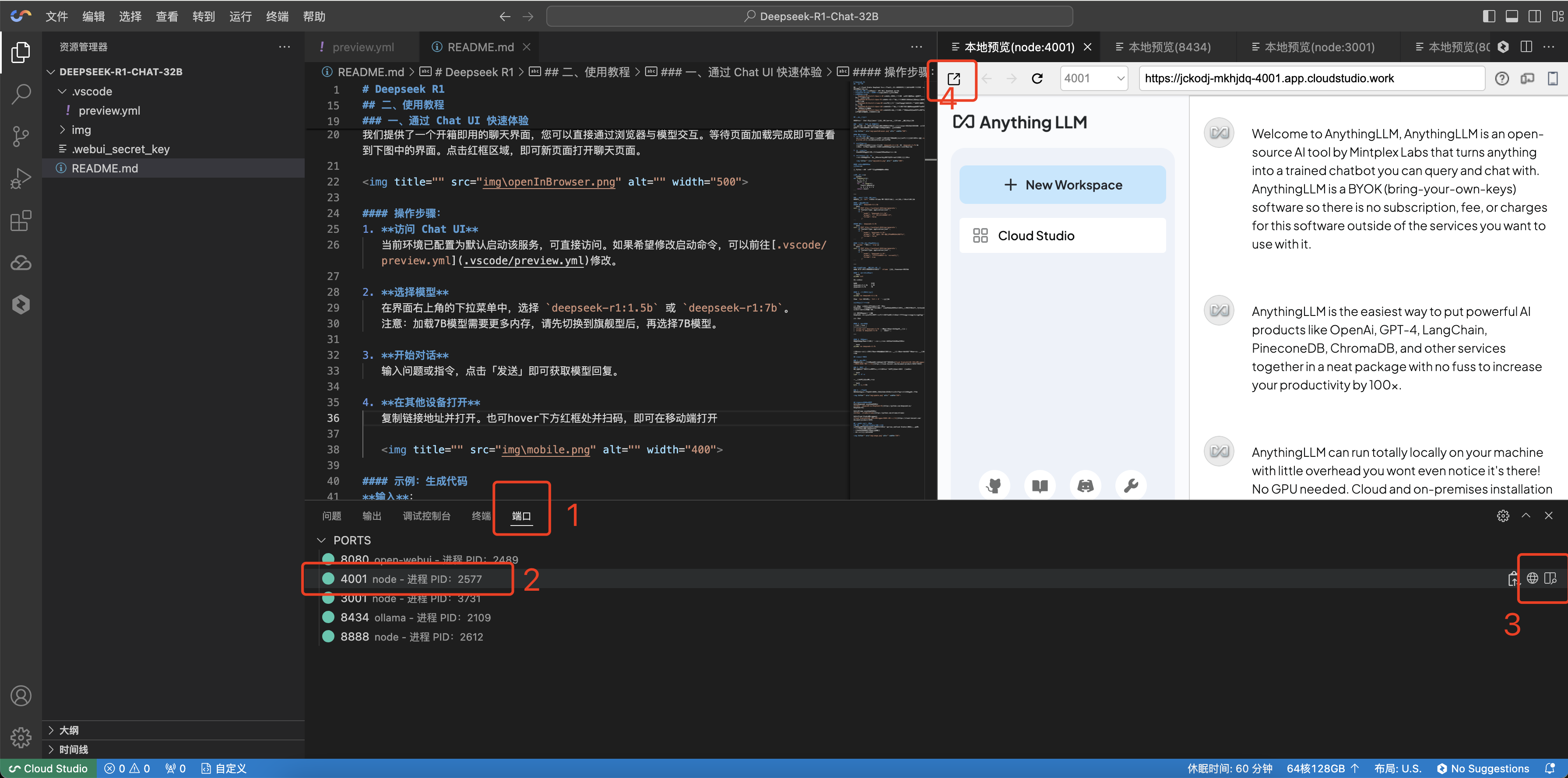

如页面加载完成后没有看到预览界面,可依次单击端口 > 4001 >

操作步骤

注意:

该浏览地址仅在当前工作空间内有效,如果关闭工作空间,则无法访问。所以使用中请保持打开当前编辑器标签页,不要关闭。

1. 设置模型

单击页面左下方的

2. 选择模型

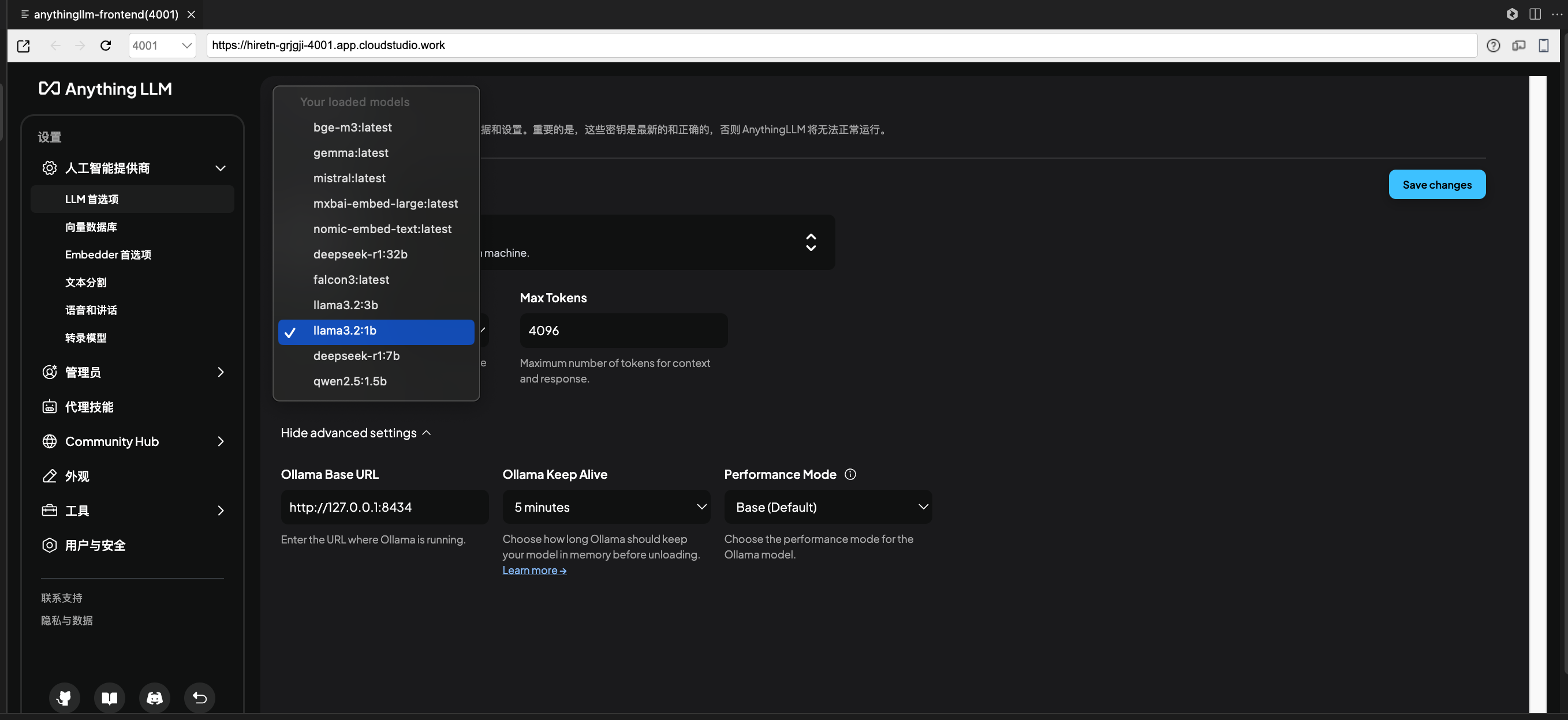

2.1 在人工智能提供商 > LLM 首选项 > Ollama Model,选择 Ollama 模型。

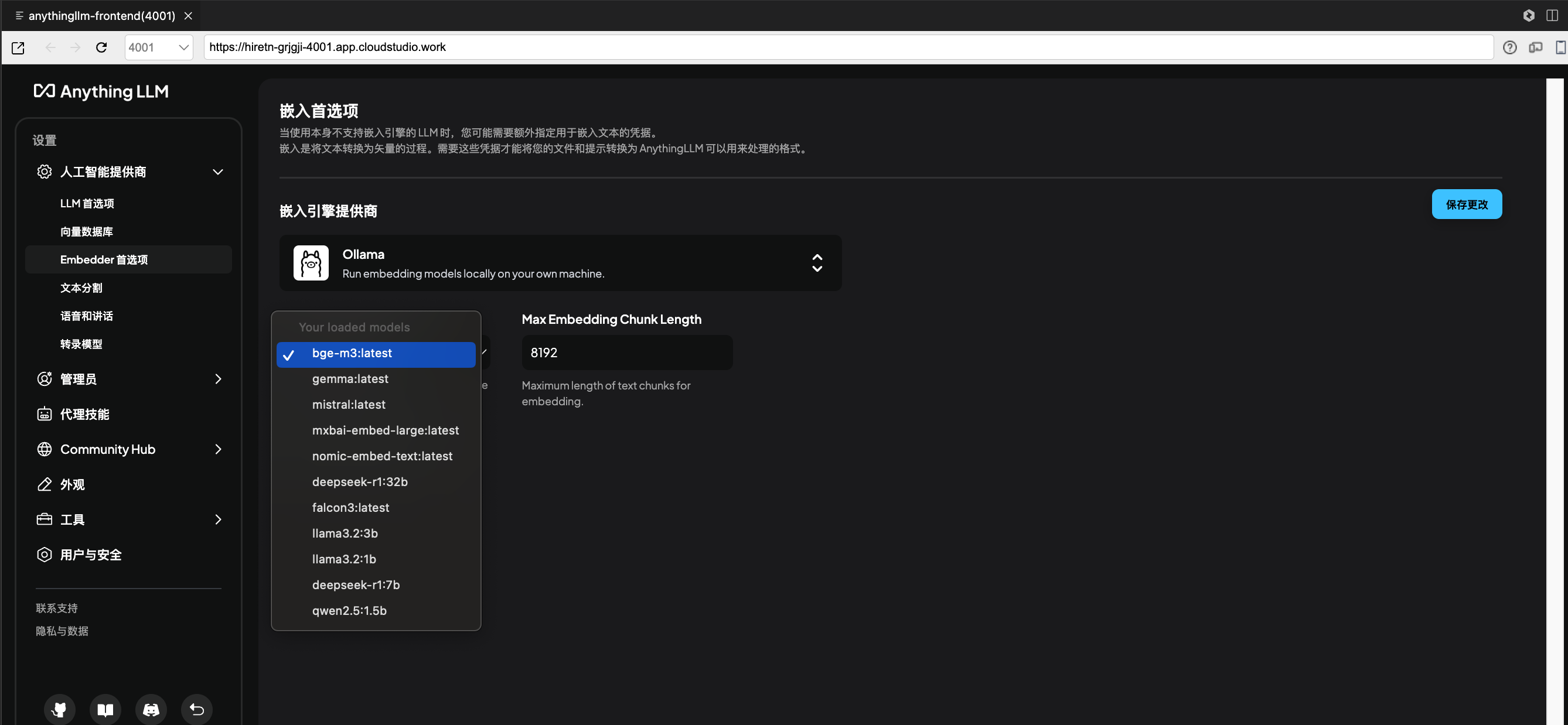

2.2 在人工智能提供商 > Embedder 首选项 > Ollama Embedding Model,选择 Ollama 嵌入模型。

3. 开始对话

输入问题或指令,发送后即可获取模型回复。

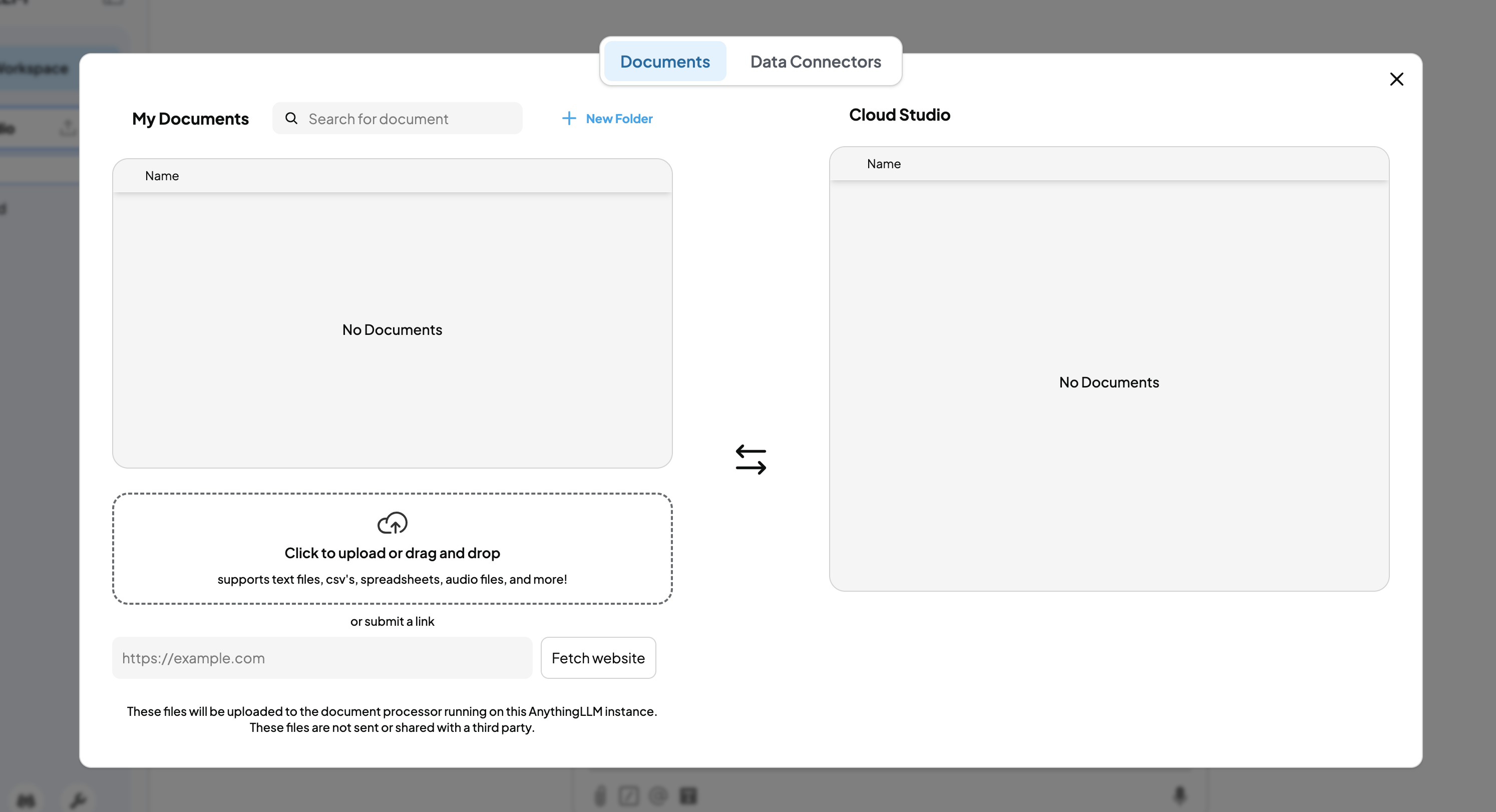

4. 上传知识库

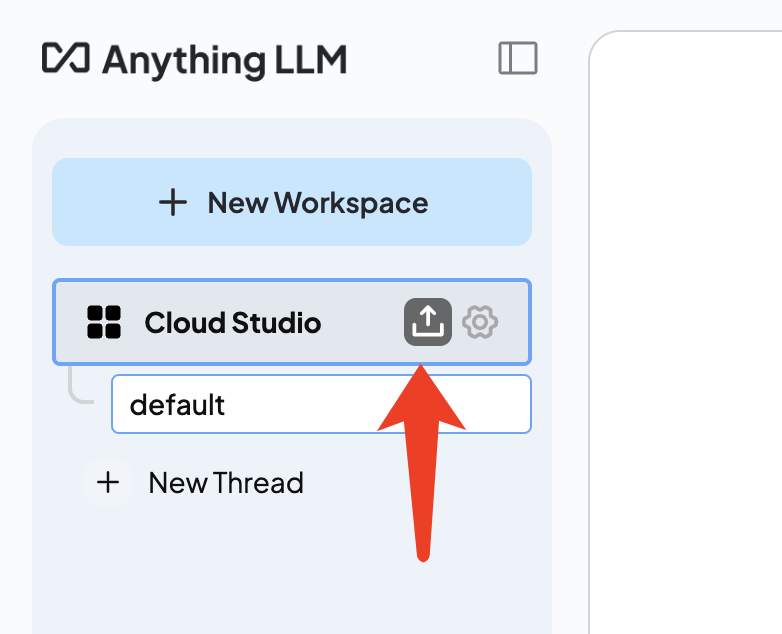

单击上传,选择本地文件,即可上传知识库。

二. 其他本地组件配置知识库进行对话(Cherry Studio)

常见问题

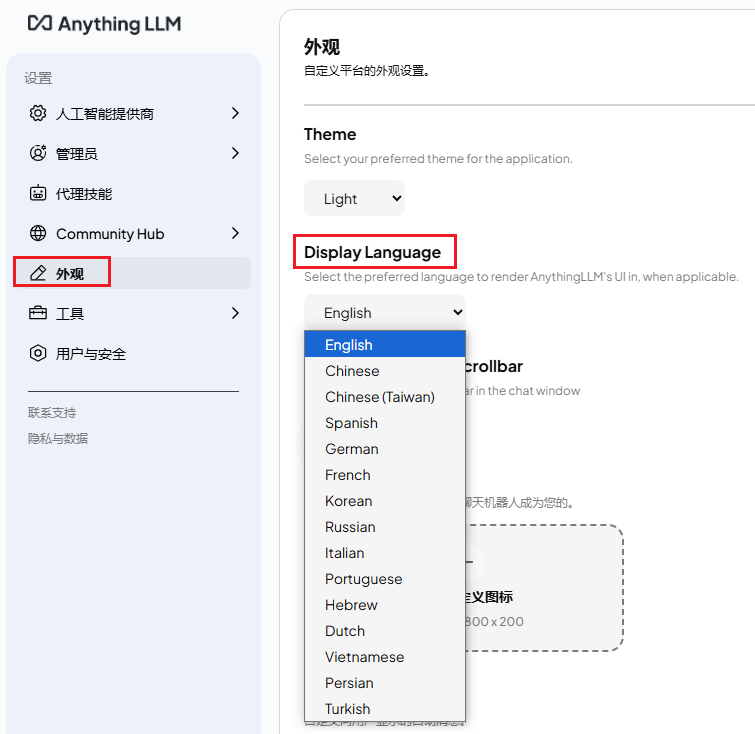

1. 如何修改系统语言?

单击页面左下方的

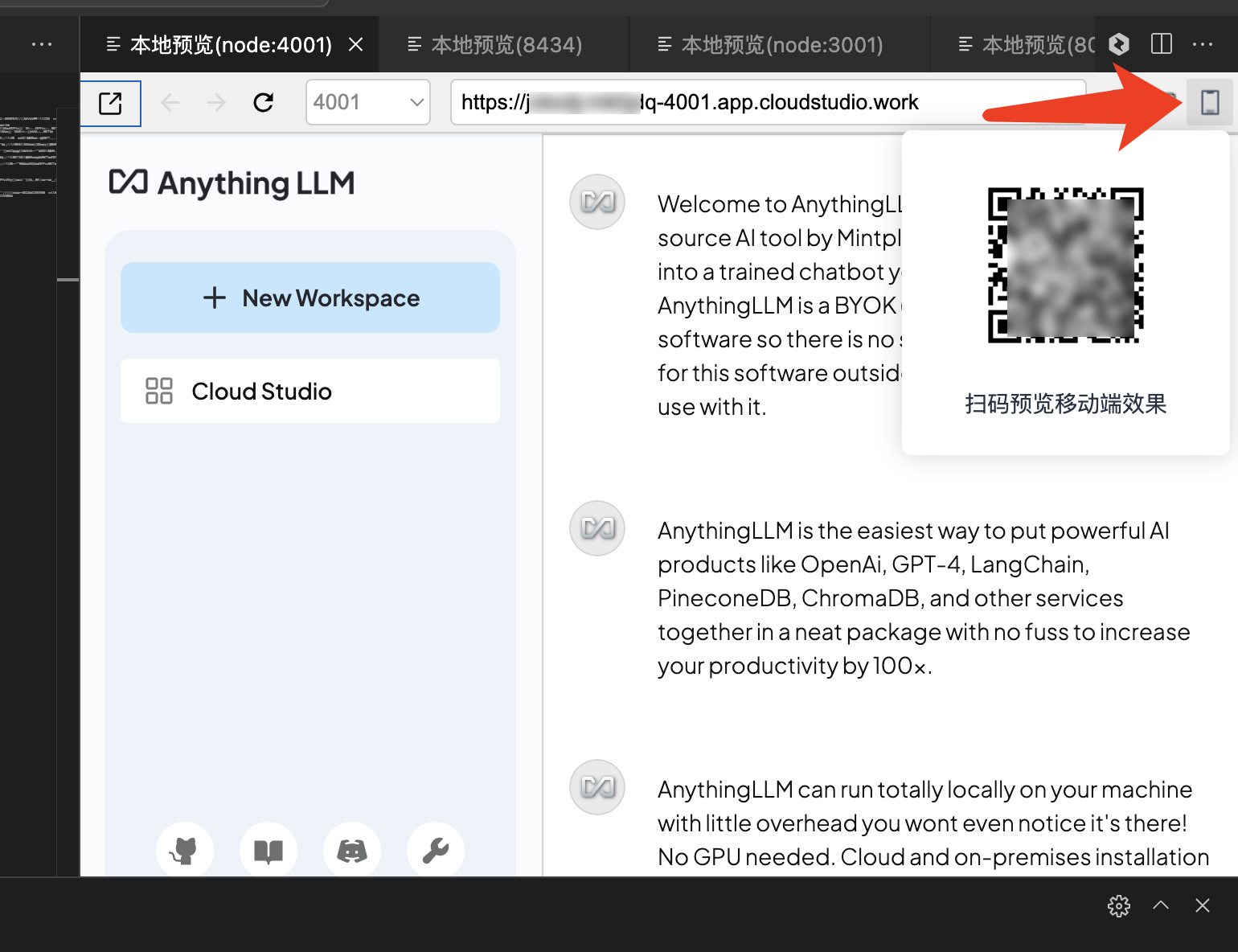

2. 如何在其他设备打开?

复制链接地址粘贴到其他设备打开;或将鼠标悬停在界面中如图的红框处并扫码,也可在移动端打开。

三. 通过命令行调用和切换其他模型

您可以使用

curl 直接与 Ollama 服务交互,适用于自动化任务或脚本调用。 基础请求示例

调用 llama3.2:1.5B

curl -X POST http://localhost:8434/api/generate \\-H "Content-Type: application/json" \\-d '{"model": "ollama3.2:1b","prompt": "用一句话解释量子计算","stream": false}'

流式输出(实时逐句返回)

将

stream 参数设为 true: curl -X POST http://localhost:8434/api/generate \\-H "Content-Type: application/json" \\-d '{"model": "ollama3.2:1b","prompt": "详细说明如何训练一个神经网络","stream": true}'

四. Ollama 原生命令进阶使用

除了 HTTP API,您还可以直接通过

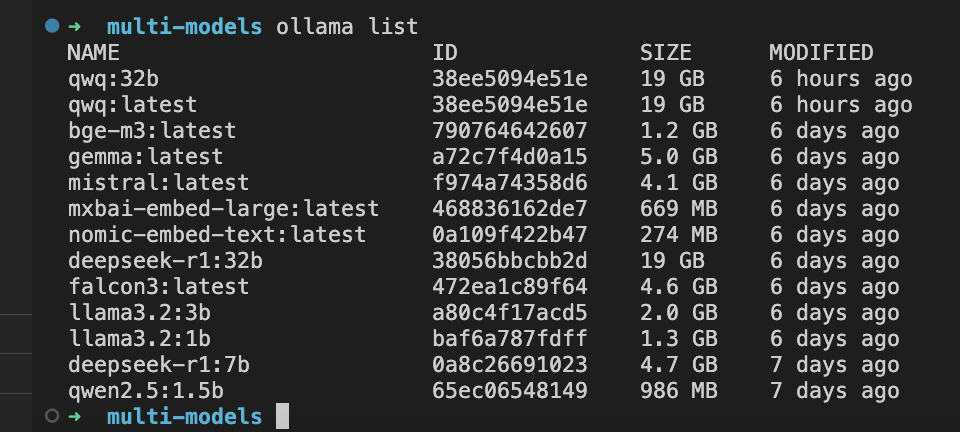

ollama 命令行工具与模型交互。 1. 查看已安装模型

输入命令:

ollama list

输出示例:

NAME ID SIZE MODIFIEDqwq:32b 38ee5094e51e 19 GB 6 hours agoqwq:latest 38ee5094e51e 19 GB 6 hours agobge-m3:latest 790764642607 1.2 GB 6 days agogemma:latest a72c7f4d0a15 5.0 GB 6 days agomistral:latest f974a74358d6 4.1 GB 6 days agomxbai-embed-large:latest 468836162de7 669 MB 6 days agonomic-embed-text:latest 0a109f422b47 274 MB 6 days agodeepseek-r1:32b 38056bbcbb2d 19 GB 6 days agofalcon3:latest 472ea1c89f64 4.6 GB 6 days agollama3.2:3b a80c4f17acd5 2.0 GB 6 days agollama3.2:1b baf6a787fdff 1.3 GB 6 days agodeepseek-r1:7b 0a8c26691023 4.7 GB 7 days agoqwen2.5:1.5b 65ec06548149 986 MB 7 days ago

2. 启动交互式对话

输入命令:

ollama run qwq:32b

输入

/bye或者点击 Ctrl + D 退出对话。 示例对话流程:

>>> 推荐一个适合初学者的机器学习项目QwQ: 一个手写数字识别系统是一个不错的入门项目,可以使用MNIST数据集和Python的scikit-learn库快速实现...>>> 如何评估模型性能?QwQ: 常用方法包括划分训练集/测试集、交叉验证、计算准确率/精确率/召回率等指标...>>> /bye

3. 模型管理

命令 | 说明 |

ollama pull qwq:32b | 重新拉取模型(更新时使用)。 |

ollama rm qwq:32b | 删除模型。 |

4. 切换模型

如需切换到其他模型,可在退出当前进程后再次输入以下代码即可:

ollama run qwq:32b

注意:

当前机器为 CPU,7B模型推理速度较慢,建议使用1.5B模型。更大参数模型建议使用 HAI 进阶型。

常见问题

如何查看更多预览使用?

端口占用,如何释放?

如果需要释放端口,关闭某个进程,可以通过下述命令查看端口占用情况:

lsof -i -P -n

再使用下述命令关闭进程:

kill -9 <进程ID>

提示空间不足怎么处理?

如果右下角提示空间不足,可单击右下角的资源规格(如“2核4G”),选择“旗舰版”,即可升级空间。

免费版工作空间时长用完如何继续使用?

相关文档与资源

QwQ-32B 官方介绍文档:QwQ-32B: 领略强化学习之力

Cloud Studio 更多操作指南:Cloud Studio(云端 IDE)操作指南