背景介绍

DeepSeek-R1 在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。在数学、代码、自然语言推理等任务上,性能比肩 OpenAI o1 正式版。

DeepSeek-R1 32B TACO 加速版环境预装腾讯云自研 TACO 推理加速框架及 DeepSeek-R1 32B 模型,大幅提升推理性能,实测在多个场景下较 vLLM 有80%的性能提升。

注意:

DeepSeek-R1 32B TACO 加速版环境目前仅对白名单客户开放,若您有体验需求,可在本文档下方填写问卷提交试用申请。

快速使用

步骤一:创建 DeepSeek-R1 32B TACO 加速版应用

1. 登录 高性能应用服务 HAI 控制台。

2. 单击新建,进入高性能应用服务 HAI 购买页面。

选择应用:选择社区应用,应用选择 DeepSeek-R1 32B TACO 加速版。

地域:建议选择靠近自己实际地理位置的地域,降低网络延迟、提高您的访问速度。

算力方案:选择合适的算力套餐。

实例名称:自定义实例名称,若不填则默认使用实例 ID 替代。

购买数量:默认1台。

3. 单击立即购买。

4. 核对配置信息后,单击提交订单,并根据页面提示完成支付。

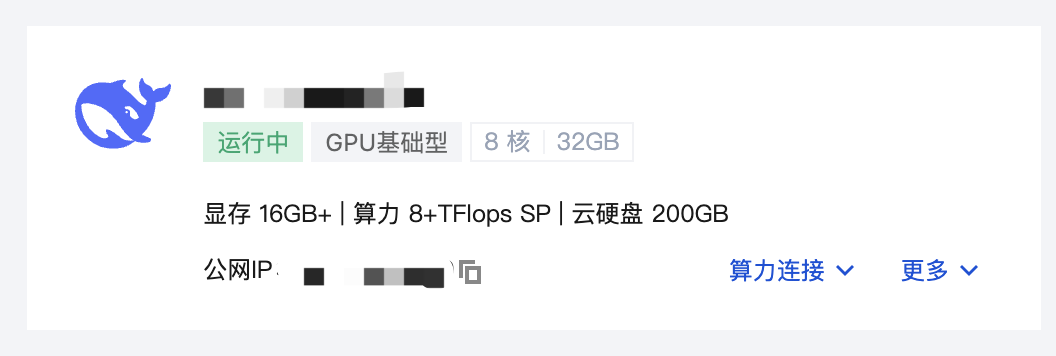

5. 等待创建完成。单击实例任意位置并进入该实例的详情页面。同时您将在站内信中收到登录密码。此时,可通过可视化界面(GUI)使用 DeepSeek 模型。

6. 您可以在此页面查看详细的配置信息,到此为止,说明您的应用实例购买成功。

步骤二:使用 DeepSeek-R1 模型

等待几分钟创建完成后,将在站内信中收到登录密码。此时,可通过可视化界面(GUI)使用 DeepSeek 模型。

通过 OpenWebUI 可视化界面使用(推荐)

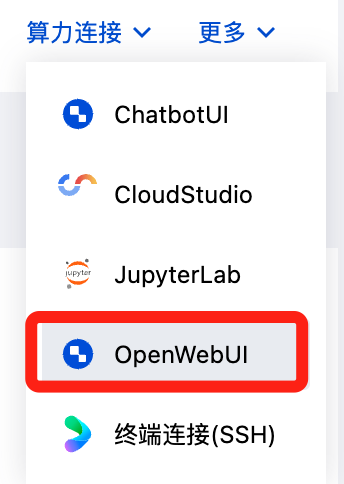

1. 登录 高性能应用服务 HAI 控制台,选择算力连接 > OpenWebUI。

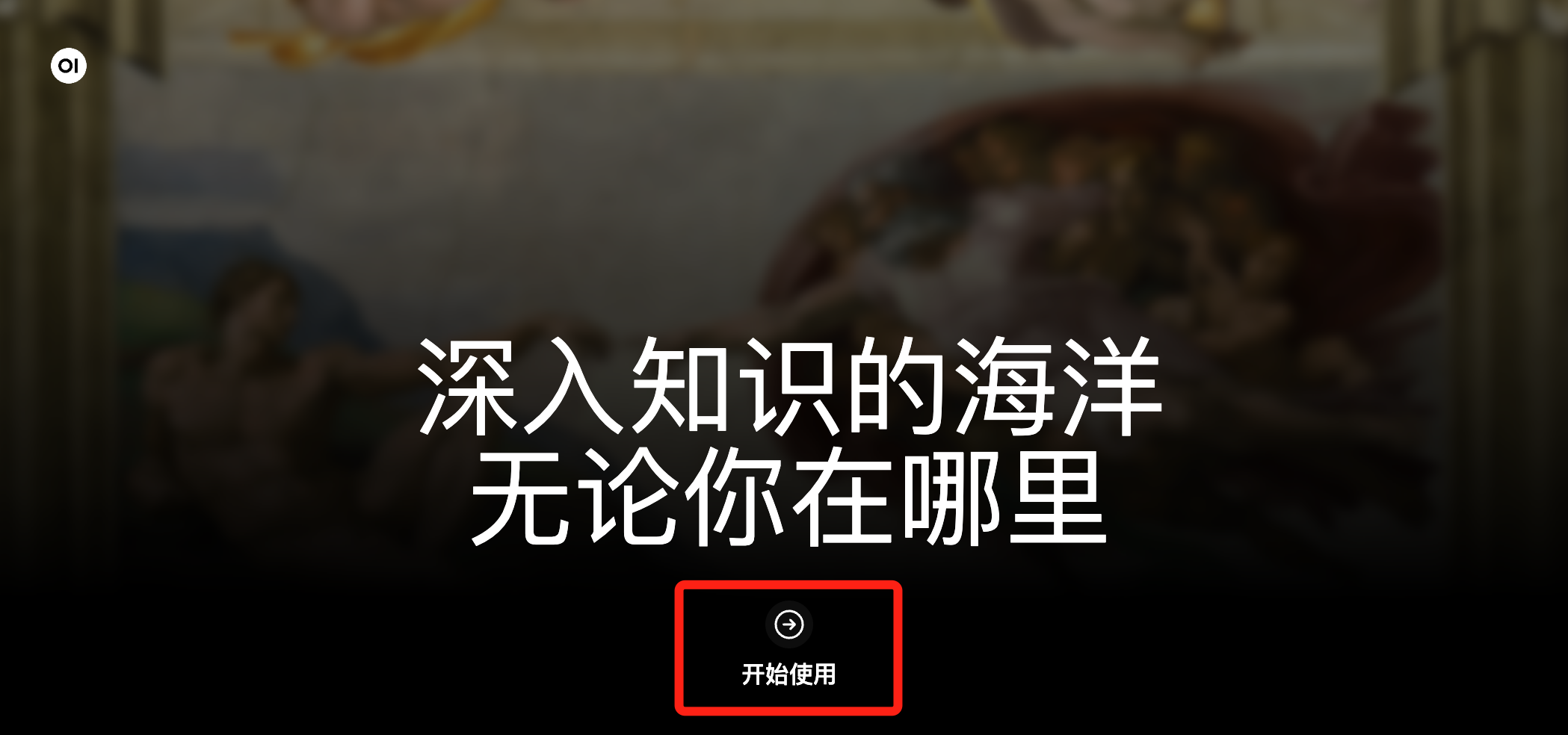

2. 在新窗口中,单击开始使用。

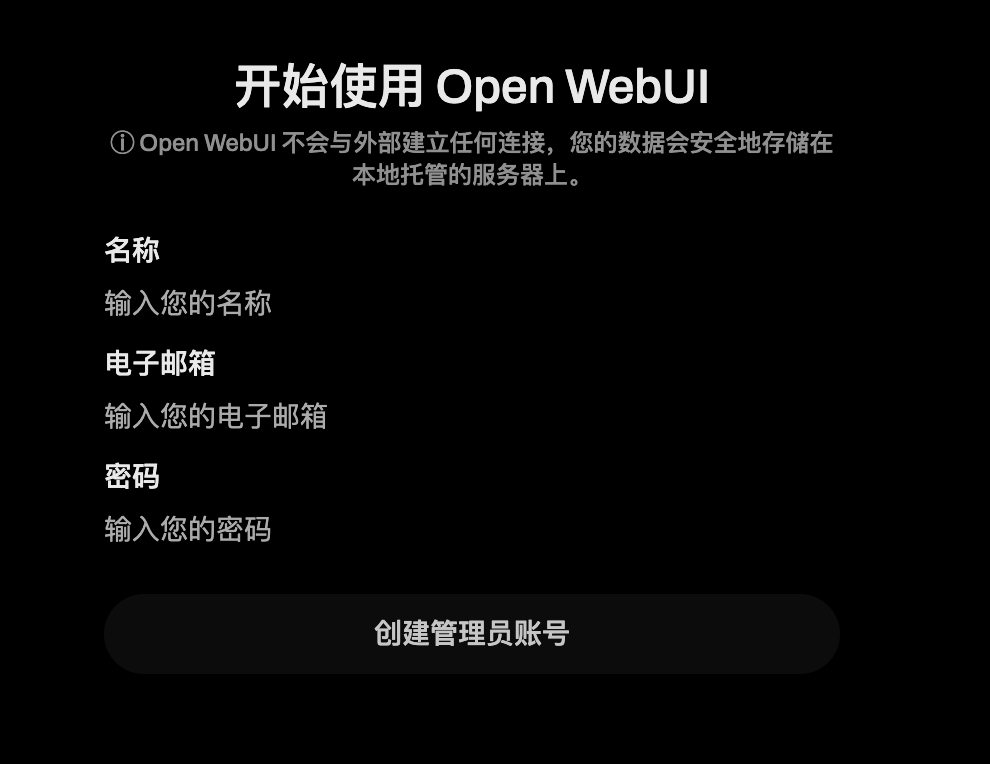

3. 自定义名称、电子邮箱、密码,创建管理员账号。

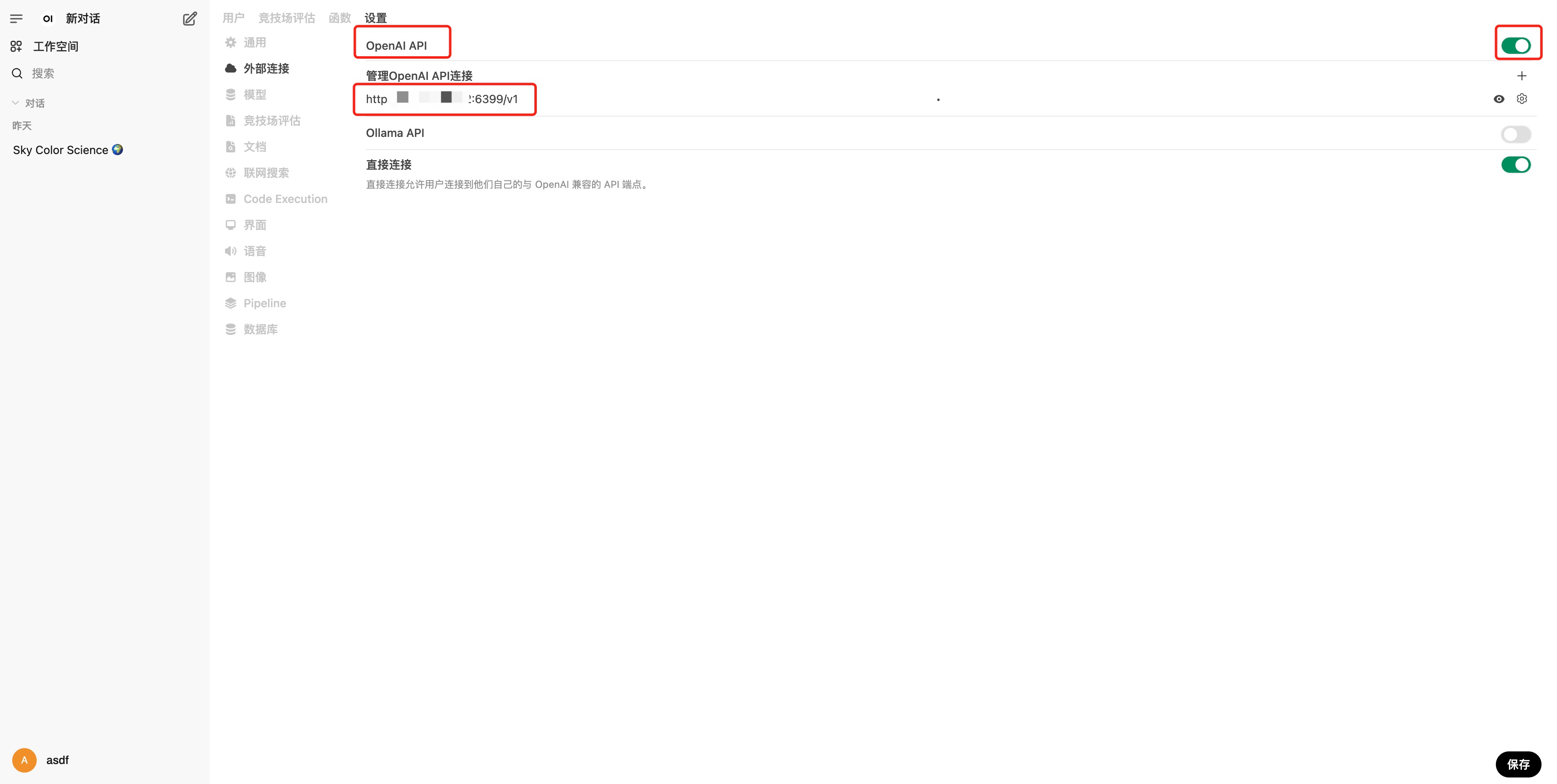

4. 配置 OpenWebUI:单击页面左下角设置-管理员设置-外部连接。

将 OpenAI API 连接修改为该台 HAI 实例的公网 IP:6399/v1。

5. 配置完成后,即可返回聊天页面进行对话。

通过 AnythingLLM 可视化界面使用

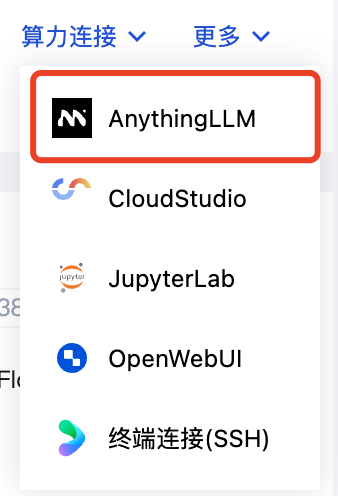

1. 登录 高性能应用服务 HAI 控制台,选择算力连接 > AnythingLLM。

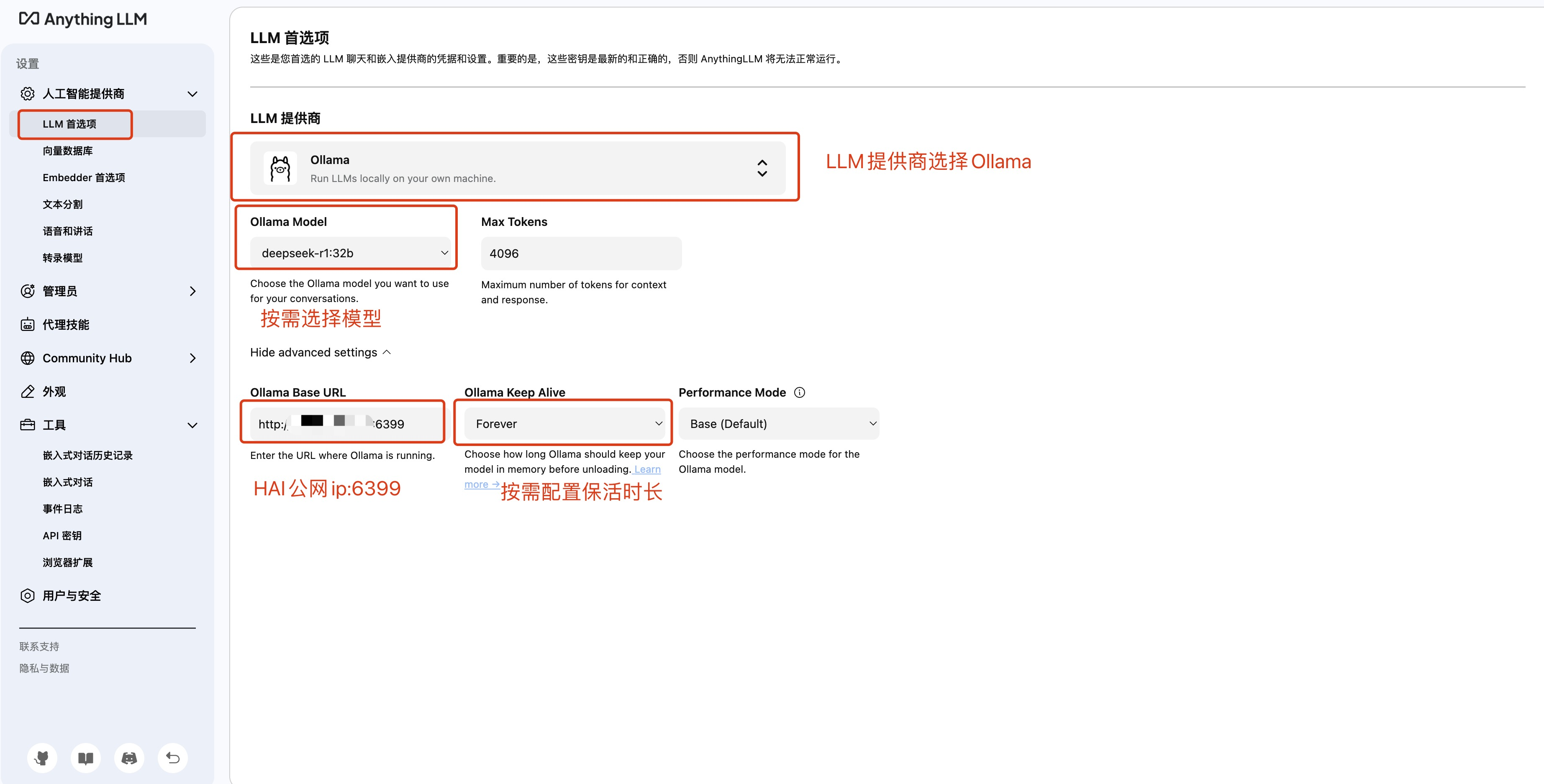

2. 新建窗口后,单击页面左下角设置,进入设置页面。单击左侧导航栏 LLM 首选项进入配置。

将 LLM 提供商选择为 Ollama。

将 Ollama Base URL 修改为:该台 HAI 实例的公网 IP:6399。

在 Ollama Model 处选择需要使用的模型,例如:deepseek-r1:32b。

在 Ollama Keep Alive 处按需配置保活时长。(模型在每次超过保活时长后会被移除,再次使用时需重新载入模型,耗时较久,若不存在频繁切换模型诉求,建议将保活时长尽可能调大。)

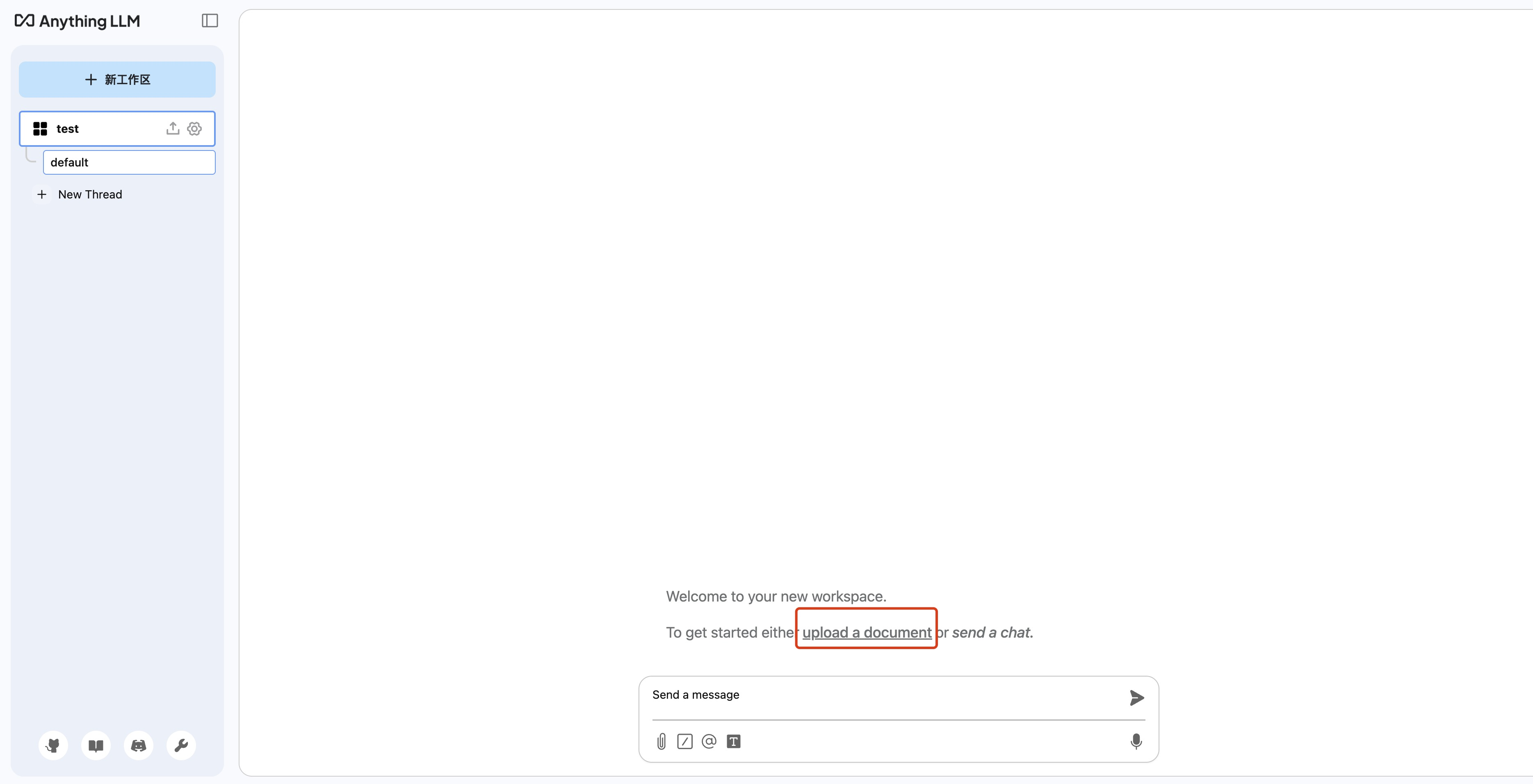

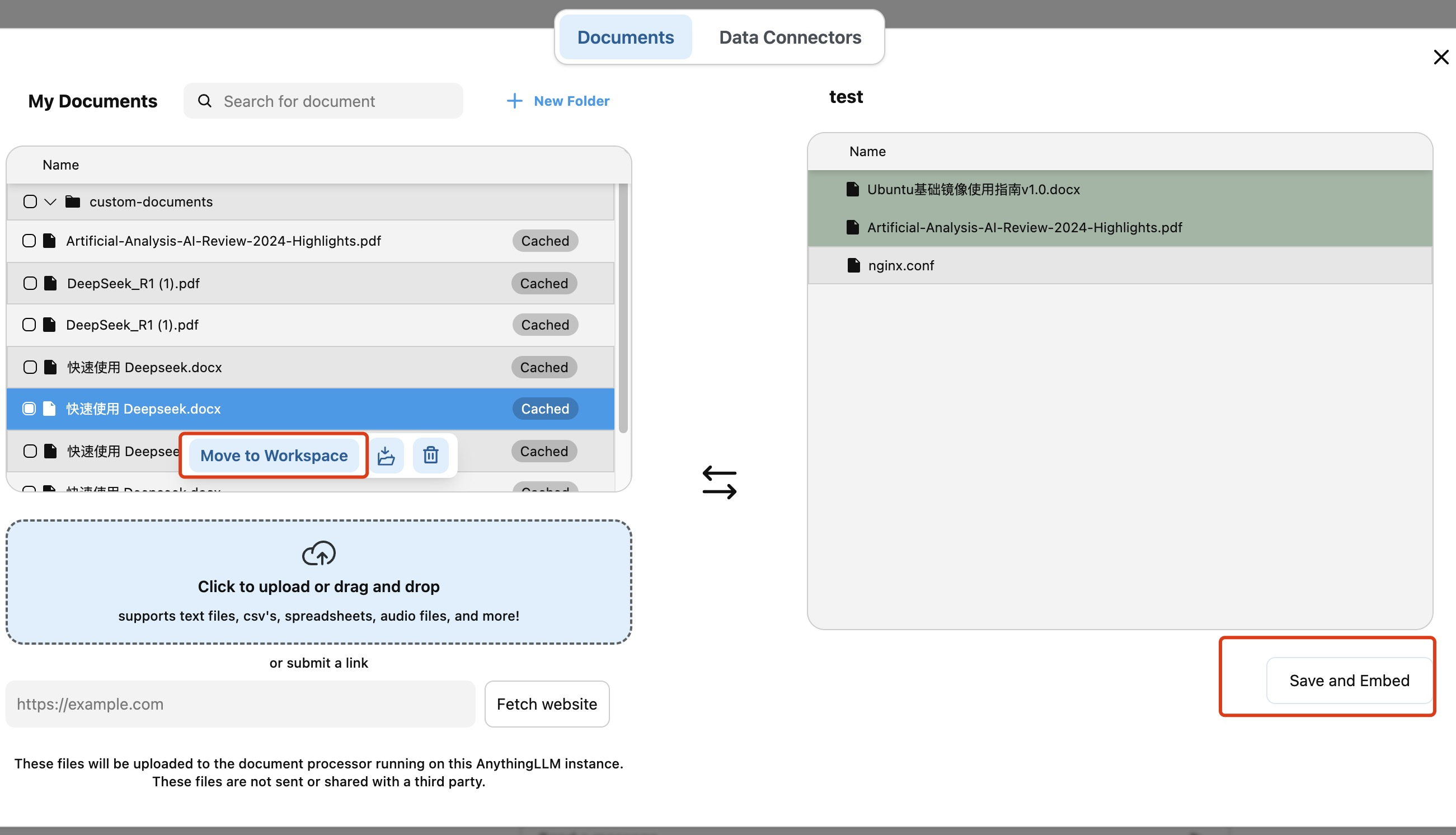

3. 配置完成后,回到项目页面,单击 upload a document 上传本地文件。

4. 上传文件后,选中希望使用的文件,单击 Move to Workspace 将文件添加至项目。单击 Save and Embed,完成配置。

5. 您可直接与模型进行对话,模型会根据对话内容智能调用本地知识库内容。

API 调用

该环境 API 兼容 OpenAI 调用规范,在实例启动后,您可使用下述调用方式对模型进行调用。

将

ip 修改为实例公网 IP,port 修改为6399。将

"Bearer $OPENAI_API_KEY" 替换为任意字符。curlhttp://<ip>:port/v1/chat/completions\\-H"Content-Type: application/json"\\-H"Authorization: Bearer $OPENAI_API_KEY"\\-d'{"model": "deepseek-r1-32b","messages": [{"role": "user", "content": "为什么天空是蓝色的"}],"temperature": 0.7}'