概述

TKE 弹性推理服务模型广场针对模型部署时复杂的配置和调优问题,将业界主流的开源模型(如 DeepSeek、Qwen 等)与高性能推理引擎(如 TACO、vLLM 等)进行了预先集成和深度优化,让您可以跳过繁琐的准备工作,通过一键式操作快速部署获得稳定、强大的在线推理服务。

前提条件

在开始使用模型广场部署推理服务前,请确保您已满足以下条件:

1. 您已拥有腾讯云账号,并具备对相关云资源(如 COS、CLS 等)的操作权限。

2. 您已经按照 资源管理 的指引,创建了应用集群和资源组,并已导入可用的 CVM 计算节点。

操作步骤

使用模型广场一键式部署推理服务

平台为您预置了多个业界主流的开源模型,无需您手动下载和配置,即可快速发起部署。

1. 登录 容器服务控制台,选择左侧导航栏中的弹性推理服务。

2. 在左侧导航栏中,单击模型广场,进入模型广场页面。 您可以在模型广场页面查看当前平台支持的所有内置模型列表,并通过任务类型、模型系列和模型相关标签进行筛选以便快速查找需要的模型。

说明:

模型广场的内置模型列表由平台统一运营和更新,暂不支持用户在界面上进行自定义增删。

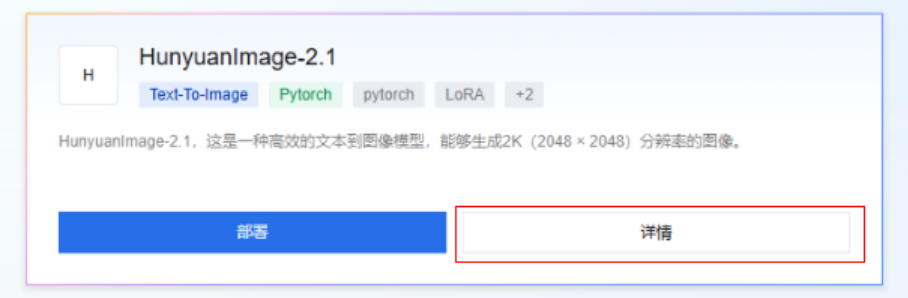

3. 单击详情,深入了解模型的全面信息。 这里是模型的数字档案,涵盖了其核心技术规格、性能指标和应用指南等内容(不同模型的涵盖内容会有差别)。

您将在这里找到:

核心信息:模型版本、许可证、发布日期。

技术规格:模型架构、参数量、所属框架(如 PyTorch、TensorFlow)。

模型能力:适用任务、预期用途、性能评估(数据集与指标)。

使用指南:快速上手的代码示例、API 调用方法。

说明:

在部署前,请重点关注技术规格中的参数量,这直接决定了所需的 GPU 显存。例如,7B 模型通常需要至少 16GB 显存的 GPU。

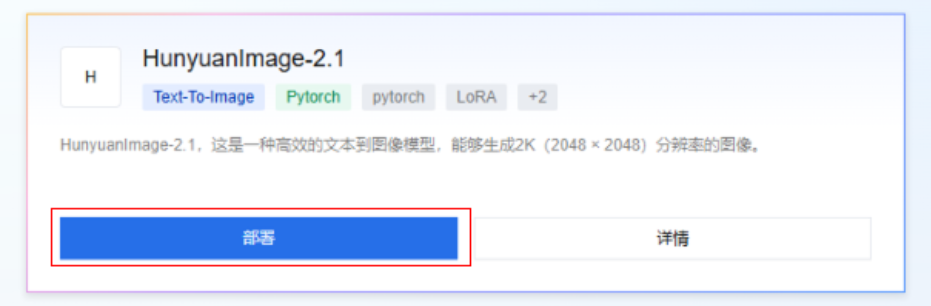

4. 单击模型选项卡底部的部署,进入推理服务创建页面。

5. 在基本配置处,配置服务的基本信息。

服务名称:输入自定义的服务名称,例如

my-hunyuan-service。描述:根据需要填写服务的描述信息。

资源模型:在模型广场选择的模型,由平台自动设置。

6. 继续完成部署信息、访问配置 、高级参数等后续配置。 配置详情可以参考 推理服务。

7. 确认所有配置信息无误后,单击底部确定,平台将开始为您部署所选模型的推理服务。服务部署通常需要3-5分钟,就绪后,您可以在推理服务列表中看到 my-hunyuan-service 的状态变为“运行中”。单击服务名称,即可在服务详情页面找到调用方法,以验证服务是否部署成功。

常见问题

我希望部署的模型不在模型广场列表中,应该怎么办?

TKE 弹性推理服务正在积极规划后续对其余模型的支持,欢迎向我们反馈您的模型需求,这将帮助我们确定未来优先支持的模型范围。 如果您已经拥有模型文件,也可以通过将模型文件上传至 COS 并进行授权,在 新建推理服务 时选择自定义模型以完成部署,具体步骤请参见 推理服务。

选择不同模型时,对资源规格有什么建议?

不同参数规模的模型对 GPU 显存的要求差异很大。例如,Qwen/Qwen3-32B 这类百亿参数模型通常需要高端 GPU 才能运行。您可以在模型广场确认模型的参数大小并查看模型详情以获得具体的资源规格需求。

模型部署失败的常见原因有哪些?

除了资源规格不足外,常见的失败原因还包括:

网络配置问题:请确保您的应用集群所在 VPC 网络通畅,特别是能够访问到模型所在的存储后端。

账户配额限制:检查您的账户下相关资源(如 CVM、CLB)是否已达到配额上限。

相关文档

关于如何创建应用集群和资源组,并导入可用的 CVM 计算节点,请参见 资源管理。

关于部署推理服务时的详细配置,请参见 推理服务。