容器服务 GPU 虚拟化

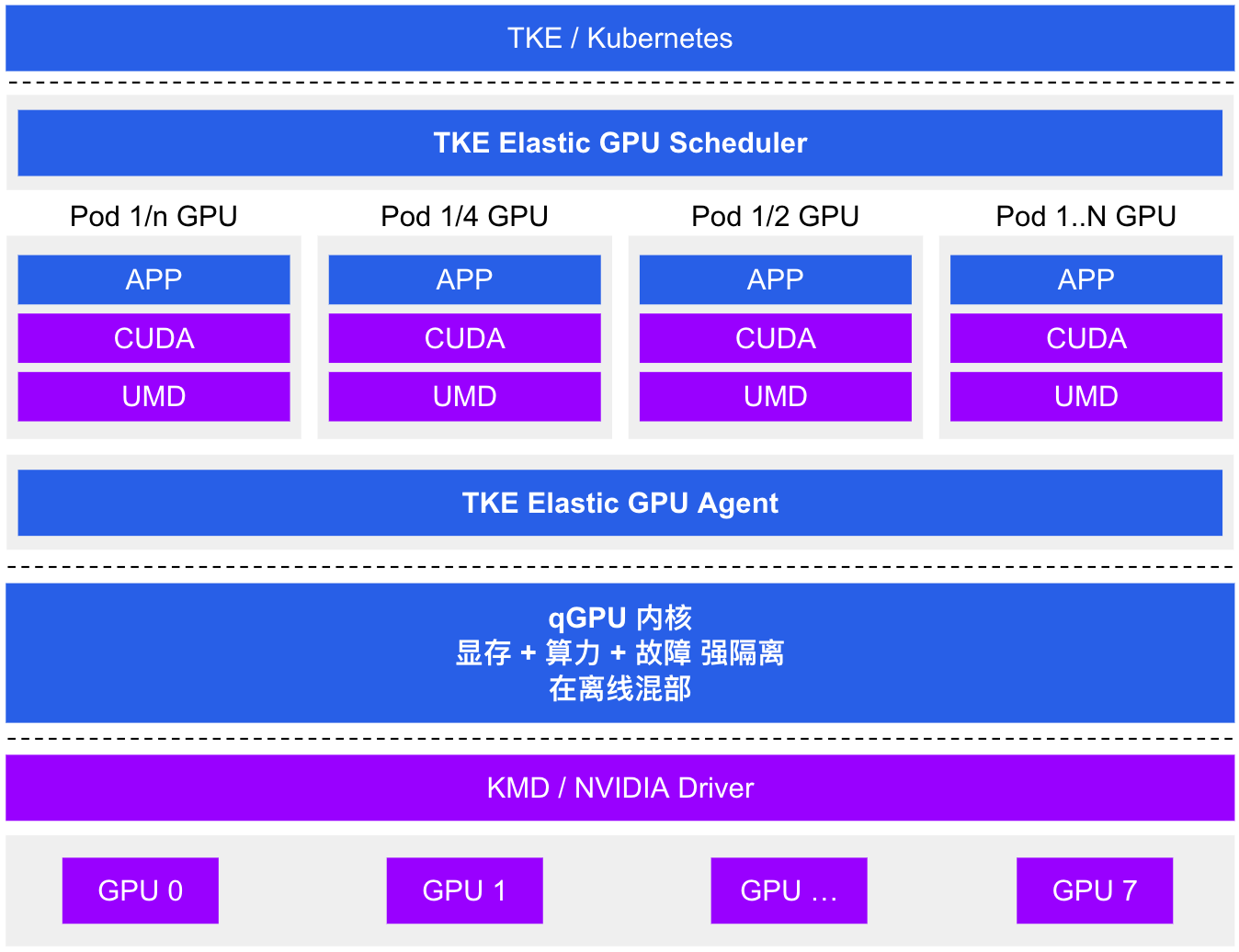

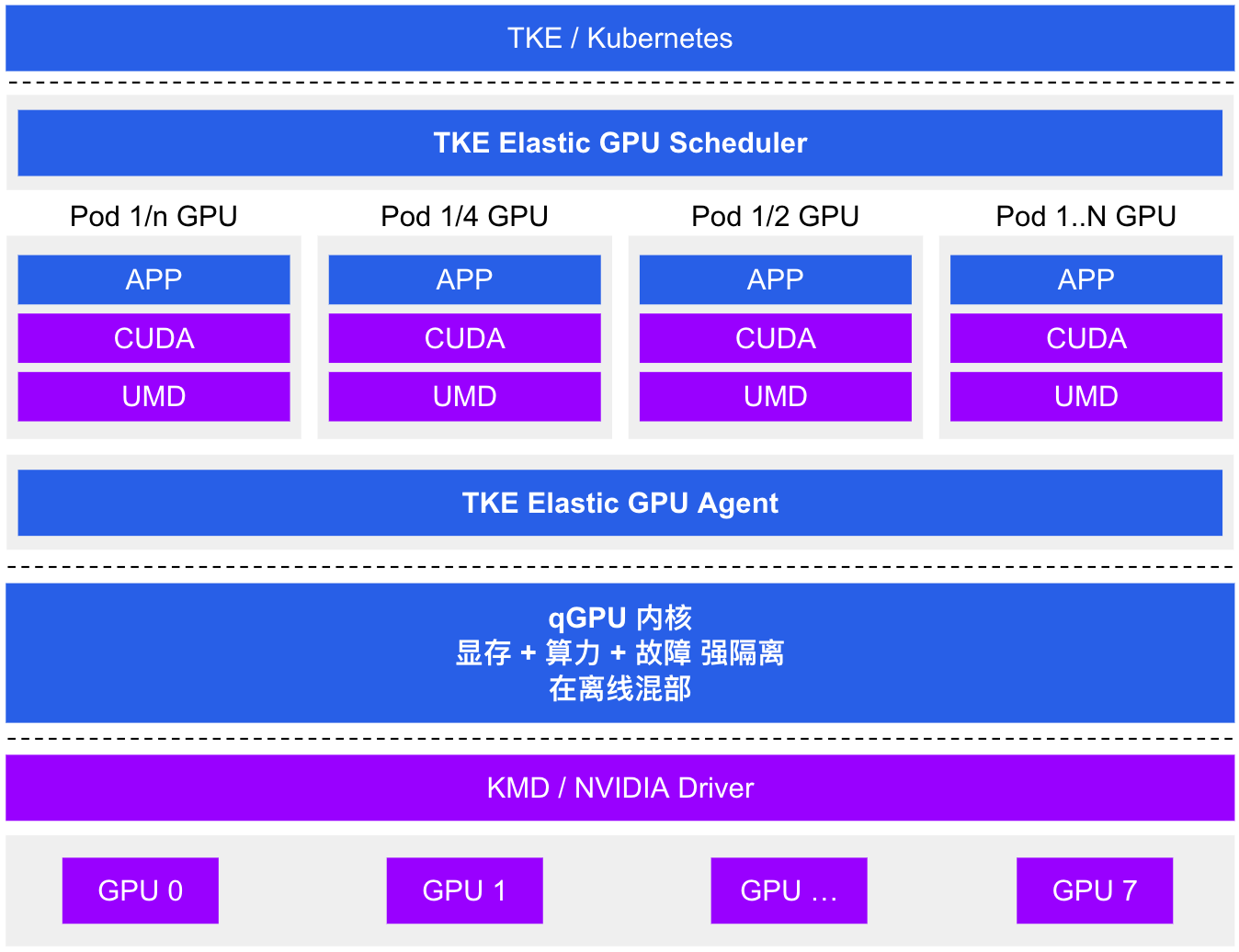

腾讯云 Tencent Kubernetes Engine qGPU 服务(以下简称 TKE qGPU)是腾讯云针对 原生节点 推出的 GPU 容器虚拟化产品,支持多个容器共享 GPU 卡并支持容器间算力和显存精细隔离,同时提供业界唯一的在离线混部能力,在精细切分 GPU 资源的基础上,在最大程度保证业务稳定的前提下,提高 GPU 使用率,帮助客户大幅度节约 GPU 资源成本。qGPU 依托 TKE 对外开源的 Elastic GPU 框架,可实现对 GPU 算力与显存的细粒度调度,并支持多容器共享 GPU 与多容器跨 GPU 资源分配。同时依赖底层强大的 qGPU 隔离技术,可做到 GPU 显存和算力的强隔离,在通过共享使用 GPU 的同时,尽量保证业务性能与资源不受干扰。

说明:

qGPU 功能仅针对 TKE 原生节点开放,其他节点类型不提供有效性服务保障。

方案框架图

产品优势

灵活性:精细配置 GPU 算力占比和显存大小。

强隔离:支持显存和算力的严格隔离。

在离线:支持业界唯一在离线混部能力,GPU 利用率压榨到最大化。

覆盖度:支持主流架构 Volta(如 V100 等)、Turing(如 T4 等)、Ampere(如 A100、A10 等)。

云原生:支持标准 Kubernetes 和 NVIDIA Docker。

兼容性:业务不重编、CUDA 库不替换、业务无感。