【每周CV论文推荐】初学动态模型压缩值得阅读的文章

欢迎来到《每周CV论文推荐》。在这个专栏里,还是本着有三AI一贯的原则,专注于让大家能够系统性完成学习,所以我们推荐的文章也必定是同一主题的。

动态模型压缩是一类比较新颖的模型设计与优化方法,通过对模型的设计,使其面对不同的样本或区域时表现出不同的结构,从而拥有更加高效的计算,在学术界研究非常广泛,本次我们来简单给大家推荐一些初入该领域值得阅读的工作。

作者&编辑 | 言有三

1 基于提前终止的框架

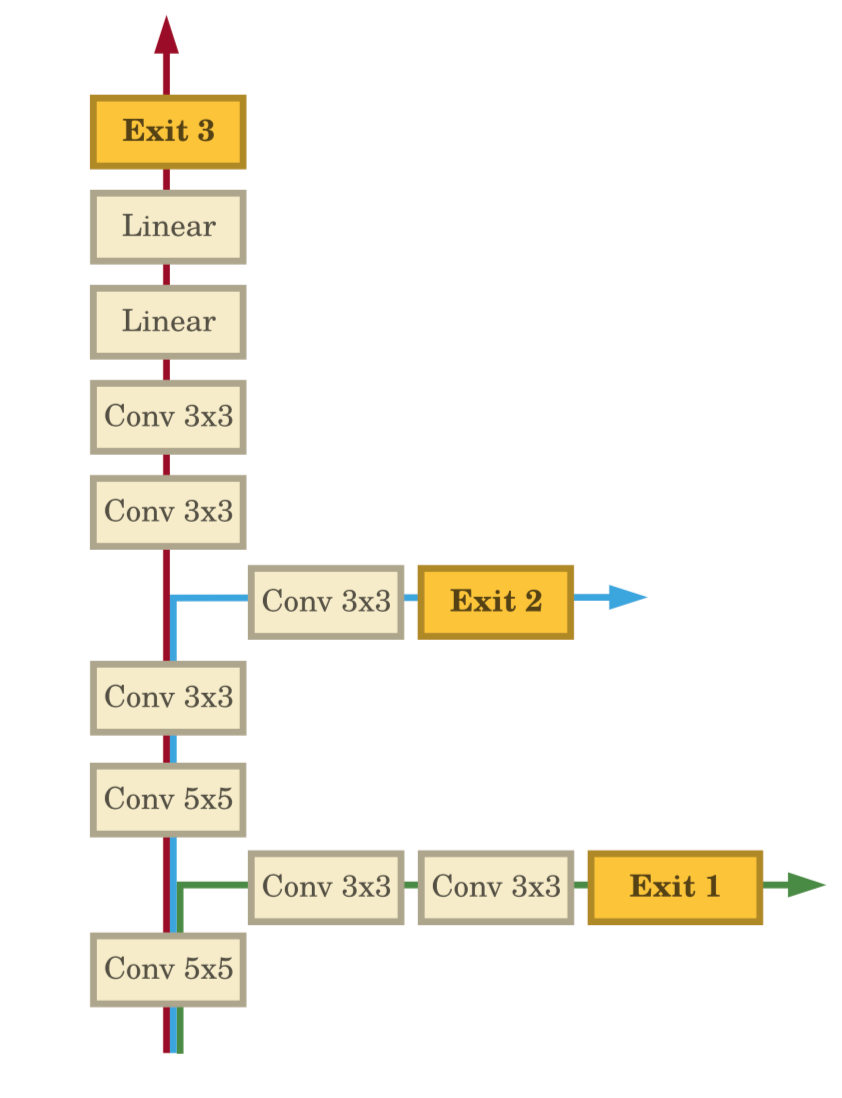

BranchyNet以非常简洁的形式实现了不同难度的样本在测试时运行不同网络的思想,它在正常网络通道上包含了多个旁路分支,这样的思想是基于观察到的现象,随着网络的加深,模型表征能力越来越强,大部分简单的图片可以在较浅层时学习到足以识别的特征,从而可以提前终止。

文章引用量:900+

推荐指数:✦✦✦✦✦

[1] Teerapittayanon S, McDanel B, Kung H T. Branchynet: Fast inference via early exiting from deep neural networks[C]//2016 23rd International Conference on Pattern Recognition (ICPR). IEEE, 2016: 2464-2469.

[2] Figurnov M, Collins M D, Zhu Y, et al. Spatially adaptive computation time for residual networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2017: 1039-1048.

2 基于模块跳过的框架

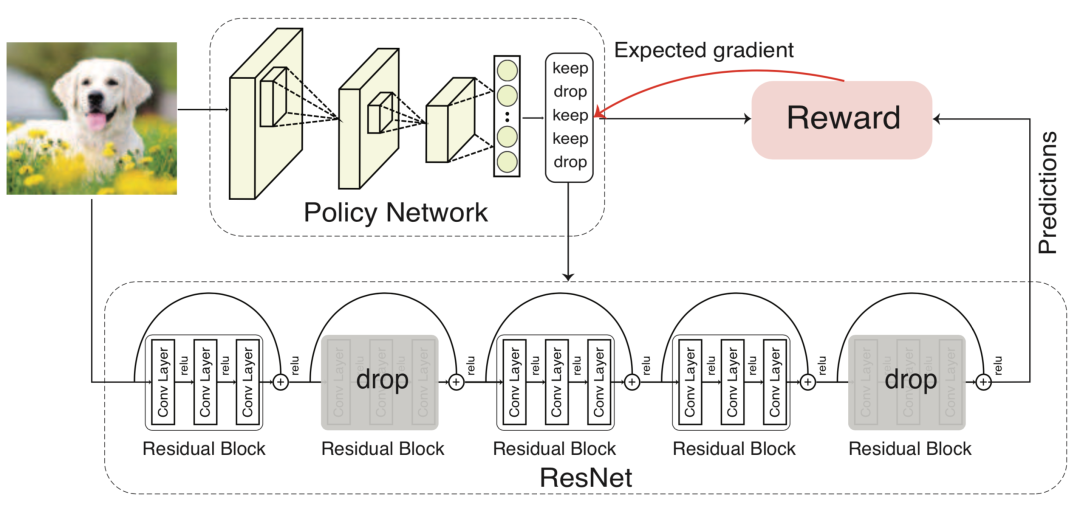

研究表明在训练时随机丢弃深度残差网络的一些残差模块,可以获得不同深度残差模型集成的效果,提高模型的泛化能力。Blockdrop框架基于这个思路,从数据中学习可以丢弃的残差模块,从而实现不同输入样本使用不同的计算。

文章引用量:800+

推荐指数:✦✦✦✦✦

[3] Wu Z, Nagarajan T, Kumar A, et al. Blockdrop: Dynamic inference paths in residual networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 8817-8826.

[4] Wang X, Yu F, Dou Z Y, et al. Skipnet: Learning dynamic routing in convolutional networks[C]//Proceedings of the European Conference on Computer Vision (ECCV). 2018: 409-424.

3 基于注意力的框架

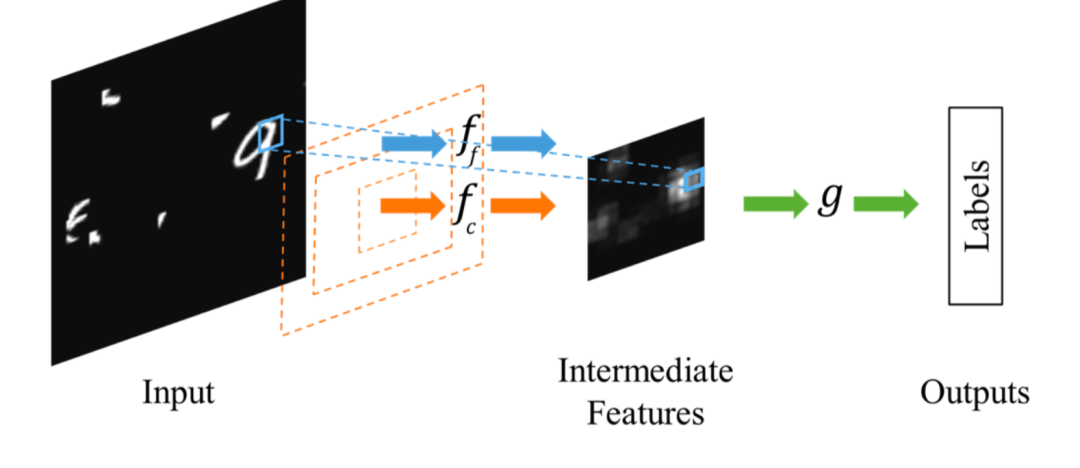

模型的计算量不仅与模型的参数量有关,也与输入数据的大小有关,如果能减小输入尺寸,降低空间维度,也可以减少计算量,Dynamic Capacity Networks就是这样的一个典型框架,通过注意力机制来选择跳过无关的背景,聚焦有意义的前景。

文章引用量:300+

推荐指数:✦✦✦✦✦

[5] Almahairi A, Ballas N, Cooijmans T, et al. Dynamic capacity networks[C]//International Conference on Machine Learning. PMLR, 2016: 2549-2558.

[6] Gao X, Zhao Y, Dudziak Ł, et al. Dynamic channel pruning: Feature boosting and suppression[J]. arXiv preprint arXiv:1810.05331, 2018.

4 与其他模型压缩方法的联系

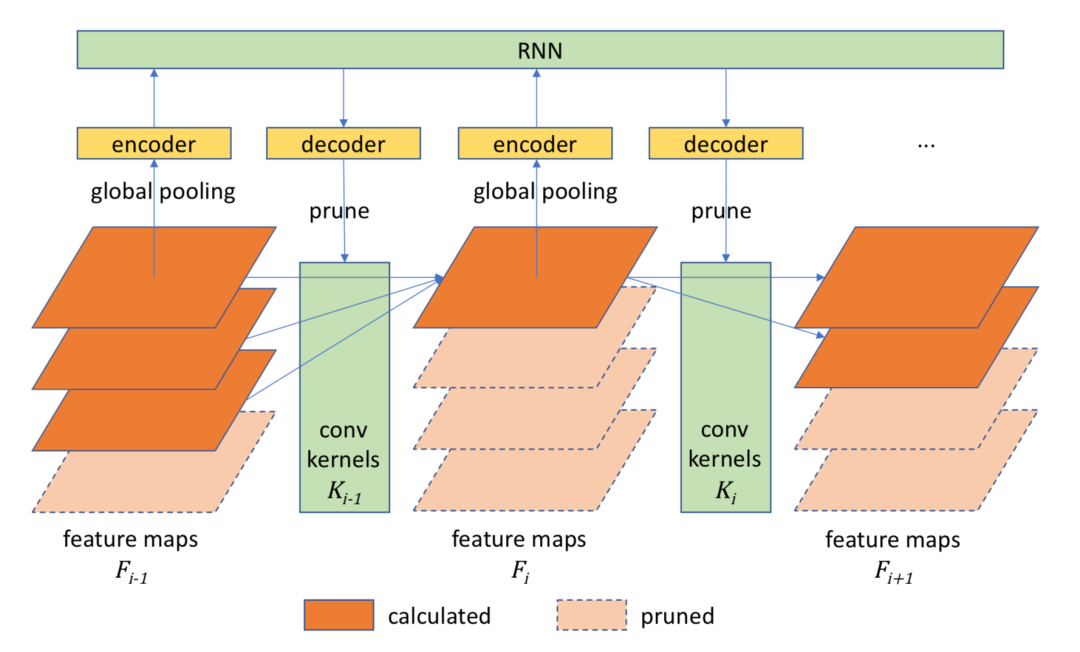

许多的模型压缩方法之间都存在联系甚至被联合使用来进一步获得计算效率更高的模型,动态模型的核心是为了动态自适应地降低模型推理过程中的计算量,这与自动化模型剪枝、自动化模型量化等技术其实是相通的。

文章引用量:500+

推荐指数:✦✦✦✦✧

[7] Lin J, Rao Y, Lu J, et al. Runtime Neural Pruning[C]. neural information processing systems, 2017: 2181-2191.

[8] Jin Q, Yang L, Liao Z. Adabits: Neural network quantization with adaptive bit-widths[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020: 2146-2156.

5 如何实战

为了帮助大家掌握模型优化压缩的相关知识!我们推出了相关的专栏课程《深度学习之模型优化:理论与实践》,讲解模型剪枝、模型量化、模型蒸馏等方向的理论与实践,感兴趣可以进一步阅读