【每周CV论文推荐】初学模型量化值得阅读的文章

欢迎来到《每周CV论文推荐》。在这个专栏里,还是本着有三AI一贯的原则,专注于让大家能够系统性完成学习,所以我们推荐的文章也必定是同一主题的。

模型量化是非常重要的模型压缩方法,在工业界应用非常广泛,本次我们来简单给大家推荐一些初入该领域值得阅读的工作。

作者&编辑 | 言有三

1 二值量化(1bit)

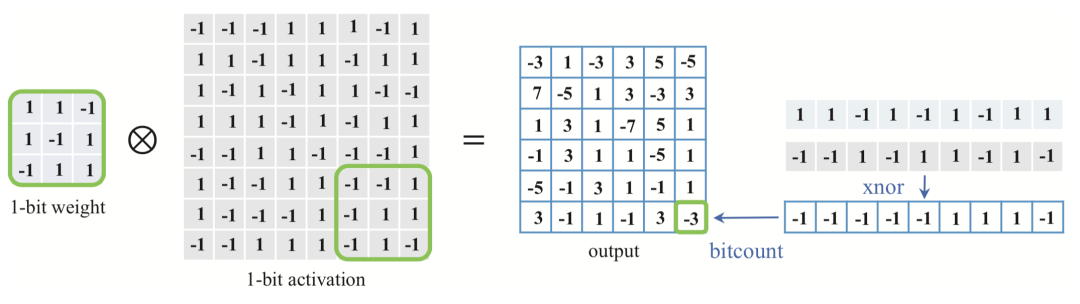

二值量化是最高效率的量化方式,也可以称之为1bit量化,即将32位浮点数量化为1bit整型,非常适合FPGA等平台进行并行运算,相比于32bit浮点数,内存使用量只有其1/32,而卷积中的复杂乘法也可以转换为异或与加法操作,因此在学术界和工业界都被广泛研究,甚至催生了不少专门的相关硬件设计工作。

文章引用量:10000+

推荐指数:✦✦✦✦✦

[1] Courbariaux M, Bengio Y, David J, et al. BinaryConnect: training deep neural networks with binary weights during propagations[C]. neural information processing systems, 2015: 3123-3131.

[2] Courbariaux M, Hubara I, Soudry D, et al. Binarized neural networks: Training deep neural networks with weights and activations constrained to+ 1 or-1[J]. arXiv preprint arXiv:1602.02830, 2016.

[3] Rastegari M, Ordonez V, Redmon J, et al. Xnor-net: Imagenet classification using binary convolutional neural networks[C]//European conference on computer vision. Springer, Cham, 2016: 525-542.

2 整型量化(8bit)

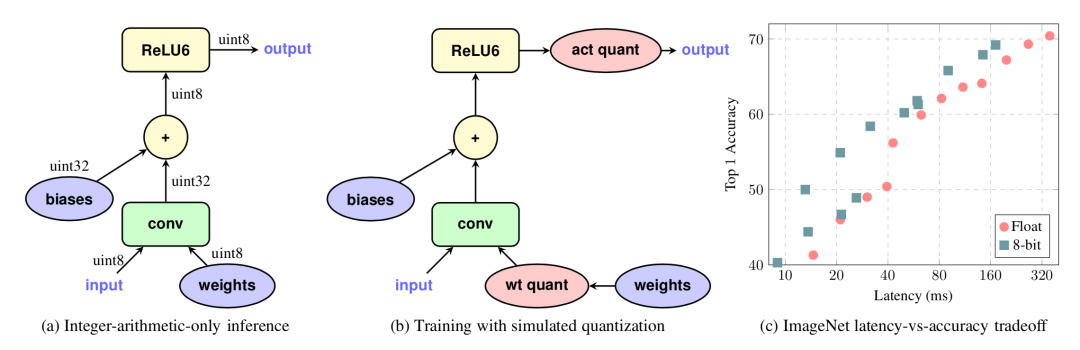

1bit虽然计算效率很高,但是对模型性能的损害还是非常大的,难以满足当前大部分工业界任务的要求。与之相比较,8bit网络能够取得较好的精度保持,是当前工业界比较成熟稳定的量化方案。目前以Tensorflow为代表的非对称量化方案和TensorRT为代表的对称量化方案是最常见的。

文章引用量:2000+

推荐指数:✦✦✦✦✦

[4] Krishnamoorthi R. Quantizing deep convolutional networks for efficient inference: A whitepaper[J]. arXiv preprint arXiv:1806.08342, 2018.

[5] Jacob B, Kligys S, Chen B, et al. Quantization and training of neural networks for efficient integer-arithmetic-only inference[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2018: 2704-2713.

[6] https://github.com/NVIDIA/TensorRT

3 任意bit量化

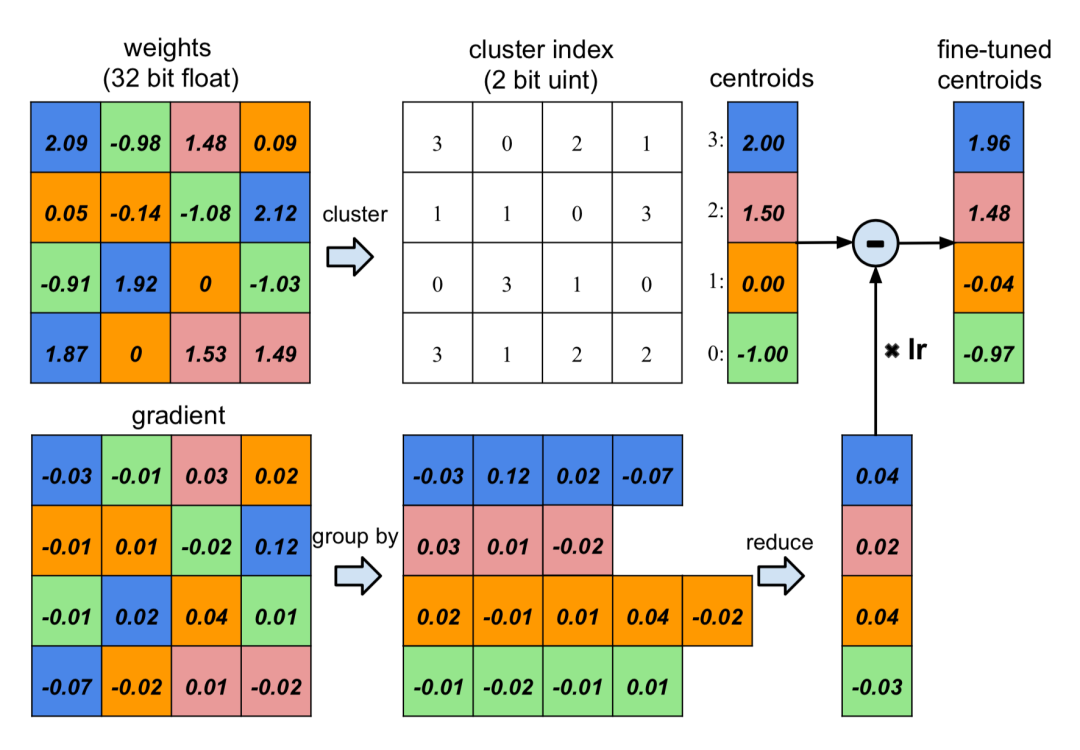

1bit量化是极致的量化方法,8bit量化是当前最流行的量化方案,不过量化位宽也不需要局限于1bit和8bit这两种,而是可以根据模型的特点与任务难度介于两者之间,早期的Deep Compression框架就是一个典型代表。

文章引用量:7000+

推荐指数:✦✦✦✦✦

[7] Han S, Mao H, Dally W J. Deep compression: Compressing deep neural networks with pruning, trained quantization and huffman coding[J]. arXiv preprint arXiv:1510.00149, 2015.

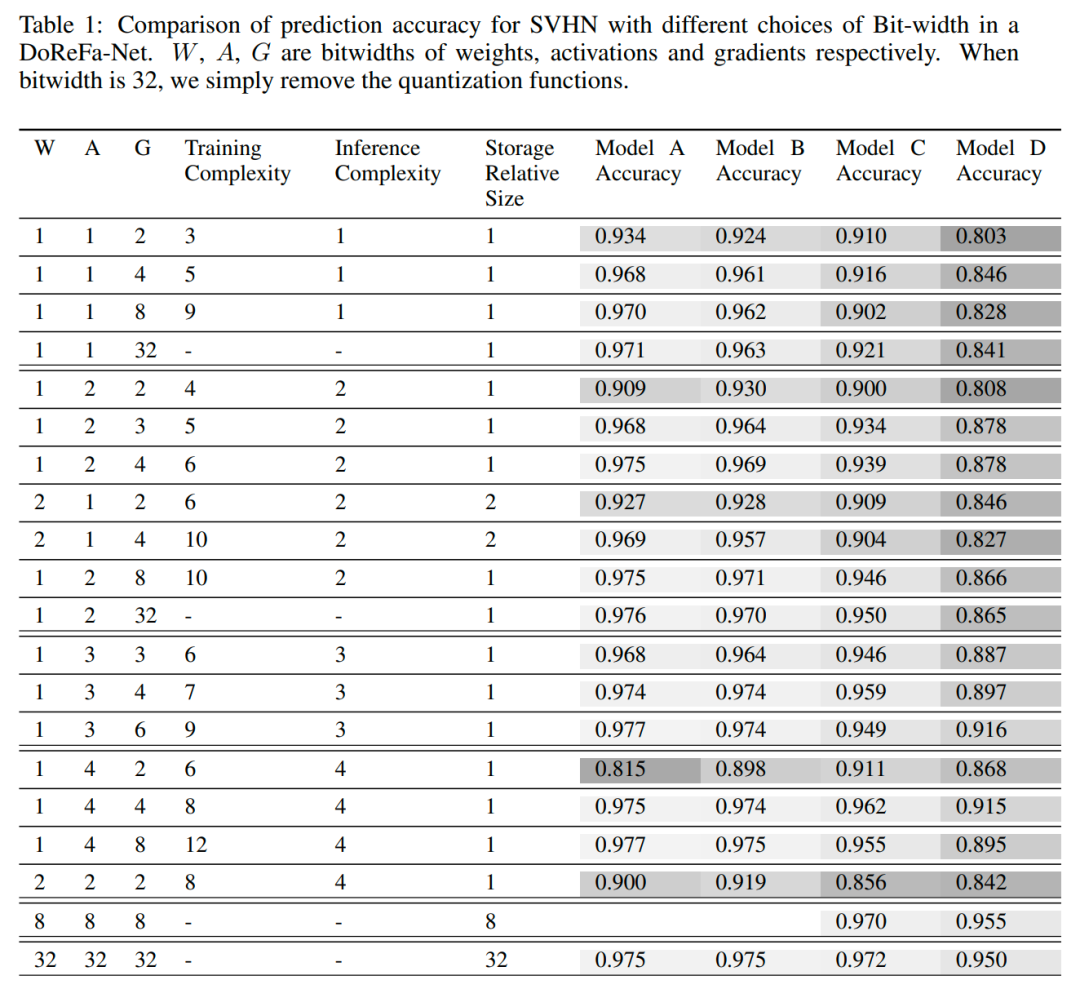

4 混合量化

所谓的混合精度量化,指的是不同的网络模块使用不同的量化位宽,或者不同的网络层使用不同的量化位宽,这是一种更加自由与个性化的量化方案,虽然实现起来更加复杂,但是在平衡模型复杂度与精度之间自有优势。

文章引用量:2000+

推荐指数:✦✦✦✦✦

[8] Hubara I, Courbariaux M, Soudry D, et al. Quantized neural networks: Training neural networks with low precision weights and activations[J]. The Journal of Machine Learning Research, 2017, 18(1): 6869-6898.

[9] Zhou S, Wu Y, Ni Z, et al. DoReFa-Net: Training Low Bitwidth Convolutional Neural Networks with Low Bitwidth Gradients[J]. arXiv: Neural and Evolutionary Computing, 2016.

5 如何实战

为了帮助大家掌握模型优化压缩的相关知识!我们推出了相关的专栏课程《深度学习之模型优化:理论与实践》,讲解模型剪枝、模型量化、模型蒸馏等方向的理论与实践,感兴趣可以进一步阅读:

【视频课】AI必学,超10小时,4大模块,掌握模型优化核心技术!

总结

本次我们介绍了模型量化的一些典型研究,从事相关方向的朋友可以通过阅读这些文章进行初步了解,模型量化是掌握模型压缩任务的必经之路。

有三AI- CV夏季划

如何系统性地从零进阶计算机视觉,永久系统性地跟随我们社区学习CV的相关内容,请关注有三AI-CV夏季划组,阅读了解下文:

【CV夏季划】2022年正式入夏,从理论到实践,如何系统性进阶CV?(产学研一体的超硬核培养方式)

转载文章请后台联系

侵权必究