在macos+ubuntu系统安装hadoop

原创Hadoop

分布式计算平台,核心是分布式文件系统HDFS

macos下

安装

下载地址:Index of apache-local/hadoop/core/hadoop-3.3.0

使用

进入目录~/tools/hadoop-3.3.0/etc/hadoop,做以下设置:

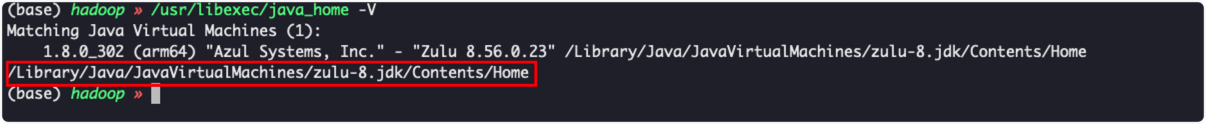

- 查看java_home:

img

img

- 打开hadoop-env.sh文件,增加JAVA的路径设置:

export JAVA_HOME=/Library/Java/JavaVirtualMachines/zulu-8.jdk/Contents/Home- 打开core-site.xml文件,将configuration节点改为如下内容,设置本地文件系统的端口和临时文件存储位置:

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>${user.home}/hadoop-tmp</value>

</property>- 打开hdfs-site.xml文件,将configuration节点改为如下内容,设置文件副本的数量:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>- 打开mapred-site.xml文件,将configuration节点改为如下内容,使用 YARN 作为 MapReduce 框架:

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>- 打开yarn-site.xml文件,将configuration节点改为如下内容:

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

</configuration>- 在目录hadoop-3.2.1/bin执行以下命令,初始化hdfs:

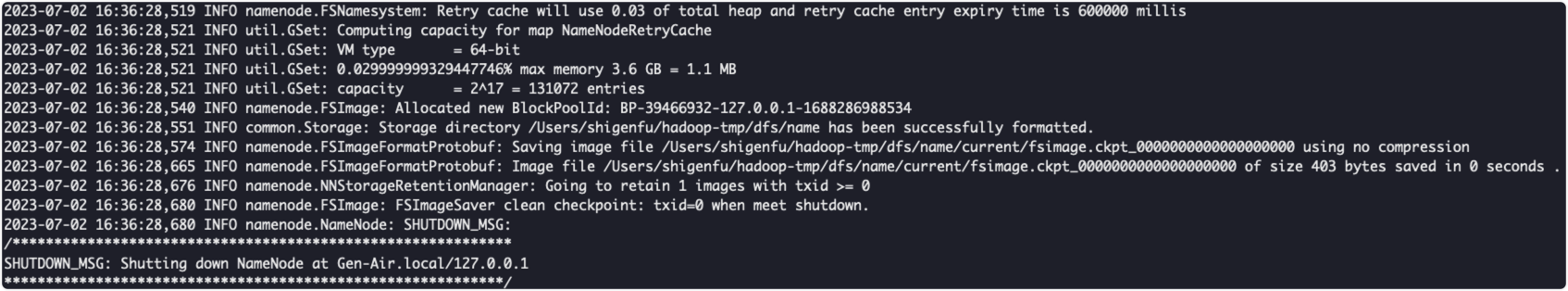

./hdfs namenode -format初始化成功后,可见如下信息:

img

启动

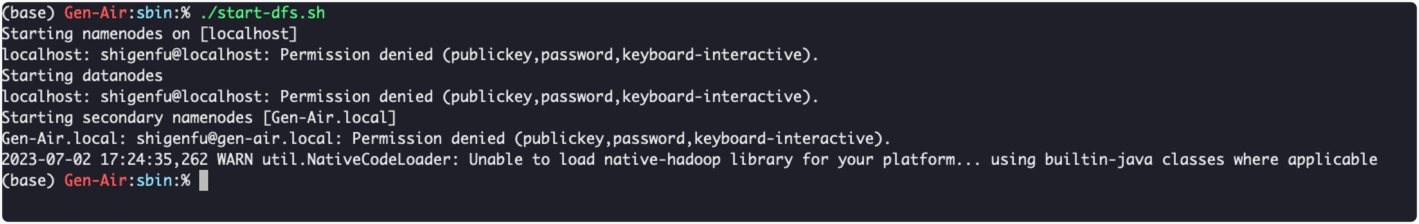

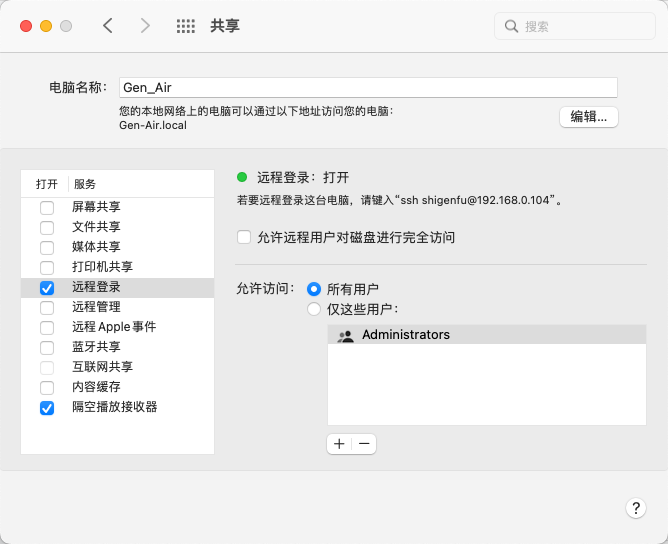

进入目录hadoop-3.2.1/sbin,执行./start-dfs.sh启动hdfs:

遇到了以下问题,我烦死了

img

img

所以,在我的mac上安装的计划彻底放弃了,正当我以为我再也安装不了handoop的时候,我再次找了很多的教程,失败了很多次,最终按照这个文章成功的实现了:Linux(阿里云)安装Hadoop(详细教程+避坑)阿里云hadoop飞川撸码的博客-CSDN博客

ubantu下

安装jdk

wget https://repo.huaweicloud.com/openjdk/18.0.1.1/openjdk-18.0.1.1_linux-aarch64_bin.tar.gz

tar -zxvf openjdk-18.0.1.1_linux-aarch64_bin.tar.gz

mv jdk-18.0.1.1/ /usr/java18

echo 'export JAVA_HOME=/usr/java18' >> /etc/profile

echo 'export PATH=$PATH:$JAVA_HOME/bin' >> /etc/profile

source /etc/profile

java -version这里手残选用了jdk18的版本,本来以为是jdk1.8的

安装hadoop

hadoop的安装包在清华云镜像下载的

tar -zxvf hadoop-3.3.4.tar.gz

ll

mv hadoop-3.3.4 /opt/hadoop

echo "export JAVA_HOME=/usr/java18" >> /opt/hadoop/etc/hadoop/yarn-env.sh

echo "export JAVA_HOME=/usr/java18" >> /opt/hadoop/etc/hadoop/hadoop-env.sh

hadoop version配置Hadoop

- 修改Hadoop配置文件 core-site.xml。

vim /opt/hadoop/etc/hadoop/core-site.xml在<configuration></configuration>节点内插入如下内容。

<property>

<name>hadoop.tmp.dir</name>

<value>file:/opt/hadoop/tmp</value>

<description>location to store temporary files</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>- 修改Hadoop配置文件 hdfs-site.xml。

vim /opt/hadoop/etc/hadoop/hdfs-site.xml在<configuration></configuration>节点内插入如下内容。

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/opt/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/opt/hadoop/tmp/dfs/data</value>

</property>配置SSH免密登录

执行以下命令,创建公钥和私钥。

ssh-keygen -t rsa将公钥添加到authorized_keys文件中。

cd ~

cd .ssh

cat id_rsa.pub >> authorized_keys将hadoop添加到环境变量中。

vi /etc/profile

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

source /etc/profile启动Hadoop

- 初始化**namenode**

hadoop namenode -format- 启动**Hadoop**

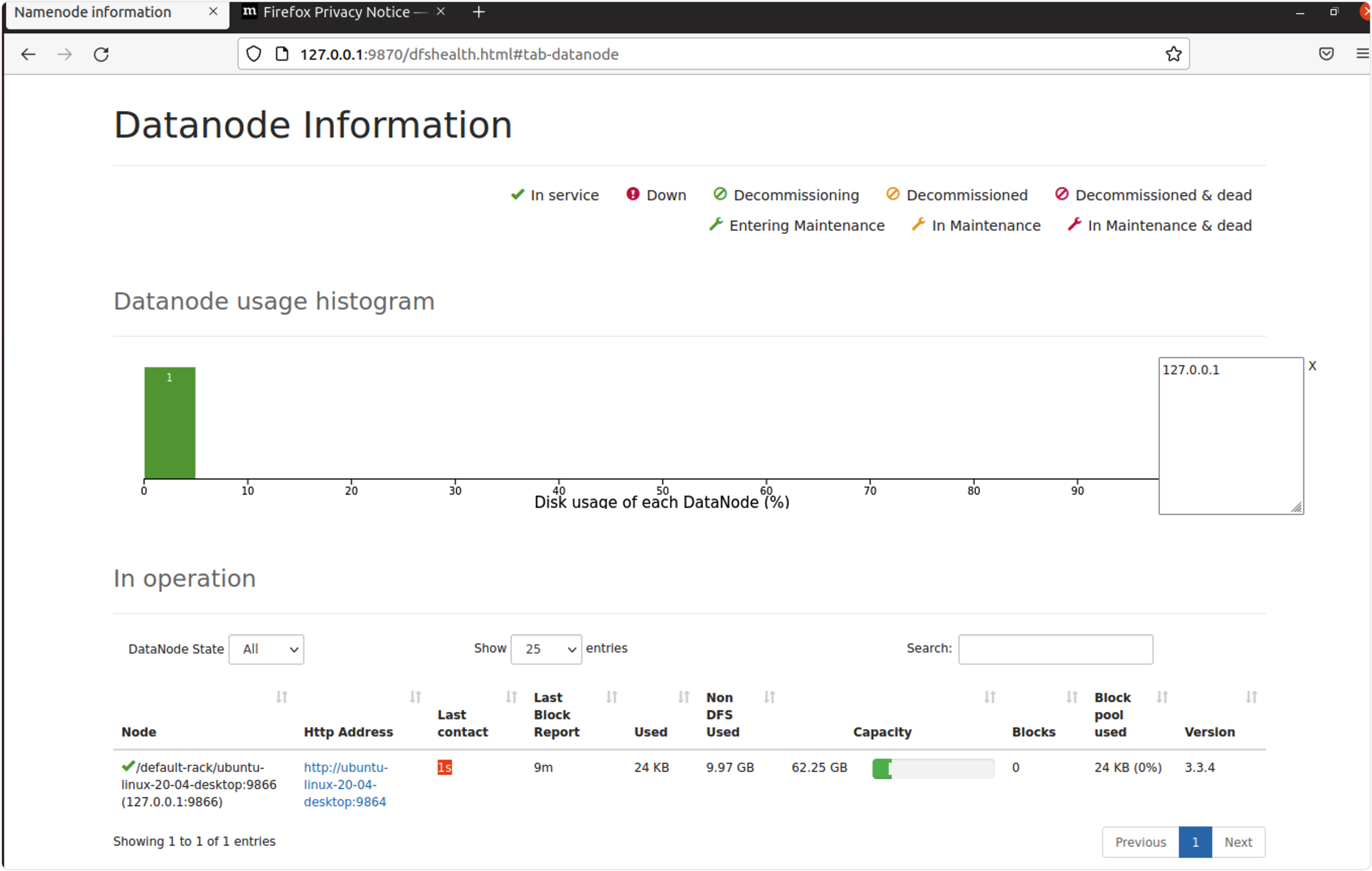

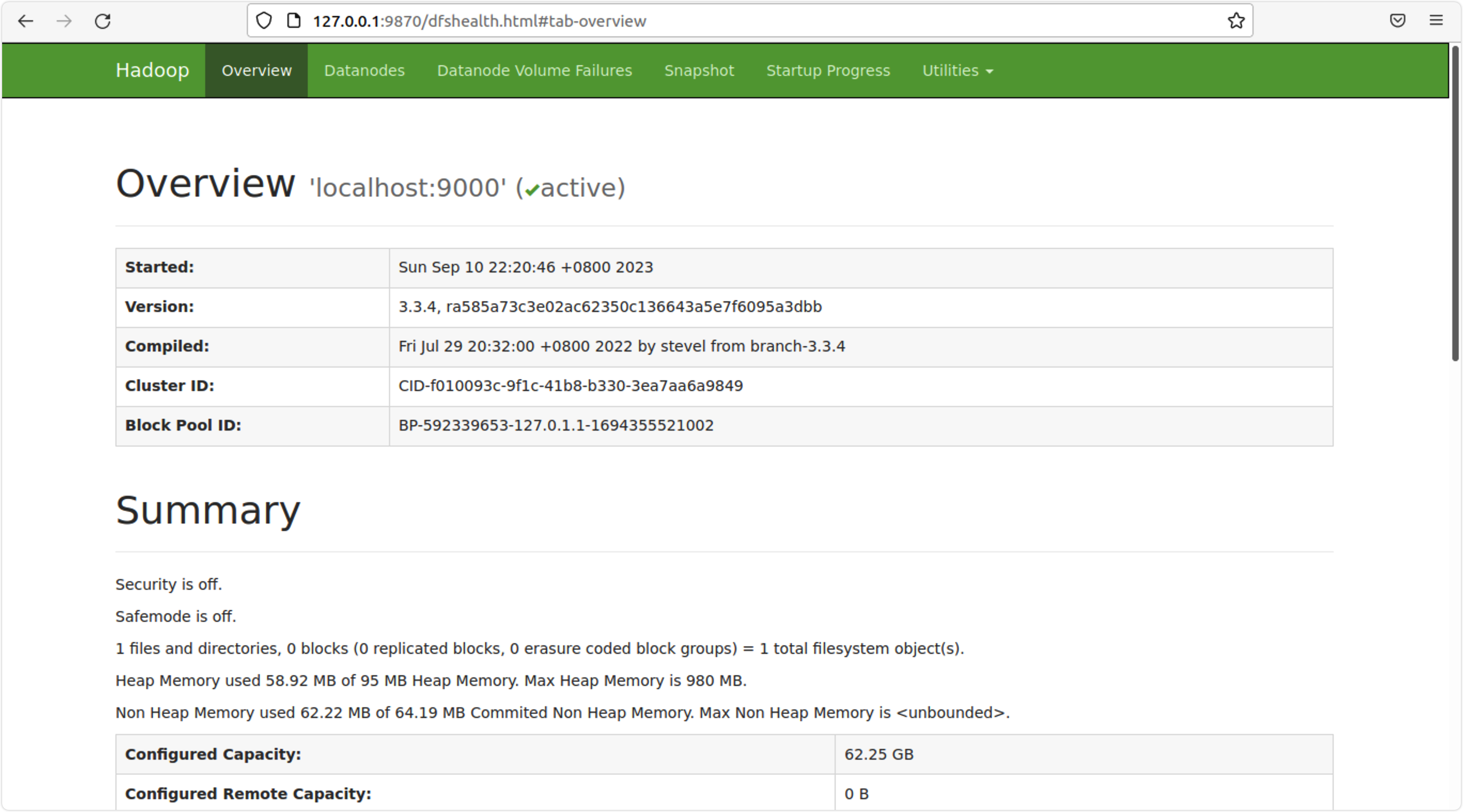

start-dfs.sh可以看到的web页面:

img

img

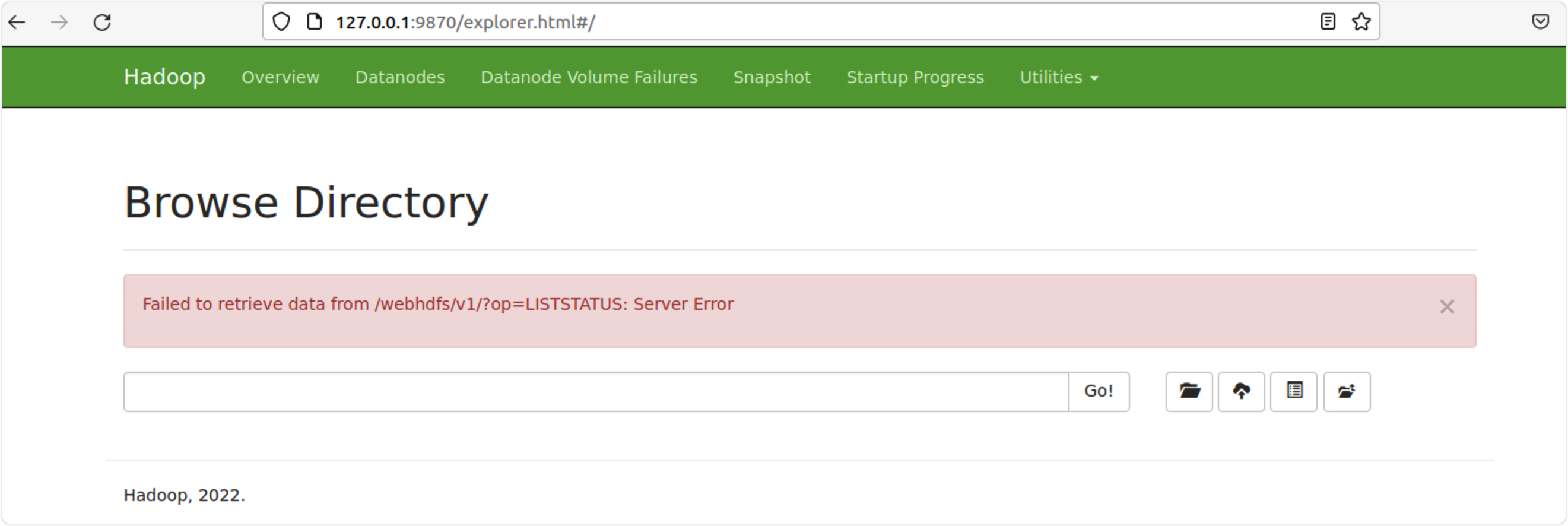

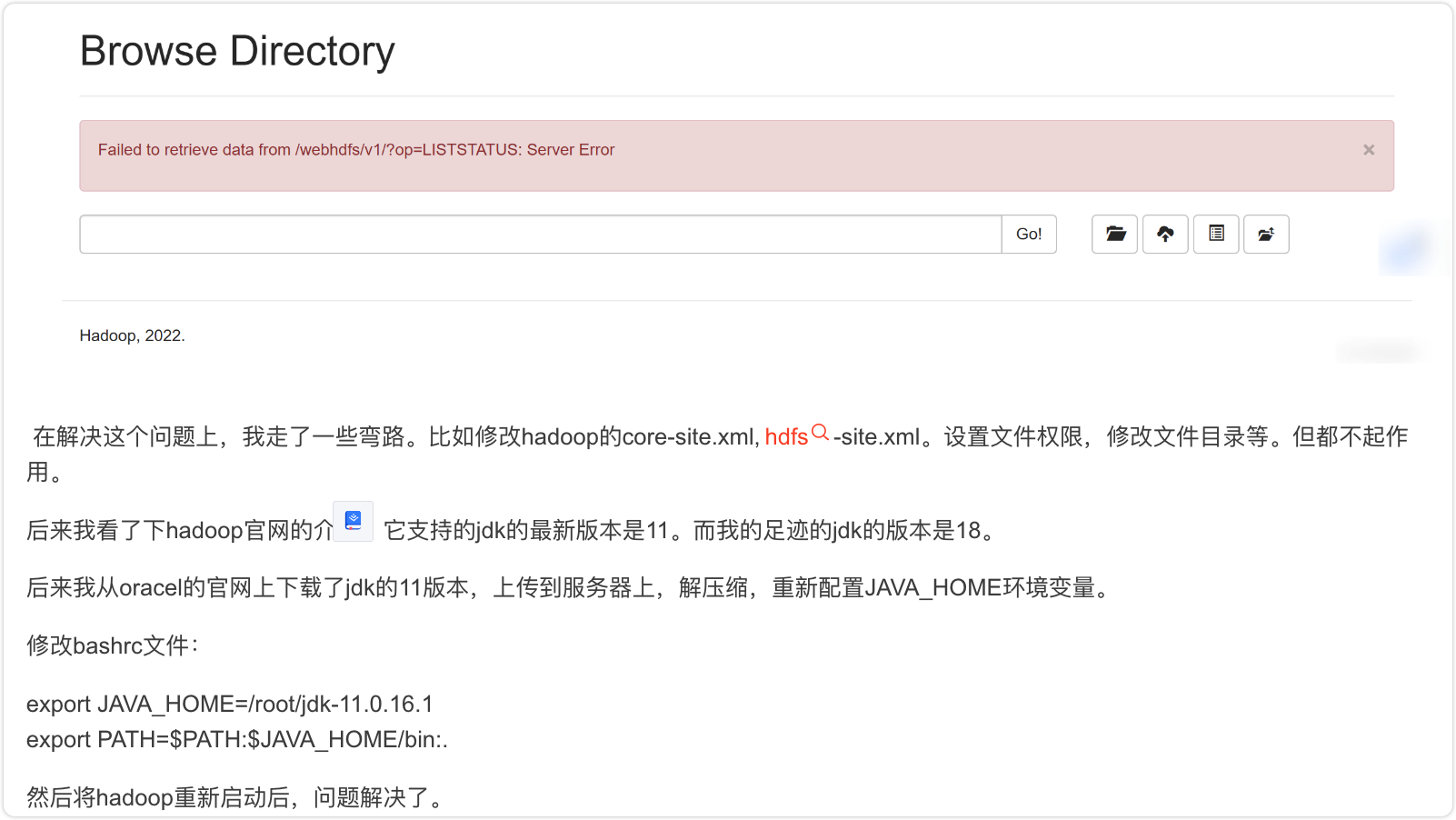

查看文件列表的时候出现了如下问题:

img

解决的方案:降低jdk的版本。

img

以上就是安装hadoop的全部过程,推荐第二种安装方式。

与**shigen**一起,每天不一样!

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读