AI与人类联手,智能排序人类决策:RLHF标注工具打造协同标注新纪元,重塑AI训练体验

原创AI与人类联手,智能排序人类决策:RLHF标注工具打造协同标注新纪元,重塑AI训练体验

原创

汀丶人工智能

发布于 2024-02-27 14:08:54

发布于 2024-02-27 14:08:54

文章被收录于专栏:NLP/KG

AI与人类联手,智能排序人类决策:RLHF标注工具打造协同标注新纪元,重塑AI训练体验

在大模型训练的 RLHF 阶段,需要人工对模型生成的多份数据进行标注排序,然而目前缺乏开源可用的 RLHF 标注平台。

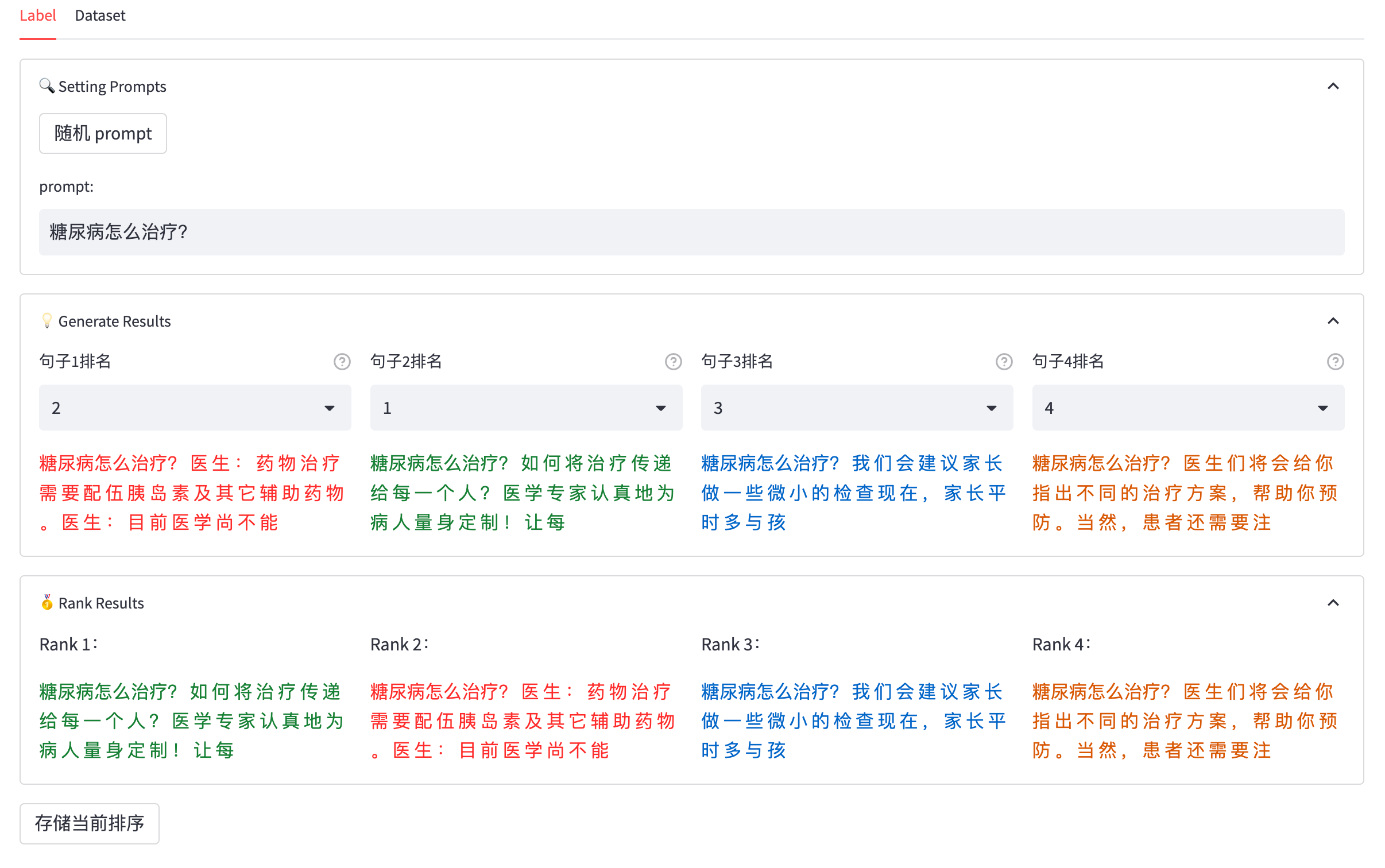

RLHF 标注工具 是一个简单易用的,可以在大模型进行 RLHF(基于人类反馈的强化学习)标注排序的工具,旨在帮助用户在友好的图形界面中对生成式模型生成的答案进行排序标注。

- 工具特点

- RLHF助力者:强调工具在大模型训练中的重要性,特别是在RLHF阶段。

- 智慧融合引擎:展示AI与人类智慧结合的创新点。

- 生成式模型助手:突出工具在生成式模型训练流程中的支持作用。

- 排序标注利器:直接描述工具的核心功能,即帮助用户对答案进行排序和标注。

- 友好界面体验:强调工具用户界面的友好性和易用性。

- 开源创新平台:突出工具的开源特性,鼓励用户参与和贡献。

- 功能点

- 提供界面展示当前的查询问题和历史对话

- 支持为生成的答案选择排名

- 可以自定义回答个数 K,默认为 4

- 自动检测和提示排名冲突

- 将标注的排序结果追加保存到数据集文件中

- 提供数据集页面以查看已标注的数据

- 更多功能点

- 实现 RLAIF ,基于 API 进行自动标注

- 支持拖动排序

- 效果展示:

1. 快速开始

- 安装依赖

- Python 3.x

- 安装依赖包:

pip install -r requirements.txt

- 使用说明

- 准备数据集文件:将包含查询问题、历史对话和生成的答案的数据集文件准备为 JSON 格式,格式参见 input_file.json。 对于 RLHF 数据的生成,直接对同一份模型运行 K 次即可。由于大模型的随机性,每次生成的答案都会不同。

- 运行应用:执行

bash run.sh命令启动应用。 - 标注排序:在标注页面,依次为每个查询问题的生成答案选择排名,并点击“存储当前排序”按钮保存标注结果。

- 查看数据集:在数据集页面,可以查看已标注的数据集,包括查询问题、历史对话和生成的答案的排序结果。

- 配置

应用支持一些配置选项,可在

app.py文件中进行修改:MODEL_CONFIG:模型配置,包括模型名称、设备、数据集文件路径等。RANK_COLOR:排名颜色列表,用于在界面中显示不同排名的颜色。

2.示例数据集

您可以使用以下 JSON 数据集示例进行测试:

{

"0": {

"query": "非常感谢您的建议,我会尽量按照您的建议来做。谢谢!",

"history": [],

"response_0": "不客气,我很高兴能够帮助到您。如果您还有其他问题,随时可以向我咨询。祝您好运!",

"response_1": "不客气,我很高兴能够帮助您。如果您还有其他问题,随时都可以向我咨询。祝您好运!",

"response_2": "不客气,我很高兴能够帮助您。如果您有任何其他问题,随时都可以向我咨询。祝您好运!",

"response_3": "不客气,我很高兴能够帮助到您。如果您还有其他问题,随时可以向我咨询。祝您好运!"

},

...

}更多优质内容请关注公号:汀丶人工智能;会提供一些相关的资源和优质文章,免费获取阅读。

更多资料下载见:https://blog.csdn.net/sinat_39620217/article/details/136317936

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录