ChatGLM2-6B和ChatGLM-6B:开源双语对话模型,探索无限对话可能!

ChatGLM2-6B和ChatGLM-6B:开源双语对话模型,探索无限对话可能!

猫头虎

发布于 2024-04-08 17:34:02

发布于 2024-04-08 17:34:02

ChatGLM2-6B和ChatGLM-6B:开创双语对话生成新时代

摘要:

本文介绍了ChatGLM2-6B和ChatGLM-6B这两个开源的中英双语对话模型,它们由清华大学的KEG和数据挖掘小组(THUDM)开发和发布。这两个模型是基于GLM模型的混合目标函数,在1.4万亿中英文tokens数据集上进行训练,并实现了模型对齐。本文将探讨它们的优势、应用场景、训练数据集来源以及如何使用它们进行对话生成和微调。

引言:

自然语言处理的发展日新月异,ChatGLM2-6B和ChatGLM-6B作为中英双语对话模型引起了广泛关注。它们在对话生成领域表现优异,为人机交互带来了新的可能性。本文将深入探讨这两个模型的特点和应用价值,帮助CSDN用户了解如何应用它们,并探索如何微调以满足特定需求。

ChatGLM2-6B和ChatGLM-6B 中英双语对话模型有哪些应用场景?

ChatGLM2-6B和ChatGLM-6B是多功能的中英双语对话模型,为多种应用场景提供了强大的支持:

- 聊天机器人:可用于构建各类聊天机器人,涵盖娱乐、教育、咨询、客服等领域,为用户提供人性化、有趣和实用的对话服务。

- 对话生成:可用于生成各类风格和主题的对话文本,如小说、剧本、故事等,为创作者提供灵感和素材。

- 对话分析:可用于对话语义、情感、逻辑和一致性等方面进行分析,评估对话质量并进行改进。

- 对话问答:可用于基于给定文档或知识库进行对话式问答,提供信息检索和知识获取能力。

- 对话教学:可用于辅助语言学习和教学,为学习者提供多语言、多场景的交流和练习机会。

除上述场景外,ChatGLM2-6B和ChatGLM-6B还可以广泛应用于其他需要自然语言交互的领域,拥有较强的通用性和适应性。

ChatGLM2-6B和ChatGLM-6B的优缺点有哪些?

ChatGLM2-6B和ChatGLM-6B具有一系列优势和限制,总结如下:

优点:

- 支持中英双语:两个模型均可进行中英文对话和互译,提供多语言交流能力。

- 性能强大:在多项对话任务中,ChatGLM2-6B和ChatGLM-6B都有高准确度和流畅度,生成自然、有趣和实用的对话回复。

- 资源占用低:采用了Multi-Query Attention和INT4量化等技术,降低了显存占用和推理时间,提高了效率和便捷性。

- 上下文长度长:引入FlashAttention技术,支持32K的上下文长度,可进行多轮对话和读取更长文档进行相关提取和问答。

缺点:

- 模型尺寸相对较小:与某些针对特定领域或任务的模型相比,ChatGLM2-6B和ChatGLM-6B的模型尺寸较小(6B),限制了复杂推理和泛化能力。

- 易被误导:模型受概率随机性因素影响,输出内容准确性无法完全保证,易受到误导。需进行安全评估和备案,防止可能带来的危害。

- 商用授权不明确:ChatGLM2-6B虽允许申请商用授权,但商用条件和收费信息尚不明确;ChatGLM-6B完全禁止商用。

ChatGLM2-6B和ChatGLM-6B的训练数据集主要有哪些?

ChatGLM2-6B和ChatGLM-6B的训练数据集包括以下几个主要部分:

- 中英文通用语料:如维基百科、CommonCrawl、OpenWebText、BookCorpus等,大规模中英文文本数据,用于预训练GLM模型。

- 中英文对话语料:如LCCC、Weibo、Douban、Reddit、Twitter等,多来源的中英文对话数据,用于微调GLM模型。

- 人类反馈数据:包含人类评价和偏好的数据,用于对齐训练GLM模型。

- 自定义数据集:用户可根据需要构建自己的JSON格式数据集,用于P-Tuning微调ChatGLM2-6B或ChatGLM-6B模型。

数据集来源:

这些数据集来自不同的资源,具体如下:

- 中文对话数据集:豆瓣多轮对话、小黄

鸡对话、微博对话、电商对话等,可在相关链接1进行下载。 2. 中文问答数据集:百度知道、知乎问答、搜狗问答等,可在相关链接2进行下载。 3. 英文对话数据集:Reddit对话、Twitter对话、Persona-Chat等,可在相关链接3进行下载。 4. 英文问答数据集:SQuAD、TriviaQA、Natural Questions等,可在相关链接查找并下载。 5. 中英双语数据集:WMT新闻翻译、UN Parallel Corpus等,可在相关链接查找并下载。

数据集的版权归属可能不同,使用时需遵守相应的协议和规定。

如何下载这些数据集?

部分数据集可直接下载,部分需要申请或注册,具体步骤如下:

- 中文对话数据集:豆瓣多轮对话、小黄鸡对话、微博对话、电商对话等,可在相关链接1找到下载链接。

- 中文问答数据集:百度知道、知乎问答、搜狗问答等,可在相关链接2找到下载链接。

- 英文对话数据集:Reddit对话、Twitter对话、Persona-Chat等,可在相关链接3找到下载链接。

- 英文问答数据集:SQuAD、TriviaQA、Natural Questions等,可在相关链接查找并下载。

- 中英双语数据集:WMT新闻翻译、UN Parallel Corpus等,可在相关链接查找并下载。

这些数据集的版权归属谁?

数据集的版权归属可能不同,需查看每个数据集的发布方和协议。通常,一些数据集是完全开源的,可自由使用和修改,而另一些数据集可能有限制,需要申请或遵守特定规则。例如:

- 中文对话数据集:豆瓣多轮对话、小黄鸡对话、微博对话、电商对话等,来源于公开网站,版权归原作者所有,使用时需注明出处和引用。

- 中文问答数据集:百度知道、知乎问答、搜狗问答等,来源于公开网站,版权归原作者所有,使用时需注明出处和引用。

- 英文对话数据集:Reddit对话、Twitter对话、Persona-Chat等,来源于公开网站或研究机构,版权归原作者或发布方所有,使用时需遵守相应协议。

- 英文问答数据集:SQuAD、TriviaQA、Natural Questions等,由研究机构发布,版权归发布方所有,使用时需遵守相应协议。

- 中英双语数据集:WMT新闻翻译、UN Parallel Corpus等,由研究机构发布,版权归发布方所有,使用时需遵守相应协议。

如何使用这两个模型进行对话生成?

使用ChatGLM2-6B和ChatGLM-6B进行对话生成的方法有以下几种:

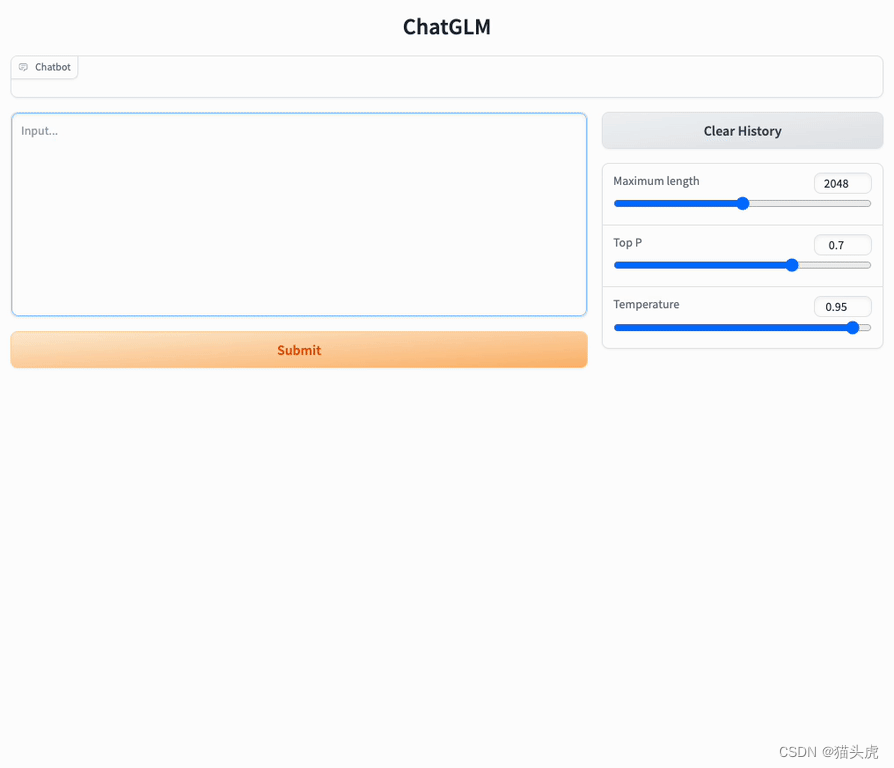

- 使用HuggingFace的pipeline:通过调用HuggingFace的pipeline接口,加载ChatGLM2-6B或ChatGLM-6B模型,输入对话文本,即可得到对话回复。

- 使用HuggingFace的model和tokenizer:通过调用HuggingFace的model和tokenizer接口,

加载ChatGLM2-6B或ChatGLM-6B模型和分词器,对输入文本进行编码,使用模型进行生成,再对输出文本进行解码。 3. 使用官方提供的demo或代码:参考官方提供的demo或代码,运行相关的脚本或命令,加载ChatGLM2-6B或ChatGLM-6B模型,输入对话文本,得到对话回复。

如何微调这两个模型以适应特定领域或任务?

对ChatGLM2-6B和ChatGLM-6B进行微调以适应特定领域或任务的方法有以下几种:

- 使用P-Tuning v2方法:官方推荐的微调方法,通过添加可学习的软提示(soft prompts)来调整模型行为,无需改变模型参数。包括准备自定义数据集、修改微调脚本参数,然后运行微调和评估脚本。

- 使用QLoRA方法:一种基于量化低秩矩阵分解的微调方法,可以在保持模型精度的同时降低模型尺寸和显存占用。包括安装QLoRA库、准备自定义数据集、修改相关参数,然后运行微调和推理脚本。

以上方法可根据具体需求选择适合的微调策略,使模型适应特定领域或任务的要求。

结论:

ChatGLM2-6B和ChatGLM-6B是具有巨大潜力的中英双语对话模型,经过1.4万亿中英文tokens数据集的训练,它们能够生成流畅、自然、有趣和有用的对话回复。在各项对话任务中,ChatGLM2-6B表现优异,性能提升显著,尤其在数学任务上,性能提高了571%。它们支持更长的上下文长度和更高效的推理,具有广泛的应用场景,可用于构建聊天机器人、对话生成、对话分析、对话问答等,同时也是研究和教育的强大工具。

总结:

ChatGLM2-6B和ChatGLM-6B代表了对话生成领域的重要进步,提供了高效、低成本、多语言、多场景的对话生成平台。它们的优势在于支持中英双语、性能强大、资源占用低、上下文长度长,但需要注意模型尺寸较小和易被误导的缺点。对这两个模型进行微调以适应特定领域或任务,可以进一步挖掘它们的潜力。ChatGLM2-6B和ChatGLM-6B的开源和商用授权政策也值得注意,选择合适的授权方式有助于充分利用它们的优势。让我们拥抱这两个强大的对话模型,一同探索无限的对话可能!

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2024-04-07,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录