详细介绍NVIDIA Jetson产品

本文整理自NVIDIA 2024 GTC讲座。

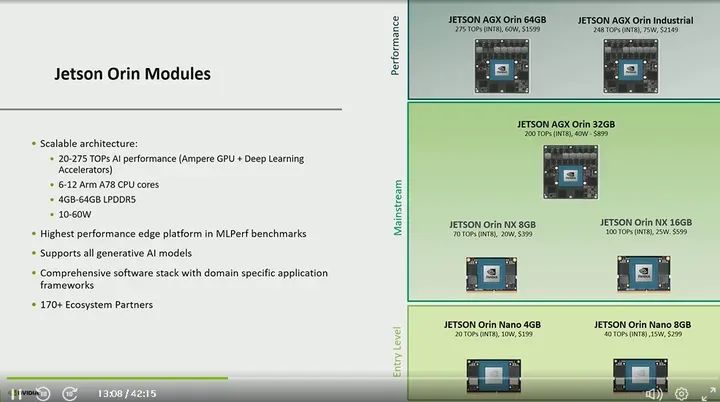

现在让我们深入了解我们的Jetson平台。这些是我们的Jetson Orin模块,我们有七种不同的模块,涵盖了从入门级到高性能的整个系列。最棒的是,与以往不同的是,我们在整个产品系列上首次采用了一种SOC(片上系统)架构。从入门级到高性能,全部都是基于同一架构,这也使得产品更加可扩展和易于从一个模块转移到另一个模块。

那么这种架构里面包含了什么呢?Orin SOC包含了一颗安培GPU和一颗Arm A78 CPU,某些模块还包含特定的加速器。我们有深度学习加速器、可编程视觉加速器、视频图像合成器。不用担心,我会在接下来的幻灯片中详细介绍这些加速器的作用。

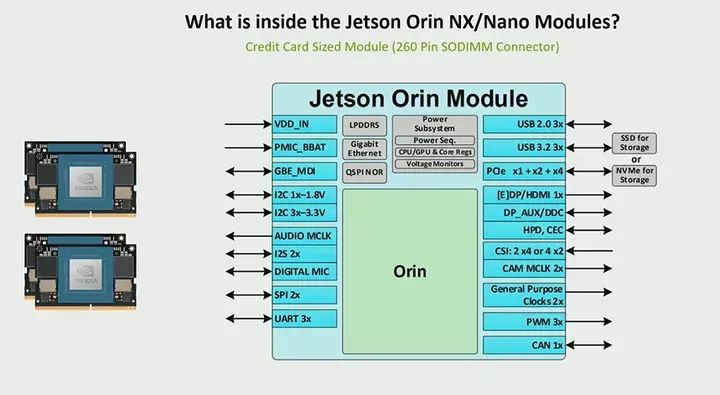

还有两种不同的形态因素。如果你看到这张幻灯片的顶部,我们有一个较大的100x87毫米的尺寸 ,也有信用卡尺寸的模块。更棒的是,从Orin nano到Orin NX,这些模块的形态因素和引脚兼容,这意味着你可以用一个载板来支持这四个模块中的任何一个。同样,对于AGX Orin和AGX Orin Industrial,它们也是一种形态因素和引脚兼容的,因此你可以用一个载板来支持所有这四个模块。

关于它们的差异,它们都是基于同一SOC架构的。然而,它们在GPU核心数量、CPU核心数量、一些加速器以及IO方面有不同的组成。因此,较小的SoDIMM有特定的IO,我将在几张幻灯片中介绍,而AGX Orin具有十千兆以太网,高达22条PCIe通道,以及一些其他的IO,我将在接下来的内容中介绍。

那么你如何决定哪个模块适合你的应用呢?这实际上取决于一些关键问题。Jetson被设计用于传感器融合和聚合。首先,你要连接到设备上的是什么类型的传感器?其次,你的工作负载是什么样子的?你试图运行一些生成式人工智能吗?你试图进行一些计算机视觉吗?你打算在设备上部署什么,这实际上可以定义你的计算需求。因此,从Orin nano的20到40 TOPS的性能范围到AGX Orin的最高275 TOPS的性能,根据你的工作量大小,这些设备中的任何一个都可以满足你的需求。

我们经常被问到的另一件事是,你的尺寸或功耗需求是多少,这就是为什么我们也有很多不同的模块,这样你就可以拥有一个符合要求的解决方案。你会看到Orin nano的功耗预算为10到15瓦,而AGX Orin可达60瓦。例如,你可能有一个功耗非常重要的无人机应用,那么Orin nano或Orin NX在考虑到功耗、重量、尺寸的情况下都可能对你有所帮助。而对于需要一些较大生成式AI模型的AGX Orin来说,额外的计算资源是可用的。我想强调的另一件事是,我们不仅拥有这些不同的模块,还在软件方面进行了大量的性能优化。对于那些不熟悉的人,我们有一个叫做mlperf的东西,这是一个标准组织,负责运行一套机器学习基准测试。从我们以前的一代Jetson AGX Xavier到我们最新的一代Jetson Orin,我们不仅在计算方面进行了优化,而且在模型方面也处于领先地位,我们能够在Jetson上运行所有的机器学习模型。

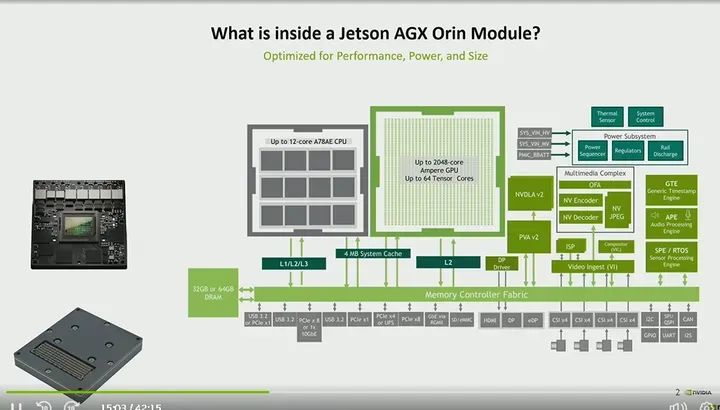

那么Jetson AGX Orin系列究竟包含了什么?Jetson AGX Orin模块采用了100x87毫米的外形。我想指出的一件事是,这张图表显示了模块上的SOC以及一些其他组件,但没有显示出TTP,这样你就可以看到模块内部的情况。但是,我们的AGX Orin模块实际上配备了所谓的热传递板。这使得您可以非常容易地在其上开发热解决方案,因为大多数的热要求都由该TTP处理。在模块的底部,您可以看到一个699引脚连接器。因此,您基本上会将此模块连接到一个载板上,在我们的开发套件中,实际上是带有一个载板加上模块再加上一个散热器,这样您就可以立即开始使用了。模块内部还有什么?所以我们在上文中提到,在Orin中有一颗安培GPU,在AGX Orin中,它有高达2048个核心和高达64个张量核心。在CPU方面,它的核心数量在Orin系列中是从8到12不等,然后还有一些加速器。有一个可编程视觉加速器,可以用于运行计算机视觉算法。有一个深度学习加速器,这样您就可以运行GPU上的深度学习算法,释放出GPU和CPU来进行更多的计算密集型任务。从多媒体复合体来看,有一个光流加速器,可以卸载光流以及一些立体视差的需求,还有AJPEG,以及一个编码器和解码器,具体取决于您对编码和解码一些相机流的要求。这张幻灯片上展示了很多内容,但我想要强调所有的模块,这样你就知道架构内部具体包含了什么。

我想要谈论的另一件事是,Orin具有共享内存。所以你可以看到内存控制器结构,所有的CPU、GPU都使用同一架构。现在在幻灯片底部的灰色区域,您可以看到所有不同的IO,从高速IO方面来看,我们支持P C I E,还有万兆以太网,还有支持US B 3.2 A,从显示方面来看,有HDMI和DP,有高达16条CSI通道,还有很多传感器IO,比如I2C、CAN、GPIO等等。

与AGX Orin相比,Orin NX模块内部有什么不同呢?主要区别在于架构、GPU核心数量、CPU核心数量以及加速器。因此,Orin NX模块配备了深度学习和视觉加速器,而Orin Nano模块则没有。从IO的角度来看,因为Orin Nano采用了一种260引脚SoDIMM形态因素,所以有一些不同的PCIe通道数量以及其他IO,你可以在这里看到。因此,它将继续支持PCIe、传感器IO、USB、ACSI等。最棒的是,Orin Nano和Orin NX在形态因素和引脚上是兼容的,这意味着你可以用一个载板来支持它们中的所有一个。

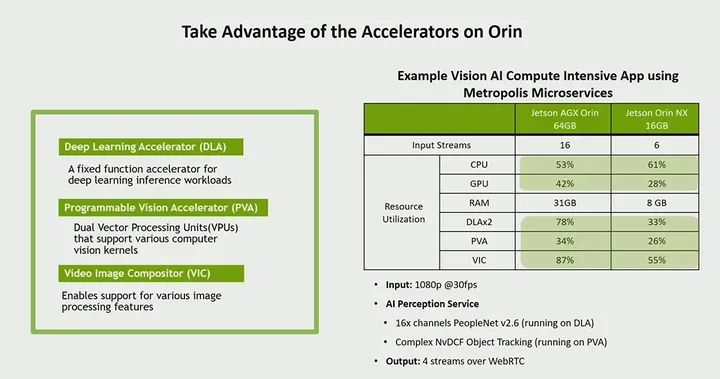

那么,我之前提到的一些加速器是什么呢?在这里,你可以看到我们有深度学习加速器,这是一个固定功能的加速器,可以用于运行一些深度学习工作负载,我们有各种文档,说明可以将哪些层移植到这个深度学习加速器上,这对于那些需要大量人工智能并希望将其卸载以便GPU具有更多计算资源的用例非常理想。同样,可编程视觉加速器也可以用于使用,我将在幻灯片的右侧讲解一个示例,展示我们如何使用一些加速器来进行这种卸载。所以,这个PVA,这些是双向矢量处理单元,可以支持一些计算机视觉算法,然后还有一个视频图像合成器,用于某些图像处理功能。在之前的图表中也显示了一个ISP。那么使用这些加速器的一个例子是什么呢?这实际上是从我之前提到的我们的Metropolis微服务中取出的一个示例,这是一组API,我们帮助优化了各种视觉AI管线。因此,在这里,我们采用了一个非常计算密集型的应用程序,并将其分布在GPU、CPU以及加速器上。因此,如果你看这里,因为我们已经将该应用程序分布在不同的处理器上,你会释放出GPU和CPU,它们在AGX上仅使用了大约50%,在Orin NX上GPU仅使用了30%,在CPU上使用了60%。因此,这确实为你留下了很大的余地,可以运行其他应用程序,同时还可以在一些加速器上运行这个视觉AI应用程序。那么这里究竟运行了什么?基本上运行的是一个人员检测模型的十六个通道,还进行了复杂对象跟踪。因此,其输出是四个流,输入是1080p30。因此你可以看到,如果利用这些加速器,你确实可以卸载部分计算,从而释放GPU和CPU。

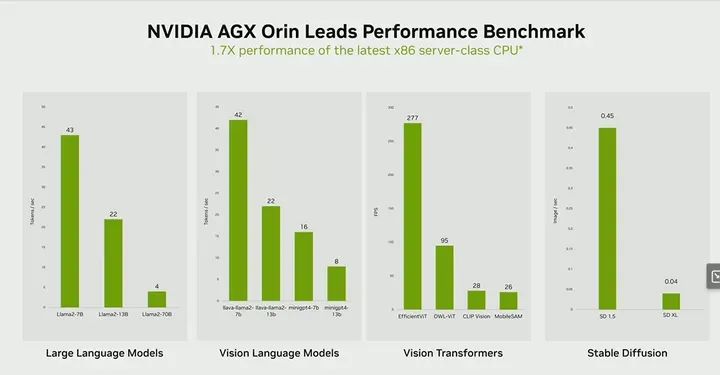

让我们再谈一下一些生成式人工智能,以及如何将生成式人工智能带到边缘。在这里,你可以看到我们的NVIDIA AGX Orin以及一些在AGX Orin上运行的各种生成式人工智能模型。通常,生成式人工智能模型以其庞大的体积和对大量内存的需求而闻名。但是,通过我们能够进行的优化,我们实际上能够在边缘运行这些模型,这确实是我们解决方案的一个独特价值主张。你可以看到这里的大型语言模型,使用常见的Llama2 7B,我们能够实现每秒43个Token。同样,对于一些视觉语言模型,我们能够在Llama2 7B上实现42个,然后在13B上实现22个。转到一些视觉Transformer模型,有一些像我们的Vision Transformer以及Mobile Sam、Efficient VIT等等。我们能够实现非常高的吞吐量,你可以看到Efficient VIT的每秒帧数是277帧,将其放入透视中,通常30帧每秒是实时帧率,所以我们能够在这些模型上实现实时帧率,有些甚至更快。此外,从Stable difussion的角度来看,从每秒图像的角度来看,我们也能够取得一些出色的表现。

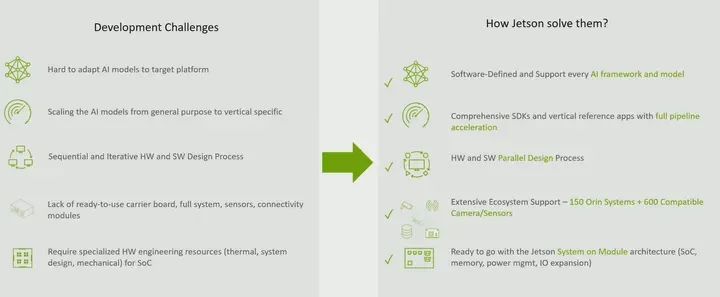

人们面临的一些挑战以及Jetson如何解决这些挑战呢?首先是模型难以适应。我们看到,并不是每个人都有很强的深度学习专业知识,因此能够支持各种类型的模型并能够对其进行调整、优化是非常重要的,这也是我们专注于成为这种软件定义平台的原因。

我们支持各种类型的模型和框架,包括Transformer模型,这在边缘平台中是非常罕见的。另一个问题是,有时人们有不同的垂直领域的需求。我们谈论了很多这些应用,比如IVA以及机器人技术,除了运行基本计算之外,在应用层面还有不同的需求,我们有解决方案,无论是我们的Isaac Perceptor还是我们的Isaac ROS,或者在视觉方面,我们有Metropolis微服务。您可以使用我们的解决方案运行完整的端到端管道。

我们刚才谈到的另一点是,我们的开发套件允许您不必进行顺序开发周期。您可以并行进行开发。您的软件团队和硬件团队都可以共同开发解决方案。

另一个问题是,在完成开发后如何开始?这就是我们的合作伙伴生态系统发挥作用的地方。他们提供载板、完整系统以及传感器、摄像头,并且他们与Jetson进行了广泛的开发,这样可以加快您的上市时间。最后,定制硬件设计资源。有时,如果您看一下完整的嵌入式系统,您会发现电源架构和内存架构在开发的角度会花费很多时间。但也会在板子上占用很多空间。因为我们有独特的模块化架构,它消除了这种复杂性。您不必担心内存,也不必担心电源设计。您所要做的就是使用这个即插即用的模块来轻松开发您的解决方案。

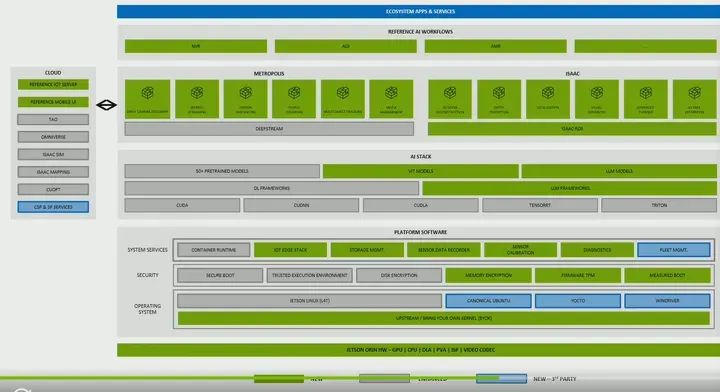

Jetson是一个软件定义的平台。我们着重于为您提供不仅是硬件,而且是完整的端到端解决方案。所以你会在这张幻灯片的底部看到,我们展示了我们的硬件,而在这之上,我们有我们的平台软件,其中包括您的基本Linux操作系统以及安全性以及一些系统服务。在这之上,我们有我们的AI堆栈,您可以利用NVIDIA正在进行的许多其他工作,这些工作现在可以在边缘运行。所以无论您正在做什么,您现在也可以在边缘运行。然后在这之上,您有您的垂直特定的需求,无论是Metropolis用于智能视频分析还是Isaac用于机器人技术。我们有各种API可以帮助加速您的开发。

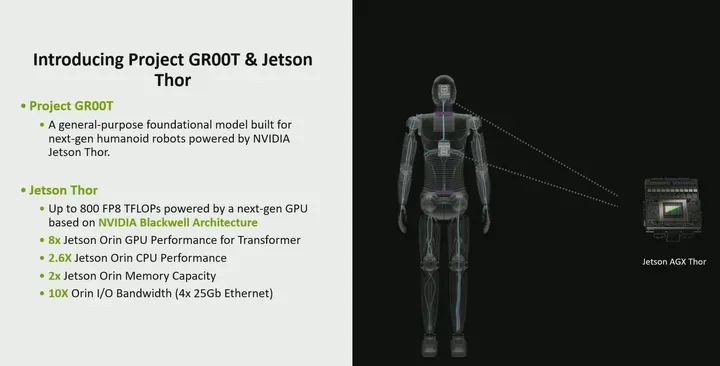

GROOT项目是一个通用的基础模型,专为下一代人形机器人打造。正如我们在开头所说的,我们确实看到人形机器人的需求大幅增长。因此,需要更多的计算能力以及更定制化的软件,您可以通过在机器人面前做动作,从文本和语音以及一般动作的角度来训练人形机器人。您可以使用其中一个生成式AI模型来训练机器人。因此,我们有了我们的Jetson Thor,

Jetson Thor提供了比Jetson Orin高8倍的性能,最高可达800 TFLOPS。这是如何可能的呢?这是因为我们有了一个新的下一代GPU架构,它是基于Blackwell的,同时也包括了Transformer引擎。我们不仅从GPU的角度进行了增加,还从CPU的角度进行了增加,CPU性能最高提升了2.6倍。从内存的角度来看,我们将DRAM容量翻了一番,现在最高可达128GB。然后从I/O带宽的角度来看,我们真正看到了需要在内存、计算和I/O之间取得平衡的变化,所以现在有了Jetson Thor,我们提高了计算能力,所以显然也需要提高I/O。因此,我们将带来比现在多10倍的I/O带宽,最高可达4x25Gb以太网。

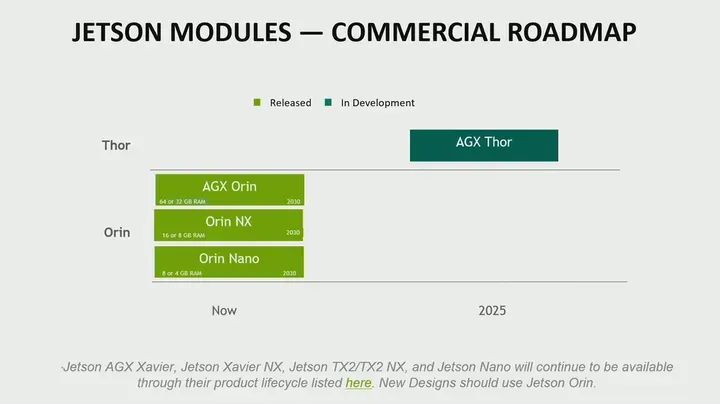

关于我们的路线图,我们的Orin模组件是商业模组。它们有一个七年的生命周期,所以这些将在2030年之前可用。我们的工业模块有一个十年的生命周期,所以将在2033年之前可用。您可以看到AGX Thor,它将在2025年可用。我想指出的是,我们的其他模块,如Jetson AGX Xavier TX2和nano,将继续在其产品生命周期内提供。但对于任何新设计,我们真的建议您考虑我们的Jetson Orin,因为我之前提到的所有软件解决方案,我们将继续添加和增强它们,并专注于Jetson Orin。