数分实战篇:爬虫、SQL存取、结巴分词、词云制作

数分实战篇:爬虫、SQL存取、结巴分词、词云制作

herain

发布于 2024-11-23 10:24:11

发布于 2024-11-23 10:24:11

代码可运行

运行总次数:0

代码可运行

本文是一篇技术实战的记录:使用Python 爬取 豆瓣书评,结构化存取Mysql数据,并通过jieba分词 剥离书评关键词,基于词频制作词云图,让数据可视化。 是经典常用的数据分析路径,希望能够帮助热爱数据分析的同学们!

引用Python包列表如下:

import pymysql

from urllib import parse

import json

import time

import requests

import re

import jieba

import jieba.analyse

import csv

from bs4 import BeautifulSoup

import numpy as np

from PIL import Image

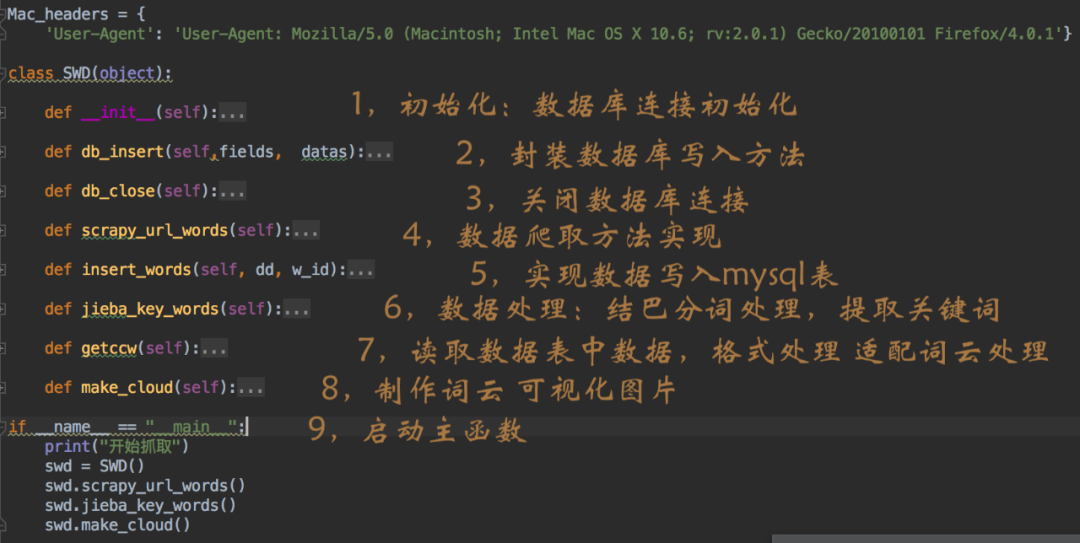

import matplotlib.pyplot as pltPython 程序代码:类/对象/方法结构:

Python程序执行流:

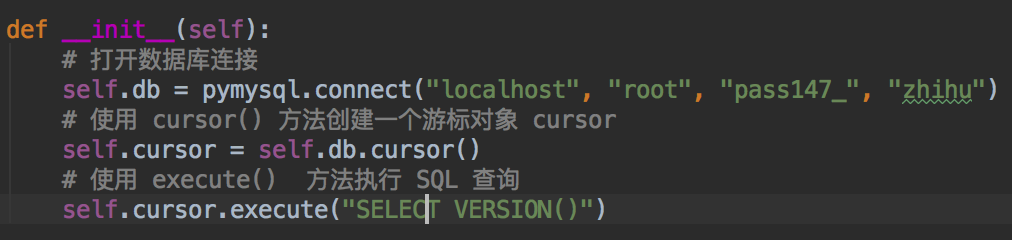

第一步:SWD对象实例化,通过 init 初始化方法实现数据库的连接。代码如下,通过本地Mysql的账号密码连接数据库,创建游标对比cursor,并执行select version 查询mysql的版本信息。

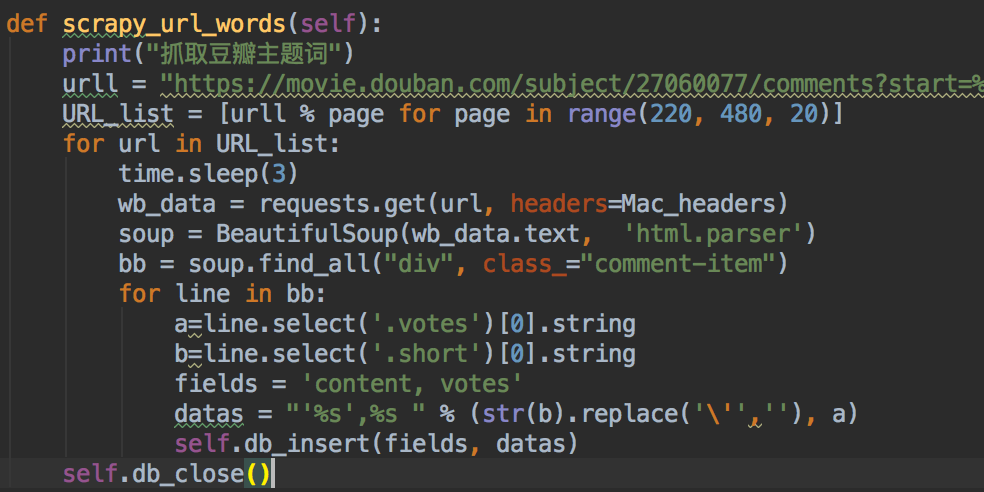

第二步:执行 爬取“豆瓣书评”的函数,设置爬取的目标URL列表,使用BeautifulSoup包完成html文本的解析提取文本信息,然后调用db_insert方法完成数据写入mysql数据表。

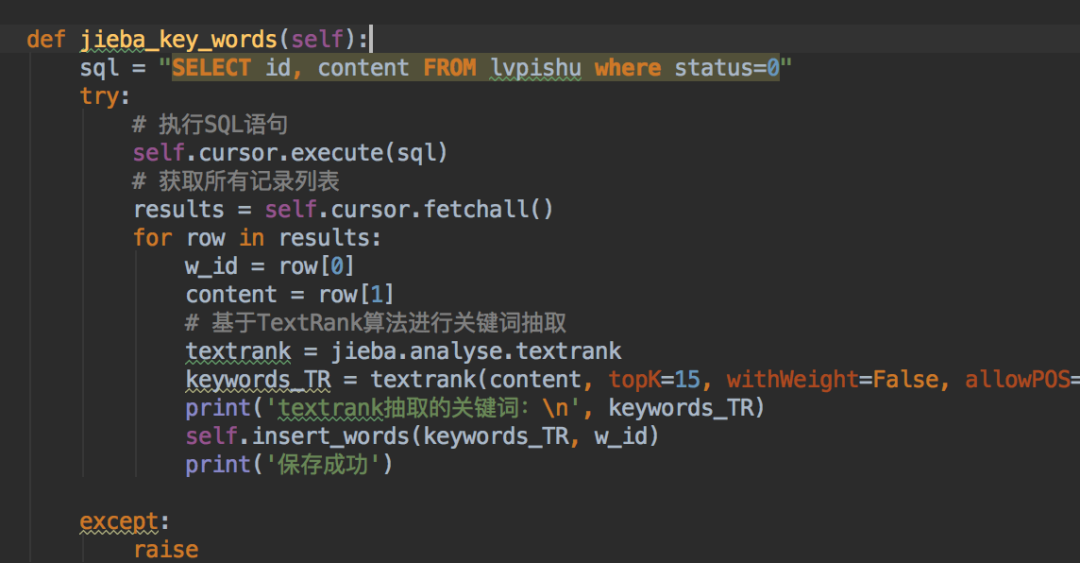

第三步:使用jieba分词,读取mysql数据,并使用jieba分词中的TextRank算法进行关键提取,并inser_word将关键词写入数据表,方便后续的查询分析。

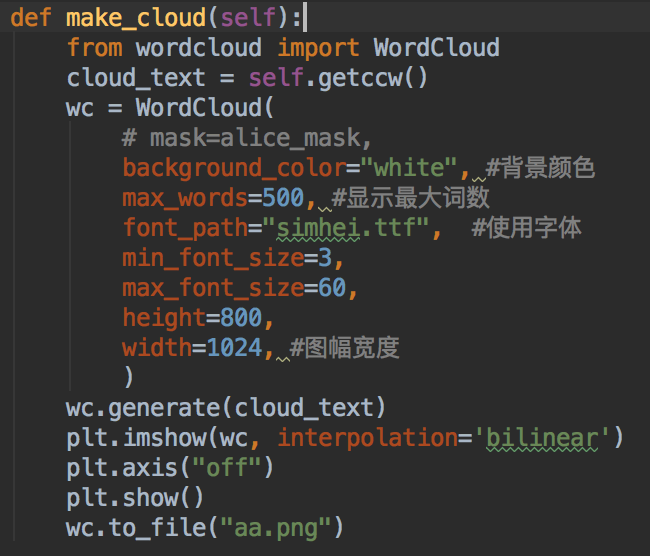

第四步:使用make_cloud 方法,读取mysql中的关键词列表,并配置WordCloud参数,生成词云数据,并使用plt绘制图片。

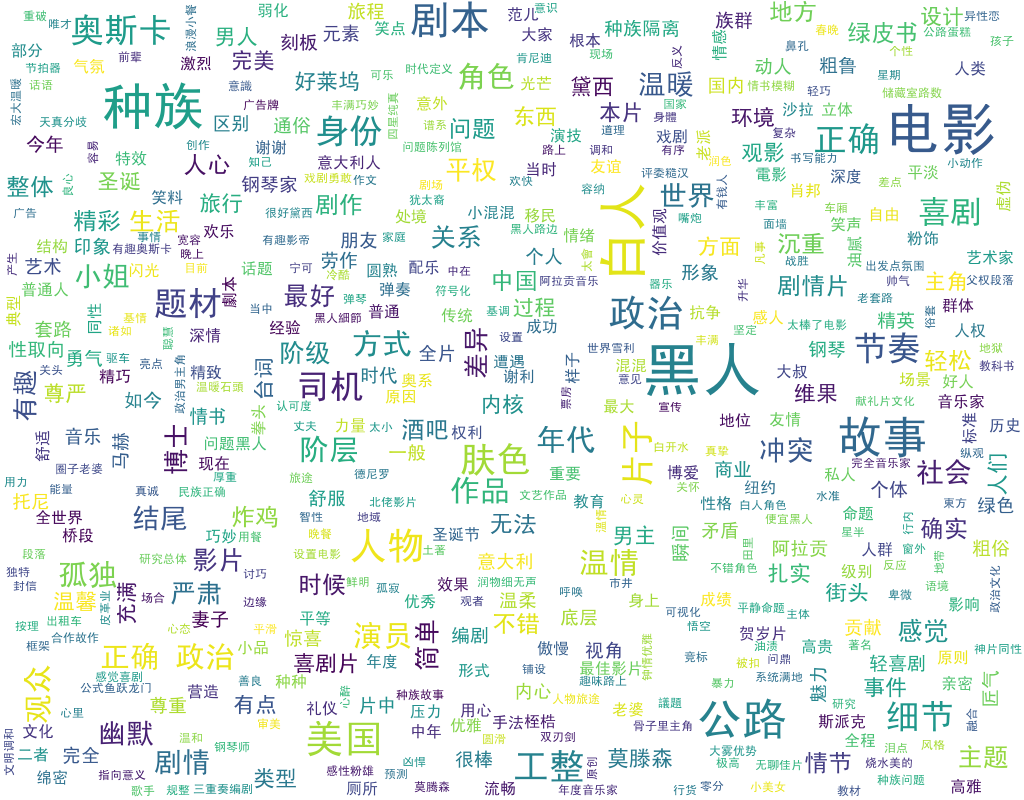

最终可视化结果如下:

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-10-20,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读