百万 QPS 性能优化

大家好,我是苏三。

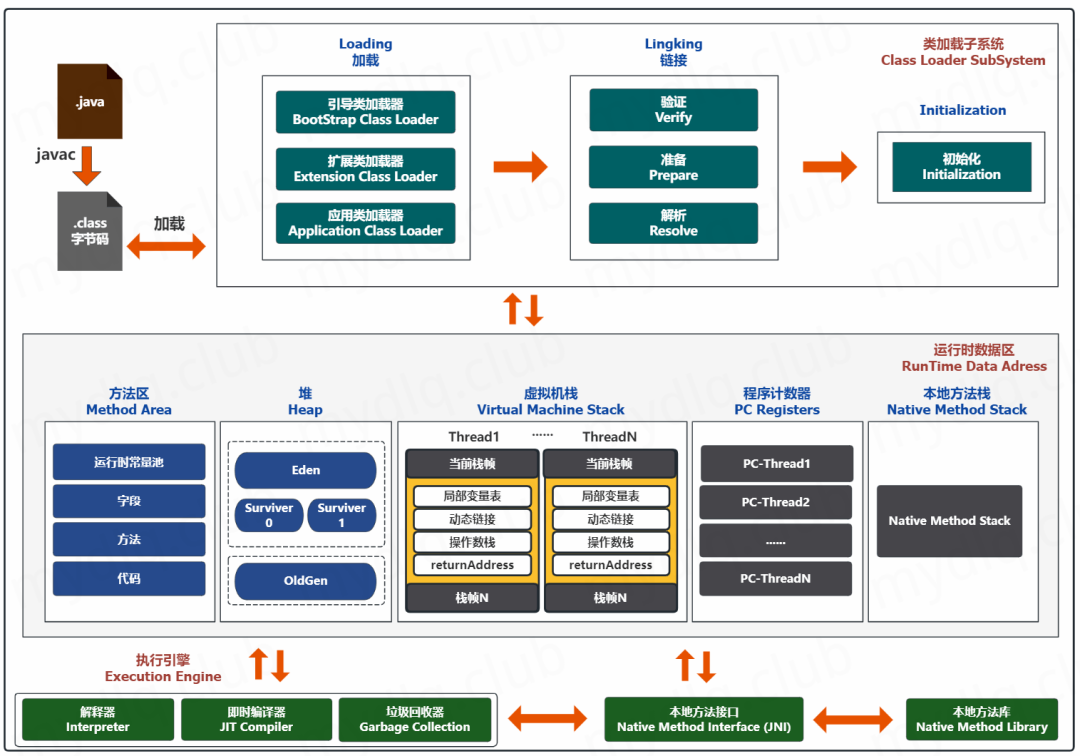

在 JVM 的世界中,运行时数据区域是整个虚拟机的基础,它决定了程序的内存管理、线程的执行流以及垃圾回收的核心逻辑。

运行时数据区域的划分不仅体现了 JVM 的设计哲学,还在性能优化中起着至关重要的作用。

今天,我们来学习下 JVM 的内存区域划分、对象内存布局、百万 QPS 优化实践。

图:小豆丁技术栈

图:小豆丁技术栈

内存区域划分

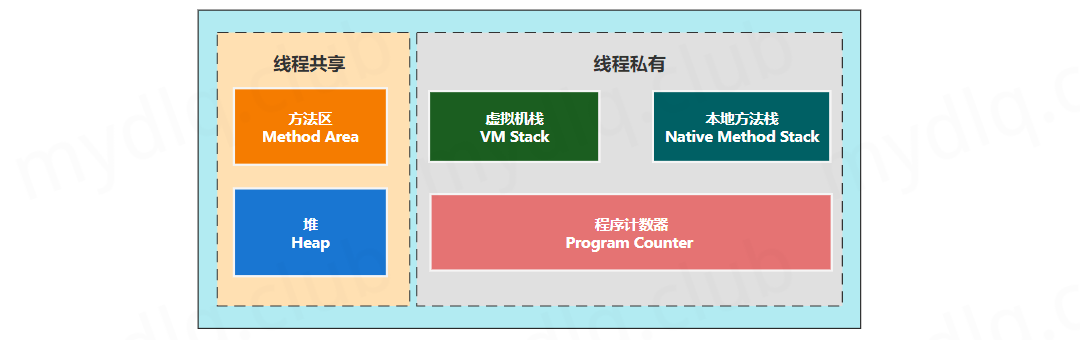

JVM 内存可分为 线程私有 和 线程共享 两大类区域:

图:小豆丁技术栈

图:小豆丁技术栈

线程私有区域

- 程序计数器(PC Register)

- 作用:记录当前线程执行的字节码指令地址,确保线程切换后能恢复执行点。

- 特点:唯一不会出现

OutOfMemoryError的区域,生命周期与线程绑定。

- Java 虚拟机栈(JVM Stack)

- 作用:存储方法调用的栈帧,包含局部变量表、操作数栈、动态链接等信息。

- 异常:StackOverflowError(栈深度溢出)和

OutOfMemoryError。

- 本地方法栈(Native Method Stack)

- 作用:服务于 JNI 调用的本地方法(如 C/C++ 代码),结构与虚拟机栈类似。

线程共享区域

- 堆(Heap)

- 新生代:包括 Eden 区和两个 Survivor 区(From/To),用于短生命周期对象。

- 老年代:存放长期存活对象(如经过多次 GC 仍存在的实例)。

- 作用:存储所有对象实例和数组,是垃圾回收(GC)的核心区域。

- 结构:

- 调优参数:通过

-Xms(初始堆大小)和-Xmx(最大堆大小)控制容量。

- 方法区(Method Area)/ 元空间(Metaspace)

- 作用:存储类元数据(如字段、方法)、常量池、静态变量等。

- 演变:JDK 8 后永久代(PermGen)被元空间取代,使用本地内存,避免

OutOfMemoryError: PermGen。

其他关键区域

- 直接内存(Direct Memory)

- 作用:通过

ByteBuffer.allocateDirect()分配,绕过堆内存直接访问物理内存,提升 I/O 性能。 - 特点:不属于 JVM 管理,但溢出时仍可能引发

OutOfMemoryError。

- 作用:通过

- 运行时常量池

- 归属:方法区的一部分,存储编译期生成的字面量和符号引用。

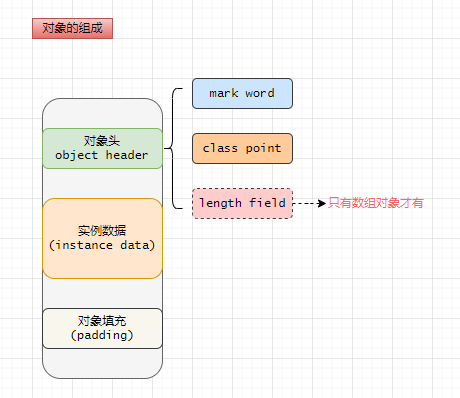

对象内存布局

JVM 对象内存布局由三部分组成:对象头(Header)、实例数据(Instance Data)和对齐填充(Padding)。

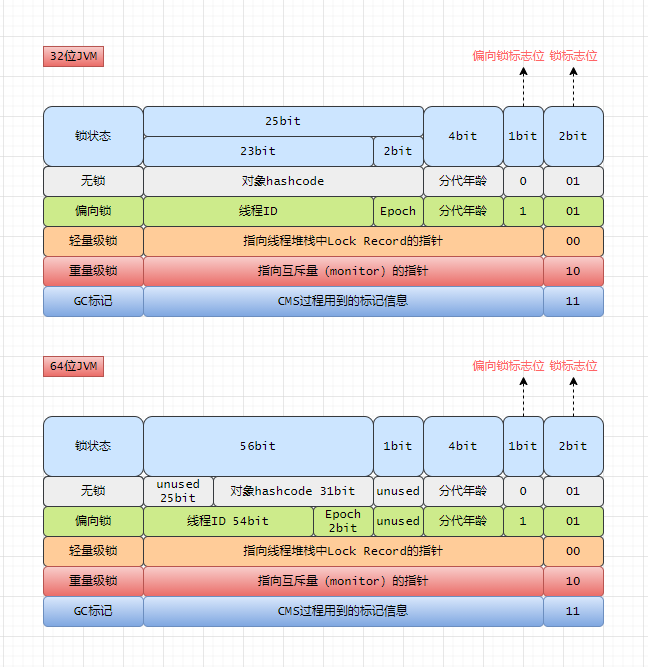

- 对象头(Header) 对象头结构示意图

- Mark Word:存储哈希码、GC 分代年龄、锁状态等(64 位系统占 8 字节)。

- 类型指针:指向方法区的类元数据(4 字节)。

- 数组长度(仅数组对象):记录数组长度(4 字节)。

- 实例数据(Instance Data)

- 包含对象所有成员变量(包括继承的变量)的实际值。

- 对齐填充(Padding)

- 确保对象总大小为 8 字节的整数倍,满足内存对齐要求。

JVM 内存划分的设计意义

Tina:JVM 内存划分的设计意义是什么?

设计意义主要体现在以下几个方面,其核心目标是通过对不同类型数据的分类管理,平衡性能、安全性、资源利用效率等多方面需求。

JVM 内存划分是一种典型的“空间换时间”设计哲学,通过牺牲部分内存冗余(如栈帧的独立分配、堆的分代结构),换取了高效的执行速度、灵活的垃圾回收策略和稳定的多线程环境。

这种设计不仅体现了对计算机科学底层原理的深刻理解(如栈与堆的结构特性),也反映了工程实践中对性能、安全性和扩展性的综合权衡。

提升内存管理机效率和访问性能

堆内存(Heap)存储对象实例和数组,这类数据生命周期差异大(短生命周期对象与长期存活对象并存),通过划分为新生代和老年代,结合不同的垃圾回收算法(如复制算法、标记整理算法)优化回收效率。

栈内存(Stack)存储线程私有的方法调用栈帧(局部变量、操作数栈等),利用栈结构的“先进后出”特性高效管理方法调用和返回,无需复杂内存分配机制,访问速度远快于堆。

线程私有的区域(如栈、程序计数器)避免了多线程竞争,无需加锁即可快速操作,降低并发开销。

共享区域(堆、方法区)则用于存储全局数据(如对象实例、类元信息),通过同步机制保障线程安全

优化垃圾回收性能

JVM 基于“弱代假说”(大部分对象生命周期短),将堆划分为新生代和老年代:

- 新生代采用复制算法(如 Survivor 区),快速回收短期对象;

- 老年代使用标记-清除或标记-整理算法,减少长期存活对象的回收频率。这种设计显著降低了垃圾回收的整体停顿时。

从永久代(PermGen)到元空间(Metaspace)的转变,避免了永久代内存溢出的问题,元空间使用本地内存动态扩展,减少了对 JVM 堆的依赖。

保障线程安全与程序稳定性

程序计数器为每个线程记录独立的执行指令地址,确保线程切换后能正确恢复执行。

本地方法栈与 Java 虚拟机栈分离,避免 Java 方法调用与本地代码(如 C/C++)的栈操作冲突。

不同区域的异常类型(如堆的 OutOfMemoryError、栈的 StackOverflowError)帮助开发者快速定位问题根源。例如,栈溢出通常由无限递归引起,而堆溢出多因对象未及时释放

支持多语言与系统交互的扩展性

本地方法栈的兼容性:为 JNI 调用提供独立栈空间,支持与 C/C++ 等语言的交互,扩展 Java 的底层资源访问能力(如操作系统 API)。

直接内存的高效 I/O:通过堆外内存(Direct Memory)减少数据在 Java 堆与 Native 堆间的复制开销,提升 NIO 等高性能操作的效率。

动态性与资源利用的平衡

元数据的灵活管理:方法区存储类元信息、常量池等数据,支持类的动态加载和卸载,避免重复加载类定义,节省内存。

内存分配策略的适配:JVM 允许通过参数(如 -Xmx、-Xss)调整各区域大小,开发者可根据应用特性优化内存分配(如高并发场景需增大栈容量)。

JVM 高效内存分配策略

Tina:在 Java 多线程环境下,频繁的对象分配若直接操作共享堆内存,会因全局锁竞争导致性能瓶颈。JVM 如何高效分配内存呢?

TLAB(线程本地分配缓冲区)

使用 TLAB(线程本地分配缓冲区)实现内存分配,TLAB 通过为每个线程在堆内存的 Eden 区分配独立的小块内存(默认 64KB-1MB),实现无锁化分配,减少同步开销。

例如,线程 A 在自己的 TLAB 中分配对象时,仅需移动内部指针,无需与其他线程竞争堆内存锁。

核心工作机制

分配流程:对象优先在 TLAB 中分配(指针碰撞方式);若空间不足,触发 TLAB Refill 操作,从 Eden 区申请新 TLAB 块或退化为全局堆分配(需加锁)。

内存回收:TLAB 生命周期与线程绑定,未用完的空间在 GC 时统一回收,可能产生内存碎片但通过“填充 Dummy 对象”优化对齐。

调优关键参数

-XX:TLABSize:初始大小(默认动态调整,建议根据对象平均大小设置,如 1M)。-XX:MinTLABSize:最小阈值(阿里案例中设为 1M 以降低初期分配压力)。-XX:TLABWasteTargetPercent:控制 TLAB 占 Eden 区的比例(默认 1%,高并发场景可适当提升)。优化效果:通过调整 TLAB 初始大小,**使 QPS 从初始爬升到稳定峰值时间缩短 50%,减少 GC 停顿约 30%**。

逃逸分析与栈上分配

逃逸分析原理

JVM 通过静态代码分析(编译时)和动态行为追踪(运行时)判断对象作用域:

- 未逃逸对象:仅在方法内部使用(如局部变量),可进行栈上分配。

- 方法逃逸:对象作为返回值或参数传递到其他方法 → 堆分配。

- 线程逃逸:对象被其他线程访问(如存入全局集合) → 堆分配。

public void processOrder() {

User user = new User(); // 无逃逸,栈上分配

user.setId(100);

// 对象未传递到外部

}

栈上分配:将未逃逸对象直接分配在栈帧中,随方法调用结束自动销毁,避免堆内存分配与 GC 开销(如循环内临时对象)。

标量替换:将对象拆解为基本类型变量(如User对象拆为int age),消除对象头占用空间(实验显示内存节省约 40%)。

同步消除:若对象仅被单线程访问,JIT 编译器自动移除synchronized块(如局部锁对象)。

JVM 参数:

-XX:+DoEscapeAnalysis(启用逃逸分析)-XX:+PrintEscapeAnalysis(输出分析日志)

性能对比:栈上分配较堆分配减少 30%的 GC 压力

百万 QPS 优化实践:TLAB 与参数调优

面试官:面对百万级请求,如何进行 JVM 调优?

面试时如果被问到这类问题,首先要做的就是问清楚背景,背景无非以下几个角度:业务、请求量、部署服务器等。

- 业务:目标服务主要用于处理登录请求。

- 请求量:请求量级每天百万级,且存在流量高峰期,高峰期持续时间 1-2 小时,高峰 QPS3000,其余时间 QPS 为 30。

- 部署服务器:服务部署的容器内存为 8G,单节点部署。

调优分析

登录请求结构通常不会太复杂,假设有 10 个字段,300 字节。由于登录操作,同时会进行网络通信、数据库操作、缓存操作等,预设占用内存扩大为 50 倍。那么每次请求大约占用 1.5K。

非流量高峰期 QPS30,每秒约 45K。流量高峰时段 QPS3000,每秒约 4.5M。

假设 8G 机器,分配 4G 堆内存,其中新生代 2G。那么流量高峰期 450 秒就会打满新生代,进行 MinorGC。

登录服务,不会处理复杂的业务逻辑,只进行通用鉴权,接口耗时会比较短。这意味着内存中大部分对象是朝生夕死,广泛存在于新生代。

调优策略

作为登录服务,新生代对象的创建和销毁比较频繁,大多数对象朝生夕死,同时登录请求要求快速响应,这意味着对新生代的要求较高。同时新生代垃圾回收主要采用复制算法,碎片问题相对较少,因此我们主要关注的是 STW 时长和吞吐量。

在众多新生代垃圾收集器中,Serial、ParNew、Parallel Scavenge 以及支持整堆回收的 G1 都是常见的选择。首先排除 Serial,单线程垃圾回收,效率低下。

G1 是服务器风格的垃圾收集器,针对的是具有大内存的多处理器服务器。追求实现高吞吐量的同时,最大程度降低垃圾回收时 STW 时间目标。

所以该场景下优先选择 G1 垃圾回收器,并设置一些调优。

-XX:+USEG1G:使用 G1 垃圾回收器。-XX:G1HeapRegionSize=16M,减少大对象直接进入老年代的概率。-XX:MaxGCPauseMillis=100,限制 GC 最大停顿时间。- TLAB 动态调整

- 设置

-XX:MinTLABSize=1M,避免初期频繁 Refill(默认 64KB 易导致慢分配)。 - 启用

-XX:+ResizeTLAB,允许 JVM 根据分配速率自动调整 TLAB 大小(动态平衡碎片与效率)。

- 设置

- 逃逸分析辅助:通过

-XX:+DoEscapeAnalysis(默认开启)优化 80%的临时对象分配路径

优化后系统 QPS 稳定在百万级,GC 频率降至 1 次/分钟以下,P99 延迟从 200ms 降至 50ms,CPU 利用率下降 15%。

实战 Checklist 与工具链

内存问题检测脚本

#!/bin/bash

# 快速检测JVM内存配置

echo "堆配置: -Xms$(jinfo -flag InitialHeapSize $PID | cut -d= -f2) -Xmx$(jinfo -flag MaxHeapSize $PID | cut -d= -f2)"

echo "元空间: -XX:MetaspaceSize=$(jinfo -flag MetaspaceSize $PID | cut -d= -f2)"

echo "TLAB状态: $(jinfo -flag UseTLAB $PID)"

堆外内存泄漏排查四步法

- 定位嫌疑进程:

top -p $PID观察 RES 与 VIRT 差值; - 分析 NIO Buffer:

jcmd $PID VM.native_memory detail; - 追踪 JNI 调用:

-XX:+PrintJNIResolving; - Dump 分析:

gdb -ex "dump memory dump.bin 0xSTART 0xEND" $PID。

最后欢迎加入苏三的星球,你将获得:苏三AI项目、商城微服务实战、秒杀系统实战、商城系统实战、秒杀系统实战、代码生成工具、系统设计、性能优化、技术选型、底层原理、Spring源码解读、工作经验分享、痛点问题、面试八股文等多个优质专栏。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-03-04,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录