强化学习算法解析:深度 Q 网络(Deep Q - Network,DQN)

强化学习算法解析:深度 Q 网络(Deep Q - Network,DQN)

jack.yang

发布于 2025-04-17 13:07:10

发布于 2025-04-17 13:07:10

一、引言

强化学习(Reinforcement Learning, RL)是机器学习领域的重要分支,它研究如何让智能体(Agent)通过与环境的交互来学习最优的行为策略。在强化学习中,智能体的目标是最大化长期累积奖励,而环境则根据智能体的行为给出反馈。Q-learning 是强化学习中一种经典的算法,它通过学习状态 - 行动对(State-Action Pair)的 Q 值来指导智能体的行为。然而,传统的 Q-learning 算法在面对状态空间巨大的场景时(如游戏、机器人控制等)存在明显的局限性,因为直接存储和更新所有状态 - 行动对的 Q 值在计算和存储上是不可行的。

深度 Q 网络(Deep Q-Network,DQN)是将深度学习与 Q-learning 相结合的一种创新方法。它利用深度神经网络来近似表示 Q 值函数,从而能够处理高维状态空间的问题。DQN 的提出标志着强化学习与深度学习的深度融合,为解决复杂环境中的决策问题提供了强大的工具。通过引入经验回放(Experience Replay)和目标网络(Target Network)等技术,DQN 有效解决了深度学习训练过程中的数据相关性和非平稳性问题,使得智能体能够在动态环境中稳定地学习和优化策略。

二、Q-learning 的基础

(一)强化学习的基本框架

强化学习的核心思想是智能体通过与环境的交互来学习最优的行为策略。强化学习的基本框架包括以下几个关键要素:

- 状态(State):智能体在环境中所处的当前情况,通常用 s 表示。

- 行动(Action):智能体在状态 s 下可以选择的行为,通常用 a 表示。

- 奖励(Reward):环境对智能体行为的即时反馈,通常用 r 表示。

- 策略(Policy):智能体选择行动的规则,通常用 π 表示。

- 价值函数(Value Function):衡量智能体在某个状态或状态 - 行动对下的长期累积奖励,通常用 V 或 Q 表示。

强化学习的目标是找到一个最优策略 π*,使得智能体在任何状态下都能获得最大的长期累积奖励。

(二)Q-learning 的核心思想

Q-learning 是一种基于价值函数的强化学习算法,它通过学习状态 - 行动对的 Q 值(Q-Value)来指导智能体的行为。Q 值表示在状态 s 下采取行动 a 后,智能体能够获得的长期累积奖励的期望值。Q-learning 的核心思想是通过动态规划(Dynamic Programming)的方法不断更新 Q 值,直到收敛到最优 Q 值函数 Q*。

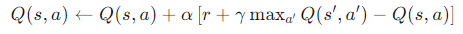

Q-learning 的更新规则如下:

- max

通过不断与环境交互并更新 Q 值,Q-learning 能够逐渐收敛到最优策略。

(三)Q-learning 的局限性

尽管 Q-learning 是一种有效的强化学习算法,但它在面对状态空间巨大的场景时存在明显的局限性:

- 存储问题:当状态空间维度较高时,直接存储所有状态 - 行动对的 Q 值需要巨大的内存。

- 泛化能力差:Q-learning 无法对相似状态进行泛化,导致在面对未见过的状态时无法有效决策。

- 计算复杂度高:在高维状态空间中,更新所有状态 - 行动对的 Q 值计算开销极大,难以实时处理。

这些问题限制了 Q-learning 在复杂环境中的应用,因此需要引入更高效的方法来解决这些问题。

三、深度 Q 网络(DQN)的核心思想

(一)深度学习与 Q-learning 的结合

深度 Q 网络(DQN)通过将深度学习与 Q-learning 相结合,利用深度神经网络来近似表示 Q 值函数,从而解决了传统 Q-learning 在高维状态空间中的局限性。具体来说,DQN 使用深度神经网络作为函数近似器(Function Approximator),将状态 s 映射到所有可能行动的 Q 值。这种映射关系可以表示为:

通过深度神经网络,DQN 能够自动学习状态的特征表示,并对相似状态进行泛化,从而在高维状态空间中高效地学习和决策。

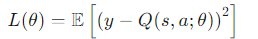

(二)DQN 的训练目标

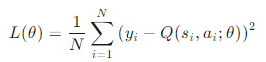

DQN 的训练目标是通过最小化 Q 值的预测值与目标值之间的均方误差(Mean Squared Error, MSE)来更新神经网络的参数。具体来说,DQN 的损失函数定义为:

通过梯度下降法(Gradient Descent)最小化损失函数,DQN 能够不断优化神经网络的参数,使得预测 Q 值逐渐接近目标 Q 值。

四、DQN 的关键技术

(一)经验回放(Experience Replay)

经验回放是 DQN 中的一项关键技术,它通过存储智能体与环境交互的经验(即状态、行动、奖励和下一个状态的四元组 ⟨

1. 数据相关性问题

在传统的 Q-learning 中,智能体与环境的交互数据是按时间顺序生成的,相邻数据之间存在高度的相关性。这种相关性会导致神经网络的训练不稳定,因为梯度更新会受到数据顺序的影响。

2. 经验回放的实现

经验回放通过以下步骤实现:

- 存储经验:将每次交互生成的经验 ⟨

- 随机采样:在每次更新网络时,从回放记忆库中随机采样一小批经验(通常称为 mini-batch)。

- 批量更新:使用采样到的 mini-batch 计算损失函数,并通过梯度下降法更新网络参数。

通过经验回放,DQN 能够打破数据的相关性,使得训练数据更加独立同分布(Independent and Identically Distributed, i.i.d.),从而提高训练的稳定性和收敛速度。

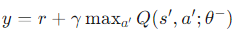

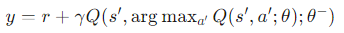

(二)目标网络(Target Network)

目标网络是 DQN 中的另一项关键技术,它通过维护一个独立的网络来计算目标 Q 值,从而解决了深度学习训练过程中的非平稳性问题。

1. 非平稳性问题

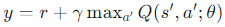

在传统的 Q-learning 中,目标 Q 值

2. 目标网络的实现

目标网络通过以下步骤实现:

- 独立网络:维护一个独立的目标网络,其参数

- 延迟更新:目标网络的参数

- 稳定目标:使用目标网络计算目标 Q 值

通过目标网络,DQN 能够有效减少目标 Q 值的波动,提高训练的稳定性。

(三)其他优化技术

除了经验回放和目标网络,DQN 还结合了其他一些优化技术来进一步提升性能:

- 奖励裁剪(Reward Clipping):将奖励值裁剪到固定范围(如 [-1, 1]),以减少奖励尺度对训练的影响。

- Adam 优化器:使用 Adam 优化器(一种自适应学习率优化算法)来加速训练并提高收敛速度。

- ε-贪心策略(ε-Greedy Strategy):在探索与利用之间取得平衡,通过以概率

五、DQN 的算法实现

(一)DQN 的基本步骤

DQN 的算法实现可以分为以下几个步骤:

- 初始化网络:

- 初始化当前网络

Q(s,a;θ) 和目标网络 Q(s,a;θ−),并将目标网络的参数 θ− 初始化为当前网络的参数 θ。 - 初始化回放记忆库

D。 - 与环境交互:

- 在每个时间步 t,智能体根据当前状态

st 和 ε-贪心策略选择行动 at。 - 执行行动

at,观察环境反馈的奖励 rt 和下一个状态 st+1。 - 将经验 ⟨

st,at,rt,st+1⟩ 存储到回放记忆库 D 中。 - 训练网络: 在深度 Q 网络(DQN)中,训练网络的过程是通过从回放记忆库中采样经验并利用这些经验来更新 Q 值函数的参数。以下是详细的训练步骤: 从回放记忆库中采样 首先,从回放记忆库

计算损失函数 定义损失函数

其中:

使用梯度下降法更新参数 通过梯度下降法(Gradient Descent)最小化损失函数

- 同步目标网络:

- 每隔一定的时间间隔(如每 1000 步),将当前网络的参数

θ 复制到目标网络的参数 θ−。 - 重复:

- 重复步骤 2-4,直到智能体的策略收敛。

(二)DQN 的伪代码

以下是 DQN 的伪代码:

初始化当前网络 Q(s, a; θ) 和目标网络 Q(s, a; θ^-)

θ^- ← θ

初始化回放记忆库 D

初始化 ε(探索率)

for 每个训练周期 do

初始化环境,得到初始状态 s

for 每个时间步 t do

根据 ε-贪心策略选择行动 a:

以概率 ε 随机选择 a

以概率 1 - ε 选择 a = argmax_a Q(s, a; θ)

执行行动 a,得到奖励 r 和下一个状态 s'

将经验 ⟨s, a, r, s'⟩ 存入 D

s ← s'

如果 D 中的经验数量超过预设的 mini-batch 大小 then

从 D 中随机采样一个 mini-batch 的经验

for 每个经验 ⟨s, a, r, s'⟩ in mini-batch do

if s' 是终止状态 then

y ← r

else

y ← r + γ * max_{a'} Q(s', a'; θ^-)

end if

计算损失 L ← (y - Q(s, a; θ))^2

使用梯度下降法更新 θ

end for

end if

每隔一定的时间间隔:

θ^- ← θ

end for

end for(三)DQN 的实现细节

在实际实现 DQN 时,需要注意以下细节:

- 网络结构:通常使用卷积神经网络(CNN)来处理高维状态(如游戏画面),而使用全连接网络(FCN)来处理低维状态。

- 回放记忆库的大小:回放记忆库的大小需要根据具体任务调整,通常在 1e4 到 1e6 之间。

- mini-batch 的大小:mini-batch 的大小通常在 32 到 128 之间,具体取决于计算资源。

- 目标网络的同步频率:目标网络的参数通常每隔 1000 到 10000 步同步一次。

- ε 的衰减策略:ε 通常从 1.0 开始,逐渐衰减到 0.01 或 0.1,以平衡探索与利用。

六、DQN 的应用场景

(一)游戏 AI

DQN 在游戏 AI 领域取得了显著的成果,尤其是在 Atari 游戏上。Atari 游戏是一种经典的强化学习测试平台,智能体需要根据游戏画面(状态)选择行动,以获得更高的分数。DQN 通过将游戏画面作为输入,利用卷积神经网络提取画面特征,并通过 Q 值函数指导行动选择,成功地在多个 Atari 游戏上达到了超越人类玩家的表现。

1. Atari 游戏的具体实现

在 Atari 游戏中,DQN 的实现通常包括以下步骤:

- 状态预处理:将游戏画面转换为灰度图像,并裁剪到固定大小(如 84×84),以减少输入维度。

- 状态堆叠:将连续的 4 帧画面堆叠在一起,形成一个状态,以捕捉时间序列信息。

- 网络结构:使用卷积神经网络提取画面特征,最后通过全连接层输出每个行动的 Q 值。

- 训练过程:通过与环境交互收集经验,并使用经验回放和目标网络进行训练。

2. Atari 游戏的实验结果

DQN 在多个 Atari 游戏上的实验结果表明,它能够在大多数游戏中达到或超越人类玩家的表现。例如,在 Breakout 游戏中,DQN 学会了如何通过击碎砖块来获得高分;在 Pong 游戏中,DQN 学会了如何击败对手。

(二)机器人控制

DQN 在机器人控制领域也有广泛的应用。例如,在机器人导航任务中,智能体需要根据当前的传感器数据(状态)选择行动(如前进、转向),以到达目标位置。DQN 通过学习状态 - 行动对的 Q 值,能够有效地指导机器人在复杂环境中进行导航。

1. 机器人导航的具体实现

在机器人导航任务中,DQN 的实现通常包括以下步骤:

- 状态表示:将机器人的传感器数据(如激光雷达数据、摄像头数据)作为状态输入。

- 行动空间:定义机器人的行动空间,如前进、向左转、向右转等。

- 奖励设计:设计合理的奖励函数,例如到达目标位置给予正奖励,碰撞障碍物给予负奖励。

- 网络结构:根据状态的维度选择合适的网络结构,如卷积神经网络处理图像数据,全连接网络处理传感器数据。

- 训练过程:通过与环境交互收集经验,并使用 DQN 的关键技术进行训练。

2. 机器人导航的实验结果

实验结果表明,DQN 能够有效地学习机器人在复杂环境中的导航策略。例如,在模拟环境中,DQN 学会了如何避开障碍物并到达目标位置;在实际机器人上,DQN 也表现出良好的导航能力。

(三)其他应用场景

除了游戏 AI 和机器人控制,DQN 还可以应用于其他领域,如推荐系统、金融交易、智能交通等。在推荐系统中,DQN 可以根据用户的历史行为(状态)选择最合适的商品或内容进行推荐;在金融交易中,DQN 可以根据市场数据(状态)选择买入或卖出的时机;在智能交通中,DQN 可以优化交通信号灯的控制策略,以减少交通拥堵。

七、DQN 的优缺点

(一)优点

- 处理高维状态空间:DQN 通过深度神经网络能够有效地处理高维状态空间的问题,适用于复杂环境。

- 自动特征提取:DQN 能够自动学习状态的特征表示,减少了人工设计特征的工作量。

- 泛化能力强:DQN 对相似状态具有泛化能力,能够在未见过的状态下做出合理的决策。

- 稳定性高:通过经验回放和目标网络等技术,DQN 的训练过程更加稳定,收敛速度更快。

(二)缺点

- 计算资源需求高:DQN 需要大量的计算资源,尤其是在训练过程中需要与环境进行大量的交互。

- 样本效率低:DQN 需要大量的样本才能收敛,尤其是在样本获取成本较高的场景中(如机器人控制)。

- 超参数敏感:DQN 的性能对超参数(如学习率、折扣因子、ε 衰减策略等)非常敏感,需要仔细调整。

- 探索不足:在某些复杂环境中,DQN 可能会陷入局部最优,无法有效探索全局最优策略。

八、DQN 的改进方向

(一)Double DQN

Double DQN 是对 DQN 的一种改进,它通过分离 Q 值的估计和选择来减少过估计(Overestimation)问题。具体来说,Double DQN 使用当前网络选择行动,而使用目标网络评估行动的 Q 值,从而使得目标 Q 值更加准确。

目标 Q 值的计算公式为:

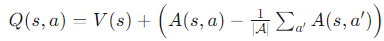

(二)Dueling DQN

Dueling DQN 是另一种改进方法,它通过将网络输出分为价值函数(Value Function)和优势函数(Advantage Function)两部分,从而更有效地学习 Q 值。具体来说,Dueling DQN 的输出可以表示为:

(三)优先经验回放(Prioritized Experience Replay)

优先经验回放是对经验回放的一种改进,它通过根据经验的重要性(如 TD 误差的大小)对经验进行优先级排序,并在采样时优先选择重要性较高的经验。这可以提高样本的利用效率,加速训练过程。

(四)分布式 DQN

分布式 DQN 通过多个并行的智能体与环境交互,异步更新网络参数,从而提高样本效率和训练速度。例如,异步 DQN(Asynchronous DQN)算法通过多个并行的线程与环境交互,并共享网络参数,取得了良好的性能。

九、DQN 的未来发展方向

(一)多智能体强化学习

在多智能体环境中,DQN 需要处理多个智能体之间的交互和协作。未来的研究可能会集中在如何设计高效的多智能体 DQN 算法,以实现智能体之间的协同决策。

(二)元强化学习

元强化学习(Meta-Reinforcement Learning)旨在让智能体能够快速适应新任务。未来的研究可能会探索如何将 DQN 与元学习相结合,使智能体能够在少量交互数据中快速学习新任务。

(三)理论分析与优化

尽管 DQN 在实践中取得了良好的性能,但其理论分析仍然不够完善。未来的研究可能会深入分析 DQN 的收敛性、样本复杂度等理论性质,并提出更优化的算法设计。

(四)实际应用的拓展

DQN 将在更多实际应用领域得到拓展,如医疗、金融、教育等。通过与领域知识的结合,DQN 有望在这些领域发挥更大的作用,解决实际问题。

十、结论

深度 Q 网络(DQN)是强化学习与深度学习结合的一个重要里程碑,它通过将深度神经网络用于 Q 值函数的近似表示,解决了传统 Q-learning 在高维状态空间中的局限性。通过引入经验回放和目标网络等技术,DQN 有效解决了深度学习训练过程中的数据相关性和非平稳性问题,使得智能体能够在复杂环境中稳定地学习和优化策略。DQN 在游戏 AI、机器人控制等领域取得了显著的成果,并为强化学习的进一步发展提供了坚实的基础。

尽管 DQN 存在一些缺点,如计算资源需求高和样本效率低,但通过 Double DQN、Dueling DQN、优先经验回放等改进方法,这些问题正在逐步得到解决。未来,随着强化学习领域的不断发展,DQN 将在理论和应用方面取得更大的突破,为解决复杂的决策问题提供更强大的工具。

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-04-16,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录