《AI大模型的下个十年:RAG与MCP驱动的认知升维革命》

原创《AI大模型的下个十年:RAG与MCP驱动的认知升维革命》

原创

老周侃AI

发布于 2025-07-25 14:41:29

发布于 2025-07-25 14:41:29

本文较长,建议点赞收藏以免遗失。由于文章篇幅有限,更多涨薪知识点,也可在主页查看。最新AI大模型应用开发学习资料免费领取。飞书右侧蓝色字体「链接」

RAG与MCP:AI大模型进化的黄金双翼

引言:

在大型语言模型(LLM)日臻成熟的今天,如何突破其固有限制成为关键议题。检索增强生成(RAG)与多模态上下文处理(MCP)技术正成为驱动大模型能力跃升的核心引擎。本文深入探讨两大技术在信息实时性、知识精准度及多维度感知方面的突破性价值及其协同演进路径。

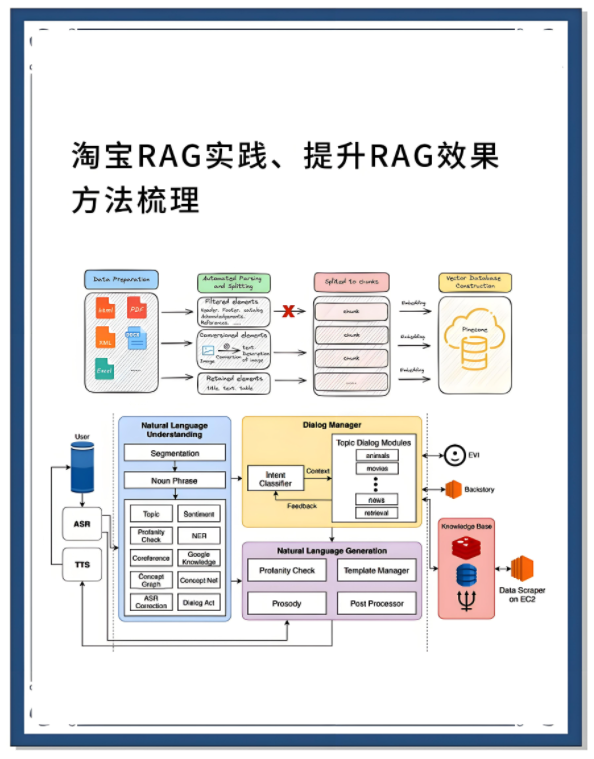

一、破壁者降临:RAG如何重构大模型知识边界

技术痛点与RAG的突破

- 知识滞后性:传统大模型的静态预训练导致知识固化于训练截止日,无法获取最新进展(如2024年新药突破)。

- 幻觉干扰:对超出训练范围的查询易产生虚构回复,影响决策可信度。

- 企业数据孤岛:无法无缝调用企业私域数据库、知识库中的高价值信息。

RAG的核心革新点:

- 动态知识索引构建:实时或近实时索引用户私有数据(文档、数据库、API)、行业知识库与最新互联网信息。

- 精准检索增强:将用户query转化为向量嵌入,在知识库中检索语义最相关的多篇文段。

- 上下文融合生成:将检索到的文段注入大模型上下文窗口,指导其生成基于实时事实的精准回复,显著抑制幻觉。

# 简化版RAG核心流程示例

query = "2024年FDA批准的靶向抗癌药物有哪些?"

retrieved_docs = vector_index.search(query_embedding, top_k=5) # 检索最相关的5份文档

augmented_prompt = f"依据以下资料:{retrieved_docs} \n\n 回答:{query}"

response = llm.generate(augmented_prompt) # 生成基于最新资料的回答行业场景的深度赋能

- 金融投研:实时分析最新财报、政策文件(SEC/央行公告)生成风险简报。

- 医疗诊断辅助:基于最新医学指南、病例库为医生提供循证决策支持。

- 智能客服:精准调用产品手册、用户手册解决客户问题,降低人工转接率。

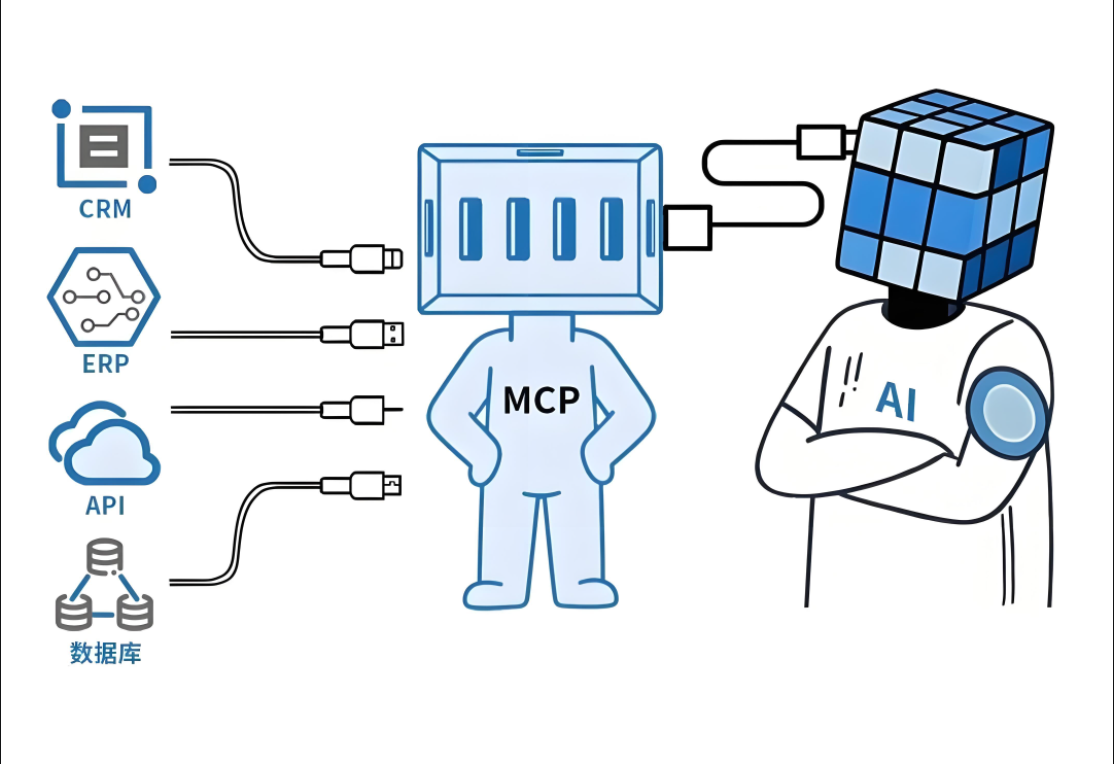

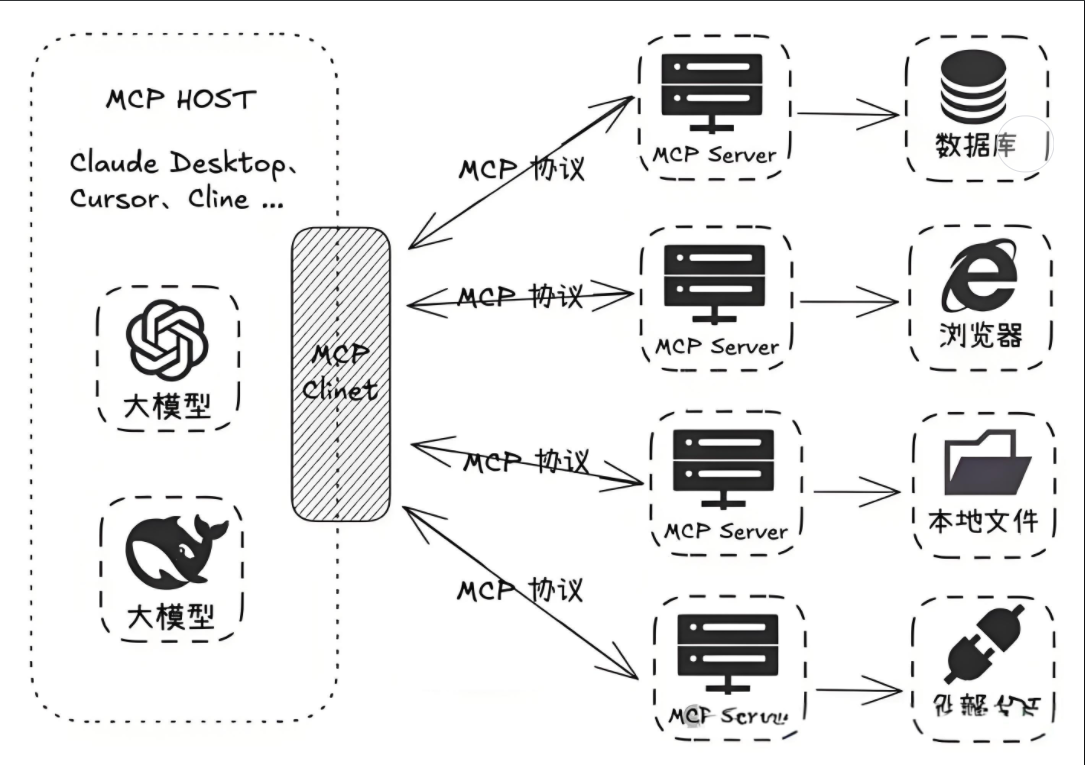

二、升维融合:MCP开启大模型的多模态认知革命

大模型的单模态瓶颈

GPT-4等模型虽能处理文本,但对图像、声音、视频等多模态信息存在先天感知缺陷,无法实现类人综合认知。

MCP的技术架构突破

- 跨模态语义对齐:构建统一嵌入空间,实现文本、图像、声音等模态的语义映射对齐。

- 多模态上下文融合:早期融合:输入端即进行多模态特征拼接对齐(如CLIP模型)。晚期融合:各模态单独编码后在大模型内进行语义协同(如Flamingo)。

- 理解生成一体化:同时支持跨模态内容理解(如图片问答)与跨模态内容生成(如以文本描述生成图像)。

MCP引发的场景革命

- 工业质检:同时处理产品图像(外观缺陷扫描)+ 传感器时序数据(生产参数波动)进行实时根因分析。

- 沉浸式教育:历史课中解析兵马俑图片+古文献描述+环境音效,生成3D历史场景互动。

- 智慧城市:交叉分析交通监控视频(拥堵画面)+文本投诉数据(市民反馈)+ 信号灯日志,自动生成疏导方案。

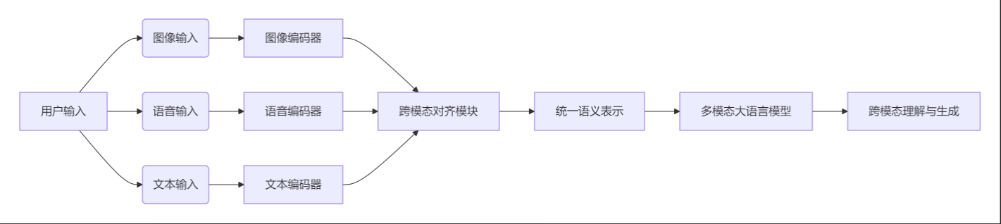

graph LR

A[用户输入] --> B(图像输入)

A --> C(语音输入)

A --> D(文本输入)

B --> E[图像编码器]

C --> F[语音编码器]

D --> G[文本编码器]

E --> H[跨模态对齐模块]

F --> H

G --> H

H --> I[统一语义表示]

I --> J[多模态大语言模型]

J --> K[跨模态理解与生成]三、黄金组合:RAG + MCP协同驱动的技术复利效应

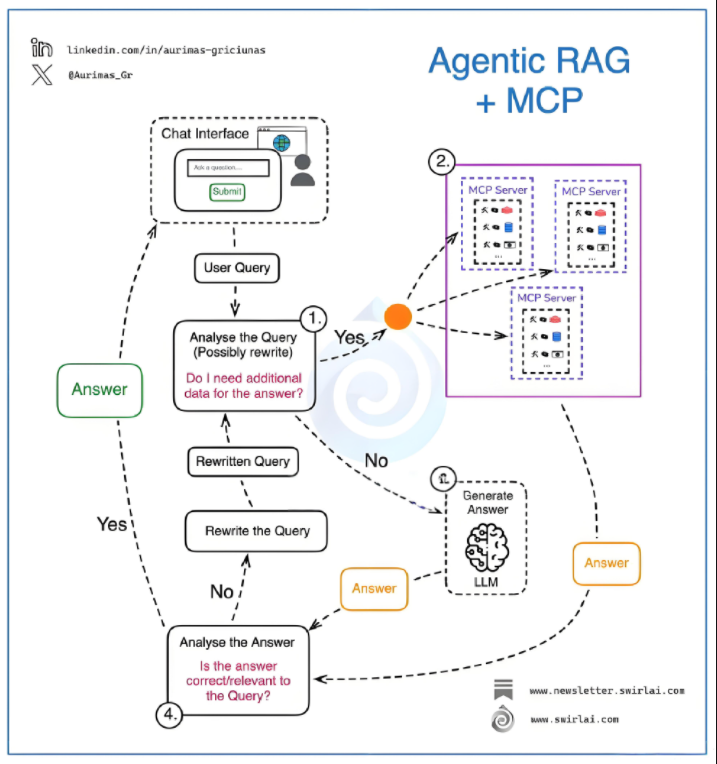

RAG和MCP不仅分别突破大模型的静态知识边界与模态壁垒,二者结合更能激发显著的协同增强效应:

- 多模态知识检索增强生成:

- 需求场景:用户上传商品图片询问“这个材质的手袋如何保养?”

- 技术实现:MCP解析图像特征→提取关键属性(材质“真皮”)→RAG检索“真皮护理”指南→融合生成个性化建议。

- 动态环境感知决策:

- 应用场景:自动驾驶系统实时感知周边图像(车辆行人)+LiDAR数据(距离信息)+导航文本信息。

- 协同流程:MCP融合多源传感器数据→提取综合路况语义→RAG调用最新交规库→生成驾驶指令(如“右侧施工,建议变道”)。

- 企业级知识中枢:

- 架构示例:用户以语音提问设备故障(如“这台机床为何震动?”),系统自动关联设备监控图像、历史维修日志(RAG),由MCP模型融合分析,输出诊断报告。

技术协同实现路径:

sequenceDiagram

User->>+系统: 多模态输入(语音+图像)

系统->>+MCP模块: 跨模态语义对齐与融合

MCP模块-->>-系统: 统一语义表示

系统->>+RAG引擎: 基于语义表示检索相关文档

RAG引擎-->>-系统: 相关文档片段

系统->>+LLM: 注入多模态语义+文档片段,生成回答

LLM-->>-User: 精准的多模态增强回复四、未来展望:融合技术的关键演进方向

- 检索机制智能化升级:

- 检索排序阶段引入微调LLM进行相关性重排序(RRR),取代传统余弦相似度。

- 主动检索:让模型学会在何时、何地发起检索请求,平衡开销与效果(如Google的“Self-RAG”)。

- 多模态大模型架构轻量化:

- 探索跨模态适配器(Adapter)、稀疏专家模型(MoE),在保障性能下降低算力成本。

- 开源轻量多模态模型(如LLaVA)将加速行业渗透。

- 企业级知识引擎融合部署:

- 私有化RAG向量库与多模态处理引擎集成,支持本地GPU或云端灵活部署。

- 知识图谱与向量库的融合应用(Graph RAG),强化推理链可信度追踪。

技术挑战 | 创新解法 | 典型应用场景 |

|---|---|---|

多模态对齐瓶颈 | 自监督对比学习+跨注意力机制 | 工业视觉缺陷检测 |

检索延迟 | 混合检索(语义+关键词索引) | 金融实时投研分析 |

上下文长度限制 | 滑动窗口检索+递归索引 | 长文档(法律合同)处理 |

结语

RAG与MCP并非相互替代的技术路径,而是重塑大模型能力象限的共生性支柱。RAG从知识动态化维度扩展模型边界,MCP则从感知融合维度拓展模型认知深度。在2025年技术视野下,二者的协同演进正推动AI大模型从“信息生成者”向具备实时感知能力、全维知识调用能力和精准判断能力的认知增强伙伴进化。

随着RAG+MCP架构标准化、工程轻量化,未来三年将是大模型在行业场景中扎根本质生产力的核心突破期——谁掌握了双引擎深度融合的钥匙,谁将率先抵达工业级智能化的新大陆。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录