一文了解,NVMe-OF:从哪里来到哪里去

一文了解,NVMe-OF:从哪里来到哪里去

数据存储前沿技术

发布于 2025-08-12 09:18:22

发布于 2025-08-12 09:18:22

全文概览

在数据爆炸式增长的今天,存储性能已成为决定应用响应速度和业务效率的关键瓶颈。传统存储协议如SATA/SAS,在面对高速闪存介质时,其固有的串行设计和单一命令队列机制,如同高速公路上的单车道,严重限制了现代多核CPU和并行SSD的潜力。NVMe协议的出现,彻底打破了这一束缚,通过PCIe直连和大规模并行队列,将本地闪存性能推向极致。

然而,本地存储的性能再强,也无法满足数据中心对资源解耦、灵活共享和独立扩展的迫切需求。当我们将目光投向网络存储,如何才能在共享存储池中,依然享受NVMe带来的低延迟和高并发优势?NVMe over Fabrics (NVMe-oF) 技术应运而生,它将NVMe的卓越性能延伸至网络,承诺构建性能媲美本地、管理更加灵活的共享存储。

但面对FC-NVMe、NVMe over RDMA (RoCEv2) 和 NVMe over TCP (NVMe/TCP) 等多种传输协议,您是否感到困惑?每种协议的诞生背后有何深层原因?它们在性能、部署复杂性、和成本之间存在怎样的权衡?您的企业又该如何根据自身业务场景和现有基础设施,做出最明智的NVMe-oF协议选择?未来的存储格局将如何演变,CXL等新兴技术又将扮演怎样的角色?本文将深入剖析这些问题,为您拨开NVMe-oF的迷雾,提供清晰的战略指引。

阅读收获

- 掌握NVMe-oF主流协议的核心权衡。 理解FC-NVMe、NVMe/RoCE和NVMe/TCP在性能、部署复杂性、硬件依赖及成本效益上的关键差异,从而在技术选型时避免盲区,做出更符合实际需求的决策。

- 获取针对不同业务场景的NVMe-oF协议选型指南。

- 洞察NVMe-oF与CXL融合的未来趋势。 理解NVMe-oF作为块存储协议与CXL作为内存语义协议的互补关系,预见未来数据中心分层存储架构的演进方向,为前瞻性技术规划提供依据。

01

摘要

本文旨在对 Non-Volatile Memory Express over Fabrics (NVMe-oF) 技术领域进行全面而深入的分析。

NVMe-oF 将 NVMe 协议的卓越性能从直连存储 (DAS) 扩展至网络结构,标志着数据中心存储架构的一次根本性变革。然而,多种传输协议的并存——主要包括 NVMe over Fibre Channel (FC-NVMe)、NVMe over RDMA (RoCEv2) 和 NVMe over TCP (NVMe/TCP)——给技术决策者带来了复杂的选择。

本文旨在厘清这些协议背后的驱动因素、技术差异和市场动态,为企业制定存储现代化战略提供关键决策依据。

核心研究发现:

- 协议多样性的根源: NVMe-oF 协议的繁多并非偶然,而是为了迎合并利用数据中心中根深蒂固的三大生态系统——传统光纤通道存储区域网络 (FC SAN)、通用以太网/IP 网络以及高性能计算 (HPC) 的 InfiniBand/RDMA 网络。NVM Express 组织通过制定与传输层无关的架构,允许每个生态系统在不放弃其庞大的基础设施投资和运营专长的前提下,拥抱 NVMe 的性能优势。这是一种旨在最大化市场渗透率的务实策略。

- 核心权衡:性能与简易性: 各种协议之间存在一个根本性的权衡:极致性能通常伴随着高昂的部署复杂性。基于 RDMA 的 RoCEv2 协议提供了最低的延迟和最高的效率,但其部署要求严苛,需要专门配置的无损网络。相比之下,NVMe/TCP 的延迟虽略高,但它能够运行在任何标准的、无处不在的以太网基础设施上,极大地简化了部署和管理,使其成为推动 NVMe-oF 主流化的关键。

- 市场格局:并行赛道而非单一竞赛: 当前市场并非一场单一协议胜出的竞赛,而是三条并行的发展赛道。FC-NVMe 主要服务于寻求平滑升级的现有企业级 SAN 用户;NVMe/RoCE 占据着对延迟极度敏感的高性能计算、人工智能和金融交易等利基市场;而 NVMe/TCP 则面向广阔的云计算、超融合基础设施 (HCI) 和主流企业市场,凭借其普适性和成本效益,正处于最快增长的轨道上。

战略建议概览:

- 对于传统企业级 SAN 用户: 应将 FC-NVMe 作为首选的升级路径。这是一种低风险、低颠覆性的方案,能够在保护现有投资的同时,获得显著的性能提升。

- 对于云原生及 HCI 架构师: 应优先考虑并标准化 NVMe/TCP。它在可扩展性、成本效益和生态系统支持方面提供了最佳平衡,是构建现代化、软件定义数据中心的理想选择。

- 对于 HPC、AI 及金融服务等领域的领导者: 应投资于 NVMe/RoCE 架构。尽管其运营复杂性较高,但为了实现微秒级的极致性能,这种投入是必要且值得的。

本文将通过后续章节的深入论述,为以上结论和建议提供详实的数据、技术分析和案例支撑。

02

转变

直连到网络扩展NVMe

01

传统协议(SATA/SAS)性能瓶颈

存储技术的发展历程中,协议的演进始终与存储介质的物理特性紧密相连。

串行高级技术附件 (SATA) 和串行连接 SCSI (SAS) 等传统协议,其设计初衷是为了服务于机械硬盘 (HDD) 1。HDD 的工作原理依赖于旋转的盘片和移动的磁头,这意味着其本质上是串行设备,一次只能在一个位置进行读写。因此,为优化磁头寻道时间,SATA 所依赖的高级主机控制器接口 (AHCI) 采用了单一命令队列结构,这在机械时代是高效的 3。

然而,当存储介质进入固态闪存 (SSD) 时代,这一设计便成为巨大的性能瓶颈。SSD 内部没有移动部件,由多个 NAND 闪存芯片组成,能够并行处理数据访问请求 4。与此同时,现代中央处理器 (CPU) 发展为多核心架构,能够同时发出大量的 I/O 请求。在这种情况下,AHCI 的单一命令队列迫使来自多个 CPU 核心的并行请求被序列化处理,形成了严重的软件瓶颈,导致 CPU 和 SSD 的巨大潜力无法被充分释放 5。

02

NVMe PCIe:性能释放

为了彻底打破这一瓶颈,NVM Express (NVMe) 协议应运而生。它并非对旧有协议的修补,而是一个专为非易失性存储器(尤其是闪存)从零开始设计的全新标准 7。

其发展历程清晰地反映了行业对更高性能的迫切需求:概念于 2007 年提出,首个 1.0 规范于 2011 年发布,而首批商用产品则在 2013 年面市 1。NVMe 的核心架构优势体现在以下几个方面:

- 精简的协议栈: NVMe 通过 PCI Express (PCIe) 总线直接与系统 CPU 通信,绕过了传统的 SATA/SAS HBA 控制器,极大地缩短了数据路径 1。

- 大规模并行性: NVMe 支持多达 65,535 个命令队列,每个队列深度可达 65,536 条命令。这种设计允许每个 CPU 核心拥有独立的队列,从而消除了因争抢单一队列而产生的软件锁开销,实现了真正的并行 I/O 处理 5。

- 高效的命令集: NVMe 的基本命令集非常精简(仅需 13 个必需命令),显著降低了协议转换的 CPU 开销和处理延迟 11。

这种从根本上与多核 CPU 和并行闪存介质相匹配的设计,使 NVMe 成为了一次范式转移,从以介质为中心(优化 HDD 机械运动)转向以系统为中心(优化从 CPU 核心到闪存芯片的整个路径)的协议设计。

03

资源解耦的必然:NVMe网络扩展

尽管 NVMe over PCIe 极大地提升了本地存储性能,但它也带来了新的限制:性能优势被束缚在服务器机箱内部的直连存储 (DAS) 模式中 6。在现代数据中心架构中,计算和存储资源的独立扩展、灵活共享和提高利用率是核心诉求。DAS 模式导致的“存储孤岛”与这一趋势背道而驰。

为了解决这个问题,NVMe over Fabrics (NVMe-oF) 标准应运而生,其首个规范于 2016 年发布 1。NVMe-oF 的核心设计目标,是将 NVMe 的低延迟和高并发优势无缝扩展到网络结构(Fabrics)之上,从而构建出性能媲美本地存储的共享、可扩展、高效率的存储池 13。

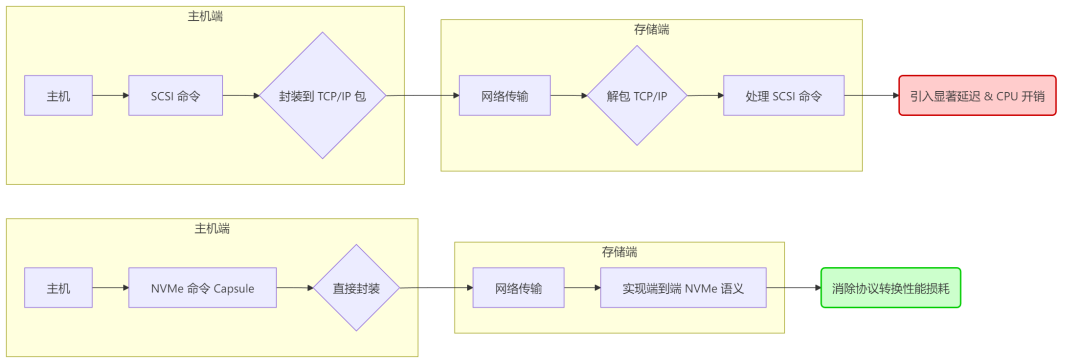

一个关键的设计原则是避免协议转换。传统的网络存储协议(如 iSCSI)需要在主机端将 SCSI 命令封装在 TCP/IP 包中,在存储端再解包,这个过程会引入显著的延迟和 CPU 开销 16。NVMe-oF 则通过直接封装 NVMe 命令(称为“Capsule”)并将其在网络上传输,实现了端到端的 NVMe 语义,从而消除了协议转换的性能损耗 9。

上图:传统的网络存储协议(如 iSCSI);下图:NVMe-oF

上图:传统的网络存储协议(如 iSCSI);下图:NVMe-oF

因此,NVMe-oF 的出现不仅是存储协议的演进,更是整个数据中心基础设施解耦(Disaggregation)趋势的关键赋能技术。它打破了“高性能必须本地化,灵活性必然慢速”的传统困境,为构建完全软件定义的、资源可自由组合的数据中心奠定了基础 2。

03

协议多样性的根源

原生应用场景剖析

NVMe-oF 领域呈现出多种传输协议并存的局面,这并非标准混乱的表现,而是一项深思熟虑的战略选择。NVM Express 联盟在设计之初便确立了“传输中立”的核心原则 13,旨在让 NVMe 技术能够融入并服务于数据中心中已经存在的、强大的、且拥有庞大投资和成熟生态的各种网络环境。每一种主流协议的诞生,都是为了满足一个特定生态系统的独特需求。

01

NVMe/FC:SAN守护

- 生态系统背景: 数十年来,光纤通道 (Fibre Channel, FC) 一直是企业级存储区域网络 (SAN) 的黄金标准。它以其固有的无损传输、可预测的稳定性能和高可靠性而著称,承载着全球无数企业的核心关键业务 10。企业在 FC 基础设施(包括 HBA 卡、交换机、光缆)以及更重要的——在相关的运营管理技能(如 Zoning 配置)上,已经投入了巨额资金 12。

- 协议设计意图: FC-NVMe (或 NVMe/FC) 的设计理念是“演进”而非“革命”。它通过将 NVMe 命令直接封装在 FC 帧内,实现了在与传统 FCP (SCSI over FC) 完全相同的物理网络设施上运行 10。这意味着企业无需更换昂贵的 FC 交换机和布线,只需升级服务器的 HBA 卡和存储阵列软件,即可享受到 NVMe 带来的性能飞跃。

- 原生应用场景: 一个典型场景是大型金融机构或医疗保健提供商,其关键的 Oracle 数据库、VMware 虚拟化集群或 SAP HANA 应用早已稳定运行在 FC SAN 环境中。通过引入 FC-NVMe,他们可以在不改变现有网络架构和管理流程的前提下,显著降低应用延迟,实现平滑、低风险的现代化升级 19。

02

NVMe/RDMA:极致性能

- 技术核心: 远程直接内存访问 (Remote Direct Memory Access, RDMA) 是一种网络技术,它允许网络中的一台计算机直接访问另一台计算机的内存,而无需涉及两者操作系统内核的参与 14。这种“内核旁路”机制最大程度地减少了数据通路上的软件处理开销,从而实现了最低的延迟和最小的 CPU 占用率 13。

- 协议分支与特点:

- InfiniBand (IB): 是一种为 RDMA 而生的专用高性能网络,是 HPC 和大规模数据分析集群的传统选择。NVMe over IB 自然成为这些环境的首选,但其市场局限于特定领域,且成本高昂 12。

- RoCE (RDMA over Converged Ethernet): 旨在将 InfiniBand 级别的性能带到更普及的以太网上。RoCEv2 是目前性能最高的以太网传输方案,但它有一个致命的部署前提——必须构建一个经过特殊配置的“无损网络”,这极大地增加了其部署和管理的复杂性 10。

iWARP (Internet Wide Area RDMA Protocol): 是另一种在以太网上实现 RDMA 的技术。它利用 TCP 进行流量控制,因此不强制要求无损网络,且具备路由能力。然而,其延迟通常高于 RoCE,且市场采纳率极低,已逐渐边缘化13。

- 原生应用场景: 对延迟要求达到极致的领域。例如,每一微秒都可能影响巨额利润的高频交易 (HFT) 平台;需要为昂贵的 GPU 集群提供海量、并行数据流以加速模型训练的人工智能/机器学习 (AI/ML) 集群;以及需要快速处理海量数据的科学计算和研究模拟 2。在这些场景中,极致的性能表现足以让用户接受其高昂的成本和复杂的部署要求。

03

NVMe/TCP:普及之路

- 诞生动机: NVMe/TCP 的出现,其核心目标是解决阻碍 NVMe-oF 广泛应用的最大障碍——FC 的专用性与 RDMA 的复杂性 28。

- 协议原理: 它将 NVMe 命令封装在标准的 TCP/IP 协议栈中进行传输。这意味着 NVMe/TCP 可以无缝运行在任何标准的以太网基础设施之上,包括企业中已有的普通网卡、交换机和路由器,无需任何特殊硬件 2。

- 市场定位: NVMe/TCP 被普遍视为传统 iSCSI 协议的现代化、高性能继任者。它提供了远超 iSCSI 的性能,同时保留了 TCP/IP 网络部署和管理的简易性与普适性 17。

- 原生应用场景: 任何寻求在标准以太网上实现高性能共享存储的场景。这包括构建可扩展存储服务的云服务提供商 (CSP),在标准以太网上部署超融合基础设施 (HCI) 的企业,以及任何希望从 iSCSI 升级以获得更高性能,但又不想投资专用网络的组织 17。

值得注意的是,RoCE 因其苛刻的无损网络配置要求(涉及 PFC、ECN 等复杂技术)而成为部署最复杂的协议之一 10。真正做到“易于使用”和“低成本”的,是能够利用现有通用以太网硬件和技术的 NVMe/TCP 2。本文必须明确澄清这一点:RoCE 的核心价值在于极致性能,而 NVMe/TCP 的核心价值在于部署简易性和成本效益。

04

NVMe-oF 协议对比分析

为了给技术决策者提供清晰的参考,本节将从协议栈、硬件依赖、网络管理和性能特征四个维度,对主流的 NVMe-oF 传输协议进行深入的技术剖析。

01

协议栈架构:封装与数据流

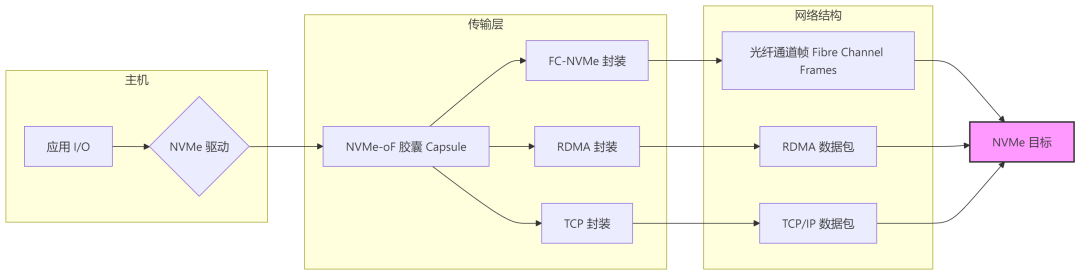

所有 NVMe-oF 协议的共同点在于,它们都需要将一个原生的 NVMe 命令(如一个提交队列条目)打包成网络传输的格式,即 NVMe-oF Capsule。不同之处在于它们如何将这个 Capsule 封装并交付给底层网络。

- FC-NVMe: 将 NVMe Capsule 直接封装进 FC-2 层的帧 (Frame) 中。这个过程很大程度上复用了现有的 FCP (Fibre Channel Protocol for SCSI) 映射机制,只是将负载从 SCSI 命令块换成了 NVMe Capsule,对 FC 网络而言是原生且高效的 20。

- NVMe/RDMA: 利用 RDMA 的语义(如 SEND/RECEIVE 操作)直接将 NVMe Capsule 放置到远程主机或目标的内存中。数据传输绕过了发送方和接收方的操作系统内核,实现了“零拷贝”,这是其超低延迟的关键 11。

- NVMe/TCP: 将 NVMe Capsule 封装成一个 TCP 数据流,然后由 TCP/IP 协议栈将其分段为标准的 IP 数据包,通过路由在网络上传输。整个过程与任何其他 TCP 应用(如 HTTP 或 FTP)在网络层面没有区别 33。

02

硬件依赖:网卡、HBA

- FC-NVMe: 强制要求使用 FC 主机总线适配器 (HBA) 和 FC 交换机。幸运的是,目前市场上主流的 16Gb、32Gb 及 64Gb FC 硬件通常都已具备 NVMe-ready 能力,支持通过软件升级开启 10。

- NVMe/RoCEv2: 需要专门的支持 RDMA 功能的网卡 (rNIC),并且,网络中的所有交换机都必须支持数据中心桥接 (Data Center Bridging, DCB) 技术族,以构建无损网络环境 24。

- NVMe/TCP: 对硬件的要求最低。它可以运行在任何标准的以太网卡 (NIC) 和标准的以太网交换机上,无需任何特殊硬件支持,这使其具备无与伦比的普适性 2。

03

网络配置与管理复杂性

- FC-NVMe: 沿用 FC SAN 成熟且被广泛理解的管理模式,如使用 World Wide Name (WWN) 进行 Zoning 来实现访问控制和安全隔离。虽然配置本身有一定复杂性,但对于经验丰富的 SAN 管理员来说非常熟悉 10。

- NVMe/RoCEv2: 是所有协议中配置和管理最复杂的。它要求在数据通路上的每一台主机和每一个交换机端口上,都精确且一致地配置好优先级流量控制 (Priority Flow Control, PFC) 和显式拥塞通知 (Explicit Congestion Notification, ECN)。任何一个环节的配置失误都可能导致数据包丢失,进而引发 RDMA 性能的灾难性下降和难以诊断的网络问题。这对网络团队的专业技能提出了极高要求 25。

- NVMe/TCP: 是最简单的。它本质上是一个标准的 TCP/IP 应用,无需对交换机进行任何特殊的无损配置,只需要保证基本的 IP 连通性即可。它天生支持路由,易于跨子网甚至广域网部署(尽管延迟会增加) 26。

04

性能特征分析

- 延迟 (Latency): RDMA (RoCE) 提供最低的延迟,通常可以做到端到端低于 100 微秒 (<100µs)。FC-NVMe 紧随其后,延迟在 100-300 微秒之间。NVMe/TCP 由于需要经过内核协议栈处理,延迟稍高,约在 200-400 微秒范围,但这仍然比毫秒 (ms) 级别的 iSCSI 快一个数量级 17。

- CPU 利用率 (CPU Utilization): RDMA 在数据传输过程中几乎不消耗主机 CPU 资源,因为所有的数据搬运工作都由 rNIC 的硬件引擎完成,这被称为“offload” 13。FC-NVMe 也通过 HBA 硬件卸载实现了较低的 CPU 开销。NVMe/TCP 则会产生最高的 CPU 开销,因为 TCP/IP 协议栈的处理是由主机 CPU 完成的。不过,随着现代 CPU 核心数增多和性能提升,以及 TCP 卸载引擎 (TOE) 等技术的应用,这一开销在实际应用中已变得可以接受 26。

- 综合性能分析: SNIA 进行的一项权威性能对比测试 37 证实,在 100Gb 以太网环境下,RDMA 传输(iWARP 和 RoCEv2)在 IOPS 和平均响应时间方面均显著优于未进行硬件卸载的 NVMe/TCP。该测试还发现,CPU 卸载是造成性能差异的关键因素,并且对于测试中的工作负载,使用 1500B 的标准 MTU 和 9000B 的巨型帧,性能差异并不明显。

下表对各种协议进行了结构化的总结对比,以便于决策者快速评估。

表 1:NVMe-oF 传输协议综合对比

特性 | NVMe/FC | NVMe/RoCEv2 | NVMe/TCP |

|---|---|---|---|

核心价值 | 可靠、平滑的企业级 SAN 升级 | 极致性能,最低延迟 | 简易、普适、高性价比 |

底层传输 | 光纤通道 (Fibre Channel) | RDMA over Ethernet | TCP/IP over Ethernet |

延迟概况 | 非常低 (约 100-300 µs) | 极低 (通常 < 100 µs) | 低 (约 200-400 µs) |

CPU 开销 | 低 (HBA 硬件卸载) | 极低 (rNIC 硬件卸载) | 较高 (主机内核处理) |

主机适配器 | FC HBA | RDMA NIC (rNIC) | 标准以太网 NIC |

交换机硬件 | FC 交换机 | 支持 DCB 的以太网交换机 | 标准以太网交换机 |

网络复杂性 | 中等 (需 Zoning 等专业知识) | 非常高 (需配置 PFC, ECN) | 低 (标准 IP 网络配置) |

可路由能力 | 否 (L2 协议) | 是 (基于 IP) | 是 (基于 IP) |

成本概况 | 高 (专用硬件) | 中到高 (rNIC 和高端交换机) | 低 (通用硬件) |

生态成熟度 | 非常高 (企业 SAN 市场) | 中等 (HPC/AI 利基市场) | 高速增长 (云和主流市场) |

主要应用场景 | 现有 FC SAN 环境中的数据库、虚拟化 | 高频交易、AI/ML 训练、HPC | 云存储、HCI、iSCSI 替代 |

05

行业采纳、部署挑战与应用案例

本节将理论与实践相结合,深入探讨 NVMe-oF 在真实世界中的部署挑战和具体应用场景,以展示不同协议如何解决不同问题。

01

RoCEv2部署挑战

RoCEv2 协议的强大性能是以巨大的部署复杂性为代价的。构建其所需的“无损以太网”远非“勾选一个选项”那么简单,它是一项涉及整个网络路径的系统工程,也是其被主流市场采纳的最大障碍。

挑战主要体现在以下方面:

- 端到端的一致性配置: 必须在每一台主机的 rNIC 和路径上所有交换机的每一个相关端口上,精确、一致地配置好拥塞管理机制,主要是优先级流量控制 (PFC) 和显式拥塞通知 (ECN) 25。

- 高昂的运维成本: 任何一个节点的配置错误或不一致,都可能导致数据包丢失。对于 RDMA 而言,丢包是灾难性的,会触发复杂的重传机制,导致性能急剧下降,并产生极难排查的“幽灵”网络问题。这要求企业拥有跨存储和网络领域的深度专业知识,而这两个团队在传统 IT 组织中通常是分离的 10。

- 缺乏标准化工具: 与 FC Zoning 的成熟工具链相比,RoCE 的配置和排错工具相对零散和复杂,进一步加大了管理难度。一个典型的部署过程可能涉及在主机端通过命令行工具设置 QoS 策略、在交换机端配置 PFC 和 ECN 阈值等多个步骤,每一步都可能出错 52。

02

案例:FC-NVMe

- 场景描述: 一家大型银行的核心交易系统或一家医院的电子病历 (EMR) 系统,运行在由 VMware vSphere 虚拟化的服务器集群上,后端连接着 Dell PowerMax 或 Pure Storage 的全闪存阵列,整个 SAN 环境基于 Brocade 的 FC 交换机构建。

- 解决方案与收益: 该组织决定将其存储网络从传统的 FCP (SCSI) 升级到 FC-NVMe。他们只需对存储阵列进行软件升级,并将服务器中的 FC HBA 更换为支持 NVMe 的新型号即可。底层的 FC 交换机和布线系统完全无需改动。升级后,他们观察到数据库事务处理的平均延迟降低了 30-50%,虚拟机的 vMotion 迁移和创建速度也显著加快。最重要的是,整个过程对业务几乎没有干扰,SAN 管理员仍然可以使用他们熟悉的 Zoning 工具进行管理,从而在保护了数百万美元的基础设施投资的同时,获得了巨大的性能回报,并降低了操作风险 19。

03

案例:NVMe/TCP

- 场景描述: 一家快速发展的 SaaS 公司,其核心产品基于 Kubernetes 容器化微服务架构,部署在本地数据中心或公有云的虚拟机上。他们需要一种高性能、可按需扩展、API 驱动且成本可控的持久化存储方案。

- 解决方案与收益: 该公司选择部署一个软件定义存储 (SDS) 解决方案,在标准的 x86 服务器上利用本地 NVMe SSD,通过 NVMe/TCP 协议构建出一个高性能的分布式存储池。由于采用了标准的以太网和 TCP/IP,他们可以像扩展计算节点一样轻松地增加存储节点,而无需关心复杂的网络配置。与之前使用的 iSCSI 方案相比,应用的 IOPS 提升了数倍,延迟降低了一个数量级。与考虑过的 RoCE 方案相比,他们节省了购买昂贵 rNIC 和高端交换机的成本,并避免了复杂的网络运维负担,从而能够将更多精力集中在核心业务应用的开发上 17。

04

案例:NVMe/RoCE

- 场景描述: 一家量化对冲基金公司和一所国家级科研机构的 AI 实验室。

- 解决方案与收益: 对于该基金公司,交易执行速度是其生命线。他们不惜成本构建了一个专用的、经过精心调优的 RoCE 网络,连接其算法交易服务器和后端的全闪存阵列。NVMe/RoCE 提供的端到端亚百微秒级延迟,使其能够在市场波动中获得纳秒级的竞争优势 24。对于 AI 实验室,其主要挑战是如何高效地将 PB 级的训练数据集喂给拥有数百个昂贵 GPU 的计算集群。通过部署 NVMe/RoCE,他们获得了极高的存储吞吐量和并行处理能力,将一个复杂的模型训练周期从几周缩短到了几天,极大地加速了科研进程 2。在这两个案例中,对极致性能的追求压倒了对成本和复杂性的考量,使得 NVMe/RoCE 成为唯一且必然的选择。

06

未来轨迹与战略建议

综合以上分析,本文对 NVMe-oF 的未来发展趋势进行预判,并为不同类型的组织提供具有可操作性的战略建议。

01

NVMe/TCP:事实标准

所有证据都指向一个清晰的未来:NVMe/TCP 将继承 iSCSI 的地位,成为网络存储领域的主流和事实标准,尤其是在所有新建(Greenfield)部署中 17。其成功源于一个无法抗拒的价值主张:它提供了“足够好”的高性能,同时结合了无与伦比的部署简易性、广泛的兼容性和成本效益。随着所有主流操作系统、虚拟化平台和存储供应商的全面支持,其生态系统日益成熟和稳固,为大规模采纳铺平了道路 29。

02

高价值市场:FC/RDMA

NVMe/TCP 的主流化并不意味着其他协议的消亡。相反,它们将在各自的优势领域继续发挥不可替代的作用:

- FC-NVMe 将在可预见的未来里,继续作为大型、风险规避型企业的 SAN 存储协议首选。对于全球数以万计已经部署了 FC SAN 的数据中心而言,FC-NVMe 提供了一条经过验证的、可靠的、低风险的现代化升级路径,其市场地位将因此而持久稳固 21。

- NVMe/RoCE 将继续作为性能金字塔的顶端,服务于那些“性能至上,成本次之”的特定环境。在高性能计算、大规模 AI/ML、实时分析和超低延迟金融服务等领域,它所能提供的极致性能是其他协议无法比拟的,这将确保其在高价值利基市场中的持续需求 2。

03

CXL与NVMe-oF融合

在展望 NVMe-oF 的未来时,不能忽视一个新兴且极具颠覆性的技术:Compute Express Link (CXL)。CXL 是一种开放的互连标准,它正在模糊内存与存储之间的界限 53。

CXL 与 NVMe-oF 并非直接的竞争关系,而是互补的。它们在未来的数据中心架构中将处于不同的层级,共同服务于资源解耦的终极目标:

- 访问层级不同: NVMe-oF 是一种块存储协议,工作在存储 I/O 层面,其延迟以微秒 (µs) 计。它解决了如何通过网络高效访问共享 SSD 池的问题 23。而 CXL 是一种 内存语义协议,工作在 CPU 的加载/存储 (load/store) 层面,其延迟以纳秒 (ns) 计。它旨在解决如何连接处理器与内存、加速器等设备的问题 54。

- 应用场景不同: NVMe-oF 的核心是存储解耦。而 CXL 的核心是内存解耦和内存池化,允许服务器访问远端的、可共享的内存资源,就如同访问本地 DRAM 一样。

- 协同工作模式: 未来的服务器架构将是一个分层的数据访问体系。应用程序可能会使用 CXL 来访问一个由 DRAM 或持久内存 (SCM) 组成的远程内存池,以扩展其本地内存容量。同时,该应用仍然会通过 NVMe-oF 协议来访问一个由海量闪存组成的、更大、更经济的共享存储池,以存放其主要的数据集。

因此,未来的数据中心不是 CXL 取代 NVMe-oF,而是一个CXL 与 NVMe-oF 共存的架构。CXL 负责处理延迟更低的“热”内存层,而 NVMe-oF 负责处理容量更大、成本更低的“温”存储层,两者共同构建一个完全解耦、资源可按需组合的计算和存储环境。

04

结论与可操作建议

基于本文的全面分析,为不同角色的决策者提供以下战略性建议:

- 对于拥有现有 FC SAN 的企业 IT 领导者:

- 行动建议: 将 FC-NVMe 作为您通往 NVMe 高性能世界最安全、最直接的路径。它能够最大程度地利用您现有的基础设施投资和团队的专业技能,从而在控制风险和颠覆性的同时实现性能现代化。

- 实施要点: 在您下一次的存储阵列和服务器 HBA 的采购和升级计划中,将对 FC-NVMe 的原生支持作为一项关键评估指标。

- 对于正在构建新一代云原生平台或 HCI 环境的架构师:

- 行动建议: 毫不犹豫地选择 NVMe/TCP 作为您的标准化网络存储协议。它为现代化的、软件定义的环境提供了性能、成本、可扩展性和管理简易性之间的最佳平衡。

- 实施要点: 投资于支持 NVMe/TCP 的存储解决方案,并关注 Linux 生态系统中相关管理工具(如 nvme-stas)的发展,以简化大规模部署和自动化运维。

- 对于身处极致性能驱动领域的机构负责人(如 HPC、AI 研究、金融科技):

- 行动建议: NVMe/RoCE 是满足您最苛刻工作负载性能要求的目标架构。其性能优势是无与伦比的,但您必须做好相应的投资准备。

- 实施要点: 这种投资不仅包括购买 rNIC 和高端交换机等硬件,更重要的是投资于能够设计、部署和维护无损以太网的专业网络人才。必须将网络视为整个高性能存储系统不可分割的一个精密组成部分。

参考资料

- What Is NVMe? - Supermicro, accessed on July 31, 2025, https://www.supermicro.com/en/glossary/nvme

- NVMe-oF™ Network Storage Protocol: NVMe™/TCP vs. RDMA with RoCEV2 - Western Digital, accessed on July 31, 2025, https://documents.westerndigital.com/content/dam/doc-library/en_us/assets/public/western-digital/collateral/white-paper/white-paper-open-flex-data24-roce-vs-tcp.pdf

- Help me understand what transfer/data protocols (NVMe, AHCI) actually are and how they interact with transfer interfaces (PCIe, SATA) : r/hardware - Reddit, accessed on July 31, 2025, https://www.reddit.com/r/hardware/comments/8d0ivn/help_me_understand_what_transferdata_protocols/

- NVMe and NVMEof: Significance to Modern Storage, accessed on July 31, 2025, https://www.aziro.com/blog/what-is-the-importance-of-nvme-and-nvme-of-in-modern-storage/

- Understanding SSD Technology: NVMe, SATA, M.2, accessed on July 31, 2025, https://www.kingston.com/en/ssd/what-is-nvme-ssd-technology

- NVME OVER FABRICS: NEW CLASS OF STORAGE | Dell Learning, accessed on July 31, 2025, https://learning.dell.com/content/dam/dell-emc/documents/en-us/2018KS_Sriramulu-NVMe_over_Fabrics_New_Class_of_Storage.pdf

- NVM Express - Wikipedia, accessed on July 31, 2025, https://en.wikipedia.org/wiki/NVM_Express

- Lets-Talk-Fabrics-NVMe-Over-Fabrics.pdf - SNIA.org, accessed on July 31, 2025, https://www.snia.org/sites/default/files/ESF/Lets-Talk-Fabrics-NVMe-Over-Fabrics.pdf

- NVMe-over-Fabrics: Enabling Next Generation Infrastructure - the Future of Memory and Storage, accessed on July 31, 2025, https://files.futurememorystorage.com/proceedings/2018/20180808_INVT-202B-1_Black.pdf

- FC-NVMe (NVMe over Fibre Channel) White Paper - Marvell, accessed on July 31, 2025, https://www.marvell.com/content/dam/marvell/en/public-collateral/fibre-channel/marvell-fibre-channel-nvme-over-fabrics-white-paper.pdf

- What is NVMe over Fabrics? - NVIDIA Enterprise Support Portal, accessed on July 31, 2025, https://enterprise-support.nvidia.com/s/article/what-is-nvme-over-fabrics-x

- When You're Implementing NVMe Over Fabrics, the Fabric Really Matters | NetApp Blog, accessed on July 31, 2025, https://www.netapp.com/blog/nvme-over-fabric/

- NVM Express over Fabrics | Chelsio Communications, accessed on July 31, 2025, https://www.chelsio.com/wp-content/uploads/resources/NVM_Express_Over_Fabrics.pdf

- What Is NVMe over Fabrics (NVMe-oF)? Benefits & Use Cases - StarWind, accessed on July 31, 2025, https://www.starwindsoftware.com/blog/what-is-nvme-of-nvme-over-fabrics/

- What is NVMe over Fabrics? | SNIA | Experts on Data, accessed on July 31, 2025, https://www.snia.org/education/what-is-nvme-of

- What Is NVMe over Fabric (NVMe-oF)? | Pure Storage, accessed on July 31, 2025, https://www.purestorage.com/au/knowledge/what-is-nvme-over-fabrics-nvme-of.html

- NVMe over TCP vs iSCSI: Evolution of Network Storage - Simplyblock, accessed on July 31, 2025, https://www.simplyblock.io/blog/nvme-over-tcp-vs-iscsi/

- Storage area network - Wikipedia, accessed on July 31, 2025, https://en.wikipedia.org/wiki/Storage_area_network

- NVMe over Fibre Channel: What You Need to Know - Enterprise Storage Forum, accessed on July 31, 2025, https://www.enterprisestorageforum.com/hardware/nvme-over-fibre-channel/

- Implementing and configuring modern SANs with NVMe-oF - NetApp, accessed on July 31, 2025, https://www.netapp.com/media/10681-tr4684.pdf

- Benefits of NVMe over FIbre Channel - YouTube, accessed on July 31, 2025, https://www.youtube.com/watch?v=y2pibif16ek

- NVMe over FC - Simplyblock, accessed on July 31, 2025, https://www.simplyblock.io/glossary/what-is-nvme-over-fc/

- NVMe over Fabrics (NVMe-oF): What IT Leaders Need to Know Now, accessed on July 31, 2025, https://elevatetechcommunity.org/resource/NVMe-over-Fabrics

- NVMe over RoCE - Simplyblock, accessed on July 31, 2025, https://www.simplyblock.io/glossary/what-is-nvme-over-roce/

- Lossless Network for AI/ML/Storage/HPC with RDMA - Arista, accessed on July 31, 2025, https://www.arista.com/assets/data/pdf/Broadcom-RoCE-Deployment-Guide.pdf

- NVMe over Fabrics (NVMe-oF): TCP vs. RDMA for Ethernet Storage - Intelligent Visibility, accessed on July 31, 2025, https://intelligentvisibility.com/nvme-over-fabrics-ethernet-comparison

- NVMe Over TCP Will Take Time to Eclipse RDMA - Lightbits Labs, accessed on July 31, 2025, https://www.lightbitslabs.com/news/nvme-over-tcp-will-take-time-to-eclipse-rdma/

- Announcing NVMe/TCP for ONTAP - NetApp, accessed on July 31, 2025, https://www.netapp.com/blog/announcing-nvme-tcp-for-ontap/

- Boost Your Workload Performance with NVMe/TCP - Dell Technologies, accessed on July 31, 2025, https://www.dell.com/en-us/blog/boost-your-workload-performance-with-nvme-tcp/

- A Beginner's Guide to Lightning-Fast Data Access with NVMe Storage - Lightbits Labs, accessed on July 31, 2025, https://www.lightbitslabs.com/blog/nvme-storage-a-beginners-guide-to-lightning-fast-data-access/

- Lightbits for Financial Services - Cloud Data Platform, accessed on July 31, 2025, https://www.lightbitslabs.com/solutions/cloud-storage-financial-services/

- Configuring Lossless Ethernet for NVMe over RDMA - Broadcom TechDocs, accessed on July 31, 2025, https://techdocs.broadcom.com/us/en/vmware-cis/vsphere/vsphere/7-0/vsphere-storage-7-0/about-vmware-nvme-storage/requirements-for-vmware-nvme-storage/configuring-lossless-ethernet-for-nvme-over-rdma.html

- NVMe/TCP Byte Stream - Dell Technologies Info Hub, accessed on July 31, 2025, https://infohub.delltechnologies.com/l/technical-overview-of-nvme-tcp/nvme-tcp-byte-stream/

- From HPE to Dell EMC and NetApp, our experts stack up the leading AFA vendors & their platforms., accessed on July 31, 2025, https://cdn.ttgtmedia.com/searchStorage/downloads/Exclusive_Look_at_AFA_Solutions_Vendors.pdf

- Lossless Network for RDMA White Paper - FS.com, accessed on July 31, 2025, https://resource.fs.com/mall/resource/cn_lossless-network-for-rdma-white-paper-20250626115109.pdf

- Storage Protocols - NVIDIA Docs Hub, accessed on July 31, 2025, https://docs.nvidia.com/networking/display/mlnxofedv24100700/storage+protocols

- White Paper April 2021 Storage Networking Industry ... - SNIA.org, accessed on July 31, 2025, https://www.snia.org/sites/default/files/education/snia-optimizing-nvme-over-fabrics-nvme-of.pdf

- NVM Express Releases NVM Express Specifications to Unify AI, Cloud, Client, and Enterprise Storage - Business Wire, accessed on July 31, 2025, https://www.businesswire.com/news/home/20240806863916/en/NVM-Express-Releases-NVM-Express-Specifications-to-Unify-AI-Cloud-Client-and-Enterprise-Storage

- NVM Express Releases NVMe 2.1 Specifications | TechPowerUp Forums, accessed on July 31, 2025, https://www.techpowerup.com/forums/threads/nvm-express-releases-nvme-2-1-specifications.325310/

- T11 - Fibre Channel - INCITS, accessed on July 31, 2025, https://www.incits.org/committees/t11/FCoEwww.fibrechannel.orgwww.fibrechannel.org

- Fibre Channel Standards - Broadcom Inc., accessed on July 31, 2025, https://www.broadcom.com/support/fibre-channel-networking/san-standards/fc-standards

- Status update for tcpm WG - Datatracker - IETF, accessed on July 31, 2025, https://datatracker.ietf.org/group/tcpm/about/status/

- NVMe over Fabric Network Requirement - IETF, accessed on July 31, 2025, https://www.ietf.org/archive/id/draft-nof-requirement-00.html

- draft-wang-nof-framework-01 - Datatracker, accessed on July 31, 2025, https://datatracker.ietf.org/doc/html/draft-wang-nof-framework

- Pure storage support - Hewlett Packard Enterprise Community, accessed on July 31, 2025, https://community.hpe.com/t5/hpe-morpheus-vm-essentials/pure-storage-support/td-p/7251923

- Release Notes: NVMe-oF Compatibility with VMware vSphere, accessed on July 31, 2025, https://support.purestorage.com/bundle/m_release_notes_for_vmware_solutions/page/Solutions/VMware_Platform_Guide/Release_Notes_for_VMware_Solutions/topics/reference/r_pure_storage_products.html

- Empowering Azure Storage with RDMA - Microsoft, accessed on July 31, 2025, https://www.microsoft.com/en-us/research/wp-content/uploads/2023/03/RDMA_Experience_Paper_TR-1.pdf

- Azure Accelerated Networking: SmartNICs in the Public Cloud - Microsoft, accessed on July 31, 2025, https://www.microsoft.com/en-us/research/wp-content/uploads/2018/03/Azure_SmartNIC_NSDI_2018.pdf

- AWS vs Azure vs GCP: A Comprehensive Guide to Cloud Network Routing Services - Megaport, accessed on July 31, 2025, https://www.megaport.com/blog/aws-azure-google-cloud-the-big-three-compared/

- Amazon EBS volumes and NVMe, accessed on July 31, 2025, https://docs.aws.amazon.com/ebs/latest/userguide/nvme-ebs-volumes.html

- Persistent Disk: durable block storage | Google Cloud, accessed on July 31, 2025, https://cloud.google.com/persistent-disk

- An idiot's walkthrough to setting up NVMEoF/RoCE between TrueNAS Scale 24.04 and Windows 11 client - Reddit, accessed on July 31, 2025, https://www.reddit.com/r/truenas/comments/1fh3rfl/an_idiots_walkthrough_to_setting_up_nvmeofroce/

- Non-volatile Memory Express (NVMe) Market to Hit USD 412.1 - openPR.com, accessed on July 31, 2025, https://www.openpr.com/news/3988847/non-volatile-memory-express-nvme-market-to-hit-usd-412-1

- Regional SDC Austin 24: CXL® and NVMe® Collaborating for Computation - YouTube, accessed on July 31, 2025, https://www.youtube.com/watch?v=gKAipzZeFe4

- CXL Memory Disaggregation and Tiering: Lessons Learned from Storage - SNIA.org, accessed on July 31, 2025, https://www.snia.org/educational-library/cxl-memory-disaggregation-and-tiering-lessons-learned-storage-2023

Notice:Human's prompt, Datasets by Gemini-2.5-Pro-DeepResearch

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-08-10,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录