YOLOv13-pose关键点检测:新颖的特征融合方法-金字塔稀疏 Transformer(PST),助力pose检测

原创YOLOv13-pose关键点检测:新颖的特征融合方法-金字塔稀疏 Transformer(PST),助力pose检测

原创

💡💡💡本文改进:提出金字塔稀疏 Transformer(PST)——一个轻量级、即插即用的模块,通过由粗到细的 token 选择机制和共享注意力参数,在大幅降低计算量的同时保留空间细节。

💡💡💡YOLOv13+PST Pose mAP50 为0.909, YOLOv13 Pose mAP50 为0.893,相较于YOLO11的Pose mAP50 为 0.871 ,大幅提升

《YOLOv13魔术师专栏》将从以下各个方向进行创新:

【原创自研模块】【多组合点优化】【注意力机制】【卷积魔改】【block&多尺度融合结合】【损失&IOU优化】【上下采样优化 】【小目标性能提升】【前沿论文分享】【训练实战篇】

定期向订阅者提供源码工程,配合博客使用。

订阅者可以申请发票,便于报销

💡💡💡为本专栏订阅者提供创新点改进代码,改进网络结构图,方便paper写作!!!

💡💡💡适用场景:红外、小目标检测、工业缺陷检测、医学影像、遥感目标检测、低对比度场景

💡💡💡适用任务:所有改进点适用【检测】、【分割】、【pose】、【分类】等

💡💡💡全网独家首发创新,【自研多个自研模块】,【多创新点组合适合paper 】!!!

☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️ ☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️

包含注意力机制魔改、卷积魔改、检测头创新、损失&IOU优化、block优化&多层特征融合、 轻量级网络设计、25年最新顶会改进思路、原创自研paper级创新等

🚀🚀🚀 本项目持续更新 | 更新完结保底≥80+ ,冲刺100+ 🚀🚀🚀

⭐⭐⭐专栏原价299,越早订阅越划算⭐⭐⭐

💡💡💡 2025年计算机视觉顶会创新点适用于YOLOv12、YOLO11、YOLOv10、YOLOv8等各个YOLO系列,专栏文章提供每一步步骤和源码,轻松带你上手魔改网络 !!!

💡💡💡重点:通过本专栏的阅读,后续你也可以设计魔改网络,在网络不同位置(Backbone、head、detect、loss等)进行魔改,实现创新!!!

☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️ ☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️☁️

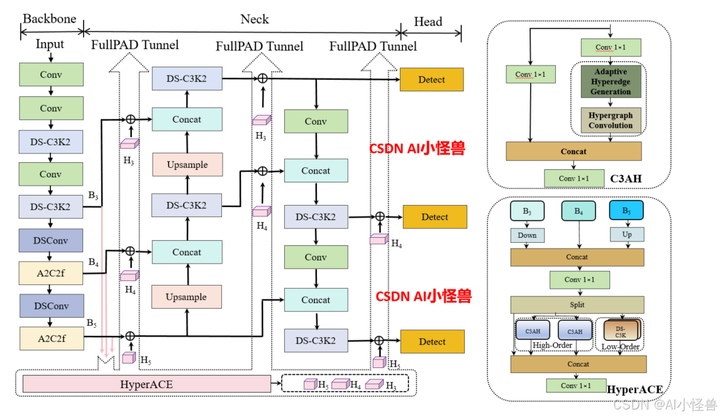

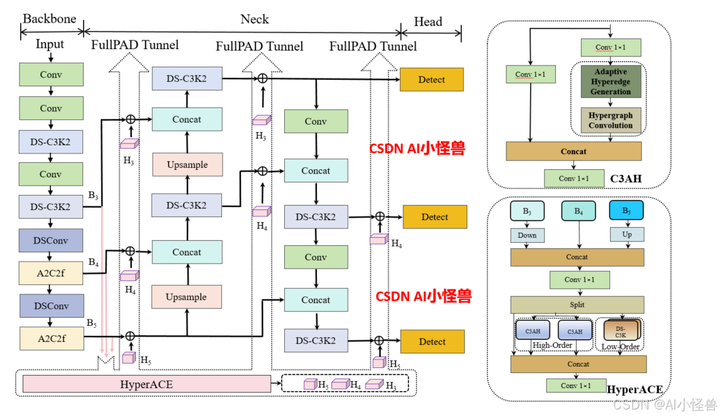

1.YOLOv13介绍

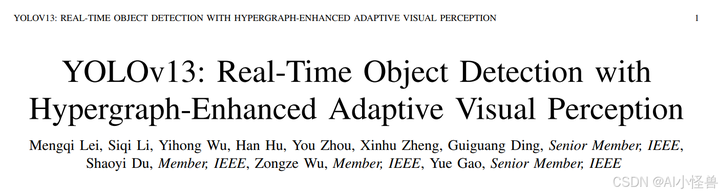

论文:[2506.17733] YOLOv13: Real-Time Object Detection with Hypergraph-Enhanced Adaptive Visual Perception

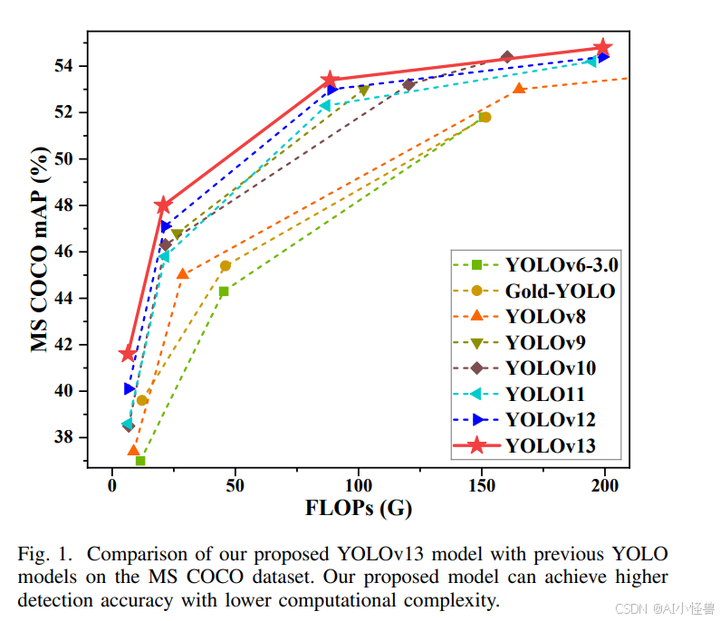

摘要—YOLO 系列模型因其卓越的准确性和计算效率在实时目标检测领域占据主导地位。然而,无论是 YOLO11 及更早版本的卷积架构,还是 YOLOv12 引入的基于区域的自注意力机制,都仅限于局部信息聚合和成对相关性建模,缺乏捕捉全局多对多高阶相关性的能力,这限制了在复杂场景下的检测性能。本文提出了一种准确且轻量化的 YOLOv13 目标检测器。为应对上述挑战,我们提出了一种基于超图的自适应相关性增强(HyperACE)机制,通过超图计算自适应地利用潜在的高阶相关性,克服了以往方法仅基于成对相关性建模的限制,实现了高效的全局跨位置和跨尺度特征融合与增强。随后,我们基于 HyperACE 提出了全链路聚合与分配(FullPAD)范式,通过将相关性增强特征分配到整个网络,有效实现了全网的细粒度信息流和表征协同。最后,我们提出用深度可分离卷积代替常规的大核卷积,并设计了一系列块结构,在不牺牲性能的前提下显著降低了参数量和计算复杂度。我们在广泛使用的 MS COCO 基准测试上进行了大量实验,结果表明,我们的方法在参数更少、浮点运算量更少的情况下达到了最先进性能。具体而言,我们的 YOLOv13-N 相比 YOLO11-N 提升了 3.0% 的 mAP,相比 YOLOv12-N 提升了 1.5% 的 mAP。

以往的 YOLO 系列遵循 “骨干网络 → 颈部网络 → 检测头” 的计算范式,这本质上限定了信息流的充分传输。相比之下,我们的模型通过超图自适应关联增强(HyperACE)机制,实现全链路特征聚合与分配(FullPAD),从而增强传统的 YOLO 架构。因此,我们提出的方法在整个网络中实现了细粒度的信息流和表征协同,能够改善梯度传播并显著提升检测性能。具体而言,如图 2 所示,我们的 YOLOv13 模型首先使用类似以往工作的骨干网络提取多尺度特征图 B1、B2、B3、B4、B5,但其中的大核卷积被我们提出的轻量化 DS-C3k2 模块取代。然后,与传统 YOLO 方法直接将 B3、B4 和 B5 输入颈部网络不同,我们的方法将这些特征收集并传递到提出的 HyperACE 模块中,实现跨尺度跨位置特征的高阶关联自适应建模和特征增强。随后,我们的 FullPAD 范式利用三个独立通道,将关联增强后的特征分别分配到骨干网络与颈部网络的连接处、颈部网络的内部层以及颈部网络与检测头的连接处,以优化信息流。最后,颈部网络的输出特征图被传递到检测头中,实现多尺度目标检测。

ultralytics/cfg/models/v13/yolov13.yaml

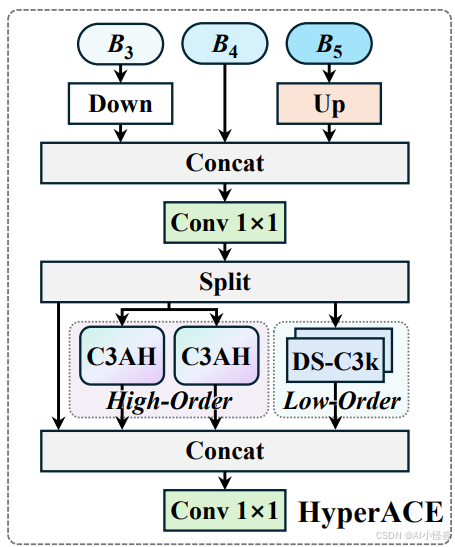

1.1 HyperACE

超图自适应相关性增强机制 HyperACE

- 超图理论借鉴与创新 :借鉴超图理论,将多尺度特征图的像素视为超图顶点,不同的是,传统超图方法依赖手工设定参数构建超边,而 HyperACE 设计了可学习的超边生成模块,能自适应地学习并构建超边,动态探索不同特征顶点间的潜在关联。

- 超图卷积操作 :在生成自适应超边后,通过超图卷积操作进行特征聚合与增强。每条超边先从其连接的所有顶点处聚合信息形成高阶特征,再将这些高阶特征传播回各个顶点,更新与增强顶点特征,从而实现高效地跨位置和跨尺度的特征融合与增强,强化不同尺度特征间的语义关联,对小目标和密集目标检测效果显著。

代码位置ultralytics/nn/modules/block.py

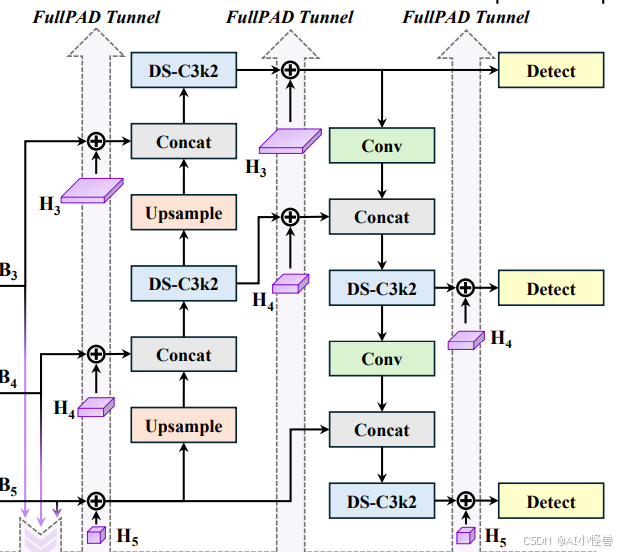

1.2 FullPAD_Tunnel

全流程聚合 - 分发范式 FullPAD

- 多通道特征传递 :打破传统的 “骨干→颈部→头部” 单向计算范式,通过三条独立通路传递特征,即主干 - 颈部连接层、颈部内部层、颈部 - 头部连接层,将 HyperACE 聚合后的多尺度特征,通过这些 “隧道” 分发回网络的不同位置,实现细粒度信息流与全流程表征协同。

- 改善梯度传播 :该范式有效解决了梯度消失或爆炸问题,显着改善了梯度传播效率,从而提升模型整体的检测性能,使模型在复杂场景下能够更好地捕捉目标特征,提高检测的准确性和稳定性。

代码位置ultralytics/nn/modules/block.py

1.3 DSC3k2

基于深度可分离卷积的轻量化模块

- 模块创新与替代 :采用深度可分离卷积构建了 DSConv、DS-Bottleneck、DS-C3k 等模块,替代传统的大核卷积。例如使用 DS-C3k2 模块作为轻量化的骨干网络提取多尺度特征,在保持感受野的同时,大幅降低了参数量与计算量,提高了模型的计算效率。

- 性能与效率平衡 :在几乎不牺牲性能的前提下,显著减少了模型的参数量和计算复杂度,使得 YOLOv13 能够在保持较高检测精度的同时,具备更快的推理速度,适合实时目标检测应用场景,降低了模型的部署难度和资源消耗。

代码位置ultralytics/nn/modules/block.py

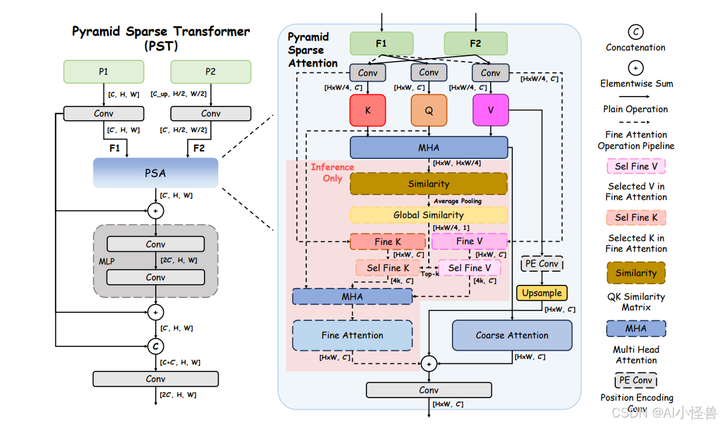

2.新的特征融合方法(PST)原理介绍

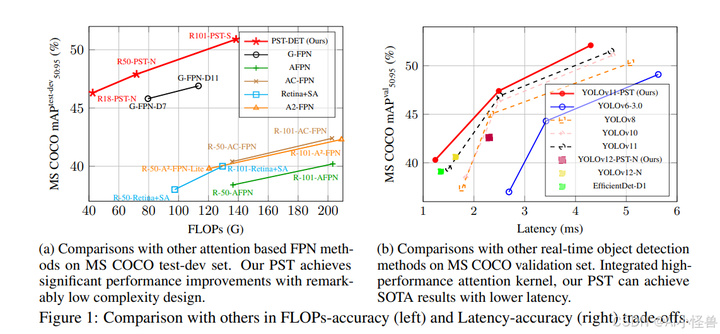

摘要:特征融合对高性能视觉模型至关重要,但往往会带来难以承受的计算复杂度。然而,主流的基于注意力的融合方法通常计算开销巨大、实现复杂,在资源受限的场景中效率低下。针对这一问题,我们提出金字塔稀疏 Transformer(PST)——一个轻量级、即插即用的模块,通过由粗到细的 token 选择机制和共享注意力参数,在大幅降低计算量的同时保留空间细节。PST 训练阶段仅使用粗粒度注意力即可,推理时无需重新训练即可启用更精细的注意力,从而进一步提升精度。

将 PST 嵌入当前最先进的实时检测模型(YOLOv11-N/S/M)后,在 MS COCO 上的 mAP 分别提升 0.9%、0.5%、0.4%,而延迟增加极小。同样地,把 PST 作为骨干网络嵌入 ResNet-18/50/101,可在 ImageNet 上将 Top-1 准确率分别提高 6.5%、1.7%、1.0%。这些结果充分证明,PST 是一种简单、硬件友好的通用增强方案,可无缝应用于检测与分类任务。

基于这一共识,我们提出了 Pyramid Sparse Transformer(PST)。如图 2 所示,PST 摒弃了传统自注意力中 Q、K、V 来自同一特征图的做法 [41, 13],转而采用交叉注意力:高层特征作为 K、V,而查询 Q 来自低层特征图,利用图像的层级语义引导细粒度融合 [46]。通过让富含语义的高层 token 引导对低层细节的关注,PST 在减少 token 交互的同时提升了上下文对齐性与判别力。

此外,我们用卷积位置编码(Convolutional Positional Encoding, CPE)模块取代了传统的可学习或正弦位置嵌入,该模块借鉴自 CvT [48]。具体而言,我们在注意力后对每个特征图施加 7×7 深度可分离卷积 [6, 40]。

图 2:Pyramid Sparse Transformer(PST)整体结构。左:PST 以相邻两层特征图为输入,用我们提出的 Pyramid Sparse Attention(PSA) 块替换标准注意力。为了兼顾硬件友好与高效,所有 Linear 和 LayerNorm 层均替换为 1×1 卷积 + BatchNorm(借鉴 EfficientFormer [24])。此外,最后的特征拼接融合了 CSPNet [43]、ELAN [45] 和 C3K2 [44] 等已被大量实验验证的高效特征聚合设计。右:PSA 先执行跨层粗粒度注意力,再按得分挑选 top-k 精细 token 进行稀疏精修注意力,最后将两次输出相加作为最终结果。

源码详见:

https://cv2023.blog.csdn.net/article/details/151310696

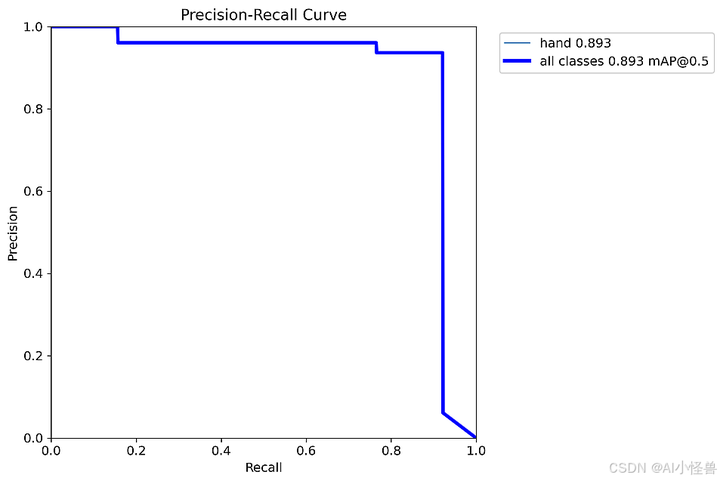

3 训练结果分析

200个epoch以后,训练结果可视化如下:

Pose mAP50 为0.893,相较于YOLO11的Pose mAP50 为 0.871 ,大幅提升

YOLO11-pose关键点检测:训练实战篇 | 自己数据集从labelme标注到生成yolo格式的关键点数据以及训练教程(一)_yolov11 pose-CSDN博客

YOLOv13-pose summary: 554 layers, 2,821,743 parameters, 0 gradients, 7.7 GFLOPs

Class Images Instances Box(P R mAP50 mAP50-95) Pose(P R mAP50 mAP50-95): 100%|██████████| 2/2 [00:04<00:00, 2.07s/it]

all 64 64 0.998 1 0.995 0.874 0.691 0.922 0.922 0.893 0.893 0.72PosePR_curve.png

预测结果如下:

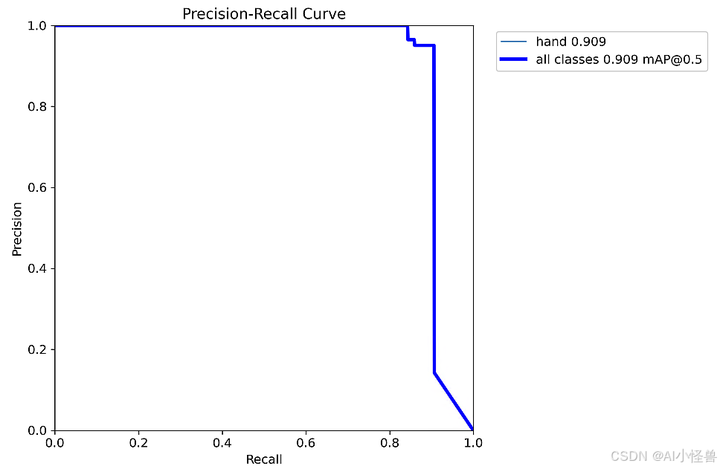

3.1 加入新的特征融合方法(PST)

YOLOv13+PST Pose mAP50 为0.909, YOLOv13 Pose mAP50 为0.893,相较于YOLO11的Pose mAP50 为 0.871 ,大幅提升

YOLOv13-pose-PST summary: 538 layers, 2,796,655 parameters, 0 gradients, 7.4 GFLOPs

Class Images Instances Box(P R mAP50 mAP50-95) Pose(P R mAP50 mAP50-95): 100%|██████████| 2/2 [00:04<00:00, 2.01s/it]

all 64 64 0.999 1 0.995 0.724 0.651 0.906 0.906 0.909 0.9 0.728

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。