YOLO26震撼发布!边缘AI推理速度提升43%,目标检测迎来全新变革

原创YOLO26震撼发布!边缘AI推理速度提升43%,目标检测迎来全新变革

原创

北京时间2025年9月25日,在伦敦举行的YOLO Vision 2025大会上,Ultralytics创始人兼CEO Glenn Jocher正式发布了备受期待的YOLO26。作为YOLO系列的最新成员,YOLO26承诺成为更好、更快、更小的Vision AI模型,专门为边缘和低功耗设备设计。

为什么YOLO26是游戏规则改变者?

YOLO26并非简单的版本升级,而是一次理念上的革新。它的架构遵循三个核心原则:简单性、部署效率和训练创新。

与传统YOLO模型最大的区别在于,YOLO26是原生端到端模型,无需非极大值抑制(NMS)后处理即可直接生成预测结果。这一突破性方法最初由清华大学的王敖在YOLOv10中首创,并在YOLO26中得到了进一步发展。

这意味着推理过程更快、更轻便,也更容易部署到现实世界的系统中。

核心技术突破:四大创新设计

1. 彻底告别DFL模块

YOLO26完全移除了分布焦点损失(DFL)模块。虽然DFL有效,但它常常使导出复杂化并限制了硬件兼容性。这一简化大大扩展了对边缘和低功耗设备的支持。

2. 端到端无NMS推理

与依赖NMS作为单独后处理步骤的传统检测器不同,YOLO26直接生成最终预测结果。这消除了整个管道阶段,显著减少延迟,使部署更加稳健。

3. 全新的MuSGD优化器

YOLO26引入了MuSGD优化器,它是SGD和Muon的混合体,灵感来自Moonshot AI在LLM训练中取得的Kimi K2突破。这一创新将语言模型中的优化技术应用到了计算机视觉领域,带来更稳定的训练和更快的收敛速度。

4. 增强的损失函数

结合ProgLoss和STAL等改进的损失函数,YOLO26在检测精度上有所提高,尤其在小物体识别方面有显著改进。这对于物联网、机器人、航空图像和其他边缘应用至关重要。

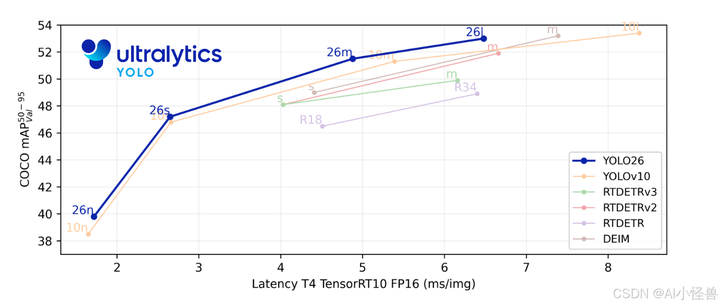

性能提升:数字说明一切

根据官方公布的性能预览,YOLO26在标准CPU上的推理速度相比前代模型最高可提升43%。这一提升对于资源受限的环境来说是一个重大飞跃。

以下是YOLO26系列模型的早期性能预览:

模型 | 尺寸(像素) | mAPval 50-95 | 速度 CPU ONNX (ms) | 参数(M) | FLOPs(B) |

|---|---|---|---|---|---|

YOLO26n | 640 | 40.3 | 38.90 ± 0.7 | 2.4 | 5.4 |

YOLO26s | 640 | 47.6 | 87.16 ± 0.9 | 9.5 | 20.7 |

YOLO26m | 640 | 51.7 | 220.0 ± 1.4 | 20.4 | 68.2 |

YOLO26l | 640 | 53.4* | 286.17 ± 2.0* | 24.8 | 86.4 |

YOLO26l和YOLO26x的测量仍在进行中

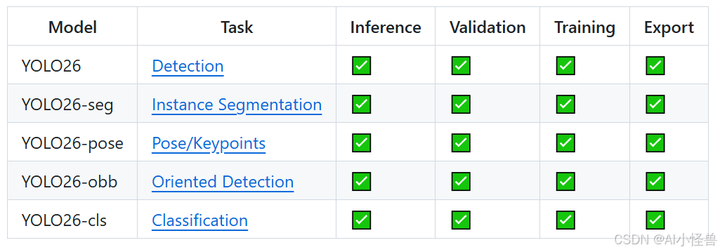

多任务支持:一站式的视觉AI解决方案

YOLO26延续了Ultralytics模型的多功能传统,支持广泛的计算机视觉任务:

- 目标检测:识别和定位图像或视频帧中的多个物体

- 实例分割:生成像素级完美的物体边界

- 图像分类:将整个图像归类到特定类别或标签

- 姿态估计:检测人体和其他物体的关键点及姿态

- 定向边界框(OBB):检测任意角度的物体,特别适用于航拍和卫星图像

- 目标跟踪:跨视频帧或实时流跟踪物体

这种统一框架使YOLO26成为真正多功能的视觉AI解决方案,适用于从实时检测到分割、分类、姿态估计和定向物体检测的各种任务。

实际应用场景:从机器人到智能交通

YOLO26的轻量化和高精度特性,使其在多个行业展现巨大潜力:

在机器人技术领域,YOLO26能帮助机器人实时解读周围环境,使导航更加顺畅,物体处理更加精确。在制造业中,它可以实现自动化缺陷检测,比人工检测更快、更准确地识别生产线上的缺陷。

对智能交通系统而言,YOLO26能在低功耗硬件上实现实时监控与预警。而在无人机与遥感领域,通过OBB功能,它可以检测复杂角度的地面物体。

部署灵活性:一次训练,随处部署

YOLO26支持多种导出格式,包括TensorRT、ONNX、CoreML、TFLite和OpenVINO等。这种灵活的部署选项使YOLO26可以轻松集成到现有工作流程,并兼容几乎所有平台。

得益于简化的架构,YOLO26还完美支持INT8量化与FP16半精度推理,在保证精度的前提下进一步减小模型体积、提升速度。这意味着YOLO26不仅能在服务器集群中高速运行,也能在手持设备、智能相机等边缘环境中稳定工作。

何时可以体验YOLO26?

根据官方信息,YOLO26模型仍在训练中,尚未开源。目前展示的是性能预览,计划在2025年10月底正式公开发布。

对于急切想体验YOLO26的开发者,可以关注Ultralytics GitHub仓库,加入全球开发者社区,共同推动计算机视觉的发展。

结语:视觉AI的未来之路

YOLO26的发布标志着实时目标检测领域的又一个重要里程碑。通过端到端简化、架构优化和训练创新,YOLO26为计算机视觉带来了全新的速度与灵活性。

正如Glenn Jocher在YOLO Vision 2025大会上所言:“最大的挑战之一,就是在保持卓越性能的同时,让用户最大化利用YOLO26的简单性与高效性。”

随着边缘AI的快速发展,YOLO26的出现正当其时。它有望成为连接边缘AI与企业级系统的桥梁,推动计算机视觉技术走向更广泛的实际应用。

让我们一起期待2025年10月底YOLO26的正式发布,见证视觉AI的新纪元!

本文基于Ultralytics官方文档及YOLO Vision 2025大会发布内容编写,部分性能数据为早期预览版本,最终性能以正式发布版本为准。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。