Agentic AI 时代的内存(2)-从HBM到分层存储架构

Agentic AI 时代的内存(2)-从HBM到分层存储架构

数据存储前沿技术

发布于 2025-11-20 13:37:09

发布于 2025-11-20 13:37:09

阅读收获

- 掌握智能体AI的三层记忆架构:深入理解工作记忆、程序性记忆和语义记忆的技术差异及其在AI推理中的协同作用

- 了解RAG系统的硬件需求:学习大规模向量数据库对TB级内存容量和高带宽的具体技术要求

- 获得内存技术选型指导:掌握HBM、MRDIMM、CMM-D等不同内存技术的适用场景和性能特点

- 构建分层存储架构能力:学会设计热-温-冷三层内存架构,优化AI系统的性能与成本平衡

全文概览

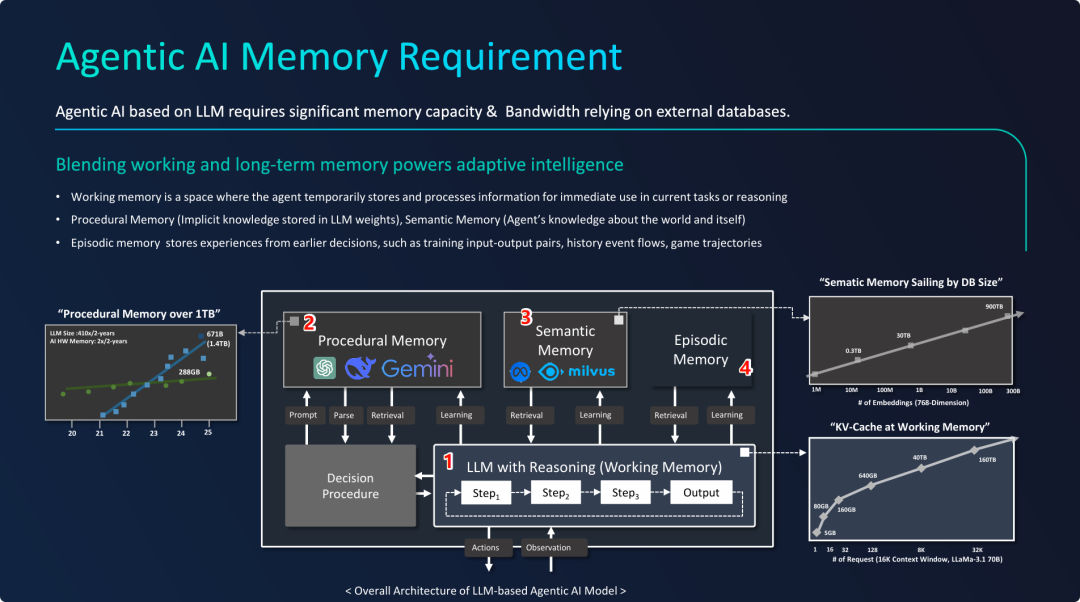

随着大模型参数量的指数级增长和RAG(检索增强生成)技术的广泛应用,AI系统对内存的需求已经达到了TB级甚至数十TB级的规模。这种复杂的记忆架构不仅对存储容量提出了极高要求,更需要满足数百GB/s的带宽需求。本文将带您深入探讨智能体AI如何通过HBM、MRDIMM和CMM-D等创新内存技术,构建分层存储架构来应对这些挑战,实现精准可靠的AI推理能力。

👉 划线高亮 观点批注

智能体AI的内存需求

智能体AI的内存需求

语义记忆的定义与作用

语义记忆的定义与作用

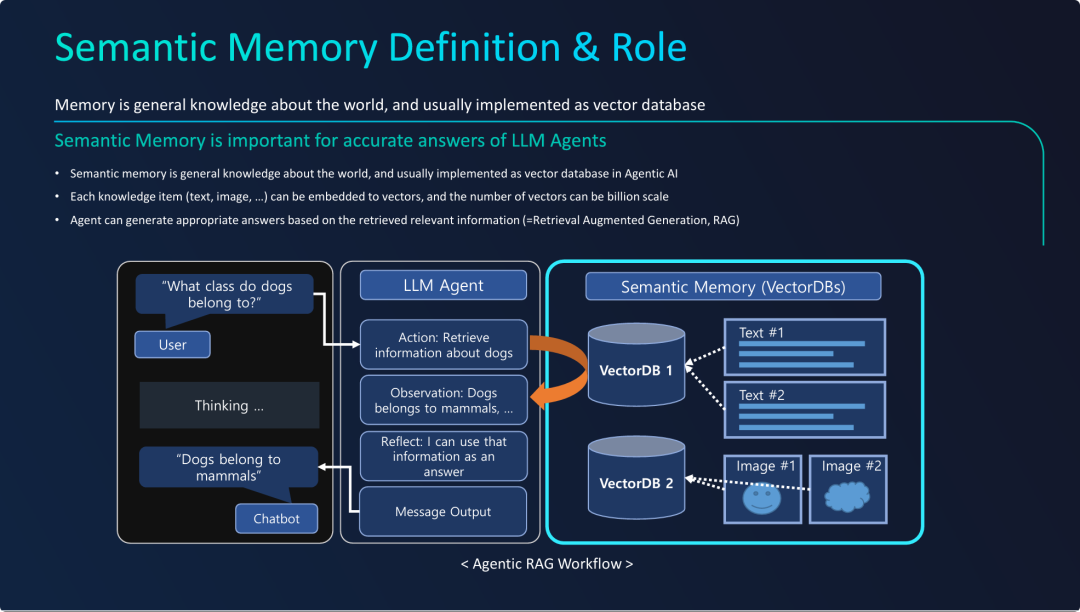

PPT的核心观点是,语义记忆作为一种外部、可扩展的知识库,是构建精准、可靠的智能体AI(Agentic AI)的关键组成部分。

- 定义与实现: 语义记忆是AI关于世界事实的知识,其标准技术实现是向量数据库。它将海量的、多模态的非结构化数据(文本、图片等)转化为可供机器检索的向量。

- 核心作用: 它的主要作用是提升LLM回答的准确性。通过引入外部知识源,可以有效减少大模型的“幻觉”现象,确保回答基于事实,并且知识可以被轻松地更新和扩展,而不必重新训练整个大模型。

- 关键技术 - RAG: 实现语义记忆价值的核心技术是检索增强生成(RAG)。PPT的工作流清晰地展示了RAG的“先检索,后生成”模式:智能体不再仅仅依赖其内部知识(程序性记忆)来“创作”答案,而是首先从外部知识库中“查找”相关依据,然后再基于这些依据来组织和生成回答。

- 架构解耦: 这种架构实现了推理能力(LLM Agent)与知识存储(VectorDBs)的解耦。LLM负责理解、推理和生成,而向量数据库负责存储和管理海量的、动态的知识,这使得整个系统更加灵活、强大和可信。

Samsung 曾在FMS23 上提出 Memory-Semantic SSD 的概念产品,当时topic 主旨指向存内计算,通过在SSD内集成DRAM缓存来加速应用层的语义搜索和算子下推,和此处强调的向量数据库是有差别的,后者在AI场景的应用更为成熟。

语义记忆的需求

语义记忆的需求

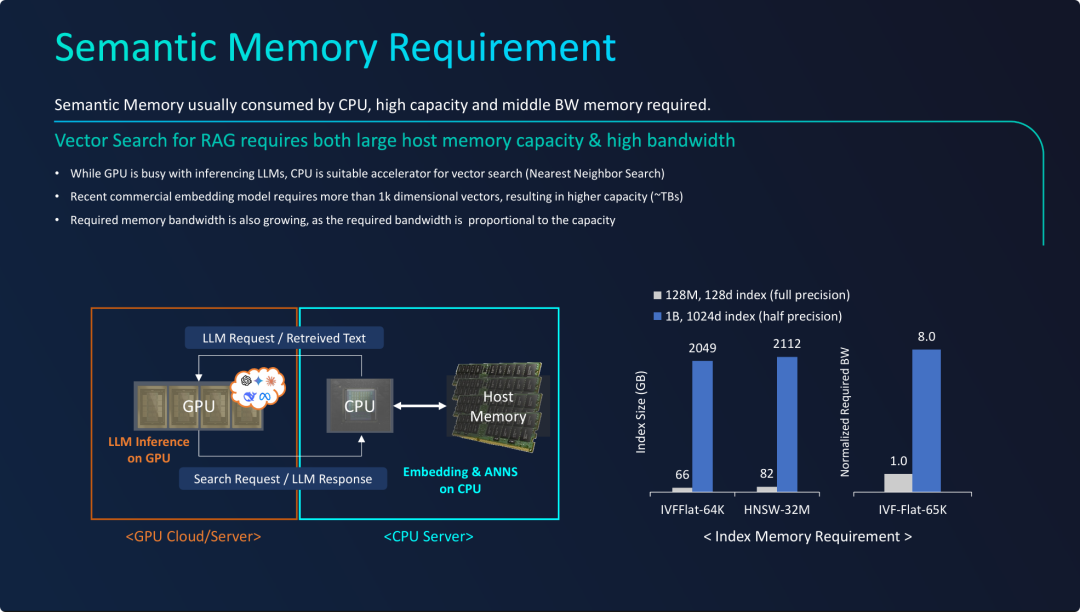

PPT的核心观点是,实现大规模语义记忆(向量数据库)在硬件上提出了以CPU为中心、需求“TB级容量”和“高带宽”主机内存的独特挑战。

- 提出“GPU+CPU”异构架构: RAG系统的最佳实践是将任务解耦:使用昂贵且专业的GPU资源处理LLM推理(程序性记忆),同时利用相对成本较低且拥有海量内存扩展性的CPU服务器来处理向量搜索(语义记忆)。

- 量化了“TB级”容量需求: 通过图表数据明确指出,一个商业规模(10亿条目,1k维度)的向量数据库索引,其内存占用会轻松超过 2TB。这意味着普通的服务器内存配置已无法满足需求,必须采用高密度大容量内存方案。

- 揭示了带宽与容量的强关联性: 强调了容量和带宽的“水涨船高”关系。当索引库大小增长几十倍时,为了保证检索效率(SLA),内存带宽也需要相应提升数倍。仅仅拥有大容量是不够的,还必须保证足够快的存取速度,否则语义记忆的检索会成为整个RAG流程的瓶颈。

MRDIMM:语义记忆的DRAM解决方案

MRDIMM:语义记忆的DRAM解决方案

MRDIMM作为下一代服务器内存技术,旨在同时解决语义记忆场景面临的“超大容量”和“高带宽”两大核心痛点。

- 直击痛点: 此前分析指出,大规模向量数据库需要TB级的内存容量和随之增长的数百GB/s的带宽。MRDIMM技术精准地回应了这两个需求,是为下一代AI和数据密集型应用量身定制的内存解决方案。

- 提供数量级的提升: MRDIMM带来的不是渐进式改良,而是数量级的飞跃。

- 容量上: 单条 512GB 的内存将极大地提升服务器的内存密度,使得在单个CPU服务器内容纳数TB的向量索引变得更加容易和经济。

- 性能上: 带宽翻倍(从6.4Gbps提升到12.8Gbps)将有效缓解因索引规模扩大而带来的性能瓶颈,确保检索效率。 MRDIMM 是如何实现内存带宽翻倍的,可参考阅读:DRAM 带宽升级,拿什么拯救你?

- 技术路线分化: 这张PPT与之前介绍HBM的幻灯片共同描绘了一幅清晰的AI内存技术蓝图:

- 程序性记忆 (GPU侧): 依赖于与计算核心紧密耦合、提供超高带宽的 HBM。

- 语义记忆 (CPU侧): 依赖于可大规模扩展、兼具海量容量和高带宽的 MRDIMM。

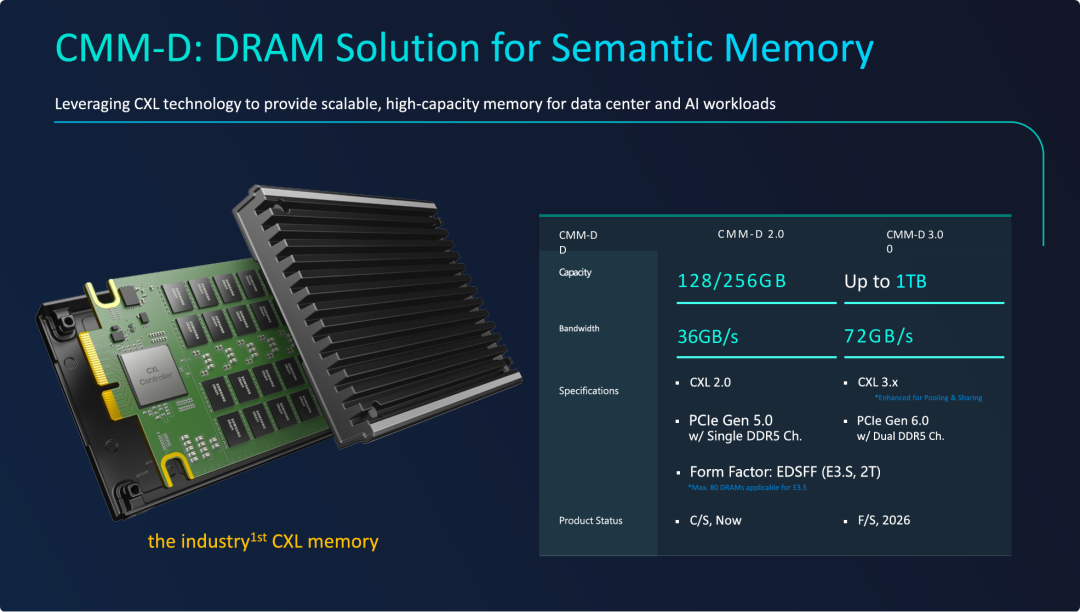

CMM-D:语义记忆的DRAM解决方案

CMM-D:语义记忆的DRAM解决方案

CMM-D,作为一种基于CXL协议的内存扩展模块,为语义记忆提供了区别于传统DIMM的、一种全新的“可扩展”解决方案。

- 全新的内存扩展范式:

- 与前一张PPT的MRDIMM(在CPU原生内存通道上提升性能和密度)不同,CMM-D通过PCIe接口来扩展内存。这打破了服务器主板上固定DIMM插槽数量的限制,使得内存容量的**横向扩展(Scale-out)**成为可能。

- 实现海量内存池:

- 单模块高达1TB的容量,意味着服务器可以轻松地将内存扩展到数十TB,为存储和处理超大规模的向量数据库(万亿级别)提供了硬件基础。

- 未来的内存池化与共享:

- CXL 3.x技术将允许构建跨服务器机柜的内存资源池。这意味着内存可以从单个服务器中解耦出来,按需分配给不同的计算任务。这对于提高资源利用率、降低数据中心TCO(总拥有成本)具有革命性的意义。

- 性能与定位(权衡):

- 从带宽数据(36-72 GB/s)可以看出,CXL内存的带宽低于CPU直连的多通道DDR5/MRDIMM内存(数百GB/s),且延迟也更高。

- 因此,CMM-D并非要取代CPU的本地内存(Local Memory),而是作为一种**内存扩展层(Expansion Tier)**存在。

最终结论: 未来的AI服务器内存架构很可能是一个分层系统:

- 第0层 (Hot Tier): GPU内的HBM,用于程序性记忆。

- 第1层 (Warm Tier): CPU直连的DDR5/MRDIMM,用于操作系统和最核心、最热的向量索引数据。

- 第2层 (Cold Tier): 通过CXL连接的CMM-D,构成海量的内存池,用于存储完整的、超大规模的向量数据库。

MRDIMM 和 CMM-D 的容量与带宽优势

MRDIMM 和 CMM-D 的容量与带宽优势

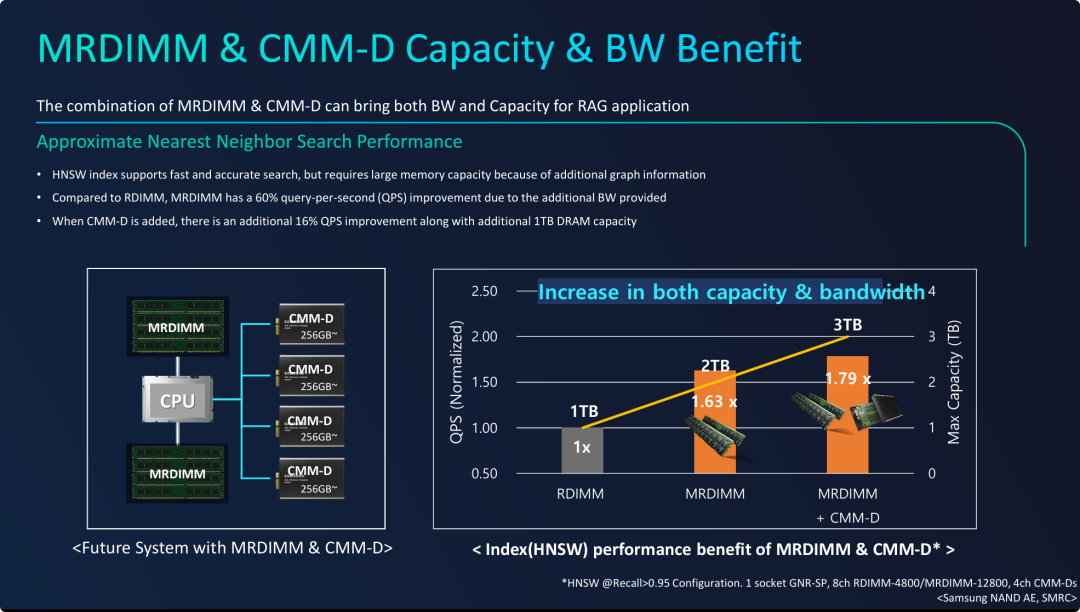

为语义记忆构建一个“MRDIMM + CMM-D”的分层内存架构,是实现性能与容量最大化的最佳策略。

- 协同效应而非替代关系: MRDIMM和CMM-D并非相互竞争的技术,而是互补的协同关系。它们共同构成了一个功能完备的内存子系统,能够同时满足RAG应用对“高带宽”和“大容量”的苛刻要求。

- 量化的性能阶梯: 图表提供了一个清晰的升级路径和量化的收益预期:

- 第一步 (升级本地内存): 将服务器的本地内存从RDIMM升级到MRDIMM,这是提升核心性能的第一步,能带来约 60% 的QPS增益。

- 第二步 (扩展内存容量): 在此基础上,通过CMM-D模块进一步扩展内存,不仅能将系统总容量提升到新的量级(如从2TB到3TB),还能带来额外的性能红利(约16%)。

- 未来架构的蓝图: 这张幻灯片最终描绘了未来AI服务器(特别是用于RAG和向量数据库的服务器)的理想内存架构:

- 使用MRDIMM作为与CPU紧密耦合的 “热”数据层,利用其高带宽处理最高频、对延迟最敏感的查询负载。

- 使用CMM-D作为可大规模扩展的 “温”数据层,利用其灵活性和高密度来承载TB乃至数十TB级别的完整向量索引。

延伸思考

这次分享的内容就到这里了,或许以下几个问题,能够启发你更多的思考,欢迎留言,说说你的想法~

- 在当前技术条件下,如何平衡HBM的高带宽优势与CMM-D的大容量扩展性,为不同规模的AI应用设计最优的内存架构方案?

- 随着CXL 3.x技术的发展,内存池化将成为可能。这种技术将如何改变数据中心的内存资源分配模式,对AI工作负载的弹性和成本效益会产生哪些深远影响?

- 面对智能体AI对内存需求的持续增长,除了现有的HBM、MRDIMM和CMM-D技术路线,您认为未来5年内还会出现哪些突破性的内存技术创新来应对这一挑战?

原文标题:Heterogeneous Memory Opportunity [1]with Agentic AI and Memory Centric Computing

Notice:Human's prompt, Datasets by Gemini-2.5-Pro

#FMS25 #AI/RAG

---【本文完】---

公众号:王知鱼,专注数据存储、云计算趋势&产品方案。

PPT取自 Samsung 资深系统架构师 Jinin So,在FMS 2025 闪存峰会上的汇报材料。

👇阅读原文,查看历史文章,推荐PC端打开 💻。

- https://files.futurememorystorage.com/proceedings/2025/20250807_DRAM-304-1_SO.pdf ↩

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-10-09,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读