大白话企业级智能体(AI Agent):从RAG、MCP、A2A到AI基础设施产业落地攻略

大白话企业级智能体(AI Agent):从RAG、MCP、A2A到AI基础设施产业落地攻略

AGI小咖

发布于 2025-12-22 11:40:32

发布于 2025-12-22 11:40:32

01

智能体的定义

如果说去年是大型语言模型(LLM)的元年,那么今年可以称之为智能体(AI Agent)的元年,根据智能体(AI Agent)架构和组成方式不同,智能体可进一步分为两类:

- 狭义智能体:核心在于模型本身原生支持工具调用与任务闭环执行,能够在无需持续人工干预的情况下,实现自我学习与优化,具备高度的环境适应与泛化能力。

- 广义智能体:泛指一切能够感知环境、决策和执行任务以达成目标的系统——基于“模型推理能力(Reasoning)+ 任务指令(Instruction)”实现“引导式自主”(Guided Autonomy),并通过“工作流(Workflow)+ 工具调用(Tool Use)”完成“预定义行动”(Pre-defined Action)。

02

智能体核心灵魂组成部分

2.1 智能体运行时核心组件

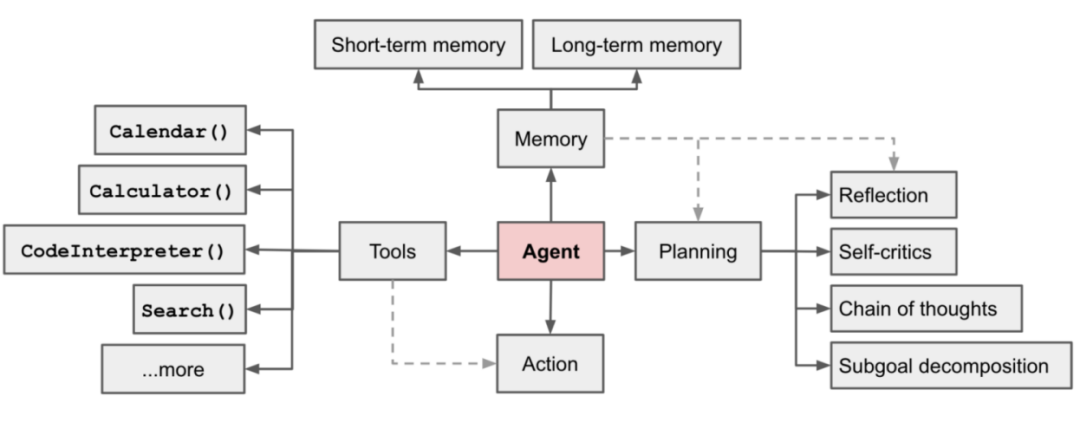

用一个简洁公式概括智能体的核心构成:智能体(AI Agent) = 大语言模型 (LLM) + 记忆 (Memory) + 规划 (Planning) + 工具 (Tools)+反馈(Reflection),智能体核心组件介绍如下:

图1:智能体的核心组件

- 大语言模型(LLM) :推理是智能体的核心认知过程,涉及使用逻辑和可用信息来得出结论、进行推断和解决问题。

- 记忆 (Memory) 与上下文 (Context):包括用于即时对话的短期记忆以及通过外部数据库(如向量数据库)实现的、用于用于知识沉淀和经验累积,长期记忆对于智能体进行有效的推理和规划极为关键。

- 规划 (Planning):当智能体接收到一个模糊的、复杂需求时,规划模块(结合“思维树”等高级规划技术)会将其分解为一系列具体的、可执行的子任务。

- 工具 (Tools) / 函数调用 (Function Calling):智能体能够调用外部工具(如API、数据库)来感知环境、获取模型权重中缺失的实时信息(如天气)汇总后执行下一步动作。

- 反馈(Reflection):智能体通过评估自己先前行动的结果和中间步骤的质量后根据评估结果动态地调整后续规划。

2.2 RAG (检索增强生成)在企业落地最佳实践

检索增强生成(RAG)技术辅助智能体提升信息存储利用率,提高信息更新速度,增强内容生成的可追溯性,支持智能体的持续学习和迭代。RAG 技术结合了信息检索(Retrieval)和文本生成(Generation),通过从外部知识库中检索相关信息来辅助生成更准确和上下文相关的文本这不仅是解决知识性幻觉、“开卷考试”的条件,从根本上降低了其“凭空捏造”的风险。

在企业级的复杂场景中,Naive RAG即简单地将用户问题向量化后进行搜索效果往往不佳,迫切需要采用更先进的RAG技术栈解决召回率(Recall)和精准度(Precision)的瓶颈,企业级RAG优化主要核心步骤如下:

- 通过查询转换(Query Transformation)解决用户查询与文档间的“语义鸿沟”,涉及的关键技术包括HyDE (Hypothetical Document Embeddings)(即利用LLM生成假设性答案后向量化这个“假设答案”去匹配知识库的)、Step-Back Prompting(即将具体问题泛化以获取宏观背景进而为LLM提供解决具体问题所需的上下文的进行匹配)、Multi-Query(即将复杂问题分解为多个并行的子问题查询后再将所有召回的上下文汇总以提高召回率)。

- 结合向量检索(擅长理解“语义相似性”)和关键词检索(术语)的混合检索 (Hybrid Search) 能确保召回的全面性。

- 使用更轻量、更精准的“重排序模型” (Reranking)对初步召回的Top 50个文档进行重新打分排序结果进行精筛,最终仅将最相关的Top-K文档喂给LLM,从而在保证召回率的同时极大提升精准度,降低了LLM处理Token的成本。

随着RAG技术的发展,智能体在调用RAG技术时变得更加智能和高效,尤其是在面对复杂的需要多级拆解的问题时:

- Agentic RAG:智能体(AI Agent)在执行任务时会自主决策按需调用RAG工具来查询外部知识,这时候RAG变成了智能体工具箱中一个可被动态编排的组件

- GraphRAG :解决标准RAG无法处理的复杂“多跳问题”的利器,使用知识图谱(Knowledge Graph, KG)代替(或补充)向量数据库来存储精确的“关系”。通过图查询语言(如Cypher)在图谱上进行精确的关系遍历进行精确的“关系遍历”,而非模糊的语义相似性搜索,从而精准锁定答案从而精准锁定答案。对于企业内部高度依赖关系(如组织架构、供应链、资产依赖)的知识库,GraphRAG是实现深度推理问答的必要架构。

03

智能体成熟度模型:从简单工具到自主集群

腾讯研究院的《企业级智能体产业落地研究报告》提供了一个极具价值的 L1-L5 能力分级框架,模型的核心划分依据是智能体的自主性以及它与人类的协作关系,市场上主流智能体“绝大多数产品仍停留在 L1-L2 级别”,例如企业落地的“数字员工”主要是 L1 的智能知识库和 L2 的流程自动化助手,但是Gartner 预测到 2028 年70% 的 AI 应用将使用多智能体系统(L5)。

等级 | 名称 | 角色类比 | 核心特征 | 典型技术 | 典型应用 |

|---|---|---|---|---|---|

L1 | 被动执行 | 问答客服 | “你问我答”:能理解指令,但依赖预设提示词或 RAG。 | Prompt + RAG | 智能客服、知识库问答 |

L2 | 项目助理 | 工具使用者 | “你让我做,我就做”:能调用工具,但必须在预定义的工作流内执行。 | Workflow + RAG + Function Calling | 自动查订单、发邮件、会议预订 |

L3 | 初级项目负责人 | 规划执行者 | “你说目标,我来规划”:能理解模糊任务,自主规划多步骤,动态调用工具。 | ReAct / Plan-and-Execute | 生成会议纪要、写周报、规划旅行 |

L4 | 专业骨干 | 主动贡献者 | “我发现问题,我来解决”:能主动感知环境(如 CRM 数据变化),自主发起任务。 | 环境感知 + L3 能力 | 智能营销(发现客户流失风险并主动触达) |

L5 | 领导者 | 团队协调者 | “我来组织”:能定义目标,并将复杂系统工程分解给其他 L2-L4 智能体(或人类)协同完成。 | Multi-Agent (多智能体) 协同 | 自动化软件开发、虚拟项目组 |

表1:L1-L5 能力分级框架

04

主流平台与框架对比:智能体构建者的工具箱

4.1 主流低代码平台对比:Coze VS Dify VS n8n

Coze 和 Dify 是原生智能体平台(以 LLM 为核心),n8n 是自动化平台(以流程为核心)。

平台 | 定位 | 核心优势 | 局限性 | 适合谁/适合场景 |

|---|---|---|---|---|

Coze (扣子) | C 端创作者平台 | 免费、插件丰富、一键发布(飞书/豆包),对非开发岗极其友好。 | 私有化能力弱且有严格的资源限制(如总知识库容量10GB 、工作流超时10分钟),难以满足企业级需求。 | 互联网产品经理,快速验证 C 端创意和 Demo。 |

Dify.ai | 开源+企业级 LLM 应用平台 | 平衡易用性与专业性。支持私有化部署、国产模型、知识库精细管理。 | 流程编排(Workflow)能力相对 n8n 较弱。 | 企业应用专家,在私有化/国产化环境中构建严肃的 B 端应用。 |

n8n | 自动化工作流引擎 | 极其强大的流程编排(Workflow),连接器(Connector)极多。 | LLM 能力是“外挂”的,而非原生。智能体(Agent)概念较弱。 | 解决方案架构师,核心是“流程自动化”(RPA+AI)而非“智能体”。 |

表2:Coze VS Dify VS n8n平台对比

4.2 框架的核心思想:LangChain & LlamaIndex

- LangChain:“链” (Chains) 和“智能体” (AI Agents) ,提供了构建复杂、多步骤智能体工作流所需的所有模块(如记忆、提示词、工具),适用于一个对话式智能体,需要执行多个步骤、调用多种工具并拥有复杂的“记忆”。

- LlamaIndex:“高级 RAG” (Advanced RAG) ,当您的 RAG 需求变得复杂时(如需要层级检索、GraphRAG或融合多文档),LlamaIndex提供了更专业的解决方案。

05

智能体的“社会化”:协同、协议与互联

由于每个智能体往往只擅长特定领域的一件或者一类任务,复杂事件的完成需要多个不同功能的智能体一起完成,那么智能体之间如何协同、协议与互联的呢?不同公司纷纷推出了支持智能体互联的协议,可以分为上下文协议和智能体交互协议两类,其中前一类比较典型的有Anthropic的模型上下文协议(model context protocol,MCP),后一类比较典型的有智能体网络协议(agent network protocol,ANP)、谷歌的智能体对智能体协议(Agent2Agent,A2A)等。

5.1 新兴的AI协议“三件套”

以下是新兴的AI协议“三件套”核心协议草案(资料来源:中国信通院、中移/联通白皮书等):

- MCP (Model Context Protocol): “AI的USB-C接口”,解决的是Agent ↔ 工具的问题,基于JSON-RPC 2.0规范,定义了Agent 调用外部工具(API) 的标准。

- A2A (Agent-to-Agent) / ACP (Agent Control Protocol):“AI的HTTP协议”,解决的是 Agent ↔ Agent 的问题,A2A允许智能体通过一个标准化的“智能体名片”(Agent Card)来广播和发现彼此的能力,目标是实现统一 Agent 之间协作通信的标准,定义任务分配、角色扮演等。

- AG-UI (Agent User Interaction):“AI的WebSockets”,解决的是Agent ↔ 用户的问题,AG-UI定义了一个轻量级的事件流协议(基于HTTP/SSE)——用于传输如 TEXTMESSAGECONTENT(流式文本)、TOOLCALLSTART(工具调用开始)、STATE_DELTA(状态变更)等标准事件,目标是实现统一Agent 与前端用户界面的交互标准。

5.2 产业落地:应用场景蓝图

图2:智能体应用场景

上图清晰地展示了智能体在金融、零售、文旅、教育、医学、出行、互联网等14个行业上百个具有代表性的智能体应用场景(图片来源于《企业级智能体产业落地研究报告》),其核心价值还体现在识别出那些最迫切需要“自主生产力”的业务环节,并设计出“稳定可用”乃至“成熟好用”的智能体解决方案,推动技术从“可能”走向“可行”,从“可行”走向“价值”。

另外IDC数据显示,超过64%的中国企业已进入智能体的测试验证和采购培训阶段,预计到2028年中国企业级智能体应用市场规模将达到270 亿美元。与此同时,生成式AI正加速渗透各个领域,2028年预计中国生成式AI占AI市场总投资规 模比例将达到30.6%,突破300亿美元,五年年复合增长率(CAGR)高达51.5%。当前,软件与信息服务行业以41亿美元领跑投资规模,预计2028年将达149亿美元;此外,医疗健康、能源、制造、交通出行和教育五大行业投资增速值得关注,预计将保持在64.3%-67.2%的高速年复合增长率,展示出强大发展潜力。

06

结论

如果说去年是大模型的元年,那么今年是智能体的(AI Agent)的元年,与此同时,智能体正推动AI基础设施从“资源规模导向”转向“业务价值创造”。智能体需要的不再是通用的算力,而是对特定能力的支撑。智能体的规模化落地,对AI基础设施提出了四大全新要求:

- Agent运行时的支撑:需要云原生架构(如容器和Serverless)来高效、弹性地承载Agent运行时环境。

- 长周期上下文的保持:需要专门的内存优化设计,以支持Agent保持长周期的记忆和上下文。

- 多智能体协同:需要支持Agent协同的架构以及支撑μs(微秒)级延迟的实时推理网络,以满足Agent间的连续决策需求。

- 安全与观测:需要安全沙箱来运行Agent的代码,并提供Agent的可观测性(Observability)来调试其复杂的决策链。

AI基础设施的演进加速智能体落地:反过来,新一代的AI基础设施正在通过提供“AI Agent服务平台”来加速智能体的落地。未来的AI基础设施不再仅仅是“卖算力”,而是会提供包括Agent运行时、安全沙箱、可观测性工具、乃至MCP协议栈等开箱即用的技术组件。这使得我们不必从零开始构建智能体的“身体”和“神经系统”,极大地降低了构建和部署智能体的门槛,让智能体的规模化应用成为可能。

往

期

回

顾

三大超节点:昇腾384 VS 阿里磐久AL128 VS NVIDIA GB200 NVL72,网工视角,谁主沉浮? 博通一统以太网江湖阳谋:SUE一超多强(字节Ethlink、NVLink与UALink)?

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-11-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读