5万吊打百万级SOTA!UTS新作VideoCoF:首创“帧链思维”统一视频编辑模型,效果惊艳!

5万吊打百万级SOTA!UTS新作VideoCoF:首创“帧链思维”统一视频编辑模型,效果惊艳!

AI生成未来

发布于 2025-12-25 14:06:41

发布于 2025-12-25 14:06:41

作者:Xiangpeng Yang等

解读:AI生成未来

亮点直击

- 首创“帧链”(Chain-of-Frames)范式:借鉴 CoT 思维,强制模型先预测编辑区域,再生成目标视频,实现了从“模糊指令”到“精准区域”的显式映射。

- 极高的数据效率:仅使用 50k 视频对进行微调,就在指令遵循和成功率上超越了经过百万级数据训练的 SOTA 模型。

- Infinite 长视频外推能力:独特的 RoPE 对齐策略解决了长视频位置编码失效问题,支持处理训练长度 4 倍以上的视频,且无任何故障。

- 全能编辑表现:在 VideoCoF-Bench 中,无论是多实例移除、添加、替换,还是局部风格迁移,均取得了最佳的定量和定性结果。

在视频生成领域,如何精准地按照人类指令编辑视频一直是个难题。现有的方法要么依赖复杂的 Mask(掩码)导致无法统一模型,要么虽然统一但缺乏空间定位能力,导致编辑“指鹿为马”。 近日,来自悉尼科技大学(UTS)和浙江大学的研究团队提出了一种全新的解决方案——VideoCoF。受到大语言模型中“思维链”(Chain-of-Thought)的启发,他们提出了“帧链”(Chain-of-Frames)机制:强制视频扩散模型在生成编辑结果前,先“看”原视频,再“推理”出编辑区域,最后执行“编辑”。

这种“看 -> 推理 -> 编辑”的新范式,不仅摆脱了人工 Mask 的依赖,还极大地提升了编辑的精准度。 在数据效率上,VideoCoF 仅使用了 50k(5万) 训练数据,就超越了使用百万级数据训练的基线模型!

论文标题: Unified Video Editing with Temporal Reasoner 论文链接: https://arxiv.org/abs/2512.07469 项目主页: https://videocof.github.io/ 代码仓库: https://github.com/knightyxp/VideoCoF

总结速览

解决的问题

- 精度与统一性的两难困境:现有的专家模型依赖掩码,精度高但模型无法统一;而统一的上下文模型虽然架构简洁,但缺乏显式的空间提示,导致指令与区域映射微弱,定位不准。

- 长视频外推能力缺失:现有模型通常难以处理超出训练时长的视频,简单的时序拼接会导致位置编码失效,产生运动错位或伪影。

提出的方案

- VideoCoF 框架:提出了一种受思维链(CoT)启发的“帧链”(Chain-of-Frames)方法,将视频编辑重构为“看 -> 推理 -> 编辑”的串行过程。

- 显式推理机制:强制视频扩散模型在生成目标视频之前,不同于ChronoEdit等隐式的采用reasoning token的方式(无ground truth的reason token),VideoCoF先预测代表编辑区域的“推理 Token”(推理帧),从而实现无掩码的精准编辑。

应用的技术

- 灰度渐变推理帧:通过实验发现,使用渐变透明度的灰色高亮区域作为推理帧,比纯黑掩码或红框更能有效引导模型进行空间推理。

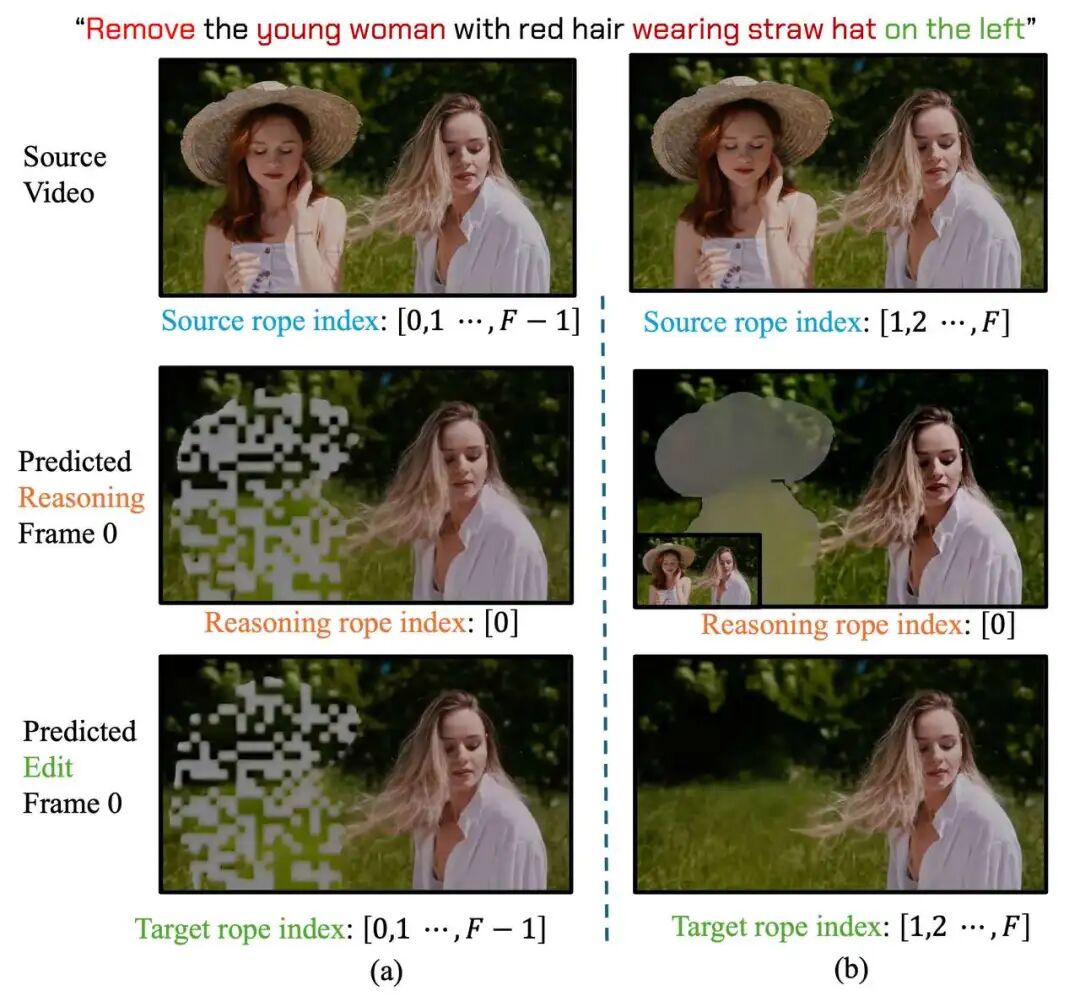

- RoPE 对齐与外推策略:设计了一种特殊的旋转位置编码(RoPE)重置策略(推理帧索引固定为 0,源/目标视频索引为 1-F),解决了索引冲突,支持模型在推理时处理 4 倍于训练长度的视频。

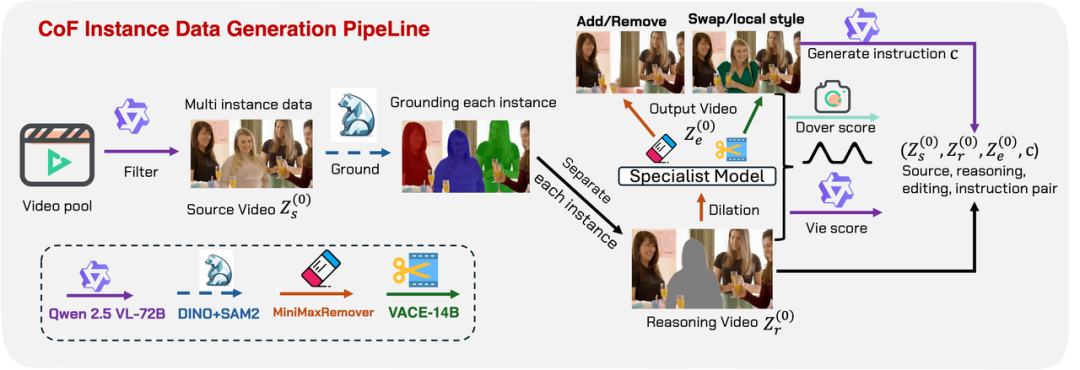

- 多实例数据生成管线:利用 Qwen-VL、Grounding-SAM2 和 VACE 等工具,构建了包含 50k 高质量多实例编辑三元组的数据集。

达到的效果

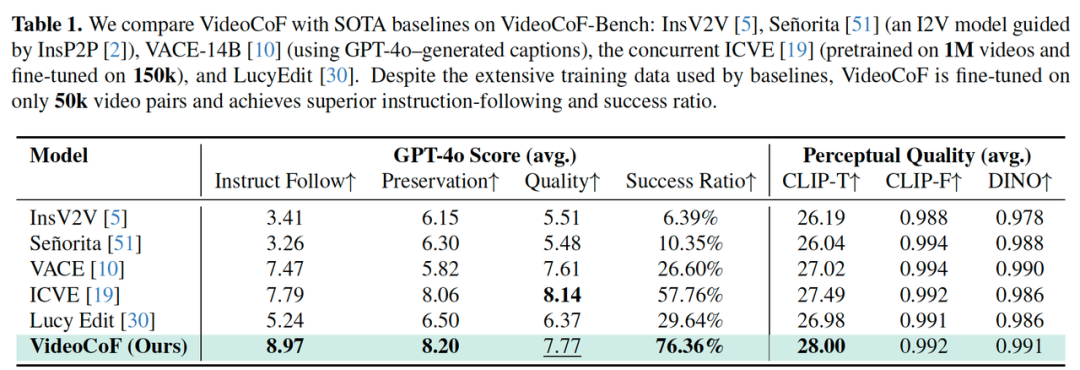

- 高效率下的 SOTA 性能:相比于使用 1M 视频预训练外加 150k 微调数据的强力基线(如 ICVE),VideoCoF 仅需 50k 视频对微调,指令遵循得分即达到 8.97(提升 15.14%),成功率高达 76.36%(提升 18.6%)。

- 完美的长度泛化:模型仅在 33 帧上训练,即可流畅推理 141 帧以上的长视频,且保持出色的运动一致性。

- 全能统一的编辑范式:实现了基于“帧链”方式的统一无 Mask 视频编辑,涵盖实例级(Instance)和局部级(Part-level)的对象移除、添加、交换及局部风格转换。该范式具有极强的灵活性,可进一步拓展至全局风格化(Global Style)和 ID 驱动编辑等任务。

- 完全开源与极速推理:目前模型权重、代码已全部开源,训练数据将在本周开源,结果可复现。在 DMD LoRA 的加持下,模型仅需 4 步采样即可完成生成,实现 20-30 秒编辑一条高清视频的极速体验。

方法详解

Chain of Frames (CoF):让生成模型先“思考”

VideoCoF 的核心架构基于标准的 Video DiT(Diffusion Transformer)。与以往简单地将“源视频”和“噪声目标视频”拼接不同,VideoCoF 在中间插入了推理帧(Reasoning Frames)。

- 输入序列:源视频 || 推理帧 || 目标视频。

- 推理帧的形式:研究发现,使用渐变灰度高亮(Gray Highlight)作为推理帧的效果最好。这不仅标出了编辑区域,还充当了从源视频到目标视频的视觉过渡。

- 核心逻辑:模型被要求在生成最终视频前,必须先预测出“在哪里修”。这种显式的推理过程迫使模型深度理解文本指令与空间区域的对应关系。

RoPE 对齐策略:打破长度限制

在传统的上下文学习中,简单的时间索引排列会导致模型过拟合于固定长度,无法处理长视频。VideoCoF 提出了一种巧妙的索引重置策略:

- 源视频与目标视频索引:统一设为 1 到 F,确保二者在时间特征上完美对齐。

- 推理帧索引:固定为 0。

这种设计将推理帧作为空间锚点隔离在时间轴之外,既能提供精准的空间指引,又不会干扰视频的运动结构。这使得模型即便在 33 帧的短视频上训练,也能完美泛化到 141 帧甚至更长的视频。

VideoCoF 在SORA生成的Multi-Shot上的141帧视频的编辑结果

训练与推理范式:高效且极速

VideoCoF 在训练和推理流程上进行了深度优化,确保了生成质量与速度的平衡:

- 训练范式:模型采用Flow matching训练,预测推理+编辑帧的velocity field作为优化目标。在训练过程中,系统将源视频、推理帧和编辑视频拼接成统一序列,但仅对推理帧和编辑视频部分进行加噪处理和监督。源视频全程保持“clean”状态,作为强大的上下文条件引导生成。

- 推理范式:推理时,源视频的 Latent 特征被固定,而推理帧和编辑部分从随机高斯噪声开始。通过 ODE 求解器,模型逐步将噪声转化为清晰的画面。

- 极速生成:得益于 DMD LoRA 技术的加持,VideoCoF 实现了极高的采样效率。原本复杂的编辑任务现在仅需 4 步(4 Steps) 采样即可完成,单条视频的编辑时间缩短至 20-30 秒(H100上),真正实现了即时反馈。

数据构建:高质量多实例数据

为了训练这种具有推理能力的模型,团队开发了一套自动化数据生产管线:

- 流程:利用 Qwen-VL 进行实例识别,Grounding-SAM2 进行精准分割,利用GPT-4o想象合理并diverse的编辑prompt, 再配合 VACE-14B 生成object替换/局部风格替换的编辑视频, MiniMax-Remover来生成object 添加/移除的编辑视频。

- 规模:pipeline在合成了包含移除、添加、交换,局部风格替换等任务的高质量三元组数据,还进一步根据dover score和vie score来筛选高质量合成数据样本,最终精选出 50k 核心样本,涵盖了大量复杂的空间关系和多物体交互场景。

实验结果

性能对比:小数据,大胜出

在 VideoCoF-Bench 上,VideoCoF 与 InsV2V、Señorita、VACE、ICVE(同期工作)等进行了对比。

- 指令遵循(Instruct Follow):VideoCoF 得分 8.97,远超 ICVE 的 7.79。

- 成功率(Success Ratio):高达 76.36%,比第二名高出近 20 个百分点。

- 数据量:VideoCoF 仅微调了 50k 数据,而 ICVE 预训练了 1M 数据并微调了 150k 数据。这证明了“帧链”范式的极高效率。

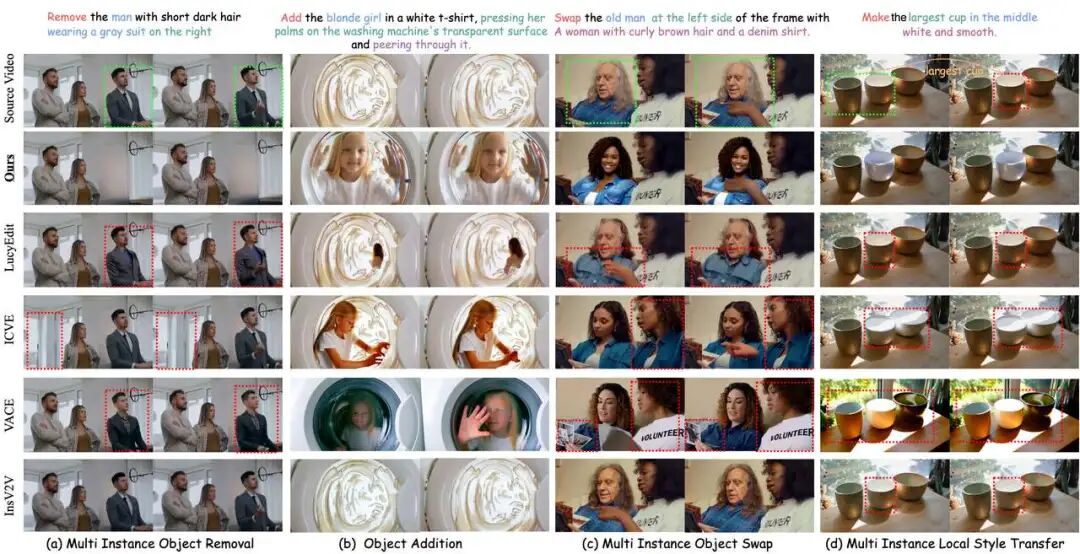

可视化展示

无论是移除画面右侧的特定人物、在洗衣机里添加一个小女孩,还是去推理哪个碗更大并且变得更白和光亮,VideoCoF 都能精准定位并自然融合。

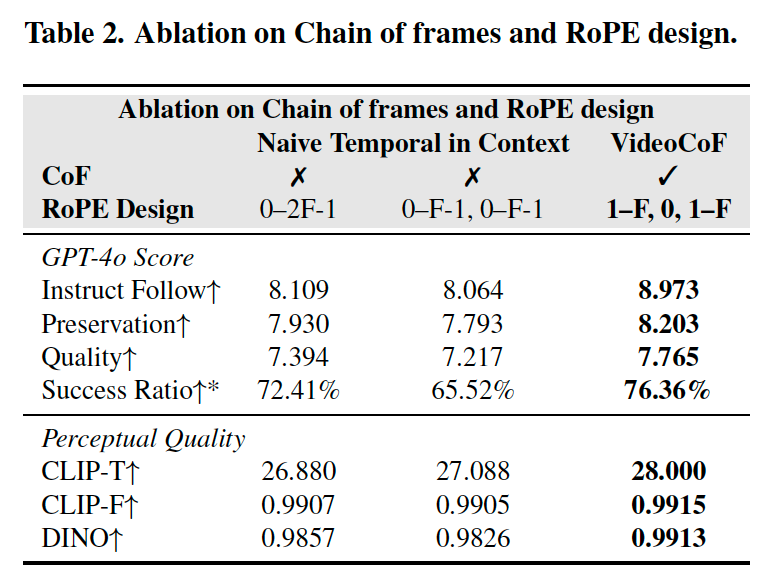

消融实验:图表与数据背后的真相

- 引入推理帧 (Reasoning Frames) 的核心增益

请看 Table 2 中 "Naive Temporal in Context" 与 "VideoCoF" 的对比:

- 量化提升:引入 CoF 设计后,指令遵循分数(Instruct Follow)从 8.109 飙升至 8.973,成功率(Success Ratio)从 72.41% 提升至 76.36%。

- 视觉实证:在右图中,左侧(不带推理帧)指令是需要模型删除右边的人,但删除错误删除了左边的人;而右图(带推理帧)通过先预测灰度掩码,精准锁定了编辑区域(右侧穿绿色衣服的人),使得后续的编辑帧(Editing)能完美继承推理帧的编辑区域实现精准的多实例级别的移除。

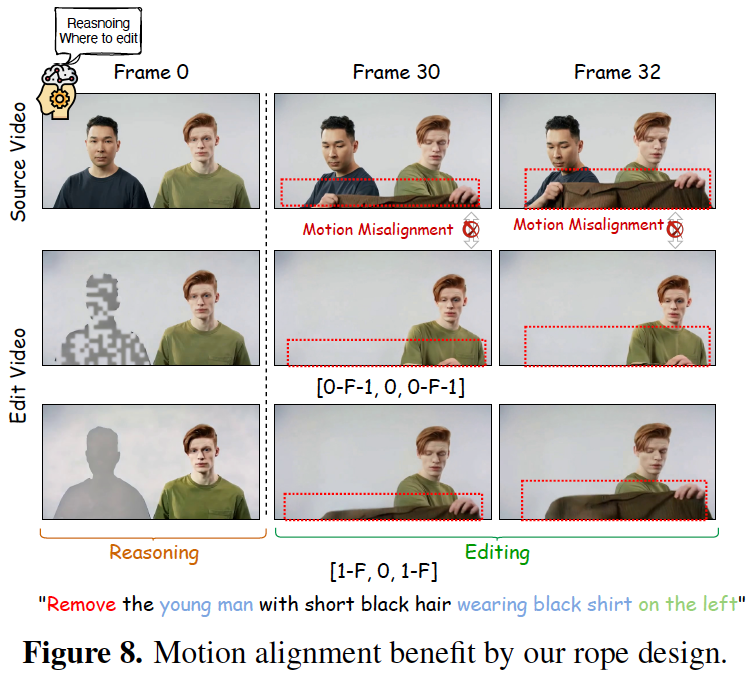

- Repeat RoPE 策略:对齐运动与无限外推

结合 Table 2 和 figure8 和右侧gif图来看 RoPE 设计的决定性作用:

- 解决索引冲突:在 figure 8 中,中间行的 Naive Reset 策略 [0-F-1, 0, 0-F-1] 导致推理帧(索引0)与编辑帧(索引0)冲突,产生了伪影。而 VideoCoF 采用的 [1-F, 0, 1-F] 策略(第三行),将推理帧索引固定为 0,源/目标视频索引设为 1-F。这种“错位对齐”让推理帧只提供空间信息,不干扰时间轴,从而完美修复了运动错位。

- 无限长度外推:在右侧gif动图中。在 Exploration Duration(长视频推理)测试中,Naive 方法(左下)生成的火焰头发出现了严重的面部崩坏和伪影;而 Our RoPE Alignment(右下)在超出训练长度的情况下,依然保持了人脸的清晰度和火焰的自然流动。

- 数据佐证:Table 2 显示,该策略下的 DINO 分数达到最高的 0.9913,证明了结构一致性的显著提升。

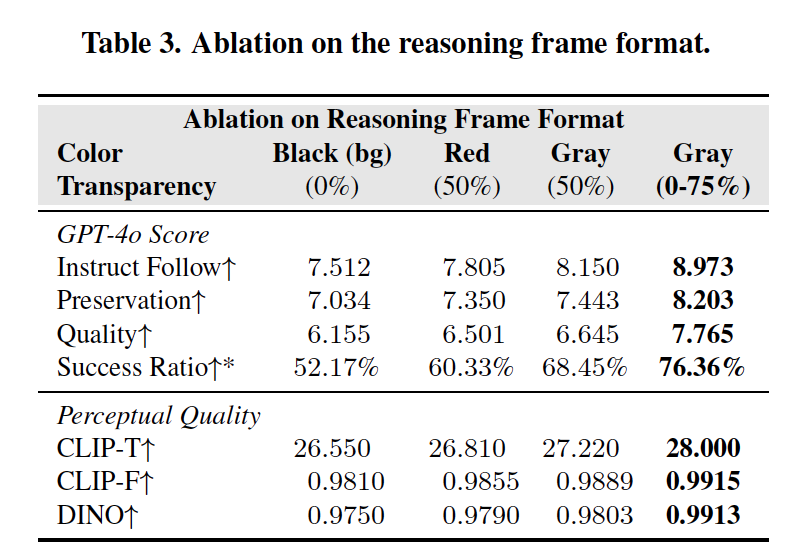

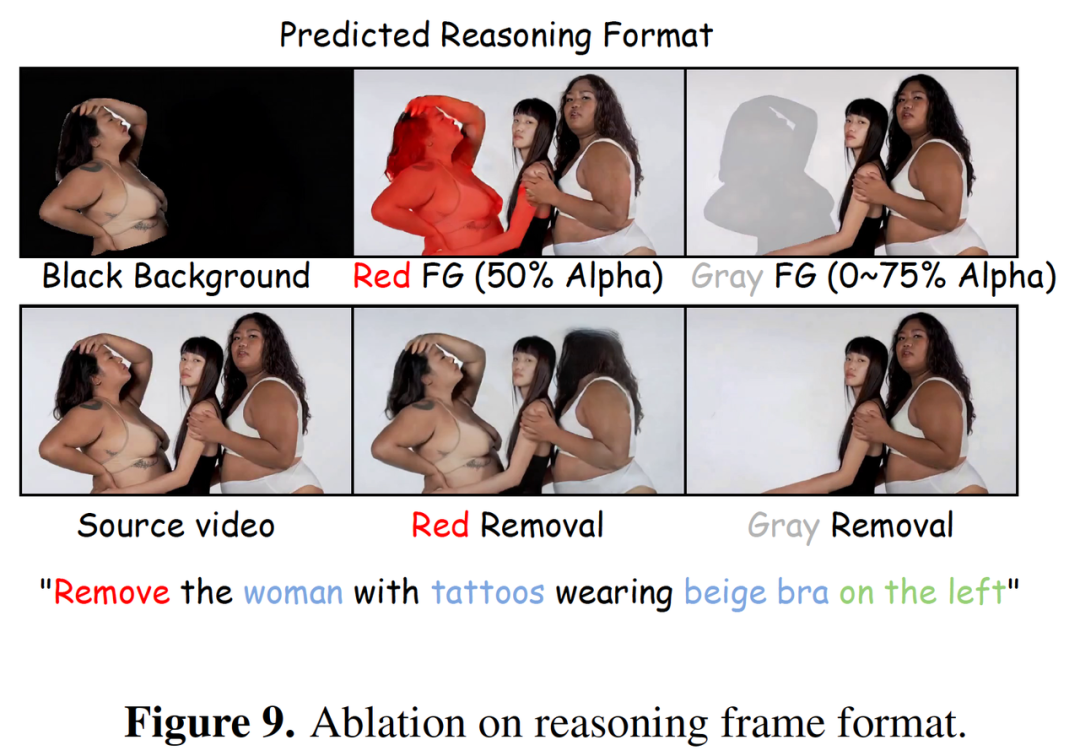

- 推理帧格式 (Reasoning Format):渐变灰的胜利

请看 Table 3 和 Figure 9 关于掩码格式的直观对比:

- 视觉对比:

- Black Background(黑背景):模型没删掉左边的人

- Red FG(红高亮):虽然识别了区域,但边缘生硬,同时无法合理移除最左边的女人。

- Gray FG(渐变灰):最右侧的 Gray (0~75% Alpha) 展现了完美的移除效果。渐变透明度就像一层“幽灵”遮罩,不仅指示了位置,还充当了从“有”到“无”的柔性视觉过渡。

- 数据碾压:Table 3 显示,渐变灰格式的 Instruct Follow 高达 8.973,远超黑背景的 7.512 和红高亮的 7.805,成功率更是从 52.17% 暴涨至 76.36%。

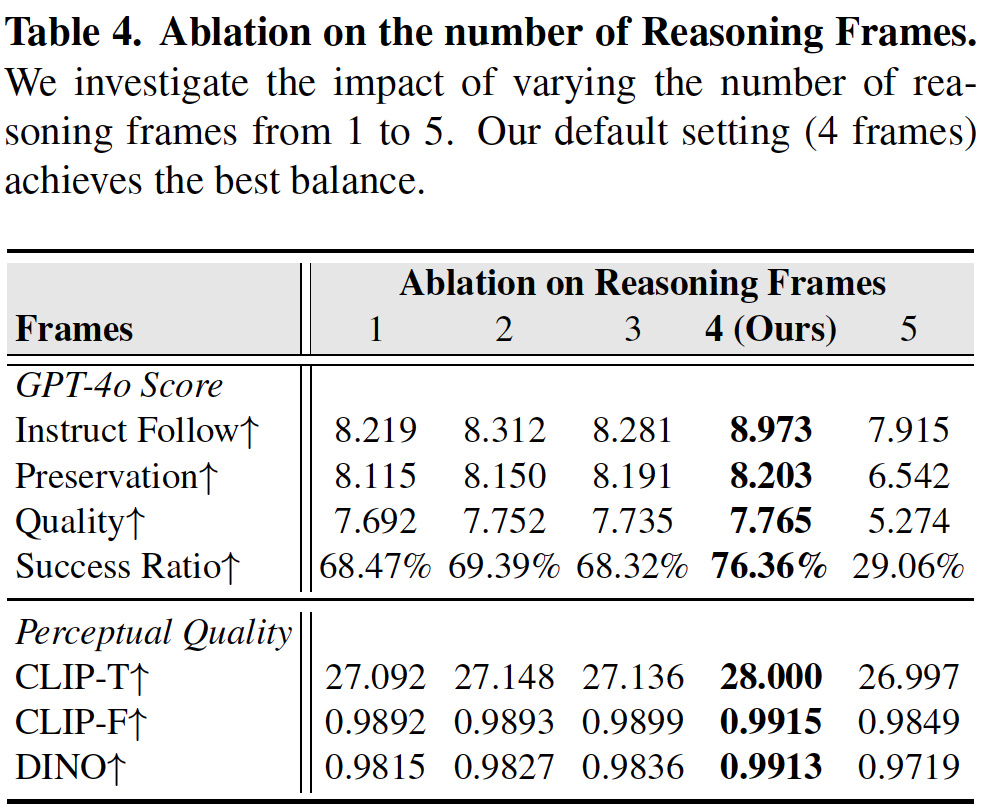

- 推理帧数量 (Number of Frames):寻找“黄金平衡点”

请关注 Table 4中的数据趋势:

- 数据拐点:实验测试了 1 到 5 帧推理帧。可以看到,随着帧数增加,性能稳步提升,在 4 Frames 时达到顶峰(Instruct Follow 8.973, Success Ratio 76.36%)。

- 过犹不及:一旦增加到 5 帧,成功率断崖式下跌至 29.06%。这说明 4 帧(对应 1 个 Latent Frame)是信息量与计算复杂度的最佳平衡点,过多的推理帧反而会引入噪声,干扰生成。

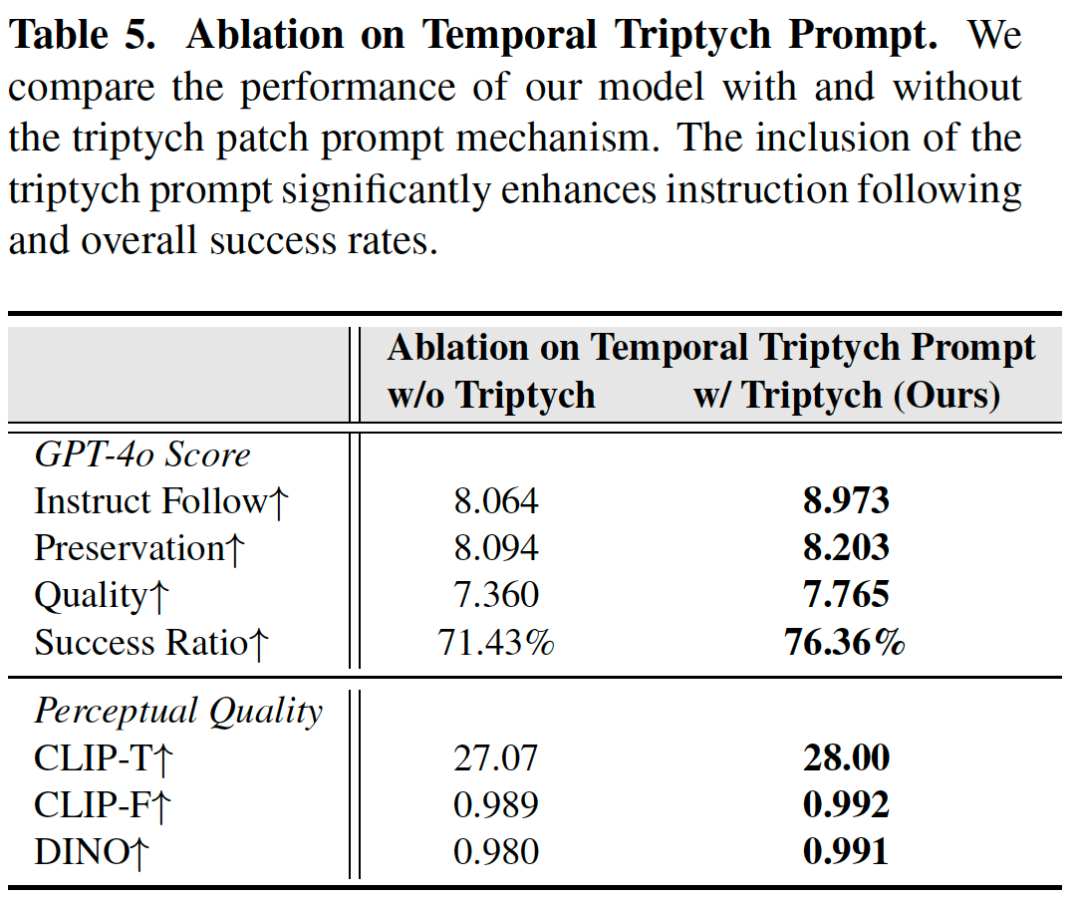

- Temporal 三连图 Prompt (Triptych Prompt):提示词的魔法

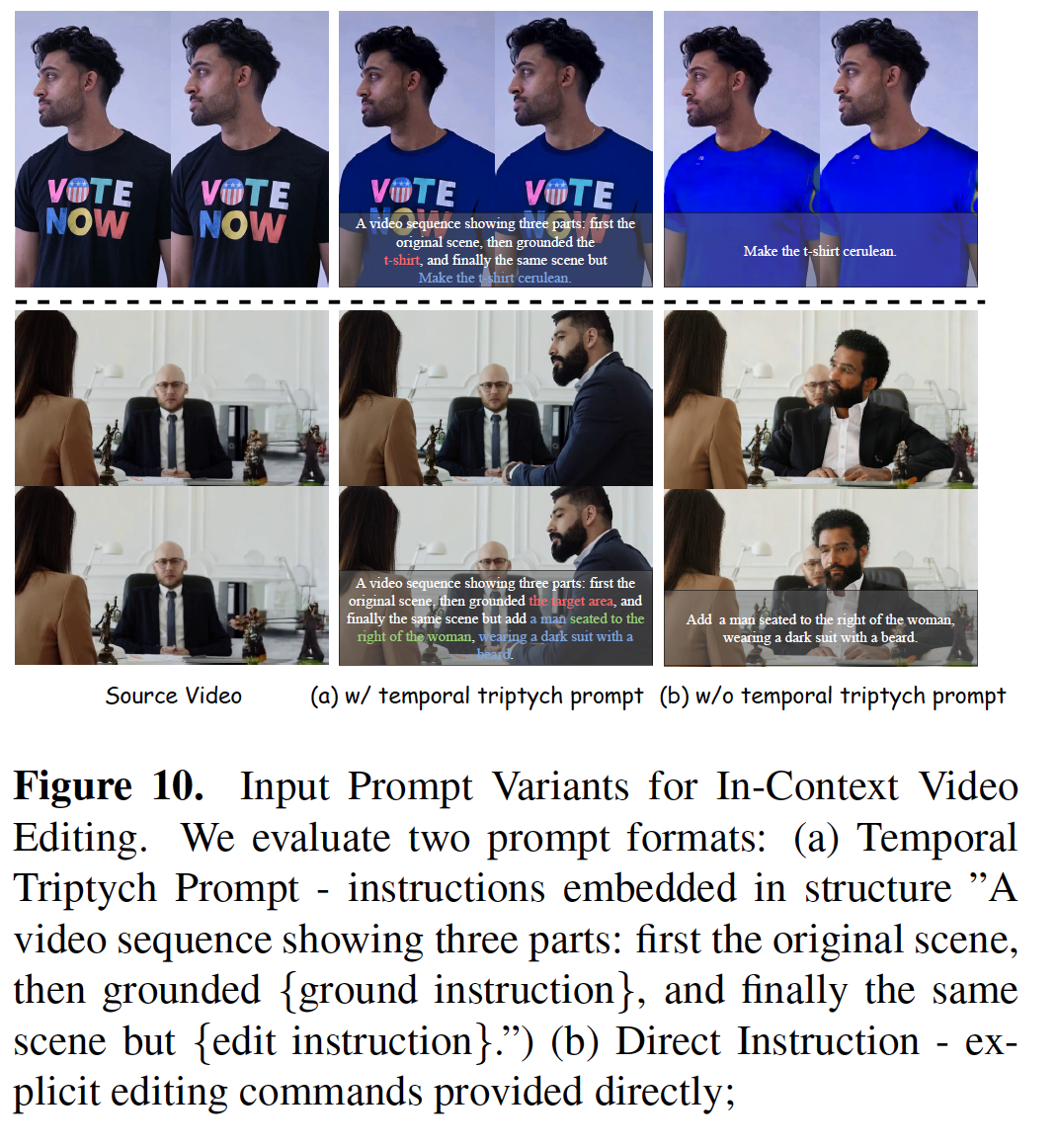

最后看 Table 5 和 Figure 10:

- Prompt 结构:图10展示了特定的 Prompt 写法:“A video sequence showing three parts: first the original scene, then grounded... and finally the same scene but...”。这种结构强行让模型在时序上理解“原片-推理-成片”的逻辑。

- 效果对比:

- (b) w/o Triptych:第三列的图,将T恤衫换成蓝色时,抹除了文字并且蓝色诡异,添加的男人位置错误十分不合理

- (a) w/ Triptych:左下角的图,在三连图 Prompt 引导下,衣服换成蓝色的同时完美的保留了文字,添加的男子西装笔挺、胡须清晰,并且位置合理,与“wear a dark suit with a beard”的指令完美契合。

- 量化提升:Table 5 显示,加上这句 Prompt,指令遵循分从 8.064 提升至 8.973,证明了这种结构化提示对激活模型推理能力的巨大价值。

总结

VideoCoF 的提出,打破了视频编辑领域长期存在的“精度 vs 统一性”僵局。通过引入帧链的推理机制(Chain-of-Frames),VideoCoF 证明了让模型先“看懂”再“动手”是提升编辑质量的关键。 更令人振奋的是,VideoCoF 展现出的极高数据效率(50k data)和长视频泛化能力,为未来开发更通用、更低成本的视频编辑大模型指明了方向。也许在不久的将来,我们每个人都能用一句话,像修图一样轻松地修改长电影片段。

论文与代码链接

Paper: https://arxiv.org/abs/2512.07469 Project: https://videocof.github.io/ Code: https://github.com/knightyxp/VideoCoF (模型,代码,均已开源,4步编辑一条视频,训练数据VideoCoF-50k本周内开源 ) Demo: https://huggingface.co/spaces/XiangpengYang/VideoCoF (20s/条,4步生成编辑视频)

参考文献

[1] Unified Video Editing with Temporal Reasoner

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-12-23,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录