RoLID-11K:面向小目标检测的行车记录仪路边垃圾数据集

原创RoLID-11K:面向小目标检测的行车记录仪路边垃圾数据集

原创

AI小怪兽

发布于 2026-01-13 10:01:41

发布于 2026-01-13 10:01:41

本文贡献如下:

1)首创数据集:发布首个基于行车记录仪的大规模路边垃圾数据集RoLID-11K,涵盖超1.1万标注图像。

2)定义核心挑战:系统量化数据集中极端小目标占比超80%与显著长尾分布特性。

3)全面性能基准:系统评测从Transformer到YOLO系列模型,揭示实时模型在小目标检测上的性能瓶颈。

4)推动应用研究:为开发低成本路边监测系统建立实验基准,指明需融合高分辨率特征与高效推理的新架构方向。

博主简介

AI小怪兽 | 计算机视觉布道者 | 视觉检测领域创新者

深耕计算机视觉与深度学习领域,专注于视觉检测前沿技术的探索与突破。长期致力于YOLO系列算法的结构性创新、性能极限优化与工业级落地实践,旨在打通从学术研究到产业应用的最后一公里。

🚀 核心专长与技术创新

- YOLO算法结构性创新:于CSDN平台原创发布《YOLOv13魔术师》、《YOLOv12魔术师》等全系列深度专栏。系统性提出并开源了多项原创自研模块,在模型轻量化设计、多维度注意力机制融合、特征金字塔重构等关键方向完成了一系列突破性实践,为行业提供了具备高参考价值的技术路径与完整解决方案。

- 技术生态建设与知识传播:独立运营 “计算机视觉大作战” 公众号(粉丝1.6万),成功构建高质量的技术交流社群。致力于将复杂算法转化为通俗易懂的解读与可复现的工程代码,显著降低了计算机视觉的技术入门门槛。

🏆 行业影响力与商业实践

- 荣获腾讯云年度影响力作者与创作之星奖项,内容质量与专业性获行业权威平台认证。

- 全网累计拥有 7万+ 垂直领域技术受众,专栏文章总阅读量突破百万,在目标检测领域形成了广泛的学术与工业影响力。

- 具备丰富的企业级项目交付经验,曾为工业视觉检测、智慧城市安防等多个关键领域提供定制化的算法模型与解决方案,驱动业务智能化升级。

💡 未来方向与使命

秉持 “让每一行代码都有温度” 的技术理念,未来将持续聚焦于实时检测、语义分割及工业缺陷检测的商业化闭环等核心方向。愿与业界同仁协同创新,共同推动技术边界,以坚实的技术能力赋能实体经济与行业变革。

论文:https://arxiv.org/pdf/2601.00398

摘要:路边垃圾带来了环境、安全和经济方面的多重挑战,然而当前监测仍依赖于劳动密集型的人工巡查和公众报告,空间覆盖范围有限。现有的垃圾检测视觉数据集主要集中于街道级别的静态图像、航拍场景或水生环境,未能反映行车记录仪视频的独特特性——其中垃圾目标极其微小、稀疏且混杂在杂乱的路肩背景中。我们推出了RoLID-11K,这是首个用于行车记录仪路边垃圾检测的大规模数据集,包含超过1.1万张标注图像,涵盖英国多样化的驾驶条件,并呈现出显著的长尾分布和小目标分布特征。我们对广泛的现代检测器进行了基准测试,从追求精度的Transformer架构到实时YOLO模型,并分析了它们在这一挑战性任务上的优势与局限。结果表明,尽管CO-DETR及相关Transformer模型取得了最佳定位精度,但实时模型仍受限于其粗糙的特征层次结构。RoLID-11K为动态驾驶场景中的极端小目标检测建立了一个具有挑战性的基准,旨在支持开发可扩展、低成本的路边垃圾监测系统。

伪代码如下:

// RoLID-11K 数据集构建与基准测试流程

BEGIN

// 第一阶段:数据集构建与准备

DATA_COLLECTION:

从英国林肯郡的行车记录仪采集4K视频;

使用OpenCV提取视频帧,降采样至1080p;

人工筛选包含垃圾的帧,移除无垃圾帧以平衡数据;

DATA_ANNOTATION:

使用VGG Image Annotator工具标注;

类别: "litter"(单类别);

标注形式: 边界框(包括极小和部分遮挡物体);

数据划分: 训练集(7,990图像), 验证集(1,201图像), 测试集(2,374图像);

DATA_STATISTICS:

分析数据分布:长尾分布、小目标占比(>80%)、空间偏向左下角;

生成统计图表(实例数量、边界框面积、热力图等);

// 第二阶段:模型训练与评估

MODEL_SELECTION:

精度导向模型: CO-DETR, DiffusionDet, DINO, RT-DETR, DEIMv2;

实时模型: YOLOv8 至 YOLOv12;

TRAINING_SETUP:

初始化: 使用COCO预训练权重;

框架: MMDetection(Transformer模型), Ultralytics(YOLO系列);

输入分辨率: 800×1333(Transformer), 640×640(YOLO系列);

训练周期: 50 epochs;

硬件: NVIDIA H200 GPU;

EVALUATION_METRICS:

采用COCO标准评估协议;

主要指标: AP50, AP50:95, AP_small, AP_medium, AP_large;

效率指标: 参数量(#Param), FLOPs, 推理延迟(ms/帧);

// 第三阶段:结果分析与比较

BENCHMARKING:

FOR 每个模型 IN 模型列表:

在测试集上进行推理;

计算所有评估指标;

记录推理时间和资源消耗;

COMPARE_MODELS:

分析精度与速度的权衡;

特别关注小目标(AP_small)的性能差异;

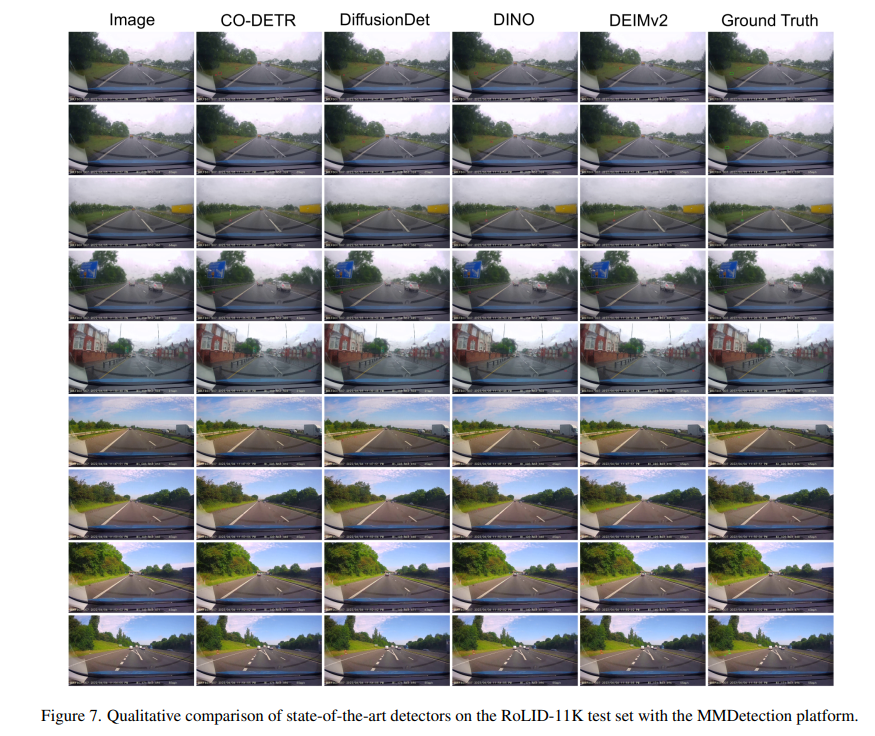

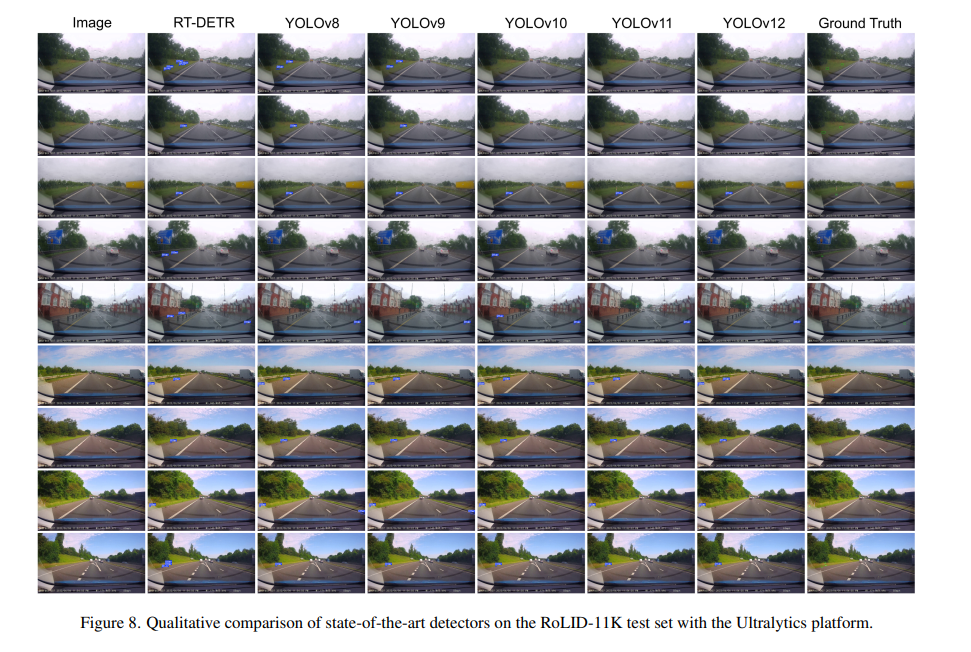

可视化检测结果(如图7, 8所示);

CONCLUSION:

输出最佳模型(CO-DETR在精度上最优);

指出实时模型(YOLO系列)在小目标检测上的局限性;

建议未来研究方向:结合高分辨率特征与高效推理的专用架构;

END

1. 引言

道路沿线垃圾的堆积造成了环境、安全和经济负担。英国当局每年在街道清洁上花费数亿英镑[10],而路边垃圾会导致径流污染、排水系统堵塞以及对路肩栖息野生动物的伤害[24]。然而,日常监测仍然不够一致,通常依赖于人工巡查和公众报告,这些方式提供的空间和时间覆盖范围有限。现有的商业垃圾检测工具,如 LitterCam 和 EnviroEye.AI,侧重于通过固定的闭路电视/杆式摄像头捕捉车内人员乱扔垃圾的行为,而非检测或绘制路肩沿线垃圾堆积情况。此外,这些系统的部署和维护成本高昂,难以大规模应用以实现对道路网络的全面覆盖。

相比之下,行车记录仪价格低廉、使用广泛,并能持续捕捉前方道路场景。它们在私家车和商业车队中的普遍存在,为利用已录制的视频进行被动式路边垃圾监测提供了一个实用机会。然而,从移动车辆上捕捉到的垃圾检测具有挑战性:目标物体通常非常小、稀疏、高度不平衡,并且受到运动模糊、压缩和杂乱路肩背景的影响。现有的废弃物相关数据集,如 TACO [20]、TrashNet [25]、UAVVaste [15] 和 FloW [6],并未反映出行车记录仪特有的这些条件。

为填补这一空白,我们推出了 RoLID-11K(Roadside Litter Detection dataset),这是一个包含超过 11,000 张标注过的行车记录仪帧图像的数据集,具有显著的长尾特征和小目标普遍性。我们对广泛的现代目标检测器进行了基准测试,从追求精度的 Transformer 模型到实时 YOLO 变体,首次系统性地评估了在行车记录仪视频中的垃圾检测能力。RoLID-11K 旨在支持可扩展、低成本的追踪路边污染的方法,并为未来小目标检测和基于行车记录仪的环境监测研究奠定基础。我们的主要贡献包括:(i) RoLID-11K,首个用于行车记录仪路边垃圾检测的大规模数据集;(ii) 对现实世界垃圾分布的分析,揭示了显著的长尾和小目标特征;(iii) 对最先进检测器在精度和实时设置下的全面基准测试;(iv) 对基准测试性能的深入洞察,突出了精度-效率的权衡以及行车记录仪特定小目标检测带来的挑战。

2. 相关工作

现有的垃圾和废弃物检测数据集涵盖街道级别、航拍和水下环境,但没有专门针对从前向行车记录仪视角观察的路边路肩。在街道级别,TACO [20] 提供了约 1.5K 张带有多类别垃圾标注的图像,而 TrashNet [25] 提供小规模的单目标分类数据。基于无人机(UAV)的数据集如 UAVVaste [15] 提供废弃物的低空航拍图像,而一些水下数据集,如 TrashCan [11]、TrashICRA [9] 和 SeaClear [28],则专注于水下或水面的海洋垃圾。PlastOPol [7] 也专注于使用众包的 Marine Debris Tracker 图像,在不同户外环境中进行单类别“垃圾”检测。FloW [6] 则以内陆水域的漂浮垃圾为目标,包含纯图像子集和多模态图像-雷达子集。最近一项旨在统一这些不同资源的努力是 DetectWaste 基准测试[18],它规范了多个数据集(包括扩展的 TACO、UAVVaste、TrashCan 和 TrashNet 等)的标注并纠正了标签不一致性。然而,所有现有数据集都与我们的场景显著不同:图像通常来自静态摄像头、手持设备、无人机或水下机器人,且垃圾通常占据画面的相当一部分或以聚集块的形式出现。没有数据集提供大规模的、垃圾在其中表现为路边微小稀疏目标的行车记录仪视频,而这正是 RoLID-11K 的重点。

基于视觉的垃圾监测已在海洋、航拍和河流环境中得到探索,使用了一系列深度目标检测器和分割器。在 TrashCan [11] 及相关海洋垃圾收集等水下数据集上,基线实验通常使用 Mask R-CNN 和 Faster R-CNN 进行实例分割和检测,后续工作[16]比较了轻量级 YOLACT 与 Mask R-CNN 用于实时水下垃圾分割的性能。SeaClear [28] 海洋垃圾数据集报告了 Faster R-CNN 和 YOLOv6 的基线结果,强调了跨地点和跨摄像头泛化的困难。对于水面和河流漂浮垃圾[19],基于 YOLOv5 的流程通常用于视频流中的检测和跟踪。使用 UAVVaste [15] 的航拍垃圾检测依赖于 YOLOv4 和 EfficientDet 等单阶段检测器部署在嵌入式硬件上,在精度和机载推理速度之间进行权衡。在更广泛的层面上,DetectWaste [18] 和最近关于自动化废弃物识别的研究综述[1]表明,YOLO 变体以及 Faster R-CNN、RetinaNet 和相关架构主导了当前的废弃物检测系统,这些系统通常在扩展的 TACO 及类似数据集上进行训练。然而,这些方法假设目标尺度适中、视角相对固定且背景具有领域特异性(水面、航拍俯视图、室内分拣线等),而在行车记录仪视频中,垃圾在高度动态的场景中表现为道路边缘附近的极小、稀疏目标。这促使我们在新的 RoLID-11K 数据集上对当代检测器进行系统性基准测试,涵盖面向精度的 Transformer 模型(DINO [12]、CO-DETR [27]、DiffusionDet [4])和实时 YOLO 模型[5],以表征它们在结合了小目标、长尾和行车记录仪特有挑战下的行为。

3. 数据集

3.1. 数据采集与标注

RoLID-11K 构建自 2022 年 2 月至 7 月间在英国林肯郡录制的 4K 行车记录仪视频。视频使用安装在车辆标准前向位置的 WOLFBOX 4K/1080p 行车记录仪录制,覆盖了广泛的驾驶环境——包括乡村道路、郊区街道、双车道主干道和城市环境,捕捉了真实的路边垃圾场景。视频还涵盖了多样的天气和光照条件(晴朗、多云、低光和阴影环境),提供了具有代表性的真实世界驾驶场景。所有帧都使用 OpenCV 的 VideoCapture 接口从原始视频中以原生帧率提取,并以 JPEG 图像格式保存,确保没有依赖于内容的采样偏差。不包含可见垃圾的帧被移除,以减轻垃圾与背景之间固有的严重不平衡问题。

尽管行车记录仪拍摄的是 4K 超高清视频,但提取的帧被标准化为 1920×1080 分辨率,降采样到 1080p 是为了在保持小垃圾目标可见性的同时,减少存储和标注开销。在基准测试期间,图像会根据每个检测器的输入要求进一步调整大小。所有图像都通过模糊画面中任何可见的车辆牌照和人脸进行了匿名化处理。标注使用 VGG Image Annotator [8] 创建,使用单一类别("垃圾"),并在任何可见的垃圾物品(包括嵌入植被中的非常小或被部分遮挡的物体)周围绘制边界框。这在训练集中产生了 14,645 个标注实例,验证集中有 2,094 个,测试集中有 4,189 个。

3.2. 数据集划分与统计

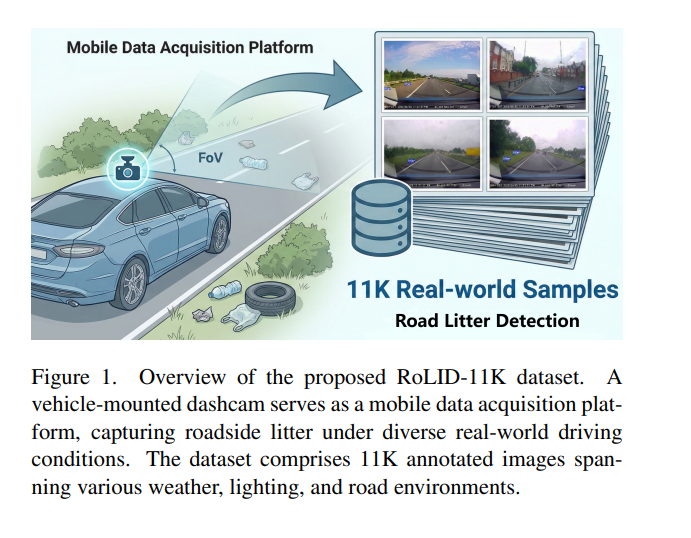

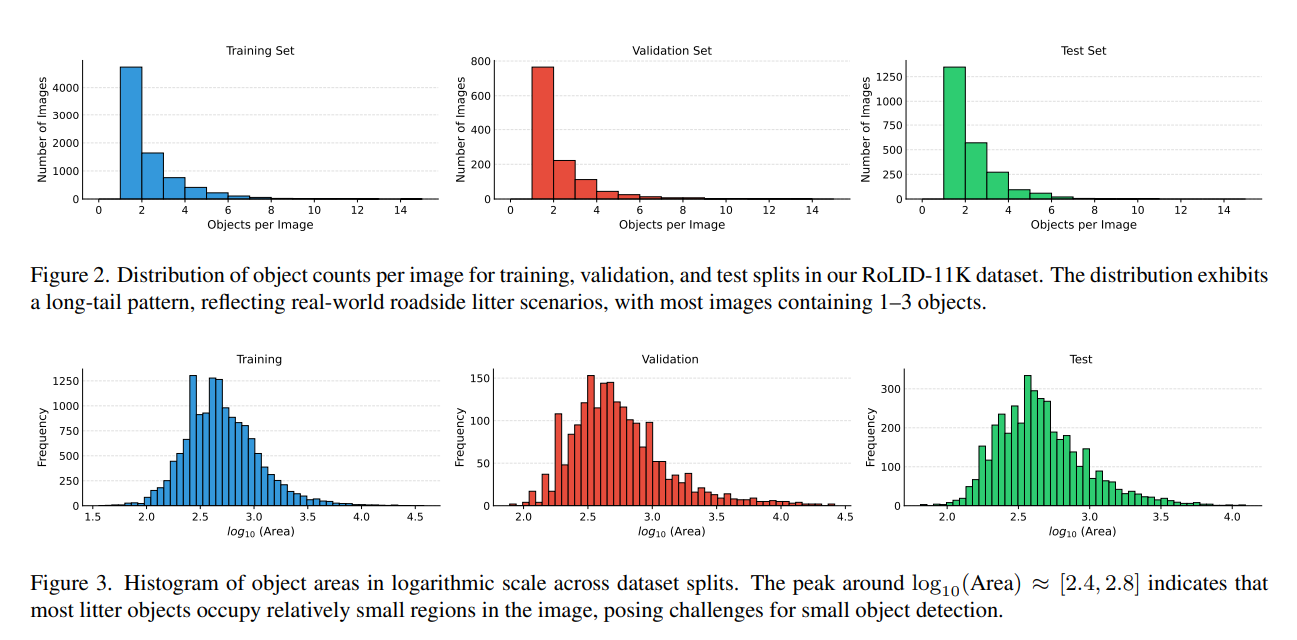

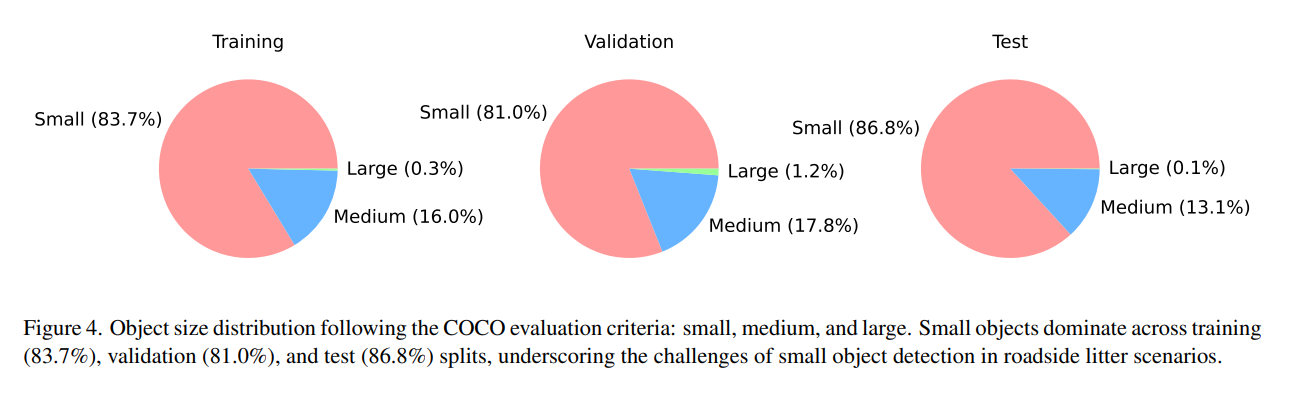

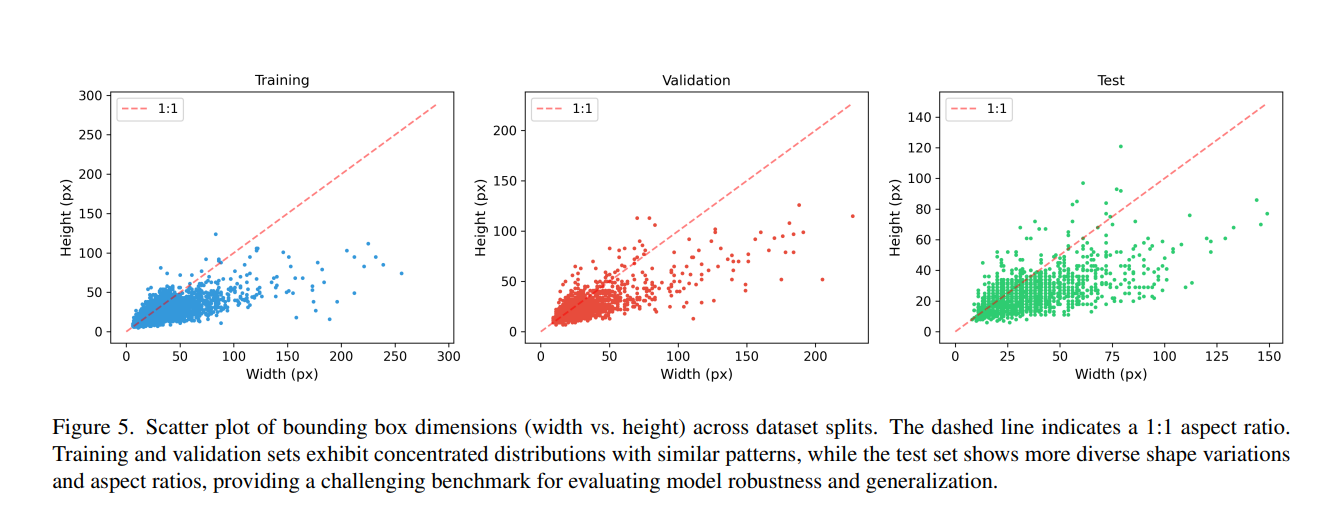

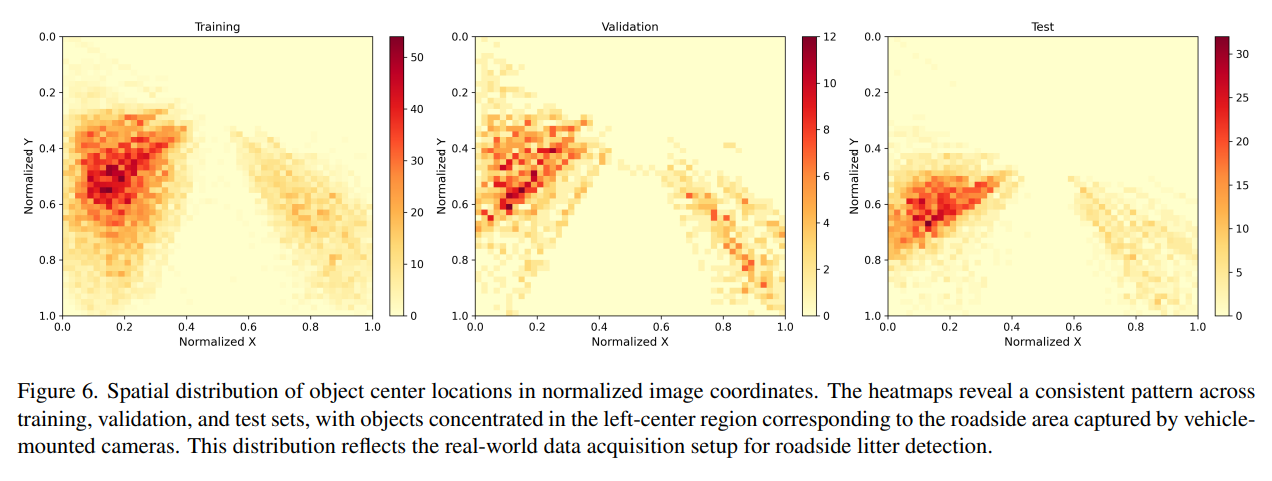

最终数据集包含 11,565 张图像,划分为 7990 张训练图像、1201 张验证图像和 2374 张测试图像(即我们基准测试中使用的划分)。RoLID-11K 呈现出目标检测面临的多个挑战性特征。每张图像中的目标数量遵循强烈的长尾分布,大多数图像包含一至三个实例(图 2)。目标尺寸极小:边界框面积分布的高峰出现在 log10(面积) ≈ 2.4–2.8 附近,这意味着垃圾通常只占据每帧画面的极小部分,如图 3 所示。根据 COCO 尺寸标准,在所有划分中,超过 80% 的标注对象被归类为小目标(图 4)。边界框长宽比分析进一步显示了高度的可变性,特别是测试集呈现出多样化的目标形状(如图 5 所示),增加了稳健检测的难度。最后,图 6 展示了目标中心热力图,揭示了图像左下区域的强烈空间偏向,这反映了英国左侧行驶的典型情况,行车记录仪主要捕捉左侧路肩。由于驾驶员行为(向路肩丢弃物品)和风力驱动的位移,垃圾也倾向于在这一侧积聚,使得左侧路肩比右侧更常出现垃圾。综合来看,这些特性使得 RoLID-11K 成为一个在真实驾驶条件下评估小目标检测能力的严苛基准。

4. 实验

4.1. 基准设计及原理

由于极高比例的超小目标、强烈的长尾实例分布以及动态的行车记录仪视角,RoLID-11K 代表了一个极具挑战性的目标检测场景。为了有意义地评估在这些条件下的性能,我们对两个互补的检测器家族进行了基准测试:

- 面向精度的 Transformer 架构(CO-DETR [27]、DiffusionDet [4]、DINO [2]、RT-DETR [26] 和 DEIMv2 [12]),这些架构已知在 COCO [17] 等数据集上具有卓越的定位精度和小目标灵敏度。

- 实时架构(YOLOv8 [13] – YOLOv12 [21]),广泛应用于汽车和边缘应用,其中推理速度至关重要。 这种组合使我们能够评估精度与可部署性之间的权衡,并确定哪些架构趋势(如基于 Transformer 的建模、密集预测头或实时卷积)对基于行车记录仪的垃圾检测最有效。我们纳入了 RT-DETR 和 DEIMv2 作为连接高精度和实时推理的现代尝试,并包含多代 YOLO 模型以反映轻量级检测器在实时路边监测系统中的实际相关性。这一选择涵盖了当代检测器(2021-2025)的当前谱系,确保我们的基准测试反映了技术发展水平。

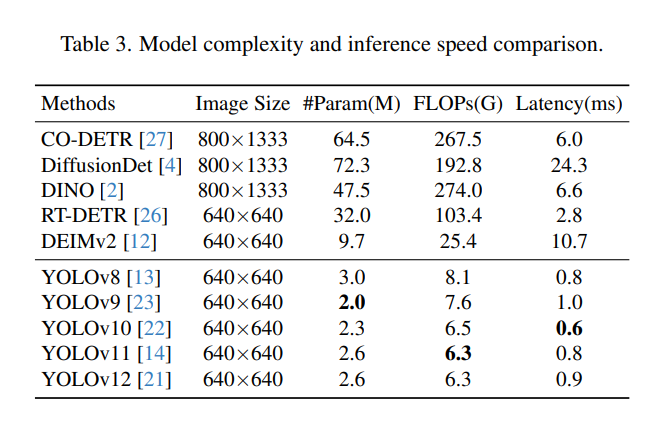

4.2. 实现细节

我们在配备 Intel Xeon Silver 4216 CPU、256GB RAM 和 NVIDIA H200 GPU(141GB 内存)的工作站上进行所有实验。模型训练使用其框架提供的默认设置,以确保可比性和可复现性。Transformer 模型(CO-DETR, DiffusionDet, DINO)使用 MMDetection [3] 实现,而 YOLO 系列模型、RT-DETR 和 DEIMv2 使用 Ultralytics 框架 [13]。对于基于 MMDetection 的检测器,输入分辨率按照标准 COCO 协议设置为 800 × 1333。对于 YOLO 系列、RT-DETR 和 DEIMv2,我们使用默认的 640 × 640 输入尺寸。所有模型均使用在 COCO [17] 上预训练的权重进行初始化,并在我们的训练集上进行 50 个周期的微调。推理延迟使用批次大小为 1 在整个测试集上测量,以每帧平均运行时间(毫秒)表示。这些指标(如表 3 所示)允许直接比较精度-效率的权衡。

4.3. 评估指标

我们采用标准的 COCO 评估协议 [17] 来全面评估在 RoLID-11K 数据集上的检测性能。主要指标包括平均精度(AP)。具体来说,我们报告 AP50(在 IoU 阈值为 0.5 时测量的检测精度)和 AP50:95(在 IoU 阈值从 0.5 到 0.95,步长为 0.05 范围内的 AP 平均值)。AP50:95 提供了对定位质量的更严格评估。此外,考虑到路边垃圾场景中小目标的普遍性,我们分别报告了小目标(面积 < 322 像素²)的 APsmall50:95、中目标(322 ≤ 面积 < 962 像素²)的 APmedium50:95 和大目标(面积 ≥ 962 像素²)的 APlarge50:95。这些指标对于评估模型在我们数据集中固有的挑战性小目标检测任务上的性能尤为重要。为了评估实际部署的计算效率,我们报告了参数数量(#Param)、浮点运算量(FLOPs)以及以每幅图像毫秒数测量的推理延迟。

5. 结果与讨论

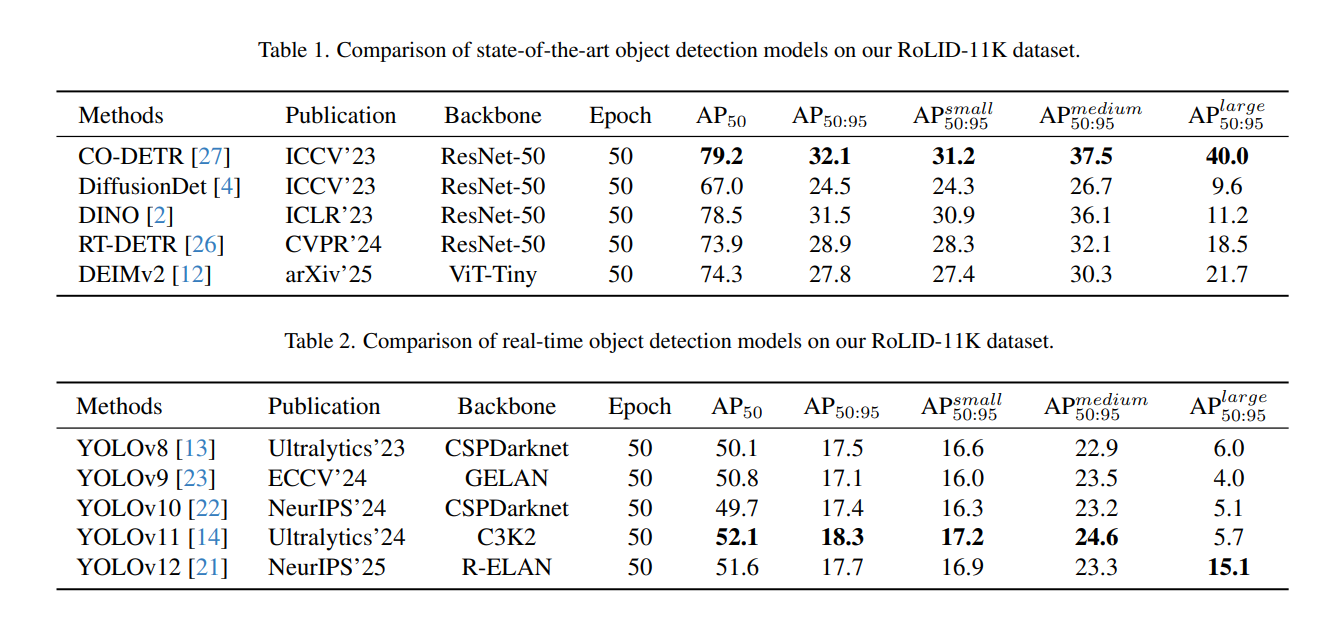

表 1 和表 2 总结了面向精度和实时检测器的性能。在基于 Transformer 的模型中,CO-DETR 取得了最高的 AP50:95,证实了其强大的定位能力和对 RoLID-11K 极端小目标分布特征的鲁棒性。DINO 也表现出了竞争力,而 DiffusionDet 在此数据集上表现不佳,这表明其粗糙的去噪调度难以检测嵌入杂乱背景中的微小物体。各模型普遍较高的 AP50 相对于 AP50:95,反映了对仅占几十个像素的物体进行精确定位的巨大挑战。

实时检测器表现出预期的速度与精度权衡。YOLO 模型(v8–v12)实现了亚毫秒级的推理延迟,同时保持了有竞争力的 AP50 分数,但在 AP50:95 上显著落后于 Transformer 架构。这种性能差距在 APsmall50:95 上最为明显,强化了轻量级检测头和较低的输入分辨率限制了在极微小目标上的细粒度定位能力。

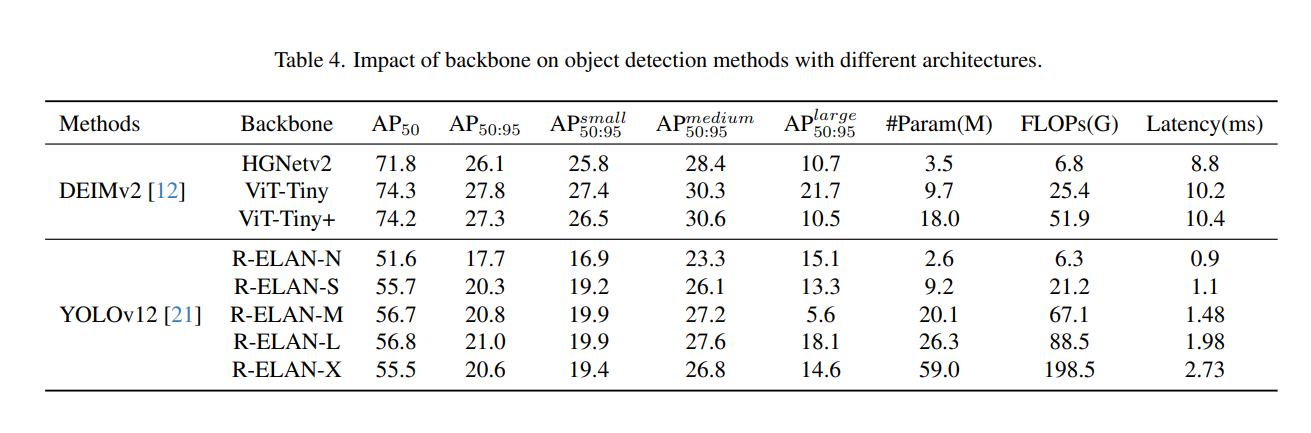

表 4 显示,骨干网络的选择对性能有显著影响。我们对 DEIMv2 和 YOLOv12 进行了消融研究,因为它们是各自模型家族的最新代表,并提供模块化的骨干网络,使得架构比较有意义。对于 DEIMv2,将默认的 CNN 骨干网络替换为 ViT-Tiny 能显著提升 AP50:95。这与观察结果一致,即基于 Transformer 的编码器保留了长距离上下文信息和精细的空间细节,这对于检测仅几个像素大小的垃圾物体至关重要。对于 YOLOv12,骨干网络和预测头的设计改进带来了适度的 AP 提升,但在检测极小的垃圾物体时,所有版本仍然受到输入分辨率和轻量级特征层次的限制。这些结果表明,在 RoLID-11K 条件下,早期特征提取阶段的架构容量是小目标检测的关键因素。

图 7 和图 8 展示了模型在挑战性场景下的预测结果。面向精度的检测器能更可靠地捕捉小型、部分被遮挡的物品,而实时模型则经常漏检嵌入植被或阴影区域的物体。YOLO 变体倾向于产生更多的漏检,但在存在中等大小物体时能保持稳定的检测。Transformer 模型减少了漏检,但偶尔在纹理丰富的路肩区域产生误检,这反映了行车记录仪图像典型的杂乱背景。这些例子突出了当目标在视觉上不明显且空间上偏向图像边界时,平衡精确率和召回率的困难。

总体而言,我们的结果表明,在所有评估的模型中,CO-DETR 实现了最强的整体 AP50:95,这表明基于密集 Transformer 的分配机制为极小而稀疏分布的垃圾实例提供了最可靠的定位。然而,尽管面向精度的 Transformer 检测器取得了最佳性能,但其计算成本限制了在低功耗平台上的实时部署。相反,YOLO 模型提供极快的推理速度,但难以捕捉一致的小目标检测所需的精细空间细节。这种矛盾凸显了需要专门针对极端小目标场景设计的架构,可能需要将高分辨率特征路径与高效的推理机制相结合。RoLID-11K 基准测试清晰地暴露了这些局限性,并为未来开发能够在实时路边监测中有效运行的模型奠定了基础。

6. 结论

我们推出了 RoLID-11K,这是首个用于行车记录仪视频路边垃圾检测的大规模数据集,捕捉了现实世界监测中的挑战——目标物体极其微小、稀疏且空间上偏向路肩。通过对当代检测器进行基准测试,我们表明,面向精度的 Transformer 架构目前提供了最强的定位性能,而实时 YOLO 模型尽管速度快,却难以满足检测垃圾大小物体所需的精细空间细节。这些发现凸显了在动态驾驶环境中,需要专门针对极端小目标检测设计的架构。RoLID-11K 为可部署的环境监测模型奠定了基础,我们希望它将支持开发用于追踪路边污染的低成本系统。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录