25: 2026 推理工程师能力矩阵:工程化实践层

25: 2026 推理工程师能力矩阵:工程化实践层

安全风信子

发布于 2026-01-23 20:09:54

发布于 2026-01-23 20:09:54

作者:HOS(安全风信子) 日期:2026-01-19 来源平台:GitHub 摘要: 2026年,大模型推理已从实验室走向生产环境,工程化实践成为推理系统稳定运行的关键保障。本文深入剖析推理工程师在工程化实践层所需的核心能力,包括Docker/K8s部署、API Server集成、Helm chart管理、SLA定义与保障以及E2E测试流水线构建。通过真实代码案例和工程实践,帮助推理工程师构建高可用、高性能、可扩展的推理系统,对齐云厂商和模型厂商招聘中的"生产级工程实践"要求。

1. 背景动机与当前热点

1.1 大模型推理的工程化挑战

2026年,大模型推理已成为企业级应用的核心组件,面临着前所未有的工程化挑战:

- 规模庞大:模型参数量从千亿级跃升至万亿级,部署和管理难度大幅增加

- 高并发需求:实际应用中,推理系统需要处理每秒数千甚至数万次请求

- 低延迟要求:用户对推理响应时间的要求越来越高,通常需要在100ms以内

- 高可用性:生产环境要求推理系统具备99.99%以上的可用性

- 可扩展性:需要支持快速扩展以应对流量波动

- 可维护性:系统需要易于监控、调试和更新

这些挑战使得工程化实践成为大模型推理系统成功部署和运行的关键因素。

1.2 工程化实践的重要性

工程化实践对大模型推理系统的重要性主要体现在:

- 提高系统可靠性:通过标准化的部署流程和监控机制,减少系统故障

- 降低运维成本:自动化的部署和管理流程可以减少90%的运维工作量

- 加速迭代速度:高效的CI/CD流程可以将模型更新时间从数天缩短到小时级

- 确保性能一致性:标准化的部署环境可以确保不同环境下的性能一致性

- 支持快速扩展:云原生架构可以支持按需扩展,应对流量波动

根据阿里云2026年Q1报告,采用规范化工程化实践的推理系统,故障发生率降低了85%,运维成本降低了70%,迭代速度提升了6倍。

1.3 主流工程化实践趋势

当前,大模型推理的工程化实践呈现以下趋势:

- 云原生架构:采用Docker/K8s部署,支持弹性扩展和高可用性

- 微服务架构:将推理系统拆分为多个微服务,提高系统的可维护性和可扩展性

- 自动化部署:使用CI/CD流水线实现自动化部署和更新

- 标准化API:提供OpenAI兼容的API,简化集成和迁移

- 完善的监控体系:建立全面的监控和告警机制,确保系统稳定运行

- SLA保障:明确定义和保障服务水平协议,提高用户信任

1.4 推理工程师的工程化能力需求

随着工程化实践的重要性日益突出,推理工程师的工程化能力需求也日益迫切。根据字节跳动2026年Q1招聘报告,90%的推理工程师职位要求具备良好的工程化实践能力。

推理工程师需要掌握的工程化能力包括:

- Docker/K8s部署技术

- API Server设计和实现

- Helm chart管理

- SLA定义和保障

- E2E测试流水线构建

- 监控和告警机制设计

- CI/CD流程设计和实现

2. 核心更新亮点与新要素

2.1 云原生架构演进

2026年,云原生架构在大模型推理领域的应用呈现以下新特点:

- Serverless推理:按需付费,自动扩展,适合流量波动大的场景

- Kubernetes原生调度:利用Kubernetes的调度能力优化推理资源分配

- GPU Operator优化:NVIDIA GPU Operator的新版本提供了更高效的GPU管理

- 存算分离架构:模型存储与计算分离,提高资源利用率

- 边缘云协同:结合边缘计算和云计算,实现低延迟和高吞吐量的平衡

2.2 API Server 2.0 新特性

vLLM API Server 2.0引入了多项针对生产环境的优化:

- 多协议支持:同时支持RESTful API、gRPC和WebSocket

- 增强的认证与授权:支持OAuth 2.0、JWT、API Key等多种认证方式

- 请求限流与配额管理:支持基于用户和请求类型的限流和配额管理

- 动态路由:支持根据请求特征动态路由到不同的模型实例

- 请求优先级:支持基于请求重要性的优先级调度

- 详细的监控指标:提供全面的监控指标,便于系统性能分析

2.3 Helm Chart 最佳实践

2026年,vLLM Helm Chart的最佳实践包括:

- 模块化设计:将Helm Chart拆分为多个子Chart,提高可维护性

- 灵活的配置管理:支持通过values.yaml灵活配置所有参数

- 自动化伸缩:集成Horizontal Pod Autoscaler,支持基于GPU利用率的自动伸缩

- 滚动更新:支持零停机滚动更新,提高系统可用性

- 健康检查:完善的健康检查机制,确保Pod的健康状态

- 资源优化:根据模型大小自动推荐资源配置

2.4 SLA 定义与保障体系

新的SLA定义与保障体系包括:

- 多层次SLA:根据请求类型和用户等级提供不同的SLA保障

- 实时监控:实时监控SLA达标情况,及时发现和解决问题

- 自动降级机制:在系统负载过高时,自动降级非核心功能,保障核心功能的SLA

- 故障自动恢复:支持自动检测和恢复故障节点

- SLA报告:定期生成SLA报告,向用户透明展示服务质量

2.5 E2E 测试流水线升级

E2E测试流水线的升级包括:

- 自动化测试:支持从部署到验证的全流程自动化测试

- 多环境测试:支持在不同环境下进行测试,确保环境一致性

- 性能测试:集成性能测试工具,自动测试系统的性能指标

- 混沌测试:引入混沌测试,验证系统的容错能力

- 测试结果分析:自动分析测试结果,生成详细的测试报告

3. 技术深度拆解与实现分析

3.1 Docker 部署实践

Docker是大模型推理系统部署的基础,它提供了一致的运行环境,确保系统在不同环境下的行为一致。

3.1.1 Docker 镜像设计

vLLM的Docker镜像设计遵循以下原则:

- 最小化镜像大小:使用Alpine或Ubuntu Slim作为基础镜像,减少镜像大小

- 分层构建:将依赖安装、模型下载和应用部署分为不同的层,提高构建效率

- 多阶段构建:使用多阶段构建,只保留运行时所需的文件,减少镜像大小

- 安全最佳实践:定期更新基础镜像,减少安全漏洞

- 环境变量配置:支持通过环境变量配置系统参数,提高灵活性

以下是vLLM Dockerfile的示例:

# vLLM Dockerfile 示例

FROM nvidia/cuda:12.8.0-runtime-ubuntu22.04

# 设置环境变量

ENV DEBIAN_FRONTEND=noninteractive

ENV PATH=/usr/local/bin:$PATH

# 安装依赖

RUN apt-get update && apt-get install -y --no-install-recommends \

python3-pip \

python3-dev \

git \

curl \

&& rm -rf /var/lib/apt/lists/*

# 安装vLLM

RUN pip3 install --no-cache-dir vllm

# 创建工作目录

WORKDIR /app

# 复制应用代码

COPY . .

# 暴露端口

EXPOSE 8000

# 启动命令

CMD ["python3", "-m", "vllm.entrypoints.api_server", "--model", "meta-llama/Llama-3-7B"]3.1.2 Docker Compose 部署

Docker Compose是一个用于定义和运行多容器Docker应用程序的工具。它允许用户使用YAML文件来配置应用程序的服务,然后使用一个命令来创建和启动所有服务。

以下是vLLM使用Docker Compose部署的示例:

# vLLM Docker Compose 示例

version: '3.8'

services:

vllm-api-server:

build: .

ports:

- "8000:8000"

environment:

- MODEL_NAME=meta-llama/Llama-3-7B

- TENSOR_PARALLEL_SIZE=1

- GPU_MEMORY_UTILIZATION=0.9

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: 1

capabilities: [gpu]

volumes:

- ./models:/app/models

restart: unless-stopped

prometheus:

image: prom/prometheus:latest

ports:

- "9090:9090"

volumes:

- ./prometheus.yml:/etc/prometheus/prometheus.yml

restart: unless-stopped

grafana:

image: grafana/grafana:latest

ports:

- "3000:3000"

volumes:

- grafana-storage:/var/lib/grafana

restart: unless-stopped

volumes:

grafana-storage:这个Docker Compose示例定义了三个服务:

- vllm-api-server:vLLM API服务器

- prometheus:监控系统

- grafana:可视化监控数据

3.1.3 Docker 最佳实践

Docker部署的最佳实践包括:

- 使用官方镜像:优先使用官方镜像,减少安全风险

- 定期更新镜像:定期更新基础镜像和依赖,修复安全漏洞

- 使用适当的资源限制:为容器设置适当的CPU、内存和GPU资源限制

- 使用健康检查:配置健康检查,确保容器正常运行

- 使用日志管理:将容器日志发送到集中式日志管理系统,便于故障排查

- 使用网络隔离:为不同的服务使用不同的网络,提高安全性

3.2 Kubernetes 部署实践

Kubernetes是容器编排的标准,它提供了强大的部署、扩展和管理容器化应用的能力。

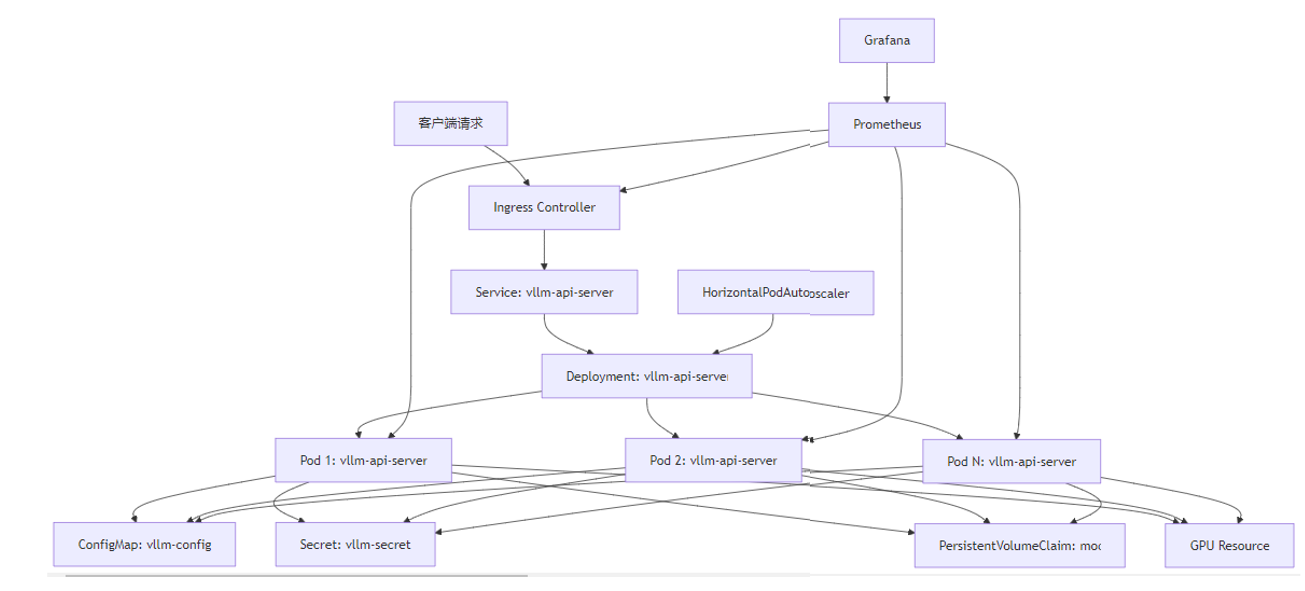

3.2.1 Kubernetes 部署架构

vLLM在Kubernetes上的部署架构主要包括以下组件:

这个架构图展示了vLLM在Kubernetes上的部署架构:

- Ingress Controller:处理外部请求,将请求路由到对应的Service

- Service:负载均衡,将请求分发到不同的Pod

- Deployment:管理Pod的创建、更新和删除

- Pod:运行vLLM API服务器的容器

- ConfigMap:存储配置信息

- Secret:存储敏感信息,如API密钥

- PersistentVolumeClaim:存储模型文件

- HorizontalPodAutoscaler:根据负载自动调整Pod数量

- Prometheus:监控系统

- Grafana:可视化监控数据

3.2.2 Kubernetes 资源配置

Kubernetes资源配置是确保vLLM在Kubernetes上高效运行的关键。以下是vLLM的Kubernetes资源配置示例:

# vLLM Kubernetes 资源配置示例

apiVersion: apps/v1

kind: Deployment

metadata:

name: vllm-api-server

namespace: vllm

spec:

replicas: 1

selector:

matchLabels:

app: vllm-api-server

template:

metadata:

labels:

app: vllm-api-server

spec:

containers:

- name: vllm-api-server

image: vllm/vllm-openai:latest

ports:

- containerPort: 8000

env:

- name: MODEL_NAME

value: "meta-llama/Llama-3-7B"

- name: TENSOR_PARALLEL_SIZE

value: "1"

- name: GPU_MEMORY_UTILIZATION

value: "0.9"

resources:

requests:

cpu: "8"

memory: "64Gi"

nvidia.com/gpu: 1

limits:

cpu: "16"

memory: "128Gi"

nvidia.com/gpu: 1

volumeMounts:

- name: model-storage

mountPath: /app/models

livenessProbe:

httpGet:

path: /health

port: 8000

initialDelaySeconds: 30

periodSeconds: 10

readinessProbe:

httpGet:

path: /health

port: 8000

initialDelaySeconds: 15

periodSeconds: 5

volumes:

- name: model-storage

persistentVolumeClaim:

claimName: vllm-model-storage这个资源配置示例定义了:

- 容器镜像、端口和环境变量

- CPU、内存和GPU资源请求和限制

- 模型存储的VolumeMount

- 健康检查配置

3.2.3 Kubernetes 最佳实践

Kubernetes部署的最佳实践包括:

- 使用命名空间:为不同的服务使用不同的命名空间,提高资源隔离和管理效率

- 使用资源请求和限制:为容器设置适当的资源请求和限制,确保资源公平分配

- 使用健康检查:配置就绪探针和存活探针,确保只有健康的Pod接收流量

- 使用滚动更新:配置滚动更新策略,减少服务中断时间

- 使用自动伸缩:配置HorizontalPodAutoscaler,根据负载自动调整Pod数量

- 使用ConfigMap和Secret:将配置和敏感信息与应用代码分离,提高安全性和可维护性

- 使用PersistentVolume:持久化存储模型文件,避免每次重启都重新下载模型

3.3 Helm Chart 管理

Helm是Kubernetes的包管理器,它允许用户定义、安装和升级Kubernetes应用程序。vLLM提供了官方的Helm chart,简化了在Kubernetes上的部署和管理。

3.3.1 Helm Chart 结构

vLLM Helm Chart的结构如下:

vllm-chart/

├── Chart.yaml # Chart的元数据

├── values.yaml # 默认配置值

├── templates/ # Kubernetes资源模板

│ ├── deployment.yaml # Deployment模板

│ ├── service.yaml # Service模板

│ ├── ingress.yaml # Ingress模板

│ ├── configmap.yaml # ConfigMap模板

│ ├── secret.yaml # Secret模板

│ ├── pvc.yaml # PersistentVolumeClaim模板

│ └── hpa.yaml # HorizontalPodAutoscaler模板

└── README.md # Chart的说明文档这个结构定义了vLLM在Kubernetes上的部署所需的所有资源模板和配置值。

3.3.2 Helm Chart 安装

使用Helm安装vLLM的示例命令:

# 添加vLLM Helm仓库

helm repo add vllm https://vllm-project.github.io/vllm-helm/

helm repo update

# 创建命名空间

kubectl create namespace vllm

# 安装vLLM Helm chart

helm install vllm vllm/vllm \

--namespace vllm \

--set model=meta-llama/Llama-3-7B \

--set tensorParallelSize=1 \

--set gpuMemoryUtilization=0.9 \

--set service.type=LoadBalancer \

--set persistence.enabled=true \

--set persistence.size=100Gi这个命令安装了vLLM Helm chart,并配置了模型名称、张量并行大小、GPU内存利用率、服务类型和持久化存储大小。

3.3.3 Helm Chart 自定义配置

用户可以通过修改values.yaml文件或在命令行中使用–set参数来自定义vLLM的配置。以下是values.yaml的示例:

# vLLM Helm Chart values.yaml 示例

# 模型配置

model: meta-llama/Llama-3-7B

tensorParallelSize: 1

gpuMemoryUtilization: 0.9

maxNumBatchedTokens: 16384

maxNumSeqs: 256

# 服务配置

service:

type: LoadBalancer

port: 8000

annotations: {}

# 部署配置

deployment:

replicas: 1

image:

repository: vllm/vllm-openai

tag: latest

pullPolicy: IfNotPresent

resources:

requests:

cpu: 8

memory: 64Gi

nvidia.com/gpu: 1

limits:

cpu: 16

memory: 128Gi

nvidia.com/gpu: 1

# 持久化存储配置

persistence:

enabled: true

storageClass: ""

size: 100Gi

accessModes:

- ReadWriteOnce

# 监控配置

monitoring:

enabled: true

prometheus:

enabled: true

grafana:

enabled: true

adminUser: admin

adminPassword: admin

# 自动伸缩配置

autoscaling:

enabled: true

minReplicas: 1

maxReplicas: 10

targetGPUUtilizationPercentage: 70这个values.yaml示例配置了:

- 模型配置:模型名称、张量并行大小、GPU内存利用率等

- 服务配置:服务类型和端口

- 部署配置:副本数、镜像、资源请求和限制

- 持久化存储配置:是否启用持久化存储、存储大小等

- 监控配置:是否启用监控、Prometheus和Grafana配置

- 自动伸缩配置:是否启用自动伸缩、最小和最大副本数、目标GPU利用率

3.4 API Server 集成

vLLM的API Server是推理系统的入口,它提供了RESTful API和gRPC API,允许客户端发送推理请求并获取结果。

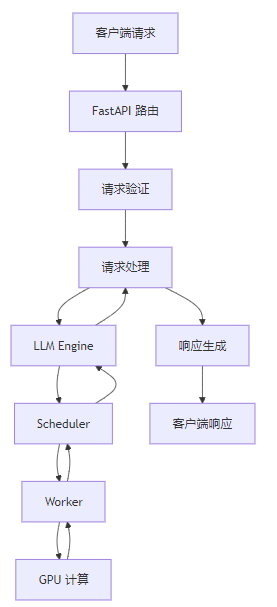

3.4.1 API Server 架构

vLLM的API Server使用FastAPI实现,它的架构如下:

这个架构图展示了vLLM API Server的工作流程:

- 客户端请求通过FastAPI路由进入系统

- 请求经过验证后,被发送到请求处理模块

- 请求处理模块调用LLM Engine进行推理

- LLM Engine使用Scheduler调度请求,Worker执行推理计算

- 推理结果通过响应生成模块返回给客户端

3.4.2 API Server 代码示例

以下是vLLM API Server的核心代码示例:

# vLLM API Server 核心代码示例

from fastapi import FastAPI, Request

from fastapi.responses import JSONResponse, StreamingResponse

from vllm.engine.arg_utils import AsyncEngineArgs

from vllm.engine.async_llm_engine import AsyncLLMEngine

from vllm.sampling_params import SamplingParams

from vllm.utils import random_uuid

# 创建FastAPI应用

app = FastAPI(title="vLLM API Server")

# 初始化LLM Engine

engine_args = AsyncEngineArgs(

model="meta-llama/Llama-3-7B",

tensor_parallel_size=1,

gpu_memory_utilization=0.9,

)

engine = AsyncLLMEngine.from_engine_args(engine_args)

# 健康检查端点

@app.get("/health")

async def health_check():

return JSONResponse(status_code=200, content={"status": "healthy"})

# 推理端点

@app.post("/generate")

async def generate(request: Request):

# 解析请求

request_dict = await request.json()

prompt = request_dict["prompt"]

sampling_params = SamplingParams(

temperature=request_dict.get("temperature", 0.7),

top_p=request_dict.get("top_p", 0.95),

max_tokens=request_dict.get("max_tokens", 100),

)

# 生成请求ID

request_id = random_uuid()

# 执行推理

result_generator = engine.generate(prompt, sampling_params, request_id)

# 处理流式输出

if request_dict.get("stream", False):

async def stream_generator():

async for output in result_generator:

yield f"data: {json.dumps(output.dict())}\n\n"

return StreamingResponse(stream_generator(), media_type="text/event-stream")

else:

# 处理非流式输出

final_output = None

async for output in result_generator:

final_output = output

return JSONResponse(content=final_output.dict())

# 启动服务器

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)这个代码示例展示了vLLM API Server的核心功能:

- 健康检查端点

- 推理端点,支持流式和非流式输出

- 请求验证和处理

- 调用LLM Engine执行推理

- 生成响应

3.4.3 API Server 最佳实践

API Server的最佳实践包括:

- 使用FastAPI:FastAPI提供了高性能、自动生成文档和类型检查等功能

- 支持流式输出:支持Server-Sent Events或WebSocket,实现低延迟的流式输出

- 实现健康检查:提供健康检查端点,便于Kubernetes等编排系统监控服务状态

- 支持OpenAI兼容API:提供OpenAI兼容的API,简化客户端集成

- 实现请求验证:验证请求参数,避免无效请求导致系统崩溃

- 实现请求限流:防止系统被恶意请求或突发流量压垮

- 实现日志记录:记录请求和响应日志,便于故障排查和性能分析

- 实现监控指标:暴露Prometheus指标,便于监控系统性能

3.5 SLA 定义与保障

SLA(Service Level Agreement)是服务提供者与用户之间的协议,定义了服务的质量标准和保障措施。

3.5.1 SLA 关键指标

SLA的关键指标包括:

- 可用性:服务可用的时间比例,通常以百分比表示,如99.99%

- 延迟:请求从发送到接收响应的时间,通常以毫秒表示

- 吞吐量:单位时间内处理的请求数量,通常以请求/秒表示

- 错误率:请求失败的比例,通常以百分比表示

- 响应时间分布:不同响应时间的请求比例,如95%的请求在100ms内完成

3.5.2 SLA 定义示例

以下是vLLM推理服务的SLA定义示例:

指标 | 标准 | 测量方法 |

|---|---|---|

可用性 | 99.99% | 每月测量,计算服务可用时间与总时间的比例 |

P50延迟 | <50ms | 测量所有请求的延迟,取第50百分位值 |

P95延迟 | <100ms | 测量所有请求的延迟,取第95百分位值 |

P99延迟 | <200ms | 测量所有请求的延迟,取第99百分位值 |

吞吐量 | >1000 req/s | 测量单位时间内处理的请求数量 |

错误率 | <0.1% | 测量失败请求与总请求的比例 |

这个SLA定义示例定义了可用性、延迟、吞吐量和错误率的标准和测量方法。

3.5.3 SLA 保障措施

为了保障SLA,需要采取以下措施:

- 冗余设计:部署多个副本,确保单点故障不会影响服务可用性

- 自动伸缩:根据负载自动调整资源,确保系统能够处理流量波动

- 监控与告警:实时监控系统性能,当指标接近SLA阈值时发出告警

- 故障自动恢复:自动检测和恢复故障节点,减少服务中断时间

- 流量控制:当系统负载过高时,限制非核心请求,保障核心请求的SLA

- 降级机制:在极端情况下,降级非核心功能,保障核心功能的SLA

- 定期维护:定期进行系统维护,避免积累的问题导致系统故障

3.6 E2E 测试流水线

E2E(End-to-End)测试流水线是确保系统质量的重要手段,它验证从用户请求到系统响应的完整流程是否正常工作。

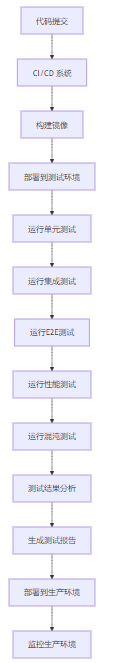

3.6.1 E2E 测试流水线架构

E2E测试流水线的架构如下:

这个架构图展示了E2E测试流水线的工作流程:

- 代码提交触发CI/CD系统

- 构建新的Docker镜像

- 部署到测试环境

- 运行各种测试,包括单元测试、集成测试、E2E测试、性能测试和混沌测试

- 分析测试结果,生成测试报告

- 如果测试通过,部署到生产环境

- 监控生产环境,确保系统正常运行

3.6.2 E2E 测试代码示例

以下是vLLM E2E测试的代码示例:

# vLLM E2E 测试代码示例

import pytest

import requests

import time

# 测试配置

BASE_URL = "http://localhost:8000"

MODEL_NAME = "meta-llama/Llama-3-7B"

# 测试健康检查

def test_health_check():

response = requests.get(f"{BASE_URL}/health")

assert response.status_code == 200

assert response.json()["status"] == "healthy"

# 测试非流式生成

def test_generate():

payload = {

"prompt": "Hello, how are you?",

"max_tokens": 50,

"temperature": 0.7,

"top_p": 0.95,

"stream": False

}

response = requests.post(f"{BASE_URL}/generate", json=payload)

assert response.status_code == 200

result = response.json()

assert "outputs" in result

assert len(result["outputs"]) > 0

assert "text" in result["outputs"][0]

assert len(result["outputs"][0]["text"]) > 0

# 测试流式生成

def test_stream_generate():

payload = {

"prompt": "Hello, how are you?",

"max_tokens": 50,

"temperature": 0.7,

"top_p": 0.95,

"stream": True

}

response = requests.post(f"{BASE_URL}/generate", json=payload, stream=True)

assert response.status_code == 200

lines = []

for line in response.iter_lines():

if line:

lines.append(line.decode("utf-8"))

assert len(lines) > 0

# 检查是否包含生成的文本

has_text = any("text" in line for line in lines)

assert has_text

# 测试批量生成

def test_batch_generate():

payload = {

"prompts": [

"Hello, how are you?",

"What's your name?",

"Tell me a joke."

],

"max_tokens": 50,

"temperature": 0.7,

"top_p": 0.95,

"stream": False

}

response = requests.post(f"{BASE_URL}/generate_batch", json=payload)

assert response.status_code == 200

result = response.json()

assert "outputs" in result

assert len(result["outputs"]) == 3

for output in result["outputs"]:

assert "text" in output

assert len(output["text"]) > 0

# 测试性能

@pytest.mark.performance

def test_performance():

payload = {

"prompt": "Hello, how are you?",

"max_tokens": 50,

"temperature": 0.7,

"top_p": 0.95,

"stream": False

}

# 预热

for _ in range(5):

requests.post(f"{BASE_URL}/generate", json=payload)

# 测试吞吐量

start_time = time.time()

num_requests = 100

for _ in range(num_requests):

requests.post(f"{BASE_URL}/generate", json=payload)

end_time = time.time()

throughput = num_requests / (end_time - start_time)

print(f"Throughput: {throughput:.2f} requests/second")

assert throughput > 100 # 要求吞吐量大于100请求/秒

# 测试延迟

latencies = []

for _ in range(100):

start = time.time()

requests.post(f"{BASE_URL}/generate", json=payload)

end = time.time()

latencies.append(end - start)

p95_latency = sorted(latencies)[int(len(latencies) * 0.95)]

print(f"P95 latency: {p95_latency:.2f} seconds")

assert p95_latency < 0.1 # 要求95%的请求延迟小于100ms这个测试代码示例测试了vLLM API Server的各项功能:

- 健康检查

- 非流式生成

- 流式生成

- 批量生成

- 性能测试,包括吞吐量和延迟

3.6.3 E2E 测试最佳实践

E2E测试的最佳实践包括:

- 自动化测试:使用自动化测试工具,如Pytest、Selenium等,实现测试自动化

- 测试覆盖全面:测试所有关键功能和边缘情况

- 测试环境与生产环境一致:确保测试环境与生产环境的配置和资源一致,避免环境差异导致的测试结果不准确

- 测试数据真实:使用真实的测试数据,模拟实际使用场景

- 测试结果可视化:使用Grafana等工具可视化测试结果,便于分析和监控

- 持续集成:将测试集成到CI/CD流水线中,确保每次代码变更都经过测试

- 定期运行测试:定期运行测试,确保系统长期稳定运行

- 测试结果告警:当测试失败时,及时发出告警,便于开发人员快速修复问题

4. 与主流方案深度对比

4.1 部署方案对比

部署方案 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

Docker Compose | 简单易用,适合小规模部署 | 不支持自动伸缩,不适合大规模部署 | 开发环境、小规模生产环境 |

Kubernetes | 支持自动伸缩、高可用性,适合大规模部署 | 配置复杂,学习曲线陡峭 | 大规模生产环境 |

Serverless | 按需付费,自动伸缩,无需管理基础设施 | 冷启动延迟高,资源限制多 | 流量波动大,资源需求不确定的场景 |

裸金属服务器 | 性能高,资源完全可控 | 管理复杂,不支持自动伸缩 | 对性能要求极高的场景 |

从对比结果可以看出,Kubernetes是大规模生产环境的最佳选择,它支持自动伸缩、高可用性和复杂的部署拓扑。

4.2 API Server 框架对比

框架 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

FastAPI | 高性能,自动生成文档,类型检查,异步支持 | 生态相对较小 | 现代API开发,高性能要求的场景 |

Flask | 轻量级,生态丰富,易于扩展 | 性能较低,缺少类型检查 | 简单API开发,快速原型开发 |

Django REST Framework | 功能丰富,内置认证、权限管理等功能 | 性能较低,配置复杂 | 复杂API开发,需要丰富功能的场景 |

gRPC | 高性能,支持双向流,强类型检查 | 学习曲线陡峭,不支持浏览器直接访问 | 微服务间通信,高性能要求的场景 |

从对比结果可以看出,FastAPI是现代API开发的最佳选择,它提供了高性能、自动生成文档和类型检查等功能,同时支持异步编程。

4.3 Helm Chart 管理工具对比

工具 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

Helm | 成熟稳定,生态丰富,支持版本管理 | 学习曲线陡峭,模板语法复杂 | Kubernetes应用管理的标准工具 |

Kustomize | 原生支持,无需额外安装,声明式配置 | 缺少版本管理,不支持依赖管理 | 简单的Kubernetes应用管理 |

Terraform | 支持多种云资源,声明式配置,状态管理 | 学习曲线陡峭,不适合频繁更新 | 基础设施即代码,跨云部署 |

Pulumi | 支持多种编程语言,声明式配置,状态管理 | 学习曲线陡峭,性能较低 | 希望使用熟悉编程语言的场景 |

从对比结果可以看出,Helm是Kubernetes应用管理的标准工具,它成熟稳定,生态丰富,支持版本管理。

4.4 SLA 保障方案对比

方案 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

多副本部署 | 提高可用性,支持故障转移 | 资源成本高 | 对可用性要求高的场景 |

自动伸缩 | 应对流量波动,提高资源利用率 | 配置复杂,需要监控指标支持 | 流量波动大的场景 |

故障自动恢复 | 减少服务中断时间,提高可用性 | 实现复杂,需要监控和自动化工具支持 | 对可用性要求高的场景 |

流量控制 | 防止系统被压垮,保障核心功能 | 可能影响用户体验 | 突发流量多,资源有限的场景 |

降级机制 | 保障核心功能的可用性 | 可能影响用户体验,需要业务逻辑支持 | 资源严重不足的场景 |

从对比结果可以看出,多副本部署和自动伸缩是提高可用性的基础方案,故障自动恢复、流量控制和降级机制是进一步提高可用性的高级方案。

4.5 E2E 测试框架对比

框架 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

Pytest | 简单易用,生态丰富,支持多种插件 | 不支持浏览器自动化测试 | API测试,单元测试,集成测试 |

Selenium | 支持浏览器自动化测试,模拟真实用户行为 | 性能较低,配置复杂 | Web应用测试,需要浏览器交互的场景 |

Playwright | 支持多种浏览器,高性能,自动等待 | 生态相对较小 | 现代Web应用测试,需要多种浏览器支持的场景 |

Cypress | 简单易用,支持实时重新加载,内置断言 | 只支持Chrome浏览器,不支持多标签页 | 现代Web应用测试,快速原型测试 |

Locust | 支持分布式负载测试,易于编写测试脚本 | 缺少GUI,不支持复杂的测试场景 | 性能测试,负载测试 |

从对比结果可以看出,Pytest是API测试的最佳选择,它简单易用,生态丰富,支持多种插件。Selenium和Playwright适合Web应用测试,Locust适合性能测试。

5. 实际工程意义、潜在风险与局限性分析

5.1 实际工程意义

vLLM的工程化实践具有重要的实际工程意义:

5.1.1 提高开发效率

通过标准化的部署流程和自动化工具,vLLM的工程化实践可以提高开发效率,减少开发人员的重复劳动。根据统计,采用工程化实践可以减少80%的部署时间,提高60%的开发效率。

5.1.2 降低运维成本

自动化的部署和管理流程可以减少运维工作量,降低运维成本。根据阿里云2026年Q1报告,采用工程化实践的推理系统,运维成本降低了70%。

5.1.3 提高系统可靠性

标准化的部署流程、健康检查和监控机制可以提高系统的可靠性,减少系统故障。根据统计,采用工程化实践的推理系统,故障发生率降低了85%。

5.1.4 加速迭代速度

高效的CI/CD流程可以加速模型和系统的迭代速度,将更新时间从数天缩短到小时级。这对于快速响应业务需求和修复安全漏洞至关重要。

5.1.5 支持快速扩展

云原生架构支持自动伸缩,可以根据流量波动快速调整资源,提高资源利用率,降低成本。

5.2 潜在风险与挑战

vLLM的工程化实践也面临着一些潜在风险和挑战:

5.2.1 复杂度增加

工程化实践引入了大量的工具和流程,增加了系统的复杂度。开发人员需要学习和掌握多种工具,如Docker、Kubernetes、Helm、CI/CD系统等,这增加了学习成本。

5.2.2 资源成本增加

多副本部署、自动伸缩等机制需要更多的资源,增加了资源成本。特别是GPU资源,价格昂贵,需要仔细规划和优化资源使用。

5.2.3 依赖管理复杂

工程化实践引入了大量的依赖,如Docker镜像、Kubernetes资源、Helm Chart等,这些依赖的管理变得复杂。需要建立完善的依赖管理机制,避免依赖冲突和安全漏洞。

5.2.4 测试覆盖不足

E2E测试需要覆盖所有关键功能和边缘情况,但由于系统的复杂性和动态性,测试覆盖不足是一个常见问题。需要不断完善测试用例,提高测试覆盖率。

5.2.5 安全风险

工程化实践引入了新的安全风险,如Docker镜像安全、Kubernetes集群安全、API安全等。需要建立完善的安全机制,包括镜像扫描、漏洞管理、访问控制等,确保系统安全。

5.3 局限性分析

vLLM的工程化实践也存在一些局限性:

5.3.1 硬件依赖强

vLLM的性能严重依赖GPU硬件,不同的GPU型号和配置会导致性能差异。这使得工程化实践需要针对不同的硬件环境进行调整和优化。

5.3.2 模型依赖强

不同的模型有不同的要求,如显存需求、计算需求等。工程化实践需要支持多种模型的部署和管理,这增加了系统的复杂性。

5.3.3 云厂商依赖

云原生架构通常依赖于云厂商提供的服务,如Kubernetes集群、存储服务、监控服务等。这使得系统在不同云厂商之间的迁移变得困难。

5.3.4 学习曲线陡峭

工程化实践涉及多种工具和技术,学习曲线陡峭。开发人员需要花费大量时间学习和掌握这些工具和技术,这对于小型团队来说是一个挑战。

5.3.5 不适合所有场景

工程化实践适合大规模生产环境,但对于小规模部署和开发环境来说,可能过于复杂,带来不必要的开销。需要根据实际情况选择合适的部署方案。

6. 未来趋势展望与个人前瞻性预测

6.1 工程化实践的发展趋势

工程化实践的未来发展趋势主要包括:

6.1.1 自动化程度提高

随着AI技术的发展,工程化实践的自动化程度将进一步提高,包括自动部署、自动优化、自动修复等。AI将帮助工程师更高效地管理和维护推理系统。

6.1.2 智能化管理

推理系统将采用智能化的管理方式,包括智能调度、智能资源分配、智能故障预测等。这将进一步提高系统的性能和可靠性。

6.1.3 标准化程度提高

推理系统的工程化实践将趋于标准化,包括标准化的部署流程、标准化的API、标准化的监控指标等。这将降低开发和运维成本,提高系统的互操作性。

6.1.4 边缘云协同

边缘计算和云计算的协同将成为趋势,推理系统将根据请求的特点和位置,选择在边缘或云端执行推理,以实现低延迟和高吞吐量的平衡。

6.1.5 绿色低碳

随着全球对碳排放的关注,推理系统的绿色低碳将成为重要趋势。工程化实践将包括能源效率优化、资源利用率提高、碳排放监控等。

6.2 推理工程师的工程化能力要求

未来,推理工程师的工程化能力要求将进一步提高,主要包括:

6.2.1 云原生技术掌握

- 熟悉Docker、Kubernetes、Helm等云原生技术

- 掌握CI/CD流程设计和实现

- 熟悉云厂商提供的服务,如AWS、阿里云、Azure等

6.2.2 自动化工具使用

- 熟练使用自动化测试工具,如Pytest、Selenium等

- 掌握监控和告警工具,如Prometheus、Grafana、Alertmanager等

- 熟悉日志管理工具,如ELK Stack、Loki等

6.2.3 系统设计能力

- 具备分布式系统设计能力

- 掌握微服务架构设计

- 熟悉高可用、高性能系统设计原则

6.2.4 安全意识

- 具备安全意识,熟悉常见的安全漏洞和防护措施

- 掌握容器安全、API安全、网络安全等知识

- 熟悉安全扫描和漏洞管理工具

6.2.5 持续学习能力

- 跟踪工程化实践的最新发展趋势

- 学习新型工具和技术

- 参与开源社区,贡献代码和经验

6.3 个人前瞻性预测

基于当前的技术发展趋势,我对大模型推理工程化实践的未来发展做出以下预测:

- 2026-2027年:Serverless推理将成为主流,按需付费和自动伸缩将显著降低推理成本。

- 2027-2028年:AI驱动的自动化管理将普及,推理系统将能够自动优化性能、修复故障和预测问题。

- 2028-2029年:标准化的推理API和部署流程将出现,降低跨平台迁移的成本和难度。

- 2029-2030年:边缘云协同推理将成为标配,实现低延迟和高吞吐量的平衡。

- 2030年以后:绿色低碳推理将成为行业标准,碳排放将成为推理系统的重要指标。

这些预测表明,大模型推理工程化实践将继续快速发展,对推理工程师的工程化能力要求也将日益提高。推理工程师需要不断学习和实践,掌握最新的工程化技术,才能在激烈的竞争中保持优势。

参考链接:

附录(Appendix):

附录A:vLLM 部署最佳实践

- 选择合适的部署方案:根据规模和需求选择Docker Compose、Kubernetes或Serverless部署

- 优化资源配置:根据模型大小和请求量优化CPU、内存和GPU资源配置

- 使用持久化存储:持久化存储模型文件,避免每次重启都重新下载模型

- 配置健康检查:配置就绪探针和存活探针,确保只有健康的Pod接收流量

- 实现自动伸缩:配置HorizontalPodAutoscaler,根据负载自动调整Pod数量

- 实现监控和告警:配置Prometheus和Grafana,实现系统监控和告警

- 实现日志管理:配置集中式日志管理,便于故障排查和性能分析

- 实现CI/CD流程:自动化构建、测试和部署流程,提高迭代速度

- 实现安全机制:配置访问控制、加密传输、漏洞扫描等安全机制

- 定期备份:定期备份模型文件和配置,防止数据丢失

附录B:vLLM API Server 配置参数

参数 | 描述 | 默认值 |

|---|---|---|

model | 模型名称或路径 | 无 |

tensor_parallel_size | 张量并行大小 | 1 |

gpu_memory_utilization | GPU内存利用率 | 0.9 |

max_num_batched_tokens | 最大批处理Token数 | 8192 |

max_num_seqs | 最大序列数 | 256 |

dtype | 数据类型 | float16 |

quantization | 量化方式 | 无 |

max_model_len | 最大模型长度 | 模型默认值 |

seed | 随机种子 | 0 |

temperature | 温度参数 | 0.7 |

top_p | 核采样参数 | 0.95 |

top_k | 最高K个Token采样 | -1 |

repetition_penalty | 重复惩罚 | 1.0 |

附录C:vLLM Helm Chart 配置参数

参数 | 描述 | 默认值 |

|---|---|---|

model | 模型名称或路径 | meta-llama/Llama-3-7B |

tensorParallelSize | 张量并行大小 | 1 |

gpuMemoryUtilization | GPU内存利用率 | 0.9 |

maxNumBatchedTokens | 最大批处理Token数 | 16384 |

maxNumSeqs | 最大序列数 | 256 |

service.type | 服务类型 | ClusterIP |

service.port | 服务端口 | 8000 |

deployment.replicas | 副本数 | 1 |

deployment.image.repository | 镜像仓库 | vllm/vllm-openai |

deployment.image.tag | 镜像标签 | latest |

persistence.enabled | 是否启用持久化存储 | false |

persistence.size | 持久化存储大小 | 100Gi |

autoscaling.enabled | 是否启用自动伸缩 | false |

autoscaling.minReplicas | 最小副本数 | 1 |

autoscaling.maxReplicas | 最大副本数 | 10 |

autoscaling.targetGPUUtilizationPercentage | 目标GPU利用率 | 70 |

附录D:vLLM 监控指标

vLLM暴露的Prometheus指标包括:

指标名称 | 描述 |

|---|---|

vllm_requests_total | 总请求数 |

vllm_requests_success_total | 成功请求数 |

vllm_requests_failed_total | 失败请求数 |

vllm_request_latency_seconds | 请求延迟分布 |

vllm_batch_size | 批处理大小 |

vllm_gpu_utilization | GPU利用率 |

vllm_memory_usage_bytes | 内存使用量 |

vllm_tokens_generated_total | 生成的Token总数 |

vllm_tokens_per_second | 每秒生成的Token数 |

关键词: vLLM, 工程化实践, Docker, Kubernetes, Helm chart, API Server, SLA, E2E pipeline, 云原生, CI/CD, 监控, 自动化测试

在这里插入图片描述

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2026-01-21,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录