AI辅助测试体系从零到一:测试新人的安全落地指南

原创AI辅助测试体系从零到一:测试新人的安全落地指南

原创霍格沃兹-测试开发学社

发布于 2026-01-26 16:11:56

发布于 2026-01-26 16:11:56

最近半年,后台总有测试同行问我:“老杨,现在AI这么火,我们团队想搭AI辅助测试体系,该从哪下手?”“试过用ChatGPT写测试用例,但总觉得不贴合业务,越用越乱怎么办?”“AI辅助测试是不是只适合大厂?中小团队没资源能落地吗?”

作为在测试行业摸爬滚打的老兵,之前牵头给团队搭过一套完整的AI辅助测试体系——没有堆昂贵的设备,也没有找外部专家,就是靠内部现有资源,一步步从0到1落地,最终把回归测试效率提了40%,缺陷提前发现率提升25%。

今天就把这份实战经验拆给大家,没有空泛的理论,全是能直接照做的步骤、踩过的坑和避坑技巧,特别适合测试新人。不管你是普通测试工程师,还是想牵头落地AI测试的测开,看完都能少走弯路。

安全第一条原则

在开始前,我必须强调一个铁律:任何公司内部数据(包括需求文档、代码、接口文档等)都不要随意上传至外部公有AI服务(如ChatGPT、Gemini、文心一言的公开网站或API)。建议所有探索都在公司认可的安全环境下进行。

第一步:先对齐认知+盘点资源,别上来就瞎折腾

很多团队搭建AI辅助测试体系,第一步就错了:上来就找各种AI工具,今天试Gemini,明天装AutoGPT,折腾半个月没出成果,最后不了了之。

我的经验是,正式动手前,先花1-2周做两件事,比盲目试工具管用10倍。

1. 对齐团队认知:明确“要解决什么问题”

先拉上团队核心成员(测试、测开、开发负责人)开个短会,统一两个问题,避免后续内耗:

① 我们当前测试工作中,最耗时、最重复的环节是什么?(比如我团队当时是“回归测试用例编写占30%时间”“测试数据造数要花2天/版本”“日志排查平均要1小时/个问题”)

② 我们期望AI辅助达到什么效果?(别贪多,聚焦1-2个核心目标,比如“把回归用例编写效率提30%”“日志排查时间缩短至10分钟/个”,目标越具体,越容易落地)

这里给个实操建议:找1-2个近期上线的版本,统计各测试环节的耗时占比,把“重复且低效”的环节列成清单,按“易落地、见效快”排序,优先解决Top2问题——比如先搞定“AI辅助写用例+AI辅助造数”,再碰日志分析、缺陷预测等复杂场景。

2. 盘点现有资源:中小团队也能落地的基础配置

别觉得AI测试门槛高,其实中小团队有这些资源就够了,不用额外砸钱:

① 工具层面:

- AI工具选择:优先使用公司内部提供的大模型服务(很多公司已有)。如果没有,可以在隔离环境探索本地开源模型(如:Llama-3.2-3B、Gemini Pro 、Qwen2.5-7B)。

- 重要提醒:切勿因方便而使用个人账号的公开AI服务处理工作数据,这是严重违规。

- 测试工具复用:现有自动化框架(Selenium、Appium、Postman)、缺陷管理工具(Jira)、日志分析工具(ELK)直接复用。

② 人员层面:

- 理想情况:有1名懂Python(或其他编程语言)的同事支持集成工作。

- 现实情况(对新人友好):即使没有开发支持,测试工程师也可以从设计提示词、整理业务规则、人工验证结果开始。这是AI落地的核心,技术集成可以后续推进。

③ 数据层面:整理团队过往的优质测试用例、清晰的缺陷报告、典型的日志文件。注意:这些不是用来“训练AI”,而是用来提炼业务规则和作为参考样例,让AI输出的结果更贴合实际。

小贴士:如果团队技术基础较弱,完全可以采用“人工中转”方式:你整理好提示词和业务规则,在安全环境下使用AI,然后将结果手动整理到用例管理系统。先验证价值,再考虑自动化。

第二步:核心落地环节(3个场景,附实操步骤)

搭建AI辅助测试体系,不用追求“大而全”,先把3个核心场景落地,就能快速看到效果。这3个场景也是我团队当时优先攻克的,操作简单、见效快,适合所有测试团队。

场景1:AI辅助测试用例生成(最易落地,当天就能试)

很多人用AI写用例,只扔一句“帮我写XX功能的测试用例”,结果AI输出的用例要么太笼统,要么漏业务场景——问题不是AI不行,是你没给够“约束和参考”。

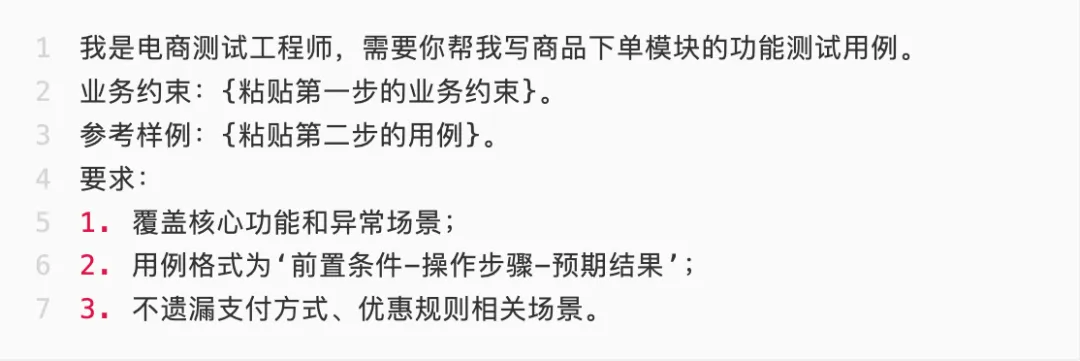

我团队的实操步骤(以电商“商品下单”模块为例),直接照做:

- 先整理“业务约束文档”:把该模块的核心规则、异常场景、依赖条件写清楚(比如“下单前必须登录”“库存不足时无法下单”“支持微信/支付宝两种支付方式”“满300减50优惠规则”),不用太长,200-300字就行。

- 给AI喂“参考样例”:挑2-3条团队过往写的高质量用例(比如“用例1:未登录状态下点击下单,验证提示‘请先登录’;用例2:库存为0时下单,验证提示‘库存不足’”),让AI模仿这个风格和颗粒度。

- 写精准提示词(直接套用模板):

图片

- 人工校验+迭代:AI生成用例后,测试工程师重点检查3点——是否覆盖核心业务场景、是否有逻辑错误、步骤是否可执行,把不合格的用例标注出来,反馈给AI(比如“缺少‘优惠券过期后下单’的场景,按参考样例补充”),让AI二次优化。

落地效果:原本需要1天写的下单模块回归用例,现在AI生成+人工校验只要2小时,效率提升70%,且用例贴合业务,漏测率比纯人工写还低。

场景2:AI辅助测试数据生成(解决“造数难”痛点)

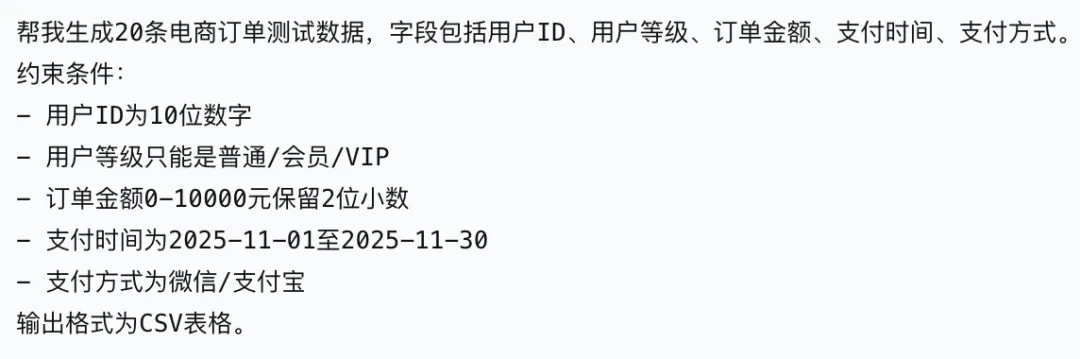

测试中最耗时的环节之一,就是造测试数据——比如测试电商订单模块,需要造不同用户等级、不同商品类型、不同支付金额的数据。

以前我们团队靠手动造数,一个版本要花2天,现在用AI+简单校验,效率大幅提升,实操步骤:

- 明确数据规则:先梳理清楚需要的测试数据格式、约束条件(比如“用户ID:10位数字;用户等级:普通/会员/VIP;订单金额:0-10000元,保留2位小数;支付时间:近30天内”)。

- 用AI生成基础数据:给AI发提示词:

图片

- 关键步骤:数据校验与使用

- 人工校验:检查生成的数据是否符合业务逻辑(比如不会出现“订单金额为0但支付成功”的情况)

- 安全使用:不要直接批量灌入共享测试数据库。最佳实践是通过调用业务的“创建”接口来生成数据,或者将数据用于独立的测试集。

避坑提醒:AI生成的数据可能存在重复或边界情况遗漏,一定要加一层人工校验,确保数据质量。

场景3:AI辅助日志分析(快速定位缺陷根源)

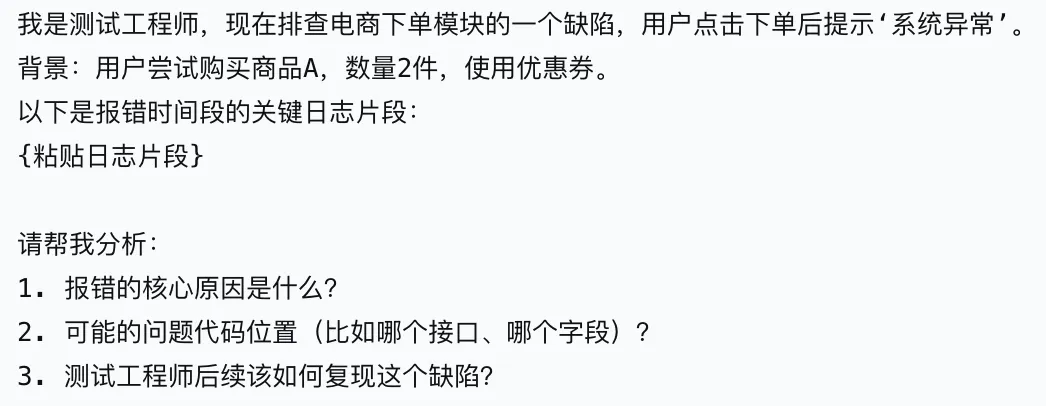

测试过程中遇到问题,我们经常要翻几千行甚至几万行日志,找报错信息。现在用AI辅助,可以快速定位问题,实操步骤:

- 提取关键日志片段:先通过ELK等工具,筛选出报错时间段、相关模块的日志(比如“2025-11-20 14:00-14:30,商品下单模块的ERROR日志”),尽量提供一次完整请求链路的跟踪ID相关的所有日志,而不只是错误行。

- 给AI发提示词(直接套用):

图片

3. 结合业务验证:AI给出分析结果后,不要直接信,要结合业务场景验证(比如AI说“可能是库存字段为Null导致”,就去测试环境查该订单对应的商品库存,复现场景验证)。

落地效果:以前平均1小时/个的日志排查,现在缩短到10-15分钟,缺陷定位效率提升75%。注意:AI更适合分析模式明确、错误信息清晰的日志,对于复杂的分布式问题,仍需人工深入分析。

第三步:体系化落地(从“单点使用”到“流程融入”)

如果只是偶尔用AI写个用例、分析个日志,那不叫“AI辅助测试体系”,只能算“工具滥用”。真正的体系化,是把AI融入到测试全流程,形成“AI输出-人工校验-迭代优化”的闭环。

1. 融入测试全流程

不用重构现有测试流程,只要在关键节点加入AI辅助:

测试阶段 | AI辅助点 | 注意事项 |

|---|---|---|

需求阶段 | 梳理需求要点,生成Checklist | 产出仅作参考,需与产品确认 |

用例设计 | 生成基础用例,人工补充复杂场景 | 必须人工校验和补充 |

测试执行 | 生成测试数据,辅助日志分析 | 数据需校验,日志分析需验证 |

缺陷管理 | 优化缺陷描述,归类缺陷 | 描述需人工最终确认 |

2. 制定2个核心规范(避免团队用法混乱)

体系化落地,规范比工具更重要:

① 提示词规范:统一提示词模板(业务约束+参考样例+输出要求),让团队所有人都按这个模板写提示词。

② 结果校验规范:明确AI输出结果必须人工校验,谁使用AI生成内容,谁负责最终质量。这是质量保障的底线。

3. 持续迭代优化(根据业务调整,越用越顺)

建议每个版本结束后,花30分钟做一次复盘:

- 效果复盘:AI辅助的环节,效率提升了多少?有没有出现漏测、误判的情况?

- 优化动作:针对问题调整提示词、补充参考样例、更新业务约束。

我们团队每季度会更新一次“AI测试知识库”,把优质的提示词、参考样例、校验规则整理进去,新人入职后能快速上手。

避坑提醒:这4个坑,我踩过,你们别再踩了

1. 坑1:贪多求全

问题:一开始就想做“AI缺陷预测、AI自动化全流程”。

解决:先落地1-2个易见效的场景(用例生成、造数),有了成果后再逐步扩展。

2. 坑2:完全依赖AI,不做人工校验

问题:AI生成的用例漏场景、数据不符合业务,导致测试遗漏缺陷。

解决:必须把人工校验作为核心环节,AI只做辅助,不做决策。

3. 坑3:不给AI业务上下文

问题:AI输出的结果脱离业务,没法用。

解决:提前整理业务规则和优质样例,给AI足够的“参考素材”。

4. 坑4:忽略团队培训

问题:体系没法推广,只能单点使用,达不到整体效率提升的目的。

解决:组织1-2次内部分享,把实操步骤、提示词模板教给团队所有人,鼓励大家多尝试。

零基础起步清单

如果你是一个技术基础较弱的测试新人,可以这样开始:

- 安全地练习:找一个公开的API文档(如GitHub API),练习给它写测试用例生成提示词,完全使用公开数据。

- 内部知识整理:开始用文档梳理你负责模块的“业务约束”和收集“优秀用例样例”,这是你的核心资产。

- 发起一次讨论:拿着这篇文章和你的整理,向组长或技术同事请教:“我们能否在安全的前提下,尝试一下第一步?”

- 聚焦一个点:哪怕第一个月只和AI一起合作产出10条高质量的回归用例,也是巨大的成功。价值比技术炫酷更重要。

最后想说

其实,从0到1搭建AI辅助测试体系,最难的不是技术,而是“从0到1的开始”和“持续落地的坚持”。很多团队卡在第一步,觉得AI测试门槛高,或者试了一次没效果就放弃,却忘了任何体系的搭建,都需要循序渐进。

作为测试工程师/测开,我们不用害怕AI,反而要学会利用AI——把重复、低效的工作交给AI,我们把精力放在更有价值的事情上,比如深入理解业务、设计复杂场景用例、优化测试架构,这才是AI时代测试人的核心竞争力。

如果你所在的团队也想搭建AI辅助测试体系,不妨从明天开始,先试一次“AI辅助写用例”,感受一下效率的提升。

最后,祝每一位测试同行,都能在AI时代,找到适合自己的工作方式,高效工作、快速成长!

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录