当AI训练一次吃掉16GW:比造核弹更疯狂的电力战争

当AI训练一次吃掉16GW:比造核弹更疯狂的电力战争

AIprince

发布于 2026-01-28 15:49:54

发布于 2026-01-28 15:49:54

📊 Key Takeaways | 核心结论速览

- 指数级电力需求:前沿AI模型训练的峰值电力需求正以每年2.2-2.9倍的速度增长,2025年已达150MW(xAI Grok-3),2028年将突破1-2GW,2030年可能达到4-16GW——相当于1-4座核电站的单机容量。

- 计算量增长是主因:训练计算量(FLOP)自2018年以来保持每年4.2倍的增速,远超硬件效率提升的26-40%/年和训练时长延长的26%/年,构成电力需求的根本驱动力。

- 美国AI电力容量十年十倍:当前美国AI数据中心电力容量约5GW,占全美发电量0.4%;到2030年将激增至50-70GW,占比超5%,成为电力系统最大的单一负荷增长源。

- 训练vs推理的电力博弈:目前领先AI公司的计算资源分配为训练占60%、推理占40%,但随着推理模型(Reasoning Models)崛起,这一比例可能逆转,将改变电力需求的地理分布和灵活性特征。

- 地理分布训练成破局关键:当单机训练集群超过5GW时,跨地域分布式训练(15-50英里)将成为规避电网约束的唯一解,但需攻克延迟、带宽、同步三大技术壁垒。

- 电网规划面临范式革命:传统"发电-输电-配电"体系从未应对过单点4GW、年增长60-70%的负荷,需要从"被动响应"转向"主动协同",并重新设计实时灵活性机制。

01

电力需求的"新摩尔定律":从10MW到16GW的致命跃迁

1.1 历史趋势的暴力延伸

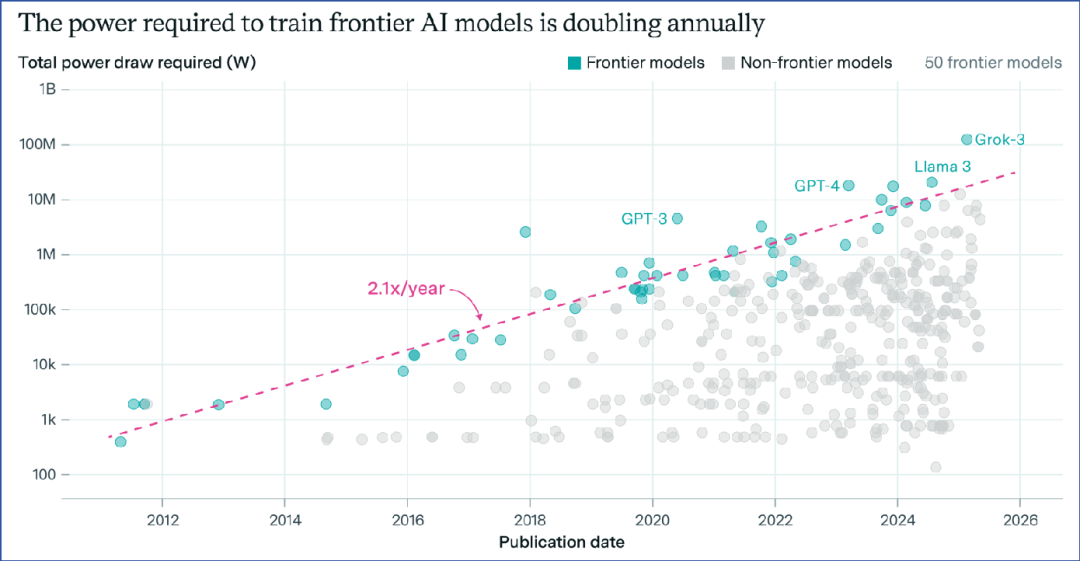

AI电力需求的增长曲线,是人类能源史上前所未有的现象。Epoch AI对过去15年50个前沿模型的复盘显示,训练峰值电力需求以每年2.1倍(90%置信区间:2.0-2.3倍)的速度指数膨胀。这一增速是普通数据中心电力增长的3倍,甚至超过了1950-2000年代芯片算力提升的Koomey定律(55%/年)。

前沿AI模型训练电力需求的历史增长曲线 Source: Epoch AI

2025年的数据极具警示意义:xAI的Grok-3在孟菲斯"Colossus"数据中心训练时,峰值功率达到150MW,是2023年GPT-4(22MW)的7倍,占当地田纳西河谷管理局(TVA)峰值负荷的5%。更惊人的是,Colossus已扩建至20万颗H100 GPU,2025年底将增至300MW,相当于一个小型城市的总用电量。

Key Highlight: 这不是渐进式增长,而是 "每隔10个月翻一番" 的暴力Scaling Law。按此速度,2030年单模型训练需求将达8GW,超过现有最大核电站(6.5GW)。

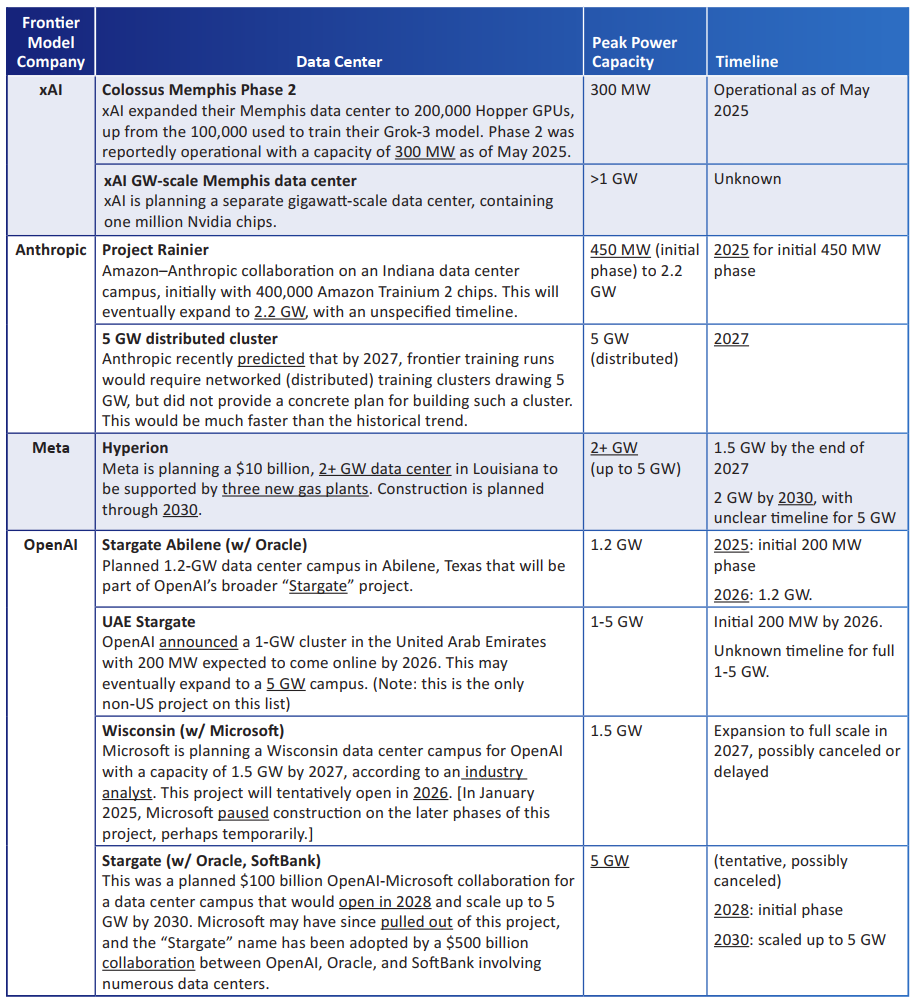

1.2 4GW训练集群:从科幻到施工图

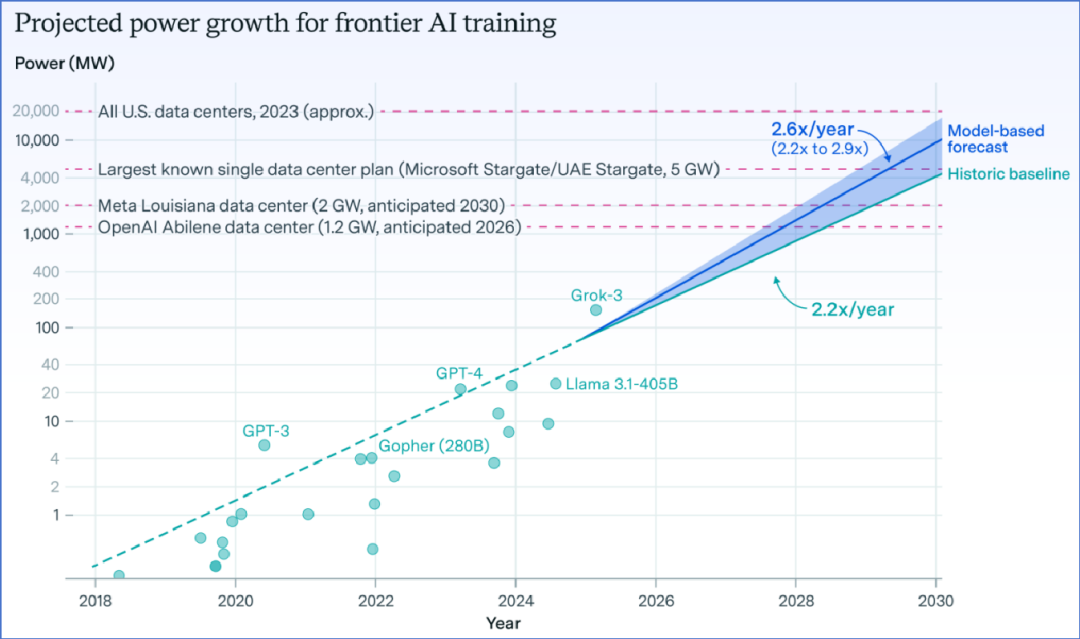

下图的可视化预测揭示了残酷未来:

前沿模型电力需求预测与实际规划对照 Source: Epoch AI

- 2026年:OpenAI与Oracle合作的Stargate项目将落地德州Abilene,首期1.2GW(含40万颗Blackwell GPU)

- 2027年:Anthropic预测分布式训练集群需5GW

- 2030年:Meta在路易斯安那州的Hyperion园区规划2-5GW,配套3座天然气发电厂

这并非纸上谈兵。EPRI的调研显示,超大规模企业已公开的AI数据中心规划中,70%的项目容量超过1GW,30%超过3GW。电力系统工程师们第一次需要为"单机负荷"设计供电方案。

02

三大驱动力解构:计算、效率与时间的三角博弈

电力需求增速(2.2x/年)为何低于计算量增速(4.2x/年)?Epoch AI的分解模型揭示了三大缓冲器:

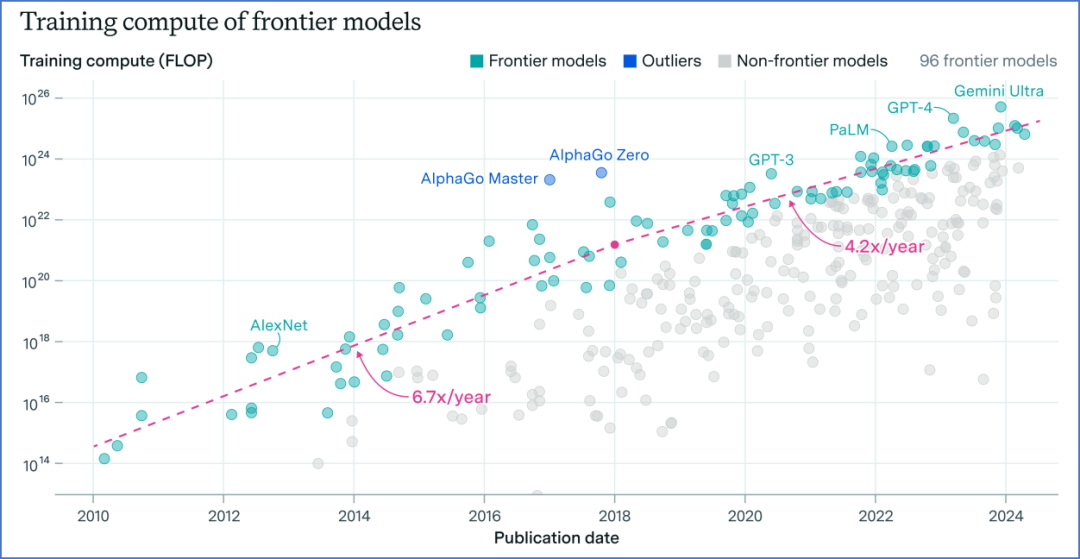

2.1 训练计算量:4.2x/年的不可阻挡之力

报告显示,自2018年起,前沿模型的训练计算量遵循 "Chinchilla Scaling Law" ,每年增长4.2倍(90%置信区间:3.6-4.9倍)。2025年Grok-3的4×10²⁶ FLOP是GPT-4的20倍,而GPT-4.5又比Grok-3高出一个数量级。

训练计算量的历史增长趋势

关键驱动因素:

- 模型参数:从GPT-3的1750亿到Llama-3.1的4050亿,再到万亿参数模型

- 数据规模:训练Token数从千亿级迈向十万亿级

- 模态扩展:文本→图像→视频→多模态,视频数据使计算需求提升10-100倍

Key Highlight: DeepSeek-V3的出现曾被解读为"效率革命",但Epoch分析指出,其10倍计算效率提升仅将年度计算增速从4.2x降至3.8x,无法扭转Scaling Law。效率提升反而会刺激更大规模训练,形成"杰文斯悖论"。

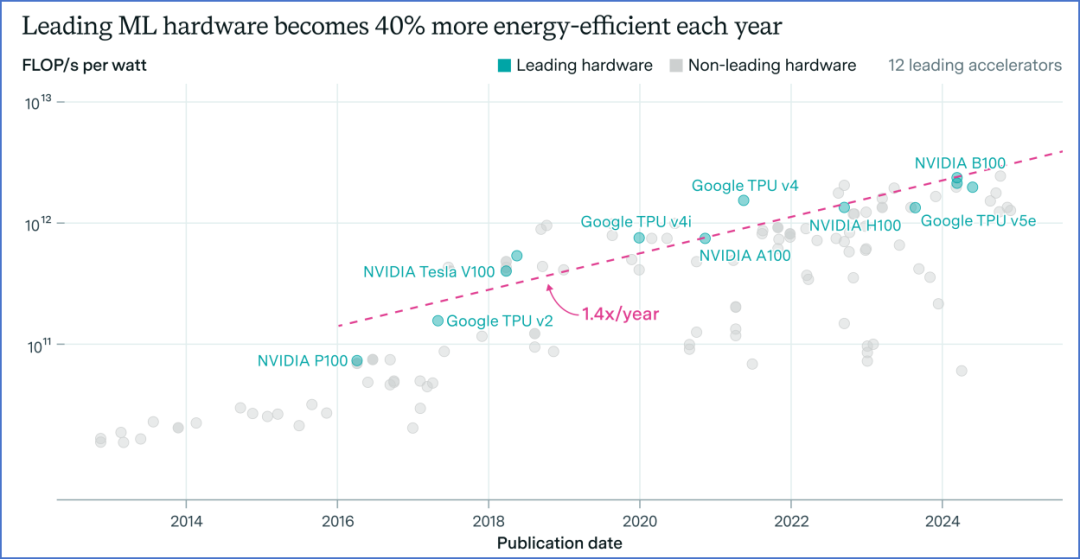

2.2 硬件能效:26-40%/年的救命稻草

AI芯片能效提升是唯一减速器。12款主流AI加速芯片(H100、B200、TPU v5e/v6)自2016年以来能效年增40%。Nvidia B200比H100能效高62%(年化27%),Google TPU v6比v5e高67%。

AI芯片能效的历史改进趋势

但报告同时警示:服务器级开销(冷却、网络)将芯片功耗翻倍,数据中心PUE(1.1-1.3)再增加10-30%。因此净能效提升仅20-25%/年,无法抵消4.2x的计算量增长。

Key Highlight: 从16位到8位精度训练可理论双倍能效,但会导致模型性能下降,实际收益可能不足50%。硬件能效改进的天花板将在10-15年内触及。

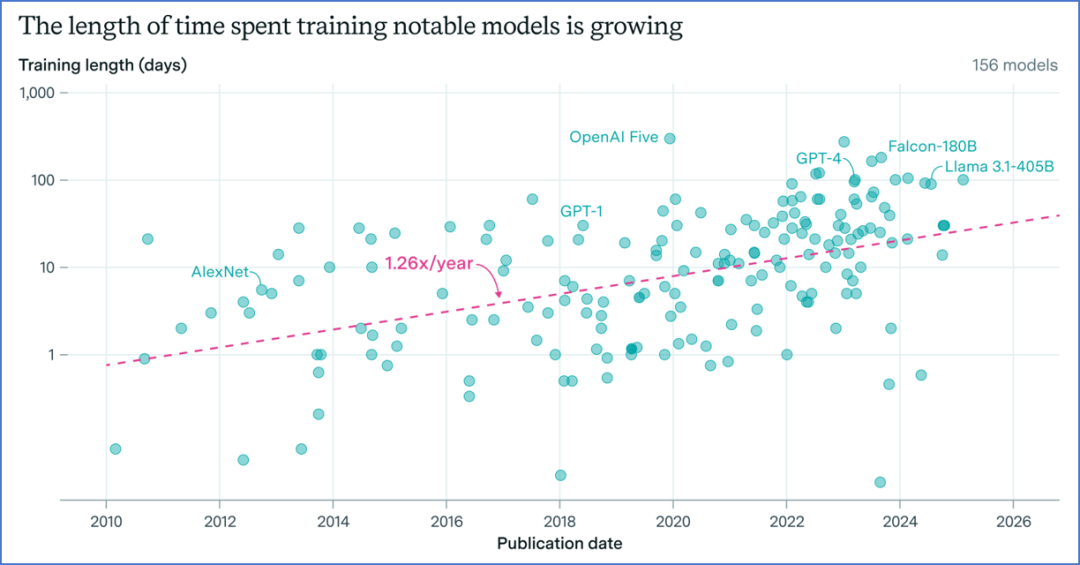

2.3 训练时长:26%/年的柔性缓冲

延长训练时间可摊薄峰值功率。历史数据显示,训练时长从2010年的1天增至2025年的120天(Grok-3),年增长26%。但指出理论极限为14-15个月——超过此限,硬件迭代会使模型在训练完成前就过时。

训练时长的历史增长趋势

竞争压力迫使企业缩短周期:Meta、Google每2-3个月发布新模型,训练时长增速已放缓至10-20%/年。这意味着功率缓冲效应减弱,电力需求将更接近计算量增速。

03

美国AI电力版图:5GW到50GW的十年大跃进

3.1 当前格局:仅占全美电力0.4%的"小角色"

2025年,美国AI数据中心电力容量约5GW(全球10GW),占全美发电量1300GW的0.4%。但地域极度集中:

- 75% 算力位于美国(Pilz et al.数据)

- 60% 集中于弗吉尼亚北部、俄勒冈、德克萨斯州、俄亥俄州四大枢纽

- 单点负荷密度:xAI孟菲斯集群占TVA区域负荷5%

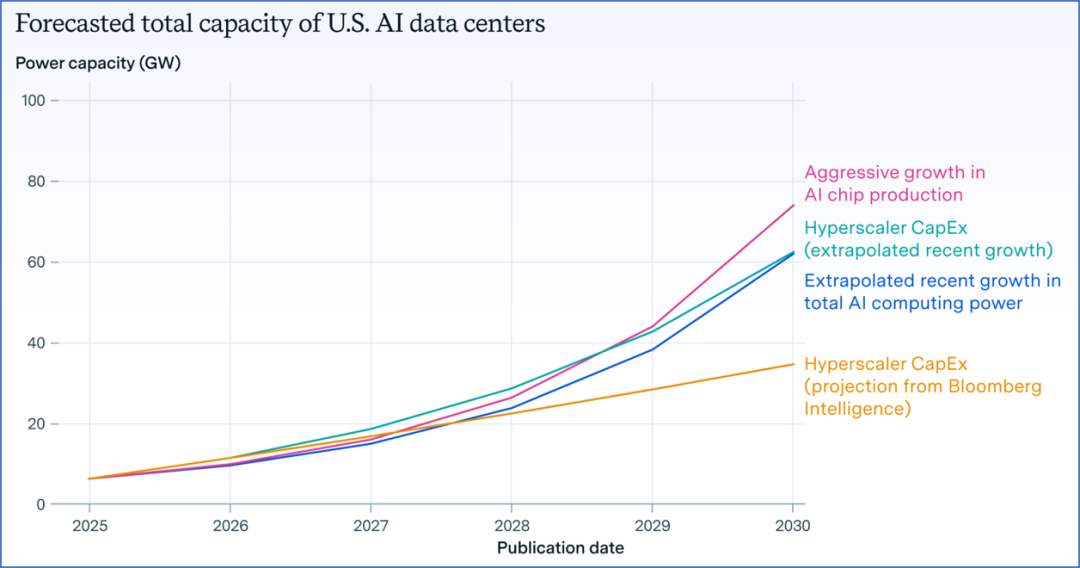

3.2 2030预测:四方法交叉验证的50GW共识

下图展示了四种独立预测路径,收敛于2030年50-70GW:

美国AI数据中心电力容量预测多路径对比 Source: Epoch AI

路径1:芯片出货量倒推

- 2024年全球AI芯片存量等效400万颗H100,功耗6GW

- 历史增速2.3x/年,折效率提升后电力需求增速1.64x/年

- 2030年:120GW全球 → 60GW美国

路径2:超大规模资本支出

- 2025年五大超大规模企业AI Capex达3710亿美元(+44% YoY)

- 每10亿美元投资对应27MW容量

- 2030年:100GW全球 → 50GW美国

路径3:行业激进扩产

- Sevilla et al. (2024) 预测AI芯片产能可年增70%

- 2030年:140GW全球 → 70GW美国

路径4:彭博保守预测

- 假设2025-2032年Capex年增仅5%

- 2030年:60GW全球 → 30GW美国(下限情景)

Key Highlight: 即使按最保守的30GW计算,AI电力需求十年增长6倍,远超电动车(预计2030年占电力需求4%)和电解制氢(预计2%),成为美国电力系统第一大增量负荷。

3.3 与总数据中心需求的对比

根据2025 EPRI报告预测,美国全部数据中心(含非AI)2030年将达45-90GW。这意味着AI占数据中心新增需求的80%以上,传统云、企业IT增长已微不足道。电力规划者面对的不再是"数据中心",而是 "AI工厂" 。

04

训练 vs 推理:电力需求的战略转移

4.1 当前分配:60%训练,40%推理

OpenAI披露,2024年30亿美元训练、20亿美元推理、10亿美元研究,训练占60%。Google 2022年数据为训练40%、推理60%,Meta为训练20%、推理70%。差异源于产品形态:

- OpenAI:持续研发旗舰模型,训练占比高

- Meta:社交推荐、广告推理为主,推理占比高

4.2 推理模型的颠覆性潜力

Reasoning Models(如OpenAI o1/o3、DeepSeek-R1)的崛起可能重塑电力需求结构:

- 单次推理计算量:提升10-100倍(思维链CoT)

- 总推理能耗:可能超过训练能耗3-5倍

- 地理分布:推理可全球分散,训练需集中,改变负荷地理特性

但Epoch警告:推理模型仍需训练,且训练规模更大。OpenAI研究员Noam Brown指出,推理模型训练需要 "数百万颗AI芯片" 。因此,训练电力占比短期不会低于50%。

4.3 灵活性价值:电网的"智能缓冲器"

美国能源部研究指出,LLM推理具有实时灵活性:

- 可在100-500ms内响应电网负荷调度

- 可迁移至可再生能源富余区域(如德克萨斯州风电高峰)

- 对延迟不敏感任务(批量处理)可削峰填谷

这意味着推理负载占比提升可降低AI对电网的尖峰冲击,但前提是广域算力调度网络的建成。

05

地理分布训练:5GW以上集群的唯一解

5.1 单机中心的物理极限

当训练集群超过5GW,单一选址面临三重死亡线:

- 电网接入:美国最大单体变电站仅支持2-3GW

- 发电容量:新建燃气电厂需3-4年,核电厂需8-10年

- 土地与许可:1GW数据中心需500-800英亩工业用地,环评周期2-3年

披露的规划显示,OpenAI、Meta、xAI的5GW级项目均标注 "tentative"(暂定) 或 "distributed"(分布式) ,承认单机方案不可行。

5.2 分布式训练的工程可行性

Google Gemini已验证跨城域数据中心训练,距离15-50英里,延迟<1ms。技术突破包括:

- 权重同步频率:从每小时降至每10分钟,减少通信量80%

- 光互联:400G/800G光纤通信使跨区带宽达10Tbps

- 容错训练:单节点故障不中断全局,支持1000+节点扩展

但跨洲训练(如美国-欧洲)延迟>50ms,将导致训练效率下降30-50%,仅适用于万亿参数模型的最后微调阶段。

5.3 对电力规划的范式冲击

分布式训练意味着"去中心化但仍集中":

- 地理:分散在3-5个相邻县,用电曲线同步

- 电网:需500kV以上环网支撑,挑战传输容量

- 规划:从"点负荷"转向"区域负荷密度",弗吉尼亚等区域需为每平方英里新增50-100MW密度做预案

Key Highlight: EPRI警告,即使分布式训练,2030年AI总需求仍可能超100GW,只是从"4GW单点"变为"5个2GW区域"。电网的聚合冲击未减反增。

06

电网冲击:当AI成为电力系统的"新巨头"

6.1 对发电侧:燃气电厂的"文艺复兴"

报告的预测暗含一个残酷现实:2025-2030年需新增45-90GW发电容量,其中60%为天然气(27-54GW)。原因无他:

- 光伏+储能:无法满足24/7训练负载,且IRA补贴2026年后退坡

- 核电:AP1000机组建设周期8-10年,2030年前仅3-5台可投运

- 燃气联合循环:建设周期3-4年,容量因子60%,完美匹配AI负载

矛盾点:Meta为2GW Louisiana数据中心配套3座燃气电厂,直接新增1200万吨CO₂/年,与其 "2030碳负" 承诺背道而驰。AI的"绿色形象"与"灰色能源"正激烈撕扯。

6.2 对输配电:500kV环网的"生死时速"

EPRI估算,每1GW AI负荷需配套:

- 500kV变电站:2-3座(每座5亿美元)

- 230kV环网:50-80英里

- 配电扩容:2-3倍常规工业标准

美国电网投资已落后20年,AI需求增长将暴露"基础设施赤字"。PJM(美国最大电网运营商)预测,仅弗吉尼亚北部需11亿美元升级输电,工期4-6年,而数据中心建设仅18-24个月。

6.3 对电力市场:尖峰电价与"AI溢价"

需求响应机制:

- 训练负载可中断4-6小时,需小时级补偿(50-100美元/MWh)

- 推理负载可迁移,但需亚秒级调度(需新市场机制)

价格传导:高盛同期报告指出,超大规模企业愿为"绿色可靠电力"支付40美元/MWh溢价。这将推高PJM、ERCOT电价中枢,传统工业用户可能被迫让出负荷空间。

07

未来时钟:2030年后的增长边界

7.1 硬约束:当Scaling Law撞上物理定律

Epoch的模型明确警示:即使维持2.6x/年增长,2030年达16GW,但 "这显然不可持续" 。

资源天花板:

- 芯片:台积电CoWoS产能2025年仅50万片,B200供应受限

- 电力:美国2030年总新增发电容量预计80-100GW,AI需占50-70%,挤占交通、化工需求

- 资本:单次训练集群成本已达100亿美元,16GW集群需5000亿美元

7.2 软约束:经济性与社会接受度

边际收益递减:当训练成本超过 1000亿美元,模型能力提升需线性计算量而非指数,ROI崩塌。OpenAI内部评估显示,GPT-5需10倍于GPT-4的计算量,但商业化收入仅能覆盖3-4倍成本。

社会反弹:若AI电力消耗占全美5%,相当于5000万家庭用电量,可能遭遇环保诉讼、社区抗议、政策限制。2025年微软在爱尔兰都柏林的数据中心已因"吃光当地电力"被政府叫停。

7.3 破局路径:三大技术变量

- 算法突破:稀疏模型、MoE架构可降低计算量30-50%,但2025年主流仍是密集模型

- 光计算:光子芯片能效提升100倍,但产业化需5-8年

- 量子计算:2030年后可能颠覆训练范式,但当前NISQ时代无法解决AI问题

Key Highlight: Epoch结论 "4x/年的计算增长在本十年末必须放缓,这几乎是确定的。关键不确定性是何时,而非是否。" 电力系统规划者需为 "增长断崖" 做准备,避免过度投资 stranded assets。

结语:AI与能源的"双螺旋"革命

这份白皮书揭示了一个颠覆性真相:AI的Scaling Law正在重塑能源的Scaling Law。过去,电力需求是经济发展的"结果";未来,电力可获得性将成为AI发展的"前提"。

对投资者的启示:

- 短期(2025-2027):电力基础设施股(电网、燃气、核电)进入 "AI溢价" 黄金期

- 中期(2028-2030):分布式训练技术(光互联、边缘计算)成为 "卖铲人" 新贵

- 长期(2030+):若增长断崖出现, "AI电力需求峰值" 将成为最大做空主题

对政策制定者的警告:

- 需将AI数据中心纳入 "国家关键基础设施" ,享受快速通道审批

- 必须启动 "AI电力需求专项规划" ,避免电网与算力建设周期错配

- 应考虑 "AI电力税" ,将部分溢价收入用于补贴可再生能源建设

-End -

免责声明:本文内容基于Epoch AI公开研究报告整理,仅供信息参考,不构成投资建议。AI电力需求的实际发展受技术突破、政策变化、电网约束等多重因素影响,请独立判断并咨询专业顾问。

本文图表引用自EPRI&Epoch AI 2025白皮书《Scaling Intelligence: The Exponential Growth of AI's Power Needs》

完整报告内容请去知识星球下载阅读,深入了解AI能耗的详细数据、预测方法和应对策略,以及20个超大规模AI算力中心的详细规划与时间表。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-11-29,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读