安装 DeepSeek

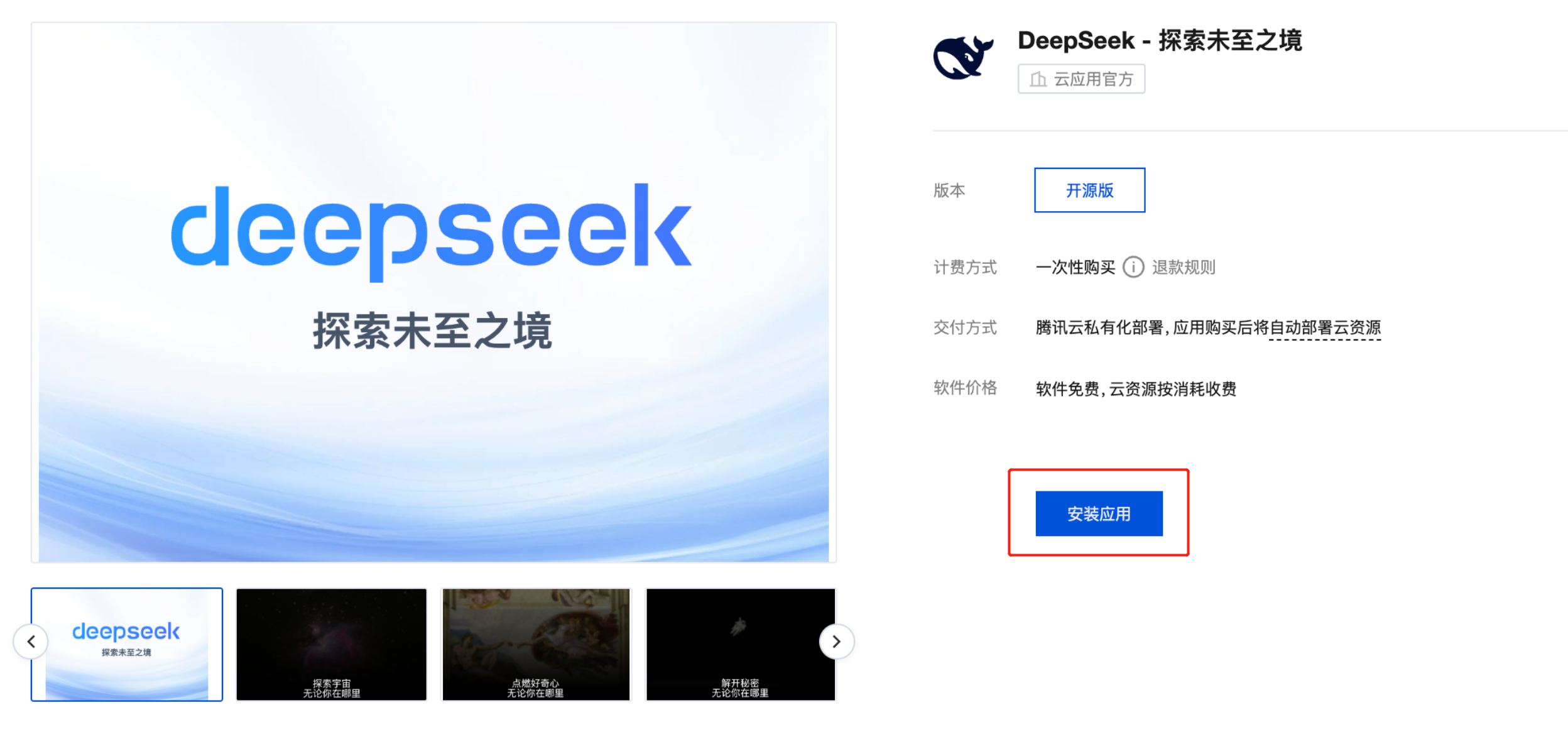

1. 前往 https://app.cloud.tencent.com/detail/SPU_BHDIEHIJCA8003 进入 DeepSeek 的商品页面。

2. 单击安装应用,进入安装页面(如未登录,会跳转至腾讯云登录页面)。

3. 填写应用名称,选择算力类型。

两种算力类型提供的 DeepSeek 服务有所差异,对比如下:

对比项 | 高性能应用服务(HAI) | 云服务器(CVM) |

库存 | 提供机型调度能力,指定算力匹配机型,在库存紧张的情况下调度成功概率更高。 | 用户自主选择机型,库存紧张时,需要在不同的可用区和机型之间重试。 |

模型 | 内置模型版本: deepseek-r1:1.5b deepseek-r1:7b deepseek-r1:8b deepseek-r1:14b deepseek-r1:32b | 内置模型版本: deepseek-r1:7b deepseek-r1:32b deepseek-r1:70b |

组件 | 内置组件: Open WebUI(6699 端口) Chatbot UI(6889 端口) Jupyter Lab(6888 端口) | 内置组件: Open WebUI (8080 端口) Ollama API (11434 端口,内网访问) |

网络 | 公网访问:支持(含 学术加速)。 内网访问:走云联网打通。 | 公网访问:支持 内网访问:支持,VPC 内互访。 |

登录 | 登录到容器进程,支持的登录方式: Cloud Studio(类似 VSCode 体验) OrcaTerm (密码登录) SSH(密码登录) | 登录到云服务器,支持的登录方式: OrcaTerm (免密登录) SSH (密码或密钥登录) |

4. 针对不同的算力类型配置网络和算力规格。

选择部署地域和算力方案,单击下一步:确定资源。

选择可用区和云服务器类型,单击下一步:确定资源。

在单并发访问模型的情况下,为确保对话输入输出的流畅性,建议最低配置如下:

模型 | CPU 与内存 | GPU |

deepseek-r1:7b | 不低于 8 核 16G | 显存不低于 8G |

deepseek-r1:70b | 不低于 32 核 64G | 显存不低于 80G |

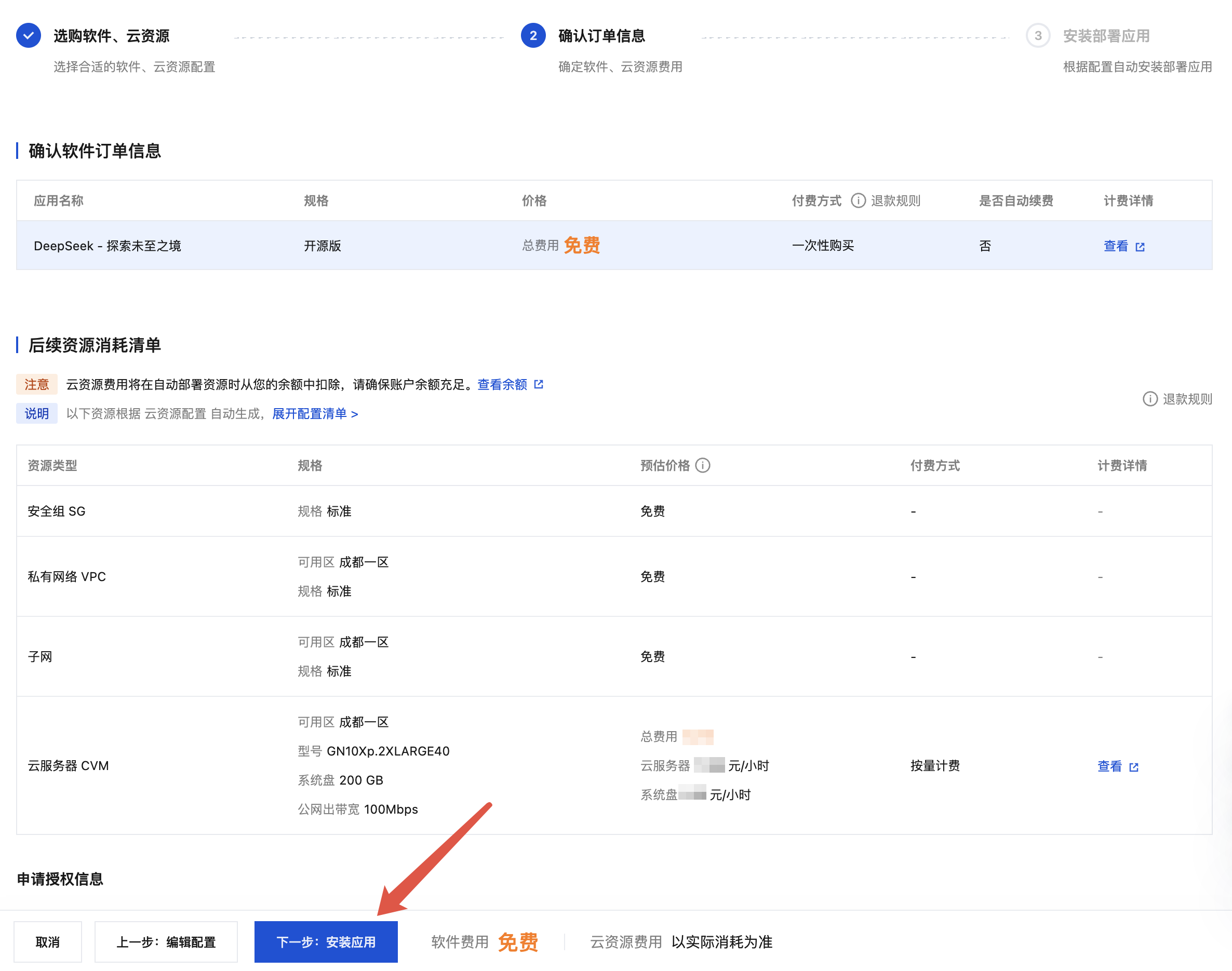

5. 在资源确认页面中,确认后续资源消耗清单,单击下一步:安装应用。

6. 耐心等待应用部署完成。

注意:

如果遇到 CVM 创建失败,提示 understock,则表示所选可用区暂无该款机型的库存,您可以更换可用区或者机型重新安装。

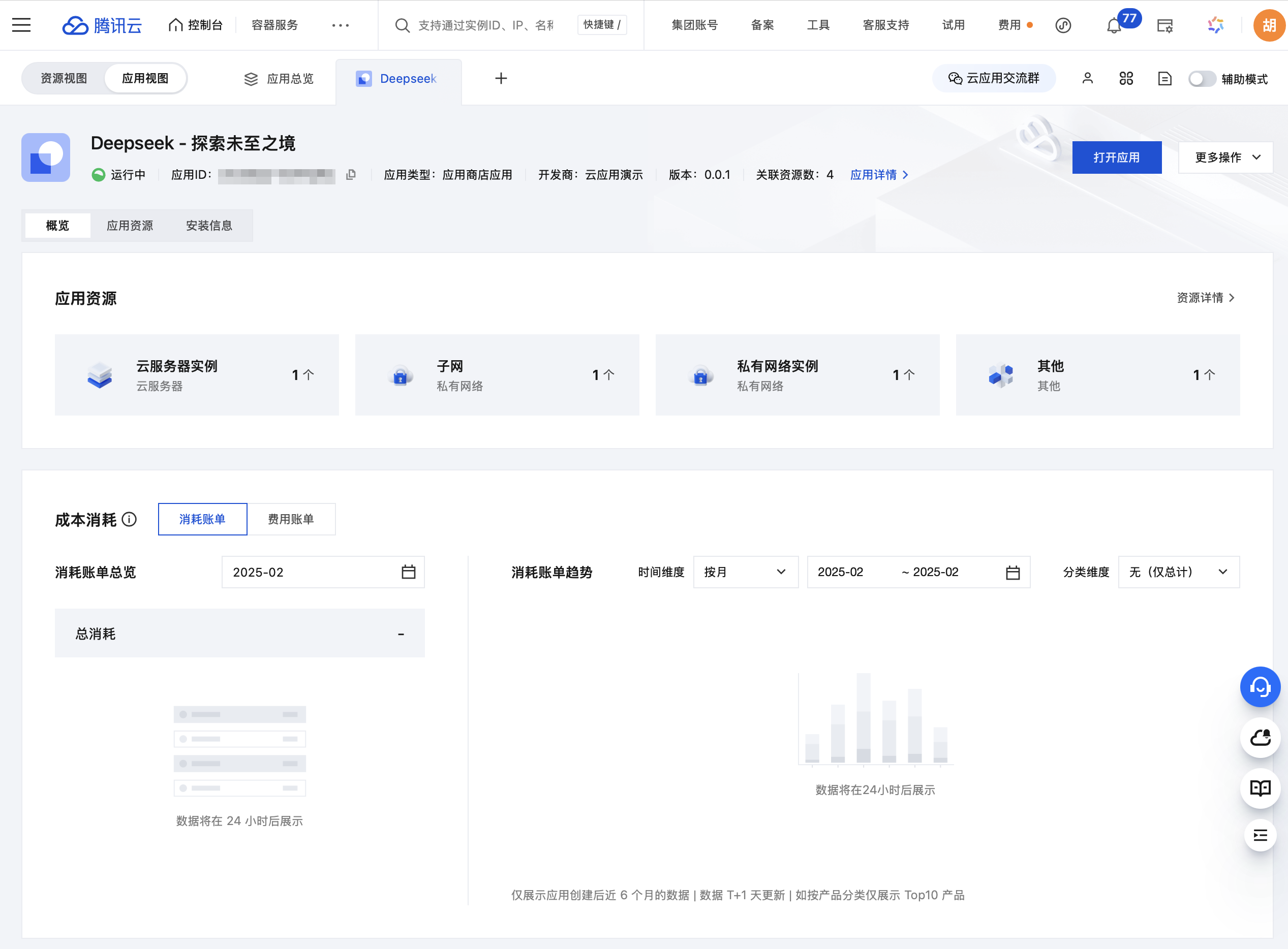

7. 安装完成后,将自动跳至应用视图。

使用 DeepSeek

安装完成后,等待2 - 3分钟,DeepSeek 即可使用。

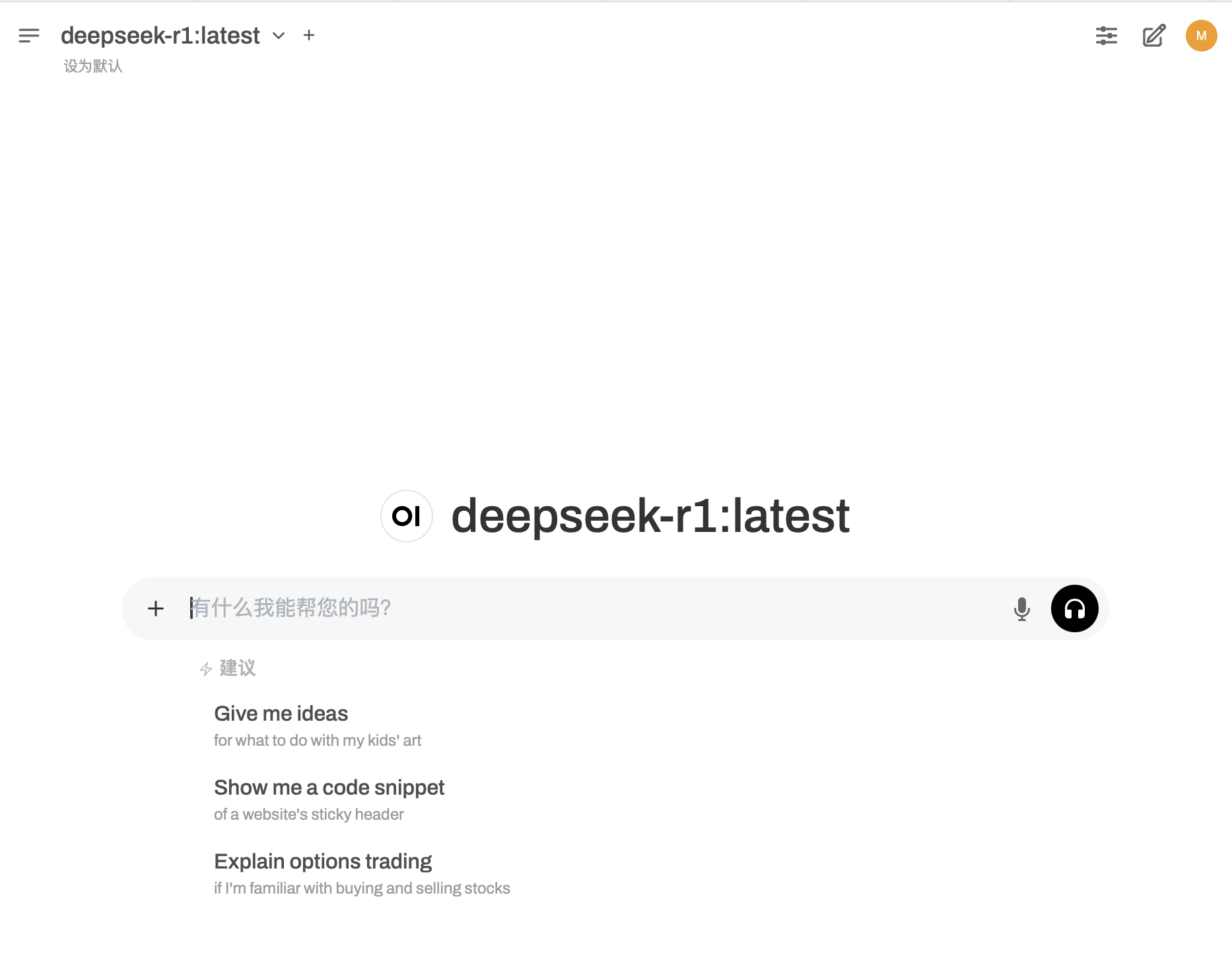

使用 Web 界面跟模型进行对话

1. 在应用视图中,单击右上角的打开应用,即可打开 Web 界面。

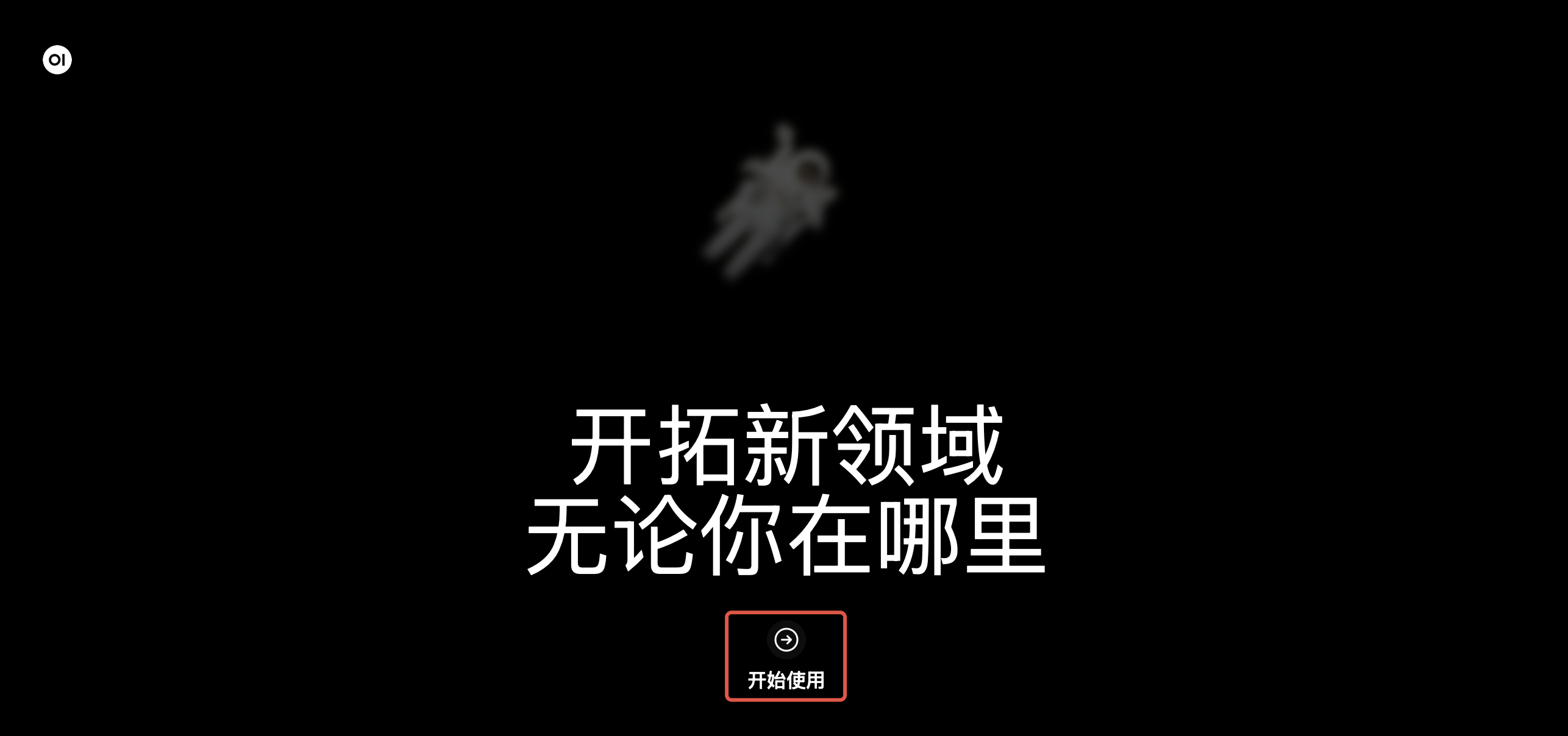

2. 打开应用后,进入 Web 界面的欢迎页,单击开始使用。

3. 创建管理员账号(请妥善保管账号和密码)。

4. 创建完成后,进入使用界面。

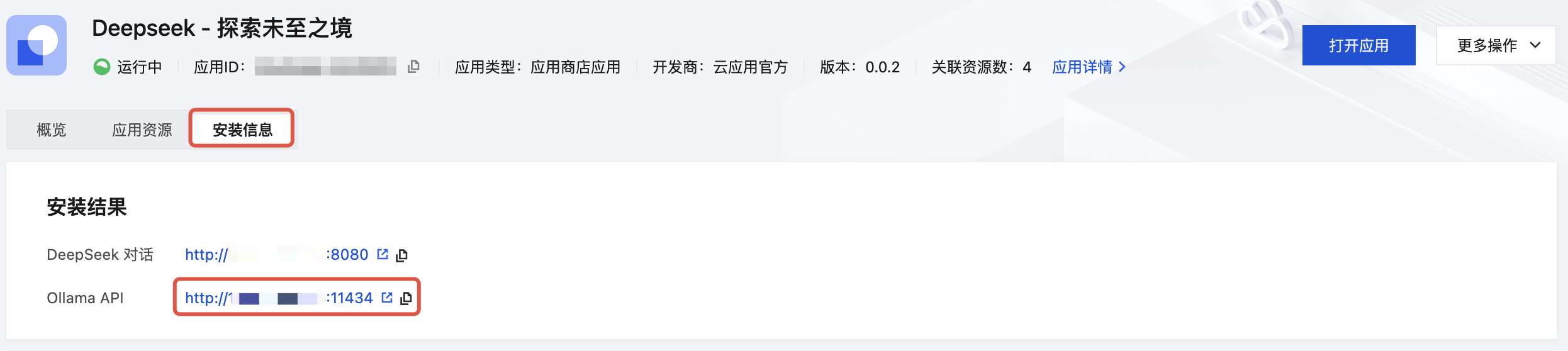

使用 Ollama API 访问模型(仅限 CVM 算力类型)

1. 通过云应用部署的版本提供了 Ollama API 的访问端口,可在应用视图选择安装信息查看 API 地址。

2. Ollama API 需要在内网访问,可以通过 CURL 调用来验证。

# 将 CVM_INNNER_IP 替换成实际的内网 IPcurl http://CVM_INNNER_IP:11434/api/tags

计费说明

通过云应用部署的 DeepSeek 服务,模型和软件来自开源社区,云应用不收费。云资源部分,按照实际消耗计费。

高性能应用服务计费说明

高性能应用服务按小时结算,具体单价跟选择的算力方案有关,具体价格可参见 购买页。

如需长期使用,HAI 算力建议转为包年包月,价格更低。

不使用期间,建议将 HAI 算力关机,关机后计算资源不计费,只收取少量磁盘费用。

云服务器计费说明

云服务器费用按小时结算,具体单价跟安装时选择的型号有关,具体价格可参考价格计算器。

如需长期使用,云服务器建议转为包年包月,按月计算价格更低。

不使用期间,建议将云服务器关机,关机后计算资源不计费,只收取少量磁盘费用。

公网带宽按照实际流量收费。

注意:

关机不收费后重新启动,IP 会重新分配,所以云应用安装时记录的 IP 无法访问,需要将访问地址中的 IP,更换为服务器启动后的最新公网 IP。

常见问题

HAI 创建失败,等待了很久后也创建不出来,该如何处理?

这个问题是 HAI 暂时无法调度到算力导致的,建议卸载后重试。

CVM 创建失败,出现 understock 报错,该如何处理?

该报错表示所选可用区暂无该款机型的库存。GPU 服务器目前库存紧张,可以更换库存比较充裕的地域和机型重新安装。

安装成功了,但是模型输出很慢,原因是什么?

云应用的 DeepSeek 部署包含了 7B 和 70B 两个参数量的模型,使用时可以切换选择。

对于 7B 的模型,使用无 GPU 机型输出速度较慢,建议采用 GPU 机型,输出速度会有明显提升。

对于 32B、70B 的模型,无 GPU 机型无法运作,需要配置较高的 GPU 机型运行。

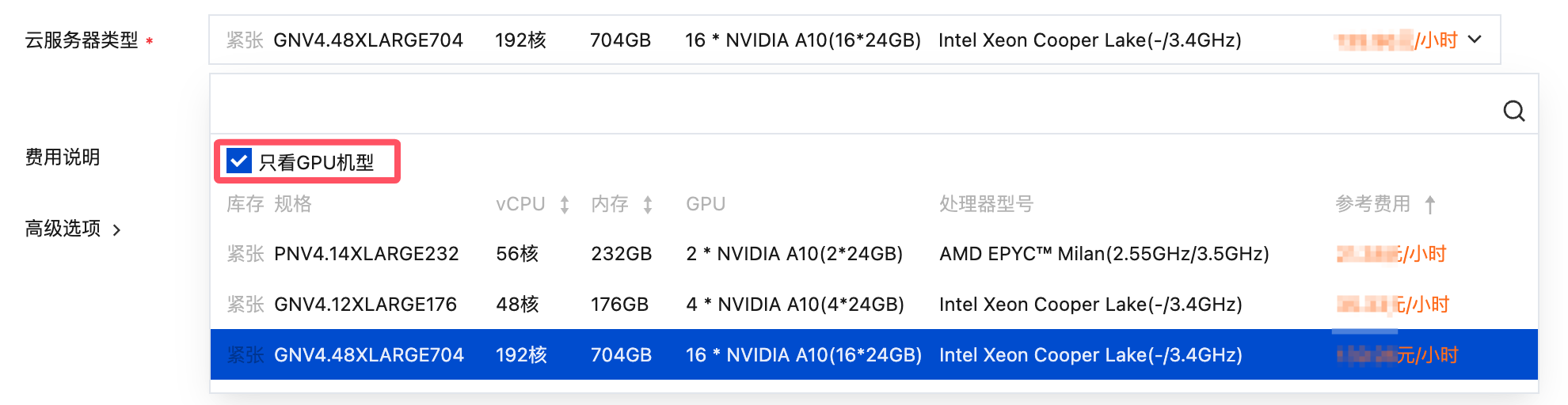

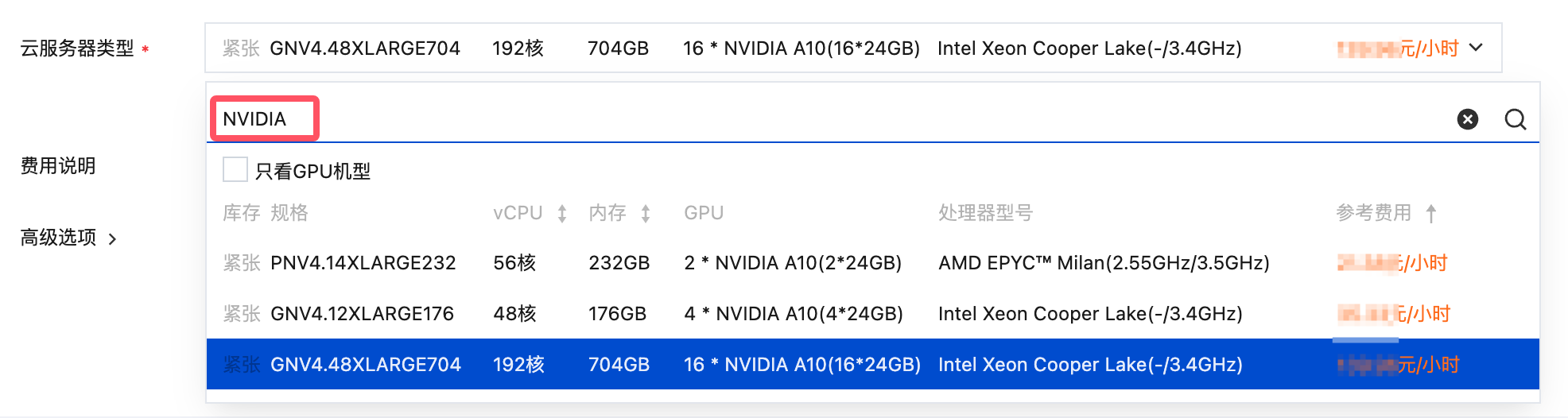

安装时如何选择 GPU 机型安装?

机型选择的时候,可以勾选上方的“只看GPU机型”,或者搜索 "NVIDIA" 即可快速查看 GPU 机型:

必须使用 GPU 服务器安装吗?

GPU 服务器是非必须的,但是可以加快 Token 的输出速度。

可以更改 WebUI 端口到 80 吗?

对于 CVM 部署的,可以用端口转发的方式解决。登录 CVM 添加转发规则:

sudo iptables -t nat -A PREROUTING -p tcp --dport 80 -j REDIRECT --to-port 8080

添加规则后,80 端口的数据包会转发给 8080 处理,实现从 80 端口访问。

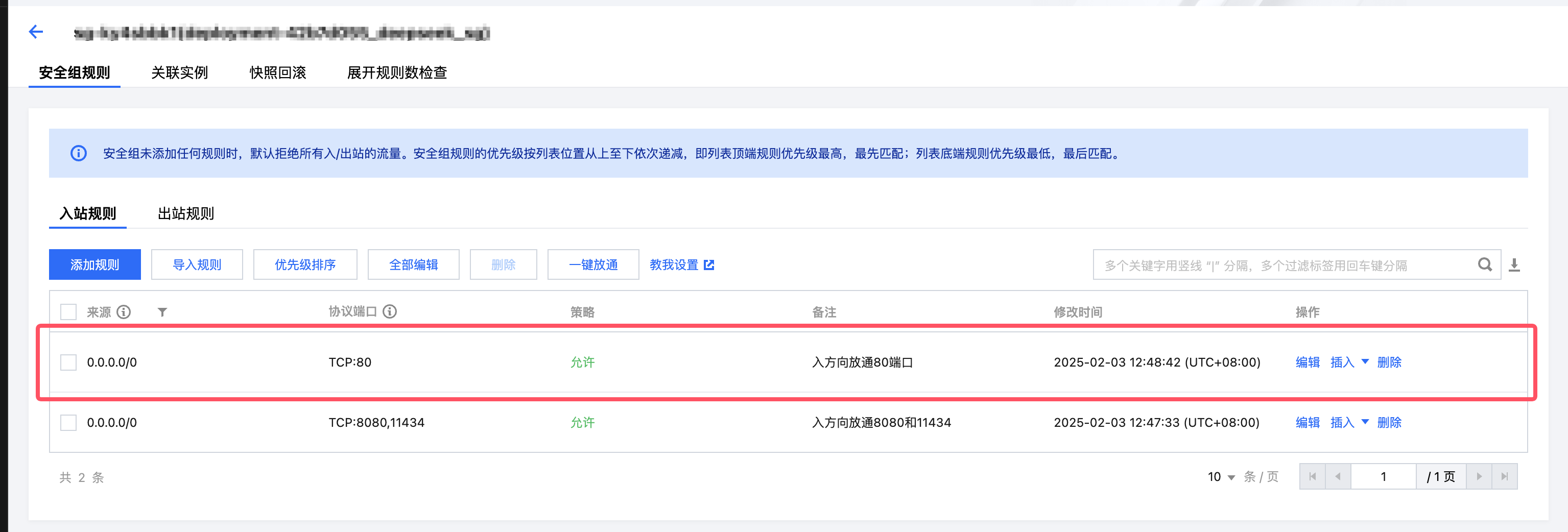

需要注意的是,CVM 关联的安全组,也需要添加 80 端口的允许规则。

可以启用 API 鉴权吗?

如果是简单的 API 鉴权能力,可以直接使用 Open-WebUI 提供的功能实现。具体操作如下:

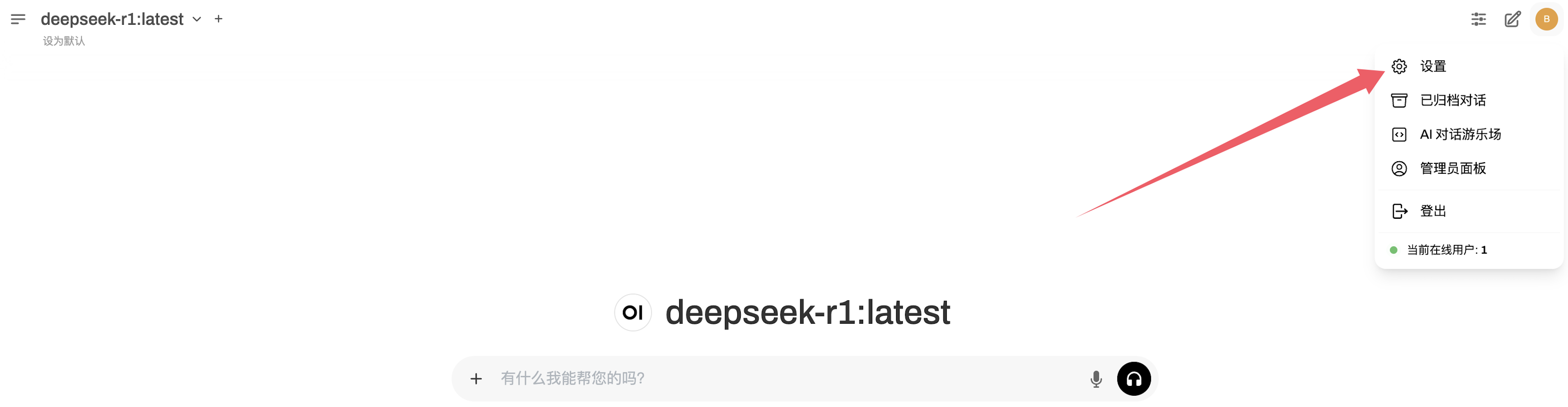

1. 登录到 Open-WebUI 界面。

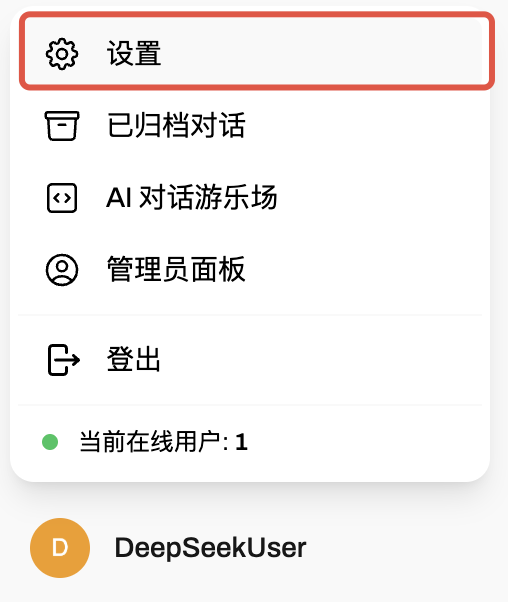

2. 单击左下角用户头像,然后单击设置。

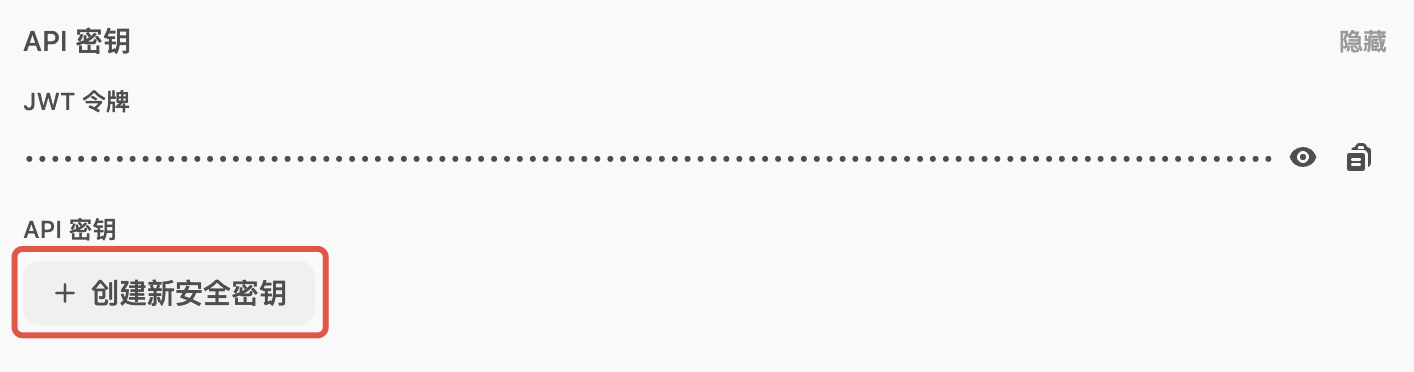

3. 在设置界面,单击账号,显示 API 密钥。

4. 单击创建新安全密钥。

5. 复制 API 密钥,调用 Open WebUI 提供的 API 时,使用该密钥,如:

#注意需要替换YOUR_SERVER_IP和YOUR_API_KEY为实际的服务器 IP 和 API Key。curl -X POST http://YOUR_SERVER_IP:8080/api/chat/completions \\-H "Authorization: Bearer YOUR_API_KEY" \\-H "Content-Type: application/json" \\-d '{"model": "deepseek-r1:latest","messages": [{"role": "user", "content": "给一个直角三角形的三边长度"}]}'

6. 开启 API 鉴权后,建议关闭 Ollama 公开的 API 地址,前往安全组禁用 11434 端口的访问即可。

说明:

上面提供了开启简单 API 鉴权的方法,如果需要更复杂的鉴权方案,建议在 Ollama API 的上层做一层反向代理来实现。可参考社区的讨论:https://github.com/ollama/ollama/issues/849。

关机后重新启动,为什么访问不了?

说明:

2025年2月5日之后安装的版本,已经改成用 EIP 提供公网访问,不再存在重启后 IP 变更的问题。

如果希望关机重启后可以保留 IP,可以将公网 IP 转为 EIP 后再关闭实例。实例绑定的 EIP,关机后 EIP 保留,重新启动后保留 EIP,关机后不计 EIP 空置费用。详细可参考文档 按量计费实例关机不收费说明。

为什么使用按量付费模式后,账户余额已欠费的情况下,没有停止服务,还是会继续扣费?

造成该情况的原因主要为以下两种情况:

1. 云服务器按量计费模式下,欠费2小时后才会停服,停服前的 2 小时内仍会产生消耗,进而产生费用结算;

2. 按量计费的产品为先服务后扣费,扣费时间晚于实际消耗时间,进而造成停服后仍有几笔扣费的情况;

如何禁用 Ollama API 的 11434 端口?

由于 Ollama API 默认不具备鉴权能力,如需禁用公网访问,建议在应用安全组禁用 11434 端口。操作参考如下:

安装部署成功后,为什么只有管理员能使用模型,新建的用户账号无法使用模型?

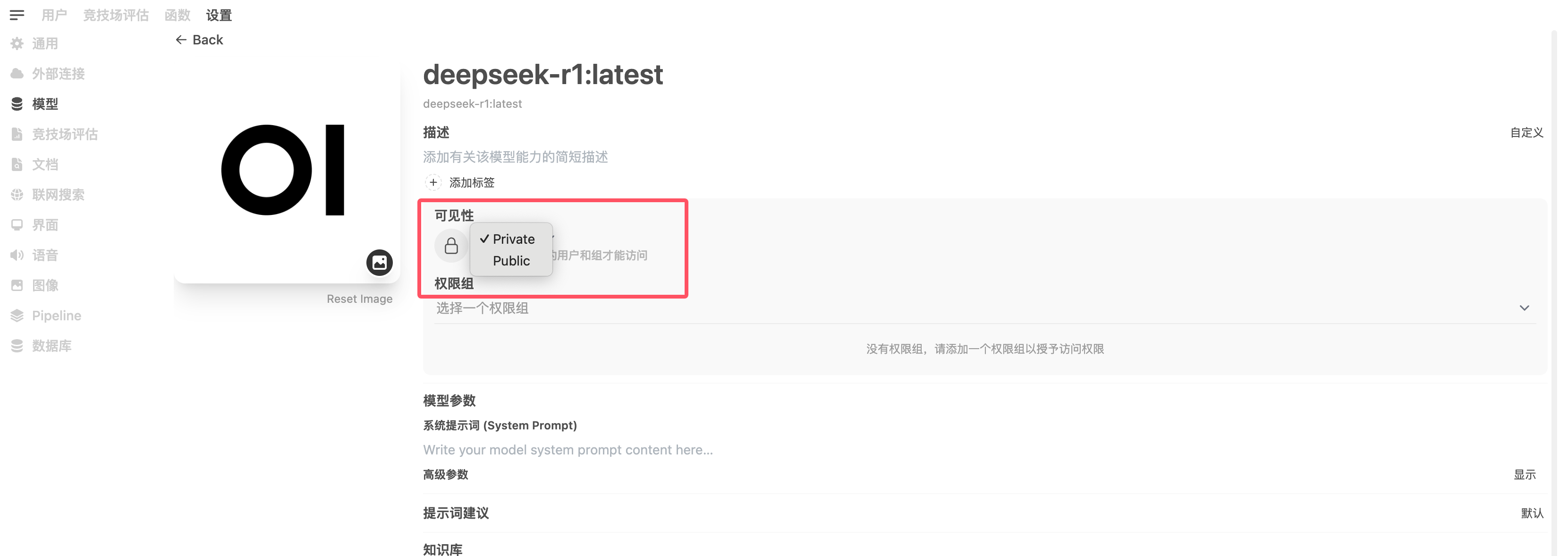

模型默认仅开放给管理员使用,新建的用户账户需要由管理员将模型设置为开放状态才可使用。具体操作如下:

1. 登录 Open-WebUI 界面。

2. 单击右上角用户头像,然后单击设置。

3. 单击管理员设置。

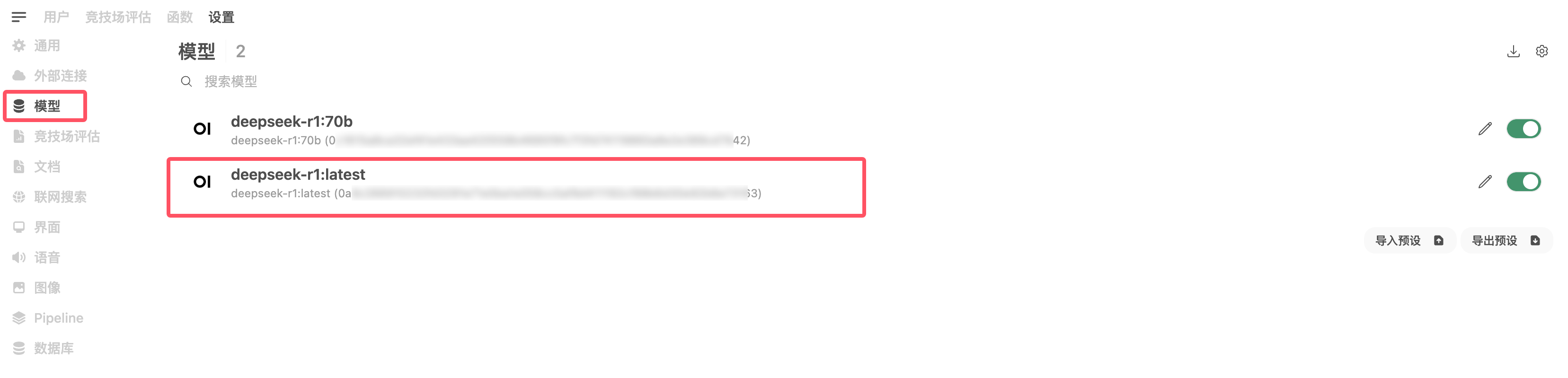

4. 单击模型,选中用户账号所需要使用的模型。

5. 将可见性设置为 Public。

可以实现 HTTPS 访问吗?

可以,具体步骤为:

1. 准备一个有解析权的根域名(如没有,请前往 购买域名)。

2. 为域名 申请 SSL 证书。

使用 CLB 的,请购买跟服务器同一个可用区的实例,实现内网回源。

使用 EdgeOne 的,需要从公网回源。