概述

用户可一键将内置大模型部署为在线服务,通过网页问答快速直观地体验大模型的效果;也可一键发起基于内置大模型的精调任务,将模型优化为可满足垂直场景需求的生产级模型。

内置大模型

大模型广场已内置如下大模型,最新支持的模型清单以大模型广场页面展示为准。

腾讯自研混元大模型:包括开源的 Hunyuan-Large 系列,以及闭源版本。

精选通用大模型:包括主流的开源大模型,如 DeepSeek 系列、Qwen3 系列、Qwen3-VL 系列、Qwen2.5-VL 系列、Gemma 3 系列、Kimi-K2 系列、Baichuan2 系列等。

其他:如腾讯自研行业大模型。

以上混元大模型的闭源版本以及行业大模型,请联系腾讯云行业销售进行服务开通。

功能说明

大模型广场提供以下主要功能。

浏览内置大模型

在大模型广场页面,以卡片形式展示模型清单。

模型标签:按任务类型(如文本分类、翻译、问答等)、语言(如中文、英文)、框架(如 PyTorch)等维度对模型进行分类,以标签形式展示,方便快速分类查找。

模型搜索:支持基于关键字的搜索功能,用户可以通过模型名称进行模糊查找。

发起部署和精调

单击广场中的卡片,可进入模型详情页,展示模型的更多详细信息,并支持快速试一试、精调训练等功能。

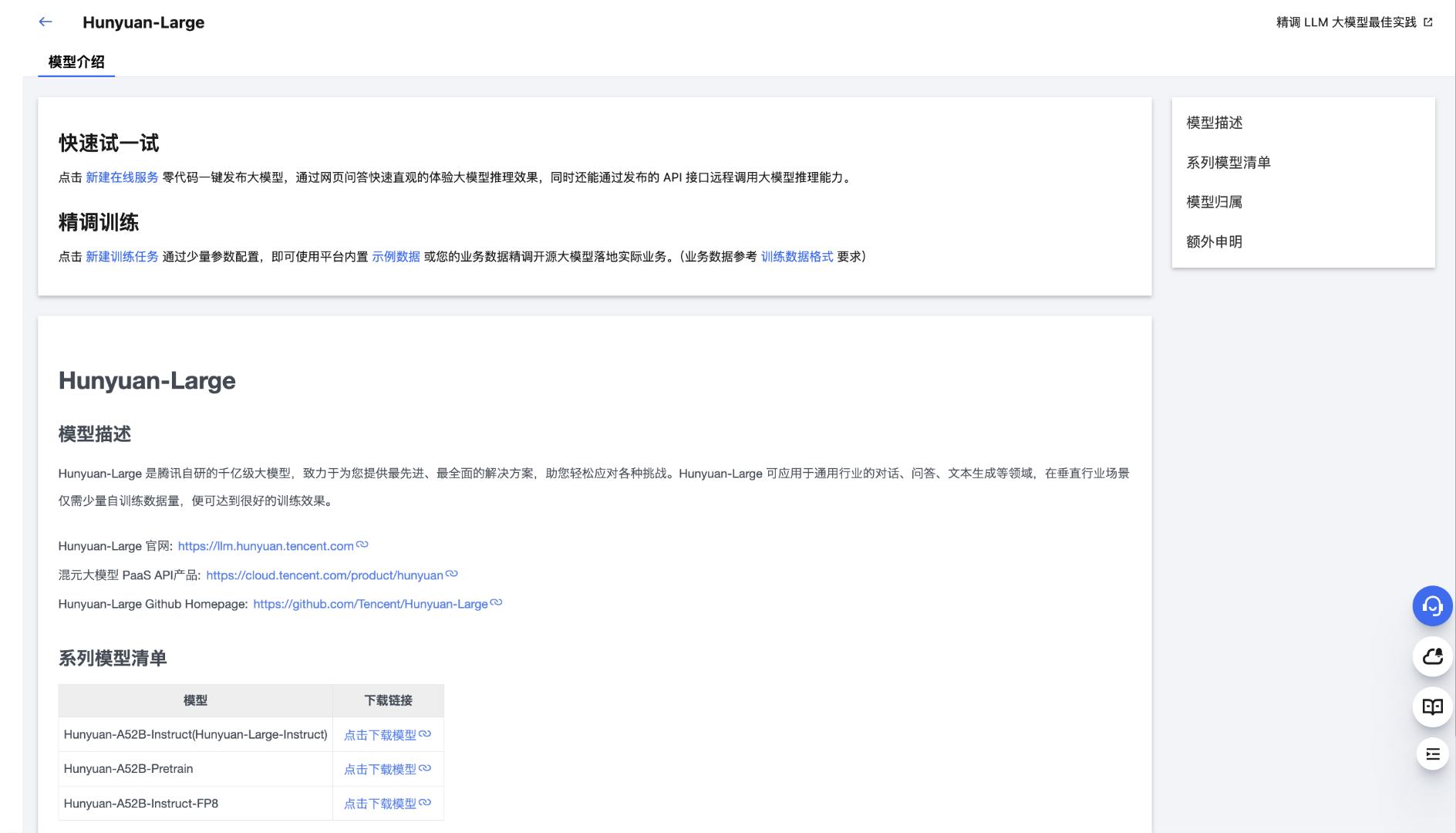

模型介绍:包括模型描述、系列模型清单、模型归属等信息。

快速试一试:单击新建在线服务,可跳转至 在线服务 模块,一键发起模型部署。

精调训练:单击新建训练任务,可跳转至 任务式建模 模块,一键发起精调训练。模型精调可显著提升模型在特定场景和任务中的性能,从而进一步满足生产级需求。

最佳实践

针对内置大模型,TI 平台提供了丰富的最佳实践文档,帮助用户快速上手模型部署和精调。

腾讯混元大模型系列:

DeepSeek 大模型部署:快速部署和体验 DeepSeek 系列模型

内置大模型部署:快速部署和体验内置开源 LLM 大模型

内置大模型精调:精调内置开源大模型