Hands on Reinforcement Learning Advanced Chapter

Hands on Reinforcement Learning Advanced Chapter

一只野生彩色铅笔

发布于 2023-04-24 09:51:12

发布于 2023-04-24 09:51:12

7 DQN 算法

7.1 简介

在第 5 章讲解的 Q-learning 算法中,我们以矩阵的方式建立了一张存储每个状态下所有动作值的表格。表格中的每一个动作价值Q(s,a)Q(s,a)Q(s,a)表示在状态sss下选择动作aaa然后继续遵循某一策略预期能够得到的期望回报。然而,这种用表格存储动作价值的做法只在环境的状态和动作都是离散的,并且空间都比较小的情况下适用,我们之前进行代码实战的几个环境都是如此(如悬崖漫步)。当状态或者动作数量非常大的时候,这种做法就不适用了。例如,当状态是一张 RGB 图像时,假设图像大小是210×160×3210\times 160\times 3210×160×3,此时一共有256(210×160×3)256^{(210\times 160\times 3)}256(210×160×3)种状态,在计算机中存储这个数量级的QQQ值表格是不现实的。更甚者,当状态或者动作连续的时候,就有无限个状态动作对,我们更加无法使用这种表格形式来记录各个状态动作对的QQQ值。

对于这种情况,我们需要用函数拟合的方法来估计QQQ值,即将这个复杂的QQQ值表格视作数据,使用一个参数化的函数QθQ_\thetaQθ来拟合这些数据。很显然,这种函数拟合的方法存在一定的精度损失,因此被称为近似方法。我们今天要介绍的 DQN 算法便可以用来解决连续状态下离散动作的问题。

7.2 CartPole 环境

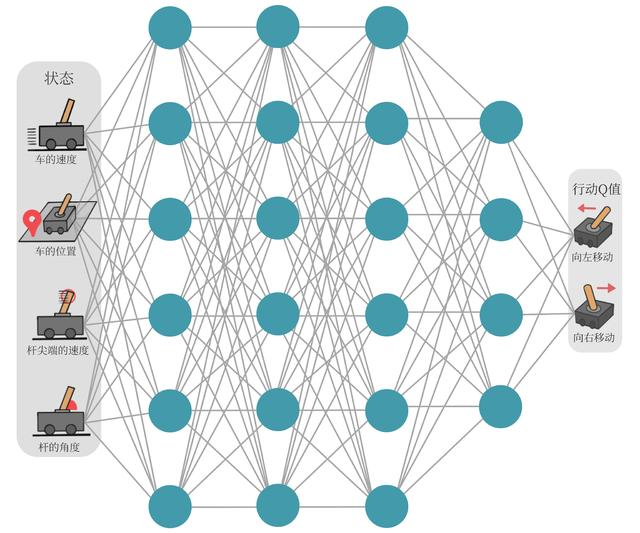

以图 7-1 中所示的所示的车杆(CartPole)环境为例,它的状态值就是连续的,动作值是离散的。

图 7-1 CartPole环境示意图

在车杆环境中,有一辆小车,智能体的任务是通过左右移动保持车上的杆竖直,若杆的倾斜度数过大,或者车子离初始位置左右的偏离程度过大,或者坚持时间到达 200 帧,则游戏结束。智能体的状态是一个维数为 4 的向量,每一维都是连续的,其动作是离散的,动作空间大小为 2,详情参见表 7-1 和表 7-2。在游戏中每坚持一帧,智能体能获得分数为 1 的奖励,坚持时间越长,则最后的分数越高,坚持 200 帧即可获得最高的分数。

表 7-1 CartPole环境的状态空间

维度 | 意义 | 最小值 | 最大值 |

|---|---|---|---|

0 | 车的位置 | -2.4 | 2.4 |

1 | 车的速度 | -Inf | Inf |

2 | 杆的角度 | ~ -41.8° | ~ 41.8° |

3 | 杆尖端的速度 | -Inf | Inf |

表7-2 CartPole环境的动作空间

标号 | 动作 |

|---|---|

0 | 向左移动小车 |

1 | 向右移动小车 |

7.3 DQN

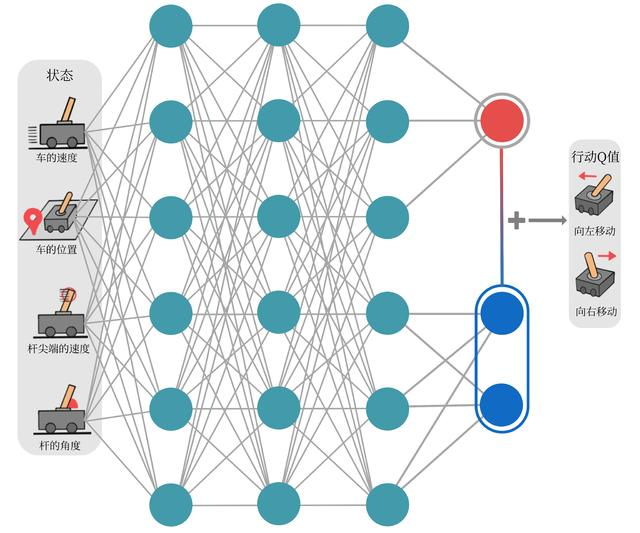

现在我们想在类似车杆的环境中得到动作价值函数Q(s,a)Q(s,a)Q(s,a),由于状态每一维度的值都是连续的,无法使用表格记录,因此一个常见的解决方法便是使用函数拟合(function approximation)的思想。由于神经网络具有强大的表达能力,因此我们可以用一个神经网络来表示函数QQQ。若动作是连续(无限)的,神经网络的输入是状态sss和动作aaa,然后输出一个标量,表示在状态sss下采取动作aaa能获得的价值。若动作是离散(有限)的,除了可以采取动作连续情况下的做法,我们还可以只将状态sss输入到神经网络中,使其同时输出每一个动作的QQQ值。通常 DQN(以及 Q-learning)只能处理动作离散的情况,因为在函数QQQ的更新过程中有maxa\max_amaxa这一操作。假设神经网络用来拟合函数的参数是ω\omegaω ,即每一个状态sss下所有可能动作aaa的值我们都能表示为Qω(s,a)Q_\omega(s,a)Qω(s,a)。我们将用于拟合函数QQQ函数的神经网络称为Q 网络,如图 7-2 所示。

图7-2 工作在CartPole环境中的Q网络示意图

那么 Q 网络的损失函数是什么呢?我们先来回顾一下 Q-learning 的更新规则(参见 5.5 节):

Q(s,a)←Q(s,a)+α[r+γmaxa′∈AQ(s′,a′)−Q(s,a)]Q(s,a) \leftarrow Q(s,a) + \alpha \Big[ r + \gamma \max_{a'\in\mathcal{A}} Q(s',a') - Q(s,a) \Big] Q(s,a)←Q(s,a)+α[r+γa′∈AmaxQ(s′,a′)−Q(s,a)]

上述公式用时序差分(temporal difference,TD)学习目标r+γmaxa′∈AQ(s′,a′)r + \gamma \max_{a'\in\mathcal{A}} Q(s',a')r+γmaxa′∈AQ(s′,a′)来增量式更新Q(s,a)Q(s,a)Q(s,a),也就是说要使Q(s,a)Q(s,a)Q(s,a)和TD目标r+γmaxa′∈AQ(s′,a′)r + \gamma \max_{a'\in\mathcal{A}} Q(s',a')r+γmaxa′∈AQ(s′,a′)靠近。于是,对于一组数据{(si,ai,ri,si′)}\Big\{(s_i,a_i,r_i,s_i')\Big\}{(si,ai,ri,si′)},我们可以很自然地将 Q 网络的损失函数构造为均方误差的形式:

ω∗=arg minω12N∑i=1N[Qω(si,ai)−(ri+γmaxa′Qω(si′,a′))]2\omega^* = \underset{\omega}{\argmin} \dfrac{1}{2N} \sum_{i=1}^N \bigg[ Q_\omega(s_i,a_i) - \Big( r_i + \gamma \max_{a'}Q_\omega (s_i', a') \Big) \bigg]^2 ω∗=ωargmin2N1i=1∑N[Qω(si,ai)−(ri+γa′maxQω(si′,a′))]2

至此,我们就可以将 Q-learning 扩展到神经网络形式——深度 Q 网络(deep Q network,DQN)算法。由于 DQN 是离线策略算法,因此我们在收集数据的时候可以使用一个ε-贪婪策略来平衡探索与利用,将收集到的数据存储起来,在后续的训练中使用。DQN 中还有两个非常重要的模块——经验回放和目标网络,它们能够帮助 DQN 取得稳定、出色的性能。

7.3.1 经验回放

在一般的有监督学习中,假设训练数据是独立同分布的,我们每次训练神经网络的时候从训练数据中随机采样一个或若干个数据来进行梯度下降,随着学习的不断进行,每一个训练数据会被使用多次。在原来的 Q-learning 算法中,每一个数据只会用来更新一次QQQ值。为了更好地将 Q-learning 和深度神经网络结合,DQN 算法采用了经验回放(experience replay)方法,具体做法为维护一个回放缓冲区,将每次从环境中采样得到的四元组数据(状态、动作、奖励、下一状态)存储到回放缓冲区中,训练 Q 网络的时候再从回放缓冲区中随机采样若干数据来进行训练。这么做可以起到以下两个作用。

- 使样本满足独立假设。在 MDP 中交互采样得到的数据本身不满足独立假设,因为这一时刻的状态和上一时刻的状态有关。非独立同分布的数据对训练神经网络有很大的影响,会使神经网络拟合到最近训练的数据上。采用经验回放可以打破样本之间的相关性,让其满足独立假设。 如果直接使用连续的样本进行训练,会导致样本之间的相关性较强,这可能会影响训练效果,使得Q值函数收敛较慢甚至不收敛。为了避免这种情况,DQN使用经验回放机制,将智能体的经验存储在回放缓冲区中,并从中随机抽取样本进行训练。在回放缓冲区中,每个样本都是从智能体在环境中的不同时间步采集的,因此它们之间的相关性很低。通过随机抽取样本进行训练,可以保证每个样本都有相同的机会被选中,从而使得样本之间的相关性更加随机化。此外,经验回放还可以减少训练数据的相关性,从而避免了过拟合的风险。这是因为经验回放可以从回放缓冲区中删除旧的样本,同时添加新的样本,从而确保样本之间的相关性始终保持在一个合理的范围内。

- 提高样本效率。每一个样本可以被使用多次,十分适合深度神经网络的梯度学习。

7.3.2 目标网络

DQN 算法最终更新的目标是让Qω(s,a)Q_\omega(s,a)Qω(s,a)逼近r+γmaxa′Qω(s′,a′)r + \gamma \max_{a'}Q_\omega(s',a')r+γmaxa′Qω(s′,a′),由于 TD 误差目标本身就包含神经网络的输出,因此在更新网络参数的同时目标也在不断地改变,这非常容易造成神经网络训练的不稳定性(在监督学习里,标签是固定不动的,但这里的估计Q值和目标Q值会一起变动,我们希望至少有一方变动不那么大,来保证算法稳定)。为了解决这一问题,DQN 便使用了目标网络(target network)的思想:既然训练过程中 Q 网络的不断更新会导致目标不断发生改变,不如暂时先将 TD 目标中的 Q 网络固定住。为了实现这一思想,我们需要利用两套 Q 网络。

- 原来的训练网络Qω(s,a)Q_\omega(s,a)Qω(s,a),用于计算原来的损失函数12[Qω(s,a)−(r+γmaxa′Qω−(s′,a′))]2\dfrac{1}{2}\bigg[Q_\omega(s,a) - \Big(r + \gamma\underset{a'}{\max} Q_{\omega^{-}}(s',a')\Big)\bigg]^221[Qω(s,a)−(r+γa′maxQω−(s′,a′))]2中的Qω(s,a)Q_\omega(s,a)Qω(s,a)项,并且使用正常梯度下降方法来进行更新。

- 目标网络Qω−(s,a)Q_{\omega^{-}}(s,a)Qω−(s,a),用于计算原先损失函数12[Qω(s,a)−(r+γmaxa′Qω−(s′,a′))]2\dfrac{1}{2}\bigg[Q_\omega(s,a) - \Big(r + \gamma\underset{a'}{\max} Q_{\omega^{-}}(s',a')\Big)\bigg]^221[Qω(s,a)−(r+γa′maxQω−(s′,a′))]2中的(r+γmaxa′Qω−(s′,a′))\Big(r + \gamma\underset{a'}{\max} Q_{\omega^{-}}(s',a')\Big)(r+γa′maxQω−(s′,a′))项,其中ω−\omega^{-}ω−表示目标网络中的参数。如果两套网络的参数随时保持一致,则仍为原先不够稳定的算法。为了让更新目标更稳定,目标网络并不会每一步都更新。具体而言,目标网络使用训练网络的一套较旧的参数,训练网络Qω(s,a)Q_\omega(s,a)Qω(s,a)在训练中的每一步都会更新,而目标网络的参数每隔CCC步才会与训练网络同步一次,即ω−←ω\omega^{-} \leftarrow \omegaω−←ω。这样做使得目标网络相对于训练网络更加稳定。

综上所述,DQN 算法的具体流程如下:

- 用随机的网络参数ω\omegaω初始化网络Qω(s,a)Q_\omega(s,a)Qω(s,a)

- 复制相同的参数ω−←ω\omega^{-}\leftarrow \omegaω−←ω来初始化目标网络Qω−Q_{\omega^{-}}Qω−

- 初始化经验回放池RRR

- for 序列e=1→Ee=1\rightarrow Ee=1→E do

- 获取环境初始状态s1s_1s1

- for 时间步t=1→Tt=1\rightarrow Tt=1→T do

- 根据当前网络Qω(s,a)Q_\omega(s,a)Qω(s,a)以ε-贪婪策略选择动作ata_tat

- 执行动作ata_tat,获得回报rtr_trt,环境状态变为st+1s_{t+1}st+1

- 将(st,at,rt,st+1)(s_t,a_t,r_t,s_{t+1})(st,at,rt,st+1)存储进回放池RRR中

- 若RRR中数据足够,从RRR中采样NNN个数据{(s1,ai,ri,si+1)}i=1,…,N\Big\{(s_1,a_i,r_i,s_{i+1})\Big\}_{i=1,\dots,N}{(s1,ai,ri,si+1)}i=1,…,N

- 对每个数据,用目标网络计算yi=ri+γmaxaQω−(si+1,a)y_i=r_i+\gamma\max_aQ_{\omega^{-}}(s_{i+1},a)yi=ri+γmaxaQω−(si+1,a)

- 最小化目标损失L=1N∑i12(yi−Qω(si,ai))2L=\dfrac{1}{N}\underset{i}{\sum}\dfrac{1}{2}\Big(y_i - Q_\omega(s_i,a_i)\Big)^2L=N1i∑21(yi−Qω(si,ai))2,以此更新当前网络QωQ_\omegaQω

- 更新目标网络

- end for

- end for

7.4 DQN 代码实践

接下来,我们就正式进入 DQN 算法的代码实践环节。我们采用的测试环境是 CartPole-v0,其状态空间相对简单,只有 4 个变量,因此网络结构的设计也相对简单:采用一层 128 个神经元的全连接并以 ReLU 作为激活函数。当遇到更复杂的诸如以图像作为输入的环境时,我们可以考虑采用深度卷积神经网络。

从 DQN 算法开始,我们将会用到rl_utils库,它包含一些专门为本书准备的函数,如绘制移动平均曲线、计算优势函数等,不同的算法可以一起使用这些函数。为了能够调用rl_utils库,请从本书的GitHub 仓库下载rl_utils.py文件。

import random

import gym

import numpy as np

import collections

from tqdm import tqdm

import torch

import torch.nn.functional as F

import matplotlib.pyplot as plt

import rl_utils

首先定义经验回放池的类,主要包括加入数据、采样数据两大函数。

class ReplayBuffer:

''' 经验回放池 '''

def __init__(self, capacity):

self.buffer = collections.deque(maxlen=capacity) # 队列,先进先出

def add(self, state, action, reward, next_state, done): # 将数据加入buffer

self.buffer.append((state, action, reward, next_state, done))

def sample(self, batch_size): # 从buffer中采样数据,数量为batch_size

transitions = random.sample(self.buffer, batch_size)

state, action, reward, next_state, done = zip(*transitions)

return np.array(state), action, reward, np.array(next_state), done

def size(self): # 目前buffer中数据的数量

return len(self.buffer)

然后定义一个只有一层隐藏层的 Q 网络。

class Qnet(torch.nn.Module):

''' 只有一层隐藏层的Q网络 '''

def __init__(self, state_dim, hidden_dim, action_dim):

super(Qnet, self).__init__()

self.fc1 = torch.nn.Linear(state_dim, hidden_dim)

self.fc2 = torch.nn.Linear(hidden_dim, action_dim)

def forward(self, x):

x = F.relu(self.fc1(x)) # 隐藏层使用ReLU激活函数

return self.fc2(x)

有了这些基本组件之后,接来下开始实现 DQN 算法。

class DQN:

''' DQN算法 '''

def __init__(self,

state_dim,

hidden_dim,

action_dim,

learning_rate,

gamma,

epsilon,

target_update,

device

):

self.action_dim = action_dim

self.q_net = Qnet(state_dim, hidden_dim, self.action_dim).to(device) # Q网络

# 目标网络

self.target_q_net = Qnet(state_dim, hidden_dim, self.action_dim).to(device)

# 使用Adam优化器

self.optimizer = torch.optim.Adam(self.q_net.parameters(), lr=learning_rate)

self.gamma = gamma # 折扣因子

self.epsilon = epsilon # epsilon-贪婪策略

self.target_update = target_update # 目标网络更新频率

self.count = 0 # 计数器,记录更新次数

self.device = device

def take_action(self, state): # epsilon-贪婪策略采取动作

if np.random.random() < self.epsilon:

action = np.random.randint(self.action_dim)

else:

state = torch.tensor([state], dtype=torch.float).to(self.device)

action = self.q_net(state).argmax().item()

return action

def update(self, transition_dict):

states = torch.tensor(transition_dict['states'], dtype=torch.float).to(self.device)

actions = torch.tensor(transition_dict['actions']).view(-1, 1).to(self.device)

rewards = torch.tensor(transition_dict['rewards'], dtype=torch.float).view(-1, 1).to(self.device)

next_states = torch.tensor(transition_dict['next_states'], dtype=torch.float).to(self.device)

dones = torch.tensor(transition_dict['dones'], dtype=torch.float).view(-1, 1).to(self.device)

q_values = self.q_net(states).gather(1, actions) # Q值

# 下个状态的最大Q值

max_next_q_values = self.target_q_net(next_states).max(1)[0].view(-1, 1)

q_targets = rewards + self.gamma * max_next_q_values * (1 - dones) # TD误差目标

dqn_loss = torch.mean(F.mse_loss(q_values, q_targets)) # 均方误差损失函数

self.optimizer.zero_grad() # PyTorch中默认梯度会累积,这里需要显式将梯度置为0

dqn_loss.backward() # 反向传播更新参数

self.optimizer.step()

if self.count % self.target_update == 0:

self.target_q_net.load_state_dict(self.q_net.state_dict()) # 更新目标网络

self.count += 1

一切准备就绪,开始训练并查看结果。我们之后会将这一训练过程包装进rl_utils库中,方便之后要学习的算法的代码实现。

lr = 2e-3

num_episodes = 500

hidden_dim = 128

gamma = 0.98

epsilon = 0.01

target_update = 10

buffer_size = 10000

minimal_size = 500

batch_size = 64

device = torch.device("cuda") if torch.cuda.is_available() else torch.device("cpu")

env_name = 'CartPole-v0'

env = gym.make(env_name)

random.seed(0)

np.random.seed(0)

env.seed(0)

torch.manual_seed(0)

replay_buffer = ReplayBuffer(buffer_size)

state_dim = env.observation_space.shape[0]

action_dim = env.action_space.n

agent = DQN(state_dim, hidden_dim, action_dim, lr, gamma, epsilon, target_update, device)

return_list = []

for i in range(10):

with tqdm(total=int(num_episodes / 10), desc='Iteration %d' % i) as pbar:

for i_episode in range(int(num_episodes / 10)):

episode_return = 0

state = env.reset()

done = False

while not done:

action = agent.take_action(state)

next_state, reward, done, _ = env.step(action)

replay_buffer.add(state, action, reward, next_state, done)

state = next_state

episode_return += reward

# 当buffer数据的数量超过一定值后,才进行Q网络训练

if replay_buffer.size() > minimal_size:

b_s, b_a, b_r, b_ns, b_d = replay_buffer.sample(batch_size)

transition_dict = {

'states': b_s,

'actions': b_a,

'next_states': b_ns,

'rewards': b_r,

'dones': b_d

}

agent.update(transition_dict)

return_list.append(episode_return)

if (i_episode + 1) % 10 == 0:

pbar.set_postfix({

'episode':

'%d' % (num_episodes / 10 * i + i_episode + 1),

'return':

'%.3f' % np.mean(return_list[-10:])

})

pbar.update(1)

Iteration 0: 100%|████████████████████████████████████████| 50/50 [00:00<00:00, 589.55it/s, episode=50, return=9.300]

Iteration 1: 100%|████████████████████████████████████████| 50/50 [00:00<00:00, 60.01it/s, episode=100, return=12.300]

Iteration 2: 100%|████████████████████████████████████████| 50/50 [00:04<00:00, 11.94it/s, episode=150, return=123.000]

Iteration 3: 100%|████████████████████████████████████████| 50/50 [00:15<00:00, 3.27it/s, episode=200, return=159.300]

Iteration 4: 100%|████████████████████████████████████████| 50/50 [00:16<00:00, 3.04it/s, episode=250, return=192.200]

Iteration 5: 100%|████████████████████████████████████████| 50/50 [00:15<00:00, 3.23it/s, episode=300, return=199.900]

Iteration 6: 100%|████████████████████████████████████████| 50/50 [00:15<00:00, 3.28it/s, episode=350, return=193.400]

Iteration 7: 100%|████████████████████████████████████████| 50/50 [00:16<00:00, 3.10it/s, episode=400, return=200.000]

Iteration 8: 100%|████████████████████████████████████████| 50/50 [00:15<00:00, 3.28it/s, episode=450, return=172.300]

Iteration 9: 100%|████████████████████████████████████████| 50/50 [00:15<00:00, 3.32it/s, episode=500, return=185.000]

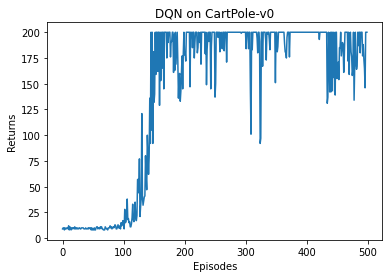

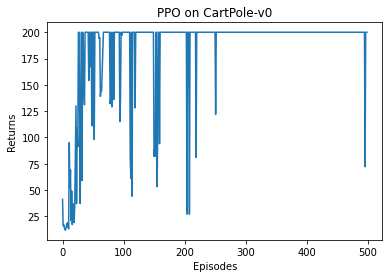

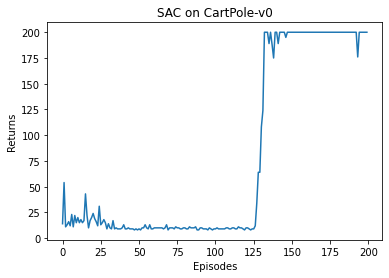

episodes_list = list(range(len(return_list)))

plt.plot(episodes_list, return_list)

plt.xlabel('Episodes')

plt.ylabel('Returns')

plt.title('DQN on {}'.format(env_name))

plt.show()

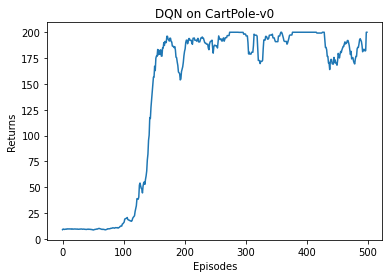

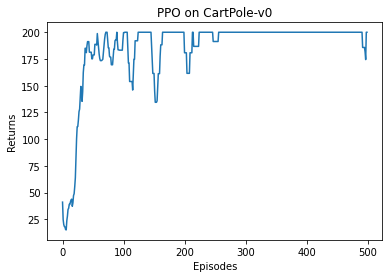

mv_return = rl_utils.moving_average(return_list, 9)

plt.plot(episodes_list, mv_return)

plt.xlabel('Episodes')

plt.ylabel('Returns')

plt.title('DQN on {}'.format(env_name))

plt.show()

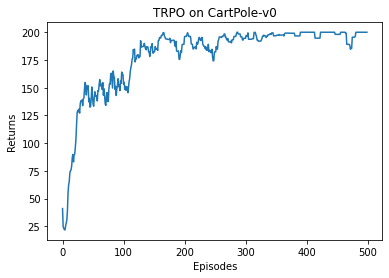

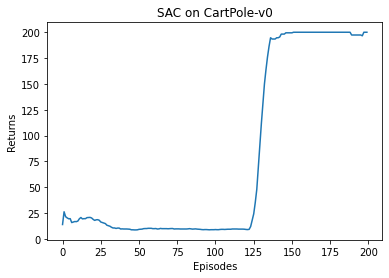

可以看到,DQN 的性能在 100 个序列后很快得到提升,最终收敛到策略的最优回报值 200。我们也可以看到,在 DQN 的性能得到提升后,它会持续出现一定程度的震荡,这主要是神经网络过拟合到一些局部经验数据后由arg max\argmaxargmax运算带来的影响。

7.5 以图像为输入的 DQN 算法

在本书前面章节所述的强化学习环境中,我们都使用非图像的状态作为输入(例如车杆环境中车的坐标、速度),但是在一些视频游戏中,智能体并不能直接获取这些状态信息,而只能直接获取屏幕中的图像。要让智能体和人一样玩游戏,我们需要让智能体学会以图像作为状态时的决策。我们可以利用 7.4 节的 DQN 算法,将卷积层加入其网络结构以提取图像特征,最终实现以图像为输入的强化学习。以图像为输入的 DQN 算法的代码与 7.4 节的代码的不同之处主要在于 Q 网络的结构和数据输入。DQN 网络通常会将最近的几帧图像一起作为输入,从而感知环境的动态性。接下来我们实现以图像为输入的 DQN 算法,但由于代码需要运行较长的时间,我们在此便不展示训练结果。

class ConvolutionalQnet(torch.nn.Module):

''' 加入卷积层的Q网络 '''

def __init__(self, action_dim, in_channels=4):

super(ConvolutionalQnet, self).__init__()

self.conv1 = torch.nn.Conv2d(in_channels, 32, kernel_size=8, stride=4)

self.conv2 = torch.nn.Conv2d(32, 64, kernel_size=4, stride=2)

self.conv3 = torch.nn.Conv2d(64, 64, kernel_size=3, stride=1)

self.fc4 = torch.nn.Linear(7 * 7 * 64, 512)

self.head = torch.nn.Linear(512, action_dim)

def forward(self, x):

x = x / 255

x = F.relu(self.conv1(x))

x = F.relu(self.conv2(x))

x = F.relu(self.conv3(x))

x = F.relu(self.fc4(x))

return self.head(x)

7.6 小结

本章讲解了 DQN 算法,其主要思想是用一个神经网络来表示最优策略的函数QQQ,然后利用 Q-learning 的思想进行参数更新。为了保证训练的稳定性和高效性,DQN 算法引入了经验回放和目标网络两大模块,使得算法在实际应用时能够取得更好的效果。在 2013 年的 NIPS 深度学习研讨会上,DeepMind 公司的研究团队发表了 DQN 论文,首次展示了这一直接通过卷积神经网络接受像素输入来玩转各种雅达利(Atari)游戏的强化学习算法,由此拉开了深度强化学习的序幕。DQN 是深度强化学习的基础,掌握了该算法才算是真正进入了深度强化学习领域,本书中还有更多的深度强化学习算法等待读者探索。

7.7 参考文献

[1] VOLODYMYR M, KAVUKCUOGLU K, SILVER D, et al. Human-level control through deep reinforcement learning [J]. Nature, 2015, 518(7540): 529-533.

[2] VOLODYMYR M, KAVUKCUOGLU K, SILVER D, et al. Playing atari with deep reinforcement learning [C]//NIPS Deep Learning Workshop, 2013.

8 DQN 改进算法

8.1 简介

DQN 算法敲开了深度强化学习的大门,但是作为先驱性的工作,其本身存在着一些问题以及一些可以改进的地方。于是,在 DQN 之后,学术界涌现出了非常多的改进算法。本章将介绍其中两个非常著名的算法:Double DQN 和 Dueling DQN,这两个算法的实现非常简单,只需要在 DQN 的基础上稍加修改,它们能在一定程度上改善 DQN 的效果。如果读者想要了解更多、更详细的 DQN 改进方法,可以阅读 Rainbow 模型的论文及其引用文献。

8.2 Double DQN

普通的 DQN 算法通常会导致对QQQ值的过高估计(overestimation)。传统 DQN 优化的 TD 误差目标为

r+γmaxa′Qω−(s′,a′)r + \gamma \max_{a'} Q_{\omega^{-}}(s',a') r+γa′maxQω−(s′,a′)

其中maxa′Qω−(s′,a′)\max_a' Q_{\omega^{-}}(s',a')maxa′Qω−(s′,a′)由目标网络(参数为ω−\omega^{-}ω−)计算得出,我们还可以将其写成如下形式:

Qω−(s′,arg maxa′Qω−(s′,a′))Q_{\omega^{-}} \Big( s', \underset{a'}{\argmax} Q_{\omega^{-}}(s',a') \Big) Qω−(s′,a′argmaxQω−(s′,a′))

换句话说,max\maxmax操作实际可以被拆解为两部分:首先选取状态s′s's′下的最优动作a∗=arg maxa′Qω−(s′,a′)a^*=\underset{a'}{\argmax} Q_{\omega^{-}}(s',a')a∗=a′argmaxQω−(s′,a′),接着计算该动作对应的价值Qω−(s′,a∗)Q_{\omega^{-}}(s',a^{*})Qω−(s′,a∗)。 当这两部分采用同一套 Q 网络进行计算时,每次得到的都是神经网络当前估算的所有动作价值中的最大值。考虑到通过神经网络估算的QQQ值本身在某些时候会产生正向或负向的误差,在 DQN 的更新方式下神经网络会将正向误差累积。例如,我们考虑一个特殊情形:在状态s′s's′下所有动作QQQ的值均为 000,即Q(s′,ai)=0,∀iQ(s',a_i)=0,\forall iQ(s′,ai)=0,∀i,此时正确的更新目标应为r+0=rr+0=rr+0=r,但是由于神经网络拟合的误差通常会出现某些动作的估算有正误差的情况,即存在某个动作a′a'a′有Q(s′,a′)>0Q(s',a')>0Q(s′,a′)>0,此时我们的更新目标出现了过高估计,r+γmaxQ>r+0r+\gamma\max Q > r + 0r+γmaxQ>r+0。因此,当我们用 DQN 的更新公式进行更新时,Q(s,a)Q(s,a)Q(s,a)也就会被过高估计了。同理,我们拿这个Q(s,a)Q(s,a)Q(s,a)来作为更新目标来更新上一步的QQQ值时,同样会过高估计,这样的误差将会逐步累积。对于动作空间较大的任务,DQN 中的过高估计问题会非常严重,造成 DQN 无法有效工作的后果。

为了解决这一问题,Double DQN 算法提出利用两个独立训练的神经网络估算maxa′Q∗(s′,a′)\max\limits_{a'}Q_{*}(s',a')a′maxQ∗(s′,a′)。具体做法是将原有的maxa′Qω−(s′,a′)\max\limits_{a'}Q_{\omega^{-}}(s',a')a′maxQω−(s′,a′)更改为Qω−(s′,arg maxa′Qω(s′,a′))Q_{\omega^{-}}(s',\underset{a'}{\argmax}Q_{\omega}(s',a'))Qω−(s′,a′argmaxQω(s′,a′)),即利用一套神经网络QωQ_\omegaQω的输出选取价值最大的动作,但在使用该动作的价值时,用另一套神经网络Qω−Q_\omega^-Qω−计算该动作的价值。这样,即使其中一套神经网络的某个动作存在比较严重的过高估计问题,由于另一套神经网络的存在,这个动作最终使用的QQQ值不会存在很大的过高估计问题。

在传统的 DQN 算法中,本来就存在两套QQQ函数的神经网络——目标网络和训练网络(参见 7.3.2 节),只不过maxa′Qω−(s′,a′)\underset{a'}{\max}Q_{\omega^{-}}(s',a')a′maxQω−(s′,a′)的计算只用到了其中的目标网络,那么我们恰好可以直接将训练网络作为 Double DQN 算法中的第一套神经网络来选取动作,将目标网络作为第二套神经网络计算QQQ值,这便是 Double DQN 的主要思想。由于在 DQN 算法中将训练网络的参数记为ω\omegaω,将目标网络的参数记为ω−\omega^{-}ω−,这与本节中 Double DQN 的两套神经网络的参数是统一的,因此,我们可以直接写出如下 Double DQN 的优化目标:

r+γQω−(s′,arg maxa′Qω(s′,a′))r + \gamma Q_{\omega^{-}} \Big( s', \underset{a'}{\argmax}Q_{\omega}(s',a') \Big) r+γQω−(s′,a′argmaxQω(s′,a′))

8.3 Double DQN 代码实践

显然,DQN 与 Double DQN 的差别只是在于计算状态s′s's′下QQQ值时如何选取动作:

- DQN 的优化目标可以写为r+γQω−(s′,arg maxa′Qω−(s′,a′))r + \gamma Q_{\omega^{-}}(s',\underset{a'}{\argmax} Q_{\omega^{-}}(s', a'))r+γQω−(s′,a′argmaxQω−(s′,a′)),动作的选取依靠目标网络Qω−Q_{\omega^{-}}Qω−;

- Double DQN 的优化目标为r+γQω−(s′,arg maxa′Qω(s′,a′))r + \gamma Q_{\omega^{-}}(s',\underset{a'}{\argmax} Q_{\omega}(s', a'))r+γQω−(s′,a′argmaxQω(s′,a′)),动作的选取依靠训练网络QωQ_{\omega}Qω。

所以 Double DQN 的代码实现可以直接在 DQN 的基础上进行,无须做过多修改。

本节采用的环境是倒立摆(Inverted Pendulum),该环境下有一个处于随机位置的倒立摆,如图 8-1 所示。环境的状态包括倒立摆角度的正弦值sinθ\sin\thetasinθ,余弦值cosθ\cos\thetacosθ,角速度θ˙\dot\thetaθ˙;动作为对倒立摆施加的力矩,详情参见表 8-1 和表 8-2。每一步都会根据当前倒立摆的状态的好坏给予智能体不同的奖励,该环境的奖励函数为−(θ2+0.1θ˙2+0.001a2)-(\theta^2 + 0.1\dot\theta^2 + 0.001a^2)−(θ2+0.1θ˙2+0.001a2),倒立摆向上保持直立不动时奖励为 000,倒立摆在其他位置时奖励为负数。环境本身没有终止状态,运行 200200200 步后游戏自动结束。

图8-1 Pendulum环境示意图

标号 | 名称 | 最小值 | 最大值 |

|---|---|---|---|

0 | cosθ\cos\thetacosθ | -1.0 | 1.0 |

1 | sinθ\sin\thetasinθ | -1.0 | 1.0 |

2 | θ˙\dot\thetaθ˙ | -8.0 | 8.0 |

表8-1 Pendulum环境的状态空间

标号 | 动作 | 最小值 | 最大值 |

|---|---|---|---|

0 | 力矩 | -2.0 | 2.0 |

表8-2 Pendulum环境的动作空间

力矩大小是在[−2,2][-2, 2][−2,2]范围内的连续值。由于 DQN 只能处理离散动作环境,因此我们无法直接用 DQN 来处理倒立摆环境,但倒立摆环境可以比较方便地验证 DQN 对QQQ值的过高估计:倒立摆环境下QQQ值的最大估计应为 000(倒立摆向上保持直立时能选取的最大QQQ值),值出现大于 000 的情况则说明出现了过高估计。为了能够应用 DQN,我们采用离散化动作的技巧。例如,下面的代码将连续的动作空间离散为 111111 个动作。动作[0,1,2,⋯ ,9,10][0,1,2,\cdots,9,10][0,1,2,⋯,9,10]分别代表力矩为[−2,−1.6,−1.2,⋯ ,1.2,1.6,2][-2, -1.6,-1.2,\cdots,1.2, 1.6, 2][−2,−1.6,−1.2,⋯,1.2,1.6,2]。

import random

import gym

import numpy as np

import torch

import torch.nn.functional as F

import matplotlib.pyplot as plt

import rl_utils

from tqdm import tqdm

class Qnet(torch.nn.Module):

''' 只有一层隐藏层的Q网络 '''

def __init__(self, state_dim, hidden_dim, action_dim):

super(Qnet, self).__init__()

self.fc1 = torch.nn.Linear(state_dim, hidden_dim)

self.fc2 = torch.nn.Linear(hidden_dim, action_dim)

def forward(self, x):

x = F.relu(self.fc1(x))

return self.fc2(x)

接下来我们在 DQN 代码的基础上稍做修改以实现 Double DQN。

class DQN:

''' DQN算法,包括Double DQN '''

def __init__(self,

state_dim,

hidden_dim,

action_dim,

learning_rate,

gamma,

epsilon,

target_update,

device,

dqn_type='VanillaDQN'):

self.action_dim = action_dim

self.q_net = Qnet(state_dim, hidden_dim, self.action_dim).to(device)

self.target_q_net = Qnet(state_dim, hidden_dim, self.action_dim).to(device)

self.optimizer = torch.optim.Adam(self.q_net.parameters(), lr=learning_rate)

self.gamma = gamma

self.epsilon = epsilon

self.target_update = target_update

self.count = 0

self.dqn_type = dqn_type

self.device = device

def take_action(self, state):

if np.random.random() < self.epsilon:

action = np.random.randint(self.action_dim)

else:

state = torch.tensor([state], dtype=torch.float).to(self.device)

action = self.q_net(state).argmax().item()

return action

def max_q_value(self, state):

state = torch.tensor([state], dtype=torch.float).to(self.device)

return self.q_net(state).max().item()

def update(self, transition_dict):

states = torch.tensor(transition_dict['states'], dtype=torch.float).to(self.device)

actions = torch.tensor(transition_dict['actions']).view(-1, 1).to(self.device)

rewards = torch.tensor(transition_dict['rewards'], dtype=torch.float).view(-1, 1).to(self.device)

next_states = torch.tensor(transition_dict['next_states'], dtype=torch.float).to(self.device)

dones = torch.tensor(transition_dict['dones'], dtype=torch.float).view(-1, 1).to(self.device)

q_values = self.q_net(states).gather(1, actions) # Q值

# 下个状态的最大Q值

if self.dqn_type == 'DoubleDQN': # DQN与Double DQN的区别

max_action = self.q_net(next_states).max(1)[1].view(-1, 1)

max_next_q_values = self.target_q_net(next_states).gather(1, max_action)

else: # DQN的情况

max_next_q_values = self.target_q_net(next_states).max(1)[0].view(-1, 1)

q_targets = rewards + self.gamma * max_next_q_values * (1 - dones) # TD误差目标

dqn_loss = torch.mean(F.mse_loss(q_values, q_targets)) # 均方误差损失函数

self.optimizer.zero_grad() # PyTorch中默认梯度会累积,这里需要显式将梯度置为0

dqn_loss.backward() # 反向传播更新参数

self.optimizer.step()

if self.count % self.target_update == 0:

self.target_q_net.load_state_dict(self.q_net.state_dict()) # 更新目标网络

self.count += 1

接下来我们设置相应的超参数,并实现将倒立摆环境中的连续动作转化为离散动作的函数。

lr = 1e-2

num_episodes = 200

hidden_dim = 128

gamma = 0.98

epsilon = 0.01

target_update = 50

buffer_size = 5000

minimal_size = 1000

batch_size = 64

device = torch.device("cuda") if torch.cuda.is_available() else torch.device("cpu")

env_name = 'Pendulum-v0'

env = gym.make(env_name)

state_dim = env.observation_space.shape[0]

action_dim = 11 # 将连续动作分成11个离散动作

def dis_to_con(discrete_action, env, action_dim): # 离散动作转回连续的函数

action_lowbound = env.action_space.low[0] # 连续动作的最小值

action_upbound = env.action_space.high[0] # 连续动作的最大值

return action_lowbound + (discrete_action / (action_dim - 1)) * (action_upbound - action_lowbound)

接下来要对比 DQN 和 Double DQN 的训练情况,为了便于后续多次调用,我们进一步将 DQN 算法的训练过程定义成一个函数。训练过程会记录下每个状态的最大值,在训练完成后我们可以将结果可视化,观测这些QQQ值存在的过高估计的情况,以此来对比 DQN 和 Double DQN 的不同。

def train_DQN(agent, env, num_episodes, replay_buffer, minimal_size, batch_size):

return_list = []

max_q_value_list = []

max_q_value = 0

for i in range(10):

with tqdm(total=int(num_episodes / 10), desc='Iteration %d' % i) as pbar:

for i_episode in range(int(num_episodes / 10)):

episode_return = 0

state = env.reset()

done = False

while not done:

action = agent.take_action(state)

max_q_value = agent.max_q_value(state) * 0.005 + max_q_value * 0.995 # 平滑处理

max_q_value_list.append(max_q_value) # 保存每个状态的最大Q值

action_continuous = dis_to_con(action, env, agent.action_dim)

next_state, reward, done, _ = env.step([action_continuous])

replay_buffer.add(state, action, reward, next_state, done)

state = next_state

episode_return += reward

if replay_buffer.size() > minimal_size:

b_s, b_a, b_r, b_ns, b_d = replay_buffer.sample(batch_size)

transition_dict = {

'states': b_s,

'actions': b_a,

'next_states': b_ns,

'rewards': b_r,

'dones': b_d

}

agent.update(transition_dict)

return_list.append(episode_return)

if (i_episode + 1) % 10 == 0:

pbar.set_postfix({

'episode':

'%d' % (num_episodes / 10 * i + i_episode + 1),

'return':

'%.3f' % np.mean(return_list[-10:])

})

pbar.update(1)

return return_list, max_q_value_list

一切就绪!我们首先训练 DQN 并打印出其学习过程中最大QQQ值的情况。

random.seed(0)

np.random.seed(0)

env.seed(0)

torch.manual_seed(0)

replay_buffer = rl_utils.ReplayBuffer(buffer_size)

agent = DQN(state_dim, hidden_dim, action_dim, lr, gamma, epsilon, target_update, device)

return_list, max_q_value_list = train_DQN(agent, env, num_episodes, replay_buffer, minimal_size, batch_size)

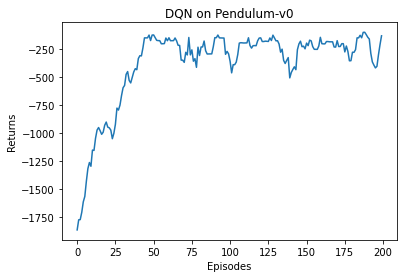

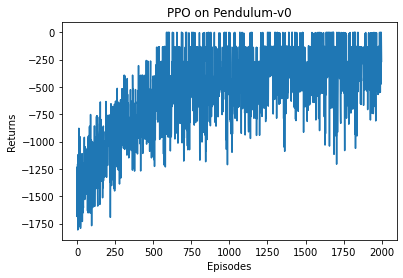

episodes_list = list(range(len(return_list)))

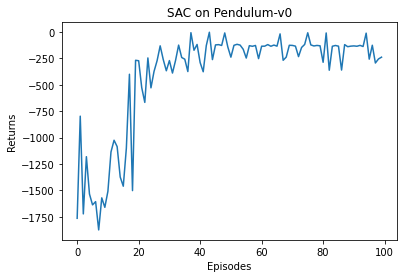

mv_return = rl_utils.moving_average(return_list, 5)

plt.plot(episodes_list, mv_return)

plt.xlabel('Episodes')

plt.ylabel('Returns')

plt.title('DQN on {}'.format(env_name))

plt.show()

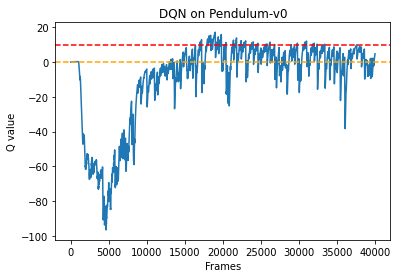

frames_list = list(range(len(max_q_value_list)))

plt.plot(frames_list, max_q_value_list)

plt.axhline(0, c='orange', ls='--')

plt.axhline(10, c='red', ls='--')

plt.xlabel('Frames')

plt.ylabel('Q value')

plt.title('DQN on {}'.format(env_name))

plt.show()

Iteration 0: 100%|██████████| 20/20 [00:02<00:00, 7.14it/s, episode=20, return=-1018.764]

Iteration 1: 100%|██████████| 20/20 [00:03<00:00, 5.73it/s, episode=40, return=-463.311]

Iteration 2: 100%|██████████| 20/20 [00:03<00:00, 5.53it/s, episode=60, return=-184.817]

Iteration 3: 100%|██████████| 20/20 [00:03<00:00, 5.55it/s, episode=80, return=-317.366]

Iteration 4: 100%|██████████| 20/20 [00:03<00:00, 5.67it/s, episode=100, return=-208.929]

Iteration 5: 100%|██████████| 20/20 [00:03<00:00, 5.59it/s, episode=120, return=-182.659]

Iteration 6: 100%|██████████| 20/20 [00:03<00:00, 5.25it/s, episode=140, return=-275.938]

Iteration 7: 100%|██████████| 20/20 [00:03<00:00, 5.65it/s, episode=160, return=-209.702]

Iteration 8: 100%|██████████| 20/20 [00:03<00:00, 5.73it/s, episode=180, return=-246.861]

Iteration 9: 100%|██████████| 20/20 [00:03<00:00, 5.77it/s, episode=200, return=-293.374]

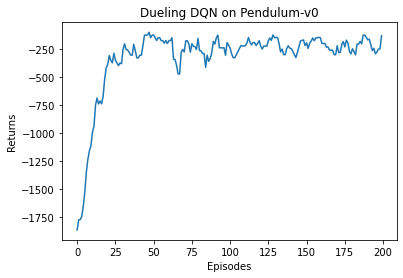

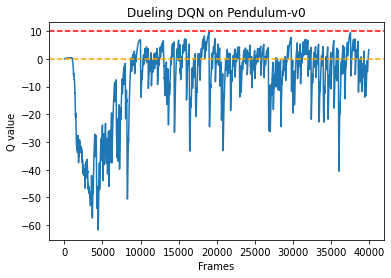

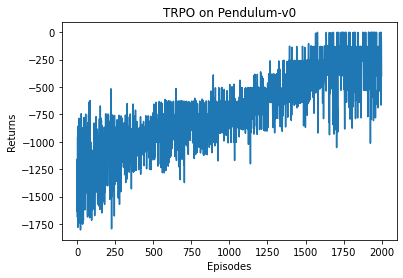

根据代码运行结果我们可以发现,DQN 算法在倒立摆环境中能取得不错的回报,最后的期望回报在−200-200−200左右,但是不少QQQ值超过了 000,有一些还超过了 101010,该现象便是 DQN 算法中的QQQ值过高估计。我们现在来看一下 Double DQN 是否能对此问题进行改善。

random.seed(0)

np.random.seed(0)

env.seed(0)

torch.manual_seed(0)

replay_buffer = rl_utils.ReplayBuffer(buffer_size)

agent = DQN(state_dim, hidden_dim, action_dim, lr, gamma, epsilon, target_update, device, 'DoubleDQN')

return_list, max_q_value_list = train_DQN(agent, env, num_episodes, replay_buffer, minimal_size, batch_size)

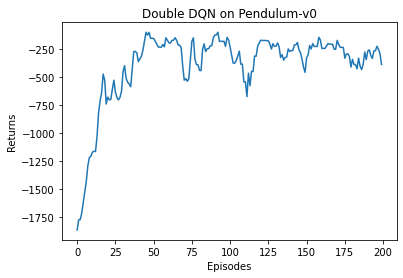

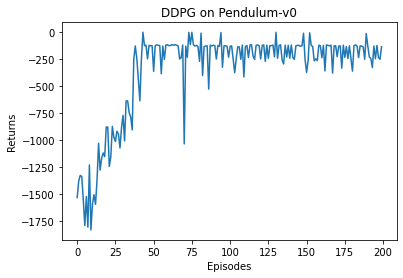

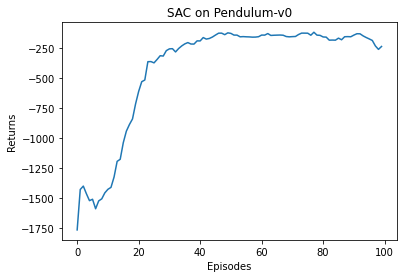

episodes_list = list(range(len(return_list)))

mv_return = rl_utils.moving_average(return_list, 5)

plt.plot(episodes_list, mv_return)

plt.xlabel('Episodes')

plt.ylabel('Returns')

plt.title('Double DQN on {}'.format(env_name))

plt.show()

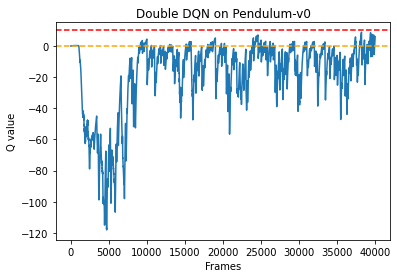

frames_list = list(range(len(max_q_value_list)))

plt.plot(frames_list, max_q_value_list)

plt.axhline(0, c='orange', ls='--')

plt.axhline(10, c='red', ls='--')

plt.xlabel('Frames')

plt.ylabel('Q value')

plt.title('Double DQN on {}'.format(env_name))

plt.show()

Iteration 0: 100%|██████████| 20/20 [00:03<00:00, 6.60it/s, episode=20, return=-818.719]

Iteration 1: 100%|██████████| 20/20 [00:03<00:00, 5.43it/s, episode=40, return=-391.392]

Iteration 2: 100%|██████████| 20/20 [00:03<00:00, 5.29it/s, episode=60, return=-216.078]

Iteration 3: 100%|██████████| 20/20 [00:03<00:00, 5.52it/s, episode=80, return=-438.220]

Iteration 4: 100%|██████████| 20/20 [00:03<00:00, 5.42it/s, episode=100, return=-162.128]

Iteration 5: 100%|██████████| 20/20 [00:03<00:00, 5.50it/s, episode=120, return=-389.088]

Iteration 6: 100%|██████████| 20/20 [00:03<00:00, 5.44it/s, episode=140, return=-273.700]

Iteration 7: 100%|██████████| 20/20 [00:03<00:00, 5.23it/s, episode=160, return=-221.605]

Iteration 8: 100%|██████████| 20/20 [00:04<00:00, 4.91it/s, episode=180, return=-262.134]

Iteration 9: 100%|██████████| 20/20 [00:03<00:00, 5.34it/s, episode=200, return=-278.752]

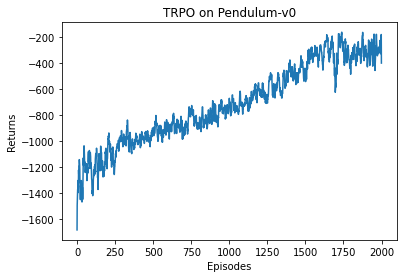

我们可以发现,与普通的 DQN 相比,Double DQN 比较少出现QQQ值大于 000 的情况,说明QQQ值过高估计的问题得到了很大缓解。

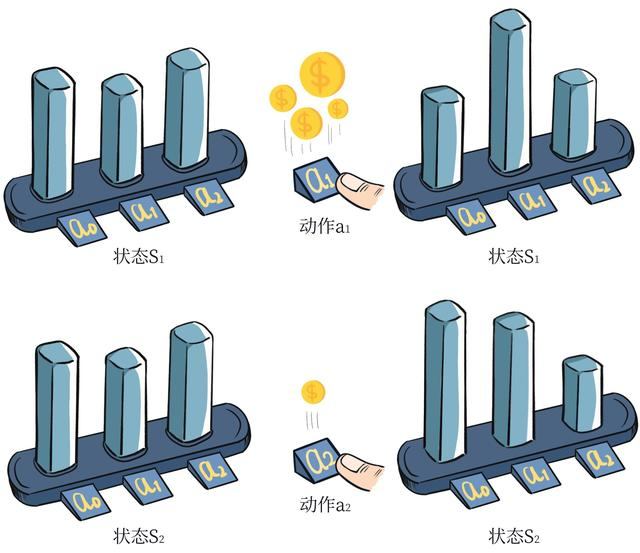

8.4 Dueling DQN

Dueling DQN 是 DQN 另一种的改进算法,它在传统 DQN 的基础上只进行了微小的改动,但却能大幅提升 DQN 的表现。在强化学习中,我们将状态动作价值函数QQQ减去状态价值函数VVV的结果定义为优势函数AAA,即A(s,a)=Q(s,a)−V(s)A(s,a) = Q(s,a) - V(s)A(s,a)=Q(s,a)−V(s)。在同一个状态下,所有动作的优势值之和为 000,因为所有动作的动作价值的期望就是这个状态的状态价值。据此,在 Dueling DQN 中,Q 网络被建模为:

Qη,α,β(s,a)=Vη,α(s)+Aη,β(s,a)Q_{\eta,\alpha,\beta}(s,a) = V_{\eta,\alpha}(s) + A_{\eta,\beta}(s,a) Qη,α,β(s,a)=Vη,α(s)+Aη,β(s,a)

其中,Vη,α(s)V_{\eta,\alpha}(s)Vη,α(s)为状态价值函数,而Aη,β(s,a)A_{\eta,\beta}(s,a)Aη,β(s,a)则为该状态下采取不同动作的优势函数,表示采取不同动作的差异性;η\etaη是状态价值函数和优势函数共享的网络参数,一般用在神经网络中,用来提取特征的前几层;而α\alphaα和β\betaβ分别为状态价值函数和优势函数的参数。在这样的模型下,我们不再让神经网络直接输出QQQ值,而是训练神经网络的最后几层的两个分支,分别输出状态价值函数和优势函数,再求和得到QQQ值。Dueling DQN 的网络结构如图 8-2 所示。

图8-2 Dueling DQN的网络结构图

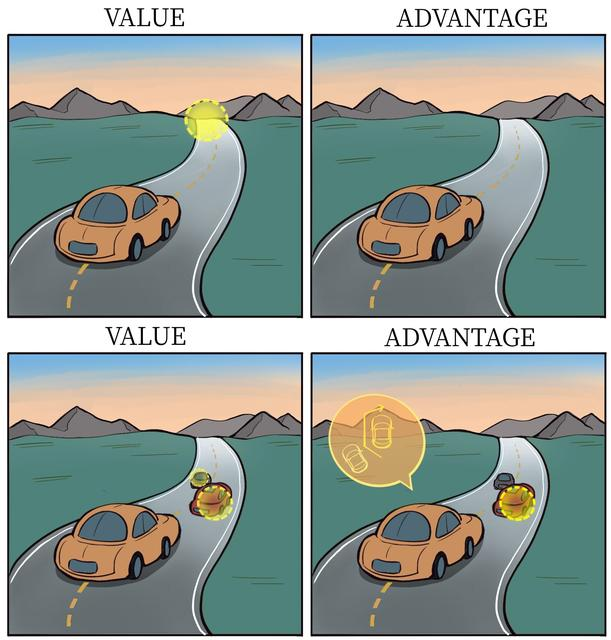

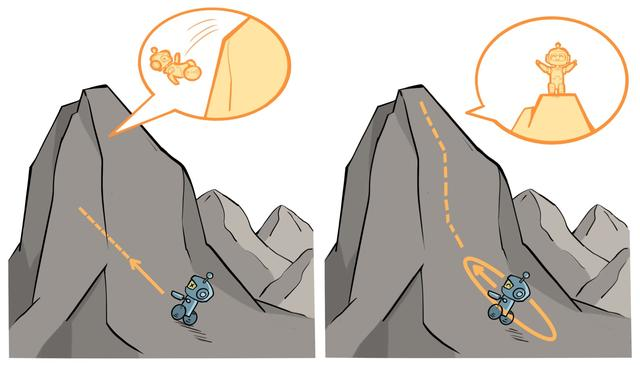

将状态价值函数和优势函数分别建模的好处在于:某些情境下智能体只会关注状态的价值,而并不关心不同动作导致的差异,此时将二者分开建模能够使智能体更好地处理与动作关联较小的状态。在图 8-3 所示的驾驶车辆游戏中,智能体注意力集中的部位被显示为橙色(另见彩插图 4),当智能体前面没有车时,车辆自身动作并没有太大差异,此时智能体更关注状态价值,而当智能体前面有车时(智能体需要超车),智能体开始关注不同动作优势值的差异。

图8-3 状态价值和优势值的简单例子

对于 Dueling DQN 中的公式Qη,α,β(s,a)=Vη,α(s)+Aη,β(s,a)Q_{\eta,\alpha,\beta}(s,a) = V_{\eta,\alpha}(s) + A_{\eta,\beta}(s,a)Qη,α,β(s,a)=Vη,α(s)+Aη,β(s,a),它存在对于VVV值和AAA值建模不唯一性的问题。例如,对于同样的QQQ值,如果将VVV值加上任意大小的常数CCC,再将所有AAA值减去CCC,则得到的QQQ值依然不变,这就导致了训练的不稳定性。为了解决这一问题,Dueling DQN 强制最优动作的优势函数的实际输出为 000,即:

Qη,α,β(s,a)=Vη,α(s)+Aη,β(s,a)−maxa′Aη,β(s,a′)Q_{\eta,\alpha,\beta}(s,a) = V_{\eta,\alpha}(s) + A_{\eta,\beta}(s,a) - \max_{a'} A_{\eta,\beta}(s,a') Qη,α,β(s,a)=Vη,α(s)+Aη,β(s,a)−a′maxAη,β(s,a′)

此时V(s)=maxaQ(s,a)V(s)=\max\limits_aQ(s,a)V(s)=amaxQ(s,a),可以确保VVV值建模的唯一性。在实现过程中,我们还可以用平均代替最大化操作,即:

Qη,α,β(s,a)=Vη,α(s)+Aη,β(s,a)−1A∑a′Aη,β(s,a′)Q_{\eta,\alpha,\beta}(s,a) = V_{\eta,\alpha}(s) + A_{\eta,\beta}(s,a) - \dfrac{1}{\mathcal{A}} \sum_{a'} A_{\eta,\beta}(s,a') Qη,α,β(s,a)=Vη,α(s)+Aη,β(s,a)−A1a′∑Aη,β(s,a′)

此时V(s)=1A∑a′Q(s,a′)V(s)=\dfrac{1}{\mathcal{A}} \sum\limits_{a'} Q(s,a')V(s)=A1a′∑Q(s,a′)。在下面的代码实现中,我们将采取此种方式,虽然它不再满足贝尔曼最优方程,但实际应用时更加稳定。

有的读者可能会问:“为什么 Dueling DQN 会比 DQN 好?”部分原因在于 Dueling DQN 能更高效学习状态价值函数。每一次更新时,函数VVV都会被更新,这也会影响到其他动作的QQQ值。而传统的 DQN 只会更新某个动作的QQQ值,其他动作的QQQ值就不会更新。因此,Dueling DQN 能够更加频繁、准确地学习状态价值函数。

8.5 Dueling DQN 代码实践

Dueling DQN 与 DQN 相比的差异只是在网络结构上,大部分代码依然可以继续沿用。我们定义状态价值函数和优势函数的复合神经网络VAnet。

class VAnet(torch.nn.Module):

''' 只有一层隐藏层的A网络和V网络 '''

def __init__(self, state_dim, hidden_dim, action_dim):

super(VAnet, self).__init__()

self.fc1 = torch.nn.Linear(state_dim, hidden_dim) # 共享网络部分

self.fc_A = torch.nn.Linear(hidden_dim, action_dim)

self.fc_V = torch.nn.Linear(hidden_dim, 1)

def forward(self, x):

A = self.fc_A(F.relu(self.fc1(x)))

V = self.fc_V(F.relu(self.fc1(x)))

Q = V + A - A.mean(1).view(-1, 1) # Q值由V值和A值计算得到

return Q

class DQN:

''' DQN算法,包括Double DQN和Dueling DQN '''

def __init__(self,

state_dim,

hidden_dim,

action_dim,

learning_rate,

gamma,

epsilon,

target_update,

device,

dqn_type='VanillaDQN'):

self.action_dim = action_dim

if dqn_type == 'DuelingDQN': # Dueling DQN采取不一样的网络框架

self.q_net = VAnet(state_dim, hidden_dim,

self.action_dim).to(device)

self.target_q_net = VAnet(state_dim, hidden_dim,

self.action_dim).to(device)

else:

self.q_net = Qnet(state_dim, hidden_dim,

self.action_dim).to(device)

self.target_q_net = Qnet(state_dim, hidden_dim,

self.action_dim).to(device)

self.optimizer = torch.optim.Adam(self.q_net.parameters(),

lr=learning_rate)

self.gamma = gamma

self.epsilon = epsilon

self.target_update = target_update

self.count = 0

self.dqn_type = dqn_type

self.device = device

def take_action(self, state):

if np.random.random() < self.epsilon:

action = np.random.randint(self.action_dim)

else:

state = torch.tensor([state], dtype=torch.float).to(self.device)

action = self.q_net(state).argmax().item()

return action

def max_q_value(self, state):

state = torch.tensor([state], dtype=torch.float).to(self.device)

return self.q_net(state).max().item()

def update(self, transition_dict):

states = torch.tensor(transition_dict['states'],

dtype=torch.float).to(self.device)

actions = torch.tensor(transition_dict['actions']).view(-1, 1).to(

self.device)

rewards = torch.tensor(transition_dict['rewards'],

dtype=torch.float).view(-1, 1).to(self.device)

next_states = torch.tensor(transition_dict['next_states'],

dtype=torch.float).to(self.device)

dones = torch.tensor(transition_dict['dones'],

dtype=torch.float).view(-1, 1).to(self.device)

q_values = self.q_net(states).gather(1, actions)

if self.dqn_type == 'DoubleDQN':

max_action = self.q_net(next_states).max(1)[1].view(-1, 1)

max_next_q_values = self.target_q_net(next_states).gather(

1, max_action)

else:

max_next_q_values = self.target_q_net(next_states).max(1)[0].view(

-1, 1)

q_targets = rewards + self.gamma * max_next_q_values * (1 - dones)

dqn_loss = torch.mean(F.mse_loss(q_values, q_targets))

self.optimizer.zero_grad()

dqn_loss.backward()

self.optimizer.step()

if self.count % self.target_update == 0:

self.target_q_net.load_state_dict(self.q_net.state_dict())

self.count += 1

random.seed(0)

np.random.seed(0)

env.seed(0)

torch.manual_seed(0)

replay_buffer = rl_utils.ReplayBuffer(buffer_size)

agent = DQN(state_dim, hidden_dim, action_dim, lr, gamma, epsilon,

target_update, device, 'DuelingDQN')

return_list, max_q_value_list = train_DQN(agent, env, num_episodes,

replay_buffer, minimal_size,

batch_size)

episodes_list = list(range(len(return_list)))

mv_return = rl_utils.moving_average(return_list, 5)

plt.plot(episodes_list, mv_return)

plt.xlabel('Episodes')

plt.ylabel('Returns')

plt.title('Dueling DQN on {}'.format(env_name))

plt.show()

frames_list = list(range(len(max_q_value_list)))

plt.plot(frames_list, max_q_value_list)

plt.axhline(0, c='orange', ls='--')

plt.axhline(10, c='red', ls='--')

plt.xlabel('Frames')

plt.ylabel('Q value')

plt.title('Dueling DQN on {}'.format(env_name))

plt.show()

Iteration 0: 100%|███████████████████████████████████████| 20/20 [00:10<00:00, 1.87it/s, episode=20, return=-708.652]

Iteration 1: 100%|███████████████████████████████████████| 20/20 [00:15<00:00, 1.28it/s, episode=40, return=-229.557]

Iteration 2: 100%|███████████████████████████████████████| 20/20 [00:15<00:00, 1.32it/s, episode=60, return=-184.607]

Iteration 3: 100%|███████████████████████████████████████| 20/20 [00:13<00:00, 1.50it/s, episode=80, return=-200.323]

Iteration 4: 100%|███████████████████████████████████████| 20/20 [00:13<00:00, 1.51it/s, episode=100, return=-213.811]

Iteration 5: 100%|███████████████████████████████████████| 20/20 [00:13<00:00, 1.53it/s, episode=120, return=-181.165]

Iteration 6: 100%|███████████████████████████████████████| 20/20 [00:14<00:00, 1.35it/s, episode=140, return=-222.040]

Iteration 7: 100%|███████████████████████████████████████| 20/20 [00:14<00:00, 1.35it/s, episode=160, return=-173.313]

Iteration 8: 100%|███████████████████████████████████████| 20/20 [00:12<00:00, 1.62it/s, episode=180, return=-236.372]

Iteration 9: 100%|███████████████████████████████████████| 20/20 [00:12<00:00, 1.57it/s, episode=200, return=-230.058]

根据代码运行结果我们可以发现,相比于传统的 DQN,Dueling DQN 在多个动作选择下的学习更加稳定,得到的回报最大值也更大。由 Dueling DQN 的原理可知,随着动作空间的增大,Dueling DQN 相比于 DQN 的优势更为明显。之前我们在环境中设置的离散动作数为 11,我们可以增加离散动作数(例如 15、25 等),继续进行对比实验。

8.6 总结

在传统的 DQN 基础上,有两种非常容易实现的变式——Double DQN 和 Dueling DQN,Double DQN 解决了 DQN 中对QQQ值的过高估计,而 Dueling DQN 能够很好地学习到不同动作的差异性,在动作空间较大的环境下非常有效。从 Double DQN 和 Dueling DQN 的方法原理中,我们也能感受到深度强化学习的研究是在关注深度学习和强化学习有效结合:一是在深度学习的模块的基础上,强化学习方法如何更加有效地工作,并避免深度模型学习行为带来的一些问题,例如使用 Double DQN 解决QQQ值过高估计的问题;二是在强化学习的场景下,深度学习模型如何有效学习到有用的模式,例如设计 Dueling DQN 网络架构来高效地学习状态价值函数以及动作优势函数。

8.7 扩展阅读: 对 Q 值过高估计的定量分析

我们可以对QQQ值的过高估计做简化的定量分析。假设在状态sss下所有动作的期望回报均无差异,即Q∗(s,a)=V∗(s)Q^{*}(s,a)=V^{*}(s)Q∗(s,a)=V∗(s)(此设置是为了定量分析所简化的情形,实际上不同动作的期望回报通常会存在差异);假设神经网络估算误差Qω−(s,a)−V∗Q_{\omega^{-}}(s,a) - V^*Qω−(s,a)−V∗服从[−1,1][-1,1][−1,1]之间的均匀独立同分布;假设动作空间大小为mmm。那么,对于任意状态sss,有:

E[maxaQω−(s,a)−maxa′Q∗(s,a′)]=m−1m+1\mathbb{E} \Big[ \max_a Q_{\omega^{-}}(s,a) - \max_{a'}Q_{*}(s,a') \Big] = \dfrac{m-1}{m+1} E[amaxQω−(s,a)−a′maxQ∗(s,a′)]=m+1m−1

即动作空间mmm越大时,QQQ值过高,估计越严重。

证明:将估算误差记为ϵa=Qω−(s,a)−maxa′Q∗(s,a′)\epsilon_a = Q_{\omega^{-}}(s,a) - \max\limits_{a'}Q^{*}(s,a')ϵa=Qω−(s,a)−a′maxQ∗(s,a′),由于估算误差对于不同的动作是独立的,因此有:

P(maxaϵa≤x)=∏a=1mP(ϵa≤x)P(\max_{a} \epsilon_a \le x) = \prod_{a=1}^m P(\epsilon_a \le x) P(amaxϵa≤x)=a=1∏mP(ϵa≤x)

P(ϵa≤x)P(\epsilon_a \le x)P(ϵa≤x)是的累积分布函数(cumulative distribution function,即 CDF),它可以具体被写为:

P(ϵa≤x)={0if x≤−1x+12if x∈(−1,1)1if x≥1P(\epsilon_a \le x) = \begin{cases} 0 & \text{if } x \le -1 \\ \dfrac{x+1}{2} & \text{if } x \in (-1,1)\\ 1 & \text{if } x \ge 1 \end{cases} P(ϵa≤x)=⎩⎨⎧02x+11if x≤−1if x∈(−1,1)if x≥1

因此,我们得到关于maxaϵa\max\limits_{a} \epsilon_aamaxϵa的累积分布函数:

P(maxaϵa≤x)=∏a=1mP(ϵa≤x)={0if x≤−1(x+12)mif x∈(−1,1)1if x≥1\begin{aligned} P(\max_{a} \epsilon_a \le x) &= \prod_{a=1}^m P(\epsilon_a \le x)\\ &= \begin{cases} 0 & \text{if } x \le -1 \\ (\dfrac{x+1}{2})^m & \text{if } x \in (-1,1)\\ 1 & \text{if } x \ge 1 \end{cases} \end{aligned} P(amaxϵa≤x)=a=1∏mP(ϵa≤x)=⎩⎨⎧0(2x+1)m1if x≤−1if x∈(−1,1)if x≥1

最后我们可以得到:

E[maxaϵa]=∫−11xddxP(maxaϵa≤x)dx=[(x+12)mmx−1m+1]∣−11=m−1m+1\begin{aligned} \mathbb{E} \Big[\max_a\epsilon_a\Big] &= \int_{-1}^1 x \dfrac{\mathbf {d}}{\mathbf{d}x} P(\max_{a} \epsilon_a \le x) \mathbf{d}x\\ &= \Big[ \Big(\dfrac{x+1}{2}\Big)^m \dfrac{mx - 1}{m+1} \Big]\bigg|_{-1}^1\\ &= \dfrac{m-1}{m+1} \end{aligned} E[amaxϵa]=∫−11xdxdP(amaxϵa≤x)dx=[(2x+1)mm+1mx−1]−11=m+1m−1

虽然这一分析简化了实际环境,但它仍然正确刻画了QQQ值过高估计的一些性质,比如QQQ值的过高估计随动作空间大小mmm的增加而增加,换言之,在动作选择数更多的环境中,QQQ值的过高估计会更严重。

8.8 参考文献

[1] HASSELT V H, GUEZ A, SILVER D. Deep reinforcement learning with double q-learning [C]// Proceedings of the AAAI conference on artificial intelligence. 2016, 30(1).

[2] WANG Z, SCHAUL T, HESSEL M, et al. Dueling network architectures for deep reinforcement learning [C]// International conference on machine learning, PMLR, 2016: 1995-2003.

[3] HESSEL M, MODAYIL J, HASSELT V H, et al. Rainbow: Combining improvements in deep reinforcement learning [C]// Thirty-second AAAI conference on artificial intelligence, 2018.

9 策略梯度算法

9.1 简介

本书之前介绍的 Q-learning、DQN 及 DQN 改进算法都是基于价值(value-based)的方法,其中 Q-learning 是处理有限状态的算法,而 DQN 可以用来解决连续状态的问题。在强化学习中,除了基于值函数的方法,还有一支非常经典的方法,那就是基于策略(policy-based)的方法。对比两者,基于值函数的方法主要是学习值函数,然后根据值函数导出一个策略,学习过程中并不存在一个显式的策略;而基于策略的方法则是直接显式地学习一个目标策略。策略梯度是基于策略的方法的基础,本章从策略梯度算法说起。

9.2 策略梯度

基于策略的方法首先需要将策略参数化。假设目标策略πθ\pi_\thetaπθ是一个随机性策略,并且处处可微,其中θ\thetaθ是对应的参数。我们可以用一个线性模型或者神经网络模型来为这样一个策略函数建模,输入某个状态,然后输出一个动作的概率分布。我们的目标是要寻找一个最优策略并最大化这个策略在环境中的期望回报。我们将策略学习的目标函数定义为

J(θ)=Es0[Vπθ(s0)]J(\theta) = \mathbb{E}_{s_0}\Big[{V^{\pi_\theta}(s_0)}\Big] J(θ)=Es0[Vπθ(s0)]

其中,s0s_0s0表示初始状态。现在有了目标函数J(θ)J(\theta)J(θ),我们将目标函数对策略θ\thetaθ求导,得到导数后,就可以用梯度上升方法来最大化这个目标函数,从而得到最优策略。

我第 3 章讲解过策略π\piπ下的状态访问分布,在此用νπ\nu^{\pi}νπ表示。然后我们对目标函数J(θ)J(\theta)J(θ)求梯度,可以得到如下式子,更详细的推导过程将在 9.6 节给出。

∇θJ(θ)∝∑s∈Sνπθ(s)∑a∈AQπθ(s,a)∇θπθ(a∣s)=∑s∈Sνπθ(s)∑a∈AQπθ(s,a)πθ(a∣s)⋅∇θπθ(a∣s)πθ(a∣s)=∑s∈Sνπθ(s)(∑a∈Aπθ(a∣s)Qπθ(s,a)⋅∇θπθ(a∣s)πθ(a∣s))=∑s∈Sνπθ(s)(∑a∈Aπθ(a∣s)Qπθ(s,a)⋅∇θlogπθ(a∣s))=Eπθ[Qπθ(s,a)∇θlogπθ(a∣s)]\begin{aligned} \nabla_\theta J(\theta) &\propto \sum_{s\in\mathcal{S}} \nu^{\pi_{\theta}}(s) \sum_{a\in\mathcal{A}}Q^{\pi_{\theta}}(s,a)\nabla_{\theta}\pi_{\theta}(a|s) \\ &= \sum_{s\in\mathcal{S}} \nu^{\pi_{\theta}}(s) \sum_{a\in\mathcal{A}}Q^{\pi_{\theta}}(s,a) \pi_{\theta}(a|s) \cdot \dfrac{\nabla_{\theta}\pi_{\theta}(a|s)}{\pi_{\theta}(a|s)} \\ &= \sum_{s\in\mathcal{S}} \nu^{\pi_{\theta}}(s) \Big( \sum_{a\in\mathcal{A}} \pi_{\theta}(a|s) Q^{\pi_{\theta}}(s,a) \cdot \dfrac{\nabla_{\theta}\pi_{\theta}(a|s)}{\pi_{\theta}(a|s)} \Big) \\ &= \sum_{s\in\mathcal{S}} \nu^{\pi_{\theta}}(s) \Big( \sum_{a\in\mathcal{A}} \pi_{\theta}(a|s) Q^{\pi_{\theta}}(s,a) \cdot \nabla_{\theta}\log \pi_{\theta}(a|s) \Big) \\ &= \mathbb{E}_{\pi_{\theta}} \Big[Q^{\pi_{\theta}}(s,a) \nabla_{\theta}\log \pi_{\theta}(a|s)\Big] \\ \end{aligned} ∇θJ(θ)∝s∈S∑νπθ(s)a∈A∑Qπθ(s,a)∇θπθ(a∣s)=s∈S∑νπθ(s)a∈A∑Qπθ(s,a)πθ(a∣s)⋅πθ(a∣s)∇θπθ(a∣s)=s∈S∑νπθ(s)(a∈A∑πθ(a∣s)Qπθ(s,a)⋅πθ(a∣s)∇θπθ(a∣s))=s∈S∑νπθ(s)(a∈A∑πθ(a∣s)Qπθ(s,a)⋅∇θlogπθ(a∣s))=Eπθ[Qπθ(s,a)∇θlogπθ(a∣s)]

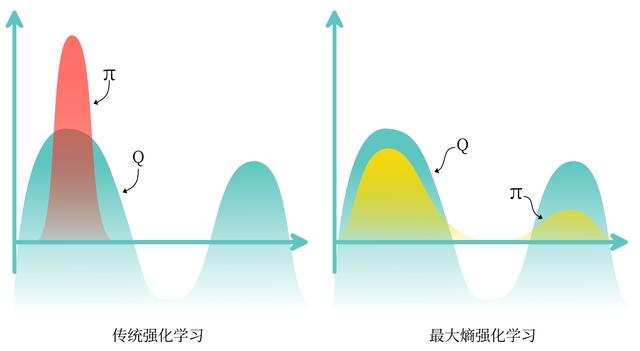

这个梯度可以用来更新策略。需要注意的是,因为上式中期望E\mathbb{E}E的下标是πθ\pi_\thetaπθ,所以策略梯度算法为在线策略(on-policy)算法,即必须使用当前策略πθ\pi_\thetaπθ采样得到的数据来计算梯度。直观理解一下策略梯度这个公式,可以发现在每一个状态下,梯度的修改是让策略更多地去采样到带来较高QQQ值的动作,更少地去采样到带来较低QQQ值的动作,如图 9-1 所示。

图9-1 策略梯度示意图

在计算策略梯度的公式中,我们需要用到Qπθ(s,a)Q^{\pi_{\theta}}(s,a)Qπθ(s,a),可以用多种方式对它进行估计。接下来要介绍的 REINFORCE 算法便是采用了蒙特卡洛方法来估计Qπθ(s,a)Q^{\pi_{\theta}}(s,a)Qπθ(s,a),对于一个有限步数的环境来说,REINFORCE 算法中的策略梯度为:

∇θJ(θ)=Eπθ[∑t=0T(∑t′=tTγt′−trt′)∇θlogπθ(at∣st)]\nabla_\theta J(\theta) = \mathbb{E}_{\pi_\theta} \bigg[ \sum_{t=0}^T \Big( \sum_{t'=t}^T \gamma^{t'-t}r_{t'} \Big) \nabla_{\theta} \log \pi_{\theta}(a_t|s_t) \bigg] ∇θJ(θ)=Eπθ[t=0∑T(t′=t∑Tγt′−trt′)∇θlogπθ(at∣st)]

其中,TTT是和环境交互的最大步数。例如,在车杆环境中,T=200T=200T=200。

9.3 REINFORCE

REINFORCE 算法的具体算法流程如下:

- 初始化策略参数θ\thetaθ

- for 序列e=1→Ee=1\rightarrow Ee=1→E do :

- 用当前策略πθ\pi_\thetaπθ采样轨迹{s1,a1,r1,s2,a2,r2,⋯ ,sT,aT,rT}\{s_1,a_1,r_1,s_2,a_2,r_2,\cdots,s_T,a_T,r_T\}{s1,a1,r1,s2,a2,r2,⋯,sT,aT,rT}

- 计算当前轨迹每个时刻ttt往后的回报∑t′=tTγt′−trt′\displaystyle\sum_{t'=t}^T \gamma^{t'-t}r_{t'}t′=t∑Tγt′−trt′,记为ψt\psi_tψt

- 对θ\thetaθ进行更新,θ←θ+α∑t′=tTψtlogπθ(at∣st)\displaystyle\theta \leftarrow \theta + \alpha \sum_{t'=t}^{T}\psi_t\log\pi_\theta(a_t|s_t)θ←θ+αt′=t∑Tψtlogπθ(at∣st)

- end for

这便是 REINFORCE 算法的全部流程了。接下来让我们来用代码来实现它,看看效果如何吧!

9.4 REINFORCE 代码实践

我们在车杆环境中进行 REINFORCE 算法的实验。

import gym

import torch

import torch.nn.functional as F

import numpy as np

import matplotlib.pyplot as plt

from tqdm import tqdm

import rl_utils

首先定义策略网络PolicyNet,其输入是某个状态,输出则是该状态下的动作概率分布,这里采用在离散动作空间上的softmax()函数来实现一个可学习的多项分布(multinomial distribution)。

class PolicyNet(torch.nn.Module):

def __init__(self, state_dim, hidden_dim, action_dim):

super(PolicyNet, self).__init__()

self.fc1 = torch.nn.Linear(state_dim, hidden_dim)

self.fc2 = torch.nn.Linear(hidden_dim, action_dim)

def forward(self, x):

x = F.relu(self.fc1(x))

return F.softmax(self.fc2(x), dim=1)

再定义我们的 REINFORCE 算法。在函数take_action()函数中,我们通过动作概率分布对离散的动作进行采样。在更新过程中,我们按照算法将损失函数写为策略回报的负数,即−∑tψt∇θlogπθ(at∣st)\displaystyle-\sum\limits_t\psi_t\nabla_\theta \log\pi_\theta(a_t|s_t)−t∑ψt∇θlogπθ(at∣st),对求导后就可以通过梯度下降来更新策略。

class REINFORCE:

def __init__(

self,

state_dim,

hidden_dim,

action_dim,

learning_rate,

gamma,

device

):

self.policy_net = PolicyNet(state_dim, hidden_dim, action_dim).to(device)

self.optimizer = torch.optim.Adam(self.policy_net.parameters(), lr=learning_rate) # 使用Adam优化器

self.gamma = gamma # 折扣因子

self.device = device

def take_action(self, state): # 根据动作概率分布随机采样

state = torch.tensor([state], dtype=torch.float).to(self.device)

probs = self.policy_net(state)

action_dist = torch.distributions.Categorical(probs)

action = action_dist.sample()

return action.item()

def update(self, transition_dict):

reward_list = transition_dict['rewards']

state_list = transition_dict['states']

action_list = transition_dict['actions']

G = 0

self.optimizer.zero_grad()

for i in reversed(range(len(reward_list))): # 从最后一步算起

reward = reward_list[i]

state = torch.tensor([state_list[i]], dtype=torch.float).to(self.device)

action = torch.tensor([action_list[i]]).view(-1, 1).to(self.device)

log_prob = torch.log(self.policy_net(state).gather(1, action))

G = self.gamma * G + reward

loss = -log_prob * G # 每一步的损失函数

loss.backward() # 反向传播计算梯度

self.optimizer.step() # 梯度下降

定义好策略,我们就可以开始实验了,看看 REINFORCE 算法在车杆环境上表现如何吧!

learning_rate = 1e-3

num_episodes = 1000

hidden_dim = 128

gamma = 0.98

device = torch.device("cuda") if torch.cuda.is_available() else torch.device("cpu")

env_name = "CartPole-v0"

env = gym.make(env_name)

env.seed(0)

torch.manual_seed(0)

state_dim = env.observation_space.shape[0]

action_dim = env.action_space.n

agent = REINFORCE(

state_dim,

hidden_dim,

action_dim,

learning_rate,

gamma,

device

)

return_list = []

for i in range(10):

with tqdm(total=int(num_episodes / 10), desc='Iteration %d' % i) as pbar:

for i_episode in range(int(num_episodes / 10)):

episode_return = 0

transition_dict = {

'states': [],

'actions': [],

'next_states': [],

'rewards': [],

'dones': []

}

state = env.reset()

done = False

while not done:

action = agent.take_action(state)

next_state, reward, done, _ = env.step(action)

transition_dict['states'].append(state)

transition_dict['actions'].append(action)

transition_dict['next_states'].append(next_state)

transition_dict['rewards'].append(reward)

transition_dict['dones'].append(done)

state = next_state

episode_return += reward

return_list.append(episode_return)

agent.update(transition_dict)

if (i_episode + 1) % 10 == 0:

pbar.set_postfix({

'episode':

'%d' % (num_episodes / 10 * i + i_episode + 1),

'return':

'%.3f' % np.mean(return_list[-10:])

})

pbar.update(1)

Iteration 0: 100%|██████████████████████████████████████| 100/100 [00:02<00:00, 47.36it/s, episode=100, return=55.500]

Iteration 1: 100%|██████████████████████████████████████| 100/100 [00:04<00:00, 21.26it/s, episode=200, return=75.300]

Iteration 2: 100%|██████████████████████████████████████| 100/100 [00:09<00:00, 10.55it/s, episode=300, return=178.800]

Iteration 3: 100%|██████████████████████████████████████| 100/100 [00:11<00:00, 8.74it/s, episode=400, return=164.600]

Iteration 4: 100%|██████████████████████████████████████| 100/100 [00:11<00:00, 8.74it/s, episode=500, return=156.500]

Iteration 5: 100%|██████████████████████████████████████| 100/100 [00:11<00:00, 8.54it/s, episode=600, return=187.400]

Iteration 6: 100%|██████████████████████████████████████| 100/100 [00:11<00:00, 8.52it/s, episode=700, return=194.500]

Iteration 7: 100%|██████████████████████████████████████| 100/100 [00:13<00:00, 7.57it/s, episode=800, return=200.000]

Iteration 8: 100%|██████████████████████████████████████| 100/100 [00:12<00:00, 7.84it/s, episode=900, return=200.000]

Iteration 9: 100%|██████████████████████████████████████| 100/100 [00:12<00:00, 7.89it/s, episode=1000, return=186.100]

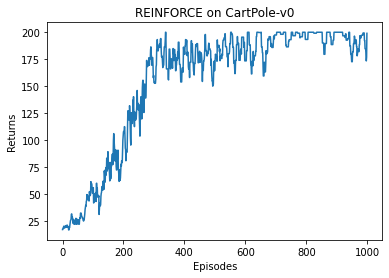

在 CartPole-v0 环境中,满分就是 200 分,我们发现 REINFORCE 算法效果很好,可以达到 200 分。接下来我们绘制训练过程中每一条轨迹的回报变化图。由于回报抖动比较大,往往会进行平滑处理。

episodes_list = list(range(len(return_list)))

plt.plot(episodes_list, return_list)

plt.xlabel('Episodes')

plt.ylabel('Returns')

plt.title('REINFORCE on {}'.format(env_name))

plt.show()

mv_return = rl_utils.moving_average(return_list, 9)

plt.plot(episodes_list, mv_return)

plt.xlabel('Episodes')

plt.ylabel('Returns')

plt.title('REINFORCE on {}'.format(env_name))

plt.show()

可以看到,随着收集到的轨迹越来越多,REINFORCE 算法有效地学习到了最优策略。不过,相比于前面的 DQN 算法,REINFORCE 算法使用了更多的序列,这是因为 REINFORCE 算法是一个在线策略算法,之前收集到的轨迹数据不会被再次利用。此外,REINFORCE 算法的性能也有一定程度的波动,这主要是因为每条采样轨迹的回报值波动比较大,这也是 REINFORCE 算法主要的不足。

9.5 小结

REINFORCE 算法是策略梯度乃至强化学习的典型代表,智能体根据当前策略直接和环境交互,通过采样得到的轨迹数据直接计算出策略参数的梯度,进而更新当前策略,使其向最大化策略期望回报的目标靠近。这种学习方式是典型的从交互中学习,并且其优化的目标(即策略期望回报)正是最终所使用策略的性能,这比基于价值的强化学习算法的优化目标(一般是时序差分误差的最小化)要更加直接。 REINFORCE 算法理论上是能保证局部最优的,它实际上是借助蒙特卡洛方法采样轨迹来估计动作价值,这种做法的一大优点是可以得到无偏的梯度。但是,正是因为使用了蒙特卡洛方法,REINFORCE 算法的梯度估计的方差很大,可能会造成一定程度上的不稳定,这也是第 10 章将介绍的 Actor-Critic 算法要解决的问题。

9.6 扩展阅读:策略梯度证明

策略梯度定理是强化学习中的重要理论。本节我们来证明

∇θJ(θ)∝∑s∈Sνπθ(s)∑a∈AQπθ(s,a)∇θπθ(a∣s)\nabla_\theta J(\theta) \propto \sum_{s\in\mathcal{S}} \nu^{\pi_\theta}(s) \sum_{a\in\mathcal{A}} Q^{\pi_\theta}(s,a)\nabla_\theta \pi_\theta(a|s) ∇θJ(θ)∝s∈S∑νπθ(s)a∈A∑Qπθ(s,a)∇θπθ(a∣s)

先从状态价值函数的推导开始:

∇θVπθ(s)=∇θ(∑a∈Aπθ(a∣s)Qπθ(s,a))=∑a∈A(Qπθ(s,a)∇θπθ(a∣s)+πθ(a∣s)∇θQπθ(s,a))=∑a∈A(Qπθ(s,a)∇θπθ(a∣s))+∑a∈A(πθ(a∣s)∇θQπθ(s,a))=∑a∈A(Qπθ(s,a)∇θπθ(a∣s))+∑a∈Aπθ(a∣s)∇θ(∑s′,rp(s′,r∣s,a)(r+γVπθ(s′)))=∑a∈A(Qπθ(s,a)∇θπθ(a∣s))+∑a∈Aπθ(a∣s)(∑s′,rp(s′,r∣s,a)∇θ(r+γVπθ(s′)))=∑a∈A(Qπθ(s,a)∇θπθ(a∣s))+∑a∈Aπθ(a∣s)(∑s′,rp(s′,r∣s,a)∇θ(γVπθ(s′)))=∑a∈A(Qπθ(s,a)∇θπθ(a∣s))+γ∑a∈Aπθ(a∣s)(∑s′p(s′∣s,a)∇θVπθ(s′))\begin{aligned} \nabla_\theta V^{\pi_\theta}(s) &= \nabla_\theta \Big( \sum_{a\in\mathcal{A}}\pi_\theta (a|s) Q^{\pi_\theta}(s,a) \Big)\\ &= \sum_{a\in\mathcal{A}} \Big( Q^{\pi_\theta}(s,a) \nabla_\theta\pi_\theta (a|s) + \pi_\theta (a|s) \nabla_\theta Q^{\pi_\theta}(s,a) \Big)\\ &= \sum_{a\in\mathcal{A}} \Big( Q^{\pi_\theta}(s,a) \nabla_\theta\pi_\theta (a|s) \Big) + \sum_{a\in\mathcal{A}} \Big( \pi_\theta (a|s) \nabla_\theta Q^{\pi_\theta}(s,a)\Big) \\ &= \sum_{a\in\mathcal{A}} \Big( Q^{\pi_\theta}(s,a) \nabla_\theta\pi_\theta (a|s) \Big) + \sum_{a\in\mathcal{A}} \pi_\theta (a|s) \nabla_\theta \bigg( \sum_{s',r} p(s',r|s,a)\Big(r+\gamma V^{\pi_\theta}(s')\Big) \bigg) \\ &= \sum_{a\in\mathcal{A}} \Big( Q^{\pi_\theta}(s,a) \nabla_\theta\pi_\theta (a|s) \Big) + \sum_{a\in\mathcal{A}} \pi_\theta (a|s) \bigg( \sum_{s',r} p(s',r|s,a) \nabla_\theta \Big(r+\gamma V^{\pi_\theta}(s')\Big) \bigg) \\ &= \sum_{a\in\mathcal{A}} \Big( Q^{\pi_\theta}(s,a) \nabla_\theta\pi_\theta (a|s) \Big) + \sum_{a\in\mathcal{A}} \pi_\theta (a|s) \bigg( \sum_{s',r} p(s',r|s,a) \nabla_\theta \Big(\gamma V^{\pi_\theta}(s')\Big) \bigg) \\ &= \sum_{a\in\mathcal{A}} \Big( Q^{\pi_\theta}(s,a) \nabla_\theta\pi_\theta (a|s) \Big) + \gamma \sum_{a\in\mathcal{A}} \pi_\theta (a|s) \Big( \sum_{s'} p(s'|s,a) \nabla_\theta V^{\pi_\theta}(s') \Big) \end{aligned} ∇θVπθ(s)=∇θ(a∈A∑πθ(a∣s)Qπθ(s,a))=a∈A∑(Qπθ(s,a)∇θπθ(a∣s)+πθ(a∣s)∇θQπθ(s,a))=a∈A∑(Qπθ(s,a)∇θπθ(a∣s))+a∈A∑(πθ(a∣s)∇θQπθ(s,a))=a∈A∑(Qπθ(s,a)∇θπθ(a∣s))+a∈A∑πθ(a∣s)∇θ(s′,r∑p(s′,r∣s,a)(r+γVπθ(s′)))=a∈A∑(Qπθ(s,a)∇θπθ(a∣s))+a∈A∑πθ(a∣s)(s′,r∑p(s′,r∣s,a)∇θ(r+γVπθ(s′)))=a∈A∑(Qπθ(s,a)∇θπθ(a∣s))+a∈A∑πθ(a∣s)(s′,r∑p(s′,r∣s,a)∇θ(γVπθ(s′)))=a∈A∑(Qπθ(s,a)∇θπθ(a∣s))+γa∈A∑πθ(a∣s)(s′∑p(s′∣s,a)∇θVπθ(s′))

为了简化表示,我们让ϕ(s)=∑a∈AQπθ(s,a)∇θπθ(a∣s)\displaystyle \phi(s) = \sum\limits_{a\in\mathcal{A}}Q^{\pi_\theta}(s,a) \nabla_\theta\pi_\theta (a|s)ϕ(s)=a∈A∑Qπθ(s,a)∇θπθ(a∣s), 定义dπθ(s→x,k)d^{\pi_\theta}(s\rightarrow x,k)dπθ(s→x,k)为策略π\piπ从状态sss出发kkk步后到达状态xxx的概率。我们继续推导:

∇θVπθ(s)=ϕ(s)+γ∑a∈Aπθ(a∣s)(∑s′p(s′∣s,a)∇θVπθ(s′))=ϕ(s)+γ∑a∈A∑s′πθ(a∣s)p(s′∣s,a)∇θVπθ(s′)=ϕ(s)+γ∑s′dπθ(s→s′,1)∇θVπθ(s′)(利用该递推式)=ϕ(s)+γ∑s′dπθ(s→s′,1)[ϕ(s′)+γ∑s′′dπθ(s′→s′′,1)∇θVπθ(s′′)]=ϕ(s)+γ∑s′dπθ(s→s′,1)ϕ(s′)+γ2∑s′′dπθ(s→s′′,2)∇θVπθ(s′′)=ϕ(s)+γ∑s′dπθ(s→s′,1)ϕ(s′)+γ2∑s′′dπθ(s→s′′,2)ϕ(s′′)+γ3∑s′′′dπθ(s→s′′′,3)∇θVπθ(s′′′)=⋯=∑s∈S∑k=0∞γkdπθ(s0→s,k)ϕ(x)\begin{aligned} \nabla_\theta V^{\pi_\theta}(s) &= \phi(s) + \gamma \sum_{a\in\mathcal{A}} \pi_\theta (a|s) \Big( \sum_{s'} p(s'|s,a) \nabla_\theta V^{\pi_\theta}(s') \Big)\\ &= \phi(s) + \gamma \sum_{a\in\mathcal{A}} \sum_{s'} \pi_\theta (a|s) p(s'|s,a) \nabla_\theta V^{\pi_\theta}(s')\\ &= \phi(s) + \gamma \sum_{s'} d^{\pi_\theta}(s\rightarrow s',1) \nabla_\theta V^{\pi_\theta}(s') \quad (\text{利用该递推式})\\ &= \phi(s) + \gamma \sum_{s'} d^{\pi_\theta}(s\rightarrow s',1) \Big[ \phi(s') + \gamma \sum_{s''} d^{\pi_\theta}(s'\rightarrow s'',1) \nabla_\theta V^{\pi_\theta}(s'') \Big]\\ &= \phi(s) + \gamma \sum_{s'} d^{\pi_\theta}(s\rightarrow s',1) \phi(s') + \gamma^2 \sum_{s''} d^{\pi_\theta}(s\rightarrow s'',2) \nabla_\theta V^{\pi_\theta}(s'')\\ &= \phi(s) + \gamma \sum_{s'} d^{\pi_\theta}(s\rightarrow s',1) \phi(s') + \gamma^2 \sum_{s''} d^{\pi_\theta}(s\rightarrow s'',2) \phi(s'') + \gamma^3 \sum_{s'''} d^{\pi_\theta}(s\rightarrow s''',3) \nabla_\theta V^{\pi_\theta}(s''')\\ &= \cdots\\ &= \sum_{s\in\mathcal{S}}\sum_{k=0}^\infin \gamma^kd^{\pi_\theta}(s_0\rightarrow s,k)\phi(x) \end{aligned} ∇θVπθ(s)=ϕ(s)+γa∈A∑πθ(a∣s)(s′∑p(s′∣s,a)∇θVπθ(s′))=ϕ(s)+γa∈A∑s′∑πθ(a∣s)p(s′∣s,a)∇θVπθ(s′)=ϕ(s)+γs′∑dπθ(s→s′,1)∇θVπθ(s′)(利用该递推式)=ϕ(s)+γs′∑dπθ(s→s′,1)[ϕ(s′)+γs′′∑dπθ(s′→s′′,1)∇θVπθ(s′′)]=ϕ(s)+γs′∑dπθ(s→s′,1)ϕ(s′)+γ2s′′∑dπθ(s→s′′,2)∇θVπθ(s′′)=ϕ(s)+γs′∑dπθ(s→s′,1)ϕ(s′)+γ2s′′∑dπθ(s→s′′,2)ϕ(s′′)+γ3s′′′∑dπθ(s→s′′′,3)∇θVπθ(s′′′)=⋯=s∈S∑k=0∑∞γkdπθ(s0→s,k)ϕ(x)

定义η(s)=Es0[∑k=0∞γkdπθ(s0→s,k)]\displaystyle \eta(s) = \mathbb{E}_{s_0}\Big[\sum_{k=0}^\infin \gamma^kd^{\pi_\theta}(s_0\rightarrow s,k)\Big]η(s)=Es0[k=0∑∞γkdπθ(s0→s,k)]。至此,回到目标函数:

∇θJ(θ)=∇θEs0[Vπθ(s0)]=∑s∈SEs0[∑k=0∞γkdπθ(s0→s,k)]ϕ(x)=∑s∈Sη(s)ϕ(x)=∑s∈Sη(s)⋅1⋅ϕ(x)=∑s∈Sη(s)⋅(∑s∈Sη(s)∑s∈Sη(s))⋅ϕ(x)∝(∑s∈Sη(s)∑s∈Sη(s))⋅ϕ(x)=(∑s∈Sη(s)∑s∈Sη(s))⋅(∑a∈AQπθ(s,a)∇θπθ(a∣s))=∑s∈Sνπθ(s)∑a∈AQπθ(s,a)∇θπθ(a∣s)\begin{aligned} \nabla_\theta J(\theta) &= \nabla_\theta \mathbb{E}_{s_0} \Big[ V^{\pi_\theta}(s_0) \Big] \\ &= \sum_{s\in\mathcal{S}} \mathbb{E}_{s_0} \bigg[\sum_{k=0}^\infin \gamma^kd^{\pi_\theta}(s_0\rightarrow s,k)\bigg]\phi(x) \\ &= \sum_{s\in\mathcal{S}} \eta(s)\phi(x) \\ &= \sum_{s\in\mathcal{S}} \eta(s) \cdot 1 \cdot \phi(x) \\ &= \sum_{s\in\mathcal{S}} \eta(s) \cdot \bigg(\sum_{s\in\mathcal{S}} \dfrac{\eta(s)}{\displaystyle \sum_{s\in\mathcal{S}} \eta(s)}\bigg) \cdot \phi(x) \\ &\propto \bigg(\sum_{s\in\mathcal{S}} \dfrac{\eta(s)}{\displaystyle \sum_{s\in\mathcal{S}} \eta(s)}\bigg) \cdot \phi(x) \\ &= \bigg(\sum_{s\in\mathcal{S}} \dfrac{\eta(s)}{\displaystyle \sum_{s\in\mathcal{S}} \eta(s)} \bigg) \cdot \bigg( \sum\limits_{a\in\mathcal{A}}Q^{\pi_\theta}(s,a) \nabla_\theta\pi_\theta (a|s)\bigg) \\ &= \sum_{s\in\mathcal{S}} \nu^{\pi_\theta}(s) \sum\limits_{a\in\mathcal{A}}Q^{\pi_\theta}(s,a) \nabla_\theta\pi_\theta (a|s) \\ \end{aligned} ∇θJ(θ)=∇θEs0[Vπθ(s0)]=s∈S∑Es0[k=0∑∞γkdπθ(s0→s,k)]ϕ(x)=s∈S∑η(s)ϕ(x)=s∈S∑η(s)⋅1⋅ϕ(x)=s∈S∑η(s)⋅(s∈S∑s∈S∑η(s)η(s))⋅ϕ(x)∝(s∈S∑s∈S∑η(s)η(s))⋅ϕ(x)=(s∈S∑s∈S∑η(s)η(s))⋅(a∈A∑Qπθ(s,a)∇θπθ(a∣s))=s∈S∑νπθ(s)a∈A∑Qπθ(s,a)∇θπθ(a∣s)

证明完毕!

9.7 参考文献

[1] SUTTON R S, MCALLESTER D A, SINGH S P, et al. Policy gradient methods for reinforcement learning with function approximation [C] // Advances in neural information processing systems, 2000: 1057-1063.

10 Actor-Critic 算法

10.1 简介

本书之前的章节讲解了基于值函数的方法(DQN)和基于策略的方法(REINFORCE),其中基于值函数的方法只学习一个价值函数,而基于策略的方法只学习一个策略函数。那么,一个很自然的问题是,有没有什么方法既学习价值函数,又学习策略函数呢?答案就是 Actor-Critic。Actor-Critic 是囊括一系列算法的整体架构,目前很多高效的前沿算法都属于 Actor-Critic 算法,本章接下来将会介绍一种最简单的 Actor-Critic 算法。需要明确的是,Actor-Critic 算法本质上是基于策略的算法,因为这一系列算法的目标都是优化一个带参数的策略,只是会额外学习价值函数,从而帮助策略函数更好地学习。

10.2 Actor-Critic

回顾一下,在 REINFORCE 算法中,目标函数的梯度中有一项轨迹回报,用于指导策略的更新。REINFOCE 算法用蒙特卡洛方法来估计Q(s,a)Q(s,a)Q(s,a),能不能考虑拟合一个值函数来指导策略进行学习呢?这正是 Actor-Critic 算法所做的。在策略梯度中,可以把梯度写成下面这个更加一般的形式:

g=E[∑t=0Tψt∇θlogπθ(at∣st)]g = \mathbb{E} \Big[ \sum_{t=0}^T \psi_t \nabla_\theta \log \pi_\theta (a_t|s_t) \Big] g=E[t=0∑Tψt∇θlogπθ(at∣st)]

其中,ψt\psi_tψt可以有很多种形式:

(1) ∑t′=0Tγt′rt′\displaystyle \sum_{t'=0}^T \gamma^{t'}r_{t'}t′=0∑Tγt′rt′:轨迹的总回报;

(2) ∑t′=tTγt′−trt′\displaystyle \sum_{t'=t}^T \gamma^{t' - t}r_{t'}t′=t∑Tγt′−trt′:动作ata_tat之后的回报;

(3) ∑t′=tTγt′−trt′−b(st)\displaystyle \sum_{t'=t}^T \gamma^{t'-t}r_{t'} - b(s_t)t′=t∑Tγt′−trt′−b(st):基准线版本的改进;

(4) Qπθ(st,at)Q^{\pi_\theta}(s_t,a_t)Qπθ(st,at):动作价值函数

(5) Aπθ(st,at)A^{\pi_\theta}(s_t,a_t)Aπθ(st,at):优势函数

(6) rt+γVπθ(st+1)−Vπθ(st)r_t + \gamma V^{\pi_{\theta}}(s_{t+1}) - V^{\pi_{\theta}}(s_t)rt+γVπθ(st+1)−Vπθ(st):时序差分残差

9.5 节提到 REINFORCE 通过蒙特卡洛采样的方法对策略梯度的估计是无偏的,但是方差非常大。我们可以用形式(3)引入基线函数(baseline function)b(st)b(s_t)b(st)来减小方差。此外,我们也可以采用 Actor-Critic 算法估计一个动作价值函数QQQ,代替蒙特卡洛采样得到的回报,这便是形式(4)。这个时候,我们可以把状态价值函数VVV作为基线,从QQQ函数减去这个VVV函数则得到了AAA函数,我们称之为优势函数(advantage function),这便是形式(5)。更进一步,我们可以利用Q=r+γVQ=r+\gamma VQ=r+γV等式得到形式(6)。

本章将着重介绍形式(6),即通过时序差分残差ψt=rt+γVπ(st+1)−Vπ(st)\psi_t = r_t + \gamma V^{\pi}(s_{t+1}) - V^{\pi}(s_t)ψt=rt+γVπ(st+1)−Vπ(st)来指导策略梯度进行学习。事实上,用QQQ值或者VVV值本质上也是用奖励来进行指导,但是用神经网络进行估计的方法可以减小方差、提高鲁棒性。除此之外,REINFORCE 算法基于蒙特卡洛采样,只能在序列结束后进行更新,这同时也要求任务具有有限的步数,而 Actor-Critic 算法则可以在每一步之后都进行更新,并且不对任务的步数做限制。

我们将 Actor-Critic 分为两个部分:Actor(策略网络)和 Critic(价值网络),如图 10-1 所示。

- Actor 要做的是与环境交互,并在 Critic 价值函数的指导下用策略梯度学习一个更好的策略。

- Critic 要做的是通过 Actor 与环境交互收集的数据学习一个价值函数,这个价值函数会用于判断在当前状态什么动作是好的,什么动作不是好的,进而帮助 Actor 进行策略更新。

图10-1 Actor 和 Critic 的关系

Actor 的更新采用策略梯度的原则,那 Critic 如何更新呢?我们将 Critic 价值网络表示为VωV_\omegaVω,参数为ω\omegaω。于是,我们可以采取时序差分残差的学习方式,对于单个数据定义如下价值函数的损失函数:

L(ω)=12(r+γVω(st+1)−Vω(st))2\mathcal{L}(\omega) = \dfrac{1}{2} \Big(r + \gamma V_{\omega}(s_{t+1}) - V_{\omega}(s_t)\Big)^2 L(ω)=21(r+γVω(st+1)−Vω(st))2

与 DQN 中一样,我们采取类似于目标网络的方法,将上式中r+γVω(st+1)r + \gamma V_{\omega}(s_{t+1})r+γVω(st+1)作为时序差分目标,不会产生梯度来更新价值函数。因此,价值函数的梯度为:

∇ωL(ω)=−(r+γVω(st+1)−Vω(st))∇ωVω(st)\nabla_{\omega}\mathcal{L}(\omega) = - \Big( r + \gamma V_{\omega}(s_{t+1}) - V_{\omega}(s_t) \Big) \nabla_{\omega} V_{\omega}(s_t) ∇ωL(ω)=−(r+γVω(st+1)−Vω(st))∇ωVω(st)

然后使用梯度下降方法来更新 Critic 价值网络参数即可。

Actor-Critic 算法的具体流程如下:

- 初始化策略网络参数θ\thetaθ,价值网络参数ω\omegaω

- for 序列 e=1→Ee=1\rightarrow Ee=1→E do :

- 用当前策略πθ\pi_\thetaπθ采样轨迹{s1,a1,r1,s2,a2,r2,⋯}\Big\{ s_1,a_1,r_1,s_2,a_2,r_2,\cdots \Big\}{s1,a1,r1,s2,a2,r2,⋯}

- 为每一步数据计算: δt=rt+γVω(st+1)−Vω(st)\delta_t = r_t + \gamma V_{\omega}(s_{t+1}) - V_{\omega}(s_t)δt=rt+γVω(st+1)−Vω(st)

- 更新价值参数 ω=ω+αω∑tδt∇ωVω(st)\displaystyle \omega = \omega + \alpha_\omega \sum_t \delta_t \nabla_\omega V_\omega (s_t)ω=ω+αωt∑δt∇ωVω(st)

- 更新策略参数 θ=θ+αθ∑tδt∇θlogπθ(at∣st)\displaystyle \theta = \theta + \alpha_\theta \sum_t \delta_t \nabla_\theta \log \pi_\theta(a_t|s_t)θ=θ+αθt∑δt∇θlogπθ(at∣st)

- end for

以上就是 Actor-Critic 算法的流程,接下来让我们来用代码实现它,看看效果如何吧!

10.3 Actor-Critic 代码实践

我们仍然在车杆环境上进行 Actor-Critic 算法的实验。

import gym

import torch

import torch.nn.functional as F

import numpy as np

import matplotlib.pyplot as plt

import rl_utils

首先定义策略网络PolicyNet(与 REINFORCE 算法一样)。

class PolicyNet(torch.nn.Module):

def __init__(self, state_dim, hidden_dim, action_dim):

super(PolicyNet, self).__init__()

self.fc1 = torch.nn.Linear(state_dim, hidden_dim)

self.fc2 = torch.nn.Linear(hidden_dim, action_dim)

def forward(self, x):

x = F.relu(self.fc1(x))

return F.softmax(self.fc2(x), dim=1)

Actor-Critic 算法中额外引入一个价值网络,接下来的代码定义价值网络ValueNet,其输入是某个状态,输出则是状态的价值。

class ValueNet(torch.nn.Module):

def __init__(self, state_dim, hidden_dim):

super(ValueNet, self).__init__()

self.fc1 = torch.nn.Linear(state_dim, hidden_dim)

self.fc2 = torch.nn.Linear(hidden_dim, 1)

def forward(self, x):

x = F.relu(self.fc1(x))

return self.fc2(x)

现在定义ActorCritic算法,主要包含采取动作(take_action())和更新网络参数(update())两个函数。

class ActorCritic:

def __init__(

self,

state_dim,

hidden_dim,

action_dim,

actor_lr,

critic_lr,

gamma,

device

):

# 策略网络

self.actor = PolicyNet(state_dim, hidden_dim, action_dim).to(device)

self.critic = ValueNet(state_dim, hidden_dim).to(device) # 价值网络

# 策略网络优化器

self.actor_optimizer = torch.optim.Adam(self.actor.parameters(), lr=actor_lr)

self.critic_optimizer = torch.optim.Adam(self.critic.parameters(), lr=critic_lr) # 价值网络优化器

self.gamma = gamma

self.device = device

def take_action(self, state):

state = torch.tensor([state], dtype=torch.float).to(self.device)

probs = self.actor(state)

action_dist = torch.distributions.Categorical(probs)

action = action_dist.sample()

return action.item()

def update(self, transition_dict):

states = torch.tensor(transition_dict['states'], dtype=torch.float).to(self.device)

actions = torch.tensor(transition_dict['actions']).view(-1, 1).to(self.device)

rewards = torch.tensor(transition_dict['rewards'], dtype=torch.float).view(-1, 1).to(self.device)

next_states = torch.tensor(transition_dict['next_states'], dtype=torch.float).to(self.device)

dones = torch.tensor(transition_dict['dones'], dtype=torch.float).view(-1, 1).to(self.device)

# 时序差分目标

td_target = rewards + self.gamma * self.critic(next_states) * (1 - dones)

td_delta = td_target - self.critic(states) # 时序差分误差

log_probs = torch.log(self.actor(states).gather(1, actions))

actor_loss = torch.mean(-log_probs * td_delta.detach())

# 均方误差损失函数

critic_loss = torch.mean(F.mse_loss(self.critic(states), td_target.detach()))

self.actor_optimizer.zero_grad()

self.critic_optimizer.zero_grad()

actor_loss.backward() # 计算策略网络的梯度

critic_loss.backward() # 计算价值网络的梯度

self.actor_optimizer.step() # 更新策略网络的参数

self.critic_optimizer.step() # 更新价值网络的参数

定义好 Actor 和 Critic,我们就可以开始实验了,看看 Actor-Critic 在车杆环境上表现如何吧!

actor_lr = 1e-3

critic_lr = 1e-2

num_episodes = 1000

hidden_dim = 128

gamma = 0.98

device = torch.device("cuda") if torch.cuda.is_available() else torch.device("cpu")

env_name = 'CartPole-v0'

env = gym.make(env_name)

env.seed(0)

torch.manual_seed(0)

state_dim = env.observation_space.shape[0]

action_dim = env.action_space.n

agent = ActorCritic(

state_dim,

hidden_dim,

action_dim,

actor_lr,

critic_lr,

gamma,

device

)

return_list = rl_utils.train_on_policy_agent(env, agent, num_episodes)

Iteration 0: 100%|██████████| 100/100 [00:00<00:00, 101.75it/s, episode=100, return=21.100]

Iteration 1: 100%|██████████| 100/100 [00:01<00:00, 58.71it/s, episode=200, return=72.800]

Iteration 2: 100%|██████████| 100/100 [00:05<00:00, 19.73it/s, episode=300, return=109.300]

Iteration 3: 100%|██████████| 100/100 [00:05<00:00, 17.30it/s, episode=400, return=163.000]

Iteration 4: 100%|██████████| 100/100 [00:06<00:00, 16.27it/s, episode=500, return=193.600]

Iteration 5: 100%|██████████| 100/100 [00:06<00:00, 15.90it/s, episode=600, return=195.900]

Iteration 6: 100%|██████████| 100/100 [00:06<00:00, 15.80it/s, episode=700, return=199.100]

Iteration 7: 100%|██████████| 100/100 [00:06<00:00, 15.72it/s, episode=800, return=186.900]

Iteration 8: 100%|██████████| 100/100 [00:06<00:00, 15.94it/s, episode=900, return=200.000]

Iteration 9: 100%|██████████| 100/100 [00:06<00:00, 15.45it/s, episode=1000, return=200.000]

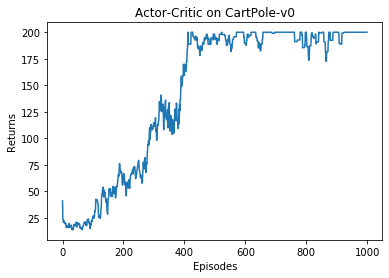

在 CartPole-v0 环境中,满分就是 200 分。和 REINFORCE 相似,接下来我们绘制训练过程中每一条轨迹的回报变化图以及其经过平滑处理的版本。

episodes_list = list(range(len(return_list)))

plt.plot(episodes_list, return_list)

plt.xlabel('Episodes')

plt.ylabel('Returns')

plt.title('Actor-Critic on {}'.format(env_name))

plt.show()

mv_return = rl_utils.moving_average(return_list, 9)

plt.plot(episodes_list, mv_return)

plt.xlabel('Episodes')

plt.ylabel('Returns')

plt.title('Actor-Critic on {}'.format(env_name))

plt.show()

根据实验结果我们可以发现,Actor-Critic 算法很快便能收敛到最优策略,并且训练过程非常稳定,抖动情况相比 REINFORCE 算法有了明显的改进,这说明价值函数的引入减小了方差。

10.4 总结

本章讲解了 Actor-Critic 算法,它是基于值函数的方法和基于策略的方法的叠加。价值模块 Critic 在策略模块 Actor 采样的数据中学习分辨什么是好的动作,什么不是好的动作,进而指导 Actor 进行策略更新。随着 Actor 的训练的进行,其与环境交互所产生的数据分布也发生改变,这需要 Critic 尽快适应新的数据分布并给出好的判别。

Actor-Critic 算法非常实用,后续章节中的 TRPO、PPO、DDPG、SAC 等深度强化学习算法都是在 Actor-Critic 框架下进行发展的。深入了解 Actor-Critic 算法对读懂目前深度强化学习的研究热点大有裨益。

10.5 参考文献

[1] KONDA, V R, TSITSIKLIS J N. Actor-critic algorithms [C]// Advances in neural information processing systems, 2000.

11 TRPO 算法

11.1 简介

本书之前介绍的基于策略的方法包括策略梯度算法和 Actor-Critic 算法。这些方法虽然简单、直观,但在实际应用过程中会遇到训练不稳定的情况。回顾一下基于策略的方法:参数化智能体的策略,并设计衡量策略好坏的目标函数,通过梯度上升的方法来最大化这个目标函数,使得策略最优。具体来说,假设 θ\thetaθ 表示策略 πθ\pi_\thetaπθ 的参数,定义J(θ)=Eπθ[Vπθ(s0)]=Eπθ[∑t=0∞γtr(st,at)]\displaystyle J(\theta)=\mathbb{E}_{\pi_{\theta}}[V^{\pi_\theta}(s_0)]=\mathbb{E}_{\pi_{\theta}}[\sum_{t=0}^\infin \gamma^t r(s_t,a_t)]J(θ)=Eπθ[Vπθ(s0)]=Eπθ[t=0∑∞γtr(st,at)],基于策略的方法的目标是找到θ∗=arg maxθJ(θ)\theta^*=\underset{\theta}{\argmax}J(\theta)θ∗=θargmaxJ(θ),策略梯度算法主要沿着 ∇θJ(θ)\nabla_\theta J(\theta)∇θJ(θ) 方向迭代更新策略参数θ\thetaθ。但是这种算法有一个明显的缺点:当策略网络是深度模型时,沿着策略梯度更新参数,很有可能由于步长太长,策略突然显著变差,进而影响训练效果。

针对以上问题,我们考虑在更新时找到一块信任区域(trust region),在这个区域上更新策略时能够得到某种策略性能的安全性保证,这就是信任区域策略优化(trust region policy optimization,TRPO)算法的主要思想。TRPO 算法在 2015 年被提出,它在理论上能够保证策略学习的性能单调性,并在实际应用中取得了比策略梯度算法更好的效果。

11.2 策略目标

策略梯度优化目标有两种表达形式:J(θ)=Eπθ[Vπθ(s0)]J(\theta) = \mathbb{E}_{\pi_{\theta}}[V^{\pi_\theta}(s_0)]J(θ)=Eπθ[Vπθ(s0)] 第一种是根据cumulative discounted reward设计的,形式为:J(θ)=Eτ∼pθ(τ)[∑t∞γtr(st,at)]\displaystyle J(\theta) = \mathbb{E}_{\tau \sim p_{\theta}(\tau)} [\sum_t^{\infin} \gamma^t r(s_t, a_t)]J(θ)=Eτ∼pθ(τ)[t∑∞γtr(st,at)] 因为 Vπθ(s)=Ea∼πθ(s)[Qπθ(s,a)]=Ea∼πθ(s)[Eτ∼pθ(τ)[∑sk=s,ak=a∑t=k∞γt−kr(st,at)]]\displaystyle V^{\pi_\theta}(s) = \mathbb{E}_{a\sim \pi_\theta(s)}[Q^{\pi_\theta}(s,a)] = \mathbb{E}_{a\sim \pi_\theta(s)}\Big[\mathbb{E}_{\tau \sim p_{\theta}(\tau)} [\sum_{s_k=s, a_k=a} \sum_{t=k}^{\infin} \gamma^{t-k} r(s_t,a_t)]\Big]Vπθ(s)=Ea∼πθ(s)[Qπθ(s,a)]=Ea∼πθ(s)[Eτ∼pθ(τ)[sk=s,ak=a∑t=k∑∞γt−kr(st,at)]] 第二种是根据s0s_0s0的distribution来设计的,形式为:J(θ)=Es0∼pθ(s0)[Vπθ(s0)]J(\theta) = \mathbb{E}_{s_0 \sim p_{\theta}(s_0)}[V^{\pi_\theta}(s_0)]J(θ)=Es0∼pθ(s0)[Vπθ(s0)]

假设当前策略为πθ\pi_\thetaπθ,参数为θ\thetaθ。我们考虑如何借助当前的θ\thetaθ找到一个更优的参数θ′\theta'θ′,使得J(θ′)≥J(θ)J(\theta')\ge J(\theta)J(θ′)≥J(θ)。具体来说,由于初始状态s0s_0s0的分布和策略无关,因此上述策略πθ\pi_\thetaπθ下的优化目标J(θ)J(\theta)J(θ)可以写成在新策略πθ′\pi_{\theta'}πθ′的期望形式:

s0s_0s0只与环境有关,所以s0s_0s0的概率与根据策略πθ\pi_{\theta}πθ采样得到的轨迹τ\tauτ中的第一个状态s0s_0s0的概率是一样的。 这样就可以对期望的因子进行换元,由 s0s_0s0 变成 τ\tauτ,然后采 τ\tauτ 里的 s0s_0s0。

J(θ)=Es0∼p(s0)[Vπθ(s0)]=Eτ∼pθ′(τ)[Vπθ(s0)]=Eτ∼pθ′(τ)[Vπθ(s0)+∑t=1∞γtVπθ(st)−∑t=1∞γtVπθ(st)]=Eτ∼pθ′(τ)[∑t=0∞γtVπθ(st)−∑t=1∞γtVπθ(st)]=−Eτ∼pθ′(τ)[∑t=1∞γtVπθ(st)−∑t=0∞γtVπθ(st)]=−Eτ∼pθ′(τ)[∑t=0∞γt+1Vπθ(st+1)−∑t=0∞γtVπθ(st)]=−Eτ∼pθ′(τ)[∑t=0∞γt(γVπθ(st+1)−Vπθ(st))]\begin{aligned} J(\theta) &= \mathbb{E}_{s_0\sim p(s_0)} [V^{\pi_\theta}(s_0)]\\ &= \mathbb{E}_{\tau \sim p_{\theta'}(\tau)} [V^{\pi_\theta}(s_0)]\\ &= \mathbb{E}_{\tau \sim p_{\theta'}(\tau)} \bigg[V^{\pi_\theta}(s_0) + \sum_{t=1}^\infin \gamma^t V^{\pi_{\theta}}(s_t) - \sum_{t=1}^\infin \gamma^t V^{\pi_{\theta}}(s_t)\bigg]\\ &= \mathbb{E}_{\tau \sim p_{\theta'}(\tau)} \bigg[\sum_{t=0}^\infin \gamma^tV^{\pi_\theta}(s_t) - \sum_{t=1}^\infin \gamma^t V^{\pi_{\theta}}(s_t)\bigg]\\ &= -\mathbb{E}_{\tau \sim p_{\theta'}(\tau)} \bigg[\sum_{t=1}^\infin \gamma^t V^{\pi_{\theta}}(s_t) - \sum_{t=0}^\infin \gamma^tV^{\pi_\theta}(s_t)\bigg]\\ &= -\mathbb{E}_{\tau \sim p_{\theta'}(\tau)} \bigg[\sum_{t=0}^\infin \gamma^{t+1} V^{\pi_{\theta}}(s_{t+1}) - \sum_{t=0}^\infin \gamma^tV^{\pi_\theta}(s_t)\bigg]\\ &= -\mathbb{E}_{\tau \sim p_{\theta'}(\tau)} \bigg[\sum_{t=0}^\infin \gamma^t \Big(\gamma V^{\pi_\theta}(s_{t+1}) - V^{\pi_{\theta}}(s_t)\Big)\bigg]\\ \end{aligned} J(θ)=Es0∼p(s0)[Vπθ(s0)]=Eτ∼pθ′(τ)[Vπθ(s0)]=Eτ∼pθ′(τ)[Vπθ(s0)+t=1∑∞γtVπθ(st)−t=1∑∞γtVπθ(st)]=Eτ∼pθ′(τ)[t=0∑∞γtVπθ(st)−t=1∑∞γtVπθ(st)]=−Eτ∼pθ′(τ)[t=1∑∞γtVπθ(st)−t=0∑∞γtVπθ(st)]=−Eτ∼pθ′(τ)[t=0∑∞γt+1Vπθ(st+1)−t=0∑∞γtVπθ(st)]=−Eτ∼pθ′(τ)[t=0∑∞γt(γVπθ(st+1)−Vπθ(st))]

基于以上等式,我们可以推导新旧策略的目标函数之间的差距:

前面用第一种形式(cumulative discounted reward)展开,后面一个根据上面推导的形式展开

J(θ′)−J(θ)=Es0[Vπθ′(s0)]−Es0[Vπθ(s0)]=Eτ∼pθ′(τ)[∑t=0∞γtr(st,at)]+Eτ∼pθ′(τ)[∑t=0∞γt(γVπθ(st+1)−Vπθ(st))]=Eτ∼pθ′(τ)[∑t=0∞γt(r(st,at)+γVπθ(st+1)−Vπθ(st))]\begin{aligned} J(\theta') - J(\theta) &= \mathbb{E}_{s_0}[V^{\pi_{\theta'}}(s_0)] - \mathbb{E}_{s_0}[V^{\pi_{\theta}}(s_0)] \\ &= \mathbb{E}_{\tau \sim p_{\theta'}(\tau)}\Big[ \sum_{t=0}^\infin \gamma^tr(s_t,a_t) \Big] + \mathbb{E}_{\tau \sim p_{\theta'}(\tau)} \bigg[\sum_{t=0}^\infin \gamma^t \Big(\gamma V^{\pi_\theta}(s_{t+1}) - V^{\pi_{\theta}}(s_t)\Big)\bigg] \\ &= \mathbb{E}_{\tau \sim p_{\theta'}(\tau)} \bigg[\sum_{t=0}^\infin \gamma^t \Big(r(s_t,a_t) + \gamma V^{\pi_\theta}(s_{t+1}) - V^{\pi_{\theta}}(s_t)\Big)\bigg] \\ \end{aligned} J(θ′)−J(θ)=Es0[Vπθ′(s0)]−Es0[Vπθ(s0)]=Eτ∼pθ′(τ)[t=0∑∞γtr(st,at)]+Eτ∼pθ′(τ)[t=0∑∞γt(γVπθ(st+1)−Vπθ(st))]=Eτ∼pθ′(τ)[t=0∑∞γt(r(st,at)+γVπθ(st+1)−Vπθ(st))]

将时序差分残差定义为优势函数AAA:

=Eτ∼pθ′(τ)[∑t=0∞γtAπθ(st,at)]=∑t=0∞γtEst∼Ptπθ′Eat∼πθ′(⋅∣st)[Aπθ(st,at)]=11−γEs∼νπθ′Ea∼πθ′(⋅∣s)[Aπθ(s,a)]\begin{aligned} &= \mathbb{E}_{\tau \sim p_{\theta'}(\tau)} \bigg[\sum_{t=0}^\infin \gamma^t A^{\pi_\theta}(s_t,a_t)\bigg] \\ &= \sum_{t=0}^\infin \gamma^t \mathbb{E}_{s_t \sim P_t^{\pi_{\theta'}}} \mathbb{E}_{a_t \sim \pi_{\theta'}(\cdot|s_t)} [A^{\pi_\theta}(s_t,a_t)] \\ &= \dfrac{1}{1-\gamma} \mathbb{E}_{s \sim \nu^{\pi_{\theta'}}} \mathbb{E}_{a \sim \pi_{\theta'}(\cdot|s)} [A^{\pi_\theta}(s,a)] \\ \end{aligned} =Eτ∼pθ′(τ)[t=0∑∞γtAπθ(st,at)]=t=0∑∞γtEst∼Ptπθ′Eat∼πθ′(⋅∣st)[Aπθ(st,at)]=1−γ1Es∼νπθ′Ea∼πθ′(⋅∣s)[Aπθ(s,a)]

最后一个等号的成立运用到了状态访问分布的定义:νπ(s)=(1−γ)∑t=0∞(1−γ)γtPtπ(s)\displaystyle \nu^\pi(s)=(1-\gamma)\sum_{t=0}^\infin (1-\gamma)\gamma^tP_t^\pi(s)νπ(s)=(1−γ)t=0∑∞(1−γ)γtPtπ(s),所以只要我们能找到一个新策略,使得Es∼νπθ′Ea∼πθ′(⋅∣s)[Aπθ(s,a)]≥0\mathbb{E}_{s \sim \nu^{\pi_{\theta'}}} \mathbb{E}_{a \sim \pi_{\theta'}(\cdot|s)} [A^{\pi_\theta}(s,a)] \ge 0Es∼νπθ′Ea∼πθ′(⋅∣s)[Aπθ(s,a)]≥0,就能保证策略性能单调递增,即J(θ′)≥J(θ)J(\theta') \ge J(\theta)J(θ′)≥J(θ)。

但是直接求解该式是非常困难的,因为πθ′\pi_{\theta'}πθ′是我们需要求解的策略,但我们又要用它来收集样本。(我们只是先求了一个πθ′\pi_{\theta'}πθ′,然后用之前的数据判断他好不好,不可能说拿他进行一轮采样再来判断,采样一次的成本太大了,而且这一般不是最优策略,显然更新要好多轮的,一直重新采样,可想而知时间开销多大)把所有可能的新策略都拿来收集数据,然后判断哪个策略满足上述条件的做法显然是不现实的。于是 TRPO 做了一步近似操作,对状态访问分布进行了相应处理。具体而言,忽略两个策略之间的状态访问分布变化,直接采用旧的策略πθ\pi_\thetaπθ的状态分布,定义如下替代优化目标:

J(θ′)≈Lθ(θ′)=J(θ)+11−γEs∼νπθEa∼πθ′(⋅∣s)[Aπθ(s,a)]J(\theta') \approx L_\theta(\theta') = J(\theta) + \dfrac{1}{1-\gamma} \mathbb{E}_{s \sim \nu^{\pi_{\theta}}} \mathbb{E}_{a \sim \pi_{\theta'}(\cdot|s)} [A^{\pi_\theta}(s,a)] J(θ′)≈Lθ(θ′)=J(θ)+1−γ1Es∼νπθEa∼πθ′(⋅∣s)[Aπθ(s,a)]

当新旧策略非常接近时,状态访问分布变化很小,这么近似是合理的。其中,动作仍然用新策略πθ′\pi_{\theta'}πθ′采样得到(这样我们只需用PolicyNet算一次就完成采样了),我们可以用重要性采样对动作分布进行处理:

Lθ(θ′)=J(θ)+11−γEs∼νπθEa∼πθ′(⋅∣s)[Aπθ(s,a)]=J(θ)+11−γEs∼νπθ[∑a∈Aπθ′(a∣s)⋅Aπθ(s,a)]=J(θ)+11−γEs∼νπθ[∑a∈Aπθ′(a∣s)⋅πθ(a∣s)πθ(a∣s)⋅Aπθ(s,a)]=J(θ)+11−γEs∼νπθ[∑a∈Aπθ(a∣s)⋅(πθ′(a∣s)πθ(a∣s)Aπθ(s,a))]=J(θ)+Es∼νπθEa∼πθ(⋅∣s)[πθ′(a∣s)πθ(a∣s)Aπθ(s,a)]\begin{aligned} L_\theta(\theta') &= J(\theta) + \dfrac{1}{1-\gamma} \mathbb{E}_{s \sim \nu^{\pi_{\theta}}} \mathbb{E}_{a \sim \pi_{\theta'}(\cdot|s)} [A^{\pi_\theta}(s,a)]\\ &= J(\theta) + \dfrac{1}{1-\gamma} \mathbb{E}_{s \sim \nu^{\pi_{\theta}}} \Big[\sum_{a \in \mathcal{A}} \pi_{\theta'}(a|s) \cdot A^{\pi_\theta}(s,a)\Big]\\ &= J(\theta) + \dfrac{1}{1-\gamma} \mathbb{E}_{s \sim \nu^{\pi_{\theta}}} \Big[\sum_{a \in \mathcal{A}} \pi_{\theta'}(a|s) \cdot \dfrac{\pi_{\theta}(a|s)}{\pi_{\theta}(a|s)} \cdot A^{\pi_\theta}(s,a)\Big]\\ &= J(\theta) + \dfrac{1}{1-\gamma} \mathbb{E}_{s \sim \nu^{\pi_{\theta}}} \bigg[\sum_{a \in \mathcal{A}} \pi_{\theta}(a|s) \cdot \Big( \dfrac{\pi_{\theta'}(a|s)}{\pi_{\theta}(a|s)} A^{\pi_\theta}(s,a) \Big)\bigg]\\ &= J(\theta) + \mathbb{E}_{s \sim \nu^{\pi_{\theta}}} \mathbb{E}_{a \sim \pi_{\theta}(\cdot|s)} \bigg[ \dfrac{\pi_{\theta'}(a|s)}{\pi_{\theta}(a|s)} A^{\pi_\theta}(s,a)\bigg] \\ \end{aligned} Lθ(θ′)=J(θ)+1−γ1Es∼νπθEa∼πθ′(⋅∣s)[Aπθ(s,a)]=J(θ)+1−γ1Es∼νπθ[a∈A∑πθ′(a∣s)⋅Aπθ(s,a)]=J(θ)+1−γ1Es∼νπθ[a∈A∑πθ′(a∣s)⋅πθ(a∣s)πθ(a∣s)⋅Aπθ(s,a)]=J(θ)+1−γ1Es∼νπθ[a∈A∑πθ(a∣s)⋅(πθ(a∣s)πθ′(a∣s)Aπθ(s,a))]=J(θ)+Es∼νπθEa∼πθ(⋅∣s)[πθ(a∣s)πθ′(a∣s)Aπθ(s,a)]

这样,我们就可以基于旧策略πθ\pi_\thetaπθ已经采样出的数据来估计并优化新策略πθ′\pi_{\theta'}πθ′了。为了保证新旧策略足够接近,TRPO 使用了库尔贝克-莱布勒(Kullback-Leibler,KL)散度来衡量策略之间的距离,并给出了整体的优化公式:

maxθ′Lθ(θ′)s.t. Es∼νπθk[DKL(πθk(⋅∣s),πθ′(⋅∣s))]≤δ\begin{aligned} & \underset{\theta'}{\max} L_\theta(\theta')\\ & \text{s.t. } \mathbb{E}_{s \sim \nu^{\pi_{\theta_k}}} \Big[ D_{KL}\Big(\pi_{\theta_k}(\cdot|s), \pi_{\theta'}(\cdot|s)\Big) \Big]\le\delta \end{aligned} θ′maxLθ(θ′)s.t. Es∼νπθk[DKL(πθk(⋅∣s),πθ′(⋅∣s))]≤δ

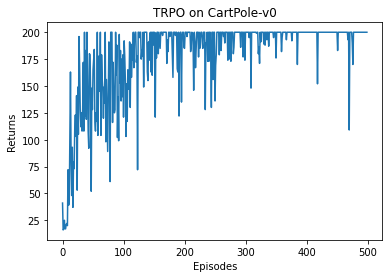

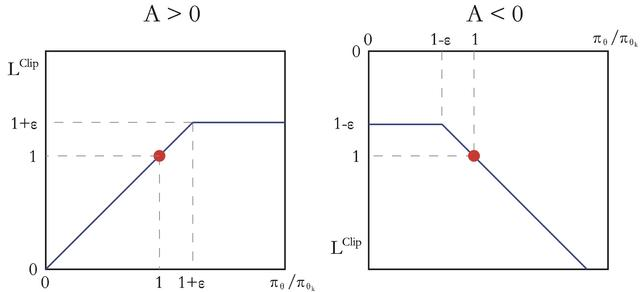

这里的不等式约束定义了策略空间中的一个 KL 球,被称为信任区域。在这个区域中,可以认为当前学习策略和环境交互的状态分布与上一轮策略最后采样的状态分布一致,进而可以基于一步行动的重要性采样方法使当前学习策略稳定提升。TRPO 背后的原理如图 11-1 所示。

图11-1 TRPO原理示意图

左图表示当完全不设置信任区域时,策略的梯度更新可能导致策略的性能骤降;右图表示当设置了信任区域时,可以保证每次策略的梯度更新都能来带性能的提升。

11.3 近似求解

直接求解上式带约束的优化问题比较麻烦,TRPO 在其具体实现中做了一步近似操作来快速求解。为方便起见,我们在接下来的式子中用θk\theta_kθk代替之前的θ\thetaθ,表示这是第kkk次迭代之后的策略。首先对目标函数和约束在θk\theta_kθk进行泰勒展开,分别用 1 阶、2 阶进行近似:

Es∼νπθkEa∼πθk(⋅∣s)[πθ′(a∣s)πθk(a∣s)Aπθk(s,a)]≈gT(θ′−θk)\mathbb{E}_{s \sim \nu^{\pi_{\theta_k}}} \mathbb{E}_{a \sim \pi_{\theta_k}(\cdot|s)} \bigg[ \dfrac{\pi_{\theta'}(a|s)}{\pi_{\theta_k}(a|s)} A^{\pi_{\theta_k}}(s,a)\bigg] \approx g^T(\theta' - \theta_k) Es∼νπθkEa∼πθk(⋅∣s)[πθk(a∣s)πθ′(a∣s)Aπθk(s,a)]≈gT(θ′−θk)

Es∼νπθk[DKL(πθk(⋅∣s),πθ′(⋅∣s))]≈12(θ′−θk)TH(θ′−θk)\mathbb{E}_{s \sim \nu^{\pi_{\theta_k}}} \Big[ D_{KL}\Big(\pi_{\theta_k}(\cdot|s), \pi_{\theta'}(\cdot|s)\Big) \Big] \approx \dfrac{1}{2} (\theta' - \theta_k)^T H (\theta'-\theta_k) Es∼νπθk[DKL(πθk(⋅∣s),πθ′(⋅∣s))]≈21(θ′−θk)TH(θ′−θk)

其中g=∇θ′Es∼νπθkEa∼πθk(⋅∣s)[πθ′(a∣s)πθk(a∣s)Aπθk(s,a)]g=\nabla_{\theta'}\mathbb{E}_{s\sim\nu^{\pi_{\theta_k}}} \mathbb{E}_{a\sim\pi_{\theta_k}(\cdot|s)}\Big[\dfrac{\pi_{\theta'}(a|s)}{\pi_{\theta_k}(a|s)} A^{\pi_{\theta_k}}(s,a)\Big]g=∇θ′Es∼νπθkEa∼πθk(⋅∣s)[πθk(a∣s)πθ′(a∣s)Aπθk(s,a)],表示目标函数的梯度,H=H[Es∼νπθk[DKL(πθk(⋅∣s),πθ′(⋅∣s))]]H = \mathbf{H}\Big[\mathbb{E}_{s \sim \nu^{\pi_{\theta_k}}} \Big[D_{KL}\Big(\pi_{\theta_k}(\cdot|s), \pi_{\theta'}(\cdot|s)\Big)\Big]\Big]H=H[Es∼νπθk[DKL(πθk(⋅∣s),πθ′(⋅∣s))]]表示策略之间平均 KL 距离的黑塞矩阵(Hessian matrix)。

于是我们的优化目标变成了:

θk+1=arg maxθ′gT(θ′−θk)s.t. 12(θ′−θk)TH(θ′−θk)≤δ\begin{aligned} & \theta_{k+1} = \argmax_{\theta'} g^T(\theta' - \theta_k)\\ &\text{s.t. } \dfrac{1}{2} (\theta' - \theta_k)^T H (\theta'-\theta_k) \le \delta \end{aligned} θk+1=θ′argmaxgT(θ′−θk)s.t. 21(θ′−θk)TH(θ′−θk)≤δ

此时,我们可以用卡罗需-库恩-塔克(Karush-Kuhn-Tucker,KKT)条件直接导出上述问题的解:

θk+1=θk+2δgTH−1gH−1g\theta_{k+1} = \theta_k + \sqrt{\dfrac{2\delta}{g^T H^{-1} g}} H^{-1}g θk+1=θk+gTH−1g2δH−1g

证明

推导过程如下,根据KKT条件,可以得到以下结论:

首先修改优化问题为求最小值问题:

θk+1=−arg minθ′gT(θ′−θk)s.t. 12(θ′−θk)TH(θ′−θk)≤δ\begin{aligned} & \theta_{k+1} = - \argmin_{\theta'} g^T(\theta' - \theta_k)\\ &\text{s.t. } \dfrac{1}{2} (\theta' - \theta_k)^T H (\theta'-\theta_k) \le \delta \end{aligned} θk+1=−θ′argmingT(θ′−θk)s.t. 21(θ′−θk)TH(θ′−θk)≤δ

如果λ>0\lambda > 0λ>0,则有12(θ′−θk)TH(θ′−θk)=δ\dfrac{1}{2} (\theta' - \theta_k)^T H (\theta'-\theta_k) = \delta21(θ′−θk)TH(θ′−θk)=δ,即等式约束处于严格约束状态,此时Stationarity条件可以简化为:

∇θ′[−gT(θ′−θk)+λ(12(θ′−θk)TH(θ′−θk)−δ)]=0−g+λH(θ′−θk)=0θ′=θk+1λH−1g\begin{aligned} \nabla_{\theta'} \Big[-g^T(\theta' - \theta_k) + \lambda \Big( \dfrac{1}{2} (\theta' - \theta_k)^T H (\theta'-\theta_k) - \delta \Big) \Big] &= 0\\ -g + \lambda H (\theta'-\theta_k) &= 0 \\ \theta' &= \theta_k + \dfrac{1}{\lambda} H^{-1} g \end{aligned} ∇θ′[−gT(θ′−θk)+λ(21(θ′−θk)TH(θ′−θk)−δ)]−g+λH(θ′−θk)θ′=0=0=θk+λ1H−1g

将上式代入等式约束中,得到:

δ=12(1λH−1g)TH(1λH−1g)δ=12λ2gTH−1gλ=gTH−1g2δ\begin{aligned} \delta &= \dfrac{1}{2} (\dfrac{1}{\lambda} H^{-1}g)^T H (\dfrac{1}{\lambda} H^{-1}g)\\ \delta &= \dfrac{1}{2\lambda^2} g^T{H^{-1}}g\\ \lambda &= \sqrt{\dfrac{g^TH^{-1}g}{2\delta}} \end{aligned} δδλ=21(λ1H−1g)TH(λ1H−1g)=2λ21gTH−1g=2δgTH−1g

回代到 θ′\theta'θ′ 的表达式中:

θ′=θk+1λH−1g=θk+2δgTH−1gH−1g\theta' = \theta_k + \dfrac{1}{\lambda} H^{-1} g = \theta_k + \sqrt{\dfrac{2\delta}{g^TH^{-1}g}} H^{-1} g θ′=θk+λ1H−1g=θk+gTH−1g2δH−1g

如果λ=0\lambda = 0λ=0,则有12(θ′−θk)TH(θ′−θk)<δ\dfrac{1}{2} (\theta' - \theta_k)^T H (\theta'-\theta_k) < \delta21(θ′−θk)TH(θ′−θk)<δ,即等式约束处于松弛状态。此时,Stationarity条件可以简化为:

∇θ′[−gT(θ′−θk)+λ(12(θ′−θk)TH(θ′−θk)−δ)]=0gT=0\begin{aligned} \nabla_{\theta'} \Big[-g^T(\theta' - \theta_k) + \lambda \Big( \dfrac{1}{2} (\theta' - \theta_k)^T H (\theta'-\theta_k) - \delta \Big) \Big] &= 0\\ g^T &= 0 \end{aligned} ∇θ′[−gT(θ′−θk)+λ(21(θ′−θk)TH(θ′−θk)−δ)]gT=0=0

此时,最优解可以在不等式约束的边界处取到,综上有:

θk+1=θk+2δgTH−1gH−1g\theta_{k+1} = \theta_k + \sqrt{\dfrac{2\delta}{g^T H^{-1} g}} H^{-1}g θk+1=θk+gTH−1g2δH−1g

得证。

11.4 共轭梯度

一般来说,用神经网络表示的策略函数的参数数量都是成千上万的,计算和存储黑塞矩阵的逆矩阵HHH会耗费大量的内存资源和时间。TRPO 通过共轭梯度法(conjugate gradient method)回避了这个问题。易观察到更新公式中 θk+1=θk+2δgTH−1gH−1g\theta_{k+1} = \theta_k + \sqrt{\dfrac{2\delta}{g^T H^{-1} g}} H^{-1}gθk+1=θk+gTH−1g2δH−1g 由向量 H−1gH^{-1} gH−1g 和标量 2δgTH−1g\sqrt{\dfrac{2\delta}{g^T H^{-1} g}}gTH−1g2δ 共同组成。通过换元法,把向量换成x=H−1gx=H^{-1}gx=H−1g表示参数更新方向。假设满足 KL 距离约束的参数更新时的最大步长为β\betaβ,于是,根据 KL 距离约束条件,有12(βx)TH(βx)=δ\dfrac{1}{2}(\beta x)^TH(\beta x) = \delta21(βx)TH(βx)=δ。求解β\betaβ:

12(βx)TH(βx)=δβ22xTHx=δβ2=2δxTHxβ=2δxTHx\begin{aligned} \dfrac{1}{2}(\beta x)^TH(\beta x) &= \delta \\ \dfrac{\beta^2}{2}x^T H x &= \delta \\ \beta^2&= \dfrac{2\delta}{x^T H x} \\ \beta &= \sqrt{\dfrac{2\delta}{x^T H x}} \\ \end{aligned} 21(βx)TH(βx)2β2xTHxβ2β=δ=δ=xTHx2δ=xTHx2δ

得到β=2δxTHx\beta = \sqrt{\dfrac{2\delta}{x^THx}}β=xTHx2δ。因此,此时参数更新方式为

θk+1=θk+2δxTHxx\theta_{k+1} = \theta_k + \sqrt{\dfrac{2\delta}{x^THx}}x θk+1=θk+xTHx2δx

因此,只要可以直接计算x=H−1gx=H^{-1}gx=H−1g,就可以根据该式更新参数,问题转化为解Hx=gHx=gHx=g。实际上HHH为对称正定矩阵,所以我们可以使用共轭梯度法来求解。共轭梯度法的具体流程如下:

- 初始化r0=g−Hx0r_0=g-Hx_0r0=g−Hx0,p0=r0p_0=r_0p0=r0,x0=0x_0=0x0=0

- for k=0→Nk=0 \rightarrow Nk=0→N do:

- 计算步长:αk=rkTrkpkTHpk\alpha_k=\dfrac{r_k^T r_k}{p_k^T H p_k}αk=pkTHpkrkTrk

- 更新当前解:xk+1=xk+αkpkx_{k+1} = x_k + \alpha_k p_kxk+1=xk+αkpk

- 更新残差:rk+1=rk−αkHpkr_{k+1} = r_k - \alpha_k H p_krk+1=rk−αkHpk

- 如果rk+1Trk+1r_{k+1}^Tr_{k+1}rk+1Trk+1非常小,则退出循环

- 计算新搜索方向的权重系数:βk=rk+1Trk+1rkTrk\beta_k = \dfrac{r_{k+1}^Tr_{k+1}}{r_k^Tr_k}βk=rkTrkrk+1Trk+1

- 计算新的搜索方向:pk+1=rk+1+βkpkp_{k+1}=r_{k+1} + \beta_kp_kpk+1=rk+1+βkpk

- end for

- 输出xN+1x_{N+1}xN+1

在共轭梯度运算过程中,直接计算αk\alpha_kαk和rk+1r_{k+1}rk+1需要计算和存储海森矩阵HHH。为了避免这种大矩阵的出现,我们只计算HxH_xHx向量,而不直接计算和存储HHH矩阵。这样做比较容易,因为对于任意的列向量vvv,容易验证:

Hv=∇θ((∇θ(DKLνπθk(πθk,πθ′)))T)v=∇θ((∇θ(DKLνπθk(πθk,πθ′)))Tv)Hv = \nabla_\theta \bigg( \Big(\nabla_\theta (D_{KL}^{\nu^{\pi_{\theta_k}}}(\pi_{\theta_k, \pi_{\theta'}}))\Big)^T \bigg)v = \nabla_\theta \bigg( \Big(\nabla_\theta (D_{KL}^{\nu^{\pi_{\theta_k}}}(\pi_{\theta_k, \pi_{\theta'}}))\Big)^T v \bigg) Hv=∇θ((∇θ(DKLνπθk(πθk,πθ′)))T)v=∇θ((∇θ(DKLνπθk(πθk,πθ′)))Tv)

即先用梯度和向量vvv点乘后计算梯度。

11.5 线性搜索

由于 TRPO 算法用到了泰勒展开的 1 阶和 2 阶近似,这并非精准求解,因此,θ′\theta'θ′可能未必比θk\theta_kθk好,或未必能满足 KL 散度限制。TRPO 在每次迭代的最后进行一次线性搜索(Line Search),以确保找到满足条件。具体来说,就是找到一个最小的非负整数iii,使得按照

θk+1=θk+αi2δxTHxx\theta_{k+1} = \theta_k + \alpha^i\sqrt{\dfrac{2\delta}{x^THx}}x θk+1=θk+αixTHx2δx

求出的θk+1\theta_{k+1}θk+1依然满足最初的 KL 散度限制,并且确实能够提升目标函数LθkL_{\theta_k}Lθk,这其中α∈(0,1)\alpha\in(0,1)α∈(0,1)是一个决定线性搜索长度的超参数。

至此,我们已经基本上清楚了 TRPO 算法的大致过程,它具体的算法流程如下:

- 初始化策略网络参数θ\thetaθ,价值网络参数ω\omegaω

- for 序列e=1→Ee=1\rightarrow Ee=1→E do:

- 用当前策略πθ\pi_\thetaπθ采样轨迹{s1,a1,r1,s2,a2,r2,⋯ }\{s_1,a_1,r_1,s_2,a_2,r_2, \cdots\}{s1,a1,r1,s2,a2,r2,⋯}

- 根据收集到的数据和价值网络估计每个状态动作对的优势A(st,at)A(s_t,a_t)A(st,at)

- 计算策略目标函数的梯度ggg

- 用共轭梯度法计算x=H−1gx=H^{-1}gx=H−1g