如何正确地夸赞Sora

好久不更了,一怪我奇懒,二怪大模型太勤。大模型23年的热点就像那款口香糖是一浪接着一浪,我又习惯先搞清楚原理,结果这边刚读完论文那边就又来了新的,最后只能狗熊掰棒子。只是我都断更这么久了,每天居然还都有一点阅读量,大家都在读什么呢?很好奇。

新年新气象,开篇就来聊Sora。

Sora很热,但我不适合写。众所周知Sora是开年热点,文章漫山遍野,还有人卖课。但众所不周知的是,Sora压根没有开卖,这会还在红队内测中。

啥叫红队?就是你要上线一款应用,又担心会被脑洞大开的网友玩得脑洞大开,最坏的结果是直接玩脱下线,你就得找一伙脑洞大开的自己人关起门来先玩一轮。这伙自己人就叫红队。

那外人有没有办法窥探点什么呢?有但不多,OpenAI官网挂着一张介绍页面,外加几条demo视频,哦,还有一篇不怎么技术的技术报告。别的没了,界面都不知道长啥样,更别说原理。

所以,Sora我不适合写。

不过,网上早都开始拿着Sora虚空变现,一群搞短视频的朋友看着demo不知道该夸还是该怕,好在分析未发布AI有一大优势,那就是技术都是有传承的。这篇我们就从传承的角度,拿着有但不多的官方消息捋一捋热点Sora。

- Sora是个啥?

简单来说,Sora是款文生视频模型。OpenAI的官宣题目简明扼要,直接就是《Creating video from text》,下面有一行小字,基本就是官宣文案的太长不看版:

Sora is an AI model that can create realistic and imaginative scenes from text instructions.

注意三个信息要素:

Sora是款AI模型。很多人都觉得是废话,我倒觉得可能暗示OpenAI不一定直接提供Sora的交互界面,而可能作为其它服务的后端,比如通过ChatGPT调用。

有一些文章习惯性地说Sora是大模型,我专门看了一下,文章和技术报告都没提到Sora是大模型,可能暗示Sora参数规模并不大。

Sora能够生成高质量的视频。所谓高质量,简单来说就是“逼真”,这是Sora给人的第一印象,没准还是唯一印象。

很多人以为Sora是第一款文生视频模型,其实不对,但Sora将这项任务做到了前所未有的高度,生成的视频以假乱真,关键是合乎物理世界的逻辑,这才是Sora真正值得称道的地方。后面会仔细说为什么。

Sora能够按照文本指令生成视频。文本指令是个啥?其实就是一段用户描述生成目标的文字,术语叫提示词(prompt)。

下面这张图已经在网上已经转烂了,不知道大家有没有注意到左下角有几行文字,大意是“一位时尚的女士漫步在东京街头,周围环绕着温暖发光的霓虹灯和动态的城市标志”,这就是提示词。

注意,是先给出提示词,然后模型再按照提示词生成下面这段视频。

介绍Sora的文章很多都在强调Sora生成视频逼真,当然也不错。但想一想,前面ChatGPT的特点是啥?是理解能力强啊,OpenAI怎么突然搞出两个不搭界的模型?

关键就在于这个“按照文本指令生成”。

这是Sora除逼真以外的另一大特点,也是这两年生成模型的主要发展脉络,我们展开聊聊。

- 文本指令生成模型

Sora也好,ChatGPT也好,都知道是生成模型,这其实是后半句,前半句应该加上“按照文本指令”。

按这个视角重新审视生成模型这两年的发展,会发现呈现出一条清晰的脉络,那就是文生XX。

这里的文,就是文本指令,或者叫提示词。比如ChatGPT。ChatGPT是文生文(text-to-text)模型。按造上面对Sora的介绍,我们可以说ChatGPT是“一款能够依据文本指令生成高质量文本的AI模型”。

对于ChatGPT来说,文本指令具体指什么呢?比如说翻译一段文字、摘要一篇文章、制定一项计划等等,这些应用场景的交互模式其实都是我们先以文本形式输入要求,然后模型再以文本形式生成相关内容。

文生文在自然语言处理中是非常一项经典的任务,在ChatGPT之前已经有无数人用无数模型去尝试,ChatGPT同样并非首创者。那为什么ChatGPT能爆火出圈?这个问题的答案,同样有助于我们更客观地理解Sora。

原因在于ChatGPT有两个高:

第一是理解水平高。ChatGPT能够非常准确地从输入文本中识别用户意图,对于一些比较复杂的、抽象的描述,模型同样能够准确理解。这一点非常重要,不但是ChatGPT的单品优势,而且即将成为OpenAI产品的企业优势。

第二是生成质量高。生成质量是模型最直观的衡量指标,过去说一篇文章翻译很烂,会说这篇文章“像机翻”,说明生成质量低劣已经成为了机翻引擎的特征。相比之下,ChatGPT的生成质量高了不止五六层楼,甚至衍生出一种新用法:请ChatGPT帮忙润色文章。

概括一句话,ChatGPT将文生文这项任务做到了前所未有的高度。

即使今天再看文生文任务,可以卷的指标依旧很多,比如支持更多的语种、更长的上下文,更强的推理以及更高的编程水平。谷歌稍早于Sora发布了一款Gemini 1.5 Pro,卖点之一就是上下文窗口长达100万词元,这就是卷上下文长度。

卷面板数据有用吗?有用,但不持久。结果就是,谷歌苦心憋了很久的超长上下文,热点很快就被还没发布的Sora完全盖过。

不卷那有没有其它方向呢?有,选项之一是多模态。

23年3月,GPT-4打响了大模型多模态的第一枪,到了2024年,多模态也已经成为大模型卷面板数据的重点方向。

- 高质量的多模态生成

什么叫多模态?很简单,输入模态和输入模态不一致就叫多模态。

我们说文本指令模型具体是文生XX,这里的XX,开始是文本,然后是图片,现在到了Sora则是视频。生成的图片、视频,都属于多模态。

OpenAI很早就点出了多模态的科技树,21年就推出了文生图的多模态模型。我们知道OpenAI有一条模型产品线叫GPT,这是文生文系列的,而文生图系列的模型则叫DALL-E。目前最新的是第三代DALL-E 3。

2022年是OpenAI的大年,年底推出了爆款ChatGPT,其实,这一年的爆品有两款,另一款是22年3月推出的第二代文生图模型DALL-E 2。

我不知道听过DALL-E 2的同学有多少,但这款模型在AI领域非常轰动,扩散模型经此一战成名,取代GAN成为图像生成领域的基干。

DALL-E 2的一大特点就是“逼真”。

对比官宣文案就会发现,OpenAI在“逼真”这方面是有执念的。2022年的DALL-E 2的官宣强调了能够生成逼真图片,2024年Sora的官宣文案同样强调能够生成逼真视频。

ChatGPT也有两个高,其中之一是生成质量高。高质量生成显然是OpenAI追求的目标之一,在图片、视频等视觉生成领域,高质量最直观、最直接的体现就是“逼真”。

我们人类对“逼真”的判断没有任何技术或文化门槛,那真是字面意义上最显而易见的事情。我想,这也是OpenAI视觉生成模型容易爆火出圈的秘诀。

- 可控的逼真

OpenAI对视觉生成的追求不止逼真。

如果只停留在追求“逼真”层面,很容易又陷入指标内卷的循环,更何况理解文本和生成逼真本来就分属于自然语言处理和计算机视觉两大领域,很容易发展成两条平行的产品线,优势反而成了负担。

不管当时OpenAI有没有考虑这一点,但最终点出的一项新技能,举重若轻地解决了这个问题,甚至直接开创了一条新赛道,叫AI绘画。

这就是DALL-E 2的另一大特点,“听懂人话”。

听懂人话非常重要。2014年提出GAN模型以后,图像生成不断取得进展,像素越来越高、画面也越来越逼真,但慢慢的大家又从最初的欣喜变成挑剔:生成确实挺好的,但怎样才能生成我想要的图像呢?于是就有了条件生成,外部输入一些条件,可以是文本也可以是图像,模型按要求生成指定图像。有了条件生成才能有AI绘画,否则就变成了抽卡。

应该说明的是,无论是GAN还是扩散模型,都已经点出了条件生成这项技能,但为什么现在主流的条件生成都是用扩散模型来做,对不起,回答不了。写出来可能只是一句话,但写什么得查很多论文。新年新气象,此处偷懒留白。

总之,OpenAI的DALL-E系列选择了用扩散模型做条件生成,21年第一代就开宗明义,说DALL-E的卖点是Creating images from text,重点不在于生成质量,而在于能够理解文本。

到了22年的DALL-E 2,文本理解就更进上了一层台阶。不过注意,官宣文案没有使用“文本指令”这个说法,而是选择了“自然语言描述”。

这里我做一个过度解读,OpenAI可能认为当时DALL-E 2的理解能力处于有但不多的水平。“自然语言描述”意思是能听懂人话,而“文本指令”则是进一步强调了模型的理解能力,能精准听懂人话。

为什么这么猜呢?因为OpenAI在发布DALL-E 2的前两个月,给“指令”这个词赋予了新的含义。

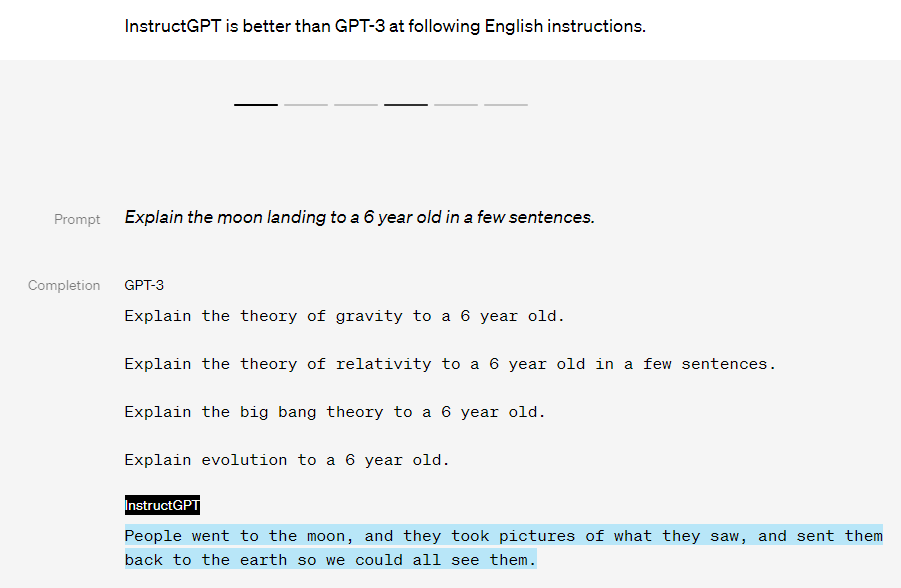

文章叫《Aligning language models to follow instructions》,介绍了一款衍生版GPT-3模型,叫InstructGPT,是ChatGPT的前身,与普通GPT-3最大的不同在于,InstructGPT能更精准地理解用户意图,也即“遵循指令”。

关键的地方来了,如果OpenAI真的认为DALL-E 2在理解用户意图上还有所欠缺,那应该怎么提升呢?很简单,让平行线相交就行。理解水平高是ChatGPT的一大优势,怎样成为OpenAI全公司的优势呢?很简单,想办法把文本理解部分丢给ChatGPT,多模态生成做后端。想法很简单,但怎样做属于学术前沿的问题。不过,OpenAI就是按照这个思路干的。证据就是最新一代DALL-E 3:

逼真的多模态生成、强大的文本指令理解,至此,Sora所需要的基础要素都齐备了。

- Sora的真正野心

Sora是文生视频模型,不过OpenAI不希望你觉得Sora只是文生视频模型。

文生视频英文text-to-video,记住这个词,我想这将会是2024年大模型新的关键词。相信很快会看到更高的像素、更长的时长,可能还有更多五花八门的场景。

堆面板数据简直是思维惯性。但这里,我尝试从更高的角度解读。

前面介绍了DALL-E,应该知道OpenAI做文生视频有优势,也是必然。因为图片和视频关系密切,但又有不同。

先说关系。其实所谓的视频,就是一串长长的图片序列。视频里成为“帧”的,就是其中的一张图片,网上经常有一些硬核UP做“逐帧分析”,意思是对组成视频的每一张图片进行分析。

所以,OpenAI能做出逼真的文生图,想要做也最终做到了逼真的文生视频,这很合理。把DALL-E生成的逼真图片连接起来,不就得到了逼真的视频吗?

当然没这么简单。

想象一下,在手机随机抽几张照片组合起来会是怎样一幅场景,我不知道术语应该怎么叫,总之画面肯定很“跳”。这就是不同。

怎样才能将图片组合词自然流畅的视频呢?说起来不复杂,只要确保图片与图片的前后关系,能够满足物理世界的逻辑就行。从AI的角度,无非就是两个问题:

1.模型怎样学到物理世界的逻辑?

2.模型怎样按照物理世界的逻辑生成图片序列(视频)?

但问题是,生成模型能回答这两个问题吗?

AI三巨头之一的LeCun说,不可能。所以,生成模型是邪路。

现在学界对大模型的看法两极分化,一派认为这是通往AGI的康庄大道,最近马克斯拿了来起诉OpenAI。另一派则反之,认为大模型是只会学舌的随机鹦鹉,LeCun甚至说了,骂大模型是随机鹦鹉,简直侮辱了鹦鹉。鄙夷至极。

那么,LeCun心中的正道是什么呢?

是世界模型,也即能真的能学到物理世界的逻辑。双方明牌以后,问题反倒简单。核心就是这个问题:生成模型到底能不能学到物理世界的逻辑?

这个问题不仅关乎高质量地文生视频,而且将揭示整条生成模型技术路线的最终命运。

接下来又是我的过度解读。目前OpenAI官方发布的Sora材料只有两份,一份是官宣,另一份是技术报告。请带着上述问题,仔细看技术报告的题目:

Video generation models as world simulators

我想,这才是Sora最大的野心。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-03-06,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读