分辨率降低,性能不降:LoReTrack实现高效Transformer跟踪 !

分辨率降低,性能不降:LoReTrack实现高效Transformer跟踪 !

高性能的Transformer跟踪器已经显示出卓越的效果,但它们往往承担着沉重的计算负担。观察到较小的输入可以立即且方便地减少计算量而不改变模型,一个简单的解决方案是采用低分辨率输入以实现高效的Transformer跟踪。 尽管这样做会更快,但由于低分辨率跟踪中的信息丢失,这大大损害了跟踪的准确性。在本文中,作者旨在通过从冻结的高分辨率(但不是更大的)Transformer跟踪器进行双重知识蒸馏来减轻这种信息丢失,以提高低分辨率Transformer跟踪的性能。 核心在于两个简单而有效的蒸馏模块,包括 Query -键-值知识蒸馏(QKV-KD)和辨别知识蒸馏(Disc-KD),这些模块跨越了不同的分辨率。 前者从全局视角允许低分辨率跟踪器继承高分辨率跟踪器的特征和交互,而后者从目标感知视角出发,通过模仿其高分辨率对应物的辨别区域,增强了目标-背景的区分能力。 通过双重知识蒸馏,作者的低分辨率Transformer跟踪器(LoReTrack)不仅因减少计算而具有高效率,而且通过从高分辨率跟踪器中蒸馏知识而提高了准确性。在广泛的实验中,具有分辨率的LoReTrack一致地改进了相同分辨率的 Baseline ,并且与高分辨率Transformer跟踪器相比,显示出具有竞争力的甚至更好的结果,同时运行速度提高了52%,节省了56%**的MACs。此外,LoReTrack具有分辨率可扩展性。在分辨率下,它在CPU上的运行速度为_fps_,在LaSOT/LaSOT上的SUC得分分别为,超过了所有其他CPU实时跟踪器。

1 Introduction

视觉跟踪的目标是在整个视频中持续定位感兴趣的目标。它是计算机视觉的基本问题,并在过去几十年因其在前瞻性应用(如视觉监控、机器人技术等)中的重要作用而受到广泛关注。近年来,随着Transformer [33; 11] 的引入,跟踪领域取得了显著进步。许多高性能的Transformer跟踪器已被提出,并展示了前所未有的准确性。尽管如此,它们通常存在计算负担沉重的问题,这大大限制了它们在实际应用中的部署。

为了克服这一限制,现有的解决方案大多专注于降低模型复杂度,例如采用更轻的Transformer Backbone 网络(如[20]),压缩Transformer Backbone 网络(如[10]),以及开发紧凑的Transformer注意力机制(如[1]),以提高Transformer跟踪器的运行效率。

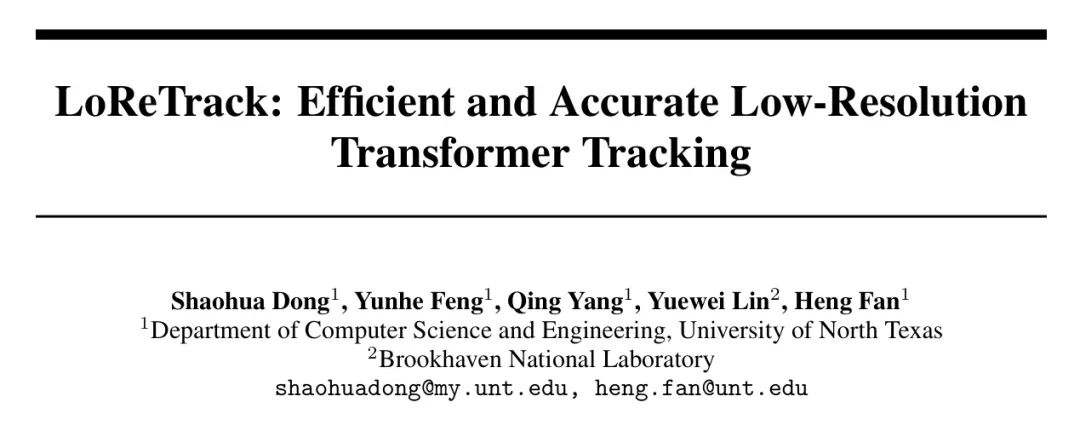

除了模型复杂度之外,影响计算和跟踪效率的另一个关键因素是输入分辨率[32]。例如,当降低流行的单流Transformer跟踪器OSTrack [44] 的输入分辨率时,其乘积累加操作(MACs)的计算量会立即大幅减少,而无需改变跟踪模型,并且如Fig. 1 (c)所示,GPU/CPU速度大幅提高。这一观察在其他许多Transformer跟踪器中同样出现(例如[44, 23, 9]),因此它们通常会设计一个面向速度的低分辨率变体以实现高效的视觉跟踪。尽管速度更快,但简单地降低输入分辨率通常会大大损害跟踪精度(例如,成功率从71.0→68.7→62.2→59.0),如图1 (b)所示。

导致性能下降的主要原因是空间信息损失,包括两个方面。

一方面,将输入图像缩小到更小的尺寸不可避免地会丢失像素中的空间细节,这可能会降低特征提取[37]。

另一方面,当降低Transformer跟踪器的分辨率时(例如[44]),使用相同 Patch 大小(例如16×16)的输入标记变得更加粗糙,并且数量减少(例如,24²→16²→8²→6²)。尽管这大大节省了注意力操作的运算量,但这些粗糙的标记并不能捕获图像内部对复杂场景下提高性能至关重要的细粒度信息交互[36]。一个解决方案是减少 Patch 大小,以允许更多细粒度的标记进行交互,如同高分辨率模型那样,但这会导致计算量增加。考虑到训练有素的高分辨率Transformer跟踪器已经通过学习图像中的细粒度标记交互保留了关键信息,作者提出一个问题:作者能否借鉴现成的高分辨率模型来减轻低分辨率Transformer跟踪中的信息损失,从而在不损失高效性的情况下提高其准确性?

作者的解决方案。作者通过引入一种简单且新颖的双重知识蒸馏框架,证明了答案是积极的。该框架允许低分辨率Transformer跟踪器从其高分辨率对应物中学习细粒度的知识,以提高准确性,同时不牺牲速度。作者框架的关键在于两个精心设计的知识蒸馏模块,包括跨分辨率的 Query -键-值知识蒸馏(QKV-KD)和判别知识蒸馏(Disc-KD)。具体来说,QKV-KD从整体角度出发,允许低分辨率跟踪器从高分辨率跟踪器那里隐式继承图像中更具判别性的特征和细粒度交互。与Transformer常见的在特征图(由 Query /键/值生成)上的知识蒸馏相比,作者的QKV-KD能够从多种视角全面学习高分辨率特征,从而得到更好的低分辨率特征表示。此外,QKV-KD的另一个好处是对注意力图的间接知识蒸馏,因为 Query 和键直接用于计算注意力关系,从而更好地促进从高分辨率Transformer跟踪器中的知识学习。为了进一步提升低分辨率跟踪,Disc-KD被用来提高其判别能力。特别是,Disc-KD从目标感知的角度出发,模仿高分辨率模型生成的判别区域,并增强低分辨率跟踪器的目标背景区分能力,以获得更好的性能。

通过QKV-KD和Disc-KD的双重知识蒸馏,名为LoReTrack的低分辨率Transformer跟踪器不仅因为使用较小的输入而具有高效率,而且通过从高分辨率跟踪器中提炼出判别性和细粒度的知识,也提高了准确性。请注意,尽管知识蒸馏源自[18],并且已被用于高效跟踪[31],但这种方法用一个更强大的模型提升了较轻的学生跟踪器的性能。与[31]中设计新学生网络的方法_不同_,LoReTrack使用高分辨率而非更强大的模型来提高低分辨率跟踪器的准确性,从而避免了设计新学生网络,因此更加紧凑。与最近关于在较小输入上应用非均匀调整大小以实现高效Transformer跟踪的工作[21]相比,LoReTrack统一调整分辨率并借用高分辨率模型进行知识学习,这更简单但效果更好。

作者在流行的单流Transformer跟踪架构[44]之上实现了LoReTrack。为了验证其有效性,作者在五个基准上进行了广泛的实验,包括LaSOT [13],LaSOT[12],GOT-10k [19],TrackingNet [29],以及UAV123 [28]。LoReTrack以相对较低分辨率256一致地改进了相同输入分辨率下的 Baseline Transformer跟踪器,与384高分辨率跟踪器相比,其准确度具有竞争力甚至更好,同时运行速度快了**52%,节省了56%**的MACs,如图1所示。此外,LoReTrack在分辨率尺度上表现极高。在128的分辨率下,它在CPU上以25 fps 的速度运行,在LaSOT/LaSOT上分别获得了64.9%/46.4%的SUC分数,超过了所有其他CPU实时跟踪器。

总之,作者的贡献有三方面:

(i) 作者提出了LoReTrack,这是一种高效且准确的方法,它有效地提升了低分辨率Transformer跟踪的性能,弥补了与高分辨率跟踪的差距;

(ii) 作者提出了两个新颖的知识蒸馏模块,包括QKV-KD和Disc-KD,它们使得低分辨率跟踪器能够从高分辨率模型中学习到具有辨识性和细粒度的信息;

(iii) 大量实验表明,LoReTrack在基准测试上持续改进,同时运行速度快,证明了其有效性。

2 Related Work

** Transformer 跟踪。** Transformer [11; 33]最近在跟踪领域取得了巨大进步,因为它在图像依赖建模方面具有出色的能力。早期的方法(如[8; 34; 42; 14])主要利用 Transformer 融合搜索区域和模板的特征以增强性能。为了进一步提高特征表示,完全基于 Transformer 的跟踪被引入。在这些方法中, Transformer 被用于特征提取和融合,从而提高了性能。尽管如此,这些方法中搜索区域和模板的特征提取 Backbone 是分别学习的,这忽略了搜索区域和模板之间早期交互的需求。为了解决这个问题,近年来出现了一种单流 Transformer 跟踪框架(如[9; 4; 44])。它以联合方式对搜索区域和模板进行特征提取和交互,展示了最新的技术水平。由于其紧凑的设计和卓越的性能,单流架构已被许多后续跟踪器采用。

高效跟踪。高效率对于视觉跟踪在现实世界中的部署至关重要。近年来,为减小目标跟踪的计算负载,已经做了大量工作。[43; 2; 20]的方法提出搜索或直接利用更轻量级的网络进行高效跟踪。[1]的工作设计了一种更有效的注意力操作来降低跟踪的计算复杂性。[10]的方法压缩了 Transformer Backbone 以加快跟踪推理速度。[31]的方法提出从较大的模型中提炼出较小但更快的跟踪模型。[21]的方法利用较小的非均匀调整大小的输入来减小 Transformer 跟踪的计算负载。作者的工作与[31]在利用知识蒸馏实现高效率方面有相似之处,但区别在于,作者从高分辨率模型中提炼知识以实现高效的单流 Transformer 跟踪,而不是像[31]那样从较大的模型中为基于卷积网络的跟踪提炼知识。此外,与[21]使用复杂的非均匀调整大小方法不同,LoReTrack统一调整输入大小,并从高分辨率模型中学习知识进行改进,这更简单但效果更好。

知识蒸馏。知识蒸馏(KD)最初在[18]中被提出,用于在教师模型的监督下学习更有效的学生模型。后来,它被用于通过从较大的模型向相对较小的模型提炼知识来提高模型效率,并在各种任务中显示出巨大潜力,如图像识别[24],目标检测[5],视觉-语言学习[39],语义分割[17],视频识别[26]等。作者的工作与[26]相关,但存在显著差异。具体来说,作者专注于提高低分辨率 Transformer 跟踪的准确性,而[26]是针对基于卷积网络的视频识别。

3 The Proposed Methodology

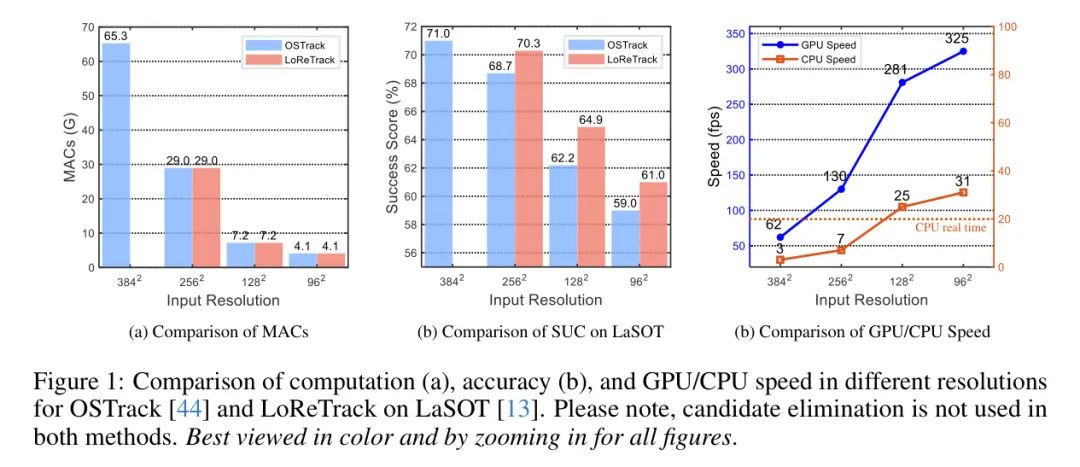

概述。在本工作中,作者旨在通过从其冻结的高分辨率对应物中提炼知识来提升低分辨率Transformer跟踪的性能,同时保持效率。具体来说,基于流行的一流Transformer跟踪器[44](SS3.1),作者引入了一个简单但有效的双知识蒸馏框架(SS3.2),该框架包括两个知识蒸馏模块,用于细粒度和有辨别力的特征学习,包括QKV-KD(SS3.2.1)和Disc-KD(SS3.2.2)。图2展示了作者方法的总体流程。

Base Tracking Architecture

作者的LoReTrack基于广受欢迎的单流Transformer跟踪框架OSTrack [44],因为其结构紧凑且性能卓越。OSTrack的核心思想在于利用视觉Transformer(ViT)[11]进行特征提取和交互,这使得搜索区域和模板之间的交互更早,从而获得更好的性能。具体来说,给定模板和搜索区域,作者首先将它们标记化为嵌入和,其中是包括图像块划分和线性投影的标记化过程。然后,将两个可学习的位置嵌入和添加到和,以生成最终模板标记嵌入和搜索区域标记嵌入,如下所示,

之后,将和首先连接为最终的标记嵌入,其中是连接操作。接着,将送入包含M(M )层的Transformer编码器[11]。每一层包括多头自注意力(MSA)和一个多层感知机(MLP)块,用于特征交互和学习。它接收上一层的输出作为输入(对于第一层,输入是)以执行特征交互和学习。这个过程可以表示如下,

其中 表示具有 Query 、键 和值 的多头注意力机制, 表示多层感知机块, 表示层归一化,且 。第 M 层输出的 包含模板和搜索区域最终的特性。通过 从 中分离出搜索区域特征 ,其中 是解连接操作,并将其输入到预测头中,预测头包含用于目标定位的分类和回归分支。

在本工作中,高分辨率和低分辨率跟踪器都是基于OSTrack [44]开发的,并使用相同的架构,除了输入分辨率不同。为了简化,作者在以下内容中使用上标“”和“”来区分高分辨率和低分辨率。请注意,[44]中的候选消除方法没有被采用,因为它可能导致不同分辨率特征的空间对齐问题。

双重知识蒸馏的低分辨率Transformer跟踪

为了提高低分辨率Transformer跟踪的性能同时保持其高效率,作者引入了双重知识蒸馏,它包括两个简单有效的模块: Query -键-值知识蒸馏(QKV-KD)和判别知识蒸馏(Disc-KD),用于从高分辨率模型中学习细粒度且有区分性的特征。请注意,在知识蒸馏过程中,高分辨率Transformer跟踪器在训练后是冻结的。

3.2.1 Query-Key-Value Knowledge Distillation

在低分辨率Transformer跟踪中,粗糙的标记难以在图像中学习到区分性特征,这导致了准确度的下降。为了缓解这个问题,作者设计了一种_query-key-value知识蒸馏_(QKV-KD),它从整体视角允许低分辨率Transformer跟踪器直接通过高分辨率模型中的细粒度标记来学习区分性特征。与现有在Transformer上执行特征(由 Query 、键和值生成)知识蒸馏的方法[24]不同,QKV-KD能够从多个视角(即 Query 、键和值视角)学习更全面的高分辨率特征知识。

此外,QKV-KD的另一个优点是它间接地使Transformer中的注意力图的知识蒸馏成为可能,因为 Query 、键和值直接用于注意力计算,这有利于学生低分辨率Transformer跟踪器进行更深入的学习模仿[35]。

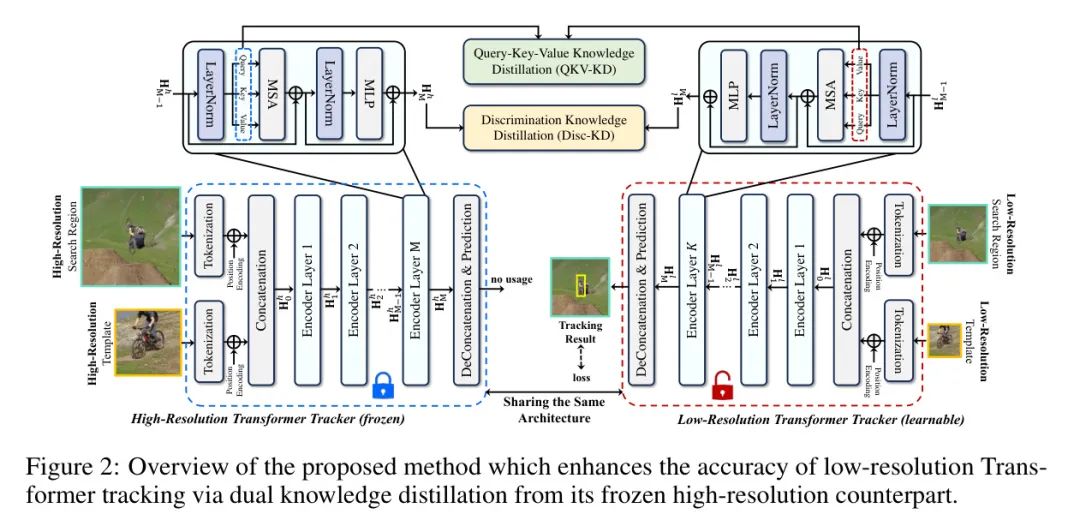

具体来说,作者在最后一个包含最多语义信息的第M层编码器的搜索区域应用QKV-KD,如图3所示。更具体地,让作者将和分别表示为高低分辨率Transformer跟踪器在第M层编码器的输入。然后,在发送到MSA之前,这两个跟踪器可以生成以下 Query 、键和值,

(

其中 和 分别表示低分辨率和高分辨率跟踪器中第M个编码层的 Query 、键和值。之后,作者可以通过以下方式的反连接将模板和相关 Query 、键和值从它们中分离出来,

其中 // 和 // 分别是高分辨率和低分辨率跟踪器中搜索区域的 Query 、键和值。

在此基础上,搜索区域的QKV-KD可以在数学上表示为如下形式,

其中 表示双线性插值操作以对齐维度,而 代表均方损失。通过等式(5)中的 ,低分辨率Transformer跟踪器的搜索区域特征能够从多个视角学习到高分辨率Transformer跟踪器的具有判别性和细粒度的搜索区域特征,这增强了最终性能。请注意,QKV-KD仅应用于搜索区域。作者研究在模板和搜索区域上应用QKV-KD,但并未观察到性能提升,稍后的实验部分将对此进行描述。

3.2.2 Discrimination Knowledge Distillation

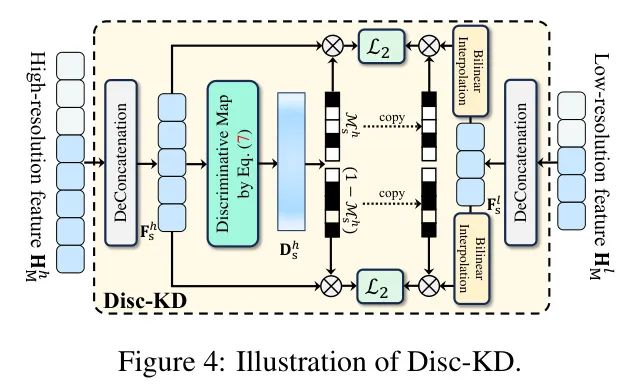

为了进一步增强低分辨率Transformer跟踪的判别能力,作者引入了判别知识蒸馏(Disc-KD),从目标感知的角度,专注于模仿高分辨率模型生成的判别区域,以提高低分辨率跟踪器的目标背景区分能力。

考虑到高级特征通常包含更多用于判别的语义信息,作者在最后一个M编码层之后的应用搜索区域特征上进行Disc-KD。具体来说,给定来自高低分辨率跟踪器的M编码层后的输出特征 和 ,作者首先从它们中分离出搜索区域特征,如下所示,

受到[45]的启发,隐藏神经元激活的重要性可以通过特征图中的绝对值来指示,作者使用来自高分辨率Transformer模型的判别图,类似于[44]。具体来说,作者通过以下方式计算中每个token沿通道维度的值:

其中 是 的判别图, 是 中的token数量, 是token的通道维度。需要注意的是,在方程(7)中,作者使用平方值来计算判别图,以获得稍好的性能。

作者不是直接在 和 上执行知识蒸馏,而是提出将特征中的判别和非判别区域解耦进行知识蒸馏,这使得可以更多地关注低分辨率跟踪器中学习区分目标的能力。更具体地说,给定 ,作者首先使用阈值 从它中提取判别 Mask ,如下所示:

值得注意的是,这里作者采用高分辨率跟踪器的判别图来生成判别 Mask ,因为高分辨率特征比低分辨率跟踪器的特征更鲁棒,因此判别区域更准确。在此之后,Disc-KD可以表述如下:

其中 和 是用于平衡损失的权重参数。通过设置 大于 ,Disc-KD使得更多地关注从判别目标区域蒸馏知识。

Loss and Inference for Low-Resolution Transformer Tracking

与OSTrack相似,在最后一个M编码层之后,通过去拼接操作(deconcatenation)从中分离出来的搜索区域特征,即,被重新塑形并送入预测头以生成分类得分和回归偏移量。在训练期间,作者考虑了与OSTrack相同的分类和回归损失项,以及包括 Query -键-值知识蒸馏和判别知识蒸馏的知识蒸馏项。最终,用于训练低分辨率Transformer跟踪器的总损失可以表达为如下形式,

其中和分别是分类和回归的损失,和是权重参数。关于这两点的详细情况,请参考OSTrack [44]。请注意,在LoReTrack的训练过程中,高分辨率Transformer跟踪模型是冻结的。

图4:Disc-KD说明。

一旦完成LoReTrack的训练,作者就按照基础跟踪器OSTrack的方式进行跟踪目标目标的推理。关于这一点的进一步阐述,作者请读者参考[44]。

实现细节。 所提出的低分辨率Transformer跟踪器,命名为LoReTrack,建立在OSTrack [44]之上,使用PyTorch [30]实现。除去了候选消除之外,参数设置与基础OSTrack保持相同,具体请参考[44]。四个数据集,包括LaSOT [13]、TrackingNet [29]、COCO [25]和GOT-10k [19]的训练划分(从GOT-10k训练集中移除了1K禁止序列)。阈值经验性地设置为0.2。和分别设置为0.6和0.4。和分别设置为0.01和0.01。作者的模型使用了4 NVIDIA A6000 GPU进行训练。在单个NVIDIA A5500 GPU和Intel i9-11900K CPU上进行推理。

分辨率设置。 在这项工作中,作者使用基础OSTrack [44]与384输入作为高分辨率Transformer。可以直接使用[44]中提供的现成预训练模型来初始化高分辨率跟踪器,并以冻结的方式使用。LoReTrack表示具有较低分辨率的基础跟踪器。其中,LoReTrack-256和LoReTrack-192,即具有256和192的LoReTrack,是为GPU上的低分辨率跟踪设计的,而具有128和96的LoReTrack-128和LoReTrack-96,即LoReTrack-128和LoReTrack-96,则是为CPU上的实时低分辨率跟踪设计的。

State-of-the-art Comparison

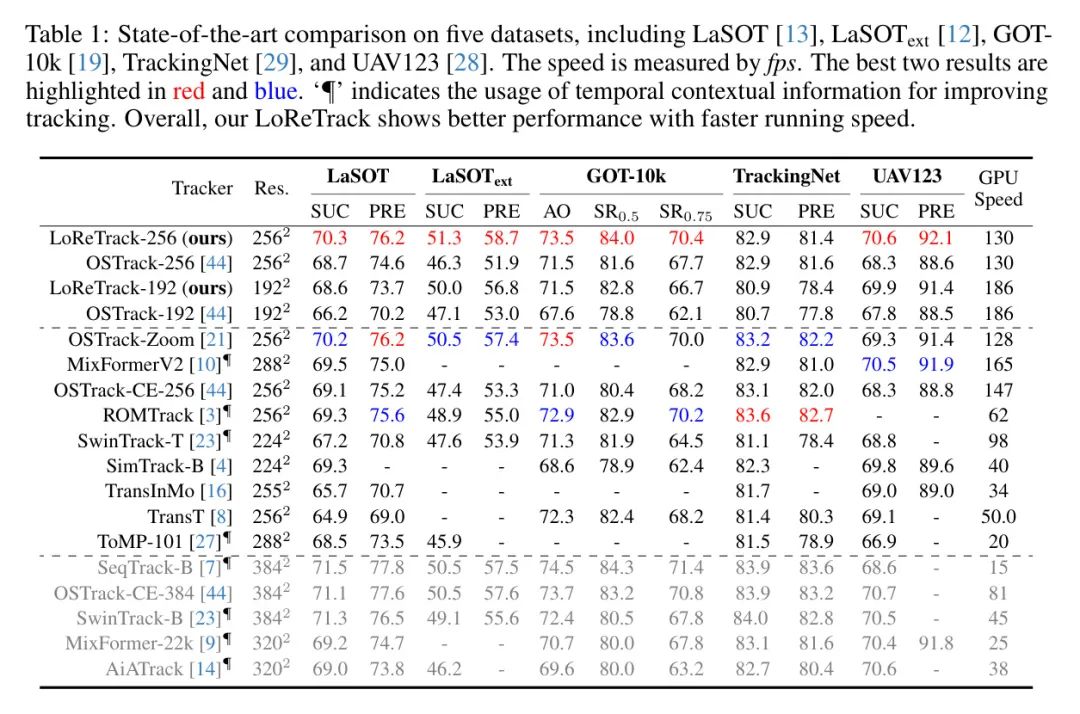

作者评估了作者的LoReTrack-256/192,并将其与其他最先进的跟踪器在五个具有挑战性的基准上进行比较,包括LaSOT [13],LaSOT[12],GOT-10k [19],TrackingNet [29] 和UAV123 [28]。在LaSOT,LaSOT,TrackingNet和UAV123上,作者使用成功率(SUC)和精确度(PRE)作为评估指标,在GOT-10k上使用平均重叠(AO)和成功率(SR)进行比较。请注意,作者主要与分辨率相似的跟踪器进行比较(例如,小于300),而具有更高分辨率(例如,大于300)或使用更大 Backbone 网络的跟踪器虽被列出但不参与比较,因为它们的目标不同。对于跟踪器OSTrack和OSTrack-Zoom,作者使用相同的GPU进行速度测量。

表1:在五个数据集上的最先进比较,包括LaSOT [13],LaSOT[12],GOT-10k [19],TrackingNet [29] 和UAV123 [28]。速度以_fps_测量。最佳两个结果用红色和蓝色突出显示。表示使用时间上下文信息来改进跟踪。总体而言,作者的LoReTrack在运行速度更快的情况下表现出更好的性能。

LaSOT[13]是一个用于测试的大规模数据集,包含280个长期序列。如表1所示,作者使用256分辨率的LoReTrack取得了最佳的70.3%SUC得分,比得分68.7%的OSTrack-256提高了1.6%。当使用192分辨率进行跟踪时,LoReTrack-192将OSTrack-192从66.2%提升到68.6%,绝对提高了2.4%。所有这些结果都表明,作者从高分辨率跟踪模型进行双重知识蒸馏,以增强低分辨率Transformer跟踪性能的有效性。LaSOT[12]是LaSOT的扩展,通过增加150个新的具有挑战性的序列。如表1所示,作者的LoReTrack取得了51.3%SUC得分,比 Baseline OSTrack-256提高了5.0%,显示出其有效性。此外,LoReTrack-256以50.5%SUC得分超过了最近的OSTrack-Zoom,提高了0.8%,这展示了作者简单而有效的方法的优势。此外,LoReTrack的性能超过了众多使用更高384分辨率的跟踪器,如SeqTrack-B、OSTrack-CE和SwinTrack-B,并且运行速度更快,达到130 _fps_,验证了其有效性。

GOT-10k[19]评估了跟踪器的零样本性能。如表1所示,LoReTrack-256获得了73.5%AO得分,比相同256分辨率的OSTrack(71.0%AO得分)提高了2.5%,并且优于其他高效跟踪器。与OSTrack-Zoom相比,LoReTrack取得了相同的AO得分,但SR和SR得分更高。

TrackingNet[29]提供了511个视频用于评估。LoReTrack在TrackingNet上没有显示出相对于基础跟踪器在SUC得分上的改进,这与OSTrack-Zoom的观察结果相似。可能的原因是TrackingNet的测试划分与其他数据集[21]非常不同,并且包含很少能够从细粒度信息中受益的场景的视频。

UAV123[28]是一个具有挑战性的基于无人机的跟踪数据集,包含123个视频。LoReTrack-256获得了70.6%的SUC得分,比OSTrack-256的68.3%提高了2.3%。它超过了其他高效跟踪器,包括最近的OSTrack-Zoom的69.3%和MixFormerV2的70.5%的SUC得分,并且与高分辨率的OSTrack-CE-384相比,显示了具有竞争力的性能。

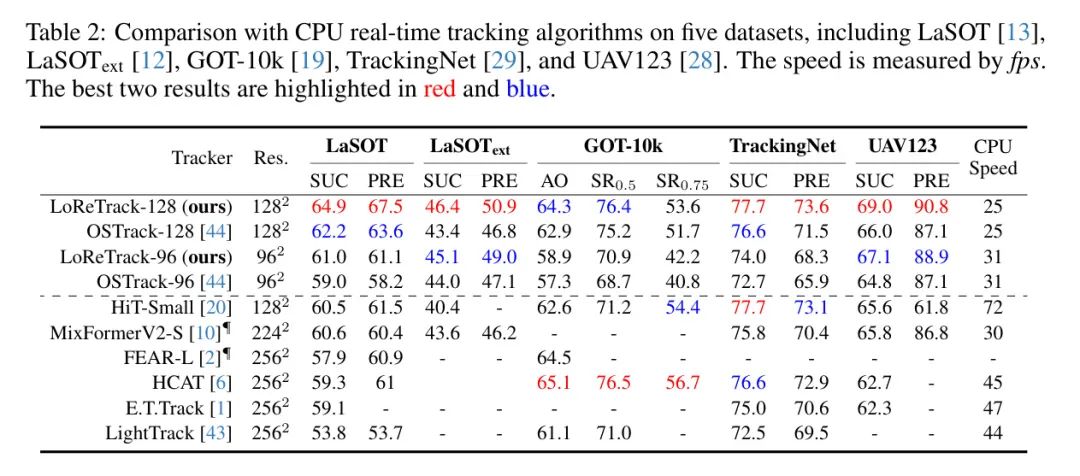

与CPU实时跟踪器的比较。 LoReTrack是可调整分辨率的,可以应用于各种分辨率进行跟踪。当进一步将输入分辨率降低到128或96时,LoReTrack实现了CPU实时跟踪(即,跟踪速度达到20 _fps_以上,按照[22]的标准)。表2展示了作者的CPU实时LoReTrack-128和LoReTrack-96在五个基准测试上的结果,包括LaSOT [13],LaSOT[12],GOT-10k [19],TrackingNet [29],和UAV123 [28],以及与其他跟踪器的比较。LoReTrack-128在LaSOT,LaSOT,TrackingNet和UAV123上分别获得了优秀的64.9%,46.4%,77.7%和69.0%的SUC得分,并在GOT-10k上显示了有竞争力的性能。

Ablation Study

为了进一步分析LoReTrack的不同设计选择,作者使用LoReTrack-256在LaSOT [13]上进行了以下各种消融研究。

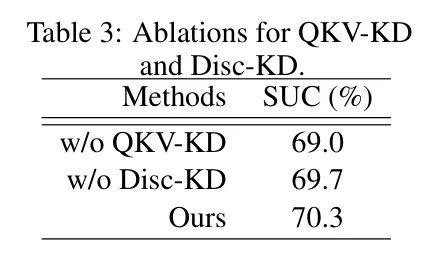

QKV-KD和Disc-KD的影响。 LoReTrack的关键在于QKV-KD和Disc-KD这两个知识蒸馏模块。为了分析它们的作用,作者在表3中进行了消融实验。从表3可以看出,当移除QKV-KD时,性能从70.3%下降到69.0%,降低了1.3%。当不应用Disc-KD时,SUC得分从70.3%下降到69.7%,降低了0.6%。这些结果表明,QKV-KD和Disc-KD对提高LoReTrack的性能都至关重要。

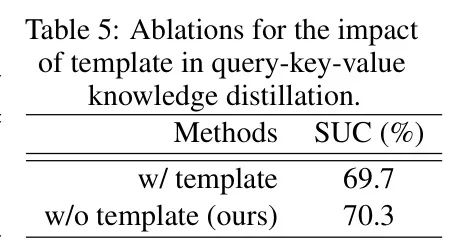

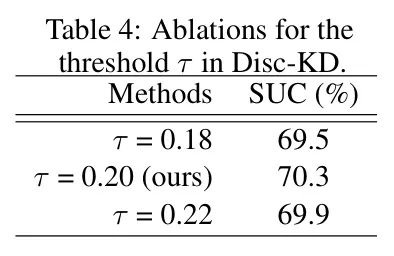

阈值的影响。 在Disc-KD中,用于生成判别 Mask 的重要参数是阈值。作者在表4中实证研究了的不同值。如表4所示,当将设置为0.20时,LoReTrack表现出最佳的70.3%的SUC得分。【影响模板在知识蒸馏中的作用。】为了探索模板对QKV-KD的影响,作者在表5中进行了实验。作者的结果显示,当在QKV-KD中对模板和搜索区域进行知识蒸馏时,准确率从70.3%降低到69.7%,降低了0.6%。可能的原因是,搜索区域特征对于跟踪更为重要,因为目标在搜索区域中被定位。当对模板进行知识蒸馏时,从高分辨率模型中对搜索区域的知识学习会被削弱,从而降低性能。

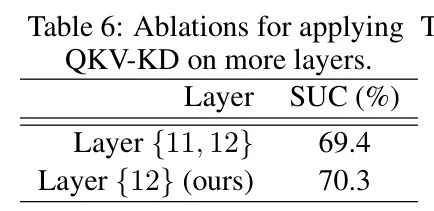

对QKV-KD的编码层影响。 QKV-KD旨在从 Query 、键和值的不同的视角蒸馏知识。在实验中,作者在表6中探讨了编码层对QKV-KD的影响。如表6所示,作者可以看到,当在更多层应用QKV-KD时,性能从70.3%下降到69.4%,降低了0.9%。原因是,当在多层应用时,QKV-KD可能难以有效从高分辨率模型中学习高级知识。

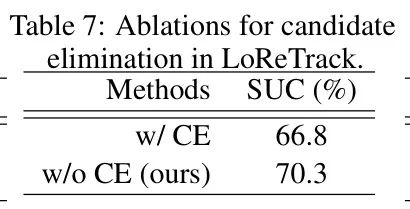

候选消除的影响。 为了避免特征中的空间错位,作者不采用候选消除(CE)。为了验证作者的观点,作者在表7中进行了实验。如表7所示,作者可以清楚地看到,当在LoReTrack中应用CE时,SUC得分显著地从70.3%下降到66.8%,降低了3.5%。因此,作者的方法不采用CE。

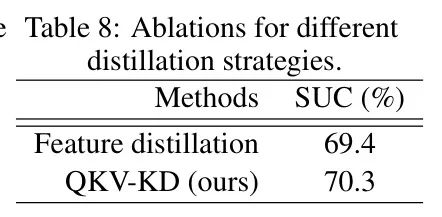

对全局特征的不同蒸馏策略的影响。 为了展示QKV-KD在整体知识学习中的作用,作者将它与另一个直接利用 Query 、键和值生成的特征版本进行了比较,在表8中。如表8所示,作者观察到对 Query 、键和值进行蒸馏的性能更好,证明了其有效性。

权重参数和的影响。 参数和用于控制对判别和非判别区域的知识蒸馏的权重。当远大于时,表示蒸馏主要关注判别区域,而对背景的关注较少,这可能导致在抑制背景方面的能力较弱。作者进行了实验,研究和的不同值。经验上,当将和设置为0.6和0.4时,作者表现出最佳的绩效。

5 Conclusion

在本工作中,作者提出通过双重知识蒸馏来增强低分辨率Transformer跟踪的性能。关键在于两个特别设计的模块,包括 Query -键-值知识蒸馏和判别知识蒸馏。前者旨在从高分辨率模型中学习细粒度特征,而后者则致力于模仿其高分辨率对应物的判别区域。

通过双重知识蒸馏,名为LoReTrack的低分辨率Transformer跟踪器既可以从高分辨率模型中提炼有用知识以获得高精度,又可以通过降低分辨率来实现快速速度。

在作者的大量实验中,作者展示了LoReTrack在大多数情况下有效地提高了具有相同分辨率的 Baseline Transformer跟踪器。

此外,LoReTrack具有分辨率可扩展性。当进一步降低分辨率时,LoReTrack实现了CPU实时跟踪,同时保持准确性,优于其他方法。

参考

[1].LoReTrack: Efficient and Accurate Low-Resolution Transformer Tracking.