三星提出当视觉模型满足参数高效的旁观适配器时,无需大规模音频预训练 !

三星提出当视觉模型满足参数高效的旁观适配器时,无需大规模音频预训练 !

近年来的研究表明,预训练的视觉模型可以在下游音频任务中提升性能。 为了进一步增强性能,通常需要在大规模音频数据上进行额外的预训练阶段,以将音频特定的知识注入到视觉模型中。然而,这样的方法需要大量的音频数据和精心设计的目标函数。 在本研究中,作者提出通过直接使用作者为高效音频理解设计的偏移 Adapter (Look-Aside Adapter,LoAA)来绕过预训练阶段。 音频频谱数据跨越时间与频率两个异质维度表示,并且作者对 Adapter 进行了优化,以促进这些维度之间token之间的交互。 作者的实验表明,作者的 Adapter 可以使视觉模型在各种音频和语音任务中达到或超越预先训练的音频模型的表现,提供了一种资源高效且有效的解决方案,用于利用视觉模型进行音频应用。

1. Introduction

在Transformer的时代[1],自我监督学习[2, 3]正在革新中国视觉(CV)和自然语言处理(NLP)等所有领域。预训练加微调的范式已被广泛采纳。然而,与CV和NLP相比,音频领域的挑战在于用于大规模预训练的数据集相对较小。尽管出现了大规模音频分类数据集,如AudioSet[4]和EPIC-SOUNDS[5],但仍然迫切需要更多的数据以支持基于Transformer模型的指数级扩展。

音频分类的一种方法是,在当前研究框架中初始利用ImageNet数据集[6]的预训练权重。这一策略在性能上明显优于使用随机初始化权重的模型,突显了跨模态迁移学习的潜力以及基于注意力机制的模型在处理音频数据集方面的高效性,这些数据集往往资源有限[7, 8]。

随后,对于音频迁移学习的方法,例如自我监督音频谱图 Transformer (SSAST)和Audio-MAE等,需要进行大规模的音频预训练以获取领域特定的知识。此外,还需要额外的微调阶段来满足下游任务的需求。如果下游数据集与预训练数据集规模相同,则总的训练成本将会大幅增加。因此,采用一种参数高效的算法,并能够在不将训练过程划分为多个阶段的情况下直接适应下游任务,将是十分有益的。例如,在计算机视觉研究中,卷积捷径(ConvPass)的概念已经被引入作为视觉 Transformer (Vision Transformer)高效适应模块的一个示例[12]。

基于参数效率和简化流程的关注点,同时考虑到音频数据的特定属性,作者考虑在图像模型中引入对音频友好的 Adapter 。

作者提出了一种新的参数高效 paradigm 用于音频分类,称为 Look-Aside Adapter (LoAA)。这种对音频友好的 Adapter 旨在帮助预训练于 ImageNet 的视觉模型,在时间或频率维度上促进音频数据中 tokens 之间的交互。由于与仅包含空间信息的图像数据不同,将音频数据转换为梅尔频谱图后,其涵盖了两种不同的领域:时间域和频域。

作者的评估涵盖了各种音频和语音数据集,包括EPIC-SOUNDS、ESC-50 [13] 和Speech Commands V2 [14]。

特别值得注意的是,作者的音频分类框架在EPIC-SOUNDS数据集上的表现超过了大规模预训练模型SSAST。请注意,这一表现是在没有任何大规模音频预训练的情况下取得的。

2. PEFT with Look-Aside Adapter

2.1.Parameter-Efficient Fine-Tuning (PEFT)

参数高效微调(PEFT)旨在通过更新少量参数来适应预训练模型以应对未见过的应用领域和下游任务。例如, Adapter 微调[15, 16]会在冻结的预训练模型的每一层中插入小型可训练模块( Adapter )。此外,为了提高效率,LoRA[17]会在注意力模块的投影层中注入低秩矩阵。

另一种方法包括 Prompt 微调[18]和前缀微调[19],它们会在输入或激活中添加可学习的 Prompt 。这些方法在更新模型参数的一小部分的同时,显示出了与完全微调相当的性能表现。作者的工作利用PEFT对图像模型进行微调,使其适用于音频下游任务,并且更新的参数比例低于总参数的10%。

2.2. PEFT for Audio based on a Frozen Image Model

最近的研究工作[8, 20]表明,在大规模音频数据集上训练之前,使用在ImageNet上预训练的权重进行初始化可以提高音频模型的性能。这表明,关于图像数据的预训练知识可以转移到音频领域。然而,仅在图像数据集上进行预训练的模型[8]的表现不如在音频数据集上进行预训练的模型[11]。

这是因为尽管音频频谱图与2D图像类似,它们具有不同的特性。图像数据中的每个维度都包含空间信息,而音频数据则是异质的,由时间和频率维度表示。大多数最近的工作通过在音频数据集上进行大规模预训练[11, 21, 22]来缓解不同模态之间的差距。在训练过程中,模型自然地学会了如何区分时间和频率维度。由于大规模预训练在计算和内存成本方面都很昂贵,作者提出对图像模型最终输出通过将块输出和 Adapter 模块输出相加来计算。

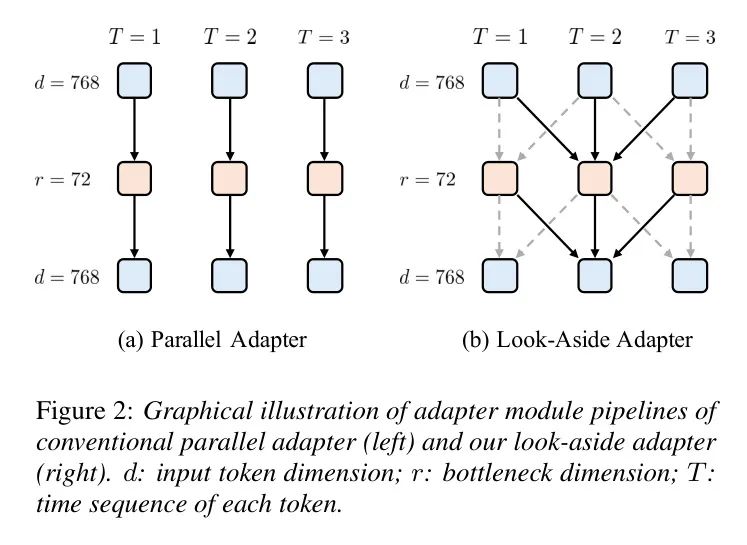

音频输入包含了三个领域的信息:时间、频率和token维度。并行 Adapter ,通过使用线性层实现,仅在token维度轴上促进交互,如图2(a)所示。因此,在冻结图像模型的PEFT场景中,token之间的交互完全依赖于预训练的注意力层。换句话说,采用之前的PEFT方法并不会直接影响token在时间和频率轴上的相互作用方式。

相反,这些方法将每个token投影到适当的维度空间,并希望基于图像的预训练注意力层表现良好。为了解决这一问题,作者提出了一种旁路 Adapter ,通过对现有方法进行简单的修改,可以在 Adapter 模块内实现token间的交互。

2.3.Look-Aside Adapter (LoAA)

作者建议使用1D卷积层作为Adapter中的投影层,以促进时域和频域轴上的Token级交互。作者将这种方法称为旁视Adapter(LoAA)。类似于式1,作者定义了LoAA的形式:

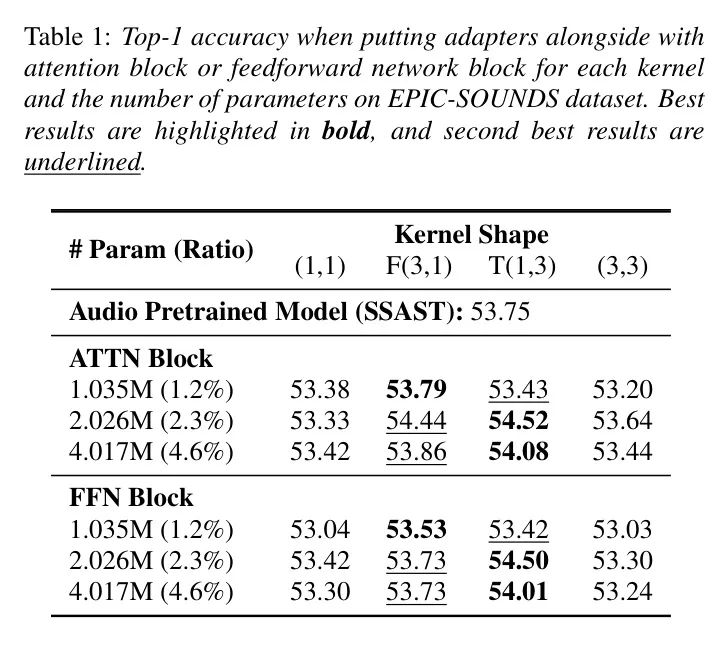

其中, 使用的核大小为 或 ,输入通道数为 ,输出通道数为 。相应地, 使用与 相同的核大小,输入通道数为 ,输出通道数为 。这意味着作者的 Adapter 模块充当了时间或频率模式识别器的角色,如图2(b)所示。鉴于线性层可以视为 卷积层,作者研究了核大小的影响。为了确保公平比较,作者在每个情况下通过调整 Bottleneck 维度来使参数数量相等,如表1所示,使用 (时间)和 (频率)核的LoAA优于表中表示为 的并行 Adapter 。

考虑到核大小的增大会导致 Bottleneck 维度的减小,这一结果表明,在时序/频率轴之间进行参数权衡对音频数据的理解是有益的。此外, 核的低性能表明,仅将卷积层引入 Adapter 而不考虑音频数据的异质性,无法有效捕捉音频特有的模式。

3.1 Experiments

3.1. Datasets and Tasks

作者在EPIC-SOUNDS音频分类、Environmental Sound Classification (ESC)环境声分类以及Speech Commands语音命令分类等三种常用音频和语音基准上评估了Look-Aside Adapter的表现。

使用预训练数据(PT-Data),包括用于视觉的ImageNet [6] 和用于音频的AudioSet-2M [4],来预训练 Baseline 模型。AudioSet-2M 包含约200万段10秒长的YouTube音频片段,每种音频事件有弱标注的类型共计527种。

EPIC-SOUNDS (EPIC) [5] 包含78,366个分类的时间标注,分布在44个类别中,平均每条标注长度为4.9秒。测试集被划分为基于音频的交互识别和检测子集。作者采用Top-1精度和平均平均精确度(mAP)作为评估指标。

ESC-50 [13] 包含2,000个环境音频录音,每段录音持续5秒,并分为50类。作者使用5折交叉验证的结果来评估作者的方法,并采用与AsT相同的数据划分。

Speech Commands (SPC-2) [14] 是一个包含两个关键词检测任务的语音命令数据集,共有35个语音指令。训练/验证/测试集分别包含84,843/9,981/11,005条1秒录音。

3.2. Implementation Details

作者的方法实现基于AST。对于AST尚未进行测试的EPIC-SOUNDS数据集,作者采用EPIC-SOUNDS [5]中的SSAST设置,使用学习率1e-4,AdamW优化器,并在不采用mixup的情况下训练30个epochs。对于ESC-50数据集,作者使用学习率1e-4对整个模型进行微调,使用Adam优化器,并在不采用mixup的情况下训练25个epochs。对于PEFT,作者选择了学习率5e-5、1e-4和5e-4。

对于SPC-2数据集,作者使用学习率2.5e-4,Adam优化器,并在采用mixup的情况下训练30个epochs。注意,在作者的adapter模块中,作者将展平的tokens Reshape 为二维的时间-频率格式,以集成卷积层。因此,在PEFT实验中,作者不重叠patch。而在全量微调时,作者采用了patch重叠。作者在配备NVIDIA RTX 3090 GPU的计算集群上进行了实验,并为每个实验分配了一个GPU。

3.3.Results

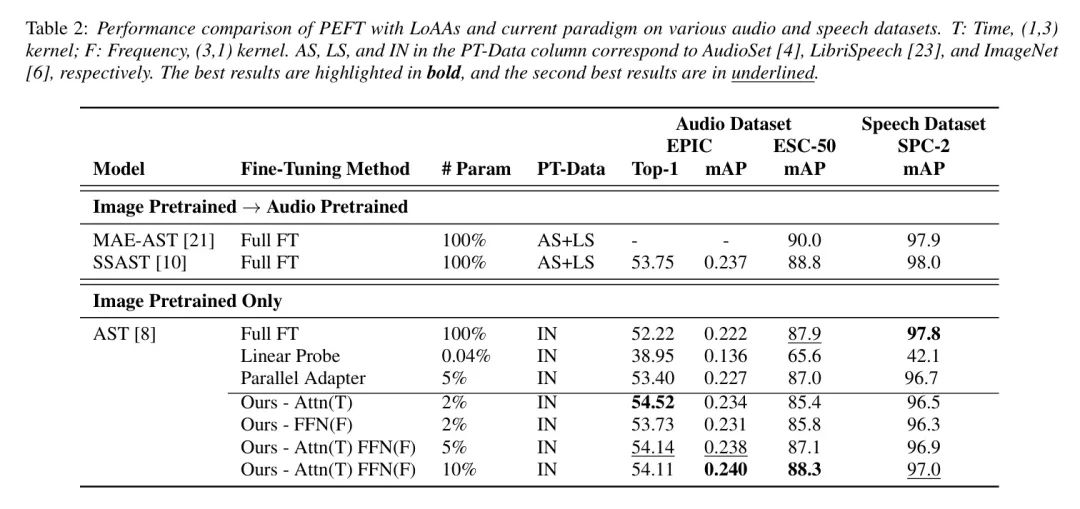

音频预训练:作者引入了基于AST [21,10]的两个音频模型,并在大规模音频数据集上进行了预训练。随后,这些模型对每个具体的下游任务进行全程微调。报告的结果直接来自相关论文。仅图像预训练:作者在音频和语音基准测试中使用基于ImageNet的预训练AST模型进行了实验。作者采用全程微调和线性 Prob 方法来考察基于图像的模型学习音频模式的能力。

仅图像预训练并结合PEFT(作者的方法):作者将作者提出的方法与各种设计选择进行了比较,以与并行 Adapter 并行。对于具有可训练参数的设置,作者分别使用时间基LoAA,其 Kernel 为且,以及带有前馈块的频率基LoAA,其 Kernel 为且,进行简单化比较。对于和参数设置,作者在这两个块中均使用了组合 Adapter ,其中 Bottleneck 维度分别为和。并行 Adapter 的参数设置为, Bottleneck 维度为。表2中的结果显示了几点关键洞察。

首先,通过应用作者的PEFT方法,图像预训练模型可以在与专用音频模型相当的性能上达到目标。特别地,在EPIC-SOUNDS数据集上,作者的方法在所有检查的参数设置(,和)中均优于SSAST,并在另外两个基准测试中取得了几乎相同的结果,性能差异不到。

此外,由于作者的方法具有以音频为中心的架构,因此在性能上超越了以前的方法。与具有相同参数数量的并行 Adapter 相比,作者的方法在所有基准测试中的表现更为优异。这表明作者提出的能够在时间和频率域中实现Token级交互的方法,有效地弥合了音频和图像数据之间的差距。

4. Discussions

4.1. What is the optimal combination of Look-Aside Adapter modules for a transformer-based model?

最近的研究工作[24, 25]实证表明,并行插入优于传统的序列插入。虽然这些工作将并行 Adapter 与其他PEFT方法(如LoRA和前缀调谐)结合使用以实现高性能,本方法仅采用并行 Adapter 架构。

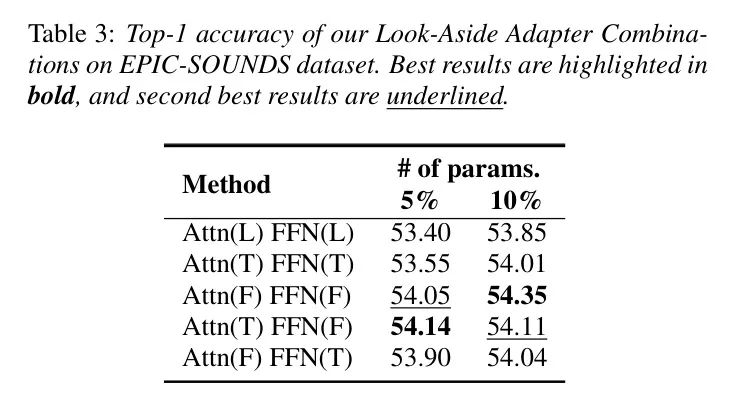

作者研究了基于时间的LoAA ( 核)与基于频率的LoAA ( 核)的各种组合,并将它们用作并行 Adapter 。表3展示了注意力块(Attn)和FFN块(Front-End Feed-Forward Network)的不同设计选择。当参数数量为5%时,表明具有更高的参数效率,基于时间的LoAA用于注意力块,而基于频率的LoAA用于FFN块是最佳选择。

4.2. What is the effect of fine-tuning by an audio friendly adapter?

虽然一般的PEFT方法应当学习领域特定和任务特定的知识,作者的PEFT方法还应同时学习不同模态之间的差异。为了高效地将知识从不同模态中转移出来,作者引入了一种新的 Adapter 架构,并且该架构对音频数据具有归纳偏置。

在模型中插入一个音频友好的 Adapter 可以影响注意力机制,基于音频梅尔频谱图的特征,这可能会导致更平滑的注意力图。音频友好的 Adapter 可以通过引入专门为下游任务微调的额外参数,来细化模型对音频梅尔频谱图中相关部分的关注。这一微调过程可以帮助模型更好地区分频率-时间维度中更为重要和不太重要的特征,从而导致更平滑且更加集中的注意力分布。

4.2.1.VisualizationofAttentionMap

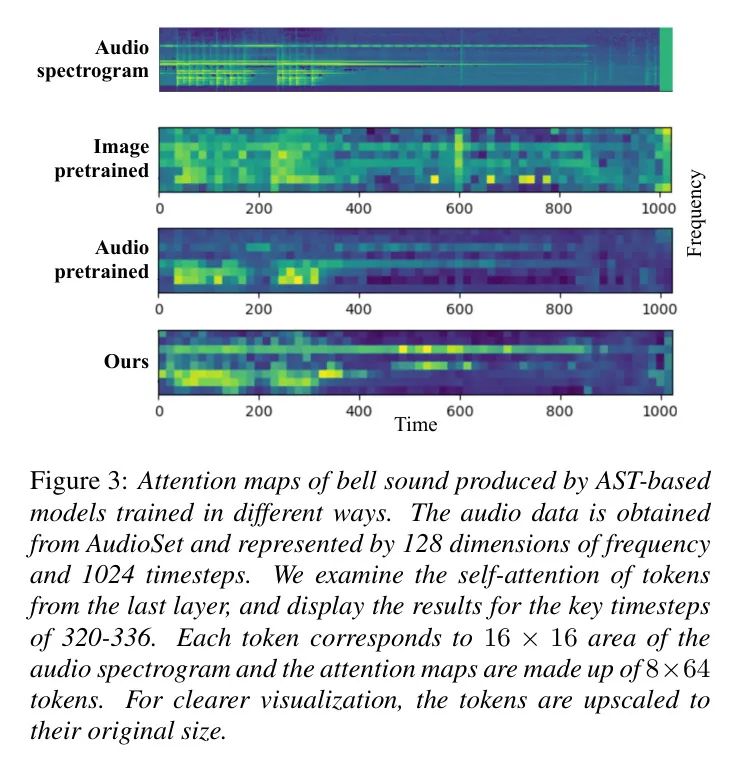

作者在图3中可视化了铃声的Mel频谱图,并在每个训练阶段的关键时间步长展示了注意力图。仅使用ImageNet预训练权重时,注意力图聚焦于铃声Mel频谱图的主要部分,但同时也较为嘈杂。

为解决这一问题,大规模音频预训练模型能够更好地关注音频数据中的重要方面,从而减少总体噪声。经过大规模音频预训练后,生成的注意力图显示出整体噪声显著减少的趋势,并倾向于关注真正对音频分类至关重要的Token。

然而,与依赖大量音频预训练不同,使用 Look-Aside Adapter(作者的方法)基本上可以减少整体噪声并给予更高的关注,不仅集中在梅尔频谱图特征显著的重要区域,还能注意到更精细的细节,同时实现高效性。

5. Conclusion

传统的两阶段范式从预训练的视觉模型开始,通过大规模音频预训练并随后进行任务特定的微调来学习下游任务所需的音频特异性知识。

然而,这由于需要大量的音频数据和精心设计的大规模音频预训练学习目标而颇具挑战性。本研究提出通过直接使用作者并行的旁路 Adapter (LoAA)对视觉模型进行微调,从而绕过预训练阶段。这种方法能够使图像模型的知识在一步之内高效地传递到音频下游任务中。

作者的方法在EPIC-SOUNDS数据集上优于预训练的音频模型,并且在多个其他音频和语音数据集上也取得了可比拟的结果。

在未来的工作中,通过对图像与音频数据模态间的独特差异进行深入研究,作者旨在构建一个具有模态特定编码器的新颖多模态框架。

参考

[0]. When Vision Models Meet Parameter Efficient Look-Aside Adapters Without Large-Scale Audio Pretraining .