2025:生成式AI如何重塑服务器市场

2025:生成式AI如何重塑服务器市场

问题意识

1. AI服务器市场与技术升级:2024-2025年AI服务器市场将大幅增长,NVIDIA和AMD在高端GPU及先进封装技术(如CoWoS、HBM)上的投入推动出货量,但如何协调需求增长与技术产能扩展是关键挑战。

2. CSPs自研与外部依赖的平衡:AWS和Google等CSPs在自研ASIC以降低成本的同时,仍依赖NVIDIA等供应商。如何平衡自研与外部芯片采购,决定其市场竞争力。

3. 竞争格局与技术标准演变:NVIDIA的Blackwell平台推动对CoWoS和HBM3e的需求,但能否在技术差异中确立行业标准,将影响2025年后的市场走势。

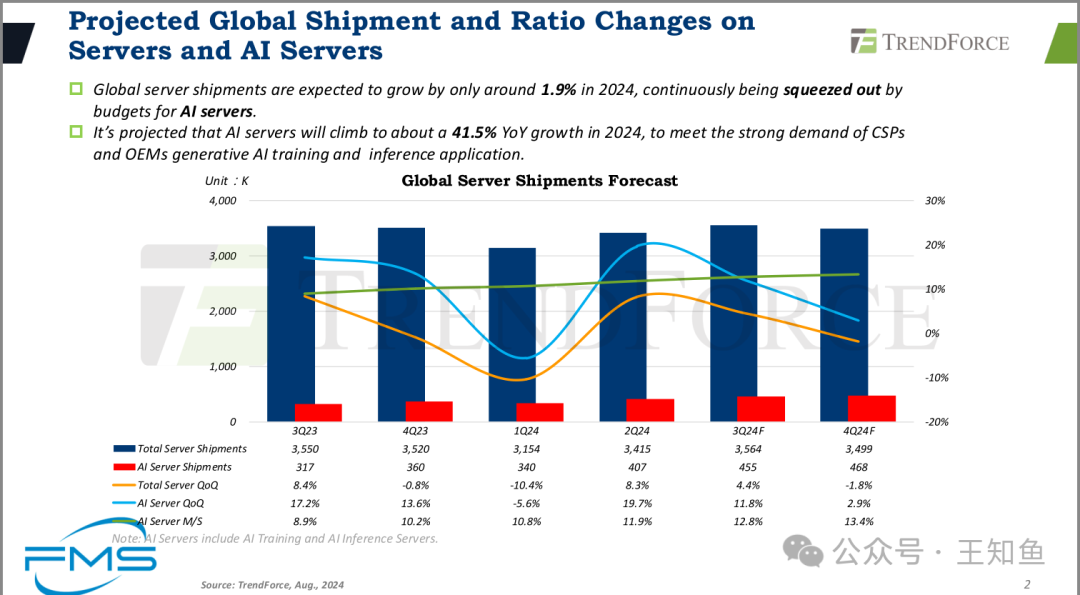

全球服务器出货量与AI服务器比例变化预测

- • 全球服务器出货量预计在2024年仅增长约1.9%,预算持续向AI服务器倾斜。

- • 预计2024年AI服务器出货量将同比增长约41.5%,以满足云服务提供商(CSPs)和原始设备制造商(OEMs)对生成式AI训练和推理应用的强劲需求。

- • AI服务器市场占比超10%,且逐渐增加

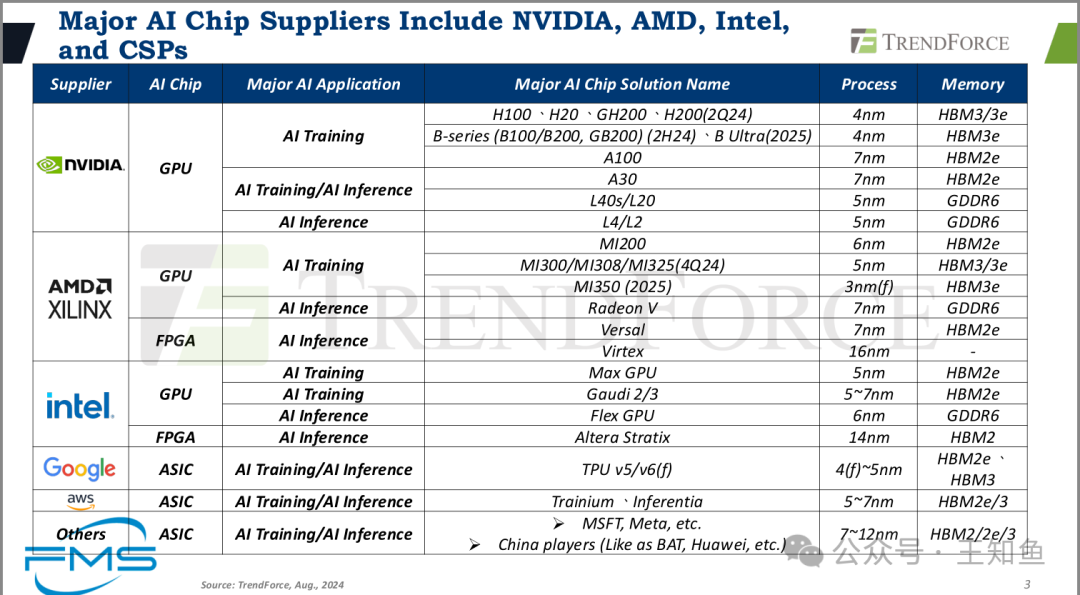

AI处理器供应商及GPU方案参数

“3nm(f)”中的“f”通常指的是finFET(鳍式场效晶体管,Fin Field-Effect Transistor)。这是一种用于构建半导体器件的技术。

背景解释:

- • FinFET是一种三维结构的晶体管设计,与传统的平面型MOSFET不同,它采用了垂直的鳍状结构,这样能更好地控制电流泄漏,提升性能和降低功耗。

- • 在先进的半导体工艺中,如3nm节点,finFET技术通常用来提高晶体管密度和能效。

因此,“3nm(f)”中的“f”意味着该制程节点使用了finFET技术,与其区别的是更先进的技术,如GAA(环绕栅极),它将可能出现在未来的节点中,比如3nm GAA或2nm制程。

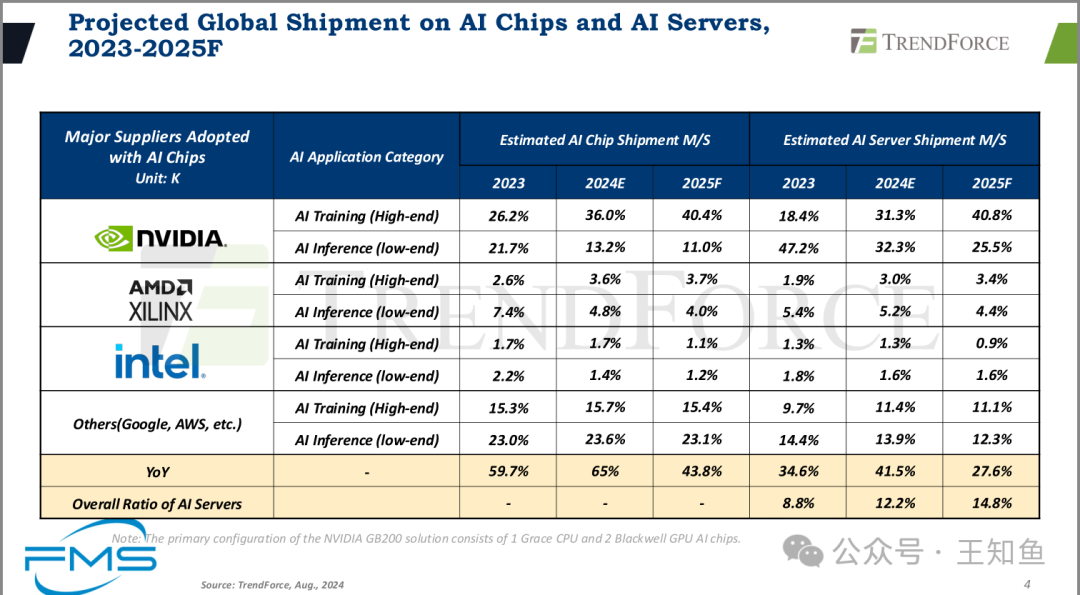

AI处理器供应商:Nvidia/AMD/intel/CSPs 市场出货量占比。

- • AI 专用处理器,在23-25年持续保持高速增长,年增长率分别:59.7%、65%和43.8%。

- • 其中Nvidia市占率最高,并将大概率维持正增长;其次独立厂商为AMD和Intel;CSP根据自己业务优化的AI加速器,在toB市场上并不火热,但因自身就是巨头,因此分量不容小觑。

Note:前两条的新闻,Intel(x86)和AMD(x64)就X86指令集的封闭痼疾展开合作,希望在未来几年打通intel和AMD处理器之间的兼容性[1]。很明显这是为将来通用计算统一生态奠定基础。

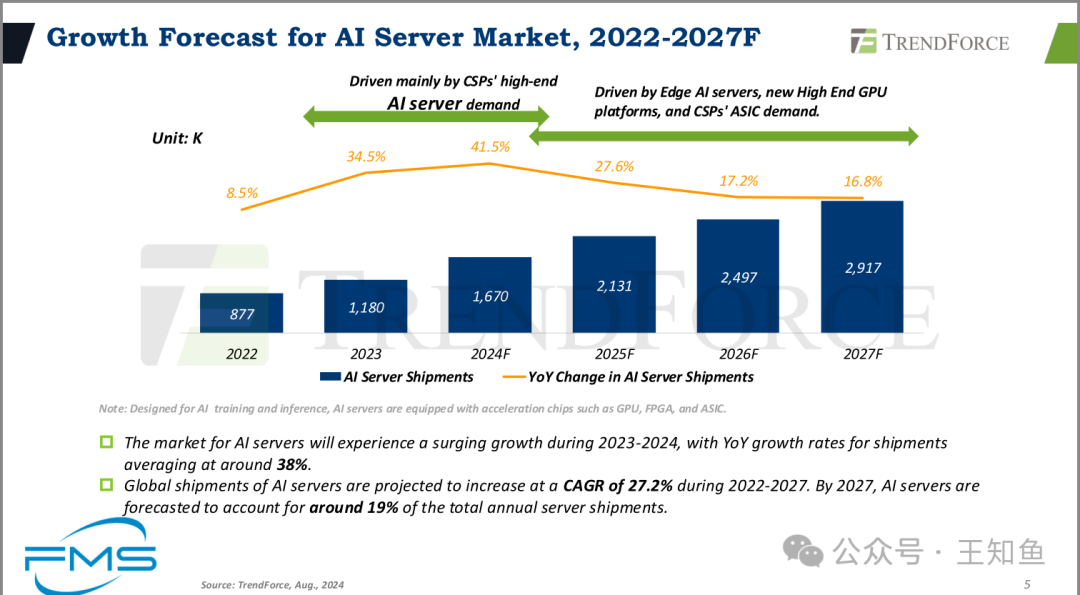

2022-2027年AI服务器市场增长预测

- • 2022-2024 AI服务器需求 主要由云服务提供商(CSPs)的高端需求驱动。

云厂商在AI业务浪潮中领先几个身位,是由其规模和客户需求相互成就,推动LLM的快速发展,越大的模型越需要高端AI服务器。

- • 2025-2027 预测未来的驱动因素 包括边缘AI服务器、新的高端GPU平台以及CSPs的ASIC需求。

随着AI业务向其他行业渗透,对数据实时性的追求,将促使边缘AI(特征工程)成为数据智能的基石,边缘AI对算力的要求并不高。

- • AI服务器市场 在2023年至2024年期间预计将经历快速增长,年均增速约为38%。

- • 全球AI服务器出货量 预计在2022年至2027年期间将以27.2%的年均复合增长率(CAGR) 增长。

- • 到2027年,AI服务器预计将占全球年度服务器出货量的约19%。

- AI服务器市场 在2023年至2024年期间预计将经历快速增长,年均增速约为38%。

- 全球AI服务器出货量 预计在2022年至2027年期间将以27.2%的年均复合增长率(CAGR) 增长。

- 到2027年,AI服务器预计将占全球年度服务器出货量的**约19%**。

高端芯片的产能焦虑

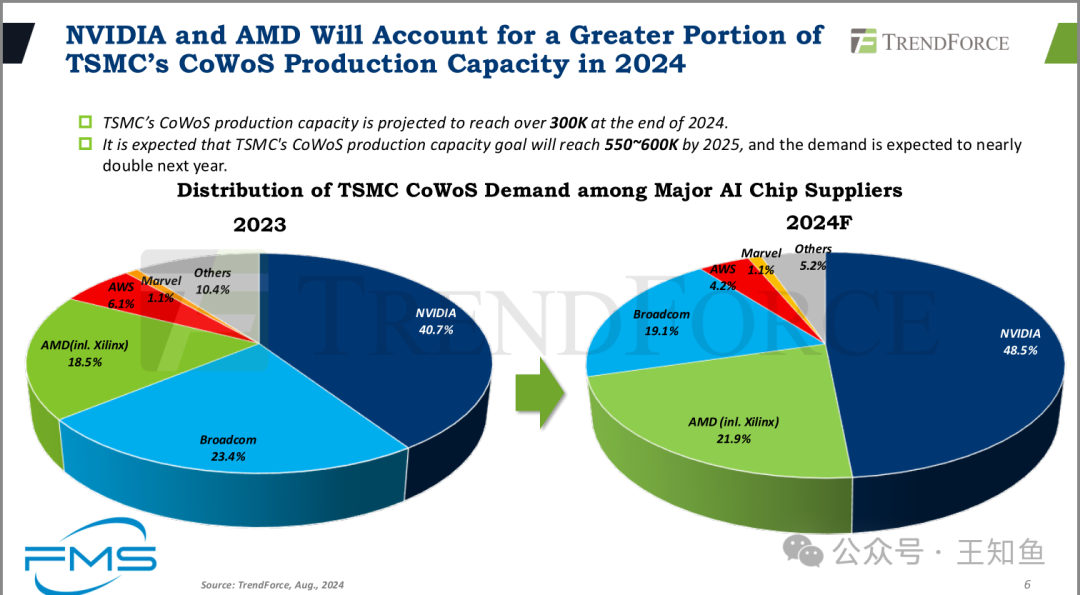

NVIDIA和AMD将在2024年占据TSMC CoWoS产能的更大份额

- • TSMC的CoWoS(Chip-on-Wafer-on-Substrate)产能预计在2024年底将达到超过30万片。

- • 预计TSMC的CoWoS产能目标将在2025年达到55万到60万片,并且明年需求预计几乎翻倍。

Note:NV和AMD将持续挤压其他厂商的先进制程产能。

关于CoWoS

CoWoS技术可以将处理器芯片(如GPU或ASIC)和多个HBM芯片在一个封装内进行集成,从而实现更高的数据传输速率和更低的延迟。CoWoS产能通常与生产和封装包括芯片(如GPU、AI加速器)和HBM相关的能力有关。

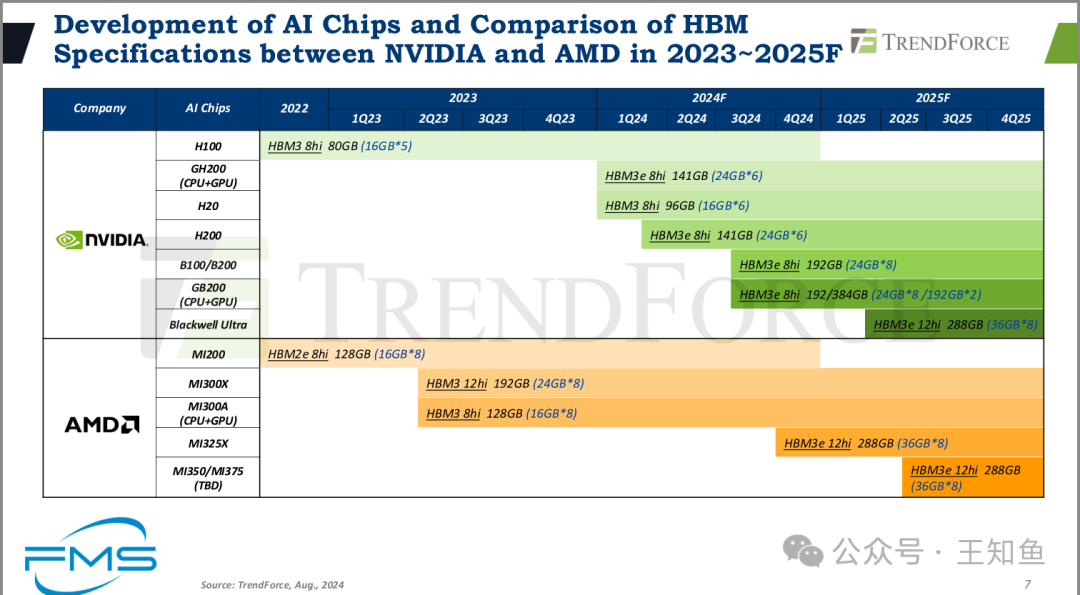

图片比较了NV和AMD两家高端训练AI芯片的HBM集成情况。

整体来看,NVIDIA和AMD的HBM存储容量逐年增长,新的HBM3e技术在2024年开始逐渐普及。AI芯片的存储需求在不断上升,主要是为了应对高性能计算和AI训练任务日益增长的带宽需求。

关于HBM的堆叠层数(8/12 hi)

- • HBM是一种3D堆叠内存技术,通过垂直堆叠多层DRAM芯片并通过硅通孔(TSV)进行连接,以实现更高的带宽和更低的功耗。

- • 8Hi或者12Hi表示HBM内存模块内部的芯片堆叠层数。例如,8Hi表示有8层芯片堆叠在一起,而12Hi则表示有12层。

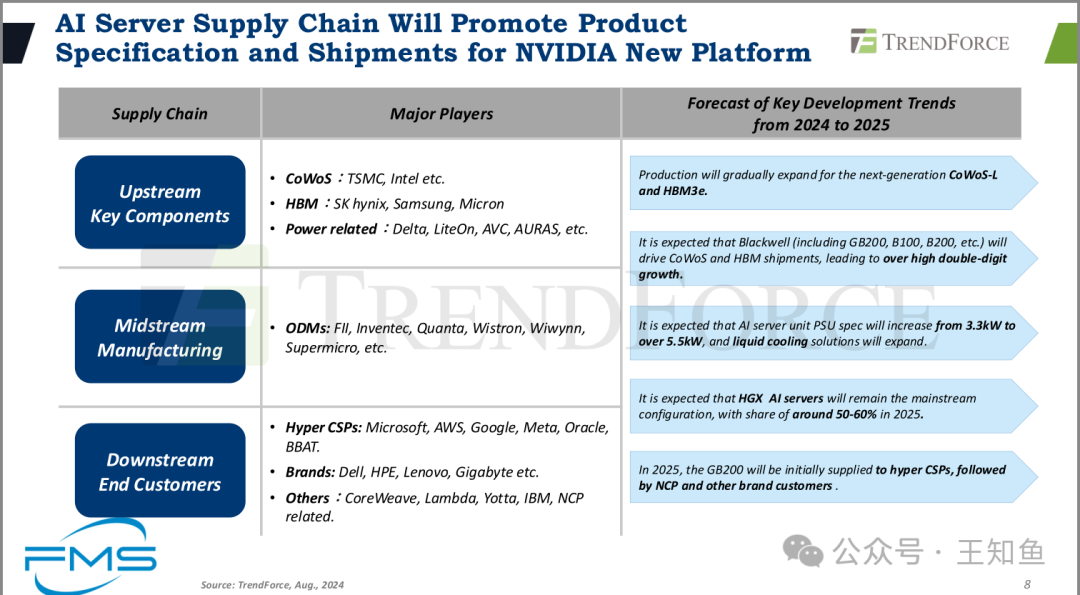

AI服务器产业链一览

上游:元器件厂商,核心在于先进封装技术(CoWoS产能)及HBM

中游:设备制造厂商,关注用户场景和方案集成

下游:终端客户,云厂商/OEMS/新兴实力

趋势

- • 生产将逐步扩展到下一代CoWoS-L和HBM3e。

- • 预计Blackwell(包括GB200、B100、B200等)将推动CoWoS和HBM的出货量,实现高双位数的增长。

- • 预计AI服务器单元的电源规格将从3.3kW增加到超过5.5kW,液冷解决方案将扩展。

- • 预计HGX AI服务器将继续作为主流配置,到2025年市场占有率将达到50%-60%。

- • 在2025年,GB200将首先供应给超大规模云服务提供商(Hyper CSPs),然后是NCP和其他品牌客户。

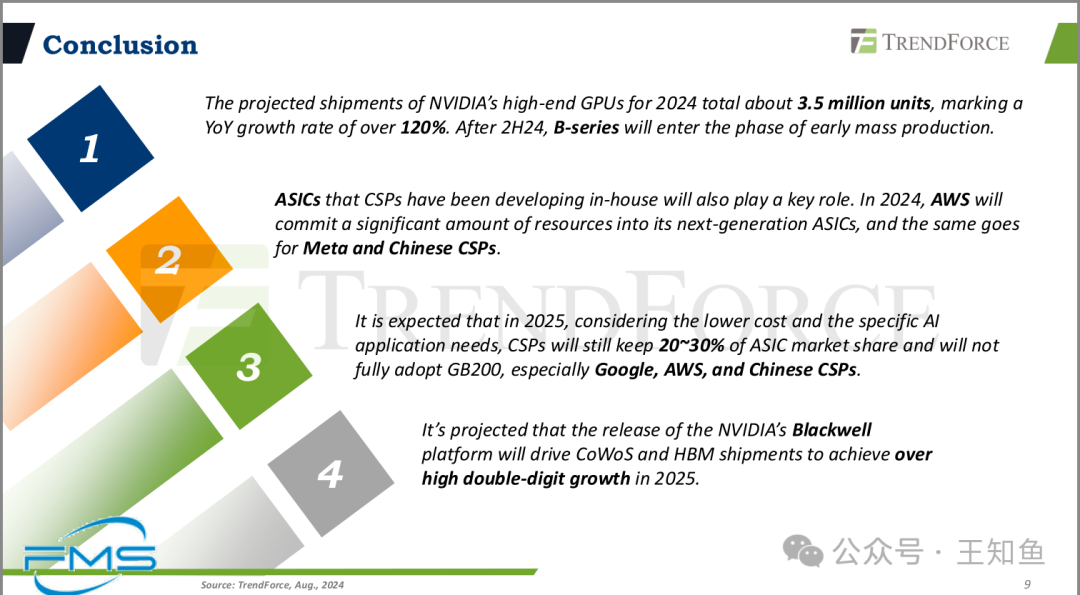

总结

- • 2024年NVIDIA高端GPU的出货量预计总计约350万台,年增长率超过120%。在2024年下半年,B系列将进入早期量产阶段。

- • CSPs(云服务提供商)自主开发的ASICs也将发挥关键作用。2024年,AWS将投入大量资源于其下一代ASICs中,Meta和中国的云服务提供商也同样如此。

- • 预计到2025年,考虑到较低的成本和特定AI应用需求,CSPs仍将保持20~30%的ASIC市场份额,并且不会完全采用GB200,尤其是Google、AWS和中国的云服务提供商。

- • 预计NVIDIA的Blackwell平台发布将推动CoWoS和HBM的出货量,并在2025年实现高双位数的增长。

引用链接

[1] 打通intel和AMD处理器之间的兼容性: http://url.trylab.site/iRD_7MPV