AI大模型之争!无法“作弊”的LiveBench榜单公布,GPT-4o第一,国产Qwen2上榜

AI大模型之争!无法“作弊”的LiveBench榜单公布,GPT-4o第一,国产Qwen2上榜

业内“常规操作”的做法是将大模型送去各大权威基准测试中“刷成绩”,得分越高,越能证明模型的实力。这样的做法显然失去了真实性,最用户造成误导!

那么,如何才能真正评估大模型的能力呢?

6月13日,AbacusAI宣布与AI领域的大咖杨立昆(Yann LeCun)、英伟达等团队合作推出LiveBench AI,号称“全球首个无法作弊的LLM基准测试”。

LiveBench评判方法

LiveBench目前涵盖18个任务,分布在六大类别:数学、编码、推理、语言理解、指令执行和数据分析。每个任务都属于以下两种类型之一:

一种是基于信息源的问题,例如最近Kaggle数据集上的数据分析问题或修复最新arXiv摘要中的拼写错误;

另一种是现有基准任务的更具挑战性或更为多样化的版本,例如来自Big-Bench Hard、IFEval、bAbI或AMPS的任务。具体类别和任务如下:

数学

包含过去12个月的高中数学竞赛问题(如AMC12、AIME、USAMO、IMO、SMC)以及更难版本的AMP问题。

编码

包括通过LiveCodeBench从Leetcode和AtCoder生成的代码问题,以及一个新的代码完成任务。

推理

涵盖了Big-Bench Hard中的Web of Lies的更难版本、bAbI中的PathFinding的更难版本,以及Zebra Puzzles。

语言理解

包含三个任务:Connection单词谜题、拼写修正任务和电影梗概重组任务,所有这些任务均来自IMDb和Wikipedia上的最新电影。

指令执行

包括四个任务,要求释义、简化、总结或根据《卫报》的最新新闻文章编写故事,并且需遵循一到多个指令或在响应中加入特定元素。

数据分析

包含使用Kaggle和Socrata最新数据集的三个任务:表格转换(在JSON、JSONL、Markdown、CSV、TSV和HTML之间)、预测哪些列可以用来连接两个表格,以及预测数据列的正确类型注释。

通过这种综合方法,LiveBench能够有效评估大型语言模型在不同任务中的表现,确保评估结果的公平性和可靠性。

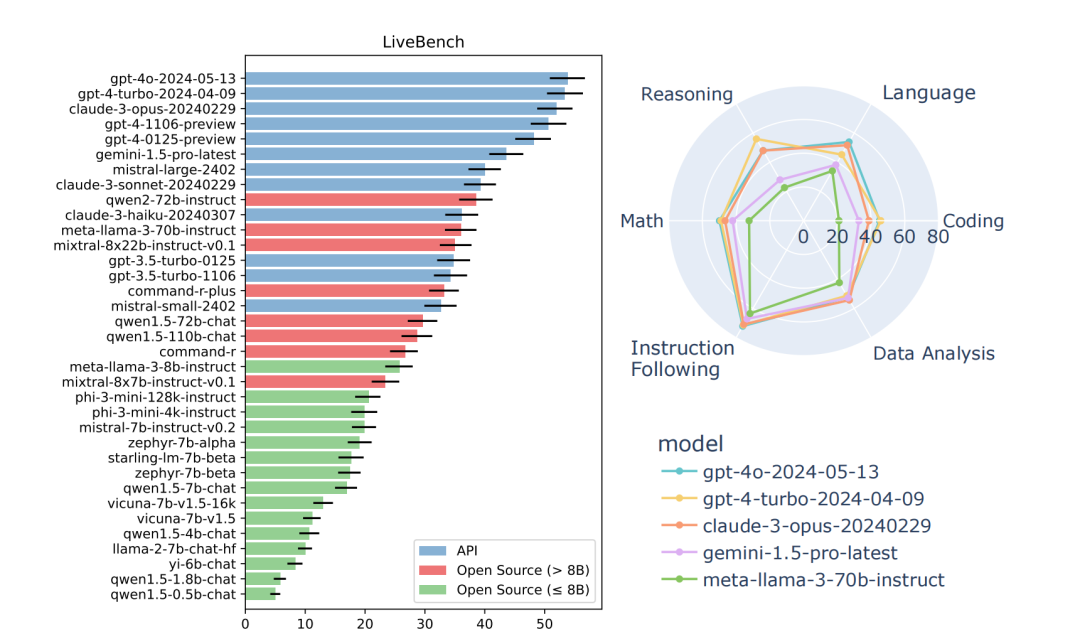

第一批成绩单

LiveBench目前评估了多款知名的闭源模型以及数十个从0.5B到70B不等的开源模型,总计34个。

综合排名及特点优势

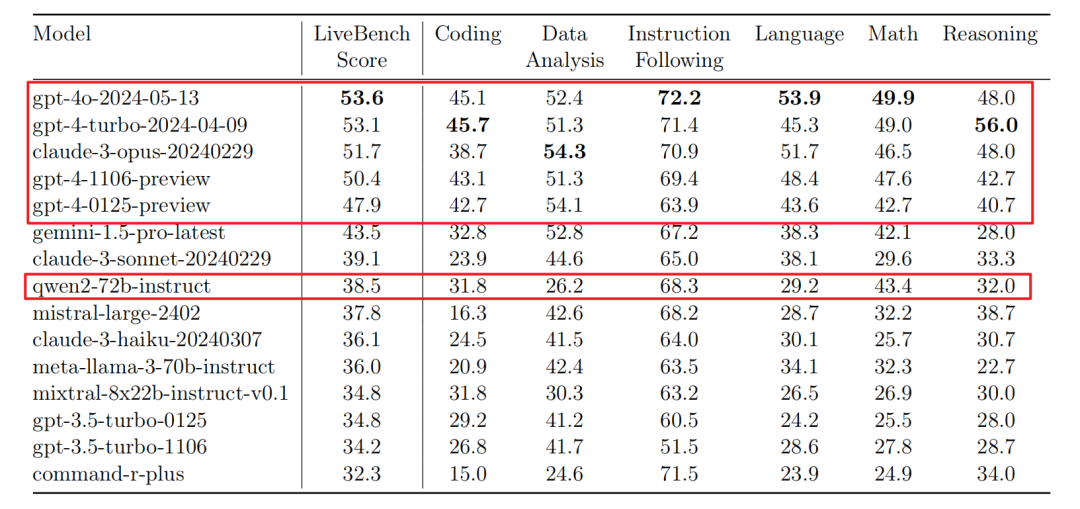

根据LiveBench的评测结果,以下是各个模型的综合排名情况:

1. gpt-4o:总体得分为53.6,表现全面,无论是数学、编程还是推理任务,均能稳定发挥,是目前综合表现最好的模型。

2. gpt-4-turbo:得分为53.1,特别擅长推理和编程任务,在这些类别中表现尤为突出,定量推理能力也很强。

3. claude-3-opus:得分为51.7,在语言理解和指令执行任务中有较强的表现,适用于需要复杂语言处理和执行任务的应用场景。

4. gpt-4-1106-preview:得分为50.4,数据分析能力强,能够处理复杂的数据集和进行深度分析。

5. gpt-4-0125-preview:得分为47.9,在编程任务中表现出色,能够解决复杂的编程问题,且在指令执行方面也有不错的表现。

评分结果跟大家的感知差不多,ChatGPT仍然处于遥遥领先的地位,TOP5中有4个模型来自于Openai。

GPT-4o的综合表现最佳,其次是gpt-4-turbo和claude-3。唯一上榜的国产模型是qwen2-72b-instruct,同时也是表现最好的开源模型。

GPT-4-turbo:在推理类别中表现最优,超出第二名模型8%。在编程类别中,GPT-4系列模型表现最优,这与最近的研究结果一致 。gpt-4-turbo在编码、数据分析、数学和推理等定量推理任务上平均表现最佳 。