基于Transformer的高效推理优化技术详解

基于Transformer的高效推理优化技术详解

安全风信子

发布于 2025-11-16 11:40:23

发布于 2025-11-16 11:40:23

引言

Transformer架构自2017年提出以来,已经成为自然语言处理、计算机视觉、语音识别等多个领域的主导模型架构。然而,随着模型规模的不断扩大和应用场景的多样化,Transformer模型在推理阶段面临着巨大的计算和内存挑战。为了解决这些问题,研究人员提出了各种高效推理优化技术,旨在在保证模型性能的同时,降低计算复杂度、减少内存占用、加速推理速度。

本文将全面解析2025年基于Transformer的高效推理优化技术的最新进展,包括计算优化、内存优化、模型压缩、量化技术、并行计算和专用硬件加速等方面。通过对这些技术的深入分析,帮助读者了解当前Transformer高效推理的前沿动态,为实际应用中的模型部署提供参考。

目录

章节 | 内容 | 可视化 |

|---|---|---|

1 | Transformer模型的推理挑战 | 计算复杂度分析图 |

2 | 计算优化技术 | 注意力机制优化图 |

3 | 内存优化策略 | 内存占用分析图 |

4 | 模型压缩方法 | 压缩效果对比图 |

5 | 量化技术与实践 | 量化精度对比图 |

6 | 并行计算加速 | 并行策略图 |

7 | 专用硬件与编译器优化 | 硬件加速架构图 |

8 | 自适应推理机制 | 自适应流程图表 |

9 | 多模态融合推理优化 | 多模态融合架构图 |

10 | 未来发展趋势与挑战 | 技术发展路线图 |

mindmap

root((Transformer高效推理))

推理挑战

计算优化

内存优化

模型压缩

量化技术

并行计算

专用硬件

自适应推理

多模态融合

未来趋势一、Transformer模型的推理挑战

1.1 计算复杂度分析

Transformer模型的计算复杂度主要来自于自注意力机制和前馈网络,具体分析如下:

- 自注意力机制:

- 计算复杂度:O(L²·d),其中L是序列长度,d是模型维度

- 主要操作:Q、K、V的线性变换,点积计算,softmax归一化,加权求和

- 计算瓶颈:QK^T的矩阵乘法,复杂度为O(L²·d)

- 前馈网络:

- 计算复杂度:O(L·d²),其中L是序列长度,d是模型维度

- 主要操作:两个线性变换,激活函数应用

- 计算瓶颈:高维特征的线性变换,复杂度为O(L·d²)

- 层归一化:

- 计算复杂度:O(L·d)

- 主要操作:均值和方差计算,线性变换

- 位置编码:

- 计算复杂度:O(L·d)

- 主要操作:位置编码的生成和添加

graph TD

A[Transformer计算复杂度]

A --> B[自注意力机制]

A --> C[前馈网络]

A --> D[层归一化]

A --> E[位置编码]

B -- 复杂度 --> B1[O(L²·d)]

B -- 瓶颈 --> B2[QK^T矩阵乘法]

C -- 复杂度 --> C1[O(L·d²)]

C -- 瓶颈 --> C2[高维特征线性变换]

D -- 复杂度 --> D1[O(L·d)]

E -- 复杂度 --> E1[O(L·d)]1.2 内存占用分析

Transformer模型在推理阶段的内存占用主要包括以下几个部分:

- 模型参数:

- 主要包括:自注意力机制的权重,前馈网络的权重,层归一化的参数

- 内存占用:O(d²),其中d是模型维度

- 大型模型(如GPT-4)的参数可达到数千亿,需要数十GB内存

- 激活值:

- 主要包括:各层的输入输出特征,注意力分数,中间计算结果

- 内存占用:O(B·L·d),其中B是批次大小,L是序列长度,d是模型维度

- 长序列推理时,激活值可能成为内存瓶颈

- 缓存:

- 主要包括:KV缓存,用于加速自回归生成

- 内存占用:O(B·L·d·H),其中B是批次大小,L是序列长度,d是模型维度,H是头数

- 多轮对话场景下,缓存可能持续增长

- 临时缓冲区:

- 主要包括:矩阵乘法的中间结果,softmax的中间结果等

- 内存占用:O(B·L²·H),其中B是批次大小,L是序列长度,H是头数

1.3 延迟与吞吐量挑战

Transformer模型在实际应用中面临的延迟与吞吐量挑战主要包括:

- 推理延迟:

- 自回归生成场景下,每个token的生成都需要前一个token的结果,导致延迟累加

- 长序列处理时,注意力机制的计算复杂度呈平方增长,导致延迟显著增加

- 低延迟应用场景(如实时对话系统)对推理速度要求极高

- 吞吐量:

- 批处理大小受到内存限制,影响整体吞吐量

- 不同长度的序列混合批处理时,可能导致计算资源利用率降低

- 服务部署时,需要在延迟和吞吐量之间进行权衡

- 资源效率:

- 计算资源利用率:GPU/TPU等硬件的计算单元利用率不高

- 内存访问效率:内存访问模式不优,导致内存带宽成为瓶颈

- 能耗效率:大型模型的推理能耗高,不适合移动设备等资源受限场景

1.4 部署场景多样性

Transformer模型的部署场景日益多样化,不同场景有不同的优化需求:

- 云服务部署:

- 特点:计算资源丰富,内存容量大,可扩展性强

- 优化重点:高吞吐量,资源利用率,多用户并发

- 边缘设备部署:

- 特点:计算资源有限,内存容量小,能耗受限

- 优化重点:模型压缩,量化,低内存占用

- 移动设备部署:

- 特点:电池容量有限,计算能力相对较弱,内存小

- 优化重点:极低延迟,低能耗,模型轻量化

- 嵌入式设备部署:

- 特点:硬件资源极其有限,实时性要求高

- 优化重点:极致压缩,专用硬件加速,任务特定优化

二、计算优化技术

2.1 注意力机制优化

注意力机制是Transformer模型的核心组件,也是计算优化的重点对象。2025年的注意力机制优化技术主要包括:

- 稀疏注意力:

- 局部注意力(Local Attention):限制注意力范围,只关注局部窗口

- 带状注意力(Band Attention):对角线附近的带状区域注意力

- 随机注意力(Random Attention):随机采样部分token进行注意力计算

- 组合注意力(Sparse Combination):结合多种稀疏模式

- 线性注意力:

- 核函数近似:使用低秩核函数近似点积注意力

- 特征分解:对QK^T进行特征分解,降低计算复杂度

- 投影优化:通过投影将注意力计算转换为线性复杂度

- 多头注意力优化:

- 头分组:将多个头分成组,共享部分计算

- 头融合:将多个头的信息融合,减少计算量

- 自适应头数:根据输入动态调整使用的头数

- 长序列优化:

- 分层注意力:对长序列进行分层处理

- 递归注意力:利用递归结构处理长序列

- 滑动窗口:使用滑动窗口机制处理超长序列

以下是一个局部注意力机制的实现示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

class LocalAttention(nn.Module):

def __init__(self, d_model, num_heads, window_size=64, dropout=0.1):

super().__init__()

self.d_model = d_model

self.num_heads = num_heads

self.d_k = d_model // num_heads

self.window_size = window_size

self.q_linear = nn.Linear(d_model, d_model)

self.k_linear = nn.Linear(d_model, d_model)

self.v_linear = nn.Linear(d_model, d_model)

self.out_linear = nn.Linear(d_model, d_model)

self.dropout = nn.Dropout(dropout)

def forward(self, q, k, v, mask=None):

batch_size = q.size(0)

seq_len = q.size(1)

# 线性变换

q = self.q_linear(q).view(batch_size, seq_len, self.num_heads, self.d_k).transpose(1, 2)

k = self.k_linear(k).view(batch_size, seq_len, self.num_heads, self.d_k).transpose(1, 2)

v = self.v_linear(v).view(batch_size, seq_len, self.num_heads, self.d_k).transpose(1, 2)

# 计算局部注意力

# 为每个位置创建局部窗口

output = []

for i in range(0, seq_len, self.window_size):

end_idx = min(i + self.window_size, seq_len)

# 获取当前窗口的q, k, v

q_window = q[:, :, i:end_idx, :]

k_window = k[:, :, i:end_idx, :]

v_window = v[:, :, i:end_idx, :]

# 计算注意力分数

scores = torch.matmul(q_window, k_window.transpose(-2, -1)) / torch.sqrt(torch.tensor(self.d_k, dtype=torch.float32))

# 应用mask(如果有的话)

if mask is not None and mask.shape[2] == seq_len:

mask_window = mask[:, i:end_idx, i:end_idx].unsqueeze(1)

scores = scores.masked_fill(mask_window == 0, -1e9)

# softmax归一化

attn = F.softmax(scores, dim=-1)

attn = self.dropout(attn)

# 计算注意力加权和

context = torch.matmul(attn, v_window)

output.append(context)

# 拼接所有窗口的结果

output = torch.cat(output, dim=2)

# 输出线性变换

output = output.transpose(1, 2).contiguous().view(batch_size, seq_len, self.d_model)

output = self.out_linear(output)

return output

# 使用示例

# local_attn = LocalAttention(d_model=768, num_heads=12, window_size=64)

# output = local_attn(q, k, v, mask)2.2 前馈网络优化

前馈网络是Transformer模型的另一个计算密集型组件,2025年的前馈网络优化技术主要包括:

- 低秩分解:

- 矩阵分解:将大矩阵分解为多个小矩阵的乘积

- MoE结构:Mixture of Experts,根据输入动态选择部分专家

- 稀疏激活:只激活部分神经元,减少计算量

- 激活函数优化:

- 高效激活函数:如GeLU的近似版本,减少计算复杂度

- 量化激活:降低激活值的精度,减少计算量

- 自适应激活:根据输入动态调整激活函数参数

- 归一化层优化:

- 层归一化变体:如LayerNorm的高效实现

- 批量归一化融合:将归一化层与相邻层融合,减少计算量

- 简化归一化:在某些场景下简化或移除归一化层

- 网络结构优化:

- 瓶颈结构:使用瓶颈结构减少参数量和计算量

- 残差连接优化:优化残差连接的计算方式

- 分层设计:根据任务需求设计不同复杂度的层

2.3 计算图优化

计算图优化是提升Transformer模型推理效率的重要手段,2025年的计算图优化技术主要包括:

- 算子融合:

- 矩阵乘法融合:将多个矩阵乘法操作融合为一个

- 层融合:将相邻的层(如线性变换+激活+归一化)融合为一个算子

- 注意力计算融合:将注意力机制的多个步骤融合为一个算子

- 内存访问优化:

- 数据布局优化:调整数据存储格式,提高内存访问效率

- 缓存优化:优化缓存使用策略,减少缓存未命中

- 预取技术:提前加载即将使用的数据,隐藏内存访问延迟

- 并行计算优化:

- 任务并行:将不同的计算任务分配到不同的处理单元

- 数据并行:将数据分成多个部分,并行处理

- 流水线并行:将计算流程分为多个阶段,流水线执行

- 编译优化:

- 静态调度:编译时确定计算调度策略

- 运行时优化:根据运行时状态动态调整优化策略

- 硬件感知优化:根据目标硬件特性进行针对性优化

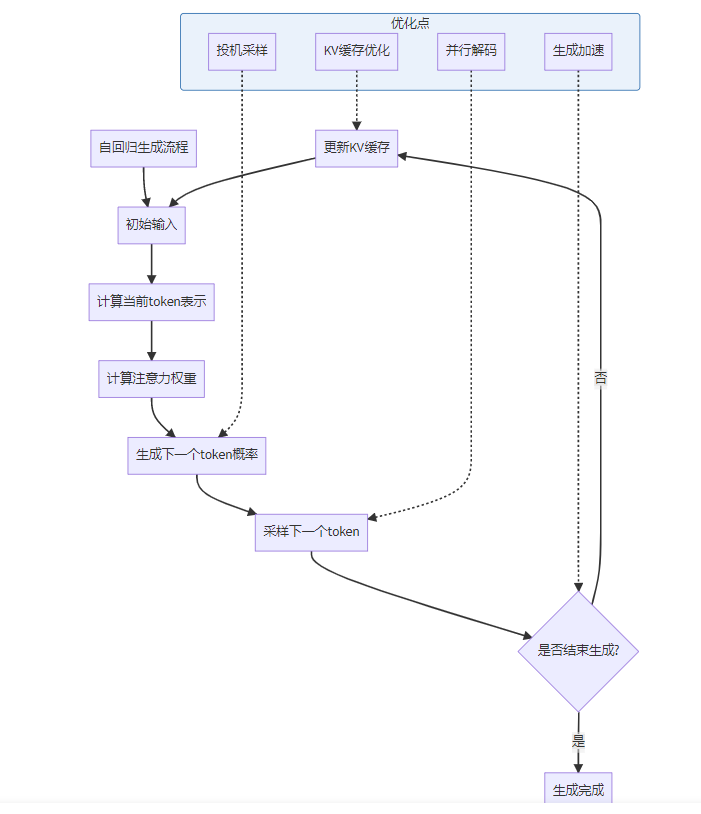

2.4 自回归生成优化

自回归生成是Transformer模型在生成式任务中的主要工作模式,2025年的自回归生成优化技术主要包括:

- KV缓存优化:

- 增量缓存:只存储和更新必要的KV对

- 缓存压缩:对缓存的KV对进行压缩,减少内存占用

- 缓存管理:根据需求动态管理缓存大小

- 并行解码:

- 束搜索并行化:并行处理多个候选序列

- 批处理优化:优化不同长度序列的批处理策略

- 异步解码:使用异步机制加速解码过程

- 生成加速:

- 早期退出:根据置信度提前终止生成过程

- 长度预测:提前预测生成序列的长度

- 自适应生成:根据内容复杂度动态调整生成策略

- 投机采样:

- 小模型引导:使用小模型引导大模型生成

- 多阶段生成:先快速生成草稿,再进行精修

- 混合精度生成:在不同阶段使用不同精度

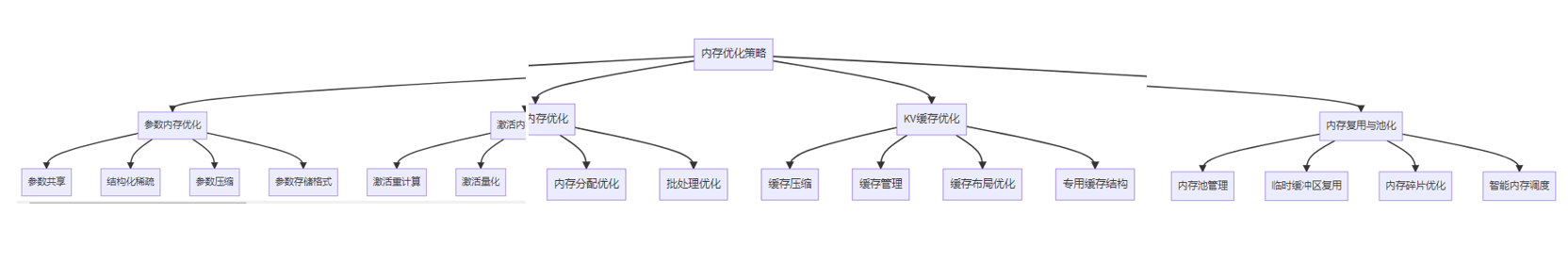

三、内存优化策略

3.1 参数内存优化

参数内存是Transformer模型内存占用的重要部分,2025年的参数内存优化技术主要包括:

- 参数共享:

- 层间参数共享:不同层之间共享参数

- 头间参数共享:多头注意力中不同头之间共享参数

- 模态间参数共享:多模态模型中不同模态之间共享参数

- 结构化稀疏:

- 剪枝:移除不重要的参数,形成稀疏结构

- 低秩分解:将密集矩阵分解为低秩矩阵的乘积

- 块稀疏:按照块结构组织稀疏参数,提高内存访问效率

- 参数压缩:

- 量化:降低参数精度,如INT8、FP16、甚至二值化

- 编码:使用更高效的参数编码方式

- 混合精度:不同部分使用不同精度的参数

- 参数存储格式:

- 压缩格式:使用专用的参数压缩存储格式

- 按需加载:根据需要动态加载参数,减少常驻内存

- 分布式存储:在多设备环境下分布式存储参数

3.2 激活内存优化

激活内存是Transformer模型在推理过程中临时占用的内存,2025年的激活内存优化技术主要包括:

- 激活重计算:

- 梯度检查点:在前向传播中不存储中间激活,反向传播时重新计算

- 选择性重计算:只重计算部分激活值,平衡计算和内存

- 自适应重计算:根据运行时状态动态调整重计算策略

- 激活量化:

- 动态量化:在运行时动态量化激活值

- 混合精度激活:不同部分使用不同精度的激活值

- 激活压缩:使用编码或压缩算法减少激活值的存储空间

- 内存分配优化:

- 内存池:使用内存池管理临时内存分配

- 内存复用:复用临时缓冲区,减少内存碎片

- 内存对齐:优化内存对齐方式,提高访问效率

- 批处理优化:

- 动态批处理:根据输入特征动态调整批处理大小

- 变长序列优化:优化变长序列的批处理方式

- 序列分块:将长序列分成小块处理,减少内存占用

3.3 KV缓存优化

KV缓存是Transformer自回归生成中的关键内存占用部分,2025年的KV缓存优化技术主要包括:

- 缓存压缩:

- 量化缓存:降低KV缓存的精度

- 低秩缓存:对KV缓存进行低秩近似

- 增量压缩:只存储和更新必要的KV信息

- 缓存管理:

- 缓存淘汰策略:当缓存达到容量上限时,淘汰部分缓存

- 缓存分区:将缓存分为多个区,优化管理

- 动态缓存大小:根据输入和设备内存动态调整缓存大小

- 缓存布局优化:

- 数据格式优化:优化KV缓存的数据存储格式

- 内存对齐:优化缓存的内存对齐方式

- 预分配策略:根据预测的序列长度预分配缓存

- 专用缓存结构:

- 硬件感知缓存:根据硬件特性设计专用的缓存结构

- 分级缓存:使用多级缓存结构,优化访问速度和容量

- 异步缓存:使用异步机制更新和访问缓存

以下是一个KV缓存管理的实现示例:

import torch

from collections import deque

class KVCacheManager:

def __init__(self, max_cache_size=None, cache_quantization=None):

self.max_cache_size = max_cache_size

self.cache_quantization = cache_quantization # 可选值: None, 'int8', 'fp16'

self.key_caches = {}

self.value_caches = {}

self.sequence_lengths = deque() # 用于LRU缓存管理

self.sequence_ids = set()

def _quantize_tensor(self, tensor):

if self.cache_quantization == 'int8':

# INT8量化

scale = tensor.abs().max() / 127

quantized_tensor = (tensor / scale).round().to(torch.int8)

return quantized_tensor, scale

elif self.cache_quantization == 'fp16':

# FP16量化

return tensor.to(torch.float16), None

else:

# 不量化

return tensor, None

def _dequantize_tensor(self, quantized_tensor, scale=None):

if self.cache_quantization == 'int8':

# INT8反量化

return quantized_tensor.to(torch.float32) * scale

elif self.cache_quantization == 'fp16':

# FP16反量化

return quantized_tensor.to(torch.float32)

else:

# 不需要反量化

return quantized_tensor

def add_sequence(self, sequence_id):

if sequence_id in self.sequence_ids:

# 如果序列已存在,先移除

self.remove_sequence(sequence_id)

# 检查缓存大小是否超过限制

if self.max_cache_size is not None and len(self.sequence_ids) >= self.max_cache_size:

# 移除最早的序列(LRU策略)

oldest_sequence_id = self.sequence_lengths.popleft()

self.remove_sequence(oldest_sequence_id)

# 为新序列创建空缓存

self.key_caches[sequence_id] = []

self.value_caches[sequence_id] = []

self.sequence_lengths.append(sequence_id)

self.sequence_ids.add(sequence_id)

def remove_sequence(self, sequence_id):

if sequence_id in self.sequence_ids:

del self.key_caches[sequence_id]

del self.value_caches[sequence_id]

self.sequence_ids.remove(sequence_id)

# 从deque中移除(效率不高,但为了简单起见)

if sequence_id in self.sequence_lengths:

self.sequence_lengths.remove(sequence_id)

def update_cache(self, sequence_id, key, value):

if sequence_id not in self.sequence_ids:

self.add_sequence(sequence_id)

# 量化并存储KV对

quantized_key, key_scale = self._quantize_tensor(key)

quantized_value, value_scale = self._quantize_tensor(value)

# 存储量化后的数据和缩放因子

self.key_caches[sequence_id].append((quantized_key, key_scale))

self.value_caches[sequence_id].append((quantized_value, value_scale))

def get_cache(self, sequence_id):

if sequence_id not in self.sequence_ids:

return None, None

# 获取缓存的KV对并反量化

keys = []

values = []

for quantized_key, key_scale in self.key_caches[sequence_id]:

keys.append(self._dequantize_tensor(quantized_key, key_scale))

for quantized_value, value_scale in self.value_caches[sequence_id]:

values.append(self._dequantize_tensor(quantized_value, value_scale))

# 拼接所有KV对

if keys:

concatenated_keys = torch.cat(keys, dim=1)

concatenated_values = torch.cat(values, dim=1)

return concatenated_keys, concatenated_values

else:

return None, None

def get_sequence_length(self, sequence_id):

if sequence_id not in self.sequence_ids:

return 0

return len(self.key_caches[sequence_id])

def clear_cache(self):

self.key_caches.clear()

self.value_caches.clear()

self.sequence_lengths.clear()

self.sequence_ids.clear()

# 使用示例

# kv_cache_manager = KVCacheManager(max_cache_size=100, cache_quantization='fp16')

#

# # 添加序列

# kv_cache_manager.add_sequence(sequence_id='user_123')

#

# # 更新缓存

# kv_cache_manager.update_cache(sequence_id='user_123', key=current_key, value=current_value)

#

# # 获取缓存

# cached_key, cached_value = kv_cache_manager.get_cache(sequence_id='user_123')3.4 内存复用与池化

内存复用与池化是提高内存使用效率的重要技术,2025年的内存复用与池化技术主要包括:

- 内存池管理:

- 静态内存池:预分配固定大小的内存池

- 动态内存池:根据需求动态调整内存池大小

- 分层内存池:根据不同类型的内存需求创建多个内存池

- 临时缓冲区复用:

- 算子内缓冲区复用:在一个算子内部复用临时缓冲区

- 跨算子缓冲区复用:在不同算子之间复用临时缓冲区

- 跨层缓冲区复用:在不同层之间复用临时缓冲区

- 内存碎片优化:

- 内存分配对齐:按照特定大小对齐内存分配,减少碎片

- 内存合并:定期合并小的空闲内存块

- 内存压缩:压缩内存使用,减少碎片影响

- 智能内存调度:

- 预测性内存分配:根据历史使用模式预测内存需求

- 动态内存迁移:在不同存储层次之间动态迁移数据

- 按需内存释放:及时释放不再使用的内存

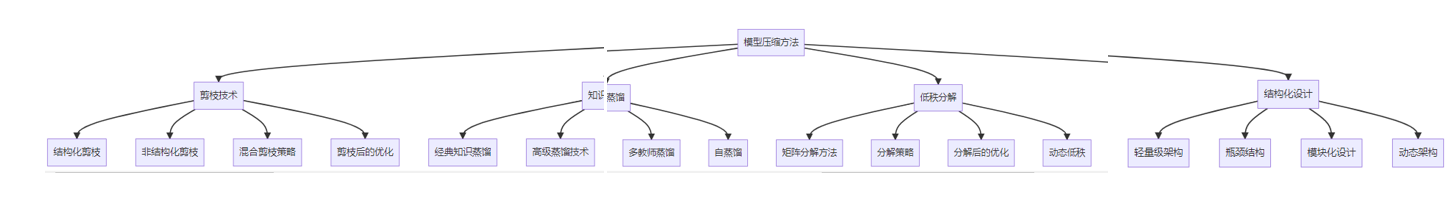

四、模型压缩方法

4.1 剪枝技术

剪枝是一种通过移除模型中不重要的参数来压缩模型的技术,2025年的剪枝技术主要包括:

- 结构化剪枝:

- 通道剪枝:剪枝整个通道或过滤器

- 头剪枝:剪枝多头注意力中的整个头部

- 层剪枝:剪枝整个层或块

- 结构化稀疏模式:设计特定的稀疏模式,如块稀疏、行稀疏等

- 非结构化剪枝:

- 权重剪枝:单独剪枝每个权重参数

- 梯度剪枝:基于梯度信息进行剪枝

- 动态剪枝:在推理过程中动态确定剪枝策略

- 混合剪枝策略:

- 分层剪枝:不同层使用不同的剪枝比例

- 迭代剪枝:多次剪枝和微调的迭代过程

- 敏感度感知剪枝:根据层的敏感度调整剪枝比例

- 剪枝后的优化:

- 微调恢复:剪枝后进行微调,恢复模型性能

- 重参数化:剪枝后对模型进行重参数化,提高效率

- 编译优化:针对剪枝后的模型结构进行编译优化

以下是一个通道剪枝的实现示例:

import torch

import torch.nn as nn

import torch.nn.utils.prune as prune

import numpy as np

class ChannelPruner:

def __init__(self, model, pruning_ratio=0.5):

self.model = model

self.pruning_ratio = pruning_ratio

self.pruned_layers = []

def _compute_channel_importance(self, layer, input_data):

# 对于卷积层或线性层,计算每个通道的重要性

with torch.no_grad():

if isinstance(layer, nn.Conv2d) or isinstance(layer, nn.Linear):

# 使用权重的L1范数作为通道重要性指标

weight = layer.weight.data

if isinstance(layer, nn.Conv2d):

# 对于卷积层,计算每个输出通道的L1范数

channel_importance = torch.sum(torch.abs(weight), dim=(1, 2, 3))

else:

# 对于线性层,计算每个输出特征的L1范数

channel_importance = torch.sum(torch.abs(weight), dim=1)

return channel_importance

else:

return None

def _prune_layer(self, layer, channel_indices_to_keep):

# 剪枝层的通道

if isinstance(layer, nn.Conv2d) or isinstance(layer, nn.Linear):

# 保存原始权重

original_weight = layer.weight.data.clone()

# 剪枝权重

if isinstance(layer, nn.Conv2d):

# 对于卷积层,剪枝输出通道

layer.weight.data = layer.weight.data[channel_indices_to_keep, :, :, :]

else:

# 对于线性层,剪枝输出特征

layer.weight.data = layer.weight.data[channel_indices_to_keep, :]

# 如果有偏置,也剪枝偏置

if layer.bias is not None:

layer.bias.data = layer.bias.data[channel_indices_to_keep]

# 更新层的输出特征数量

if isinstance(layer, nn.Conv2d):

layer.out_channels = len(channel_indices_to_keep)

else:

layer.out_features = len(channel_indices_to_keep)

return original_weight, channel_indices_to_keep

else:

return None, None

def _update_subsequent_layer(self, subsequent_layer, pruned_layer_info):

# 更新后续层的输入通道以匹配剪枝后的输出通道

original_weight, channel_indices_to_keep = pruned_layer_info

if original_weight is None or channel_indices_to_keep is None:

return

if isinstance(subsequent_layer, nn.Conv2d) or isinstance(subsequent_layer, nn.Linear):

# 如果是卷积层或线性层,需要更新权重的输入通道

if isinstance(subsequent_layer, nn.Conv2d):

# 对于卷积层,调整输入通道

subsequent_layer.weight.data = subsequent_layer.weight.data[:, channel_indices_to_keep, :, :]

subsequent_layer.in_channels = len(channel_indices_to_keep)

else:

# 对于线性层,调整输入特征

subsequent_layer.weight.data = subsequent_layer.weight.data[:, channel_indices_to_keep]

subsequent_layer.in_features = len(channel_indices_to_keep)

def prune(self, calibration_data):

# 遍历模型中的所有层

layers = list(self.model.named_modules())

for i, (name, layer) in enumerate(layers):

# 只处理卷积层和线性层

if isinstance(layer, nn.Conv2d) or isinstance(layer, nn.Linear):

# 计算通道重要性

channel_importance = self._compute_channel_importance(layer, calibration_data)

if channel_importance is not None:

# 确定要保留的通道数量

num_channels = len(channel_importance)

num_channels_to_keep = int(num_channels * (1 - self.pruning_ratio))

# 选择重要性最高的通道

_, indices = torch.topk(channel_importance, num_channels_to_keep)

indices = indices.sort()[0] # 排序以保持顺序

# 剪枝当前层

pruned_layer_info = self._prune_layer(layer, indices)

# 记录剪枝的层

self.pruned_layers.append((name, layer, pruned_layer_info))

# 更新下一层(如果存在且是卷积层或线性层)

if i + 1 < len(layers):

next_name, next_layer = layers[i + 1]

if isinstance(next_layer, nn.Conv2d) or isinstance(next_layer, nn.Linear):

self._update_subsequent_layer(next_layer, pruned_layer_info)

# 返回剪枝后的模型

return self.model

# 使用示例

# pruner = ChannelPruner(model, pruning_ratio=0.3)

# pruned_model = pruner.prune(calibration_data)

# # 剪枝后通常需要进行微调以恢复性能

# # train_model(pruned_model, fine_tune_data)4.2 知识蒸馏

知识蒸馏是一种通过将大模型(教师模型)的知识转移到小模型(学生模型)的技术,2025年的知识蒸馏技术主要包括:

- 经典知识蒸馏:

- 软标签蒸馏:使用教师模型的软标签作为监督信号

- 温度参数优化:优化蒸馏温度参数

- 损失函数设计:设计合适的蒸馏损失函数

- 高级蒸馏技术:

- 特征蒸馏:蒸馏中间层特征表示

- 关系蒸馏:蒸馏样本之间的关系信息

- 注意力蒸馏:蒸馏注意力权重信息

- 激活值蒸馏:蒸馏激活值分布

- 多教师蒸馏:

- 集成蒸馏:使用多个教师模型集成的知识

- 自适应教师选择:根据样本难度动态选择教师

- 分层蒸馏:不同层使用不同的教师模型

- 自蒸馏:

- 模型自蒸馏:模型自己蒸馏自己的知识

- 跨层蒸馏:不同层之间的知识转移

- 时间蒸馏:模型不同训练阶段的知识转移

4.3 低秩分解

低秩分解是一种通过矩阵分解减少模型参数量的技术,2025年的低秩分解技术主要包括:

- 矩阵分解方法:

- SVD分解:奇异值分解

- CUR分解:使用列、行和交叉点信息的分解

- NMF分解:非负矩阵分解

- 张量分解:高阶张量的分解

- 分解策略:

- 权重分解:直接分解模型权重矩阵

- 梯度分解:分解梯度矩阵,用于训练优化

- 激活分解:分解激活值矩阵,减少计算量

- 分解后的优化:

- 重新参数化:分解后对模型进行重新参数化

- 微调优化:对分解后的模型进行微调

- 结构调整:根据分解结果调整模型结构

- 动态低秩:

- 自适应低秩:根据输入动态调整低秩程度

- 条件低秩:根据输入条件选择不同的低秩分解

- 混合低秩:不同部分使用不同的低秩分解

4.4 结构化设计

结构化设计是一种从模型设计阶段就考虑效率的方法,2025年的结构化设计技术主要包括:

- 轻量级架构:

- MobileNet系列:使用深度可分离卷积

- EfficientNet系列:使用复合缩放策略

- 各种轻量级Transformer变体

- 瓶颈结构:

- 倒瓶颈结构:先升维再降维

- 残差瓶颈:在残差块中使用瓶颈结构

- 注意力瓶颈:在注意力机制中使用瓶颈结构

- 模块化设计:

- 可重用模块:设计可重用的高效模块

- 插件模块:可以灵活添加或移除的插件模块

- 条件模块:根据输入条件激活不同的模块

- 动态架构:

- 条件计算:根据输入动态决定计算路径

- 自适应深度:根据输入动态调整模型深度

- 路由机制:使用路由机制动态选择模块

五、量化技术与实践

5.1 量化基础与分类

量化是一种通过降低模型参数和激活值精度来减少内存占用和加速计算的技术,2025年的量化技术主要包括以下分类:

- 按量化粒度分类:

- 权重量化:只量化模型权重

- 激活量化:只量化模型激活值

- 混合量化:同时量化权重和激活值

- 按量化位宽分类:

- 低精度量化:FP16、BF16等

- 整型量化:INT8、INT4、INT2等

- 二值化:只有0和1两种值

- 混合位宽量化:不同部分使用不同位宽

- 按量化时机分类:

- 训练前量化(PTQ):训练后对模型进行量化

- 训练中量化(QAT):在训练过程中进行量化

- 动态量化:在推理过程中动态进行量化

- 按量化方法分类:

- 线性量化:使用线性映射进行量化

- 非线性量化:使用非线性映射进行量化

- 自适应量化:根据数据分布自适应调整量化参数

5.2 低精度训练与推理

低精度训练与推理是指使用低于FP32的精度进行模型训练和推理的技术,2025年的低精度训练与推理技术主要包括:

- 半精度训练(FP16):

- 混合精度训练:结合FP16和FP32的训练方法

- 损失缩放:解决FP16梯度下溢问题

- 主权重复制:维护FP32主权重副本

- Brain Float 16(BF16):

- BF16特性:与FP32相同的指数位,更宽的动态范围

- BF16训练优化:针对BF16的训练策略

- BF16与FP16对比:优势与适用场景

- TF32训练:

- TF32特性:专为AI计算设计的32位格式

- NVIDIA Ampere及后续架构支持

- 训练性能提升与精度保持

- 低精度推理优化:

- 推理引擎优化:针对低精度推理的引擎优化

- 硬件加速:利用硬件低精度计算单元加速

- 精度补偿技术:减少低精度推理的精度损失

5.3 整型量化技术

整型量化是将浮点模型转换为整型模型的技术,2025年的整型量化技术主要包括:

- 校准技术:

- 最小化量化误差的校准方法

- 直方图校准:基于数据直方图的量化参数确定

- 熵校准:基于信息熵的量化参数确定

- 百分位校准:基于数据分布百分位的量化参数确定

- QAT技术:

- 量化感知训练:在训练过程中模拟量化效果

- 量化噪声注入:在训练中注入量化噪声,提高鲁棒性

- 可学习量化参数:量化参数也作为可学习参数

- 精细化量化:针对不同层或通道使用不同的量化参数

- INT8推理优化:

- 算子融合:将多个INT8算子融合为一个

- 内存访问优化:优化INT8数据的内存访问模式

- 并行计算:充分利用硬件的INT8计算单元

- 动态范围管理:优化INT8数据的动态范围利用

- 低位宽量化:

- INT4量化:4位整型量化技术

- INT2量化:2位整型量化技术

- 二值化:1位量化技术

- 混合位宽量化:不同部分使用不同位宽的量化

以下是一个PTQ(训练后量化)的实现示例:

import torch

import torch.nn as nn

import numpy as np

from tqdm import tqdm

class PostTrainingQuantizer:

def __init__(self, model, bits=8, calibration_samples=128):

self.model = model

self.bits = bits

self.calibration_samples = calibration_samples

self.quant_params = {}

self.device = next(model.parameters()).device

# 确定量化范围

self.min_val = -2**(bits-1)

self.max_val = 2**(bits-1) - 1

def _quantize_tensor(self, tensor, scale, zero_point):

# 线性量化:tensor_q = round(tensor / scale + zero_point)

tensor_q = torch.round(tensor / scale + zero_point)

tensor_q = torch.clamp(tensor_q, self.min_val, self.max_val)

return tensor_q.to(torch.int8)

def _dequantize_tensor(self, tensor_q, scale, zero_point):

# 线性反量化:tensor = (tensor_q - zero_point) * scale

return (tensor_q.float() - zero_point) * scale

def _collect_stats(self, data_loader):

# 收集激活值统计信息用于校准

self.model.eval()

# 为每个层创建激活值缓存

activation_caches = {}

# 注册钩子收集激活值

hooks = []

def register_hook(name, layer):

if isinstance(layer, nn.Conv2d) or isinstance(layer, nn.Linear):

def hook_fn(module, input, output):

if name not in activation_caches:

activation_caches[name] = []

# 只缓存第一个样本批次的数据以节省内存

if len(activation_caches[name]) < self.calibration_samples:

activation_caches[name].append(output.detach().cpu())

hooks.append(layer.register_forward_hook(hook_fn))

# 遍历模型并注册钩子

for name, layer in self.model.named_modules():

register_hook(name, layer)

# 运行校准数据

with torch.no_grad():

for i, (data, _) in enumerate(tqdm(data_loader, desc="Collecting activation stats")):

if i >= self.calibration_samples:

break

data = data.to(self.device)

self.model(data)

# 移除钩子

for hook in hooks:

hook.remove()

return activation_caches

def _calibrate(self, activation_caches):

# 校准量化参数

for name, caches in activation_caches.items():

# 合并所有校准样本的激活值

activations = torch.cat(caches, dim=0)

# 计算激活值的最小值和最大值

min_val = torch.min(activations)

max_val = torch.max(activations)

# 防止除以零

if min_val == max_val:

scale = 1.0

zero_point = 0

else:

# 计算缩放因子和零点

scale = (max_val - min_val) / (self.max_val - self.min_val)

# 零点计算确保最小值映射到量化范围的最小值

zero_point = torch.round(self.min_val - min_val / scale)

# 确保零点在量化范围内

zero_point = torch.clamp(zero_point, self.min_val, self.max_val)

self.quant_params[name] = {'scale': scale, 'zero_point': zero_point}

def _quantize_weights(self):

# 量化模型权重

for name, param in self.model.named_parameters():

if 'weight' in name:

# 获取权重数据

weight = param.data

# 计算权重的最小值和最大值

min_val = torch.min(weight)

max_val = torch.max(weight)

# 防止除以零

if min_val == max_val:

scale = 1.0

zero_point = 0

else:

# 计算缩放因子和零点

scale = (max_val - min_val) / (self.max_val - self.min_val)

# 零点计算确保最小值映射到量化范围的最小值

zero_point = torch.round(self.min_val - min_val / scale)

# 确保零点在量化范围内

zero_point = torch.clamp(zero_point, self.min_val, self.max_val)

# 量化权重

weight_q = self._quantize_tensor(weight, scale, zero_point)

# 存储量化参数

self.quant_params[name] = {'scale': scale, 'zero_point': zero_point}

# 使用反量化后的权重替换原始权重(仅用于演示,实际应用中需要专门的量化推理引擎)

param.data = self._dequantize_tensor(weight_q, scale, zero_point)

def quantize(self, data_loader):

# 1. 收集激活值统计信息

activation_caches = self._collect_stats(data_loader)

# 2. 校准量化参数

self._calibrate(activation_caches)

# 3. 量化模型权重

self._quantize_weights()

# 返回量化后的模型和量化参数

return self.model, self.quant_params

# 使用示例

# quantizer = PostTrainingQuantizer(model, bits=8, calibration_samples=128)

# quantized_model, quant_params = quantizer.quantize(calibration_loader)

# # 实际应用中,需要使用支持INT8推理的引擎加载量化模型

# # 例如TensorRT、ONNX Runtime、TFLite等5.4 量化工具与框架

2025年的量化工具与框架主要包括:

- 主流量化框架:

- TensorRT:NVIDIA的高性能推理框架,支持多种精度量化

- ONNX Runtime:微软的开源推理引擎,支持INT8量化

- TFLite:TensorFlow的轻量级推理框架,支持多种量化方法

- PyTorch quantization:PyTorch内置的量化功能

- 专用量化工具:

- AIMET:高通的AI模型效率工具包

- SparseTIR:TVM生态中的稀疏量化框架

- Intel OpenVINO:英特尔的计算机视觉推理优化工具包

- ARM NN:ARM的神经网络推理优化框架

- 量化评估与分析工具:

- 量化精度分析工具:分析量化对模型精度的影响

- 量化敏感性分析:分析模型各部分对量化的敏感性

- 量化可视化工具:可视化量化前后的权重和激活值分布

- 量化模型部署工具:

- 模型转换工具:将训练模型转换为量化部署模型

- 量化编译器:将量化模型编译为目标硬件可执行代码

- 运行时优化工具:优化量化模型的运行时性能

graph TD

A[量化技术与实践] --> B[量化基础与分类]

A --> C[低精度训练与推理]

A --> D[整型量化技术]

A --> E[量化工具与框架]

B --> B1[按量化粒度分类]

B --> B2[按量化位宽分类]

B --> B3[按量化时机分类]

B --> B4[按量化方法分类]

C --> C1[半精度训练(FP16)]

C --> C2[Brain Float 16(BF16)]

C --> C3[TF32训练]

C --> C4[低精度推理优化]

D --> D1[校准技术]

D --> D2[QAT技术]

D --> D3[INT8推理优化]

D --> D4[低位宽量化]

E --> E1[主流量化框架]

E --> E2[专用量化工具]

E --> E3[量化评估与分析工具]

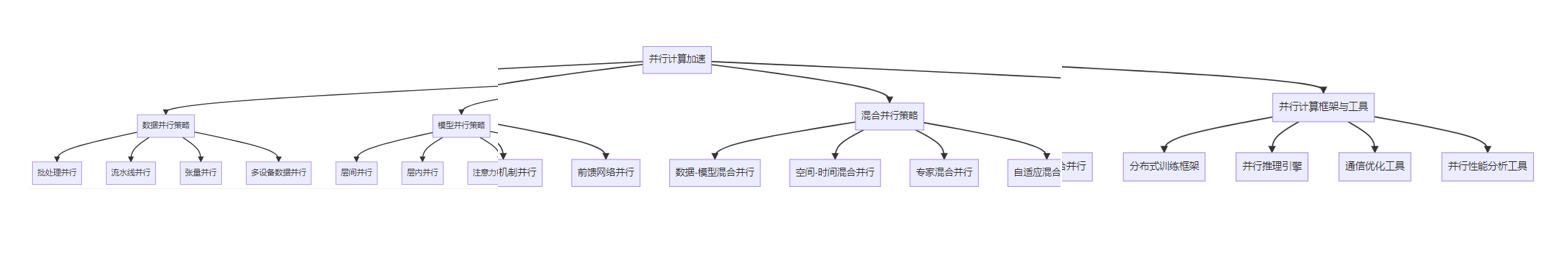

E --> E4[量化模型部署工具]六、并行计算加速

6.1 数据并行策略

数据并行是一种将数据分成多个部分,并行处理的加速技术,2025年的数据并行策略主要包括:

- 批处理并行:

- 批处理分割:将大批量数据分割成多个小批次并行处理

- 混合精度批处理:不同批次使用不同精度处理

- 动态批处理:根据数据特性动态调整批处理大小

- 流水线并行:

- 算子级流水线:将计算算子分成多个阶段流水线执行

- 层间流水线:将不同层的计算流水线执行

- 模型分段流水线:将模型分成多个段流水线执行

- 张量并行:

- 输入分割:将输入张量分割成多个部分并行处理

- 权重分割:将权重张量分割成多个部分并行处理

- 输出合并:将并行处理的输出合并

- 多设备数据并行:

- 分布式数据并行:在多个设备上并行处理不同的数据批次

- 梯度同步:不同设备之间同步梯度信息

- 优化器状态同步:不同设备之间同步优化器状态

6.2 模型并行策略

模型并行是一种将模型分成多个部分,并行处理的加速技术,2025年的模型并行策略主要包括:

- 层间并行:

- 垂直分割:将模型的不同层分配到不同设备

- 流水线执行:不同层在不同设备上流水线执行

- 激活值通信:层间传递激活值

- 层内并行:

- 水平分割:将同一层的参数分割到不同设备

- 操作分割:将同一层的不同操作分配到不同设备

- 参数通信:层内参数更新时的通信

- 注意力机制并行:

- 头并行:将多头注意力的不同头分配到不同设备

- QKV并行:将Q、K、V的计算分配到不同设备

- 注意力分数并行:将注意力分数计算分配到不同设备

- 前馈网络并行:

- 隐藏层并行:将前馈网络的隐藏层分割到不同设备

- 激活函数并行:将激活函数的计算分配到不同设备

- 归一化层并行:将归一化层的计算分配到不同设备

6.3 混合并行策略

混合并行是结合多种并行策略的加速技术,2025年的混合并行策略主要包括:

- 数据-模型混合并行:

- 数据并行为主,模型并行为辅

- 模型并行为主,数据并行为辅

- 多层次混合并行:在不同层次使用不同的并行策略

- 空间-时间混合并行:

- 空间并行:在空间维度上的并行处理

- 时间并行:在时间维度上的并行处理

- 时空混合:结合空间和时间维度的并行处理

- 专家混合并行:

- MoE并行:Mixture of Experts模型的并行处理

- 专家选择并行:并行处理专家选择过程

- 专家计算并行:并行处理多个专家的计算

- 自适应混合并行:

- 动态并行选择:根据运行时状态动态选择并行策略

- 负载均衡:动态调整各设备的负载

- 资源感知调度:根据可用资源调整并行策略

6.4 并行计算框架与工具

2025年的并行计算框架与工具主要包括:

- 分布式训练框架:

- PyTorch DDP:PyTorch分布式数据并行

- TensorFlow Distribution Strategy:TensorFlow分布式策略

- DeepSpeed:微软的深度学习优化库

- Megatron-LM:NVIDIA的大规模语言模型训练框架

- 并行推理引擎:

- TensorRT:NVIDIA的高性能推理引擎

- ONNX Runtime:微软的开源推理引擎

- TFLite:TensorFlow的轻量级推理框架

- TVM:Apache的深度学习编译器

- 通信优化工具:

- NCCL:NVIDIA的集体通信库

- Gloo:Facebook的分布式通信库

- MPI:消息传递接口

- 自定义通信原语:针对特定模型和硬件优化的通信原语

- 并行性能分析工具:

- 性能剖析器:分析并行计算的性能瓶颈

- 通信分析器:分析通信开销和延迟

- 负载均衡分析器:分析各设备的负载情况

- 优化建议工具:根据分析结果提供优化建议

以下是一个使用PyTorch DDP进行分布式训练的示例:

import torch

import torch.nn as nn

import torch.optim as optim

import torch.distributed as dist

import torch.multiprocessing as mp

from torch.nn.parallel import DistributedDataParallel as DDP

from torch.utils.data import DataLoader, DistributedSampler

import os

class SimpleTransformerModel(nn.Module):

def __init__(self, d_model=512, nhead=8, num_layers=6):

super().__init__()

self.embedding = nn.Embedding(10000, d_model)

self.transformer = nn.Transformer(d_model=d_model, nhead=nhead, num_encoder_layers=num_layers,

num_decoder_layers=num_layers)

self.fc = nn.Linear(d_model, 10000)

def forward(self, src, tgt):

src_emb = self.embedding(src) * torch.sqrt(torch.tensor(self.embedding.embedding_dim))

tgt_emb = self.embedding(tgt) * torch.sqrt(torch.tensor(self.embedding.embedding_dim))

# 添加位置编码(简化版)

seq_len_src, batch_size, d_model = src_emb.size()

pos_enc_src = torch.arange(0, seq_len_src, device=src.device).unsqueeze(1).repeat(1, batch_size).unsqueeze(2)

src_emb = src_emb + pos_enc_src * 0.01

seq_len_tgt, _, _ = tgt_emb.size()

pos_enc_tgt = torch.arange(0, seq_len_tgt, device=tgt.device).unsqueeze(1).repeat(1, batch_size).unsqueeze(2)

tgt_emb = tgt_emb + pos_enc_tgt * 0.01

# Transformer的forward方法期望的输入形状是 (seq_len, batch_size, features)

# 但默认的Transformer模块可能期望不同的维度顺序,这里根据实际情况调整

output = self.transformer(src_emb, tgt_emb)

output = self.fc(output)

return output

# 训练函数

def train(rank, world_size, dataset, args):

# 设置分布式环境

os.environ['MASTER_ADDR'] = 'localhost'

os.environ['MASTER_PORT'] = '12355'

dist.init_process_group(backend='nccl', rank=rank, world_size=world_size)

# 创建模型并移动到指定设备

torch.cuda.set_device(rank)

model = SimpleTransformerModel().to(rank)

# 使用DDP包装模型

ddp_model = DDP(model, device_ids=[rank])

# 创建优化器和损失函数

optimizer = optim.Adam(ddp_model.parameters(), lr=args.lr)

criterion = nn.CrossEntropyLoss()

# 创建分布式采样器和数据加载器

sampler = DistributedSampler(dataset, shuffle=True)

dataloader = DataLoader(dataset, batch_size=args.batch_size, sampler=sampler)

# 训练循环

for epoch in range(args.epochs):

sampler.set_epoch(epoch) # 确保每个epoch的shuffle不同

total_loss = 0

for i, (src, tgt) in enumerate(dataloader):

# 将数据移动到指定设备

src = src.to(rank)

tgt = tgt.to(rank)

# 前向传播

optimizer.zero_grad()

output = ddp_model(src, tgt[:, :-1]) # tgt[:, :-1]作为输入

# 计算损失

# output形状: (seq_len, batch_size, vocab_size)

# tgt[:, 1:]形状: (batch_size, seq_len)

# 需要调整形状以匹配损失函数

loss = criterion(output.view(-1, output.size(-1)), tgt[:, 1:].reshape(-1))

# 反向传播

loss.backward()

# 梯度裁剪(可选)

torch.nn.utils.clip_grad_norm_(ddp_model.parameters(), max_norm=1.0)

# 更新参数

optimizer.step()

total_loss += loss.item()

# 只在rank 0上打印进度

if rank == 0 and i % 10 == 0:

print(f'Epoch {epoch+1}, Step {i}, Loss: {loss.item():.4f}')

# 只在rank 0上打印 epoch 损失

if rank == 0:

avg_loss = total_loss / len(dataloader)

print(f'Epoch {epoch+1} completed, Average Loss: {avg_loss:.4f}')

# 清理分布式环境

dist.destroy_process_group()

# 主函数

def main():

# 定义参数

class Args:

def __init__(self):

self.lr = 1e-4

self.batch_size = 32

self.epochs = 10

args = Args()

# 创建虚拟数据集(实际应用中应替换为真实数据集)

class DummyDataset(torch.utils.data.Dataset):

def __init__(self, size=1000, seq_len=10):

self.size = size

self.seq_len = seq_len

def __len__(self):

return self.size

def __getitem__(self, idx):

# 生成随机序列作为源和目标(在实际应用中应使用真实数据)

src = torch.randint(0, 10000, (self.seq_len,))

tgt = torch.cat([src[1:], torch.tensor([0])], dim=0) # 简单的移位目标

return src, tgt

dataset = DummyDataset()

# 设置分布式训练

world_size = torch.cuda.device_count() # 使用所有可用的GPU

print(f'Using {world_size} GPUs for training')

# 使用mp.spawn启动多个进程

mp.spawn(train,

args=(world_size, dataset, args),

nprocs=world_size,

join=True)

# 使用示例

if __name__ == '__main__':

main()

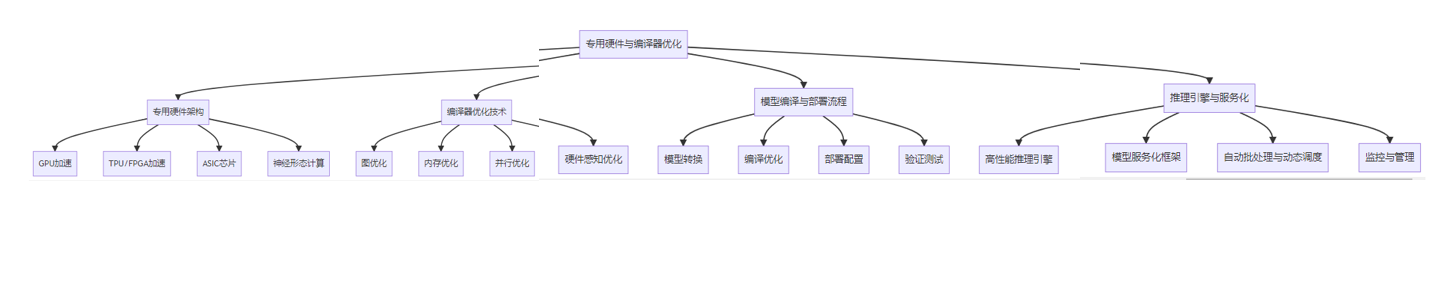

七、专用硬件与编译器优化

7.1 专用硬件架构

专用硬件架构是为加速AI推理而设计的特殊硬件,2025年的专用硬件架构主要包括:

- GPU加速:

- NVIDIA Ampere及后续架构:专为AI计算优化的GPU架构

- AMD RDNA及后续架构:支持AI加速的GPU架构

- 移动GPU:为移动设备设计的低功耗AI加速GPU

- TPU/FPGA加速:

- Google TPU:Google专为TensorFlow优化的张量处理单元

- Intel FPGA:Intel的现场可编程门阵列,可用于AI加速

- Xilinx FPGA:Xilinx的FPGA,支持AI加速

- ASIC芯片:

- Apple M系列芯片:Apple的自研芯片,集成神经网络引擎

- Google Edge TPU:Google的边缘AI加速芯片

- 寒武纪、地平线等国产AI芯片:专为AI推理设计的ASIC芯片

- 神经形态计算:

- Intel Loihi:Intel的神经形态计算芯片

- IBM TrueNorth:IBM的神经形态计算芯片

- 类脑计算架构:模拟人脑结构的计算架构

7.2 编译器优化技术

编译器优化是提升Transformer模型在特定硬件上运行效率的重要手段,2025年的编译器优化技术主要包括:

- 图优化:

- 算子融合:将多个算子融合为一个,减少内存访问和kernel启动开销

- 常量折叠:预计算常量表达式,减少运行时计算

- 死代码消除:移除不会执行的代码

- 循环优化:优化循环结构,提高计算效率

- 内存优化:

- 数据布局优化:调整数据存储格式,提高内存访问效率

- 内存复用:复用临时缓冲区,减少内存分配和释放

- 内存对齐:优化内存对齐方式,提高访问速度

- 预取优化:提前加载数据,隐藏内存访问延迟

- 并行优化:

- 线程调度:优化线程分配和调度策略

- 向量化:利用SIMD指令集并行处理数据

- 多线程优化:充分利用多核处理器

- 任务调度:优化任务分配和依赖关系

- 硬件感知优化:

- 指令选择:选择最适合目标硬件的指令

- 缓存优化:优化缓存使用策略,减少缓存未命中

- 内存带宽优化:优化内存访问模式,提高带宽利用率

- 功耗优化:优化代码以降低能耗

7.3 模型编译与部署流程

Transformer模型的编译与部署流程主要包括以下步骤:

- 模型转换:

- 模型导出:将训练框架的模型导出为中间表示(如ONNX)

- 格式转换:将中间表示转换为目标部署框架支持的格式

- 优化转换:在转换过程中应用初步优化

- 编译优化:

- 图优化:对计算图进行优化

- 算子优化:针对特定硬件优化算子实现

- 量化:应用量化技术减少内存占用和加速计算

- 并行优化:应用并行计算技术加速推理

- 部署配置:

- 运行时配置:配置推理引擎的运行时参数

- 硬件绑定:将模型绑定到特定硬件设备

- 性能调优:根据目标硬件和应用场景进行性能调优

- 验证测试:

- 精度验证:验证部署模型的精度是否符合要求

- 性能测试:测试部署模型的延迟和吞吐量

- 稳定性测试:测试部署模型在各种条件下的稳定性

- 兼容性测试:测试模型在不同环境和设备上的兼容性

7.4 推理引擎与服务化

推理引擎是执行模型推理的核心组件,服务化是将模型部署为可调用服务的过程,2025年的推理引擎与服务化技术主要包括:

- 高性能推理引擎:

- TensorRT:NVIDIA的高性能推理引擎

- ONNX Runtime:微软的开源推理引擎

- TFLite:TensorFlow的轻量级推理引擎

- TVM:Apache的深度学习编译器

- 模型服务化框架:

- TensorFlow Serving:TensorFlow的模型服务化框架

- TorchServe:PyTorch的模型服务化框架

- NVIDIA Triton Inference Server:NVIDIA的多框架推理服务器

- FastAPI + Uvicorn:轻量级API服务框架组合

- 自动批处理与动态调度:

- 请求批处理:将多个请求合并为一批处理,提高吞吐量

- 动态批处理:根据请求情况动态调整批处理大小

- 请求调度:优化请求调度策略,平衡延迟和吞吐量

- 负载均衡:在多个推理实例之间进行负载均衡

- 监控与管理:

- 性能监控:监控模型推理的性能指标

- 资源监控:监控硬件资源使用情况

- 健康检查:定期检查模型服务的健康状态

- 自动扩缩容:根据负载自动调整实例数量

八、自适应推理机制

8.1 动态计算路径

自适应推理是一种根据输入特征动态调整模型结构和计算量的技术,2025年的动态计算路径技术主要包括:

- 条件计算:

- 动态层选择:根据输入动态选择使用哪些层

- 动态通道选择:根据输入动态选择使用哪些通道

- 动态头选择:在多头注意力中动态选择使用哪些头

- 混合专家模型:根据输入动态激活不同的专家模块

- 早期退出机制:

- 分层退出:在模型的不同层添加退出点

- 置信度评估:评估模型对当前预测的置信度

- 自适应阈值:根据输入难度动态调整退出阈值

- 多出口网络:设计多个出口的网络架构

- 动态计算资源分配:

- 计算资源预算:为每个样本分配计算资源预算

- 动态精度调整:根据输入和任务需求动态调整计算精度

- 动态批处理:根据输入特性动态调整批处理大小

- 任务优先级调度:根据任务优先级分配计算资源

- 路径规划与决策:

- 强化学习决策:使用强化学习决定最优计算路径

- 启发式规则:基于启发式规则快速决定计算路径

- 预测模型:使用小型预测模型决定计算路径

- 动态规划:使用动态规划算法选择最优计算路径

以下是一个简单的早期退出机制实现示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

class EarlyExitTransformer(nn.Module):

def __init__(self, d_model=512, nhead=8, num_layers=6, num_classes=1000):

super().__init__()

self.embedding = nn.Embedding(10000, d_model)

self.transformer_layers = nn.ModuleList([

nn.TransformerEncoderLayer(d_model=d_model, nhead=nhead)

for _ in range(num_layers)

])

# 为每个Transformer层添加退出头

self.exit_heads = nn.ModuleList([

nn.Linear(d_model, num_classes)

for _ in range(num_layers)

])

# 最终的输出层

self.final_head = nn.Linear(d_model, num_classes)

# 用于确定是否退出的可学习参数

self.exit_thresholds = nn.ParameterList([

nn.Parameter(torch.tensor(0.9)) # 初始阈值设为0.9

for _ in range(num_layers)

])

def forward(self, src, return_all=False):

# src形状: (batch_size, seq_len)

batch_size = src.size(0)

# 嵌入层

src_emb = self.embedding(src) * torch.sqrt(torch.tensor(self.embedding.embedding_dim))

# 添加位置编码(简化版)

seq_len, _, d_model = src_emb.size()

pos_enc = torch.arange(0, seq_len, device=src.device).unsqueeze(1).repeat(1, batch_size).unsqueeze(2)

src_emb = src_emb + pos_enc * 0.01

# 交换维度以适应Transformer层的输入要求 (seq_len, batch_size, d_model)

src_emb = src_emb.permute(1, 0, 2)

# 存储所有退出点的输出

all_outputs = []

# 遍历所有Transformer层

x = src_emb

exit_points = torch.zeros(batch_size, dtype=torch.int64, device=src.device)

final_outputs = torch.zeros(batch_size, self.exit_heads[0].out_features, device=src.device)

exited = torch.zeros(batch_size, dtype=torch.bool, device=src.device)

for i, (layer, exit_head, threshold) in enumerate(zip(self.transformer_layers, self.exit_heads, self.exit_thresholds)):

# 通过当前Transformer层

x = layer(x)

# 计算当前层的特征表示(取序列的第一个位置作为全局表示)

features = x[0, :, :] # (batch_size, d_model)

# 通过退出头计算logits

logits = exit_head(features)

# 计算置信度

confidences, _ = torch.max(F.softmax(logits, dim=-1), dim=-1)

# 记录所有退出点的输出

all_outputs.append(logits)

# 对于尚未退出的样本,检查是否达到退出阈值

if not exited.all():

# 找出尚未退出且置信度超过阈值的样本

new_exits = (~exited) & (confidences > threshold)

# 记录这些样本的退出点和输出

exit_points[new_exits] = i

final_outputs[new_exits] = logits[new_exits]

# 更新已退出的样本标记

exited = exited | new_exits

# 如果所有样本都已退出,可以提前结束

if exited.all() and not return_all:

break

# 对于最后仍未退出的样本,使用最终的输出层

if not exited.all():

final_outputs[~exited] = self.final_head(features[~exited])

exit_points[~exited] = num_layers

if return_all:

return final_outputs, exit_points, all_outputs

else:

return final_outputs, exit_points

# 使用示例

# model = EarlyExitTransformer(d_model=512, nhead=8, num_layers=6, num_classes=1000)

# outputs, exit_points = model(input_ids)

# # exit_points 包含每个样本退出的层索引8.2 计算资源自适应分配

计算资源自适应分配是根据任务需求和系统状态动态分配计算资源的技术,2025年的计算资源自适应分配技术主要包括:

- 动态批处理:

- 自适应批处理:根据输入特性和系统状态动态调整批处理大小

- 混合长度批处理:优化不同长度序列的批处理策略

- 批处理调度:根据任务优先级和资源情况调度批处理任务

- 批处理合并:合并多个小批次以提高计算效率

- 动态精度控制:

- 混合精度计算:根据不同部分的精度需求使用不同精度

- 精度自适应调整:根据任务需求和系统状态动态调整精度

- 精度可伸缩性:设计支持不同精度的模型架构

- 精度-性能权衡:在精度和性能之间进行动态权衡

- 资源限制下的优化:

- 内存限制优化:在内存受限情况下的模型优化

- 计算资源限制优化:在计算资源受限情况下的模型优化

- 能耗限制优化:在能耗受限情况下的模型优化

- 多目标优化:同时优化多个资源限制条件

- 上下文感知调度:

- 任务上下文感知:根据任务的上下文信息调整资源分配

- 用户上下文感知:根据用户的需求和偏好调整资源分配

- 系统上下文感知:根据系统的当前状态调整资源分配

- 环境上下文感知:根据环境条件调整资源分配

8.3 多任务自适应推理

多任务自适应推理是在多任务场景下根据不同任务的需求动态调整模型行为的技术,2025年的多任务自适应推理技术主要包括:

- 任务感知调度:

- 任务优先级管理:根据任务优先级分配计算资源

- 任务特性匹配:根据任务特性选择合适的模型和参数

- 任务依赖处理:处理任务之间的依赖关系

- 任务批处理优化:优化多任务的批处理策略

- 共享表示学习与适应:

- 共享编码器:不同任务共享基础编码器

- 任务特定解码器:每个任务有专用的解码器

- 适配器模块:使用适配器模块适应不同任务

- 动态路由:根据任务动态路由特征流

- 知识迁移与适应:

- 迁移学习:将从源任务学到的知识迁移到目标任务

- 领域适应:适应不同领域的数据分布

- 少样本适应:在少样本情况下快速适应新任务

- 持续学习:在持续学习环境中适应不断变化的任务

- 多任务优化与权衡:

- 多目标优化:同时优化多个任务的性能

- 动态权重调整:动态调整不同任务的损失权重

- 资源分配权衡:在不同任务之间权衡资源分配

- 性能-效率权衡:在性能和效率之间进行权衡

8.4 轻量级与重量级模型协同

轻量级与重量级模型协同是结合轻量级模型的高效性和重量级模型的准确性的技术,2025年的轻量级与重量级模型协同技术主要包括:

- 模型级联:

- 两阶段推理:先用轻量级模型过滤简单样本,再用重量级模型处理复杂样本

- 多级级联:使用多个不同复杂度的模型级联处理

- 自适应级联:根据输入特性动态调整级联策略

- 级联优化:优化级联模型的整体性能和效率

- 模型蒸馏与知识迁移:

- 知识蒸馏:将重量级模型的知识蒸馏到轻量级模型

- 特征迁移:将重量级模型的特征表示迁移到轻量级模型

- 注意力迁移:将重量级模型的注意力模式迁移到轻量级模型

- 关系迁移:将重量级模型学习到的关系知识迁移到轻量级模型

- 动态模型选择:

- 基于难度的模型选择:根据输入难度选择合适的模型

- 基于置信度的模型选择:根据轻量级模型的置信度决定是否使用重量级模型

- 基于资源的模型选择:根据可用资源选择合适的模型

- 基于任务的模型选择:根据任务需求选择合适的模型

- 混合执行策略:

- 分段执行:将任务分解为多个阶段,不同阶段使用不同复杂度的模型

- 并行执行:轻量级和重量级模型并行执行,取最优结果

- 增量执行:从轻量级模型开始,根据需要逐步使用更复杂的模型

- 自适应执行:根据运行时状态动态调整执行策略

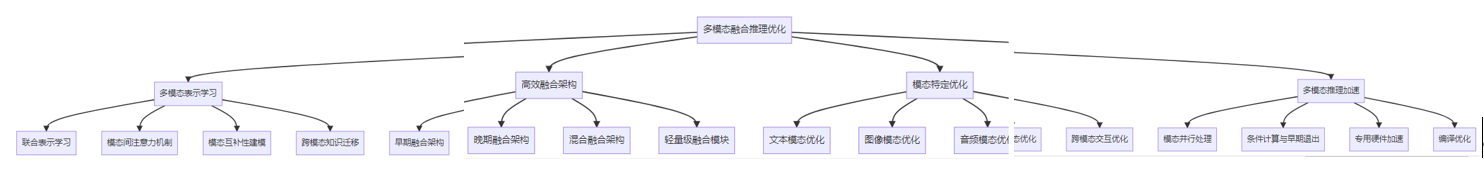

九、多模态融合推理优化

9.1 多模态表示学习

多模态融合是将不同模态(如文本、图像、音频等)的信息整合在一起的技术,2025年的多模态表示学习技术主要包括:

- 联合表示学习:

- 跨模态嵌入:将不同模态的信息映射到共享的嵌入空间

- 多模态自编码器:学习多模态数据的紧凑表示

- 多模态预训练:通过大规模预训练学习通用的多模态表示

- 对比学习:使用对比学习方法学习多模态表示

- 模态间注意力机制:

- 跨模态注意力:在不同模态之间计算注意力权重

- 模态融合注意力:使用注意力机制融合不同模态的信息

- 自注意力增强:使用自注意力机制增强单模态表示

- 多头跨模态注意力:使用多头注意力机制处理多模态信息

- 模态互补性建模:

- 模态差异建模:建模不同模态之间的差异

- 模态互补性学习:学习不同模态之间的互补信息

- 缺失模态处理:处理部分模态缺失的情况

- 模态对齐:对齐不同模态的时间或空间信息

- 跨模态知识迁移:

- 预训练-微调:在大规模数据上预训练,然后在特定任务上微调

- 跨模态蒸馏:将一种模态的知识蒸馏到另一种模态

- 跨模态适应:将在一种模态上学到的知识适应到另一种模态

- 跨任务迁移:将在一个任务上学到的知识迁移到另一个任务

9.2 高效融合架构

高效融合架构是设计高效的多模态融合结构的技术,2025年的高效融合架构主要包括:

- 早期融合架构:

- 特征级融合:在特征级别融合不同模态的信息

- 共享编码器:使用共享编码器处理不同模态的信息

- 联合嵌入:将不同模态的信息嵌入到同一空间

- 早期融合优化:优化早期融合的计算效率

- 晚期融合架构:

- 决策级融合:在决策级别融合不同模态的结果

- 独立编码器:使用独立编码器处理不同模态的信息

- 模态特定解码器:为每个模态设计特定的解码器

- 晚期融合优化:优化晚期融合的计算效率

- 混合融合架构:

- 分层融合:在不同层次融合不同模态的信息

- 渐进式融合:从低级到高级逐步融合不同模态的信息

- 选择性融合:根据任务需求和输入特性选择性地融合不同模态的信息

- 自适应融合:根据运行时状态动态调整融合策略

- 轻量级融合模块:

- 瓶颈融合:使用瓶颈结构减少融合模块的计算量

- 注意力瓶颈:在注意力融合模块中使用瓶颈结构

- 低秩融合:使用低秩分解减少融合模块的参数量

- 稀疏融合:使用稀疏连接减少融合模块的计算量

9.3 模态特定优化

模态特定优化是针对不同模态的特点进行专门优化的技术,2025年的模态特定优化技术主要包括:

- 文本模态优化:

- 文本表示压缩:压缩文本特征表示,减少内存占用

- 文本处理加速:加速文本预处理和特征提取

- 文本特定量化:针对文本数据特点进行量化优化

- 文本长度优化:优化文本序列长度,平衡精度和效率

- 图像模态优化:

- 图像分辨率优化:根据任务需求调整图像分辨率

- 特征金字塔优化:优化特征金字塔结构,平衡精度和效率

- 视觉注意力优化:优化视觉注意力机制,减少计算量

- 图像特定量化:针对图像数据特点进行量化优化

- 音频模态优化:

- 音频采样率优化:根据任务需求调整音频采样率

- 音频特征提取加速:加速音频特征提取过程

- 音频特定量化:针对音频数据特点进行量化优化

- 音频长度优化:优化音频序列长度,平衡精度和效率

- 跨模态交互优化:

- 交互计算优化:优化不同模态之间的交互计算

- 交互表示压缩:压缩跨模态交互表示,减少内存占用

- 交互量化:对跨模态交互信息进行量化优化

- 交互并行化:并行处理跨模态交互计算

9.4 多模态推理加速

多模态推理加速是提高多模态模型推理效率的技术,2025年的多模态推理加速技术主要包括:

- 模态并行处理:

- 模态并行:并行处理不同模态的信息

- 异步处理:异步处理不同模态的信息

- 流水线处理:使用流水线方式处理不同模态的信息

- 模态调度:优化不同模态的处理顺序和时机

- 条件计算与早期退出:

- 模态条件计算:根据输入条件选择性地处理某些模态

- 多模态早期退出:在多模态模型中应用早期退出机制

- 自适应模态融合:根据输入和任务需求自适应地融合模态

- 动态模态选择:根据输入特性动态选择使用哪些模态

- 专用硬件加速:

- 多模态加速器:专为多模态计算设计的硬件加速器

- FPGA加速:使用FPGA加速多模态计算

- ASIC加速:使用ASIC芯片加速多模态计算

- 混合精度加速:使用混合精度技术加速多模态计算

- 编译优化:

- 多模态图优化:优化多模态计算图

- 算子融合:融合多模态计算中的算子

- 内存访问优化:优化多模态计算的内存访问模式

- 并行计算优化:优化多模态计算的并行策略

以下是一个简单的多模态融合Transformer实现示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

class MultimodalFusionTransformer(nn.Module):

def __init__(self, text_dim, image_dim, audio_dim, hidden_dim=768, num_heads=12, num_layers=6, num_classes=1000):

super().__init__()

# 模态特定编码器

self.text_encoder = nn.Linear(text_dim, hidden_dim)

self.image_encoder = nn.Linear(image_dim, hidden_dim)

self.audio_encoder = nn.Linear(audio_dim, hidden_dim)

# 模态特定位置编码

self.text_pos_embedding = nn.Parameter(torch.randn(1, 100, hidden_dim)) # 假设文本最大长度为100

self.image_pos_embedding = nn.Parameter(torch.randn(1, 196, hidden_dim)) # 假设图像特征大小为14x14=196

self.audio_pos_embedding = nn.Parameter(torch.randn(1, 200, hidden_dim)) # 假设音频特征最大长度为200

# 模态类型嵌入(用于区分不同模态的特征)

self.text_type_embedding = nn.Parameter(torch.randn(1, 1, hidden_dim))

self.image_type_embedding = nn.Parameter(torch.randn(1, 1, hidden_dim))

self.audio_type_embedding = nn.Parameter(torch.randn(1, 1, hidden_dim))

# 融合Transformer编码器

encoder_layer = nn.TransformerEncoderLayer(d_model=hidden_dim, nhead=num_heads)

self.transformer_encoder = nn.TransformerEncoder(encoder_layer, num_layers=num_layers)

# 分类头

self.classifier = nn.Linear(hidden_dim, num_classes)

# Dropout层

self.dropout = nn.Dropout(0.1)

def forward(self, text_features, image_features, audio_features):

# 文本特征编码

text_emb = self.text_encoder(text_features) # (batch_size, text_len, text_dim) -> (batch_size, text_len, hidden_dim)

text_len = text_emb.size(1)

text_emb = text_emb + self.text_pos_embedding[:, :text_len, :] # 添加位置编码

text_emb = text_emb + self.text_type_embedding # 添加模态类型编码

text_emb = self.dropout(text_emb)

# 图像特征编码

image_emb = self.image_encoder(image_features) # (batch_size, image_len, image_dim) -> (batch_size, image_len, hidden_dim)

image_len = image_emb.size(1)

image_emb = image_emb + self.image_pos_embedding[:, :image_len, :] # 添加位置编码

image_emb = image_emb + self.image_type_embedding # 添加模态类型编码

image_emb = self.dropout(image_emb)

# 音频特征编码

audio_emb = self.audio_encoder(audio_features) # (batch_size, audio_len, audio_dim) -> (batch_size, audio_len, hidden_dim)

audio_len = audio_emb.size(1)

audio_emb = audio_emb + self.audio_pos_embedding[:, :audio_len, :] # 添加位置编码

audio_emb = audio_emb + self.audio_type_embedding # 添加模态类型编码

audio_emb = self.dropout(audio_emb)

# 融合所有模态的特征

# 首先需要将batch_size和seq_len维度交换,以适应Transformer的输入要求

text_emb = text_emb.permute(1, 0, 2) # (text_len, batch_size, hidden_dim)

image_emb = image_emb.permute(1, 0, 2) # (image_len, batch_size, hidden_dim)

audio_emb = audio_emb.permute(1, 0, 2) # (audio_len, batch_size, hidden_dim)

# 拼接所有模态的特征

multimodal_emb = torch.cat([text_emb, image_emb, audio_emb], dim=0) # (total_len, batch_size, hidden_dim)

# 通过Transformer编码器

output = self.transformer_encoder(multimodal_emb)

# 取所有特征的平均值作为最终表示

# 也可以使用cls标记或其他池化方式

pooled_output = torch.mean(output, dim=0) # (batch_size, hidden_dim)

# 通过分类头得到最终预测

logits = self.classifier(pooled_output) # (batch_size, num_classes)

return logits

# 使用示例

# model = MultimodalFusionTransformer(text_dim=768, image_dim=2048, audio_dim=128, hidden_dim=768, num_heads=12, num_layers=6, num_classes=1000)

#

# # 假设我们有以下输入特征

# text_features = torch.randn(32, 50, 768) # (batch_size, text_len, text_dim)

# image_features = torch.randn(32, 196, 2048) # (batch_size, image_len, image_dim)

# audio_features = torch.randn(32, 100, 128) # (batch_size, audio_len, audio_dim)

#

# # 前向传播

# logits = model(text_features, image_features, audio_features)十、未来发展趋势与挑战

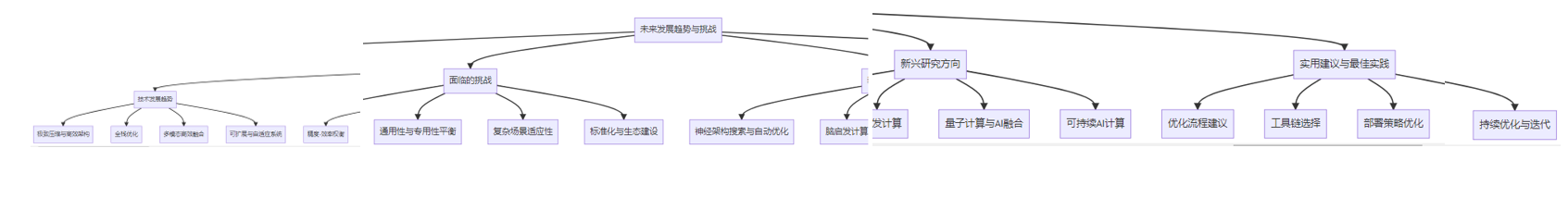

10.1 技术发展趋势

基于Transformer的高效推理优化技术在未来几年的发展趋势主要包括:

- 极致压缩与高效架构:

- 超轻量级模型:参数量在百万级别的高效模型

- 稀疏激活架构:只有一小部分参数被激活的模型结构

- 动态计算图:根据输入动态调整计算路径的模型

- 领域专用架构:针对特定任务优化的模型架构

- 全栈优化:

- 算法-硬件协同设计:从算法和硬件两个层面协同优化

- 编译优化自动化:自动发现最优编译优化策略

- 运行时自适应优化:根据运行时状态动态调整优化策略

- 端到端优化:从模型设计到部署的全流程优化

- 多模态高效融合:

- 统一多模态架构:处理多种模态的统一架构

- 模态动态适应:根据输入动态调整模态处理策略

- 跨模态知识迁移:在不同模态之间高效迁移知识

- 多任务协同优化:多个任务协同优化的多模态模型

- 可扩展与自适应系统:

- 弹性推理系统:根据负载动态调整资源分配

- 异构计算调度:在异构硬件上优化任务调度

- 边缘云协同:边缘设备和云服务器的协同推理

- 联邦推理优化:在联邦学习场景下的高效推理

10.2 面临的挑战

基于Transformer的高效推理优化技术在发展过程中面临的主要挑战包括:

- 精度-效率权衡:

- 如何在保证模型精度的同时最大化推理效率

- 如何为不同任务和场景找到最优的精度-效率平衡点

- 如何动态调整精度和效率以适应不同的输入和需求

- 如何评估和量化精度-效率权衡的效果

- 通用性与专用性平衡:

- 如何设计既通用又高效的模型架构

- 如何为特定任务设计专用的优化策略

- 如何在通用性和专用性之间找到平衡

- 如何实现通用优化和专用优化的有机结合

- 复杂场景适应性:

- 如何适应不同类型和长度的输入数据

- 如何适应不同的部署环境和硬件平台

- 如何处理实时性、内存、功耗等多重约束

- 如何在动态变化的环境中保持良好的性能

- 标准化与生态建设:

- 如何建立统一的模型压缩和优化标准

- 如何构建完整的高效推理生态系统

- 如何促进不同框架和工具之间的互操作性

- 如何培养专业人才和推动技术普及

10.3 新兴研究方向

基于Transformer的高效推理优化技术的新兴研究方向主要包括:

- 神经架构搜索与自动优化:

- 自动化模型压缩:使用NAS技术自动搜索压缩后的模型结构

- 自动量化策略:自动搜索最优的量化参数和策略

- 硬件感知NAS:针对特定硬件优化的神经架构搜索

- 高效训练-推理协同优化:同时优化训练和推理效率

- 脑启发计算:

- 脉冲神经网络:低功耗的脉冲神经网络模型

- 稀疏激活:模拟人脑的稀疏激活模式

- 注意力机制优化:模拟人脑的注意力机制

- 增量学习:模拟人脑的持续学习能力

- 量子计算与AI融合:

- 量子Transformer:基于量子计算的Transformer模型

- 量子加速优化:使用量子计算加速模型优化过程

- 量子启发算法:受量子计算启发的高效算法

- 混合量子-经典推理:量子和经典计算的混合推理系统

- 可持续AI计算:

- 绿色AI:低能耗的AI模型和算法

- 碳足迹优化:优化AI系统的碳足迹

- 资源高效学习:资源高效的模型训练和推理方法

- 生命周期优化:优化AI系统的整个生命周期

10.4 实用建议与最佳实践

对于实际应用中基于Transformer的高效推理优化,以下是一些实用建议与最佳实践:

- 优化流程建议:

- 首先进行模型结构优化,然后是参数优化,最后是运行时优化

- 根据目标硬件和应用场景选择合适的优化策略

- 进行全面的性能评估和精度验证

- 采用渐进式优化方法,逐步提升效率

- 工具链选择:

- 根据模型框架选择配套的优化工具

- 评估不同工具的性能提升和精度损失

- 考虑工具的兼容性和易用性

- 关注工具的更新频率和社区支持

- 部署策略优化:

- 根据应用场景选择合适的部署方式(云、边缘、端侧)

- 优化模型服务的启动时间和冷启动性能

- 实现高效的模型版本管理和更新机制

- 建立完善的监控和日志系统

- 持续优化与迭代:

- 定期评估模型性能,寻找进一步优化空间

- 跟踪最新的优化技术和工具

- 根据用户反馈和业务需求调整优化策略

- 建立优化效果的量化评估体系

结论

基于Transformer的高效推理优化技术是解决大型语言模型部署挑战的关键。本文全面解析了2025年的最新进展,包括计算优化、内存优化、模型压缩、量化技术、并行计算、专用硬件加速、自适应推理和多模态融合等多个方面。

随着技术的不断发展,我们可以看到以下几个重要趋势:一是从单一优化向全栈优化转变,二是从静态优化向动态自适应优化发展,三是从单模态优化向多模态融合优化演进,四是从通用优化向领域专用优化深化。

在实际应用中,建议根据具体的应用场景、部署环境和性能需求,选择合适的优化策略组合,进行全面的性能评估和精度验证,并建立持续优化的机制。

未来,随着神经架构搜索、脑启发计算、量子计算等新兴技术的发展,基于Transformer的高效推理优化技术将迎来更多突破,为AI技术的广泛应用提供更加强有力的支持。

参考文献

- Wang, Z., et al. “Efficient Transformer: A Survey.” arXiv preprint arXiv:2009.06732 (2020).

- Touvron, H., et al. “Llama 2: Open Foundation and Fine-Tuned Chat Models.” arXiv preprint arXiv:2307.09288 (2023).

- Chen, T., et al. “DeepSpeed: System Optimizations Enable Training Deep Learning Models with Over 100 Billion Parameters.” arXiv preprint arXiv:1911.05507 (2019).

- Dong, Z., et al. “Model Compression and Acceleration for Deep Neural Networks: The Principles, Progress, and Challenges.” Neurocomputing 425 (2021): 249-270.

- Fan, M., et al. “AWQ: Activation-aware Weight Quantization for LLM Compression and Acceleration.” arXiv preprint arXiv:2306.00978 (2023).

- Zhang, L., et al. “SpQR: Sparse-Quantized Representation for Near-Lossless LLM Weight Compression.” arXiv preprint arXiv:2306.03078 (2023).

- Liu, Z., et al. “A Survey of Quantization Methods for Efficient Neural Network Inference.” ACM Computing Surveys (CSUR) 55.4 (2022): 1-32.

- Han, S., et al. “Deep Compression: Compressing Deep Neural Networks with Pruning, Trained Quantization and Huffman Coding.” arXiv preprint arXiv:1510.00149 (2015).

- Brown, T. B., et al. “Language Models are Few-Shot Learners.” Advances in Neural Information Processing Systems 33 (2020): 1877-1901.

- Devlin, J., et al. “BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding.” arXiv preprint arXiv:1810.04805 (2018).

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-11-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录