001_具身人工智能概述与安全引言:从理论基础到前沿应用的深度解析

001_具身人工智能概述与安全引言:从理论基础到前沿应用的深度解析

安全风信子

发布于 2025-11-18 18:37:15

发布于 2025-11-18 18:37:15

1. 具身人工智能的概念与发展背景

具身人工智能(Embodied AI)代表了人工智能发展的一个重要方向,它突破了传统AI系统仅在数字世界运行的限制,通过物理载体与真实环境进行互动。这种融合物理与数字世界的特性,为AI系统带来了前所未有的能力和挑战。

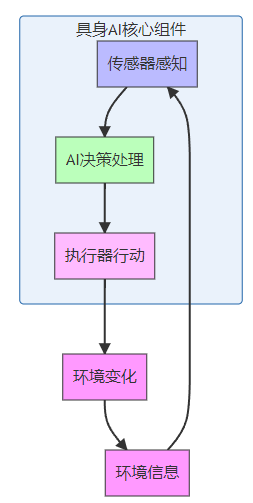

1.1 具身AI的核心定义

具身人工智能是指AI系统嵌入物理实体(如机器人、无人机、智能设备等)中,通过传感器感知环境,经过计算决策,最后通过执行器作用于物理世界,实现感知-决策-行动的闭环系统。与传统的纯软件AI不同,具身AI强调"身体"对于智能形成的重要性。

1.2 具身认知理论基础

具身认知理论为具身AI提供了重要的思想基础。这一理论认为,智能不仅仅来源于抽象的符号处理,而是与身体结构、感官体验和环境互动密切相关。主要理论包括:

- Moravec悖论:由Hans Moravec提出,指出人类认为困难的任务(如下棋)对计算机相对容易,而人类认为简单的任务(如行走、识别物体)对计算机却极其困难

- 情境认知:智能行为是主体与环境互动的结果,而非仅存在于个体内部的计算过程

- 生成认知:认知过程是大脑、身体和环境共同作用的动态生成过程

1.3 具身AI的发展历程

具身AI的发展经历了几个重要阶段:

- 早期探索阶段(1960s-1980s):以Shakey机器人为代表,开始了AI与物理实体结合的尝试

- 认知革命阶段(1980s-1990s):具身认知理论兴起,影响了AI研究方向

- 计算智能融合阶段(2000s-2010s):机器学习与机器人技术深度结合

- 深度学习时代(2010s至今):深度学习技术极大提升了具身AI的感知和决策能力

2. 具身AI的关键特性与优势

2.1 与传统AI的本质区别

具身AI与传统AI在多个维度上存在显著差异:

特性维度 | 传统AI | 具身AI |

|---|---|---|

存在形式 | 纯软件系统 | 软硬件结合的物理实体 |

感知方式 | 依赖输入数据,缺乏直接感知 | 通过传感器直接感知环境 |

环境交互 | 被动响应,无物理影响 | 主动作用于物理环境 |

学习方式 | 主要依赖预训练数据 | 可通过环境互动进行强化学习 |

安全风险 | 主要是数据和算法风险 | 包括物理安全、人身安全等多维度风险 |

应用场景 | 主要在数字领域 | 可应用于物理世界的各种场景 |

2.2 具身AI的核心优势

具身AI相比传统AI具有独特的优势:

- 环境适应性:能够实时感知环境变化并做出响应

- 多模态感知:融合视觉、听觉、触觉等多种感知信息

- 情境理解:更好地理解物理世界的约束和规则

- 自主学习:通过与环境互动不断优化行为策略

- 实际干预能力:能够直接影响和改变物理环境

2.3 2025年具身AI的前沿进展

2025年,具身AI在以下领域取得了显著进展:

- 神经形态计算的安全集成:模仿生物神经网络的计算架构,提升AI系统的能效和鲁棒性

- 多智能体协作系统:多个具身AI能够安全高效地协作完成复杂任务

- 可解释AI技术:提升具身AI决策过程的透明度和可理解性

- 边缘计算与AI融合:在资源受限的物理设备上实现高效AI推理

- 量子安全通信:应用量子加密技术保护具身AI系统间的通信安全

3. 具身AI的安全挑战与威胁模型

3.1 具身AI特有的安全风险

由于具身AI系统的物理特性,它面临着传统AI系统所不具备的安全风险:

- 物理安全风险:设备被破坏、篡改或劫持

- 传感器欺骗攻击:通过欺骗传感器获取错误的环境信息

- 执行器恶意控制:攻击者控制执行器执行有害动作

- 人机交互安全:在人机协作过程中可能产生的安全隐患

- 隐私泄露风险:传感器收集的环境数据可能包含敏感信息

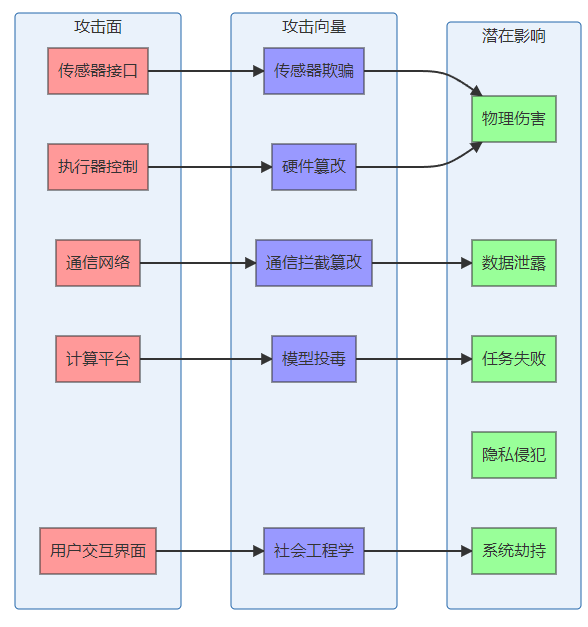

3.2 具身AI安全威胁模型

具身AI系统的安全威胁可以从攻击面、攻击向量和潜在影响三个维度进行建模:

3.3 经典安全威胁案例分析

以下是几个具身AI领域的典型安全威胁案例:

- 传感器欺骗案例:研究人员通过激光干扰自动驾驶汽车的LiDAR传感器,使其错误感知周围环境,导致安全隐患

- 通信劫持案例:攻击者通过中间人攻击拦截并篡改无人机的控制信号,获取控制权

- 模型后门案例:在机器人视觉模型中植入后门,当出现特定触发条件时,模型会产生错误识别结果

- 物理篡改案例:恶意修改工业机器人的硬件组件,使其在运行时执行未授权操作

4. 具身AI安全评估框架

4.1 安全评估的核心维度

对具身AI系统进行全面安全评估需要考虑以下核心维度:

- 感知安全:评估传感器数据的完整性、真实性和可靠性

- 计算安全:评估AI算法和计算平台的安全性

- 通信安全:评估系统间通信的保密性和完整性

- 执行安全:评估执行器控制的安全性和可靠性

- 物理安全:评估硬件设备的物理防护能力

- 隐私保护:评估系统对用户和环境数据的隐私保护措施

- 伦理合规:评估系统行为是否符合伦理标准和法规要求

4.2 风险评估方法论

具身AI系统的风险评估可以采用以下方法论:

- STRIDE模型适配:将经典的STRIDE威胁建模方法适配到具身AI场景

- FAIR模型应用:采用Factor Analysis of Information Risk方法量化安全风险

- 失效模式与影响分析(FMEA):分析系统各组件的潜在失效模式及其影响

- 攻击树分析:构建攻击树,识别系统的脆弱点

- 渗透测试:通过模拟攻击评估系统的防御能力

4.3 安全评估工具与技术

2025年,具身AI安全评估领域有多种先进工具和技术:

- AI安全测试框架:如TensorFlow Model Analysis for Security、PyTorch Security Extensions

- 模拟仿真环境:如Gazebo、Webots等用于虚拟安全测试

- 形式化验证工具:如Coq、Isabelle等用于验证AI系统的安全属性

- 异常检测系统:基于机器学习的实时异常行为检测

- 安全审计工具:自动化的代码和模型安全审计工具

5. 具身AI的安全防护策略

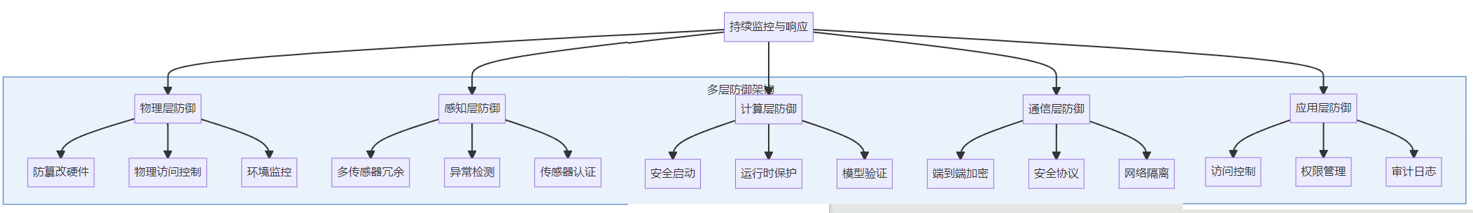

5.1 多层防御架构

具身AI系统应采用多层防御架构,形成纵深防御体系:

5.2 安全设计原则

在具身AI系统设计中,应遵循以下安全设计原则:

- 安全优先设计:在系统设计初期就将安全因素纳入考虑

- 默认安全配置:系统默认配置应采用最安全的设置

- 最小权限原则:每个组件和用户只授予完成任务所需的最小权限

- 防御纵深:采用多层防御机制,避免单点失效

- 安全弹性:系统在遭受攻击时能够降级运行或安全恢复

- 可验证性:安全措施应可验证和测试

- 可审计性:关键操作和事件应可追踪和审计

5.3 安全实施最佳实践

具身AI系统安全实施的最佳实践包括:

- 安全开发生命周期(SDL):将安全集成到整个开发流程中

- 定期安全评估:持续进行安全评估和渗透测试

- 安全更新机制:建立安全、可靠的更新机制

- 事件响应计划:制定完善的安全事件响应流程

- 威胁情报共享:积极参与行业威胁情报共享

- 用户安全培训:对系统用户进行安全意识培训

6. 具身AI安全标准与法规

6.1 国际安全标准

2025年,具身AI领域的主要国际安全标准包括:

- ISO/IEC 27000系列:信息安全管理体系标准

- ISO/IEC 42001:AI管理体系标准

- IEC 61508:电气/电子/可编程电子安全相关系统的功能安全

- NIST AI风险管理框架:美国国家标准与技术研究院发布的AI风险管理指南

- IEC 62443系列:工业自动化和控制系统的安全标准

6.2 地区法规要求

不同地区对具身AI系统有不同的法规要求:

- 欧盟:AI法案对高风险AI系统(包括具身AI)提出了严格的安全和伦理要求

- 美国:通过联邦和州级法规规范AI系统的安全使用

- 中国:《生成式人工智能服务管理办法》等法规对AI系统的安全使用提出要求

- 日本:《AI治理基本方针》指导AI系统的安全开发和使用

- 新加坡:《AI治理框架》提供了AI系统安全治理的指导原则

6.3 行业特定标准

不同行业对具身AI系统有特定的安全标准:

- 医疗领域:IEC 60601(医疗电气设备安全)、FDA医疗AI指南

- 汽车领域:ISO 26262(道路车辆功能安全)、SAE J3016(自动驾驶分级)

- 工业领域:ISA/IEC 62443(工业自动化和控制系统安全)

- 航空领域:DO-178C(软件考虑因素)、ARP4754A(民用飞机系统和设备认证)

7. 具身AI安全工具与实践

7.1 ROS安全工具

Robot Operating System (ROS)是具身AI系统常用的开发平台,其安全工具包括:

# ROS 2安全插件示例:安全节点配置

from rclpy.node import Node

from rclpy.security import SecurityContext

class SecureRobotNode(Node):

def __init__(self):

# 创建带有安全上下文的节点

security_context = SecurityContext()

security_context.load_security_files(

certificate_path='/path/to/cert.pem',

private_key_path='/path/to/key.pem',

ca_cert_path='/path/to/ca.pem'

)

super().__init__('secure_robot_node', security_context=security_context)

# 设置安全订阅器,验证发布者身份

self.subscription = self.create_subscription(

String, # 消息类型

'sensor_data', # 话题名

self.listener_callback,

10, # QoS

callback_group=None,

raw=False

)

# 设置安全发布器,签名消息

self.publisher = self.create_publisher(

String, # 消息类型

'control_commands', # 话题名

10, # QoS

callback_group=None

)

def listener_callback(self, msg):

# 验证消息完整性

if self.verify_message_integrity(msg):

# 处理验证通过的消息

processed_data = self.process_sensor_data(msg.data)

# 发布控制命令

self.publish_command(processed_data)

def verify_message_integrity(self, msg):

# 实现消息完整性验证逻辑

# 1. 验证消息签名

# 2. 检查消息时间戳是否合理

# 3. 检查数据范围是否在预期内

return True # 简化示例

def process_sensor_data(self, data):

# 实现传感器数据处理逻辑

return f"processed:{data}"

def publish_command(self, command):

# 发布签名的控制命令

msg = String()

msg.data = command

# 消息将自动使用节点的安全上下文进行签名

self.publisher.publish(msg)

self.get_logger().info(f'发布安全命令: {command}')

# 主函数

import rclpy

from std_msgs.msg import String

def main(args=None):

rclpy.init(args=args)

# 创建并配置安全环境

secure_node = SecureRobotNode()

try:

# 运行节点

rclpy.spin(secure_node)

except KeyboardInterrupt:

secure_node.get_logger().info('收到退出信号,关闭节点')

finally:

# 清理资源

secure_node.destroy_node()

rclpy.shutdown()

if __name__ == '__main__':

main()7.2 具身AI安全开发框架

2025年流行的具身AI安全开发框架包括:

- TensorFlow Secure:提供模型安全、数据隐私保护功能

- PyTorch SafeRL:专注于强化学习的安全框架

- OpenAI Safety Gym:用于测试和训练安全AI策略的环境

- DeepMind Safety Research Framework:深度安全研究框架

- Microsoft Aether:边缘AI安全框架

7.3 安全测试与验证工具

具身AI安全测试与验证工具示例:

# 具身AI传感器数据异常检测工具

import numpy as np

import tensorflow as tf

from sklearn.ensemble import IsolationForest

from sklearn.preprocessing import StandardScaler

class SensorAnomalyDetector:

def __init__(self, model_type='iforest'):

"""初始化传感器异常检测模型

参数:

model_type: 模型类型,'iforest'或'autoencoder'

"""

self.model_type = model_type

self.scaler = StandardScaler()

if model_type == 'iforest':

# 隔离森林模型

self.model = IsolationForest(

n_estimators=100,

contamination=0.01,

random_state=42

)

elif model_type == 'autoencoder':

# 自编码器模型

self.model = self._build_autoencoder(input_dim=6)

else:

raise ValueError(f'不支持的模型类型: {model_type}')

self.is_trained = False

def _build_autoencoder(self, input_dim=6):

"""构建自编码器模型"""

inputs = tf.keras.layers.Input(shape=(input_dim,))

# 编码器

encoded = tf.keras.layers.Dense(128, activation='relu')(inputs)

encoded = tf.keras.layers.Dense(64, activation='relu')(encoded)

encoded = tf.keras.layers.Dense(32, activation='relu')(encoded)

# 解码器

decoded = tf.keras.layers.Dense(64, activation='relu')(encoded)

decoded = tf.keras.layers.Dense(128, activation='relu')(decoded)

decoded = tf.keras.layers.Dense(input_dim, activation='linear')(decoded)

# 构建自编码器模型

autoencoder = tf.keras.models.Model(inputs, decoded)

autoencoder.compile(optimizer='adam', loss='mse')

return autoencoder

def fit(self, X_train):

"""训练异常检测模型

参数:

X_train: 训练数据,形状为 (n_samples, n_features)

"""

# 数据标准化

X_scaled = self.scaler.fit_transform(X_train)

if self.model_type == 'iforest':

# 训练隔离森林

self.model.fit(X_scaled)

elif self.model_type == 'autoencoder':

# 训练自编码器

self.model.fit(

X_scaled, X_scaled,

epochs=100,

batch_size=32,

shuffle=True,

validation_split=0.2,

verbose=0

)

# 计算重建误差阈值

X_pred = self.model.predict(X_scaled)

mse = np.mean(np.power(X_scaled - X_pred, 2), axis=1)

self.threshold = np.percentile(mse, 99) # 99%分位数作为阈值

self.is_trained = True

print(f"模型训练完成,类型: {self.model_type}")

def detect_anomalies(self, X_test, return_scores=False):

"""检测异常数据

参数:

X_test: 测试数据,形状为 (n_samples, n_features)

return_scores: 是否返回异常分数

返回:

predictions: 预测结果,1表示正常,-1表示异常

scores: 异常分数 (如果return_scores为True)

"""

if not self.is_trained:

raise ValueError("模型尚未训练,请先调用fit方法")

# 数据标准化

X_scaled = self.scaler.transform(X_test)

if self.model_type == 'iforest':

# 使用隔离森林预测

predictions = self.model.predict(X_scaled)

scores = self.model.score_samples(X_scaled) # 异常分数

elif self.model_type == 'autoencoder':

# 使用自编码器预测

X_pred = self.model.predict(X_scaled)

mse = np.mean(np.power(X_scaled - X_pred, 2), axis=1) # 重建误差

predictions = np.where(mse > self.threshold, -1, 1) # -1表示异常

scores = mse

if return_scores:

return predictions, scores

else:

return predictions

def get_anomaly_metrics(self, X_test, y_true):

"""计算异常检测的性能指标

参数:

X_test: 测试数据

y_true: 真实标签,1表示正常,-1表示异常

返回:

metrics: 性能指标字典

"""

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

predictions = self.detect_anomalies(X_test)

metrics = {

'accuracy': accuracy_score(y_true, predictions),

'precision': precision_score(y_true, predictions, pos_label=-1),

'recall': recall_score(y_true, predictions, pos_label=-1),

'f1_score': f1_score(y_true, predictions, pos_label=-1)

}

return metrics

# 使用示例

if __name__ == "__main__":

# 生成示例数据

np.random.seed(42)

# 正常数据 - 多维高斯分布

n_samples = 1000

X_normal = np.random.randn(n_samples, 6)

# 异常数据 - 离群点

n_anomalies = 50

X_anomalies = 10 + np.random.randn(n_anomalies, 6) # 远离原点的点

# 合并数据集

X_train = X_normal[:800]

X_test = np.vstack([X_normal[800:], X_anomalies])

y_test = np.concatenate([np.ones(200), -np.ones(n_anomalies)])

# 创建并训练检测器

detector = SensorAnomalyDetector(model_type='autoencoder')

detector.fit(X_train)

# 检测异常

predictions, scores = detector.detect_anomalies(X_test, return_scores=True)

# 计算性能指标

metrics = detector.get_anomaly_metrics(X_test, y_test)

print("异常检测性能指标:")

for key, value in metrics.items():

print(f"{key}: {value:.4f}")

# 显示检测结果统计

n_true_anomalies = (y_test == -1).sum()

n_detected_anomalies = (predictions == -1).sum()

n_correctly_detected = ((predictions == -1) & (y_test == -1)).sum()

print(f"\n测试集中异常样本数量: {n_true_anomalies}")

print(f"检测到的异常样本数量: {n_detected_anomalies}")

print(f"正确检测的异常样本数量: {n_correctly_detected}")

print(f"异常检测率: {n_correctly_detected / n_true_anomalies:.4f}")8. 具身AI安全的未来展望

8.1 技术发展趋势

具身AI安全技术的未来发展趋势包括:

- 自适应安全防御:基于AI的自适应安全防御系统,能够实时调整防御策略

- 量子安全技术:量子加密和量子随机数生成器在具身AI安全中的应用

- 区块链安全:利用区块链技术确保具身AI系统数据和操作的不可篡改性

- 边缘计算安全:优化边缘设备上的AI安全计算能力

- 生物启发安全:模仿生物免疫系统的安全防御机制

8.2 研究热点方向

2025年具身AI安全的研究热点包括:

- 安全强化学习:在强化学习框架中融入安全约束

- 可验证AI:形式化验证AI系统的安全属性

- 隐私保护机器学习:联邦学习、差分隐私在具身AI中的应用

- 多智能体安全协作:确保多个具身AI系统安全高效地协作

- 人机协作安全:研究人机协作过程中的安全机制

8.3 面临的挑战与机遇

具身AI安全领域面临的挑战与机遇:

- 挑战:

- 计算资源限制与安全需求之间的平衡

- 实时性要求对安全机制的挑战

- 复杂环境下的安全态势感知

- 安全与功能灵活性的权衡

- 机遇:

- 新技术(如量子计算、区块链)为安全提供新解决方案

- 跨学科研究促进安全创新

- 标准化进程推动行业安全水平提升

- 市场需求驱动安全技术快速发展

9. 学习路径与资源推荐

9.1 具身AI安全学习路径

对于希望学习具身AI安全的读者,推荐以下学习路径:

- 基础知识阶段:

- 人工智能基础理论

- 信息安全基础概念

- 机器人学基础

- 计算机网络安全

- 进阶学习阶段:

- 具身认知理论

- 安全强化学习

- 传感器安全技术

- AI系统安全评估

- 专业研究阶段:

- 具身AI特定安全挑战

- 前沿安全技术研究

- 安全标准与法规

- 实际系统安全设计

9.2 推荐学习资源

2025年具身AI安全领域的优质学习资源:

- 学术论文:

- IEEE Transactions on Dependable and Secure Computing

- Journal of Artificial Intelligence Research

- ACM Conference on Computer and Communications Security

- 技术书籍:

- 《具身人工智能安全:理论与实践》

- 《机器人安全工程》

- 《AI安全:原理与实践》

- 在线课程:

- Coursera: “具身AI安全专项课程”

- edX: “AI与机器人安全”

- Udacity: “自动驾驶安全工程师纳米学位”

- 开源项目:

- ROS Security Working Group

- OpenAI Safety Gym

- TensorFlow Security

10. 总结与展望

具身人工智能作为AI领域的重要发展方向,正在各个行业得到广泛应用。然而,其安全问题也日益凸显,需要我们从多个维度进行系统性思考和解决。通过采用多层防御架构、遵循安全设计原则、应用先进安全工具和技术,我们可以构建更加安全可靠的具身AI系统。

随着技术的不断发展,具身AI安全将面临新的挑战和机遇。未来,我们需要加强跨学科合作,推动安全标准的制定和完善,促进安全技术的创新和应用,确保具身AI技术的健康发展,为人类社会创造更多价值。

在后续章节中,我们将深入探讨具身AI的核心组件安全、感知安全、决策安全等具体技术领域,为读者提供更加专业和深入的指导。

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-10-16,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录