Agentic AI 时代的内存(3)-KVCache卸载与PNM、PIM

Agentic AI 时代的内存(3)-KVCache卸载与PNM、PIM

数据存储前沿技术

发布于 2025-11-20 13:37:31

发布于 2025-11-20 13:37:31

阅读收获

掌握KV缓存的核心原理与挑战

- 深入理解工作记忆在LLM推理中的技术实现机制

- 掌握KV缓存大小计算公式及其对系统性能的影响因素

了解内存架构的技术演进路径

- 认识从传统内存分层到PNM/PIM技术的演进逻辑

- 学习如何评估不同内存方案在长上下文场景下的适用性

全文概览

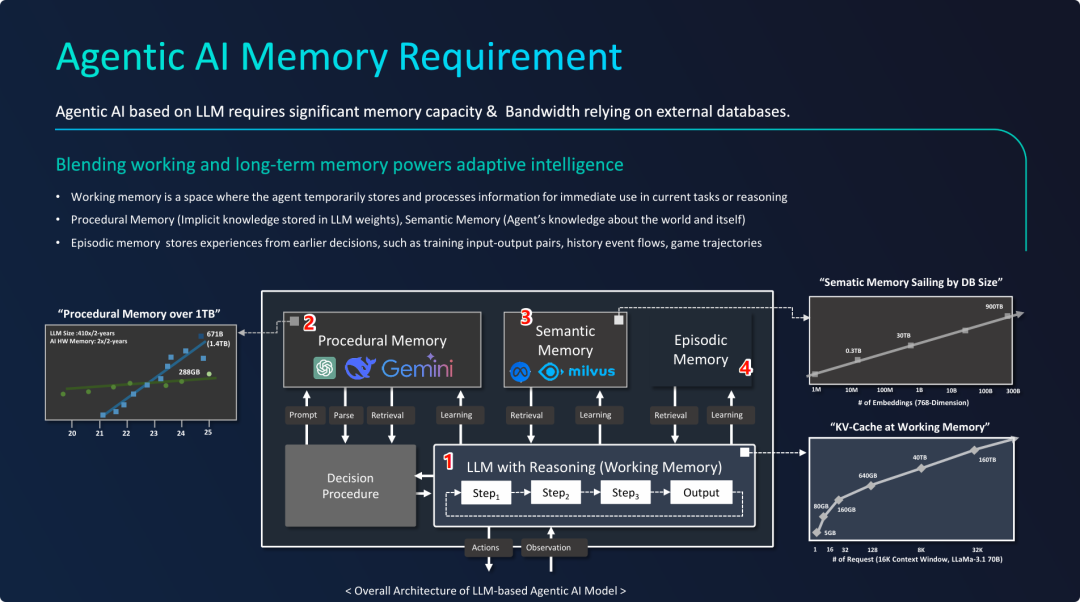

随着智能体AI的快速发展,大模型在处理长上下文任务时面临着一个关键瓶颈:工作记忆的管理。您是否曾思考过,为什么即使是最先进的GPU集群,在处理128K长上下文推理时仍会遭遇性能瓶颈?答案就隐藏在KV缓存这一核心技术中。

AI的"工作记忆"本质上就是LLM的上下文窗口,它承载着系统指令、历史对话、用户输入和中间推理过程。然而,随着上下文长度的指数级增长,KV缓存的内存需求已远超当前硬件极限,形成了"容量鸿沟"和"带宽鸿沟"的双重挑战。在8卡H100服务器上,KV缓存就能轻易耗尽昂贵的HBM内存,这就是所谓的"工作记忆墙"。

面对这一困境,业界正在探索全新的内存架构解决方案。近内存处理(PNM/PIM)技术通过将计算移近数据,从根本上改变了传统的数据移动范式,为解决大模型推理的内存瓶颈提供了创新思路。

👉 划线高亮 观点批注

智能体AI的内存需求

智能体AI的内存需求

工作记忆的定义与作用

工作记忆的定义与作用

AI的“工作记忆”在技术上体现为LLM的“上下文窗口”,它是AI进行复杂、多步推理和决策的工作台与基础。

- 定义与实现: 工作记忆不是一个独立的数据库,而是LLM处理当前任务时的一个动态、临时的信息集合。它的物理载体就是上下文窗口,其底层数据结构就是KV缓存。

- 功能: 它的核心功能是整合所有相关信息以支持连贯思考。通过将系统指令、历史对话、用户问题、外部知识(来自语义记忆)和模型的中间思路全部“尽收眼底”,LLM才能进行全面、有深度的推理,而不是孤立地看问题。

- 动态与扩展性: 工作记忆是动态增长的。随着对话的进行和任务的深入,信息不断被加入上下文窗口。PPT明确指出了一个关键的挑战:任务越复杂,需要维持的工作记忆(上下文窗口)就越长,这对系统的内存容量和处理能力(特别是KV缓存的管理)提出了巨大的要求,这也与本系列PPT第一张图中“KV-Cache at Working Memory”的数据图表遥相呼-应。

===

上下文窗口的构成: 这个长条从左到右填充了不同类型的信息(Tokens),代表了模型在进行当前推理时所需要看到的所有内容:

- System Prompt (系统提示): 对AI角色的初始设定和指令。

- Prev. Conversation (先前对话): 历史对话记录。

- User Inputs (用户输入): 用户当前轮次提出的问题或指令。

- Thinking Tokens (思考过程): 模型内部的思考步骤,例如“思维链 (Chain-of-Thought)”的中间过程。

- Retrieved info (from semantic mem.) (从语义记忆检索的信息): 从外部知识库(如向量数据库)中检索到的事实依据。

- Thinking tokens (思考过程): 更多的内部推理步骤。

- Output tokens (输出内容): 模型正在生成或已经生成的回答。

工作记忆 - KV缓存

工作记忆 - KV缓存

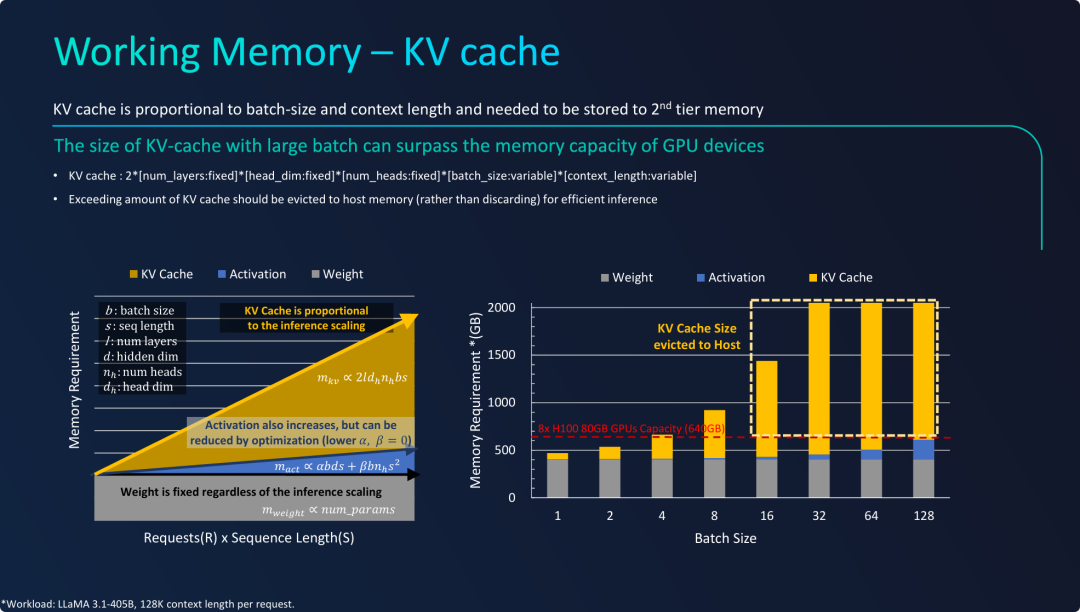

在处理大批量、长上下文的生产级推理负载时,工作记忆的实现核心——KV缓存,是导致内存容量瓶颈的关键因素,必须采用内存分层技术来解决。

- KV缓存是内存消耗的“大头”: 与固定大小的模型权重不同,KV缓存的大小与工作负载(批处理大小 x 上下文长度)成正比,在重负载下会急剧膨胀,成为最主要的内存消耗项。

- 触发“工作记忆墙”: KV缓存很容易就会耗尽昂贵且有限的GPU HBM内存。图表用一个非常实际的例子(8卡H100服务器)证明,即使是顶级的硬件配置,也无法在HBM内完全容纳大批量推理所需的KV缓存,这就是“工作记忆墙”。

- 内存分层是必然选择: 解决“工作记忆墙”的有效方案,就是将GPU HBM视为一级高速缓存,将更大容量的CPU主机内存(DDR DRAM)视为二级内存。当HBM不足时,将超出部分的KV缓存动态地“驱逐”或“交换”到主机内存。这种分层内存管理 (Memory Tiering) 策略,是实现大吞吐量、高效LLM推理服务的关键系统级技术。

===

- KV缓存大小的计算公式: PPT给出了一个公式

KV cache : 2*[num_layers]*[head_dim]*[num_heads]*[batch_size]*[context_length]。这个公式清晰地表明,KV缓存的大小由模型固有参数(层数、头维度、头数量)和两个关键的可变负载参数——批处理大小 (batch_size) 和 上下文长度 (context_length)——线性决定。 - 解决方案: 超出GPU内存容量的KV缓存,应该被**“驱逐”(evicted)到主机内存(Host Memory, 即DDR DRAM)**中,而不是直接丢弃,这样才能保证推理的效率。这提出了一种内存分层的解决方案。

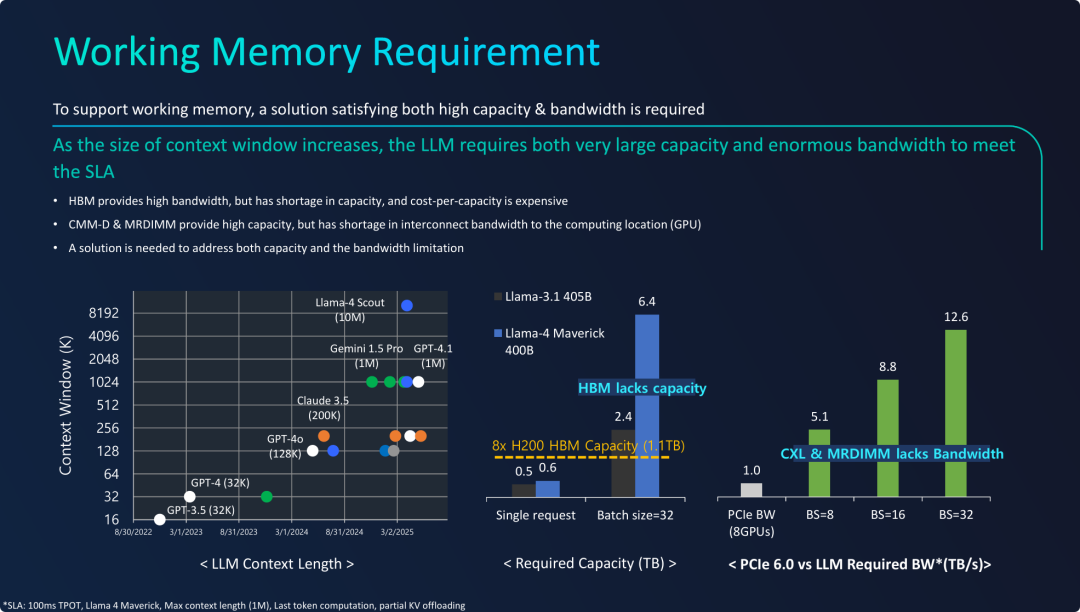

现代AI大模型对工作记忆(KVCache)的需求已经超出了当前主流内存技术的极限,形成了一个两难的“架构困境”。

- 需求的根源: 上下文窗口的指数级增长是推动工作记忆需求(容量和带宽)急剧膨胀的根本原因。

- 架构的困境: 当前的内存技术方案存在根本性的矛盾:

- HBM: 带宽足够,但容量太小(容量鸿沟)。

- MRDIMM / CMM-D: 容量足够,但连接到GPU的通路带宽太窄(带宽鸿沟)。

- 量化的挑战: PPT用数据清晰地展示了这个困境的严重性。无论是容量(需要6.4TB vs 只有1.1TB HBM)还是带宽(需要~12TB/s vs 只有1TB/s互联),都存在一个数量级的巨大差距。

- 最终指向: 为了支撑下一代拥有超长上下文的大模型,业界迫切需要一种全新的内存解决方案或内存架构。这个未来的方案必须能够打破现有技术的桎梏,同时提供TB级的容量和TB/s级的带宽,并使其能被GPU等计算单元高效访问。

注:上述结论仅从物理时延角度评估 LLM 推理对内存带宽和容量的理论需求,实际工程实践中结合PD分离、Flash Attention 等机制能有效缓解 KVCache的容量和带宽问题。

近存计算: Working Memory 的DRAM 解决方案

近存计算: Working Memory 的DRAM 解决方案

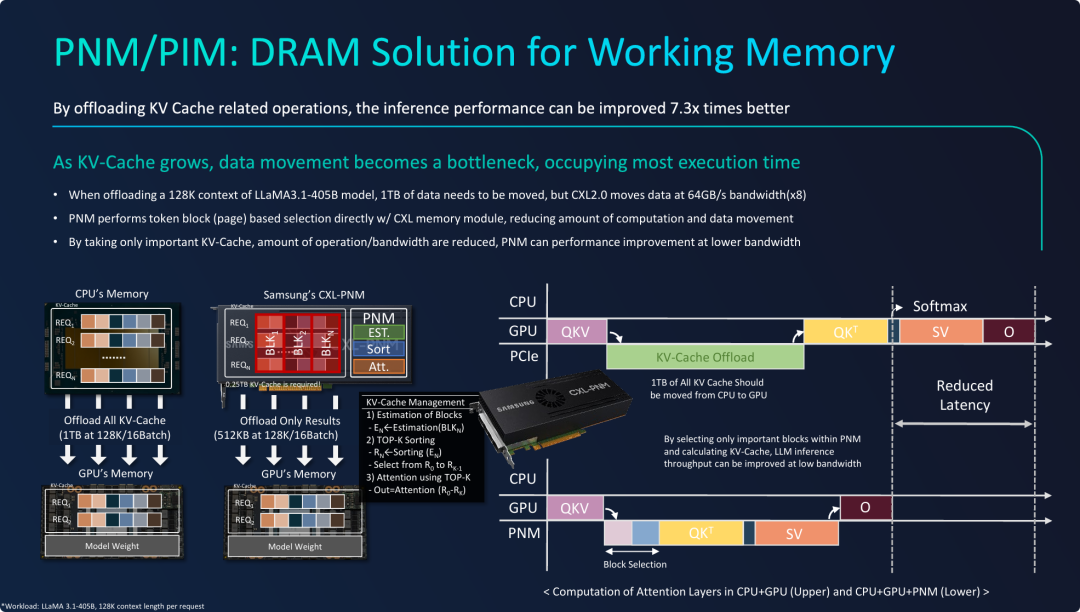

PPT的核心观点是,PNM/PIM技术通过将计算移近数据,从根本上解决了工作记忆面临的“带宽鸿沟”问题,是解锁未来超长上下文大模型性能的关键。

- 范式转变: PNM的核心思想是从传统的 “移动数据到计算单元” 转变为 “移动计算到数据所在地”。它没有试图去拓宽那条“狭窄”的CXL/PCIe通路,而是从源头上减少了需要通过这条通路的数据量。

- 智能数据筛选: PNM并非一个通用的处理器,而是一个专用的“过滤器”和“预处理器”。它在内存端执行轻量级的计算(如Top-K选择),智能地识别出对于当前推理步骤哪些KV缓存是最重要的。

可以将PNM/PIM 理解为 向量数据库核心算法(HNSW/ANN) 的硬件实现,或者说是实现KV缓存的语义检索,和DPU解耦系统中的网络通信相似,PNM/PIM 的最终目的是解耦推理系统对KVCache 的检索依赖,从概念到工程实现,应该还有很长一段路要走。

- 数量级的优化: 这种智能筛选带来了数量级的效果。需要跨越“带宽鸿沟”的数据量从TB级别骤降至KB级别,使得原本的带宽瓶颈被完全规避。

PNM解决方案在智能体AI中的应用案例

PNM解决方案在智能体AI中的应用案例

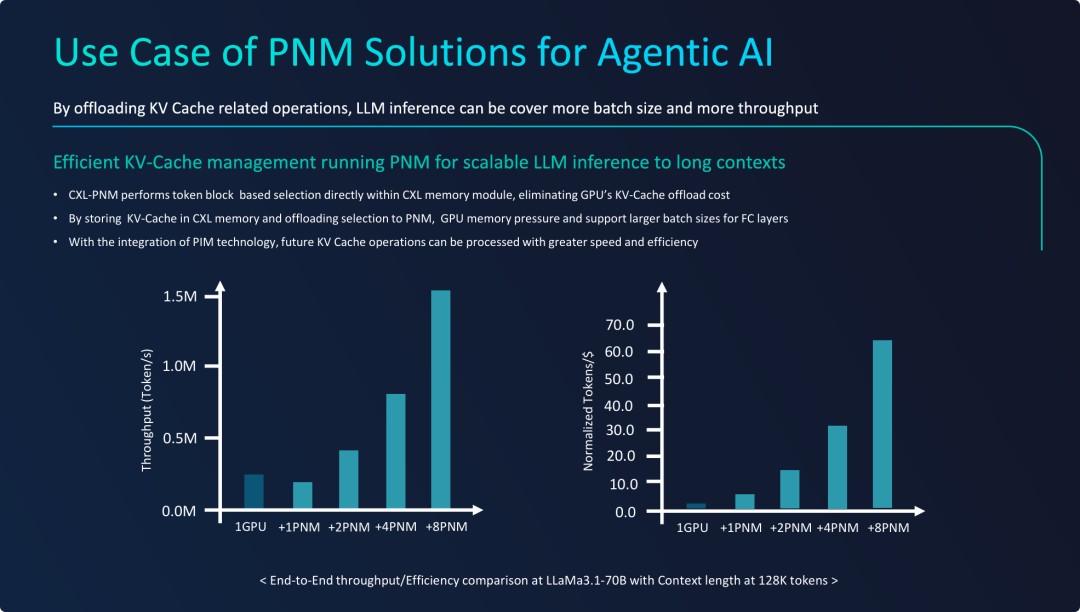

PPT的核心观点是,PNM不仅是一个技术上可行的方案,更是一个在实际应用中具有极高扩展性和经济效益的解决方案,尤其适用于长上下文的智能体AI推理。

- 证明了可扩展性 (Scalability): 测试数据清晰地表明,通过为单个GPU配备更多的PNM模块,可以近似线性地提升整个系统的推理吞吐量。这打破了单GPU因内存带宽和容量限制而无法有效处理更大负载的瓶颈。

- 突出了经济效益 (Cost-Effectiveness): “Tokens/$”效率图是本张幻灯片最有说服力的部分。它证明了PNM是一种高性价比的“加速器”。对于需要横向扩展推理能力的用户来说,购买更多的PNM模块是比购买更多的GPU更经济的选择。

- 明确了应用场景: PNM方案特别适用于像LLaMA 70B这样的大模型在128K长上下文场景下的推理。在这种场景下,KV缓存管理是最大的瓶颈,而PNM恰好能精准地解决这个问题。

更多关于 PNM/PIM 的原型设计与技术细节,可参考阅读 Samsung 在 HotChip 2023 上的技术报道[1]。

总结性的幻灯片,清晰地勾勒出了整个演示文稿的 “问题-挑战-方案-生态” 的完整逻辑链条。

- 时代背景 (The Driver): 智能体AI(Agentic AI) 的兴起,对传统的内存架构提出了颠覆性的要求,一个分层、大容量、高带宽的内存系统成为刚需。

- 核心瓶颈 (The Problem): 在所有挑战中,工作记忆(KV缓存)的有效管理是最大的瓶颈。在长上下文、大吞吐量的需求下,海量KV缓存的移动成为了性能的“阿喀琉斯之踵”,导致了“容量鸿沟”和“带宽鸿沟”。

- 终极方案 (The Solution): 解决方案是构建一个全新的内存范式。通过大容量、可扩展的CXL内存来承载海量数据,再利用近内存处理(PNM/PIM)技术在数据源头进行智能筛选和预处理,从而将需要移动的数据量降至最低。

- 未来路径 (The Path Forward): 这条技术路线并非空中楼阁,而是由行业领导者(三星)与开放标准社区(OCP)共同推动的、代表未来的重要方向。

延伸思考

这次分享的内容就到这里了,或许以下几个问题,能够启发你更多的思考,欢迎留言,说说你的想法~

技术架构层面 在当前AI硬件生态中,PNM/PIM技术要实现大规模商业化应用,除了技术成熟度外,还需要克服哪些标准化和生态系统建设的挑战?您认为行业应该如何协同推进这一技术的落地?

工程实践角度 考虑到实际工程中已经存在PD分离、Flash Attention等优化技术,PNM方案与这些现有优化手段应该如何协同工作?在您的项目经验中,哪种组合方案最能平衡性能与成本?

未来发展方向 如果PNM技术成功普及,它将对AI推理服务的商业模式产生怎样的影响?是否会催生新的内存即服务(Memory-as-a-Service)业态?您如何看待这一技术变革带来的商业机会?

原文标题:Heterogeneous Memory Opportunity [2]with Agentic AI and Memory Centric Computing

Notice:Human's prompt, Datasets by Gemini-2.5-Pro

#FMS25 #KvCache卸载 #近存、存内计算

---【本文完】---

公众号:王知鱼,专注数据存储、云计算趋势&产品方案。

PPT取自 Samsung 资深系统架构师 Jinin So,在FMS 2025 闪存峰会上的汇报材料。

👇阅读原文,查看历史文章,推荐PC端打开 💻。

- https://www.hc2023.hotchips.org/assets/program/conference/day1/PIM/23_HC35_PIM_PNM_Samsung_final.pdf ↩

- https://files.futurememorystorage.com/proceedings/2025/20250807_DRAM-304-1_SO.pdf ↩

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-10-11,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读